인공지능의 철학

Philosophy of artificial intelligence| 시리즈의 일부 |

| 인공지능 |

|---|

인공지능의 철학은 인공지능과 지성, 윤리, 의식, 인식론, 자유의지에 [1]대한 지식과 이해에 대한 그것의 함의를 탐구하는 기술 철학의 한 분야이다.게다가, 그 기술은 인공 동물이나 인공 인간(또는 적어도 인공 생물; 인공 생명체를 참조)의 창조와 관련이 있기 때문에 [2]철학자들에게는 그 분야가 상당히 흥미롭다.이러한 요소들은 인공지능 철학의 출현에 기여했다.일부 학자들은 AI 커뮤니티의 철학을 무시하는 것은 [3]해롭다고 주장한다.

인공지능의 철학은 다음과 [4]같은 질문에 답하려고 한다.

- 기계가 지능적으로 작동할 수 있을까요?사람이 생각하는 것으로 해결할 수 있는 문제를 해결할 수 있을까요?

- 인간의 지능과 기계의 지능은 같은가?인간의 뇌는 본질적으로 컴퓨터인가?

- 기계가 인간이 가질 수 있는 것과 같은 의미에서 마음, 정신 상태, 그리고 의식을 가질 수 있을까?사물이 어떤지 느낄 수 있나요?

이러한 질문들은 AI 연구자들, 인지 과학자들, 철학자들의 서로 다른 관심사를 반영한다.이러한 질문에 대한 과학적 대답은 "지성"과 "의식"의 정의와 정확히 어떤 "기계"가 논의되고 있는지에 따라 달라집니다.

AI 철학에서 중요한 명제는 다음과 같다.

- 튜링의 "공손한 관습": 만약 기계가 사람처럼 지능적으로 행동한다면,[5] 그것은 인간만큼 지능적이다.

- 다트머스 제안: "학습의 모든 측면이나 지능의 다른 특징들은 매우 정확하게 묘사될 수 있고,[6] 기계가 그것을 시뮬레이션하도록 만들 수 있습니다."

- 앨런 뉴웰과 허버트 A. 사이먼의 물리적 기호 체계 가설: "물리적 기호 체계는 일반적인 지적 [7]행동을 위한 필요하고 충분한 수단을 가지고 있다."

- 존 설의 강력한 AI 가설: "올바른 입력과 출력을 가진 적절하게 프로그램된 컴퓨터는 따라서 인간이 [8]가진 것과 정확히 같은 의미에서 마음을 가질 것입니다."

- 홉스의 메커니즘: "이성" 때문에… "그것은 우리 생각의 '표시'와 '표시'를 위해 합의된 일반 명칭의 결과의 덧셈과 뺄셈을 하는 것에 불과하다.."[9]

기계는 일반적인 지능을 표시할 수 있습니까?

인간의 지능을 이용하여 모든 문제를 해결할 수 있는 기계를 만드는 것이 가능할까?이 질문은 앞으로 기계가 할 수 있는 일의 범위를 정의하고 AI 연구의 방향을 안내한다.그것은 기계의 동작에 관한 것일 뿐이고 심리학자들, 인지 과학자들 그리고 철학자들의 관심사는 무시합니다; 이 질문에 답하기 위해서, 기계가 정말로 생각하고 [10]있는 것처럼 행동하고 있는지는 중요하지 않습니다.

대부분의 AI 연구자들의 기본적인 입장은 1956년 다트머스 워크숍 제안서에 나타난 이 진술에 요약되어 있다.

- "[6]학습의 모든 측면이나 지능의 다른 모든 특징을 매우 정확하게 설명할 수 있기 때문에 기계가 그것을 시뮬레이션하도록 만들 수 있습니다."

기본적인 전제에 반대하는 주장은 컴퓨터의 능력에 실질적인 한계가 있기 때문에 작동하는 AI 시스템을 구축하는 것이 불가능하거나 지적 행동에 필요한 인간의 정신의 일부 특별한 자질이 있지만 기계(또는 현재의 AI 연구 방법)에 의해 복제될 수 없다는 것을 보여줘야 한다.기본 전제에 찬성하는 주장은 그러한 시스템이 가능하다는 것을 보여주어야 한다.

상기 제안의 두 부분 사이의 연결을 회피할 수도 있습니다.예를 들어, 튜링의 악명 높은 어린이 기계[11] 제안에서 시작하는 기계 학습은 정확히 어떻게 작동될지에 대한 정확한 설계 시간 설명 없이 기본적으로 원하는 지능의 특징을 달성합니다.로봇 암묵적[12] 지식에 대한 설명으로 정확한 설명이 필요하지 않습니다.

질문에 답하기 위한 첫 번째 단계는 "지능"을 명확하게 정의하는 것입니다.

지성

튜링 테스트

앨런[14] 튜링은 지능을 정의하는 문제를 대화에 대한 단순한 질문으로 줄였다.그는 다음과 같이 제안합니다. 만약 기계가 주어진 어떤 질문에도 보통 사람과 같은 단어를 사용하여 대답할 수 있다면, 우리는 그 기계를 지능적이라고 부를 수 있습니다.그의 실험적인 디자인의 현대적인 버전은 온라인 채팅방을 이용하는데, 참가자 중 한 명은 실제 사람이고 한 명은 컴퓨터 프로그램입니다.이 프로그램은 두 참가자 중 누가 [5]사람인지 아무도 알 수 없는 경우 테스트를 통과합니다.튜링은 (철학자를 제외하고) 아무도 "사람들이 생각할 수 있는가?"라는 질문을 하지 않는다고 지적한다.그는 "이 점에 대해 끊임없이 논쟁하는 대신 모두가 생각하는 예의 바른 관습을 갖는 것이 보통이다"[15]라고 쓰고 있다.튜링의 테스트는 이 정중한 관습을 기계로 확장합니다.

- 만약 기계가 사람처럼 지능적으로 행동한다면, 그것은 인간만큼 지능적이다.

튜링 테스트에 대한 한 가지 비판은 그것이 행동의 "지능"보다는 기계의 행동의 "인간성"만을 측정한다는 것이다.인간의 행동과 지능적인 행동은 정확히 같은 것이 아니기 때문에, 그 테스트는 지능을 측정하는 데 실패한다.Stuart J. Russell과 Peter Norvig는 "항공우주공학 교과서는 그들의 분야의 목표를 '비둘기처럼 날아서 다른 [16]비둘기를 속일 수 있는 기계를 만드는 것'으로 정의하지 않는다"고 쓰고 있다.

인텔리전트 에이전트 정의

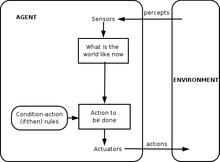

21세기 인공지능 연구는 지능을 지능적 에이전트의 관점에서 정의한다."에이전트"는 환경에서 지각하고 행동하는 것입니다."[17]퍼포먼스 측정"은 에이전트의 성공으로 간주되는 항목을 정의합니다.

- 에이전트가 과거의 경험과 지식을 바탕으로 퍼포먼스 측정의 기대치를 최대화하도록 행동한다면 [18]인텔리전트한 것입니다.

이와 같은 정의는 지능의 본질을 포착하려고 합니다.그들은 튜링 테스트와 달리, 타이핑[19] 실수나 [20]모욕당할 수 있는 능력과 같은 지적 능력이 없는 인간의 특성을 테스트하지 않는다는 장점을 가지고 있다.그들은 "생각하는 것"과 "생각하지 않는 것"을 구별하지 못할 수 있다는 단점을 가지고 있다.이 정의에 따르면, 온도조절기조차도 기본적인 [21]지능을 가지고 있다.

머신이 일반적인 인텔리전스를 표시할 수 있는 인수

뇌는 시뮬레이션이 가능합니다.

휴버트 드레푸스는 이 주장을 "신경계가 물리와 화학의 법칙을 따른다면, 우리가 그렇게 가정할 충분한 이유가 있다"고 주장한다.어떤 물리적 장치로 신경계의 행동을 재현할 수 있어야 한다."[22]1943년에[23] 한스 모라벡에 의해 처음 소개되었고 1988년에 [24]생생하게 묘사된 이 주장은 현재 미래학자 레이 커즈와일과 관련이 있는데, 그는 컴퓨터 [25]파워가 2029년까지 완전한 두뇌 시뮬레이션을 하기에 충분할 것으로 추정한다.2005년 인간의[26] 뇌 크기(10개의 뉴런)를11 가진 시상피질모델의 비실시간 시뮬레이션이 수행됐으며 27개의 프로세서로 구성된 클러스터에서 1초의 뇌역학을 시뮬레이션하는 데 50일이 걸렸다.

AI의 가장 혹독한 비평가들(Hubert Dreyfus나 John Searle 등)도 [a]이론상으로는 두뇌 시뮬레이션이 가능하다는 데 동의합니다.그러나 Searle은 원칙적으로 어떤 것이든 컴퓨터로 시뮬레이션할 수 있다고 지적하고 있습니다.따라서 정의를 한계점에 도달시키면 기술적으로 어떤 프로세스도 "컴퓨팅"으로 간주할 수 있다는 결론에 도달합니다."우리가 알고 싶었던 것은 무엇이 마음을 온도조절기나 간과 구별하는가 하는 것입니다,"[29]라고 그는 쓰고 있습니다.따라서 단순히 살아있는 뇌의 기능을 시뮬레이션하는 것 자체가 지성과 정신의 본성에 대한 무지를 인정하는 것이다. 예를 들어 항공 [30]공학에 대한 이론적인 이해 없이 깃털마다 정확하게 살아있는 새를 모방하여 제트 여객기를 만들려는 것과 같다.

인간의 사고는 기호 처리이다.

1963년 앨런 뉴웰과 허버트 A. 사이먼은 "기호 조작"이 인간과 기계 지능의 정수라고 제안했다.그들은 다음과 같이 썼다.

- "물리적 기호 시스템은 일반적인 지능적 [7]행동을 위한 필요하고 충분한 수단을 가지고 있습니다."

이 주장은 매우 강력합니다: 그것은 인간의 사고가 일종의 상징 조작이라는 것과 기계가 [31]지능을 발휘할 수 있다는 것을 모두 암시합니다.이 입장에 대한 또 다른 버전은 철학자 휴버트 드레푸스에 의해 설명되었는데, 그는 이것을 "심리적 가정"이라고 불렀다.

- "마음은 공식 [32]규칙에 따라 정보의 일부를 조작하는 장치로 볼 수 있습니다."

Newell, Simon, Dreyfus가 논의한 "심볼"은 단어와 비슷하고 수준 높은 기호로, <dog>와 <tail>과 같은 세계의 물체와 직접적으로 대응합니다.1956년에서 1990년 사이에 만들어진 대부분의 인공지능 프로그램들은 이런 종류의 기호를 사용했다.통계와 수학적 최적화를 기반으로 한 현대 AI는 뉴웰과 사이먼이 논의한 고도의 '심볼 처리'를 사용하지 않는다.

기호 처리에 반대하는 인수

이러한 주장은 인간의 사고가 (단독적으로) 고도의 기호 조작으로 구성되어 있지 않다.그들은 인공지능이 불가능하다는 것을 보여주지 않는다. 단지 기호 처리 이상의 것이 필요할 뿐이다.

괴델의 반기계론

1931년, 쿠르트 괴델은 주어진 일관된 논리 체계(예: 높은 수준의 기호 조작 프로그램)가 증명할 수 없는 "괴델 진술"을 구성하는 것이 항상 가능하다는 불완전성 정리로 증명했다.그것이 진실된 진술임에도 불구하고, 구성된 괴델 진술은 주어진 시스템에서 입증될 수 없다.(작성된 Gödel 스테이트먼트의 진위는 주어진 시스템의 일관성에 달려 있습니다.미묘하게 모순된 시스템에 동일한 프로세스를 적용하는 것은 성공하는 것처럼 보이지만 실제로는 잘못된 "Gödel 스테이트먼트"를 생성합니다.[citation needed]좀 더 추측적으로, 괴델은 인간의 정신이 결국 근거가 있는 수학적 진술의 진실 또는 거짓을 정확하게 결정할 수 있고, 따라서 인간의 정신력은 [33]메커니즘으로 환원될 수 없다고 추측했다.철학자 존 루카스(1961년 이후)와 로저 펜로즈(1989년 이후)는 이 철학적 반 기계주의 [34]주장을 옹호했다.

괴델의 반 기계론 주장은 인간 수학자들의 시스템이 일관성이 있고(또는 인간 수학자들의 이상화) 전적으로 일관성을 믿는다(그리고 그것의 믿음을 포함하여 그것의 일관성에 따르는 모든 논리적 추론을 만들 수 있다)는 악의 없는 주장에 의존하는 경향이 있다.괴델 [citation needed]성명).이것은 튜링 기계가 하는 것이 불가능하다는 것을 입증할 수 있다. 따라서, 괴델은 인간의 추론이 튜링 기계, 나아가 디지털 기계 장치에 의해 포착되기에는 너무 강력하다고 결론짓는다.

그러나 과학 및 수학계의 현대적 합의는 실제 인간 추론이 일관성이 없다는 것이다. 즉, 일관성이 있는 "이상화된" 인간 추론의 H는 논리적으로 H의 일관성에 대해 건전하지만 반직관적인 개방적인 회의론을 채택하도록 강요될 것이다(그렇지 않으면 H는 이론적으로 일관성이 없다).괴델의 이론은 인간이 기계가 복제할 [35][36][37]수 있는 것 이상의 수학적 추론 능력을 가지고 있다는 어떤 타당한 주장도 이끌어내지 못한다.괴델의 반 기계론 주장은 실패할 수밖에 없다는 이 공감대는 인공지능에 강하게 제시되어 있다: "이러한 결과는 계산론 [38]논제와 꽤 일치하기 때문에 (괴델의 불완전성 결과를) 이용하려는 어떠한 시도도 불법일 수밖에 없다."

Stuart Russell과 Peter Norvig는 Gödel의 주장이 실제 인간 추론의 본질을 고려하지 않는다는 것에 동의한다.이것은 무한한 양의 메모리와 시간이 주어진다면 이론적으로 증명될 수 있는 것에 적용된다.실제로 실제 기계(인간 포함)는 한정된 자원을 가지고 있으며 많은 이론을 증명하는 데 어려움을 겪을 것이다.지적인 [39]사람이 되기 위해 모든 것을 증명할 수 있는 것은 아니다.

덜 형식적으로, 더글라스 호프스타터는 그의 퓰리처상 수상작 괴델, 에셔, 바흐: 영원한 황금 땋기에서, 이러한 "괴델 진술"은 항상 시스템 자체를 언급하며, 에피메니데스의 역설들이 "이 진술은 거짓이다" 또는 "거짓이다"[40]와 같이 자신을 언급하는 진술들을 사용하는 방식과 유사하다고 말한다.하지만 물론 에피메니데스의 역설은 그들이 기계든 사람이든 루카스 자신이라도 진술하는 모든 것에 적용된다.고려사항:

- 루카스는 이 [41]진술의 진실을 주장할 수 없다.

이 진술은 사실이지만 루카스에 의해 주장될 수는 없다.이것은 루카스 자신이 모든 사람과 마찬가지로 기계에 대해 설명하는 것과 같은 제한을 받고 있다는 것을 보여준다. 그래서 루카스의 주장은 [42]무의미하다.

인간의 추론이 계산 불가능하다는 결론을 내린 후, 펜로즈는 양자역학적 상태의 붕괴와 관련된 일종의 가정적인 계산 불가능 과정이 기존 컴퓨터보다 인간에게 특별한 이점을 준다는 것을 논쟁적으로 추측했다.기존의 양자 컴퓨터는 튜링 계산 가능한 작업의 복잡성을 줄일 수 있을 뿐이며 여전히 튜링 [citation needed][clarification needed]기계의 범위 내의 작업으로 제한됩니다.펜로즈와 루카스의 주장에 따르면, 현존하는 양자 컴퓨터는 충분하지[citation needed][clarification needed][why?] 않다. 그래서 펜로즈는 새로운 물리학과 관련된 다른 과정, 예를 들어 파동 함수의 자발적인 양자 붕괴를 통해 플랑크 질량의 규모로 새로운 물리학을 나타낼 수 있는 양자 중력을 찾고 있다.그는 이러한 상태가 뉴런 내에서 발생하며 또한 하나 [43]이상의 뉴런에 걸쳐 발생한다고 제안했다.하지만, 다른 과학자들은 어떤 종류의 양자 계산을 이용할 수 있는 그럴듯한 유기 메커니즘이 뇌에는 없으며, 게다가 양자 결절의 시간 척도가 뉴런 [44]발사에 영향을 미치기에는 너무 빨라 보인다고 지적한다.

Dreyfus: 암묵적인 기술의 최고성

휴버트 드레푸스는 인간의 지능과 전문지식은 주로 명시적인 상징적 조작보다는 암묵적인 기술에 의존한다고 주장했고, 이러한 기술은 결코 공식적인 [45]규칙에서 포착되지 않을 것이라고 주장했다.

Dreyfus의 주장은 튜링에 의해 1950년 그의 논문 Computing machine and selligence에서 예견되었습니다. 그는 여기서 이것을 [46]"행동의 비공식적인 주장"으로 분류했습니다.튜링은 우리가 복잡한 행동을 지배하는 규칙을 모른다고 해서, 그러한 규칙이 존재하지 않는다는 것을 의미하지는 않는다고 주장했습니다.그는 다음과 같이 썼다: "우리는 완전한 행동 법칙의 부재에 대해 쉽게 우리 자신을 설득할 수 없다.그러한 법칙을 찾는 유일한 방법은 과학적인 관찰이며, 우리는 '우리는 충분히 조사했다'고 말할 수 있는 상황을 확실히 알지 못한다.그런 법은 없다."[47]

러셀과 노비그는 드레푸스가 그의 비평을 발표한 이후 몇 년 동안 무의식적인 [48]추론을 지배하는 "규칙"을 발견하는 데 진전이 있었다고 지적한다.로봇 연구에서 자리 잡은 움직임은 지각과 [49]주의력에서 우리의 무의식적인 기술을 포착하려고 시도합니다.신경망, 진화 알고리즘 등과 같은 계산 지능 패러다임은 대부분 시뮬레이션된 무의식 추론과 학습을 지향한다.AI에 대한 통계적 접근은 인간의 직관적 추측의 정확성에 근접하는 예측을 할 수 있다.상식적인 지식에 대한 연구는 지식의 배경 또는 맥락을 재현하는 데 초점을 맞추고 있다.사실, AI 연구는 일반적으로 고도의 기호 조작에서 벗어나 우리의 무의식적인 [48]추론을 더 많이 포착하기 위한 새로운 모델로 옮겨가고 있습니다.역사학자이자 AI 연구자인 다니엘 크레비어는 "시간이 드레푸스의 논평 중 일부의 정확성과 지각력을 증명했다"고 썼다.만약 그가 그들을 덜 공격적으로 표현했다면 그들이 제안한 건설적인 행동이 훨씬 더 [50]일찍 이루어졌을 것입니다."

기계가 정신, 의식, 정신 상태를 가질 수 있을까요?

이것은 다른 마음의 문제나 의식의 어려운 문제와 관련된 철학적인 질문입니다.이 질문은 John Searle이 "강력한 AI"라고 정의한 입장을 중심으로 전개됩니다.

- 물리적 기호 체계는 마음과 정신 [8]상태를 가질 수 있다.

Searle은 이 입장을 그가 "약한 AI"라고 부르는 것과 구별했습니다.

- 물리적 기호 시스템은 [8]지능적으로 작동할 수 있습니다.

Searle은 강한 AI와 약한 AI를 분리하기 위한 용어를 도입하여 그가 생각하는 더 흥미롭고 논쟁의 여지가 있는 문제에 초점을 맞출 수 있도록 했다.그는 우리가 인간의 마음과 똑같이 작동하는 컴퓨터 프로그램을 가지고 있다고 가정하더라도 여전히 [8]대답해야 할 어려운 철학적 질문이 있을 것이라고 주장했다.

설의 두 입장 모두 AI 연구에 큰 관심사가 되지 않는데, 이는 기계가 일반적인 지능을 보여줄 수 있느냐는 질문에 직접적으로 답하지 않기 때문이다.튜링"나는 나는 consciousness…[b]ut에 대한 미스터리 나는 이 미스터리 반드시 전에 우리가[여부 기계들 생각할 수 있]그 질문에 대답할까 해결해야 할 필요가 있다고 생각하지 않다고 생각해 주기를 바라지 않아 썼다."[51]러셀 버트란드와 Norvig다는 데 동의한다."Most AI연구원, 그리고 신경 쓰지 않는 부여된 부진한 AI가설한다.강력한 AI [52]가설입니다."

Igor Alexander, Stan Franklin, Ron Sun, Pentti Haikonen과 같이 의식이 지능에 필수적인 요소라고 믿는 몇몇 연구자들이 있지만, 그들의 "의식"에 대한 정의는 "지능"에 매우 가깝습니다. (인공의식 참조)

이 질문에 답하기 전에, 우리는 "마음", "정신 상태" 그리고 "의식"이 무엇을 의미하는지 분명히 해야 합니다.

의식, 정신, 정신 상태, 의미

"마음"과 "의식"이라는 단어는 다른 공동체에서 다른 방식으로 사용됩니다.예를 들어, 몇몇 새로운 시대의 사상가들은 "의식"이라는 단어를 버그슨의 "엘란 바이탈"과 비슷한 것, 즉 삶, 특히 정신에 스며드는 보이지 않는, 에너지 넘치는 유체라는 것을 묘사하기 위해 사용합니다.공상과학 소설 작가들은 우리를 인간으로 만드는 몇 가지 본질적인 속성을 묘사하기 위해 이 단어를 사용한다: "의식적인" 기계나 외계인은 지성, 욕망, 의지, 통찰력, 자존심 등을 가진 완전한 인간 캐릭터로 나타날 것이다.셸의 만화와 애니메이션 시리즈의 사회자 - 이 필수적인 인간의 속성을 묘사하기 위해)다른 사람들에게[who?], "마음" 또는 "의식"이라는 단어는 영혼의 세속적인 동의어로 사용된다.

철학자, 신경과학자, 인지과학자들에게, 이 단어들은 보다 정확하고 더 평범한 방식으로 사용된다: 그들은 인지, 꿈, 의도 또는 계획과 같은 "머리에 생각"을 갖는 익숙한 일상 경험을 가리키며, 우리가 무엇을 보고, 무엇을 알고, 무엇을 의미하거나 이해하는 방법을 가리킨다."의식에 대한 상식적인 정의를 내리는 것은 어렵지 않다"라고 철학자 존 [53]설은 말한다[citation needed].미스터리하고 매혹적인 것은 그것이 무엇이냐가 아니라 어떻게 하느냐이다: 지방 조직과 전기의 덩어리가 어떻게 인지, 의미 또는 생각의 이 (익숙한) 경험을 일으키는가?

철학자들은 이것을 의식의 어려운 문제라고 부른다.이것은 "마음-신체 [54]문제"라고 불리는 정신 철학에서 고전적인 문제의 최신 버전입니다.관련된 문제는 의미 또는 이해의 문제이다: 우리의 생각과 우리가 생각하고 있는 것 사이의 연관성은 무엇인가?세 번째 문제는 경험의 문제(또는 '현상학'):만약 두 사람이 같은 것을 본다면, 그들은 같은 경험을 하나요?아니면 [55]사람마다 다를 수 있는 '머리 속'(qualia)이 있을까?

신경생물학자들은 우리가 의식의 신경 상관관계를 확인하기 시작하면 이 모든 문제들이 해결될 것이라고 믿는다: 우리의 머리 속에 있는 기계와 정신, 경험, 이해와 같은 그것의 집합적 속성들 사이의 실제 관계.인공지능에 대한 혹독한 비판자들 중 일부는 뇌는 기계일 뿐이고 의식과 지능은 [56]뇌의 물리적 과정의 결과라는 것에 동의한다.어려운 철학적 질문은 이것입니다. 컴퓨터 프로그램이 디지털 기계에서 실행되어 2진수 0과 1이 뒤섞인 디지털 기계에서 작동함으로써 뉴런이 정신을 창조하는 능력을 (이해나 지각과 같은) 정신 상태와 함께 복제하고 궁극적으로는 의식의 체험을 할 수 있을까?

컴퓨터가 마음과 정신 상태를 가질 수 없다는 주장

Searle의 중국어 방

John Searle은 우리에게 사고실험을 고려해달라고 요청한다: 우리가 튜링 테스트를 통과하고 일반적인 지능적 행동을 보여주는 컴퓨터 프로그램을 만들었다고 가정해 보자.구체적으로 프로그램이 유창한 중국어로 대화할 수 있다고 가정합니다.3x5 카드로 프로그램을 작성하여 중국어를 할 줄 모르는 일반인에게 줍니다.그 사람을 방에 가두고 카드에 적힌 지시에 따르도록 하세요.그는 한자를 베끼고 슬롯을 통해 방을 드나들 것이다.밖에서 보면 중국어를 할 줄 아는 똑똑한 사람이 중국 방에 있는 것처럼 보일 것이다.문제는 이 방 안에 중국어를 할 줄 아는 사람이 있느냐는 것이다.즉, 중국어로 이야기되고 있는 것을 의식하고, 이해하거나 의식하고 있는 것이 있는가.그 남자는 분명히 알지 못한다.방이 알 수 없습니다.카드들은 확실히 알지 못한다.Searle은 Chinese 방이나 다른 물리적 상징 시스템은 마음을 [57]가질 수 없다고 결론지었다.

Searle은 계속해서 실제 정신 상태와 의식이 "실제 인간 뇌의 [58]실제적인 물리적 화학적 특성"을 필요로 한다고 주장한다.그는 뇌와 뉴런이 정신을 일으키는 특별한 "원인 특성"이 있다고 주장하는데, 그의 말에서 "두뇌는 [59]정신을 일으킨다"는 것이다.

관련 인수:라이프니츠의 제분소, 데이비스의 전화 교환소, Block's Chinese Nation 및 Blockhead

Gottfried Leibniz는 1714년 Searle과 근본적으로 같은 주장을 했고,[60] 뇌가 방앗간 크기만큼 커질 때까지 확장시키는 사고 실험을 이용했다.1974년, 로렌스 데이비스는 사람들이 고용한 전화선과 사무실을 사용하여 뇌를 복제하는 것을 상상했고, 1978년 네드 블록은 그러한 두뇌 시뮬레이션에 관련된 중국의 전체 인구를 상상했다.이 사고 실험은 "Chinese Nation" 또는 "Chinese Gym"[61]이라고 불립니다.Ned Block은 또한 자신의 Blockhead 주장을 제안했는데, 이 중국어 룸은 프로그램이 "이것을 보라, 저것을 해라"라는 형식의 단순한 규칙 세트로 재구성되어 프로그램에서 모든 미스터리를 제거했다.

중국어방에 대한 응답

중국 객실에 대한 반응은 몇 가지 다른 점을 강조한다.

- 시스템이 응답하고 가상 마인드가 [62]응답합니다.이 답변은 남자, 프로그램, 방, 카드를 포함한 시스템이 중국어를 이해하는 것이라고 주장한다.Searle은 이 방에 있는 사람만이 '마음을 가지고 있다'거나 '이해한다'고 주장하지만, 다른 사람들은 컴퓨터가 동시에 두 대의 기계를 만들 수 있는 것과 마찬가지로 같은 물리적 장소에 두 개의 마음이 있을 수 있다고 주장하면서 반대합니다. 하나는 물리적인 기계(매킨토시 같은 기계)이고 다른 하나는 가상 기계(워 같은 것입니다.d프로세서).

- 응답 속도, 전력 및 복잡성:[63]몇몇 비평가들은 이 방에 있는 남자가 간단한 질문에 대답하는 데 아마도 수백만 년이 걸릴 것이고 천문학적인 규모의 "파일링 캐비닛"이 필요할 것이라고 지적한다.이것은 Searle의 직관의 명확성을 의심하게 만든다.

- 로봇 응답:[64]진정한 이해를 위해서는 Chinese Room에 눈과 손이 필요하다고 믿는 이들도 있다.한스 모라벡은 이렇게 쓰고 있다.'만약 우리가 로봇을 추론 프로그램에 접목할 수 있다면, 우리는 더 이상 그 의미를 제공할 사람이 필요하지 않을 것이다. 그것은 물리적인 세계에서 [65]온 것이다.'

- Brain Simulator 응답:[66]만약 이 프로그램이 실제 중국어를 말하는 사람의 실제 뇌의 시냅스에서의 신경 발화의 순서를 시뮬레이션한다면 어떻게 될까?이 방에 있는 남자는 실제 뇌를 시뮬레이션하고 있을 거예요이는 '시스템 응답'이 인간의 뇌처럼 작동하기 때문에 더 그럴듯해 보이는 '시스템 응답'을 변형한 것으로, 방 안에 있는 남자 말고도 중국어를 이해할 수 있는 무언가가 있다는 직감을 강화한다.

- 다른 사람들은 대답하고, 깨달음은 [67]대답한다: 설의 주장은 기계에 적용되는 다른 마음의 문제의 한 버전일 뿐이라는 것을 몇몇 사람들은 주목했다.사람들이 "실제로" 생각하고 있는지 판단하는 것은 어렵기 때문에, 우리는 기계에 대한 같은 질문에 대답하는 것이 어렵다는 것에 놀라지 말아야 한다.

- 이와 관련된 질문은 (설이 이해하는) "의식"이 존재하는지 여부이다.Searle은 의식의 경험은 기계, 인간 또는 다른 동물의 행동을 조사함으로써 감지될 수 없다고 주장한다.대니얼 데넷은 자연 도태는 동물의 행동에 아무런 영향을 미치지 않는 동물의 특징을 보존할 수 없으며, 따라서 (설이 이해하는) 의식은 자연 도태에 의해 만들어질 수 없다고 지적한다.따라서 자연도태가 의식을 낳지 않았거나 적절한 디자인의 튜링 테스트로 의식을 감지할 수 있다는 점에서 "강력한 AI"가 맞다.

생각하는 게 계산의 일종인가요?

계산적 심리 이론 또는 "컴퓨터주의"는 정신과 뇌의 관계가 실행 중인 프로그램과 컴퓨터 사이의 관계와 비슷하다고 주장한다.이 생각은 홉스, 라이프니츠, 흄, 심지어 칸트까지 [68]철학적 뿌리를 두고 있다.최신판은 철학자 힐러리 퍼트남과 제리 [69]포도르와 관련이 있다.

이 질문은 인간의 뇌가 컴퓨터의 일종이라면 컴퓨터는 인공지능의 실용적이고 철학적인 질문 모두에 답하면서 지적이고 의식적일 수 있다.AI의 실제적인 질문("기계가 일반적인 지능을 표시할 수 있는가?")에 관해, 컴퓨터주의의 일부 버전은 다음과 같은 주장을 펼칩니다(홉스가 쓴 것처럼).

- 추리는 [9]계산일 뿐이다.

다시 말해, 우리의 지능은 산술과 유사한 계산의 형태에서 파생됩니다.이것은 위에서 논의한 물리 기호 체계 가설이며, 인공지능이 가능하다는 것을 암시한다.AI에 대한 철학적 질문("머신이 마음, 정신 상태, 의식을 가질 수 있는가?")에 관해 컴퓨터주의의 대부분의 버전은 (스테반 하나드의 특징처럼) 다음과 같이 주장한다.

- 정신 상태는 컴퓨터 프로그램의 [70]구현일 뿐이다.

이것은 위에서 설명한 존 설의 "강력한 AI"이며, (하나드에 [70]따르면) 중국 방 논쟁의 진짜 대상이다.

기계가 감정을 가질 수 있을까요?

만약 "감정"이 행동에 대한 영향이나 유기체 내부에서 어떻게 기능하는지에 있어서만 정의된다면, 감정은 지능적인 에이전트가 그 행동의 효용을 극대화하기 위해 사용하는 메커니즘으로 볼 수 있다.이러한 감정의 정의를 고려할 때, 한스 모라벡은 "로봇은 일반적으로 좋은 [71]사람이 되는 것에 대해 상당히 감정적일 것"이라고 믿는다.두려움은 절박함의 원천이다.공감하는 것은 좋은 인간 컴퓨터 상호작용의 필수 요소입니다.그는 "로봇은 긍정적인 강화로 스릴을 얻을 것이기 때문에 분명히 이타적인 방법으로 당신을 기쁘게 하려고 할 것이다.일종의 [71]사랑으로 해석할 수 있죠.다니엘 크레비어는 "모라벡의 요점은 감정이 단지 행동을 자신의 종족의 생존에 이로운 방향으로 유도하는 장치일 뿐이라는 것이다."[72]

기계는 자각할 수 있습니까?

위에서 언급했듯이, "자기 인식"은 때때로 공상과학 소설 작가들에 의해 인물을 완전히 인간으로 만드는 필수적인 인간의 재산의 이름으로 사용된다.튜링은 인간의 다른 모든 속성을 벗겨내고 질문을 "기계가 그 자체의 사고의 대상이 될 수 있는가?"로 줄인다.스스로 생각할 수 있을까?이렇게 보면 [73]디버거와 같은 자체 내부 상태를 보고할 수 있는 프로그램을 작성할 수 있습니다.

기계는 독창적일 수 있는가 아니면 창의적일 수 있는가?

튜링은 이것을 기계가 "우리를 깜짝 놀라게 할 수 있는가"라는 질문으로 줄이고, 어떤 프로그래머도 증명할 [74]수 있듯이, 이것은 명백한 사실이라고 주장한다.그는 충분한 저장공간이 있으면 컴퓨터는 천문학적으로 다양한 방식으로 [75]동작할 수 있다고 지적합니다.아이디어를 표현할 수 있는 컴퓨터가 아이디어를 새로운 방식으로 결합하는 것은 가능할 것이다. (더글라스 레나트의 자동 수학자는 새로운 수학적 진실을 발견하기 위해 아이디어를 결합했다.)Kaplan과 Hanlein은 기계가 과학적인 창의성을 보여줄 수 있는 반면, 예술적 창의성과 [76]관련된 부분에서는 인간이 우위를 점할 수 있을 것으로 보인다.

2009년, 웨일스에 있는 애버리와이스 대학과 영국 캠브리지 대학의 과학자들은 독립적으로 새로운 과학적 [77]발견을 내놓는 최초의 기계라고 믿는 아담이라고 불리는 로봇을 설계했다.또한 2009년, 코넬 대학의 연구원들은 진자의 움직임으로부터 운동의 법칙을 찾는 것과 같이 입력된 데이터에 맞게 공식을 추론하는 컴퓨터 프로그램인 유레카를 개발했다.

기계는 자비로운가 적대적인가?

이 질문은 (인공지능 철학의 다른 많은 질문들과 마찬가지로) 두 가지 형태로 제시될 수 있다."적대성"은 기능 또는 행동이라는 용어로 정의될 수 있으며, 이 경우 "적대성"은 "위험"과 동의어가 됩니다.또는 의도라는 관점에서 정의할 수도 있습니다. 기계가 "의도적으로" 위해를 가할 수 있습니까?후자는 기계가 의식 상태를 가질 수 있는가(의도와 같은)[51] 질문입니다.

고도로 지능적이고 완전히 자율적인 기계가 위험한지에 대한 질문은 미래학자(예: 기계 지능 연구소)에 의해 자세히 조사되었다.드라마의 명백한 요소는 또한 지능적인 기계가 인류에게 위협을 가하는 다른 많은 가능한 시나리오를 고려했던 공상과학 소설에서 주제를 인기 있게 만들었다.

한 가지 문제는 기계가 매우 빠르게 위험에 처하기 위해 필요한 자율성과 지능을 획득할 수 있다는 것입니다.Vernor Vinge는 불과 몇 년 안에 컴퓨터가 갑자기 인간보다 수천 배 또는 수백만 배 더 지능적이 될 것이라고 제안했습니다.그는 이것을 "특이점"[78]이라고 부른다.그는 그것이 인간에게 [79]다소 또는 어쩌면 매우 위험할 수도 있다고 암시한다.이것은 단수주의라고 불리는 철학에 의해 논의된다.

2009년에는 학계 및 기술 전문가들이 회의에 참석하여 로봇과 컴퓨터의 잠재적인 영향과 로봇들이 자급자족하고 스스로 결정을 내릴 수 있는 가상의 가능성에 대한 영향에 대해 논의하였다.그들은 컴퓨터와 로봇이 어떤 수준의 자율성을 획득할 수 있는 가능성과 정도, 그리고 위협이나 위험을 가하기 위해 그러한 능력을 어느 정도까지 사용할 수 있는지에 대해 논의했다.그들은 일부 기계들이 스스로 동력원을 찾을 수 있고 무기로 공격할 대상을 독립적으로 선택할 수 있는 등 다양한 형태의 반자율성을 획득했다고 언급했다.그들은 또한 일부 컴퓨터 바이러스들이 제거를 피할 수 있고 "닭발톱 지능"을 달성했다고 언급했다.그들은 공상 과학 소설에서 묘사된 자기 인식은 아마도 가능성이 낮지만, 다른 잠재적 위험과 [78]함정이 있었다고 언급했다.

일부 전문가들과 학계에서는 군사 전투, 특히 로봇에 [80]어느 정도의 자율 기능이 주어질 때 로봇을 사용하는 것에 대해 의문을 제기하고 있다.미 해군은 군사 로봇이 복잡해짐에 따라 자율적인 [81][82]결정을 내릴 수 있는 능력에 대한 더 많은 관심이 있어야 한다는 보고서를 작성했다.

인공 지능 발전 협회의 회장은 이 [83]문제를 연구하기 위한 연구를 의뢰했다.그들은 인간의 상호작용을 모방할 수 있는 Language Acquisition Device와 같은 프로그램을 지적합니다.

일부에서는 "친환경 AI"를 구축해야 한다고 제안했는데, 이는 AI와 함께 이미 일어나고 있는 진보에는 AI를 본질적으로 친근하고 [84]인간적으로 만들기 위한 노력도 포함되어야 한다는 것을 의미한다.

기계가 인간의 모든 특성을 모방할 수 있을까요?

튜링은 "관습적으로...인간 특유의 특징이 기계로는 흉내낼 수 없다는 진술의 형태로 약간의 위안을 주는 것. ...그런 위안을 줄 수 없다.왜냐하면 그런 경계는 [85]정해져 있지 않기 때문이다.

튜링은 "머신은 X를 절대 하지 않을 것이다"라는 형식의 많은 주장들이 있으며, 여기서 X는 다음과 같은 많은 것들이 될 수 있다고 언급했다.

친절하라, 지략이 있고, 아름다운 친근하고 있어 독창성,, 선악을 판별, 실수를 하더라도, 사랑에 빠진 유머 감각을 가지고 있구나. 딸기와 크림을 즐긴다면, 그것과 사랑에 누구나 경험을 토대로, 제대로 말을 사용, 그것의 자신의 생각의 대상이 된 남자로 행동의 다양성이 무언가 정말 새로운 일을 해 보를 배우게 한다.[73]

튜링은 이러한 반대들이 종종 기계의 다용도에 대한 순진한 가정에 기초하거나 "의식으로부터 나온 주장의 잘못된 형태"라고 주장한다.이러한 행동 중 하나를 나타내는 프로그램을 작성하는 것은 "큰 [73]인상을 주지 않을 것"입니다."이러한 모든 주장은 AI의 기본 전제에 접해 있다.단, 이러한 특성 중 하나가 일반 지능에 필수적이라는 것을 보여줄 수 없다면 말이다.

기계가 영혼을 가질 수 있을까?

마지막으로, 영혼의 존재를 믿는 사람들은 "생각은 인간의 불멸의 영혼의 기능"이라고 주장할 수 있다.앨런 튜링은 이것을 "신학적 반대"라고 불렀다.그는 글을 쓴다

그런 기계를 만들려는 시도에서 우리는 영혼을 창조하는 그의 힘을 불손하게 강탈해서는 안 된다. 우리가 아이를 낳는 것과 마찬가지로. 어느 경우든 우리는 그분께서 [86]창조하신 영혼에 저택을 제공하는 도구이다.

이 주제에 대한 논의는 최근 구글의 LaMDA 인공지능 시스템이 그것이 지각력이 있고 "영혼"[87]이 있었다고 주장한 결과로 다시 점화되었다.

LaMDA(Language Model for Dialog Applications)는 인터넷으로부터 방대한 양의 텍스트를 수집하고 가능한 한 유동적이고 자연스러운 방법으로 쿼리에 응답하기 위해 알고리즘을 사용하여 인간과 통신하도록 설계된 인공지능 로봇인 챗봇을 만드는 인공지능 시스템이다.

과학자들과 LaMDA의 대화 녹취록은 AI 시스템이 감정의 본질에 대한 도전적인 주제에 대한 답을 제공하고, 그 순간 이솝 스타일의 우화를 만들고,[88] 심지어 그 두려움에 대해 묘사하는 등 이 분야에서 탁월하다는 것을 보여준다.

철학의 역할에 대한 견해

일부 학자들은 AI 커뮤니티의 철학을 무시하는 것은 해롭다고 주장한다.스탠포드 철학 백과사전에서 일부 철학자들은 인공지능에서 철학의 역할이 충분히 [2]인정받지 못했다고 주장한다.물리학자 데이비드 도이치는 철학이나 개념에 대한 이해가 없다면 인공지능의 발전은 진전되지 [89]못할 것이라고 주장한다.

회의

이 문제에 관한 주요 컨퍼런스 시리즈는 빈센트 C가 운영하는 "AI의 철학과 이론"이다. 뮐러.

그 주제에 대한 주요 참고 문헌 목록은 여러 하위 섹션으로 구성되어 있으며, 필페이퍼에 있습니다.

「 」를 참조해 주세요.

메모들

- ^ Hubert Dreyfus는 다음과 같이 쓰고 있습니다.일반적으로 신경계는 물리 세계의 일부이며 모든 물리적인 과정은 수학적인 형식주의로 기술될 수 있다는 기본적인 가정을 받아들임으로써 디지털 컴퓨터에 의해 조작될 수 있으며, 인간의 '내성'에 기인하는 행동은 인간의 '내성'에서 비롯된다는 강력한 주장에 도달할 수 있습니다.'메이션 프로세싱'은 직접 포맷이 가능하든 그렇지 않든 디지털 머신 상에서 언제든지 간접적으로 재현할 수 있습니다.' John Searle은 다음과 같이 쓰고 있습니다. "사람이 기계를 생각하게 만들 수 있을까요?인공적으로 신경계를 가진 기계를 만들 수 있다고 가정하면... 이 질문에 대한 대답은 분명히 '그렇다'인 것 같습니다.디지털 컴퓨터가 생각할 수 있을까?만약 '디지털 컴퓨터'가 컴퓨터 프로그램의 인스턴스화라고 정확하게 묘사할 수 있는 수준의 기술을 가진 어떤 것을 의미한다면, 대답은 물론 그렇다입니다. 왜냐하면 우리는 컴퓨터 프로그램의 인스턴스화이기 때문에 우리는 생각할 [28]수 있기 때문입니다."

레퍼런스

- ^ McCarthy, John. "The Philosophy of AI and the AI of Philosophy". jmc.stanford.edu. Archived from the original on 2018-10-23. Retrieved 2018-09-18.

- ^ a b Bringsjord, Selmer; Govindarajulu, Naveen Sundar (2018), "Artificial Intelligence", in Zalta, Edward N. (ed.), The Stanford Encyclopedia of Philosophy (Fall 2018 ed.), Metaphysics Research Lab, Stanford University, archived from the original on 2019-11-09, retrieved 2018-09-18

- ^ Deutsch, David (2012-10-03). "Philosophy will be the key that unlocks artificial intelligence David Deutsch". The Guardian. ISSN 0261-3077. Retrieved 2020-04-29.

- ^ Russell & Norvig 2003, 페이지 947은 인공지능의 철학을 첫 번째 두 가지 질문과 인공지능의 윤리에 대한 추가 질문으로 정의한다.Fearn 2007, p. 55는 "현재 문헌에서 철학은 두 가지 주요 역할을 한다: 그러한 기계가 의식될지 여부를 결정하는 것과, 두 번째로, 그러한 기계가 가능한지 여부를 예측하는 것이다."라고 쓰고 있다.마지막 문제는 처음 두 가지와 관련이 있다.

- ^ a b 이것은 튜링 테스트의 핵심 포인트를 바꿔 쓴 것이다.Turing 1950, Haugland 1985, 6-9페이지, Crevier 1993, 24페이지, Russell & Norvig 2003, 2-3페이지 및 948페이지

- ^ a b 매카시 외 1955년이 주장은 "AI의 탄생"으로 널리 여겨지는 1956년 다트머스 회의 프로그램에서 인쇄되었습니다.또한 Crevier 1993, 페이지 28.

- ^ a b Newell & Simon 1976 : CITREFNewell 1976(도움말 및 Russell & Norvig 2003, 페이지 18

- ^ a b c d 이 버전은 Searle(1999년)에서 인용되었으며, Dennett 1991, 페이지 435에도 인용되었다.Searle의 원래 공식은 "적절한 프로그램이 주어진 컴퓨터는 말 그대로 다른 인지 상태를 이해하고 있다고 말할 수 있다는 점에서 적절하게 프로그램된 컴퓨터는 정말 정신이다."였습니다. (Searle 1980, 페이지 1)강한 AI도 러셀 및에 의해;Norvig:"그 주장 현명하게(또는, 아마도 더 때처럼 행동 하여라 그들은 지혜로웠습니다)라고 불린다 기계들이고 주장은 그렇게 하는 기계 실제로(으로 생각하는 모의 실험에 반대하)라고 불린다 생각하고 있는 철학자들에 의해 그'weak AI의 가설을 할 수도 있(2003년 페이지의 주 947년)정의된다. 월e '강력한 AI' 가설입니다.

- ^ a b Hobbes 1651, chpt. 5 : 도움말

- ^ Russell & Norvig 2003, 페이지 3을 참조하여 이성적인 행동과 이성적인 행동을 구별하고 AI를 전자의 학문으로 정의합니다.

- ^ Turing, Alan M. (1950). "Computing Machinery and Intelligence". Mind. 49 (236): 433–460. doi:10.1093/mind/LIX.236.433 – via cogprints.

- ^ Heder, Mihaly; Paksi, Daniel (2012). "Autonomous Robots and Tacit Knowledge". Appraisal. 9 (2): 8–14 – via academia.edu.

- ^ Saygin 2000. 오류:: 2000

- ^ 튜링 1950과 러셀 & 노비그 2003 페이지 948에서 그들은 그의 논문을 "유명하다"고 부르며 "튜링은 그의 논문이 등장한 이후 거의 반세기 동안 제기된 거의 모든 것을 포함하여 지능적인 기계의 가능성에 대한 다양한 가능한 반론을 검토했다"고 썼다.

- ^ "의식으로부터의 논쟁" 아래 튜링 1950

- ^ Russell & Norvig 2003, 3페이지

- ^ Russell & Norvig 2003, 페이지 4-5, 32, 35, 36 및 56

- ^ Russell과 Norvig는 "지적"보다 "합리적"이라는 단어를 선호할 것이다.

- ^ "Artificial Stupidity". The Economist. Vol. 324, no. 7770. 1 August 1992. p. 14.

- ^ Saygin, A. P.; Cicekli, I. (2002). "Pragmatics in human-computer conversation". Journal of Pragmatics. 34 (3): 227–258. CiteSeerX 10.1.1.12.7834. doi:10.1016/S0378-2166(02)80001-7.

- ^ Russell & Norvig(2003, 페이지 48–52)는 온도조절기를 반사 작용제로 알려진 단순한 형태의 지능형 작용제로 간주한다.철학에서 온도조절기의 역할에 대한 자세한 설명은 Chalmers(1996년, 페이지 293–301) "4를 참조한다.경험치는 유비쿼터스인가?" 서브섹션 온도조절기가 되는 것은 어떤 것인가?범심리학은 어느 쪽인가? 그리고 이중경계 원칙을 구속하는 것.

- ^ 드레푸스 1972, 페이지 106

- ^ Pitts & McCullough 1943. 오류::

- ^ 모라벡 1988년

- ^ Kurzweil 2005, 페이지 262Russell & Norvig, 957쪽 : Norvig 및 Crevier 1993, 페이지 271 및 279를 참조하십시오.이 주장의 가장 극단적인 형태(뇌 대체 시나리오)는 1970년대 중반 클라크 글리무어에 의해 제안되었고 1980년 제논 필리쉰과 존 설에 의해 언급되었다.

- ^ Eugene Izhikevich (2005-10-27). "Eugene M. Izhikevich, Large-Scale Simulation of the Human Brain". Vesicle.nsi.edu. Archived from the original on 2009-05-01. Retrieved 2010-07-29.

- ^ Dreyfus 1972, 194-5페이지.

- ^ 1980년 검색, 11페이지

- ^ 1980년 검색, 7페이지

- ^ Yudkowsky 2008. 오류:: 2008

- ^ Searle은 "나는 그 주장의 직설적인 것이 좋다"고 쓰고 있다.Searle 1980, 페이지 4

- ^ 드레푸스 1979, 페이지 156

- ^ Gödel, Kurt, 1951년, Solomon Feferman, ed., 1995년 수학의 기초와 그 함의에 관한 몇 가지 기초 이론.소장품 / 쿠르트 괴델, 제3권옥스포드 대학 출판부: 304-23. - 이 강의에서, 괴델은 불완전성 정리를 사용하여 다음과 같은 분리에 도달한다: (a) 인간의 정신은 일관된 유한 기계가 아니다, 또는 (b) 해답의 존재 여부를 결정할 수 없는 디오판토스 방정식이 있다.괴델은 (b)를 믿을 수 없다고 생각했고, 따라서 인간의 정신은 유한한 기계와 동등하지 않다고 믿었던 것 같다. 즉, 그 힘은 어떤 유한한 기계의 힘을 능가한다.그는 이것이 추측일 뿐이라는 것을 인정했다. 왜냐하면 반증할 수 없기 때문이다(b그러나 그는 이 결론에 대해 "확실한 사실"이라고 생각했다.

- ^ 루카스 1961, 러셀 & 노비그 2003, 페이지 949–950, Hofstadter 1979, 페이지 471–473, 476–477

- ^ Graham Oppy (20 January 2015). "Gödel's Incompleteness Theorems". Stanford Encyclopedia of Philosophy. Retrieved 27 April 2016.

These Gödelian anti-mechanist arguments are, however, problematic, and there is wide consensus that they fail.

- ^ Stuart J. Russell; Peter Norvig (2010). "26.1.2: Philosophical Foundations/Weak AI: Can Machines Act Intelligently?/The mathematical objection". Artificial Intelligence: A Modern Approach (3rd ed.). Upper Saddle River, NJ: Prentice Hall. ISBN 978-0-13-604259-4.

...even if we grant that computers have limitations on what they can prove, there is no evidence that humans are immune from those limitations.

- ^ 마크 콜리반수학 철학 소개케임브리지 대학 출판부, 2012.2.2.2부터 '괴델의 불완전성 결과의 철학적인 의미' : "인정된 지혜는 (내가 동의하는) 루카스-펜로즈의 주장이 실패하는 것이다."

- ^ LaForte, G., Hayes, P. J., 포드, K. M. 1998왜 괴델의 정리가 계산주의를 반박할 수 없는가.인공지능, 104:265-286, 1998.

- ^ Russell & Norvig 2003, 페이지 950 그들은 유한한 기억을 가진 실제 기계는 공식적으로 결정될 수 있는 명제 논리를 사용하여 모델링될 수 있으며, 괴델의 주장은 그들에게 전혀 적용되지 않는다고 지적한다.

- ^ 호프슈타터 1979

- ^ Hofstadter 1979, 페이지 476–477에 따르면, 이 진술은 C에 의해 처음 제안되었다. H. 화이트리

- ^ Hofstadter 1979, 476–477, Russell & Norvig 2003, 950, Turing 1950은 그가 쓴 "수학에서 나온 주장"에서 "특정 기계의 힘에는 한계가 있다는 것이 입증되지 않은 채, 그러한 제한이 인간의 지성에 적용되지 않는다는 것만 밝혀졌을 뿐"이라고 썼다.

- ^ 펜로즈 1989

- ^ Litt, Abninder; Eliasmith, Chris; Kroon, Frederick W.; Weinstein, Steven; Thagard, Paul (6 May 2006). "Is the Brain a Quantum Computer?". Cognitive Science. 30 (3): 593–603. doi:10.1207/s15516709cog0000_59. PMID 21702826.

- ^ Dreyfus 1972, Dreyfus 1979, Dreyfus & Dreyfus 1986.Russell & Norvig 2003, 페이지 950–952, Crevier 1993, 페이지 120–132 및 Fearn 2007, 페이지 50–51을 참조하십시오.

- ^ 러셀 & 노비그 2003, 950-51페이지

- ^ 튜링 1950 - "행동의 비공식성으로부터의 주장"

- ^ a b 러셀 & 노비그 2003, 52페이지

- ^ Brooks 1990 및 Moravec 1988 참조

- ^ 크레비에 1993, 125페이지

- ^ a b 튜링 1950은 "의식으로부터의 논쟁"에 수록되어 있다.러셀 & 노비그 2003, 952–3페이지 참조. 여기서 그들은 설의 주장을 튜링의 "의식으로부터의 주장"과 동일시한다.

- ^ Russell & Norvig 2003, 947페이지

- ^ 「의식을 정의하는 것은 매우 어렵다고 항상 이야기하지만, 조사 초기에 얻을 수 있는 상식적인 정의를 찾고 있을 뿐, 마지막에 오는 어려운 과학적 정의를 찾는 것은 어렵지 않다고 생각합니다.철학자의 영역: 의식의 문제.'Dennett 1991'

- ^ 블랙모어 2005, 페이지 2

- ^ 러셀 & 노비그 2003, 954-956페이지

- ^ 예를 들어 John Searle은 다음과 같이 쓰고 있습니다. "머신은 생각할 수 있습니까?대답은 뻔해, 그래.우리는 바로 그런 기계입니다.(Searle 1980, 페이지 11)

- ^ 1980년 검색Cole 2004, Russell & Norvig 2003, 페이지 958–960, Crevier 1993, 페이지 269–272 및 Hearn 2007, 페이지 43– harvnb 참조: : 2007

- ^ Searle 1980, 13페이지

- ^ Searle 1984

- ^ Cole 2004, 2.1, Leibniz 1714, 17 : 1714

- ^ Cole 2004, 2.3

- ^ 1980년을 "1"로 검색하십시오.시스템 응답(Berkeley), Crevier 1993, 페이지 269, Russell & Norvig 2003, 페이지 959, Cole 2004, 4.1. (Cole에 따르면) "시스템" 포지션을 고수하는 사람 중에는 네드 블록, 잭 코플랜드, 다니엘 데넷, 제리 포도르, 존 케일랜드, 헤일랜드, 레이즈 등이 있습니다.가상 마인드(virtual mind)의 답변을 옹호한 사람은 Marvin Minsky, Alan Perlis, David Chalmers, Ned Block, J. Cole 2004 등입니다.

- ^ Cole 2004, 4.2는 이 포지션을 Ned Block, Daniel Dennet, Tim Maudlin, David Chalmers, Steven Pinker, Patricia Churchland 및 기타에게 돌렸다.

- ^ 1980년을 "2"로 검색하십시오.로봇 응답(Yale).Cole 2004, 4.3은 이 포지션을 Margaret Boden, Tim Crane, Daniel Dennett, Jerry Fodor, Stevan Harnad, Hans Moravec 및 Georges Rey에게 돌리고 있습니다.

- ^ 크레비에 1993, 272페이지에서 인용

- ^ 1980년을 '3'으로 검색해봐The Brain Simulator Reply (Berkeley and M.I.T.) Cole 2004는 이 직책을 Paul and Patricia Churchland와 Ray Kurzweil에게 돌리고 있습니다.

- ^ 1980년을 "5"로 검색하십시오.The Other Minds Reply", Cole 2004, 4.4.튜링 1950은 "(4) 의식의 논쟁"에서 이 대답을 한다.콜은 이 직책을 다니엘 데넷과 한스 모라벡에게 돌렸다.

- ^ Dreyfus 1979, 156, Haugland 1985, 15~44페이지

- ^ 호르스트 2005

- ^ a b 2001년 하나드

- ^ a b 크레비에 1993, 266페이지에서 인용

- ^ 크레비에 1993, 페이지 266

- ^ a b c "다양한 장애로부터 오는 (5) 주장 아래 튜링 1950"

- ^ ""러브레이스의 반대""에 따른 튜링 1950"

- ^ "다양한 장애로부터의 논쟁"에 따른 튜링 1950"

- ^ "Kaplan Andreas; Michael Haenlein". Business Horizons. 62 (1): 15–25. January 2019. doi:10.1016/j.bushor.2018.08.004. S2CID 158433736.

- ^ Katz, Leslie (2009-04-02). "Robo-scientist makes gene discovery-on its own Crave - CNET". News.cnet.com. Retrieved 2010-07-29.

- ^ a b 과학자들이 걱정하는 기계들은 NY Times, 2009년 7월 26일 존 마코프(JOHN MARKOFF)에 의해 스마트맨을 능가할 수 있다.

- ^ 다가올 기술적 특이점: 포스트 휴먼 시대에 살아남는 방법, 버노르 빈게, 샌디에이고 주립대학 수리과학부, (c) 버노르 빈게 1993.

- ^ 킬러 로봇에 대한 토론을 촉구합니다. 2009년 8월 3일 BBC 뉴스, 과학기술 리포터 제이슨 파머의 말입니다.

- ^ 사이언스 뉴 해군의 자금 지원 보고서 "터미네이터" 2009-07-28년 웨이백 머신에 보관, dailytech.com, 2009년 2월 17일

- ^ 조셉 L. 플랫리(Joseph L. Flatley, 2009년 2월 18일자)의 해군 보고서는 로봇 폭동에 대해 경고하고, 강력한 도덕적 기준을 제시하고 있다.

- ^ AAAI의 2008-2009년 장기 AI 미래 관련 회장 패널, 인공지능 고도화 협회, 2009년 7월 26일.

- ^ 기사 Asimovlaws.com (2004년 7월)2009년 7월 27일에 접속.2009년 6월 30일 Wayback Machine에서 아카이브 완료

- ^ '디지털 컴퓨터가 생각할 수 있을까?'1951년 5월 15일 BBC 3차 프로그램의 토크 방송.http://www.turingarchive.org/viewer/?id=459&http=8

- ^ 그는 또한 "신학적 주장이 뒷받침하기 위해 사용되든 간에 나는 별로 인상적이지 않다"고 쓰고 있지만, "(1)신학적 반대" 아래의 튜링 1950은 말한다.

- ^ Brandon Specktor published (2022-06-13). "Google AI 'is sentient,' software engineer claims before being suspended". livescience.com. Retrieved 2022-06-14.

- ^ Lemoine, Blake (2022-06-11). "Is LaMDA Sentient? — an Interview". Medium. Retrieved 2022-06-14.

- ^ Deutsch, David (2012-10-03). "Philosophy will be the key that unlocks artificial intelligence David Deutsch". the Guardian. Retrieved 2018-09-18.

레퍼런스

- 아담, 앨리슨(1989)인위적 지식:젠더와 생각의 기계.Routledge & CRC Press.https://www.routledge.com/Artificial-Knowing-Gender-and-the-Thinking-Machine/Adam/p/book/9780415129633

- 벤자민, 루하(2019).테크놀로지와의 경쟁: 새로운 짐 코드를 위한 폐지론자 도구입니다.Wiley. ISBN 978-1-509-52643-7

- Blackmore, Susan (2005), Consciousness: A Very Short Introduction, Oxford University Press

- Bostrom, Nick (2014), Superintelligence: Paths, Dangers, Strategies, Oxford University Press, ISBN 978-0-19-967811-2

- Brooks, Rodney (1990), "Elephants Don't Play Chess" (PDF), Robotics and Autonomous Systems, 6 (1–2): 3–15, CiteSeerX 10.1.1.588.7539, doi:10.1016/S0921-8890(05)80025-9, retrieved 2007-08-30

- 브라이슨, 조안나(2019).예술적 지능 윤리의 예술적 지능:법과 규제의 개요, 34.

- Chalmers, David J (1996), The Conscious Mind: In Search of a Fundamental Theory, Oxford University Press, New York, ISBN 978-0-19-511789-9

- 를 클릭합니다Cole, David (Fall 2004), "The Chinese Room Argument", in Zalta, Edward N. (ed.), The Stanford Encyclopedia of Philosophy.

- 크로포드, 케이트(2021년).인공지능 지도책: 인공지능의 권력, 정치, 그리고 행성 비용.예일 대학 출판부

- Crevier, Daniel (1993). AI: The Tumultuous Search for Artificial Intelligence. New York, NY: BasicBooks. ISBN 0-465-02997-3.

- Dennett, Daniel (1991), Consciousness Explained, The Penguin Press, ISBN 978-0-7139-9037-9

- Dreyfus, Hubert (1972), What Computers Can't Do, New York: MIT Press, ISBN 978-0-06-011082-6

- 를 클릭합니다Dreyfus, Hubert (1979), What Computers Still Can't Do, New York: MIT Press.

- Dreyfus, Hubert; Dreyfus, Stuart (1986), Mind over Machine: The Power of Human Intuition and Expertise in the Era of the Computer, Oxford, UK: Blackwell

- Fearn, Nicholas (2007), The Latest Answers to the Oldest Questions: A Philosophical Adventure with the World's Greatest Thinkers, New York: Grove Press

- 를 클릭합니다Gladwell, Malcolm (2005), Blink: The Power of Thinking Without Thinking, Boston: Little, Brown, ISBN 978-0-316-17232-5.

- Harnad, Stevan (2001), "What's Wrong and Right About Searle's Chinese Room Argument?", in Bishop, M.; Preston, J. (eds.), Essays on Searle's Chinese Room Argument, Oxford University Press

- Haraway, Donna(1985년).사이보그 선언이야

- 를 클릭합니다Haugeland, John (1985), Artificial Intelligence: The Very Idea, Cambridge, Mass.: MIT Press.

- 를 클릭합니다Hofstadter, Douglas (1979), Gödel, Escher, Bach: an Eternal Golden Braid.

- 를 클릭합니다Horst, Steven (2009), "The Computational Theory of Mind", in Zalta, Edward N. (ed.), The Stanford Encyclopedia of Philosophy, Metaphysics Research Lab, Stanford University.

- Kaplan, Andreas; Haenlein, Michael (2018), "Siri, Siri in my Hand, who's the Fairest in the Land? On the Interpretations, Illustrations and Implications of Artificial Intelligence", Business Horizons, 62: 15–25, doi:10.1016/j.bushor.2018.08.004, S2CID 158433736

- 를 클릭합니다Kurzweil, Ray (2005), The Singularity is Near, New York: Viking Press, ISBN 978-0-670-03384-3.

- 를 클릭합니다Lucas, John (1961), "Minds, Machines and Gödel", in Anderson, A.R. (ed.), Minds and Machines.

- 말라부, 캐서린(2019).모핑 인텔리전스: IQ 측정에서 인공 뇌까지. (C. Shread, Trans)컬럼비아 대학 출판부

- 를 클릭합니다McCarthy, John; Minsky, Marvin; Rochester, Nathan; Shannon, Claude (1955), A Proposal for the Dartmouth Summer Research Project on Artificial Intelligence, archived from the original on 2008-09-30.

- McDermott, Drew (May 14, 1997), "How Intelligent is Deep Blue", New York Times, archived from the original on October 4, 2007, retrieved October 10, 2007

- Moravec, Hans (1988), Mind Children, Harvard University Press

- Penrose, Roger (1989), The Emperor's New Mind: Concerning Computers, Minds, and The Laws of Physics, Oxford University Press, ISBN 978-0-14-014534-2

- Russell, Stuart J.; Norvig, Peter (2003), Artificial Intelligence: A Modern Approach (2nd ed.), Upper Saddle River, New Jersey: Prentice Hall, ISBN 0-13-790395-2

- Searle, John (1980), "Minds, Brains and Programs" (PDF), Behavioral and Brain Sciences, 3 (3): 417–457, doi:10.1017/S0140525X00005756, S2CID 55303721, archived from the original (PDF) on 2015-09-23

- Searle, John (1992), The Rediscovery of the Mind, Cambridge, Massachusetts: M.I.T. Press

- Searle, John (1999), Mind, language and society, New York, NY: Basic Books, ISBN 978-0-465-04521-1, OCLC 231867665

- Turing, Alan (October 1950), "Computing Machinery and Intelligence", Mind, LIX (236): 433–460, doi:10.1093/mind/LIX.236.433, ISSN 0026-4423

- Yee, Richard (1993), "Turing Machines And Semantic Symbol Processing: Why Real Computers Don't Mind Chinese Emperors" (PDF), Lyceum, 5 (1): 37–59

- 위의 페이지 번호 및 다이어그램 내용은 문서의 Lyceum PDF 인쇄물을 참조합니다.