베이지안 네트워크

Bayesian network| 시리즈의 일부 |

| 베이지안 통계 |

|---|

| 이론. |

| 기술 |

베이지안 네트워크(Bayes 네트워크, Bayes 네트워크, 신념 네트워크 또는 의사결정 네트워크라고도 함)는 일련의 변수와 그 조건부 의존성을 DAG(Directed Acyclic Graph)를 통해 나타내는 확률론적 그래픽 모델입니다.베이지안 네트워크는 발생한 이벤트를 포착하여 여러 가지 가능한 기존 원인 중 하나가 원인일 가능성을 예측하는 데 이상적입니다.예를 들어, 베이지안 네트워크는 질병과 증상 사이의 확률론적 관계를 나타낼 수 있다.증상이 나타나면 네트워크를 사용하여 다양한 질병의 발생 확률을 계산할 수 있습니다.

효율적인 알고리즘은 베이지안 네트워크에서 추론 및 학습을 수행할 수 있습니다.변수의 시퀀스(예: 음성 신호 또는 단백질 시퀀스)를 모델링하는 베이지안 네트워크를 동적 베이지안 네트워크라고 한다.불확실성 하에서 의사결정 문제를 표현하고 해결할 수 있는 베이지안 네트워크의 일반화를 영향도라고 한다.

그래픽 모델

공식적으로, 베이지안 네트워크는 노드가 베이지안 의미에서 변수를 나타내는 DAG(방향 비순환 그래프)입니다. 즉, 관측 가능한 양, 잠재 변수, 알려지지 않은 매개변수 또는 가설일 수 있습니다.에지는 조건부 종속성을 나타냅니다.연결되지 않은 노드(노드 간에 연결되는 경로가 없음)는 서로 조건적으로 독립적인 변수를 나타냅니다.각 노드는 노드의 부모 변수에 대한 특정 값 집합을 입력으로 받아들여 노드에 의해 표현되는 변수의 확률(또는 해당하는 경우 확률 분포)을 출력으로 제공하는 확률 함수와 관련지어진다.예를 들어 m\ m m\ m m\displaystyle 2^{의 부울 변수를 확률함수는 의엔트리로 표로 수 .유사한 아이디어는 마르코프 네트워크와 같은 무방향(아마도 순환) 그래프에 적용될 수 있다.

예

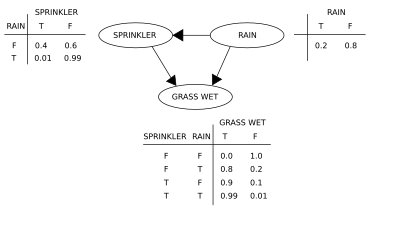

두 가지 이벤트가 잔디밭을 젖게 할 수 있다: 활성 스프링클러 또는 비.비는 스프링클러 사용에 직접적인 영향을 미칩니다(즉, 비가 오면 스프링클러는 일반적으로 작동하지 않습니다).이 상황은 베이지안 네트워크(오른쪽에 표시)를 사용하여 모델링할 수 있습니다.각 변수에는 T(참)와 F(거짓)의 두 가지 가능한 값이 있습니다.

여기서 G = "잔디 습기(참/거짓)", S = "스프링클러가 켜짐(참/거짓)", R = "Raining(참/거짓)".

모델은 조건부 확률식을 사용하고 모든 방해 변수를 합산하여 "잔디가 젖었을 때 비가 올 확률은?"와 같은 효과(이른바 역확률)가 있을 때 원인 존재에 대한 질문에 대답할 수 있다.

Using the expansion for the joint probability function and the conditional probabilities from the conditional probability tables (CPTs) stated in the diagram, one can evaluate each term in the sums in the numerator and denominator.예를들면,

그런 다음 숫자 결과(관련 변수 값으로 표시됨)는 다음과 같습니다.

예를 들어, "잔디를 적신다면 비가 올 확률이 얼마나 됩니까?"와 같은 중재적 질문에 답합니다.답변은 사후 예방 공동 분배 함수에 의해 제어됩니다.

사전 간섭 분포에서 인자 ( ,R ) { S을 제거하여 구합니다.do 연산자는 강제로 G 값이 참이 되도록 합니다.비가 올 확률은 작용의 영향을 받지 않습니다.

스프링클러 켜짐의 영향을 예측하려면:

용어 ( R) ({ R을 제거하여, 작용이 잔디에 영향을 미치지만 비는 영향을 미치지 않음을 보여준다.

이러한 예측은 대부분의 정책 평가 문제와 같이 관측되지 않은 변수를 고려할 때 실현 가능하지 않을 수 있다. 액션 실행)(\style의 효과는 백도어 기준을 [1][2]충족할 때마다 예측할 수 있습니다.노드 세트 Z가 X에서Y로의 모든 백도어 패스를 d분할[3](또는 블록)하는 것을 확인할 수 있는 경우,

백도어 패스는 X로 화살표가 들어가는 패스입니다.백도어 기준을 충족하는 세트를 "충분" 또는 "허용"이라고 합니다.예를 들어, 세트 Z = R은 (유일한) 백도어 경로 S ← R ← G이므로, 세트 Z = T의 영향을 예측하는 데 허용된다. 그러나, S가 관찰되지 않을 경우, 이 경로와 (S = T) 스프링클러가 (G)에 미치는 영향은 다른 세트 D = T의 영향을 예측할 수 없다.이 경우 P(G do(S = T))는 "식별"되지 않는다.이는 중재적 데이터가 부족할 때, S와 G 사이의 관찰된 의존성은 인과 관계에 기인하거나 거짓이라는 사실을 반영한다(공통 원인 R에서 발생하는 명백한 의존성). (심슨 역설 참조)

인과관계가 관찰되지 않은 변수를 가진 임의의 베이지안 네트워크에서 식별되는지 여부를 판단하기 위해 "do-calculus"[1][4]의 세 가지 규칙을 사용하여 모든 do 항이 해당 관계의 표현에서 제거될 수 있는지 여부를 테스트하여 원하는 양이 주파수 [5]데이터에서 추정 가능한지 확인할 수 있다.

공동 분포의 의존성이 희박한 경우, 베이지안 네트워크를 사용하면 완전 확률 테이블보다 상당한 양의 메모리를 절약할 수 있습니다.예를 들어, 10개의 두 값 변수의 조건부 확률을 테이블로 저장하는 단순한 방법은 2개의 2}= 값을 저장할 공간이 합니다.변수의 로컬 분포가 3개 이상의 부모 변수에 의존하지 않는 경우, 베이지안 네트워크 표현은 3 {\ 10 2}=의 값을 저장합니다.

베이지안 네트워크의 한 가지 장점은 인간이 완전한 공동 분포보다 (희박한 일련의) 직접 종속성과 로컬 분포를 이해하는 것이 직관적으로 더 쉽다는 것이다.

추론 및 학습

베이지안 네트워크는 다음 3가지 주요 추론 태스크를 수행합니다.

관측되지 않은 변수 추론

베이지안 네트워크는 변수와 그들의 관계에 대한 완전한 모델이기 때문에, 그것들에 대한 확률론적 질문에 답하는 데 사용될 수 있다.예를 들어 네트워크를 사용하여 다른 변수(증거 변수)가 관찰될 때 변수 하위 집합의 상태에 대한 지식을 업데이트할 수 있습니다.주어진 증거의 변수 사후 분포를 계산하는 이 과정을 확률론적 추론이라고 한다.후부는 일부 예상 손실 함수를 최소화하는 변수 하위 집합의 값을 선택할 때, 예를 들어 의사결정 오류의 확률과 같은 검출 애플리케이션에 대한 보편적인 충분한 통계량을 제공한다.따라서 베이지안 네트워크는 복잡한 문제에 베이즈의 정리를 자동으로 적용하는 메커니즘으로 간주될 수 있다.

가장 일반적인 정확한 추론 방법은 다음과 같습니다. 변수 제거는 제품 전체에 합계를 분배하여 관찰되지 않은 비쿼리 변수를 하나씩 제거(적분 또는 합계를 통해), 한 번에 많은 변수를 쿼리할 수 있도록 계산을 캐시하고 새로운 증거를 빠르게 전파할 수 있도록 합니다.; 및 재귀적 조건화 및 AND/OR 검색: 충분한 공간이 사용되었을 때 시공간 트레이드오프를 허용하고 변수 제거의 효율과 일치합니다.이러한 모든 방법은 네트워크의 트리 폭에서 기하급수적으로 복잡합니다.가장 일반적인 근사 추론 알고리즘은 중요도 샘플링, 확률적 MCMC 시뮬레이션, 미니 버킷 제거, 루피한 믿음 전파, 일반화 믿음 전파 및 변동 방법이다.

파라미터 학습

베이지안 네트워크를 완전히 규정하여 공동 확률 분포를 완전히 나타내기 위해서는 X의 부모에 따라 조건부로 X에 대한 확률 분포를 각 노드 X에 대해 규정할 필요가 있다.부모에 따른 X의 분포는 어떠한 형태도 가질 수 있다.이산 분포 또는 가우스 분포를 사용하면 계산이 간단해지므로 일반적으로 사용됩니다.때때로 분포에 대한 제약만이 알려져 있다; 그 후 주어진 제약조건에서 가장 큰 엔트로피를 가진 단일 분포를 결정하기 위해 최대 엔트로피의 원리를 사용할 수 있다. (아날로그로 동적 베이지안 네트워크의 특정한 맥락에서, 숨겨진 상태의 시간적 진화에 대한 조건부 분포는 일반적으로 존재한다.암시적 확률 과정의 엔트로피 속도를 최대화하기 위해 지정됩니다.)

종종 이러한 조건부 분포에는 알 수 없는 모수가 포함되며 최대우도 접근법을 통해 데이터에서 추정해야 한다.관측되지 않은 변수를 고려할 때 우도(또는 사후 확률)의 직접적인 최대화는 종종 복잡하다.이 문제에 대한 고전적인 접근방식은 기대 최대화 알고리즘으로, 이전에 계산된 기대값이 정확하다고 가정할 때 완전한 우도(또는 사후)를 최대화하는 방식으로 관측되지 않은 변수의 기대값을 번갈아 계산한다.경미한 규칙성 조건에서는 이 공정은 모수에 대한 최대 우도(또는 최대 사후) 값에 수렴됩니다.

모수에 대한 보다 완전한 베이지안 접근법은 이들을 추가적인 비관측 변수로 취급하고 관찰된 데이터에 따라 조건부로 모든 노드에 대한 완전한 후방 분포를 계산한 다음 모수를 통합하는 것이다.이 접근방식은 비용이 많이 들고 대형 치수 모델로 이어질 수 있으며, 이는 기존의 매개변수 설정 접근방식을 보다 다루기 쉽게 만든다.

구조 학습

가장 간단한 경우, 베이지안 네트워크는 전문가에 의해 지정되고 추론을 수행하기 위해 사용된다.다른 응용 프로그램에서는 네트워크를 정의하는 작업이 인간에게 너무 복잡합니다.이 경우 네트워크 구조와 로컬 배포의 매개 변수는 데이터에서 학습해야 합니다.

베이지안 네트워크(BN)의 그래프 구조를 자동으로 학습하는 것은 기계 학습 내에서 추구되는 과제이다.기본 개념은 Rebane과[6] Pearl이 개발한 복구 알고리즘으로 거슬러 올라가며, 3노드 DAG에서 허용되는 세 가지 패턴 간의 구별에 기초하고 있습니다.

| 양식 | 모델 |

|---|---|

| 체인 | |

| 포크 | |

| 충돌기 |

첫 번째 2개는 동일한 종속성을 나타냅니다( X와Z(\ Z는 Y Y에 대해 독립적이므로 구분할 수 없습니다).그러나와약간 독립적이고 다른 모든 쌍은 종속적이기 에 충돌기는 고유하게 식별할 수 있습니다.따라서 이 세 개의 세 개의 세 개의 골격(화살표가 제거된 그래프)은 동일하지만 화살표의 방향성은 부분적으로 식별할 수 있습니다.와가 공통의 부모를 둔 에도 동일한 구별이 적용되지만, 그 부모에게 먼저 조건을 달아야 한다.알고리즘은 [1][7][8][9]기본 그래프의 골격을 체계적으로 결정한 다음 관찰된 조건부 독립성에 의해 방향성이 지시되는 모든 화살표에 방향을 지정하기 위해 개발되었다.

구조 학습의 다른 방법은 최적화 기반 검색을 사용합니다.스코어링 기능과 검색 전략이 필요합니다.일반적인 채점 함수는 BIC 또는 BDeu와 같은 훈련 데이터가 주어진 구조의 사후 확률이다.점수를 최대화하는 구조를 반환하는 완전 검색의 시간 요건은 변수 수에 초비례합니다.로컬 검색 전략은 구조의 점수를 개선하기 위해 점진적으로 변경합니다.마르코프 체인 몬테카를로와 같은 글로벌 검색 알고리즘은 로컬 미니마에 갇히는 것을 피할 수 있습니다.Friedman [10][11]등은 변수 간의 상호 정보 사용과 이를 극대화하는 구조를 찾는 것에 대해 논의한다.이를 위해 부모 후보 세트를 k노드로 제한하고 철저히 검색합니다.

정확한 BN 학습을 위한 특히 빠른 방법은 문제를 최적화 문제로 캐스팅하고 정수 프로그래밍을 사용하여 해결하는 것입니다.비순환성 제약은 절단면의 [12]형태로 해결 중에 정수 프로그램(IP)에 추가된다.이러한 방법은 최대 100개의 변수를 가진 문제를 처리할 수 있습니다.

수천 개의 변수와 관련된 문제를 다루기 위해서는 다른 접근법이 필요합니다.첫 번째 방법은 첫 번째 순서를 샘플로 추출한 후 해당 순서에 대한 최적의 BN 구조를 찾는 것입니다.이는 가능한 순서의 서치 공간에서 작업하는 것을 의미하며, 네트워크 구조의 공간보다 작기 때문에 편리합니다.그런 다음 여러 순서를 샘플링하고 평가합니다.이 방법은 변수의 수가 [13]많을 때 문헌에서 가장 잘 사용 가능한 것으로 입증되었습니다.

또 다른 방법은 MLE가 닫힌 형태를 갖는 분해 가능한 모델의 하위 클래스에 초점을 맞추는 것입니다.그러면 수백 개의 [14]변수에 대해 일관된 구조를 발견할 수 있습니다.

최악의 경우 추론 복잡성이 (지수 시간 가설에 따라) 나무 너비 k에서 기하급수적이기 때문에, 나무 너비로 정확하고 다루기 쉬운 추론을 허용하기 위해 베이지안 네트워크를 학습하는 것이 필요하다.그러나 그래프의 글로벌 속성으로서 학습 과정의 난이도를 상당히 높인다.이러한 맥락에서 K-tree를 사용하여 효과적으로 [15]학습할 수 있습니다.

통계 소개

x(\x와 파라미터(\ \theta를 지정하면 간단한 베이지안 분석은 p( p(\ 및 p의 사후 p \로부터 시작됩니다 p x p

의 경우 의 이전 파라미터는 에서 언급되지 않은 다른 파라미터 {따라서 이전 p)는 p p p p 로 대체해야 하며 새로 도입된 의 이전 p(\가 뒤에 나타날 가능성이 있습니다

예를 들어 파라미터 는 그 전에 필요한 추가 파라미터 에 의존할 수 있습니다.최종적으로 프로세스가 종료되어야 하며, 이 프로세스는 언급되지 않은 파라미터에 의존하지 않는 prior로 종료되어야 합니다.

도입 예

이 섹션은 확장해야 합니다.추가함으로써 도움이 될 수 있습니다. (2009년 3월) |

를 들어, § _의 추정에 관심이 있다고 가정하자. 접근법은 최대우도 접근법을 사용하여i \theta _를 추정하는 것이다. 관측치는 독립적이기 때문에, 우도 인수분해 및 최대우도 추정치는 단순하다.

단, 예를 들어 개체 i _가 기본 분포에서 추출된 경우, 이 관계는 독립성을 파괴하고 보다 복잡한 모델을 제시한다.

~flat style \ sim {{}0 ,)n3 \ n \ 3 e 、 thereee thereeeeeeeeeeeeeeeeeeeeeeeee thereeeeeeeeeeeeeeeeeeeeeeeeeeeeeeeeee e thereeeeeeeeeeeee there추정치로부터 공통의 평균을 향해 이동하거나 하는 경향이 있습니다이 수축은 계층형 Bayes 모델에서 일반적인 동작입니다.

우선 사항의 제한

계층 모델, 특히 이 예의 변수 와 같은 의 상위 레벨의 스케일 변수를 선택할 때는 약간의 주의가 필요합니다.사전 Jeffreys와 같은 통상적인 이전은 종종 작동하지 않는다. 왜냐하면 후방 분포는 정규화할 수 없고 예상 손실을 최소화하여 만든 추정치는 허용되지 않기 때문이다.

정의 및 개념

베이지안 네트워크의 등가 정의가 몇 가지 제공되고 있습니다.다음의 경우, G = (V,E)를 지향성 비순환 그래프(DAG)라고 하고 X = (Xv), v δ V를 V에 의해 지수화된 랜덤 변수 집합으로 한다.

인수분해 정의

X는 G에 관한 베이지안 네트워크이다. 만약 공동 확률 밀도 함수(제품 측정과 관련된)가 부모 [16]변수에 따라 개별 밀도 함수의 곱으로 작성될 수 있다면:

여기서 pa(v)는 v의 부모 집합이다(즉, 단일 가장자리를 통해 v를 직접 가리키는 정점).

임의의 랜덤 변수 집합에서,[16] 결합 분포의 모든 구성원의 확률은 연쇄 규칙(X의 위상 순서 부여)을 사용하여 다음과 같이 조건부 확률로부터 계산할 수 있습니다.

위의 정의를 사용하면 다음과 같이 기술할 수 있습니다.

두 식 간의 차이는 상위 변수의 값이 주어진 경우 변수가 비후속 변수로부터 조건부 독립적이라는 것입니다.

국소 마르코프 특성

로컬 마르코프 속성을 만족시키는 경우 X는 G에 관한 베이지안 네트워크입니다.각 변수는 부모 [17]변수가 주어졌을 때 조건적으로 비후속 변수와 독립적입니다.

여기서 de(v)는 하위 집합이고 V \de(v)는 v의 비후속 집합입니다.

이것은 첫 번째 정의와 유사한 용어로 표현될 수 있다.

그래프가 비순환적이므로 상위 집합은 비후속 집합의 하위 집합입니다.

베이지안 네트워크 개발

베이지안 네트워크의 개발은 종종 X가 G에 관한 로컬 마르코프 속성을 만족하도록 DAG G를 만드는 것으로 시작한다.때로는 이것이 인과 DAG이다.각 변수의 부모가 G에 주어진 조건부 확률 분포를 평가합니다.많은 경우에, 특히 변수가 이산적인 경우에, 만약 X의 공동 분포가 이러한 조건부 분포의 산물이라면, X는 [18]G에 관한 베이지안 네트워크이다.

마르코프 블랭킷

노드의 마르코프 블랭킷은 노드의 부모, 자녀 및 자녀의 다른 부모로 구성된 노드 집합입니다.마르코프 블랭킷은 노드를 네트워크의 나머지 부분으로부터 독립적으로 렌더링합니다. 노드의 마르코프 블랭킷에 있는 변수의 공동 분포는 노드의 분포를 계산하기 위한 충분한 지식입니다.마르코프 [17]블랭킷이 주어졌을 때 모든 노드가 네트워크 내의 다른 모든 노드로부터 조건적으로 독립되어 있는 경우 X는 G에 관한 베이지안 네트워크입니다.

d분리

이 정의는 두 노드의 "d" 분리를 정의함으로써 더 일반화할 수 있다. 여기서 d는 [1]방향을 나타낸다.먼저 트레일의 "d" 분리를 정의한 후, 그 관점에서 두 노드의 "d" 분리를 정의합니다.

P를 노드 u에서 v로의 트레일이라고 합니다.트레일은 두 노드 사이의 루프가 없는 무방향(즉, 모든 에지 방향이 무시됨) 경로입니다.다음 조건 중 하나가 충족되면 P는 노드 세트 Z에 의해 d-분리된다고 합니다.

- P는 유도 사슬 ⋯ m {\\cdots \ 화살표 left u \u mv를 포함(전부는 필요 없음)하며, 중간 노드 m은 Z,

- P에는 포크 u , { u \ \ left m \ \ v가 포함되어 중간 노드m이 Z 또는

- P에는 중간 노드 m이 Z에 없고 m의 후손이 Z에 존재하지 않도록 반전 포크(또는 충돌기), u \ \ u \ \ \ v}가 되어 있습니다

노드 u와 v 사이의 모든 경로가 d로 분리된 경우 노드 u와 v는 Z로 구분됩니다.u와 v가 d로 구분되지 않으면 d로 연결됩니다.

임의의 2개의 노드 u에 대해 다음과 같은 경우 X는 G에 관한 베이지안 네트워크입니다.

여기서 Z는 d-분리 u와 v-분리하는 집합이다. (마르코프 블랭킷은 다른 모든 노드로부터 d-분리하는 최소 노드 집합이다.)

원인 네트워크

베이지안 네트워크는 인과 관계를 나타내기 위해 종종 사용되지만, 그럴 필요는 없다: u에서 v로 향하는 방향 엣지는 X가 인과v 관계에 의존할u 필요가 없다.이는 그래프상의 베이지안 네트워크가 다음과 같이 되어 있음을 나타냅니다.

동등: 즉, 정확히 동일한 조건부 독립성 요건을 부과한다는 것입니다.

인과관계 네트워크는 관계가 인과관계여야 한다는 요건을 가진 베이지안 네트워크이다.인과 네트워크의 추가 의미론을 지정하는 것은 만약 노드 X는 적극적으로 야기된 에 지정된 상태)(액션 do로(X)) 쓴)), 확률 밀도 함수 변화에 그것의 네트워크 얻은 베는 것은 광고를 통해 부모 X로 설정 X로 인한 값 x.[1]를 사용하여 이러한 의미, 그 충격의.e개입 전에 얻은 데이터에서 외부 개입을 예측할 수 있다.

추론의 복잡성과 근사 알고리즘

1990년, Stanford University에서 대규모 바이오 정보 애플리케이션을 연구하던 중, Cooper는 베이지안 네트워크에서의 정확한 추론이 [19]NP-hard라는 것을 증명했습니다.이 결과는 확률론적 추론에 대한 다루기 쉬운 근사 개발을 목적으로 근사 알고리즘에 대한 연구를 촉진했다.1993년에 Paul Dagum과 Michael Luby는 베이지안 [20]네트워크에서 확률론적 추론의 근사 복잡성에 대한 두 가지 놀라운 결과를 입증했다.첫째, 그들은 어떤 추적 가능한 결정론적 알고리즘도 절대 오차 δ < 1/2 이내로 확률론적 추론을 근사할 수 없다는 것을 증명했다.둘째, 그들은 어떤 추적 가능한 무작위화 알고리즘도 신뢰 확률이 1/2보다 큰 절대 오차 δ < 1/2 이내로 확률론적 추론을 근사할 수 없다는 것을 증명했다.

거의 동시에, 로스 그 베이즈 네트워크에서 정확한 추론 사실)P-완전(그리고 그래서 열심히 놓아 정규형 공식의 만족하는 과제들의 수를 셈으로(CNF)에서)며 이것은 팩터 2n1−ɛ 내에 있는 모든 ɛ 을을 위한 건축물로 베이즈 네트워크도 그 대략적인 추론;0, NP-ha다고 증명한다.rd.[21][22]

실질적으로, 이러한 복잡성 결과는 베이지안 네트워크가 AI와 기계 학습 애플리케이션을 위한 풍부한 표현이었지만, 대규모 실제 애플리케이션에서 베이지안 네트워크는 순진한 베이즈 네트워크와 같은 위상 구조 제약이나 조건부 확률에 대한 제한에 의해 사용이 강화될 필요가 있음을 시사했다.Dagum과 Luby에 의해 개발된 경계 분산[23] 알고리즘은 오류 근사치에 대한 보증을 가지고 베이지안 네트워크에서 확률론적 추론을 효율적으로 근사하기 위한 최초의 입증 가능한 빠른 근사 알고리즘이었다.이 강력한 알고리즘은 베이지안 네트워크의 조건부 확률에 대한 사소한 제한을 0에서 1/p(n) 단위로 제한해야 했습니다. 여기서 p(n)는 네트워크 n의 노드 수에 대한 다항식입니다.

소프트웨어

베이지안 네트워크의 주요 소프트웨어는 다음과 같습니다.

- 또 하나의 Gibbs Sampler(JAGS)– WinBUGS의 오픈 소스 대체품.Gibbs 샘플링을 사용합니다.

- Open BUGS – Win BUGS의 오픈 소스 개발.

- SPSS Modeler – 베이지안 네트워크의 실장을 포함한 상용 소프트웨어.

- Stan (소프트웨어) – Stan은 Hamiltonian Monte Carlo의 변형인 [24]NUTS(No-U-Turn sampler)를 사용하여 베이지안 추론을 얻기 위한 오픈 소스 패키지이다.

- PyMC3 – 임베디드 도메인 고유의 언어를 구현하여 베이지안 네트워크와 다양한 샘플러(NUTS 포함)를 나타내는 Python 라이브러리

- WinBUGS – MCMC 샘플러의 최초의 컴퓨터 구현 중 하나입니다.더 이상 유지되지 않습니다.

역사

베이지안 네트워크라는 용어는 1985년 Judea Pearl에 의해 다음과 같은 점을 [25]강조하기 위해 만들어졌습니다.

- 입력 정보의 자주 주관적인 성질

- 정보를 갱신하기 위한 기초로서 베이즈의 조건에 대한 의존

- 추론의[26] 인과관계와 증거형태의 구별

1980년대 후반에 펄의 지능형[27] 시스템에서의 확률론적 추론과 나폴리탄의 전문가[28] 시스템에서의 확률론적 추론은 그 특성을 요약하여 연구 분야로 확립했다.

「 」를 참조해 주세요.

메모들

- ^ a b c d e Pearl, Judea (2000). Causality: Models, Reasoning, and Inference. Cambridge University Press. ISBN 978-0-521-77362-1. OCLC 42291253.

- ^ "The Back-Door Criterion" (PDF). Retrieved 2014-09-18.

- ^ "d-Separation without Tears" (PDF). Retrieved 2014-09-18.

- ^ Pearl J (1994). "A Probabilistic Calculus of Actions". In Lopez de Mantaras R, Poole D (eds.). UAI'94 Proceedings of the Tenth international conference on Uncertainty in artificial intelligence. San Mateo CA: Morgan Kaufmann. pp. 454–462. arXiv:1302.6835. Bibcode:2013arXiv1302.6835P. ISBN 1-55860-332-8.

- ^ Shpitser I, Pearl J (2006). "Identification of Conditional Interventional Distributions". In Dechter R, Richardson TS (eds.). Proceedings of the Twenty-Second Conference on Uncertainty in Artificial Intelligence. Corvallis, OR: AUAI Press. pp. 437–444. arXiv:1206.6876.

- ^ Rebane G, Pearl J (1987). "The Recovery of Causal Poly-trees from Statistical Data". Proceedings, 3rd Workshop on Uncertainty in AI. Seattle, WA. pp. 222–228. arXiv:1304.2736.

- ^ Spirtes P, Glymour C (1991). "An algorithm for fast recovery of sparse causal graphs" (PDF). Social Science Computer Review. 9 (1): 62–72. doi:10.1177/089443939100900106. S2CID 38398322.

- ^ Spirtes P, Glymour CN, Scheines R (1993). Causation, Prediction, and Search (1st ed.). Springer-Verlag. ISBN 978-0-387-97979-3.

- ^ Verma T, Pearl J (1991). "Equivalence and synthesis of causal models". In Bonissone P, Henrion M, Kanal LN, Lemmer JF (eds.). UAI '90 Proceedings of the Sixth Annual Conference on Uncertainty in Artificial Intelligence. Elsevier. pp. 255–270. ISBN 0-444-89264-8.

- ^ Friedman N, Geiger D, Goldszmidt M (November 1997). "Bayesian Network Classifiers". Machine Learning. 29 (2–3): 131–163. doi:10.1023/A:1007465528199.

- ^ Friedman N, Linial M, Nachman I, Pe'er D (August 2000). "Using Bayesian networks to analyze expression data". Journal of Computational Biology. 7 (3–4): 601–20. CiteSeerX 10.1.1.191.139. doi:10.1089/106652700750050961. PMID 11108481.

- ^ Cussens J (2011). "Bayesian network learning with cutting planes" (PDF). Proceedings of the 27th Conference Annual Conference on Uncertainty in Artificial Intelligence: 153–160. arXiv:1202.3713. Bibcode:2012arXiv1202.3713C.

- ^ Scanagatta M, de Campos CP, Corani G, Zaffalon M (2015). "Learning Bayesian Networks with Thousands of Variables". NIPS-15: Advances in Neural Information Processing Systems. Vol. 28. Curran Associates. pp. 1855–1863.

- ^ Petitjean F, Webb GI, Nicholson AE (2013). Scaling log-linear analysis to high-dimensional data (PDF). International Conference on Data Mining. Dallas, TX, USA: IEEE.

- ^ M. Scanagatta, G. Corani, C. P. de Campos, M. Zaffalon.수천 개의 변수를 가진 트리 폭 제한 베이지안 네트워크를 학습합니다.NIPS-16: 신경 정보 처리 시스템의 진보 29, 2016.

- ^ a b 러셀 & 노비그 2003, 페이지 496

- ^ a b 러셀 & 노비그 2003, 페이지 499

- ^ Neapolitan RE (2004). Learning Bayesian networks. Prentice Hall. ISBN 978-0-13-012534-7.

- ^ Cooper GF (1990). "The Computational Complexity of Probabilistic Inference Using Bayesian Belief Networks" (PDF). Artificial Intelligence. 42 (2–3): 393–405. doi:10.1016/0004-3702(90)90060-d.

- ^ Dagum P, Luby M (1993). "Approximating probabilistic inference in Bayesian belief networks is NP-hard". Artificial Intelligence. 60 (1): 141–153. CiteSeerX 10.1.1.333.1586. doi:10.1016/0004-3702(93)90036-b.

- ^ D. Roth, 근사 추론의 난이도에 대하여, IJCAI(1993)

- ^ D. Roth, 근사추론의 난이도에 대하여, 인공지능 (1996)

- ^ Dagum P, Luby M (1997). "An optimal approximation algorithm for Bayesian inference". Artificial Intelligence. 93 (1–2): 1–27. CiteSeerX 10.1.1.36.7946. doi:10.1016/s0004-3702(97)00013-1. Archived from the original on 2017-07-06. Retrieved 2015-12-19.

- ^ Hoffman, Matthew D.; Gelman, Andrew (2011). "The No-U-Turn Sampler: Adaptively Setting Path Lengths in Hamiltonian Monte Carlo". arXiv:1111.4246. Bibcode:2011arXiv1111.4246H.

{{cite journal}}:Cite 저널 요구 사항journal=(도움말) - ^ Pearl J (1985). Bayesian Networks: A Model of Self-Activated Memory for Evidential Reasoning (UCLA Technical Report CSD-850017). Proceedings of the 7th Conference of the Cognitive Science Society, University of California, Irvine, CA. pp. 329–334. Retrieved 2009-05-01.

- ^ Bayes T, Price (1763). "An Essay towards solving a Problem in the Doctrine of Chances". Philosophical Transactions of the Royal Society. 53: 370–418. doi:10.1098/rstl.1763.0053.

- ^ Pearl J (1988-09-15). Probabilistic Reasoning in Intelligent Systems. San Francisco CA: Morgan Kaufmann. p. 1988. ISBN 978-1558604797.

- ^ Neapolitan RE (1989). Probabilistic reasoning in expert systems: theory and algorithms. Wiley. ISBN 978-0-471-61840-9.

레퍼런스

- Ben Gal I (2007). "Bayesian Networks" (PDF). In Ruggeri F, Kennett RS, Faltin FW (eds.). Support-Page. Encyclopedia of Statistics in Quality and Reliability. John Wiley & Sons. doi:10.1002/9780470061572.eqr089. ISBN 978-0-470-01861-3.

- Bertsch McGrayne S (2011). The Theory That Would not Die. New Haven: Yale University Press.

- Borgelt C, Kruse R (March 2002). Graphical Models: Methods for Data Analysis and Mining. Chichester, UK: Wiley. ISBN 978-0-470-84337-6.

- Borsuk ME (2008). "Ecological informatics: Bayesian networks". In Jørgensen, Sven Erik, Fath, Brian (eds.). Encyclopedia of Ecology. Elsevier. ISBN 978-0-444-52033-3.

- Castillo E, Gutiérrez JM, Hadi AS (1997). "Learning Bayesian Networks". Expert Systems and Probabilistic Network Models. Monographs in computer science. New York: Springer-Verlag. pp. 481–528. ISBN 978-0-387-94858-4.

- Comley JW, Dowe DL (June 2003). "General Bayesian networks and asymmetric languages". Proceedings of the 2nd Hawaii International Conference on Statistics and Related Fields.

- Comley JW, Dowe DL(2005년)."최소 메시지 길이고 일반화된 베이스의 네츠 비대칭 언어로".Grünwald PD인 IJ, 피트는 MA(eds.)에서.최소 기술 길이의 발전:.이론과 응용 프로그램은 실패한다.신경 정보 처리 시리즈.메사추세츠 캠브리지:브래드 포드 북스(MIT출판사)(출판된 4월 2005년).를 대신하여 서명함. 265–294.아이 에스비엔 978-0-262-07262-5.(이 종이든지 베이즈 네트워크 최소 메시지 길이를 사용하는 내부 노드에서(LIBOR결정 나무를 놓는다).

- Darwiche A (2009). Modeling and Reasoning with Bayesian Networks. Cambridge University Press. ISBN 978-0521884389.

- Dowe, David L. (2011-05-31). "Hybrid Bayesian network graphical models, statistical consistency, invariance and uniqueness" (PDF). Philosophy of Statistics. Elsevier. pp. 901–982. ISBN 9780080930961.

- Fenton N, Neil ME (November 2007). "Managing Risk in the Modern World: Applications of Bayesian Networks" (PDF). A Knowledge Transfer Report from the London Mathematical Society and the Knowledge Transfer Network for Industrial Mathematics. London (England): London Mathematical Society. Archived from the original (PDF) on 2008-05-14. Retrieved 2008-10-29.

- Fenton N, Neil ME (July 23, 2004). "Combining evidence in risk analysis using Bayesian Networks" (PDF). Safety Critical Systems Club Newsletter. Vol. 13, no. 4. Newcastle upon Tyne, England. pp. 8–13. Archived from the original (PDF) on 2007-09-27.

- Gelman A, Carlin JB, Stern HS, Rubin DB (2003). "Part II: Fundamentals of Bayesian Data Analysis: Ch.5 Hierarchical models". Bayesian Data Analysis. CRC Press. pp. 120–. ISBN 978-1-58488-388-3.

- Heckerman, 데이비드(3월 1일 1995년)."Tutorial베이스의 네트워크로 학습에".요르단에서는 마이클 어윈(교육.).그래픽 모델의 학습은.적응적 계산과 기계를 배우는 것은.메사추세츠 캠브리지:MIT출판사(1998년 출판되).를 대신하여 서명함. 301–354.아이 에스비엔 978-0-262-60032-3.7월 19일 2006년에 원래에서 Archived.Retrieved 9월 15일 2006년.{{책을 인용하다.}}:CS1 maint:봇:원래 URL상태 알 수 없는(링크):.로도 표시됩니다.

- 이전 버전은 Microsoft Research, 1995년 3월 1일자로 표시됩니다.이 논문은 베이지안 네트워크에서의 파라미터와 구조 학습에 관한 것이다.

- Jensen FV, Nielsen TD (June 6, 2007). Bayesian Networks and Decision Graphs. Information Science and Statistics series (2nd ed.). New York: Springer-Verlag. ISBN 978-0-387-68281-5.

- Karimi K, Hamilton HJ (2000). "Finding temporal relations: Causal bayesian networks vs. C4. 5" (PDF). Twelfth International Symposium on Methodologies for Intelligent Systems.

- Korb KB, Nicholson AE (December 2010). Bayesian Artificial Intelligence. CRC Computer Science & Data Analysis (2nd ed.). Chapman & Hall (CRC Press). doi:10.1007/s10044-004-0214-5. ISBN 978-1-58488-387-6. S2CID 22138783.

- Lunn D, Spiegelhalter D, Thomas A, Best N (November 2009). "The BUGS project: Evolution, critique and future directions". Statistics in Medicine. 28 (25): 3049–67. doi:10.1002/sim.3680. PMID 19630097. S2CID 7717482.

- Neil M, Fenton N, Tailor M (August 2005). Greenberg, Michael R. (ed.). "Using Bayesian networks to model expected and unexpected operational losses" (PDF). Risk Analysis. 25 (4): 963–72. doi:10.1111/j.1539-6924.2005.00641.x. PMID 16268944. S2CID 3254505.

- Pearl J (September 1986). "Fusion, propagation, and structuring in belief networks". Artificial Intelligence. 29 (3): 241–288. doi:10.1016/0004-3702(86)90072-X.

- Pearl J (1988). Probabilistic Reasoning in Intelligent Systems: Networks of Plausible Inference. Representation and Reasoning Series (2nd printing ed.). San Francisco, California: Morgan Kaufmann. ISBN 978-0-934613-73-6.

- Pearl J, Russell S (November 2002). "Bayesian Networks". In Arbib MA (ed.). Handbook of Brain Theory and Neural Networks. Cambridge, Massachusetts: Bradford Books (MIT Press). pp. 157–160. ISBN 978-0-262-01197-6.

- 를 클릭합니다Russell, Stuart J.; Norvig, Peter (2003), Artificial Intelligence: A Modern Approach (2nd ed.), Upper Saddle River, New Jersey: Prentice Hall, ISBN 0-13-790395-2.

- Zhang NL, Poole D (May 1994). "A simple approach to Bayesian network computations" (PDF). Proceedings of the Tenth Biennial Canadian Artificial Intelligence Conference (AI-94).: 171–178. 이 논문은 신념 네트워크에 대한 가변 제거를 제시한다.

추가 정보

- Conrady S, Jouffe L (2015-07-01). Bayesian Networks and BayesiaLab – A practical introduction for researchers. Franklin, Tennessee: Bayesian USA. ISBN 978-0-9965333-0-0.

- Charniak E (Winter 1991). "Bayesian networks without tears" (PDF). AI Magazine.

- Kruse R, Borgelt C, Klawonn F, Moewes C, Steinbrecher M, Held P (2013). Computational Intelligence A Methodological Introduction. London: Springer-Verlag. ISBN 978-1-4471-5012-1.

- Borgelt C, Steinbrecher M, Kruse R (2009). Graphical Models – Representations for Learning, Reasoning and Data Mining (Second ed.). Chichester: Wiley. ISBN 978-0-470-74956-2.

외부 링크

- 베이지안 네트워크와 그 현대 응용 프로그램 개요

- 베이지안 네트와 확률에 대한 온라인 튜토리얼

- 베이지안 넷을 만들고 몬테카를로 방식으로 실행하기 위한 웹 앱

- 연속 시간 베이지안 네트워크

- 베이지안 네트워크: 설명과 유추

- 베이지안 네트워크 학습 라이브 튜토리얼

- 분류 문제에서 표본 이질성을 다루기 위한 계층적 베이즈 모델은 반복 표본 측정과 관련된 불확실성을 고려한 분류 모델을 제공한다.

- 샘플 불확실성 처리를 위한 계층적 Naig Bayes 모델 웨이백 머신에 보관된 2007-09-28은 반복 측정으로 연속적이고 이산적인 변수로 분류 및 학습을 수행하는 방법을 보여준다.

제거하여 구합니다.do 연산자는 강제로 G 값이 참이 되도록 합니다.비가 올 확률은 작용의 영향을 받지 않습니다.

제거하여 구합니다.do 연산자는 강제로 G 값이 참이 되도록 합니다.비가 올 확률은 작용의 영향을 받지 않습니다.

제거하여, 작용이 잔디에 영향을 미치지만 비는 영향을 미치지 않음을 보여준다.

제거하여, 작용이 잔디에 영향을 미치지만 비는 영향을 미치지 않음을 보여준다.  효과는 백도어 기준을

효과는 백도어 기준을

.변수의 로컬 분포가 3개 이상의 부모 변수에 의존하지 않는 경우, 베이지안 네트워크 표현은

.변수의 로컬 분포가 3개 이상의 부모 변수에 의존하지 않는 경우, 베이지안 네트워크 표현은  값을 저장합니다.

값을 저장합니다.

Y

Y

파라미터

파라미터

시작됩니다

시작됩니다

![{\displaystyle {\begin{aligned}&\operatorname {P} (X_{v}=x_{v}\mid X_{i}=x_{i}{\text{ for each }}X_{i}{\text{ that is not a descendant of }}X_{v}\,)\\[6pt]={}&P(X_{v}=x_{v}\mid X_{j}=x_{j}{\text{ for each }}X_{j}{\text{ that is a parent of }}X_{v}\,)\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f8f18a3121835ff1e58881ebfc0d5f8ef95b783d)