주성분 분석

Principal component analysis실제 좌표 공간에서 점 집합의 주요 구성요소는 의 pp 단위 벡터입니다. 여기서 i-th 벡터는 첫 i - { 벡터에 직교하면서 데이터에 가장 잘 맞는 선의 방향입니다.여기서 최적선은 점부터 선까지의 평균 제곱 거리를 최소화하는 선으로 정의됩니다.이러한 방향은 데이터의 서로 다른 개별 차원이 선형적으로 상관되지 않는 직교 정규 기준을 구성합니다.주성분 분석(PCA)은 주성분을 계산하고 이를 사용하여 데이터에 대한 기준 변경을 수행하는 과정이며, 때로는 처음 몇 개의 주성분만 사용하고 나머지는 무시하는 과정입니다.

데이터 분석에서 pp 변수 집합의 첫 번째 주성분은 공통 정규 분포를 따르는 것으로 추정되며, 가장 많은 분산을 설명하는 원래 변수의 선형 조합으로 형성된 파생 변수이다.두 번째 주요 구성요소는 첫 번째 구성요소의 효과가 제거된 후 남은 사항의 가장 큰 차이를 설명하며, 모든 구성요소가 설명될 때까지 p{\ p회 반복 작업을 수행할 수 있습니다.PCA는 변수들 중 많은 것들이 서로 높은 상관관계를 가질 때 가장 일반적으로 사용되며 변수들의 수를 독립적인 집합으로 줄이는 것이 바람직합니다.

PCA는 탐색적 데이터 분석 및 예측 모델 작성에 사용됩니다.일반적으로 각 데이터 포인트를 처음 몇 개의 주요 컴포넌트에만 투영하여 저차원 데이터를 얻으면서 데이터의 변동을 최대한 보존함으로써 차원 축소를 위해 사용됩니다.첫 번째 주성분은 투영된 데이터의 분산을 최대화하는 방향으로 동등하게 정의할 수 있습니다.i - 주성분은 투사된 데이터의 분산을 최대화하는 첫 i -(\ i-1 주성분과 직교하는 방향으로 볼 수 있습니다.

두 목적 모두 주성분이 데이터의 공분산 행렬의 고유 벡터임을 알 수 있습니다.따라서 주성분은 종종 데이터 공분산 행렬의 eigendecomposition 또는 데이터 행렬의 특이값 분해에 의해 계산됩니다.PCA는 실제 고유 벡터 기반 다변량 분석 중 가장 단순하며 요인 분석과 밀접한 관련이 있습니다.인자 분석은 일반적으로 기본 구조에 대한 더 많은 영역별 가정을 통합하고 약간 다른 행렬의 고유 벡터를 해결합니다.PCA는 표준 상관 분석(CCA)과도 관련이 있습니다.CCA는 두 데이터 세트 간의 교차 공분산을 최적으로 설명하는 좌표계를 정의하는 반면, PCA는 단일 데이터 [1][2][3][4]세트의 분산을 최적으로 설명하는 새로운 직교 좌표계를 정의한다.표준 PCA의 견고한 L1 규격 기반 변형도 [5][6][4]제안되었다.

역사

PCA는 1901년 칼 [7]피어슨에 의해 발명되었는데, 이것은 후에 독립적으로 개발되었고 1930년대에 [8]Harold Hoteling에 의해 명명되었다.응용 프로그램 분야에 따라서는 이것은 또한 신호 처리에서의 이산 Karhunen–Loève 대해 변환(카루넨 루베 변환), 다변량 품질 관리의Hotelling 대해 변형, 기계 공학에 적절한 직교 분해(POD), X(19century[9]의 지난 분기에서 발명되)의 특이한 값 분해(simultaneous), 고유 값 이름이 붙었습니다. 드선형 대수의 XX 구성T(EVD), 인자 분석(PCA와 인자 분석 간의 차이에 대한 논의는 졸리프의 주성분 [10]분석 7장 참조), Eckart -영 정리(Harman, 1960), 또는 기상과학의 경험적 직교 함수(EOF), 경험적 고유 함수 분해(Sirovich, 1987), 경험적 성분 분석(Lorenz, 1956), 준조화 모드(Brooks et al., 1988), 소음과 진동의 스펙트럼 분해 및 구조 역학에서의 경험적 모달 분석.

직감

PCA는 데이터에 p차원 타원체를 적합시키는 것으로 생각할 수 있으며, 여기서 타원체의 각 축은 주성분을 나타낸다.타원체의 일부 축이 작으면 해당 축을 따른 분산도 작습니다.

타원체의 축을 찾으려면 먼저 각 값에서 변수의 관측값 평균을 빼서 데이터 집합의 각 변수 값을 0에 맞춰야 합니다.이러한 변환된 값은 각 변수에 대해 원래 관측치 대신 사용됩니다.그런 다음 데이터의 공분산 행렬을 계산하고 이 공분산 행렬의 고유값과 해당 고유 벡터를 계산합니다.그런 다음 각 직교 고유 벡터를 정규화하여 단위 벡터로 변환해야 합니다.이 작업이 완료되면 각 상호 직교 단위 고유 벡터는 데이터에 적합한 타원체의 축으로 해석될 수 있습니다.이러한 기준 선택을 통해 공분산 행렬이 대각선화된 형태로 변환되며, 대각선 요소는 각 축의 분산을 나타냅니다.각 고유 벡터가 나타내는 분산의 비율은 해당 고유 벡터에 해당하는 고유 값을 모든 고유 값의 합으로 나누어 계산할 수 있습니다.

이중 플롯과 스크리 그림(설명된 분산의 정도)은 PCA의 결과를 설명하는 데 사용됩니다.

세부 사항

PCA는 데이터를 새로운 좌표계로 변환하는 직교 선형 변환으로 정의되며 데이터의 스칼라 투영에 의해 가장 큰 분산이 첫 번째 좌표(첫 번째 주성분이라고 함)에 놓이고 두 번째 큰 분산이 두 번째 좌표계에 놓입니다.[10]

각 n개의 행이 실험의 서로 다른 반복을 나타내며 p개의 각 열은 특정 종류의 특징(특정 센서의 결과 등)을 제공하는 열별 경험적 평균이 0인n × \ n\p 데이터 행렬 X를 해 보자.

수학적으로 변환은 각 행(을 매핑하는 ( ( 1, , )( k) \ \} _ { ( k ) = ( w _ { , \ , _ p_ { p } { k} ( w _ 1 , \ _ p _ { p _ { p _ { p _ { p _ { p _ { p _ { } ) } } } } } } } } } } } }X에서 주성분 t ( ( , l) () { \ _)}=(i의 새로운 벡터는 다음과 같습니다.

데이터 세트에 대해 고려된 t의 t1, {\l}이() 단위 벡터로 구속된 상태에서 X로부터 가능한 최대 분산을 연속적으로 상속하도록 한다(여기서 l{\ l은 일반적으로 p보다 값으로 선택됨). p를 표시하여 치수성을 낮춥니다).

첫 번째 컴포넌트

분산을 최대화하기 위해 첫 번째 무게 벡터(1) w는 다음과 같이 만족해야 한다.

마찬가지로 이것을 매트릭스 형태로 쓰면

w가 단위 벡터로 정의되었기 때문에(1), 그것은 또한 동등하게 다음을 만족시킨다.

최대화할 양은 레일리 지수로 인식할 수 있다.XX와 같은T 양의 반정의 행렬에 대한 표준 결과는 몫의 최대 가능한 값이 행렬의 가장 큰 고유 값이며, w가 대응하는 고유 벡터일 때 발생합니다.

w를 찾으면 데이터(1) 벡터(i) x의 첫 번째 주성분은 변환된 좌표에서 점수1(i) t = x(i) w(1) w 또는 원래 변수에서 대응하는 벡터 {x(i) w(1) w} w로(1) 주어질 수 있다.

기타 컴포넌트

k번째 성분은 X에서 첫 번째 k - 1 주성분을 빼서 찾을 수 있습니다.

그리고 이 새로운 데이터 매트릭스에서 최대 분산을 추출하는 무게 벡터를 찾습니다.

이는 XX의 나머지T 고유 벡터와 대응하는 고유값에 의해 주어진 괄호 안의 수량에 대한 최대값을 제공하는 것으로 나타났습니다.따라서 가중치 벡터는 XX의T 고유 벡터입니다.

따라서 데이터 벡터(i) x의 k번째 주성분은 변환된 좌표에서 점수k(i) t = x(i) µ(k) w 또는 원래 변수 공간의 대응하는 벡터 {x(i) µ(k) w} w로(k) 주어질 수 있다. 여기서(k) w는 XX의T k번째 고유 벡터이다.

따라서 X의 전체 주성분 분해는 다음과 같이 주어질 수 있다.

여기서 W는 열이 XX의 고유T 벡터인 가중치의 p-by-p 행렬입니다.W의 전치는 때때로 미백 또는 스파링 변환이라고 불립니다.W에 해당하는 고유값의 제곱근을 곱한 열, 즉 분산으로 크기가 커진 고유 벡터를 PCA 또는 인자 분석에서는 적재라고 합니다.

공바리안스

XXT 자체는 데이터 집합T [10]: 30–31 X의 경험적 표본 공분산 행렬에 비례하는 것으로 인식될 수 있다.

데이터 집합에서 서로 다른 두 주성분 사이의 표본 공분산 Q는 다음과 같이 제공됩니다.

여기서 w의(k) 고유값 속성을 사용하여 2행에서 3행으로 이동합니다.그러나 대칭 행렬의 고유값에 해당하는 고유 벡터(j) w와(k) w는 직교하거나(고유값이 다른 경우), 또는 직교할 수 있습니다(벡터가 동일한 반복 값을 공유하는 경우).따라서 최종 라인의 곱은 0입니다. 따라서 데이터 집합에서 서로 다른 주성분 간에는 표본 공분산이 없습니다.

따라서 주성분 변환을 특성화하는 또 다른 방법은 경험적 표본 공분산 행렬을 대각화하는 좌표로 변환하는 것입니다.

행렬 형식에서 원래 변수에 대한 경험적 공분산 행렬은 다음과 같이 기술될 수 있습니다.

주성분 간의 경험적 공분산 행렬은

여기서 δ는 XX의T 고유값 δ의(k) 대각 행렬입니다. δ는(k) 각 성분 k와 관련된 데이터 집합의 제곱합, 즉 δ(k) = δik2(i) t = δi (x(i) δ(k) w)2입니다.

치수 축소

원래는 치킨보다 정현~ 와이번스 정현~ 날려버려 정현 오오오오오~ 였으나 공개 직후 팬들의 반응이 매우 좋지 않았고 여러 논란끝에 결국 20시즌 개막전부터 바뀐 가사의 응원가로 부르게 되었다.허나 정현 본인은 치킨보다 정현을 매우 맘에 들어했다고...첫 번째 L 고유 벡터만 사용하여 생성된 L 주성분은 잘린 변환을 제공합니다.

여기서 행렬L T에는 n개의 행이 있지만 L개의 열만 있습니다.즉, PCA는 선형 t x, p R {\ t \mathbb {R} }}개 컬럼을 학습합니다.장식에 [11]관련된 것들입니다.구성상, 이 점수 행렬은 L열만 있는 변환된 모든 데이터 행렬 중 보존된 원래 데이터의 분산을 최대화하는 동시에 총 제곱 재구성 오차 - T \ style \ } \ } ^ { } \ { } 또는 - 2 \ \ \{ X } - \{ X } { L } \

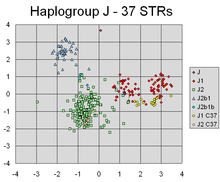

PCA는 개인의 Y염색체 유전자 혈통의 다른 라인에 대응하는 다른 클러스터를 분리하는 마커의 선형 조합을 성공적으로 찾아냈다.

이러한 차원 축소는 데이터 집합의 편차를 최대한 유지하면서 고차원 데이터 집합을 시각화하고 처리하는 데 매우 유용한 단계가 될 수 있습니다.예를 들어, L = 2를 선택하고 처음 두 개의 주요 구성요소만 유지하면 데이터가 가장 많이 분산된 고차원 데이터 집합을 통해 2차원 평면을 찾을 수 있다. 따라서 데이터에 클러스터가 포함되어 있는 경우 이 역시 가장 많이 분산될 수 있으며, 따라서 2차원 다이어그램에 가장 많이 표시될 수 있다.데이터를 통한 CTion(또는 원래 변수 중 두 개)은 무작위로 선택되고, 클러스터는 서로 멀리 떨어져 있지 않을 수 있으며, 실제로 서로 겹칠 가능성이 훨씬 높아 구별할 수 없다.

마찬가지로 회귀 분석에서 허용되는 설명 변수의 수가 많을수록 모형을 과적합하여 다른 데이터 집합으로 일반화하지 못하는 결론을 도출할 가능성이 커집니다.가능한 여러 설명 변수 간에 특히 강한 상관 관계가 있는 한 가지 방법은 변수를 몇 개의 주성분으로 줄인 다음 주성분 회귀라고 하는 방법을 실행하는 것입니다.

차원 축소는 데이터 집합의 변수에 노이즈가 있는 경우에도 적절할 수 있습니다.데이터 세트의 각 열에 독립적으로 동일한 분포의 가우스 노이즈가 포함되어 있는 경우, T의 열에는 유사하게 동일한 분포의 가우스 노이즈도 포함됩니다(이러한 분포는 좌표 축의 고차원 회전으로 간주될 수 있는 행렬 W의 영향 하에서는 불변).그러나, 동일한 소음 분산에 비해 총 분산이 처음 몇 개의 주요 구성요소에 더 많이 집중되면, 소음의 비례적 효과는 더 작아집니다. 즉, 처음 몇 개의 구성요소는 더 높은 신호 대 소음 비율을 달성합니다.따라서 PCA는 신호의 대부분을 최초의 몇 개의 주요 컴포넌트에 집중시키는 효과를 얻을 수 있습니다.이러한 주요 컴포넌트는 치수 축소에 의해 유용하게 포착될 수 있습니다.나중의 주요 컴포넌트는 노이즈에 의해 지배되므로 큰 손실 없이 폐기될 수 있습니다.데이터셋이 너무 크지 않은 경우 주요 컴포넌트의 중요도를 파라미터 부트스트랩을 사용하여 테스트할 수 있습니다.이는 유지할 [12]주요 컴포넌트의 수를 결정하는 데 도움이 됩니다.

특이값 분해

주성분 변환은 또 다른 행렬 인수분해, 즉 X의 특이값 분해(SVD)와도 연관될 수 있다.

여기서 δ는 X의 단수값이라고 불리는 정수 θ의(k) nxp 직사각형 대각행렬이며, U는 X의 왼쪽 단수 벡터라고 불리는 길이 n의 직교 단위 벡터이며, W는 p의 단수 벡터이며, X의 오른쪽 단수 벡터라고 불리는 p-byp 행렬이다.

이 인수분해에서는 행렬T XX를 쓸 수 있다.

여기서δ {\ δ δ {\= \{\sigma }} \mathbf {\s ^s} ^{t}} =\mathbf {\mat} ^s ^} gmat}의 단수치 X의 단수 값을 갖는 정사각형 대각행렬입니다.XX의T 인수분해는 X의 오른쪽 단수 벡터 W가 XX의T 고유 벡터와 동일하고의 단수 값 of(k)(\displaystyle })는 XX의 고유T 값 of의(k) 제곱근과 동일함을 나타냅니다.

특이값 분해를 사용하여 점수 행렬 T를 작성할 수 있습니다.

따라서 T의 각 열은 X의 왼쪽 특이 벡터 중 하나에 해당하는 특이값을 곱한 값으로 주어진다.이 형태는 T의 극성 분해이기도 하다.

행렬T XX를 형성할 필요 없이 X의 SVD를 계산하는 효율적인 알고리즘이 존재하기 때문에 SVD를 계산하는 것은 소수의 컴포넌트만 필요하지 않는 한 데이터[citation needed] 매트릭스에서 주요 컴포넌트 분석을 계산하는 표준 방법이 되었습니다.

고유 분해와 마찬가지로, 잘린 n × L 점수L 행렬 T는 첫 번째 가장 큰 L개의 특이값과 그 특이 벡터만을 고려함으로써 얻을 수 있다.

이러한 방식으로 잘린 단수값 분해를 사용하여 행렬 M 또는 T를 잘라내면 가능한 가장 작은 프로베니우스 노름을 가진 두 행렬 사이의 차이, 즉 Eckart로 알려진 결과인 원래 행렬에 가장 가까운 등급 L의 행렬인 잘린 행렬이 생성된다.영 정리[1936]

기타 고려사항

단수값(Ω 단위)은T 행렬 XX의 고유값의 제곱근입니다.각 고유값은 각 고유 벡터와 연관된 "분산" 부분(다차원 평균에서 점의 제곱 거리 합계의 더 정확함)에 비례합니다.모든 고유값의 합은 점의 다차원 평균으로부터의 거리 제곱의 합과 같습니다.PCA는 기본적으로 주성분과 정렬하기 위해 점 집합을 평균 주위로 회전시킵니다.그러면 분산의 대부분이(직교 변환을 사용하여) 처음 몇 개의 차원으로 이동합니다.따라서 나머지 치수의 값은 작은 경향이 있으며 정보 손실을 최소화하면서 폐기될 수 있습니다(아래 참조).PCA는 종종 치수 축소를 위해 이 방법으로 사용됩니다.PCA는 위에서 정의한 바와 같이 가장 큰 "분산"을 갖는 부분 공간을 유지하기 위한 최적의 직교 변환이라는 특징이 있습니다.그러나 이 장점은 예를 들어 이산 코사인 변환, 특히 단순히 "DCT"로 알려진 DCT-II와 비교한다면 더 큰 계산 요건의 대가를 치르게 된다.비선형 차원 축소 기법은 PCA보다 계산 부하가 높은 경향이 있습니다.

PCA는 변수의 확장에 민감합니다.변수가 두 개뿐이고 표본 분산이 동일하고 완전히 상관관계가 있는 경우 PCA는 45°의 회전을 수반하며 주성분에 대한 두 변수의 "가중치"(회전 코사인)는 같아집니다.그러나 첫 번째 변수의 모든 값에 100을 곱하면 첫 번째 주성분은 다른 변수의 기여가 적은 반면 두 번째 성분은 두 번째 원래 변수와 거의 일치합니다.즉, 변수마다 (온도나 질량 등)단위가 다를 때마다 PCA는 다소 자의적인 분석방법입니다.(예를 들어 섭씨보다는 화씨로 분석하면 다른 결과를 얻을 수 있습니다.)Pearson의 원래 논문은 "On Lines and Planes of Neast Fit to Systems of Points in Space"라는 제목이었습니다. "in Space"는 그러한 우려가 발생하지 않는 물리적 유클리드 공간을 의미합니다.PCA를 덜 임의적으로 만드는 한 가지 방법은 데이터를 표준화함으로써 단위 분산을 가지도록 스케일링된 변수를 사용하는 것입니다. 따라서 PCA의 기초로서 자기변화행렬 대신 자기상관행렬을 사용합니다.단, 이는 신호 공간의 모든 차원의 변동을 단위 분산으로 압축(또는 확장)합니다.

첫 번째 주성분이 최대 분산의 방향을 설명하도록 하기 위해 표준 PCA를 수행하기 위해 평균 감산(일명 "평균 센터링")이 필요합니다.평균 감산을 수행하지 않으면 첫 번째 주성분이 데이터 평균에 거의 해당할 수 있습니다.평균 0은 데이터 [13]근사치의 평균 제곱 오차를 최소화하는 기준을 찾는 데 필요합니다.

상관 행렬에 대한 주성분 분석을 수행하는 경우에는 데이터가 이미 상관 관계를 계산한 후 중심화되어 있으므로 평균 중심이 필요하지 않습니다.상관 계수는 두 표준 점수(Z-점수) 또는 통계 모멘트(따라서 Pearson Product-Motent Correlation)의 교차곱에서 파생됩니다.또한 Kromrey & Foster-Johnson(1998)의 "모델레이트 회귀의 평균 중심: 아무것도 아닌 것에 대해 떠들어댄다.공분산은 정규화 변수(Z 또는 표준 점수)의 상관 관계이므로 X의 상관 행렬에 기초한 PCA는 X의 표준화된 버전인 Z의 공분산 행렬에 기초한 PCA와 동일합니다.

PCA는 패턴 인식에서 널리 사용되는 주요 기술입니다.단, 클래스 [14]분리에 최적화되어 있지 않습니다.그러나 주성분 공간의 각 등급에 대한 질량 중심을 계산하고 [15]두 개 이상의 등급의 질량 중심 사이의 유클리드 거리를 보고함으로써 두 개 이상의 등급 사이의 거리를 정량화하는 데 사용되어 왔다.선형 판별 분석은 클래스 분리 가능성에 최적화된 대안입니다.

기호 및 약어 표

| 기호. | 의미. | 치수 | 인덱스 |

|---|---|---|---|

| 모든 데이터 벡터 집합으로 구성된 데이터 매트릭스, 행당 하나의 벡터 | | ||

| 데이터 집합의 행 벡터 수 | 스칼라 | ||

| 각 행 벡터 내의 요소 수(수치) | 스칼라 | ||

| 차원적으로 축소된 부분공간의 수, L p \ \ L \leq p } | 스칼라 | ||

| 경험적 평균의 벡터, 데이터 행렬의 각 열 j당 하나의 평균 | |||

| 경험적 표준 편차의 벡터, 데이터 행렬의 각 열 j에 대해 하나의 표준 편차 | |||

| 모든 1의 벡터 | |||

| 데이터 행렬의 각 열 j의 평균으로부터의 편차 | | ||

| z-평균, 데이터 행렬의 각 행 m에 대한 평균 및 표준 편차를 사용하여 계산됨 | | ||

| 공분산 행렬 | | ||

| 상관 행렬 | | ||

| C의 모든 고유 벡터 집합으로 이루어진 행렬, 열당 하나의 고유 벡터 | | ||

| 주요 대각선을 따라 C의 모든 고유값 집합과 기타 모든 요소에 대해 0으로 구성된 대각행렬( \} | | ||

| 베이스 벡터의 행렬, 각 베이스 벡터가 C의 고유 벡터 중 하나이고, 여기서 W의 벡터는 V의 벡터들의 하위 집합이다. | | ||

| 행렬은 n개의 행 벡터로 구성되며, 여기서 각 벡터는 행렬 X에서 행렬 W의 열에 포함된 기저 벡터에 대응하는 데이터 벡터의 투영이다. | |

PCA 속성 및 제한 사항

특성.

PCA의 속성은 다음과 같습니다.[10][page needed]

- 속성 1: 임의의 정수 q, 1 µ q µ p에 대해 직교 선형 변환을 고려합니다.

- 서 y y는 q-제곱 이고 B는 (q × p) 행렬이며, \} \ \그런 다음 tr ( )로 된 y \ \} _ { )의B Aq \ \ { B } _ b }를 취함으로써 최대화한다.displaystyle 의 lums (는 B의 전치입니다

- 속성 2: 직교 정규 변환을 다시 고려합니다.

- x x,\{B{A (\}가 전과 같이 정의되어 있습니다. 다음 tr( ( \{} ( \ { } )는 B q、 \ { B } = \ { A}_ { { { { q} } } )를 으로써 최소화합니다. 서 、 \ sty 。

이 속성의 통계적 의미는 마지막 몇 대의 PC가 중요한 PC를 제거한 후 단순히 구조화되지 않은 나머지 PC가 아니라는 것입니다.이러한 마지막 PC는 편차가 가능한 한 작기 때문에 그 자체로 유용합니다.이 값은 x의 요소 간에 예기치 않은 거의 일정한 선형 관계를 탐지하는 데 도움이 될 수 있으며 회귀 분석, x에서 변수의 부분 집합 선택 및 특이치 탐지에도 유용할 수 있습니다.

- 속성 3: (δ의 스펙트럼 분해)

용도를 조사하기 전에 먼저 대각선 요소를 살펴봅니다.

그러면, 결과의 주요 통계적 의미는 x의 모든 요소의 결합된 분산을 각 PC로 인한 기여 감소로 분해할 수 있을 뿐만 아니라 전체 공분산 행렬을 기여 \ style _ { k } \_ { \ { fr로 분해할 수 있다는 것이다.각 PC를 선택합니다.엄밀하게 감소하는 것은 아니지만 { _ {} \_ {k } '의 요소는 k kof {_ { \ _ {의 증가에 작아지는 경향이 있습니다. 단, k \style _의 는 정규화 제약으로 인해 거의 같은 크기를 유지하는 경향이 있습니다. k , ,1 \ alpha { } ' \ _ { k } 'alpha _ { } .

제한 사항

위에서 설명한 바와 같이 PCA의 결과는 변수의 스케일링에 따라 달라집니다.이는 각 피쳐를 표준 편차에 따라 스케일링함으로써 해결할 수 있으며, 이로 인해 단일 [16]분산의 차원 없는 피쳐가 발생합니다.

위에서 설명한 PCA의 적용 가능성은 PCA의 파생 과정에서 이루어진 특정(태싯) 가정에[17] 의해 제한됩니다.특히 PCA는 기능 간의 선형 상관관계를 포착할 수 있지만 이 가정을 위반하면 실패합니다(참조 자료 그림 6a 참조).경우에 따라서는 좌표 변환을 통해 선형성 가정을 복원하고 PCA를 적용할 수 있습니다(커널 PCA 참조).

또 다른 한계는 PCA에 대한 공분산 행렬을 구성하기 전의 평균 제거 과정입니다.천문학과 같은 분야에서는 모든 신호가 음이 아니며, 평균 제거 프로세스는 일부 천체물리학적 노출의 평균을 0으로 만들고, 결과적으로 비물리적 음속(negative flux)[18]을 생성하며,[19] 신호의 실제 크기를 회복하기 위해 전방 모델링을 수행해야 합니다.대안적인 방법으로는, 천체물리학적 [20][21][22]관측에 적합한 행렬의 음이 아닌 요소에만 초점을 맞춘 음이 아닌 행렬 인수 분해가 있다.자세한 내용은 PCA와 비음수 행렬 인수분해 사이의 관계를 참조하십시오.

알고리즘을 적용하기 전에 데이터가 표준화되지 않은 경우 PCA는 불리합니다.PCA는 원본 데이터를 해당 데이터의 주요 구성요소와 관련된 데이터로 변환합니다. 즉, 새 데이터 변수를 원본과 동일한 방식으로 해석할 수 없습니다.원래 변수의 선형 해석입니다.또한 PCA가 적절하게 수행되지 않으면 정보가 손실될 [23]가능성이 높습니다.

PCA는 선형 모델에 의존합니다.데이터 집합 내부에 비선형 패턴이 숨겨져 있는 경우 PCA는 실제로 분석을 진행 [24][page needed]방향과 반대 방향으로 조정할 수 있습니다.캔자스 주립 대학의 연구원들은 그들의 실험에서 표본 오차가 PCA 결과의 치우침에 영향을 미친다는 것을 발견했습니다.피험자 또는 블록의 수가 30개 미만인 경우 또는 연구자가 첫 번째 이상의 PC에 관심이 있는 경우 PCA를 수행하기 전에 먼저 직렬 상관관계를 수정하는 것이 좋을 수 있습니다.[25]캔자스 주 연구진은 또한 "데이터의 자기 상관 구조가 올바르게 처리되지 않으면"[25] PCA가 심각하게 편향될 수 있다는 것을 발견했다.

PCA와 정보 이론

차원 축소는 일반적으로 정보의 손실을 초래합니다.PCA 기반 치수 감소는 특정 신호 및 노이즈 모델에서 정보 손실을 최소화하는 경향이 있습니다.

라는 가정하에

즉, 데이터 x(\가 원하는 정보 보유 s(\와 노이즈 n(\})의 합이 정보 이론적 관점에서 PCA가 차원 축소에 최적일 수 있음을 보여줄 수 있다.

특히, 린스커는s {\이(가)이고 n {n}이() 동일 매트릭스에 비례하는 공분산 행렬을 가진 가우스 노이즈인 , 는 { I { 사이의 상호 I를 최대화한다.s {\ \{s 및 치수 예측 y T \= \ { \ [26] } 。

노이즈가 여전히 가우스이고 동일 매트릭스에 비례하는 공분산 매트릭스(즉, n(\의 성분이 iid)이지만 정보 보유 s(\가 비가우스(일반 시나리오)인 경우 PCA는 적어도 th 상한을 최소화한다.e 정보 손실, 즉 다음과 같이 정의됩니다[27][28].

만약 소음 n{\displaystyle \mathbf{n}}와 최소한 더 가우스(그 Kullback–Leibler 발산의 관점에서)일반적으로 그information-bearing 신호 s{\displaystyle \mathbf{s}}.[29]보다, 그리고 위의 신호 모델을 안심지어, PCA는information-theoretic optimali을 잃iid은 PCA의 최적성 또한 보존 되어 있다.한 ty n이(가) 종속되면 바로 s가 됩니다.

공분산 방법을 사용한 PCA 계산

다음은 상관법이 아닌 공분산법([30]여기도 참조)을 사용한 PCA에 대한 자세한 설명입니다.

목표는 주어진 차원 p의 데이터 집합 X를 더 작은 차원 L의 대체 데이터 집합 Y로 변환하는 것이다. 마찬가지로, 우리는 행렬 Y를 찾고 있다. 여기서 Y는 행렬 X의 Karhunen-Loeve 변환(KLT)이다.

- 데이터 세트를 정리하다

넌, 너는 따라서 각 관측 유일한 나는 변수, L<>설명할 수 있는 데이터를 줄이고 싶어 데이터 p변수의 연속적인 관측. 구성, p. 가정하자더 데이터가 n자료 벡터의 x1. 깨진 집합으로 정돈되어 있다)각인데와 n{\displaystyle \mathbf{)}_{1}\ldots \mathbf{)}_{n}}가정하자 _는 p 변수의 단일 그룹화된 관찰을 나타냅니다.

- 벡터로 x 1 n \ \{ { \\ _ 이라고 입력합니다.각각은 p개의 요소가 있습니다.

- 행 벡터를 차원 n × p의 단일 행렬 X에 배치합니다.

- 경험적 평균 계산

- 각 열 j = 1, ..., p를 따라 경험적 평균을 구합니다.

- 계산된 평균값을 차원 p × 1의 경험적 평균 벡터 u에 배치한다.

- 평균으로부터의 편차 계산

평균 감산은 데이터 [31]근사치의 평균 제곱 오차를 최소화하는 주성분 기준을 찾기 위한 솔루션의 필수 요소입니다.따라서 다음과 같이 데이터를 중심으로 진행합니다.

- 데이터 행렬 X의 각 행에서 경험적 평균 style \ {u}}를 뺀다.

- 평균 추출 데이터를 n × p 행렬 B에 저장합니다.

- 여기서 h는 모든 1s의 n x 1 열 벡터입니다.

일부 응용 프로그램에서는 각 변수(B의 열)의 크기가 1과 같도록 조정될 수도 있습니다([32]Z-점수 참조).이 단계는 계산된 주성분에 영향을 미치지만 다른 변수를 측정하는 데 사용되는 단위와는 독립적입니다.

- 공분산 행렬 찾기

- 행렬 B에서 p × p 경험적 공분산 행렬 C를 구합니다.여기서 {은 켤레 전치 연산자입니다.B가 완전히 실수로 구성되어 있는 경우(많은 응용 프로그램에서 그러하듯이), "공역 전치"는 일반 전치와 동일합니다.

- 공분산을 계산하는 데 n 대신 n - 1을 사용하는 이유는 Bessel의 보정입니다.

- 공분산 행렬의 고유 벡터 및 고유 값 찾기

- 공분산 행렬 C를 대각화하는 고유 벡터의 행렬 V를 계산합니다.여기서 D는 C의 고유값의 대각 행렬입니다.이 단계는 일반적으로 고유 벡터와 고유값을 계산하기 위한 컴퓨터 기반 알고리즘을 사용합니다.이러한 알고리즘은 SAS,[33] R, MATLAB,[34][35] Mathematica,[36] SciPy, IDL(Interactive Data Language), GNU 옥타브 및 OpenCV와 같은 대부분의 행렬 대수 시스템의 하위 구성요소로 쉽게 사용할 수 있습니다.

- 행렬 D는 p × p 대각 행렬의 형태를 취한다.공분산 행렬 C의 j번째 고유값입니다.

- 또한 차원 p × p인 행렬 V는 공분산 행렬 C의 p 고유 벡터를 나타내는 길이 p의 열 벡터를 포함합니다.

- 고유값과 고유 벡터가 정렬되고 쌍체화됩니다.j번째 고유값은 j번째 고유 벡터에 해당합니다.

- 행렬 V는 (왼쪽 고유 벡터가 아닌) 오른쪽 고유 벡터의 행렬을 나타냅니다.일반적으로 오른쪽 고유 벡터의 행렬이 왼쪽 고유 벡터 행렬의 (공역) 전치일 필요는 없습니다.

- 고유 벡터 및 고유 값 재정렬

- 고유 벡터 행렬 V 및 고유값 행렬 D의 열을 고유값 감소 순서대로 정렬합니다.

- 각 행렬의 열 사이에 올바른 쌍을 유지해야 합니다.

- 각 고유 벡터에 대한 누적 에너지 함량 계산

- 고유값은 각 고유 벡터에 대한 소스 데이터의 에너지[clarification needed] 분포를 나타내며, 고유 벡터는 데이터의 기초를 구성합니다.j번째 고유 벡터에 대한 누적 에너지 함량 g는 1부터 j까지의 모든 고유 값에 걸친 에너지 함량의 합이다.

- [필요한 건]

- 고유 벡터의 하위 집합을 기준 벡터로 선택합니다.

- V의 첫 번째 L 열을 p × L 행렬 W로 저장합니다.어디에

- L에 대한 적절한 값을 선택할 때 벡터 g를 참고한다.목표는 가능한 한 작은 L 값을 선택하면서 백분율 기준으로 상당히 높은 g 값을 달성하는 것입니다.예를 들어 누적 에너지 g가 특정 임계값(예: 90%)보다 커지도록 L을 선택할 수 있습니다.이 경우 L의 가장 작은 값을 선택합니다.

- 새로운 베이스에 데이터를 투영하다

- 투영된 데이터 점은 행렬의 행입니다.

T {\displaystyle 의 첫 번째 열은 첫 번째 주성분에 대한 데이터 점 투영이고, 두 번째 열은 두 번째 주성분에 대한 투영 등입니다.

공분산법을 이용한 PCA 유도

X를 열 벡터로 표현되는 d차원 랜덤 벡터라고 하자.일반성을 잃지 않고 X의 평균이 0이라고 가정합니다.

PX가 대각 공분산 행렬을 가지도록 d× d 직교 정규 변환 행렬 P를( is)\style (\ {\ (\ast {\style} {\style} {\st} {\st} {\style} {\st} {\st} {\st} {\style} {\st} {\st} {\st}} {\display}} {\}}} {\coral 변환 행렬 PX}

P P가 단일 수율이라고 한 간단한 계산:

따라서( ){ ( \ )는 (X ) { style \ { ( )가P { \ P 에 의해 대각선 가능한 경우에만 유지됩니다.

cov(X)가 음이 아닌 유한 행렬임을 보장하고, 따라서 일부 단일 행렬에 의해 대각선화 가능함을 보장하므로 이것은 매우 건설적이다.

무공분산 계산

실용적인 구현, 특히 고차원 데이터(큰 p)에서 순진한 공분산 방법은 공분산 행렬을 명시적으로 결정하는 높은 계산 및 메모리 비용 때문에 효율적이지 않기 때문에 거의 사용되지 않는다.공분산 없는 접근법은 공분산 행렬T XX를 명시적으로 계산하고 저장하는 np2 연산을 피하며, 대신 2np 연산의 비용으로 제품T X(X r)를 평가하는 함수를 기반으로 행렬 없는 방법 중 하나를 사용합니다.

반복계산

제1주성분을 효율적으로[37] 계산하는 한 가지 방법은 공분산행렬을 전혀 계산하지 않고 평균이 0인 데이터행렬 X에 대해 다음 의사코드에 나타나 있다.

r = 길이 p r = r / norm(r) do c 곱하기: X의 각 행 x에 대해 s = 0 (길이 p의 벡터) = s = s = rsT // // // // is is < < < < < < < < = ⋅ if if if if < < < 、 < < < < < < < < < < < < < < < < < < = < < < < < < <

이 거듭제곱 알고리즘은 단순히 벡터T X(X r)를 계산하여 정규화하고 결과를 r로 되돌립니다.만약 가장 큰 특이한 가치는 다음 큰 공룡으로부터 분리된다 그 고유 값은 단위 벡터 r의 공분산 행열 XTX을 가져오는 레일리 몫rT(XTX)r,. 잡는다, 벡터 r가까이 X의 첫번째 주요 구성 요소에 반복 c의 총 비용에서 p상대 작은 번호 내에서는 가져옵니다. 2cnp. Lanczos 알고리즘이나 LOBPCG(Local Optimal Block Preconditioned Conjectate Gradient) 방법 등 보다 고도의 매트릭스가 필요 없는 방법을 사용하여 반복당 작은 비용을 현저하게 희생시키지 않고 전력 반복 수렴을 가속화할 수 있습니다.

후속 주성분은 감압을 통해 하나씩 계산하거나 블록으로 동시에 계산할 수 있습니다.전자의 접근방식에서, 이미 계산된 대략적인 주성분에서의 충돌은 후속적으로 계산된 주성분의 정확도에 부가적으로 영향을 미치며, 따라서 새로운 계산마다 오차를 증가시킨다.블록 검정력법의 후자 접근방식은 싱글 벡터 r과 s를 블록 벡터 행렬 R과 S로 대체한다.R의 모든 열은 주요 주성분 중 하나에 가깝고 모든 열은 동시에 반복됩니다.주요 계산은 제품T X(X R)의 평가입니다.예를 들어 LOBPCG에서 구현되는 효율적인 블로킹은 오류의 누적을 제거하고 높은 수준의 BLAS 매트릭스 제품 기능을 사용할 수 있도록 하며, 일반적으로 단일 벡터 1개 기술에 비해 컨버전스 속도가 빨라집니다.

NIPALS 방식

비선형 반복 부분 최소 제곱(NIPALS)은 주성분 또는 부분 최소 제곱 분석의 처음 몇 가지 성분을 계산하기 위해 구현된 감산에 의한 행렬 감압을 갖는 고전적인 전력 반복의 변형입니다.*omics 과학(예: 유전체학, 대사학)에서 생성된 것과 같은 매우 고차원적인 데이터 세트의 경우 일반적으로 처음 몇 대의 PC만 계산하면 됩니다.그 비선형 반복 부분은 맞아떨어지는군(NIPALS)알고리즘이 권력 반복에 의해 주도적인 점수와 하중 t1과 r1T X왼쪽에 매 반복 주기 그리고 그 오른쪽에 곱하는 것이 공 분산 매트릭스의 계산, 피하는 것은 권력 ite의matrix-free 구현에 반복적인 근사치를 업데이트한다.ra제품T X(X r) =((X Tr)TX)를 평가하는 함수에 따라 XX로T 계산한다.

감산행렬 감압은 후속 선행 PC [38]계산에 사용되는 감압된 잔류행렬을 남기고 X에서 외부 곱 tr을11T 빼서 수행됩니다.대규모 데이터 행렬 또는 열 공선성이 높은 행렬의 경우 NIPALS는 각 반복에서 누적된 기계 정밀도 반올림 오류 및 [39]감산 행렬 감쇠로 인해 PC의 직교성을 상실합니다.그램-슈미트 재직교화 알고리즘은 이러한 직교성 [40]손실을 제거하기 위해 각 반복 단계에서 점수와 부하 모두에 적용된다.단일 벡터 곱셈에 대한 NIPALS 의존은 높은 수준의 BLAS를 이용할 수 없으며 클러스터화된 선행 단수 값에 대한 수렴이 느립니다. 이러한 두 가지 결함은 로컬 최적 블록 사전 조정 방식(LOBPCG)과 같은 보다 정교한 매트릭스 없는 블록 솔버로 해결됩니다.

온라인/시퀀스 평가

데이터가 한 번에 저장되는 것이 아니라 조각별로 도착하는 "온라인" 또는 "스트리밍" 상황에서는 순차적으로 업데이트할 수 있는 PCA 예측값을 산출하는 것이 유용합니다.이것은 효율적으로 실시할 수 있지만, 다른 [41]알고리즘이 필요합니다.

PCA 및 질적 변수

PCA에서는 질적 변수를 보충 요소로 도입하는 것이 일반적입니다.예를 들어, 많은 정량적 변수가 식물에서 측정되었습니다.이러한 발전소의 경우, 예를 들어 발전소가 속한 종으로 일부 질적 변수를 사용할 수 있다.이러한 데이터는 정량적 변수에 대해 PCA를 적용받았다.결과를 분석할 때는 주요 성분을 질적 변수종에 연결하는 것이 자연스럽다.이를 위해 다음과 같은 결과가 도출된다.

- 예를 들어, 다른 색상을 사용하여 요인 평면에서 다른 종에 대한 식별.

- 요인 평면에서 동일한 종에 속하는 식물의 무게 중심을 나타냅니다.

- 각 무게 중심과 각 축에 대해 무게 중심과 원점 사이의 차이의 유의성을 판단하기 위한 p-값입니다.

이러한 결과를 보충 요소로 질적 변수를 도입하는 것으로 부릅니다.이 절차는 및 Husson, Lé & Pagés 2009 및 Pagés 2013에 자세히 설명되어 있습니다.이 옵션을 "자동" 방식으로 제공하는 소프트웨어는 거의 없습니다.이것은 역사적으로 Ludovic Lebart의 연구에 따라 이 옵션을 최초로 제안한 SPAD와 R 패키지 FactoMineR의 경우입니다.

적용들

지성

인자 분석의 최초 적용은 인간 지능의 구성 요소를 찾고 측정하는 데 있었다.지능은 공간 지능, 언어 지능, 유도, 추론 등과 같은 상관 관계가 없는 다양한 요소들을 가지고 있다고 믿었고, 이러한 요소들에 대한 점수는 지능 지수(IQ)로 알려진 단일 지수를 제공하기 위해 다양한 테스트의 결과로부터 요인 분석에 의해 추론될 수 있다.선구적인 통계심리학자인 스피어맨은 1904년 그의 지능의 2요소 이론을 위해 심리측정학의 과학에 공식적인 기술을 추가하면서 실제로 요인 분석을 개발했다.1924년에 서스톤은 56가지 지능 요소를 찾아 정신 연령의 개념을 발전시켰다.오늘날의 표준 IQ 테스트는 이 초기 [42]작업에 기초합니다.

주거 분화

1949년,[43] 쉐브키와 윌리엄스는 1950년대부터 1970년대까지 주거 분화에 대한 연구를 지배했던 요인 생태 이론을 도입했다.도시의 인근 지역은 다양한 특성으로 인식 가능하거나 서로 구별할 수 있었으며, 요인 분석을 통해 3개로 축소할 수 있었다.이들은 '사회적 지위'(직업 지위의 지수), '가족주의' 또는 '가족 규모', '민족성'으로 알려져 있으며, 클러스터 분석을 적용하여 세 가지 핵심 요인 변수의 값에 따라 도시를 클러스터 또는 구역으로 나눌 수 있다.도시지리학에서 요인생태학을 중심으로 광범위한 문헌이 개발되었지만, 1980년 이후 방법론적으로 원시적이고 포스트모던 지리적 패러다임에서 거의 자리를 차지하지 못함에 따라 그 접근법은 시대에 뒤떨어졌다.

인자 분석의 문제점 중 하나는 항상 다양한 인위적 요인에 대한 설득력 있는 이름을 찾는 것이었습니다.2000년에 Flood는 요인 생태학 접근법을 부활시켜 주성분 분석이 실제로 요인 회전에 의존하지 않고 의미 있는 답을 직접 제공한다는 것을 보여 주었습니다.주요 요소는 사실 이중 변수 또는 '힘'의 그림자 가격이었다.첫 번째 요소는 '접근성'으로, 여행 수요와 공간 수요 사이의 전형적인 트레이드오프로서, 고전적인 도시 경제학의 기반이 되었다.다음 두 가지 요소는 '불이익'으로, 유사한 지위를 가진 사람들을 (계획에 따라) 다른 지역에 계속 있게 하고, 유사한 민족적 배경을 가진 사람들이 함께 [44]거주하려고 하는 민족성이었다.

이와 동시에, 호주 통계청은 중요하다고 생각되는 일련의 핵심 변수 중 첫 번째 주요 요소를 취하여 장단점 지수를 명확히 정의했다.이러한 SEIFA 지수는 다양한 관할 지역에서 정기적으로 발행되며 공간 [45]분석에 자주 사용된다.

개발 지수

PCA는 인덱스 개발에 사용할 수 있는 유일한 공식 방법이며, 그렇지 않으면 히트 오어 미스 애드혹 사업입니다.

도시개발지수는 PCA가 세계 254개 도시를 대상으로 한 1996년 조사에서 도시 결과의 약 200개의 지표로부터 개발하였다.첫 번째 주성분은 변동의 약 90%가 설명될 때까지 원래 변수를 개별적으로 추가하는 반복 회귀 분석을 받았다.이 지수는 궁극적으로 약 15개의 지표를 사용했지만 더 많은 변수에 대한 좋은 예측 변수였다.비교 가치는 각 도시의 상황에 대한 주관적인 평가와 매우 잘 일치했다.기반시설 항목에 대한 계수는 기초 서비스를 제공하는 평균 비용과 거의 비례하여, 지수가 실제로 도시에 대한 효과적인 물리적 및 사회적 투자의 척도임을 시사했다.

1990년부터 발행되어 개발 [46]연구에 널리 사용되고 있는 UNDP의 국가수준 인간개발지수(HDI)는 유사한 지표에 대해 매우 유사한 계수를 가지고 있어 원래 PCA를 사용하여 구축되었음을 강력히 시사한다.

집단유전학

1978년 Cavali-Sargari-Sargari와 다른 사람들은 지역에 걸친 인간 유전자 빈도의 변동에 대한 데이터를 요약하기 위해 주성분 분석(PCA)의 사용을 개척했다.구성 요소는 구배와 사인파를 포함한 독특한 패턴을 보였습니다.그들은 이러한 패턴을 특정한 고대 이주 사건에서 비롯되었다고 해석했다.

그 이후로, PCA는 집단 유전학에서 보편화되었고, 수천 개의 논문이 PCA를 표시 메커니즘으로 사용하고 있습니다.유전학은 주로 근접성에 따라 다르므로, 처음 두 개의 주요 구성요소는 실제로 공간 분포를 보여주고 다른 모집단의 상대적인 지리적 위치를 지도화하는 데 사용될 수 있으며, 따라서 원래 [47]위치에서 헤매는 개인을 보여줄 수 있다.

유전학에서의 PCA는 이산적인 비정규 변수와 종종 이진 대립 유전자 마커에 대해 수행되었다는 점에서 기술적으로 논란이 있었다.PCA에 표준 오차 측정이 없는 것도 보다 일관된 사용에 방해가 됩니다.

시장조사 및 태도지수

시장조사는 PCA의 광범위한 사용자입니다.제품에 대한 고객 만족도 또는 고객 충성도 점수를 개발하고, 클러스터링을 통해 광고 캠페인의 대상이 될 수 있는 시장 세그먼트를 개발하는 데 사용됩니다. 이는 요인 생태학이 [48]유사한 특성을 가진 지리적 영역을 찾는 것과 거의 같은 방법입니다.

PCA는 대량의 데이터를 보다 빠르고 쉽게 분석할 수 있는 더 작고 소화하기 쉬운 변수로 빠르게 변환합니다.모든 소비자 설문지에는 소비자의 태도를 유도하기 위해 설계된 일련의 질문이 있으며, 주요 구성요소는 이러한 태도를 뒷받침하는 잠재적 변수를 찾는다.예를 들어, 2013년 옥스포드 인터넷 서베이는 2000명의 사람들에게 그들의 태도와 신념에 대해 질문했고, 이러한 분석가들로부터 4가지 주요 요소 차원을 추출했는데, 그들은 이를 '탈옥', '소셜 네트워킹', '효율성', '문제 창출'[49]로 파악했다.

2008년 Joe Flood의 또 다른 예는 호주의 2697가구를 대상으로 한 국가 조사에서 28가지 태도 질문에서 주택에 대한 태도 지수를 추출했다.첫 번째 주요 구성요소는 부동산과 주택 소유에 대한 일반적인 태도를 나타냈다.지표 또는 그 지표가 구체화한 태도 질문은 테뉴어 선택의 일반 선형 모델에 포함될 수 있다.민간 임대의 가장 강력한 결정 요인은 소득, 혼인 여부 또는 가구 [50]유형보다는 태도 지수였다.

양적 금융

양적금융에서 주성분 분석은 금리파생상품 포트폴리오의 [51]위험관리에 직접 적용할 수 있다.일반적으로 30~500개의 다른 시장가격형 스와프상품의 함수인 복수의 스와프상품을 거래하는 경우에는 거시기준으로 이자율의 경로를 나타내는 보통 3개 또는 4개의 주요요소로 축소한다.위험을 계수 하중(또는 승수)으로 변환하면 개별 30-500 버킷의 위험을 단순히 집합적으로 볼 수 있는 수준 이상의 평가와 이해를 얻을 수 있다.

PCA는 포트폴리오 리스크와 리스크 수익률 모두에 유사한 [52]방식으로 주식 포트폴리오에도 적용되어 왔습니다.한 가지 적용은 포트폴리오 리스크를 줄이는 것입니다.이 경우 기본주가 [53]아닌 "주요 포트폴리오"에 할당 전략이 적용됩니다.두 번째는 포트폴리오 수익률을 높이는 것으로, 주요 컴포넌트를 사용하여 상승 가능성이 [citation needed]있는 종목을 선택하는 것입니다.

신경과학

주요 성분 분석의 변형은 활동 [54]전위를 발생시키는 뉴런의 확률을 증가시키는 자극의 특정한 특성을 식별하기 위해 신경 과학에서 사용됩니다.이 기법을 스파이크 트리거 공분산 분석이라고 합니다.일반적인 응용 프로그램에서 실험자는 백색 소음 과정을 자극(일반적으로 테스트 피험자에 대한 감각 입력 또는 뉴런에 직접 주입된 전류)으로 제시하고 결과적으로 뉴런에 의해 생성된 일련의 활동 전위 또는 스파이크를 기록한다.아마도, 자극의 어떤 특징들은 뉴런이 더 급상승할 가능성을 높인다.이러한 특징을 추출하기 위해, 실험자는 스파이크 발생 앙상블의 공분산 행렬을 계산한다. 즉, 스파이크 발생 앙상블의 바로 앞에 있는 (일반적으로 100ms의 유한 시간대에 걸쳐 정의되고 이산화된) 모든 자극의 집합이다.스파이크 트리거 공분산 행렬과 이전 자극 앙상블의 공분산 행렬 사이의 차이의 고유 벡터는 스파이크 트리거 앙상블의 분산이 가장 많이 다른 자극 공간의 방향을 나타낸다.이전 자극 앙상블.특히, 가장 큰 양의 고유값을 가진 고유 벡터는 스파이크 유발 앙상블의 분산이 이전의 정맥류와 비교하여 가장 큰 양의 변화를 보인 방향에 해당한다.이러한 방향들은 자극의 변화가 급상승으로 이어지는 방향이었기 때문에, 종종 요구되는 관련 자극 특징의 근사치이다.

신경과학에서, PCA는 또한 활동 전위의 모양에서 뉴런의 정체를 구별하는데 사용된다.스파이크 분류는 세포 외 기록 기술이 종종 둘 이상의 뉴런에서 신호를 포착하기 때문에 중요한 절차입니다.스파이크 정렬에서는 먼저 PCA를 사용하여 활동전위파형의 공간의 차원을 줄인 후 클러스터 분석을 수행하여 특정 활동전위를 개별 뉴런과 연관시킵니다.

차원 감소 기법으로서의 PCA는 특히 큰 신경 앙상블의 조정된 활동을 검출하는 데 적합하다.이것은 뇌의 [55]상전이 동안 집합 변수, 즉 순서 매개변수를 결정하는 데 사용되어 왔다.

다른 방법과의 관계

대응 분석

대응 분석(CA)은 Jean-Paul Benzécri에[56] 의해 개발되었으며 개념적으로 PCA와 유사하지만, 행과 열이 동등하게 처리되도록 데이터를 스케일링한다(음수가 아니어야 함).전통적으로 분할표에 적용된다.CA는 이 표와 관련된 카이 제곱 통계량을 직교 [57]인자로 분해합니다.CA는 기술적 기법이기 때문에 카이 제곱 통계량이 적절한지 아닌지에 대한 표에 적용할 수 있습니다.디렌딩 대응 분석 및 표준 대응 분석을 포함하여 CA의 여러 변형을 사용할 수 있습니다.한 가지 특수 확장으로는 범주형 [58]데이터에 대한 주성분 분석의 대응 분석으로 볼 수 있는 다중 대응 분석입니다.

인자 분석

주성분 분석은 원래 변수의 선형 조합인 변수를 생성합니다.새 변수에는 변수가 모두 직교하는 특성이 있습니다.PCA 변환은 클러스터링 전 처리 단계로 도움이 될 수 있습니다.PCA는 총 변수 분산을 재현하려는 분산 중심 접근법이며, 여기서 성분은 변수의 공통 분산과 고유 분산을 모두 반영합니다.일반적으로 PCA는 데이터 감소(변수 공간을 최적 요인 공간으로 변환) 목적으로 선호되지만, 잠재적 구성 요소 또는 요인을 탐지하는 것이 목표일 때는 선호되지 않는다.

인자 분석은 변수의 선형 조합도 포함된다는 점에서 주성분 분석과 유사합니다.PCA와 달리 인자 분석은 변수 간의 상관 관계를 재현하려는 상관 관계 중심 접근법이며, 여기서 인자는 "고유 [59]분산을 제외한 변수의 공통 분산을 나타낸다"고 합니다.상관 행렬의 관점에서, 이것은 오프 대각 항(공유 공분산)을 설명하는 데 초점을 맞추고, PCA는 대각선에 있는 항을 설명하는 데 초점을 맞춥니다.그러나 결과적으로, 온대각 항을 재현하려고 할 때, PCA는 오프대각 [10]: 158 상관 관계에도 비교적 잘 들어맞는 경향이 있습니다.PCA와 인자 분석에 의한 결과는 대부분의 경우 매우 비슷하지만 항상 그렇지는 않으며 결과가 크게 다른 문제도 있습니다.인자 분석은 일반적으로 연구 목적이 데이터 구조(잠재 구조 또는 요인) 또는 인과 모형화를 탐지하는 데 사용됩니다.요인 모형이 잘못 공식화되거나 가정이 충족되지 않으면 요인 분석에서 잘못된 [60]결과를 얻을 수 있습니다.

- K클러스터화

클러스터 지표에 의해 지정된 -평균 군집화의 완화된 솔루션은 주성분에 의해 주어지며, 주성분에 의해 확장된 PCA 부분 공간은 클러스터 중심 부분 공간과 [61][62]동일하다고 주장되어 왔다.그러나 PCA가 -평균 군집화의 유용한 완화라는 것은 [63]새로운 결과가 아니며, 클러스터 중심 하위 공간이 주방향에 [64]의해 확장된다는 진술에 대한 반례를 밝히는 것은 간단하다.

비음수 행렬 인수분해

NMF(Non-negative matrix factorization)는 행렬에서 음이 아닌 원소만 사용하는 차원 축소법으로서 천체물리학적 신호가 음이 아니라는 점에서 [20][21][22]천문학에서 유망한 방법이다.PCA 컴포넌트는 서로 직교하는 반면 NMF 컴포넌트는 모두 음이 아니기 때문에 비직교 베이스가 됩니다.

PCA에서 각 성분의 기여도는 경험적 [18]데이터 분석 시 분수잔차분산(FRV)에 해당하는 해당 고유값의 크기에 따라 순위가 매겨진다.NMF의 경우 해당 구성요소는 경험적 FRV 곡선만을 [22]기준으로 순위가 매겨집니다. 부분 고유값 그림 즉 - i / j n j { _{ \_{} {\sum _{n} \ _n} \sum _{n} \ kstyle kstyleda n} {\ /}의 총 kstyleda{n}의 성분으로 되는 kstyleda _{n}의 함수로서의 잔차 n의 고유값e 준정적 노이즈를 제거하기 위한 데이터는 캡처되지 않으며, 그 후 곡선은 과적합의 표시로 빠르게 떨어지며 [18]랜덤 노이즈를 캡처한다.NMF 컴포넌트가 [21]순차적으로 구성되면 NMF의 FRV 곡선이 연속적으로[22] 감소하여 준정적 노이즈의 연속적인 캡처를 나타내며, 그 후 [22]PCA보다 높은 수준으로 수렴하여 NMF의 과적합성이 낮음을 나타냅니다.

상관 관계 아이콘그래피

데이터에 다양한 기원의 변수가 많이 포함되어 있거나 일부 변수가 정성적인 경우에는 주성분을 해석하기가 어려운 경우가 많습니다.이를 통해 PCA 사용자는 몇 가지 변수를 세심하게 제거할 수 있습니다.관측치 또는 변수가 축의 방향에 과도한 영향을 미치는 경우 이를 제거한 다음 보조 요소로 투영해야 합니다.또한 요인 평면의 중심에 가까운 점 사이의 근접성을 해석하지 않도록 해야 합니다.

반대로 상관계의 도상학에는 이러한 단점이 없습니다.따라서 모든 변수를 유지할 수 있습니다.

다이어그램의 원리는 실선(양 상관) 또는 점선(음 상관)에 의해 상관 행렬의 "주목할 만한" 상관에 밑줄을 긋는 것입니다.

강한 상관 관계는 직접적이지 않으면 "주목할 만한" 것이 아니라 세 번째 변수의 영향으로 인해 발생합니다.반대로 약한 상관관계는 "주목할 만한" 경우가 있습니다.예를 들어 변수 Y가 여러 독립 변수에 의존하는 경우 Y와 각 변수의 상관 관계는 약하지만 "주목할 만한" 변수입니다.

Generalizations()

PCA()

PCA의 특별한 단점은 주성분이 일반적으로 모든 입력 변수의 선형 조합이라는 것입니다.스파스 PCA는 소수의 입력 변수만 포함하는 선형 조합을 찾아냄으로써 이 단점을 극복합니다.입력 변수에 희소성 제약 조건을 추가하여 데이터의 차원성을 줄이기 위해 기존의 주성분 분석(PCA) 방법을 확장합니다.다음과 같은 몇 가지 접근방식이 제안되었습니다.

- 회귀 프레임워크,[65]

- 볼록한 완화/반한 프로그래밍 프레임워크,[66]

- 일반화 전력법 프레임워크[67]

- 교대 최대화 프레임워크[68]

- 분기 및 경계 [69]기법을 사용한 정확한 방법 및 순방향 탐욕 검색,

- 베이지안 공식 프레임워크.[70]

스파스 PCA의 방법론 및 이론적 개발과 과학 연구에서의 적용은 최근 [71]설문지에서 검토되었다.

PCA

비선형 차원 축소를 위한 현대적 방법의 대부분은 이론적이고 알고리즘적인 뿌리를 PCA 또는 K-평균에서 찾는다.Pearson의 원래 아이디어는 일련의 데이터 점에 "가장 적합한" 직선(또는 평면)을 취하는 것이었습니다.Trevor Hastie는 그림에서 설명한 것처럼 데이터 근사치를 위한 다각형을 명시적으로 구성하고 그 위에 점을 투영하는 PCA의 기하학적 해석을 위한 자연적 확장으로서 주요[75] 곡선을 제안함으로써 이 개념을 확장했다.탄성 지도 알고리즘 및 주요 측지 [76]분석을 참조하십시오.또 하나의 일반적인 일반화는 커널 PCA로, 양의 확정 커널과 관련된 재생 커널 힐버트 공간에서 실행되는 PCA에 대응한다.

다중 선형 부분 공간 [77]학습에서 PCA는 텐서 표현에서 직접 특징을 추출하는 다중 선형 PCA(MPCA)로 일반화된다.텐서의 각 모드에서 PCA를 반복함으로써 MPCA를 해결한다.MPCA는 얼굴인식, 보행인식 등에 적용되어 왔다. MPCA는 상관관계가 없는 MPCA, 음이 아닌 MPCA 및 견고한 MPCA로 더욱 확대된다.

N방향 주성분 분석은 터커 분해, PARAFAC, 다중 인자 분석, 공동 관성 분석, STATIS 및 DISTATIS와 같은 모델을 사용하여 수행할 수 있습니다.

한 PCA ® PCA

PCA는 수학적으로 최적의 방법(오차 제곱을 최소화하는 경우)을 찾지만 큰 오차를 생성하는 데이터의 특이치에는 여전히 민감합니다. 이 방법은 처음부터 이 방법을 피하려고 합니다.따라서 PCA를 계산하기 전에 특이치를 제거하는 것이 일반적입니다.그러나 일부 상황에서는 특이치를 식별하기가 어려울 수 있습니다.예를 들어 상관 군집 분석과 같은 데이터 마이닝 알고리즘에서는 군집 및 특이치에 대한 점 할당이 사전에 알려져 있지 않습니다.최근 제안된 가중치 PCA에 기초한 PCA의[78] 일반화는 추정된 관련성에 기초하여 데이터 객체에 서로 다른 가중치를 할당함으로써 견고성을 높인다.

L1-norm 제제(L1-PCA)[5][3]에 기초한 특이치 내성 변종 PCA도 제안되었다.

하위 및 희박한 행렬의 분해를 통한 견고한 주성분 분석(RPCA)은 심하게 손상된 [79][80][81]관측치에 대해 잘 작동하는 PCA의 수정이다.

성분

독립 성분 분석(ICA)은 주성분 분석과 유사한 문제를 다루지만 연속적인 근사치보다는 추가로 분리할 수 있는 성분을 찾습니다.

컴포넌트

EE를 지정하면 E E로 분해하려고 합니다. PCA 및 ICA와 같은 기법과의 주요 차이점은 AA})의 일부 엔트리가 0으로 제한된다는 것입니다.서 P P를 규제층이라고 합니다.일반적으로 이러한 분해는 여러 개의 솔루션을 가질 수 있지만 다음 조건이 충족되면 다음과 같이 증명됩니다.

- A에는 풀컬럼 랭크가 .

- 각 열에는 L-1 의 ( 스타일 이 있어야 합니다 서 L(디스플레이 스타일 L은 A의 열 수또는의 수)입니다.이 기준의 근거는 노드에 연결된 모든 출력 노드와 함께 규제 레이어에서 노드를 삭제해도 결과는 완전한 컬럼랭크를 가진 접속 매트릭스로 특징지을 필요가 있다는 것입니다.

- P는 풀 로우 랭크를 가져야 합니다.

분해는 [82]스칼라에 의한 곱셈까지 고유합니다.

주성분 판별 분석(DAPC)은 유전적으로 관련된 개인의 군집을 식별하고 설명하는 데 사용되는 다변량 방법입니다.유전적 변이는 두 가지 요소로 구분된다: 그룹 간 및 그룹 내 변이, 그리고 그것은 전자를 최대화한다.선형 판별자는 군집을 가장 잘 분리하는 대립 유전자의 선형 조합입니다.따라서 이러한 차별에 가장 많이 기여하는 대립 유전자는 집단 간에 가장 현저하게 다르다.DAPC에 의해 식별된 그룹에 대한 대립 유전자의 기여는 그룹 간의 유전자[83] 분리를 촉진하는 게놈의 특정 영역을 가능하게 할 수 있다. DAPC에서 데이터는 먼저 주성분 분석(PCA)을 사용하여 변환되고 그 후에 식별 분석(DA)을 사용하여 식별된다.

DAPC는 Adegenet 패키지를 사용하여 R 상에서 실현할 수 있습니다.(상세: https://adegenet.r-forge.r-project.org/)

Code(소프트웨어/소스 코드)

- ALGLIB - PCA 및 잘린 PCA를 구현하는 C++ 및 C# 라이브러리

- Analytica – 내장된 IgenDecomp 함수는 주요 구성요소를 계산합니다.

- ELKI – PCA 기반 클러스터링 알고리즘뿐만 아니라 강력한 변종 PCA를 포함한 투영용 PCA가 포함됩니다.

- Gretl – 주요 성분 분석은 다음 중 하나를 통해 수행할 수 있습니다.

pca또는 ""를 하여 명령어를 실행합니다.princomp()★★★★★★ 。 - Julia – PCA 지원

pca - KNIME – Java 기반의 Analysis용 노드 배치 소프트웨어입니다.이 노드에서는 PCA, PCA compute, PCA Apply, PCA inverse라고 불리는 노드를 사용하면 쉽게 해석할 수 있습니다.

- Mathematica – 공분산 및 상관 방법을 모두 사용하여 PrincipleComponents 명령을 사용하여 주성분 분석을 구현합니다.

- MathPHP – PCA를 지원하는 PHP 수학 라이브러리.

- MATLAB - SVD 기능은 기본 시스템의 일부입니다.Statistics Toolbox에서 함수는

princomp★★★★★★★★★★★★★★★★★」pca하고, (R2012b)는 (R2012b)은 주요 컴포넌트를 제공합니다.pcares에서는 낮은 순위의 PCA 근사치에 대한 잔차 및 재구성된 행렬을 제공합니다. - Matplotlib – Python 라이브러리에는 .mlab 모듈에 PCA 패키지가 있습니다.

- mlpack : C++에서 주요 컴포넌트 분석을 구현합니다.

- NAG 라이브러리 – 주요 컴포넌트 분석은

g03aaFortran(포트란). - NMath:용 PCA를 포함한 자체 수치 라이브러리.NET 프레임워크

- GNU Octabe – 대부분 MATLAB과 호환되는 무료 소프트웨어 컴퓨팅 환경, 기능

princomp는 주요 컴포넌트를 나타냅니다. - 오픈 CVOpenCV

- Oracle Database 12c – 구현 방법

DBMS_DATA_MINING.SVDS_SCORING_MODE「」을 .SVDS_SCORING_PCA - 오렌지(소프트웨어)– PCA를 비주얼 프로그래밍 환경에 통합합니다.PCA에는 사용자가 대화식으로 주성분 수를 선택할 수 있는 스크리 그림(설명된 분산의 정도)이 표시됩니다.

- 오리진 – Pro 버전에 PCA가 포함되어 있습니다.

- Qlucore – PCA를 사용하여 다변량 데이터를 즉각적인 응답으로 분석하기 위한 상용 소프트웨어입니다.

- R – 무료 통계 패키지, 기능

princomp★★★★★★★★★★★★★★★★★」prcomp분석에 할 수 .prcomp는 일반적으로 더 나은 수치적 정확도를 제공하는 특이값 분해를 사용합니다.PCA를 R로 실장하는 패키지에는 다음이 포함되지만 이에 한정되는 것은 아닙니다.ade4,vegan,ExPosition,dimRed, , , , 입니다.FactoMineR. - SAS – 자체 소프트웨어(예[84]: 참조)

- Scikit-learn – PCA, 확률론적 PCA, 커널 PCA, 스파스 PCA 및 기타 기술을 분해 모듈에 포함하는 기계 학습용 Python 라이브러리.

- SPSS - 사회과학자가 PCA, 인자 분석 및 관련 클러스터 분석을 위해 가장 일반적으로 사용하는 독자 소프트웨어입니다.

- Weka – 주요 컴포넌트를 계산하는 모듈을 포함하는 기계 학습용 Java 라이브러리.

「」도 .

- 대응 분석(분할표의 경우)

- 다중 대응 분석(질적 변수의 경우)

- 혼합 데이터의 인자 분석(양적 변수와 질적 변수의 경우)

- 관계

- CUR 행렬 근사치(낮은 등급의 SVD 근사치를 대체할 수 있음)

- 분석

- 모드

- 탐색적 요인 분석(Wikdiversity)

- ★★★★★

- 기하학적 데이터 분석

- 독립 성분 분석

- 커널 PCA

- L1-규격 주성분 분석

- 낮은 등급의 근사치

- 행렬 분해

- 비음수 행렬 인수분해

- 비선형 치수 축소

- 오자의 법칙

- 점 분포 모델(형태측정 및 컴퓨터 비전에 적용되는 PCA)

- 주성분분석(위키북)

- 주성분 회귀 분석

- 특이 스펙트럼 분석

- 특이값 분해

- 스파스 PCA

- 변환 부호화

- 가중 최소 제곱

레퍼런스

- ^ Barnett, T. P. & R. Preisendorfer. (1987). "Origins and levels of monthly and seasonal forecast skill for United States surface air temperatures determined by canonical correlation analysis". Monthly Weather Review. 115 (9): 1825. Bibcode:1987MWRv..115.1825B. doi:10.1175/1520-0493(1987)115<1825:oaloma>2.0.co;2.

- ^ Hsu, Daniel; Kakade, Sham M.; Zhang, Tong (2008). A spectral algorithm for learning hidden markov models. arXiv:0811.4413. Bibcode:2008arXiv0811.4413H.

- ^ a b Markopoulos, Panos P.; Kundu, Sandipan; Chamadia, Shubham; Pados, Dimitris A. (15 August 2017). "Efficient L1-Norm Principal-Component Analysis via Bit Flipping". IEEE Transactions on Signal Processing. 65 (16): 4252–4264. arXiv:1610.01959. Bibcode:2017ITSP...65.4252M. doi:10.1109/TSP.2017.2708023. S2CID 7931130.

- ^ a b Chachlakis, Dimitris G.; Prater-Bennette, Ashley; Markopoulos, Panos P. (22 November 2019). "L1-norm Tucker Tensor Decomposition". IEEE Access. 7: 178454–178465. arXiv:1904.06455. doi:10.1109/ACCESS.2019.2955134.

- ^ a b Markopoulos, Panos P.; Karystinos, George N.; Pados, Dimitris A. (October 2014). "Optimal Algorithms for L1-subspace Signal Processing". IEEE Transactions on Signal Processing. 62 (19): 5046–5058. arXiv:1405.6785. Bibcode:2014ITSP...62.5046M. doi:10.1109/TSP.2014.2338077. S2CID 1494171.

- ^ Kanade, T.; Ke, Qifa (June 2005). Robust L1 Norm Factorization in the Presence of Outliers and Missing Data by Alternative Convex Programming. 2005 IEEE Computer Society Conference on Computer Vision and Pattern Recognition (CVPR'05). Vol. 1. IEEE. p. 739. CiteSeerX 10.1.1.63.4605. doi:10.1109/CVPR.2005.309. ISBN 978-0-7695-2372-9. S2CID 17144854.

- ^ Pearson, K. (1901). "On Lines and Planes of Closest Fit to Systems of Points in Space". Philosophical Magazine. 2 (11): 559–572. doi:10.1080/14786440109462720.

- ^ Hoteling, H. (1933)통계 변수의 복합체를 주성분으로 분석합니다.교육심리학 저널, 24, 417-441 및 498-520.

Hotelling, H (1936). "Relations between two sets of variates". Biometrika. 28 (3/4): 321–377. doi:10.2307/2333955. JSTOR 2333955. - ^ Stewart, G. W. (1993). "On the early history of the singular value decomposition". SIAM Review. 35 (4): 551–566. doi:10.1137/1035134.

- ^ a b c d e Jolliffe, I. T. (2002). Principal Component Analysis. Springer Series in Statistics. New York: Springer-Verlag. doi:10.1007/b98835. ISBN 978-0-387-95442-4.

- ^ Bengio, Y.; et al. (2013). "Representation Learning: A Review and New Perspectives". IEEE Transactions on Pattern Analysis and Machine Intelligence. 35 (8): 1798–1828. arXiv:1206.5538. doi:10.1109/TPAMI.2013.50. PMID 23787338. S2CID 393948.

- ^ Forkman J., Josse, J., Piepho, H. P. (2019). "Hypothesis tests for principal component analysis when variables are standardized". Journal of Agricultural, Biological, and Environmental Statistics. 24 (2): 289–308. doi:10.1007/s13253-019-00355-5.

{{cite journal}}: CS1 maint: multiple names: authors list (link) - ^ A. A. Miranda, Y. A. Le Borgne, and G. Bontempi. New Routes from Minimal Approximation Error to Principal Components, Volume 27, Number 3 / June, 2008, Neural Processing Letters, Springer

- ^ Fukunaga, Keinosuke (1990). Introduction to Statistical Pattern Recognition. Elsevier. ISBN 978-0-12-269851-4.

- ^ Alizadeh, Elaheh; Lyons, Samanthe M; Castle, Jordan M; Prasad, Ashok (2016). "Measuring systematic changes in invasive cancer cell shape using Zernike moments". Integrative Biology. 8 (11): 1183–1193. doi:10.1039/C6IB00100A. PMID 27735002.

- ^ Leznik, M; Tofallis, C. 2005 Estimating Invariant Principal Components Using Diagonal Regression.

- ^ Jonathon Shlens, A Tutorial on Principal Component Analysis.

- ^ a b c Soummer, Rémi; Pueyo, Laurent; Larkin, James (2012). "Detection and Characterization of Exoplanets and Disks Using Projections on Karhunen-Loève Eigenimages". The Astrophysical Journal Letters. 755 (2): L28. arXiv:1207.4197. Bibcode:2012ApJ...755L..28S. doi:10.1088/2041-8205/755/2/L28. S2CID 51088743.

- ^ Pueyo, Laurent (2016). "Detection and Characterization of Exoplanets using Projections on Karhunen Loeve Eigenimages: Forward Modeling". The Astrophysical Journal. 824 (2): 117. arXiv:1604.06097. Bibcode:2016ApJ...824..117P. doi:10.3847/0004-637X/824/2/117. S2CID 118349503.

- ^ a b Blanton, Michael R.; Roweis, Sam (2007). "K-corrections and filter transformations in the ultraviolet, optical, and near infrared". The Astronomical Journal. 133 (2): 734–754. arXiv:astro-ph/0606170. Bibcode:2007AJ....133..734B. doi:10.1086/510127. S2CID 18561804.

- ^ a b c Zhu, Guangtun B. (2016-12-19). "Nonnegative Matrix Factorization (NMF) with Heteroscedastic Uncertainties and Missing data". arXiv:1612.06037 [astro-ph.IM].

- ^ a b c d e f Ren, Bin; Pueyo, Laurent; Zhu, Guangtun B.; Duchêne, Gaspard (2018). "Non-negative Matrix Factorization: Robust Extraction of Extended Structures". The Astrophysical Journal. 852 (2): 104. arXiv:1712.10317. Bibcode:2018ApJ...852..104R. doi:10.3847/1538-4357/aaa1f2. S2CID 3966513.

- ^ "What are the Pros and cons of the PCA?". i2tutorials. September 1, 2019. Retrieved June 4, 2021.

- ^ Abbott, Dean (May 2014). Applied Predictive Analytics. Wiley. ISBN 9781118727966.

- ^ a b Jiang, Hong; Eskridge, Kent M. (2000). "Bias in Principal Components Analysis Due to Correlated Observations". Conference on Applied Statistics in Agriculture. doi:10.4148/2475-7772.1247. ISSN 2475-7772.

- ^ Linsker, Ralph (March 1988). "Self-organization in a perceptual network". IEEE Computer. 21 (3): 105–117. doi:10.1109/2.36. S2CID 1527671.

- ^ Deco & Obradovic (1996). An Information-Theoretic Approach to Neural Computing. New York, NY: Springer. ISBN 9781461240167.

- ^ Plumbley, Mark (1991). Information theory and unsupervised neural networks.Tech Note

- ^ Geiger, Bernhard; Kubin, Gernot (January 2013). "Signal Enhancement as Minimization of Relevant Information Loss". Proc. ITG Conf. On Systems, Communication and Coding. arXiv:1205.6935. Bibcode:2012arXiv1205.6935G.

- ^ "Engineering Statistics Handbook Section 6.5.5.2". Retrieved 19 January 2015.

- ^ A.A. Miranda, Y.-A. Le Borgne, and G. Bontempi. New Routes from Minimal Approximation Error to Principal Components, Volume 27, Number 3 / June, 2008, Neural Processing Letters, Springer

- ^ Abdi. H. & Williams, L.J. (2010). "Principal component analysis". Wiley Interdisciplinary Reviews: Computational Statistics. 2 (4): 433–459. arXiv:1108.4372. doi:10.1002/wics.101. S2CID 122379222.

- ^ "SAS/STAT(R) 9.3 User's Guide".

- ^ eig function Matlab documentation

- ^ MATLAB PCA-based Face recognition software

- ^ Eigenvalues function Mathematica documentation

- ^ Roweis, Sam. "EM Algorithms for PCA and SPCA." Advances in Neural Information Processing Systems. Ed. Michael I. Jordan, Michael J. Kearns, and Sara A. Solla The MIT Press, 1998.

- ^ Geladi, Paul; Kowalski, Bruce (1986). "Partial Least Squares Regression:A Tutorial". Analytica Chimica Acta. 185: 1–17. doi:10.1016/0003-2670(86)80028-9.

- ^ Kramer, R. (1998). Chemometric Techniques for Quantitative Analysis. New York: CRC Press. ISBN 9780203909805.

- ^ Andrecut, M. (2009). "Parallel GPU Implementation of Iterative PCA Algorithms". Journal of Computational Biology. 16 (11): 1593–1599. arXiv:0811.1081. doi:10.1089/cmb.2008.0221. PMID 19772385. S2CID 1362603.

- ^ Warmuth, M. K.; Kuzmin, D. (2008). "Randomized online PCA algorithms with regret bounds that are logarithmic in the dimension" (PDF). Journal of Machine Learning Research. 9: 2287–2320.

- ^ Kaplan, R.M., & Saccuzzo, D.P. (2010). Psychological Testing: Principles, Applications, and Issues. (8th ed.). Belmont, CA: Wadsworth, Cengage Learning.

- ^ Shevky, Eshref; Williams, Marilyn (1949). The Social Areas of Los Angeles: Analysis and Typology. University of California Press.

- ^ Flood, J (2000). Sydney divided: factorial ecology revisited. Paper to the APA Conference 2000, Melbourne,November and to the 24th ANZRSAI Conference, Hobart, December 2000.[1]

- ^ "Socio-Economic Indexes for Areas". Australian Bureau of Statistics. 2011. Retrieved 2022-05-05.

- ^ Human Development Reports. "Human Development Index". United Nations Development Programme. Retrieved 2022-05-06.

- ^ Novembre, John; Stephens, Matthew (2008). "Interpreting principal component analyses of spatial population genetic variation". Nat Genet. 40 (5): 646–49. doi:10.1038/ng.139. PMC 3989108. PMID 18425127.

- ^ DeSarbo, Wayne; Hausmann, Robert; Kukitz, Jeffrey (2007). "Restricted principal components analysis for marketing research". Journal of Marketing in Management. 2: 305–328 – via Researchgate.

- ^ Dutton, William H; Blank, Grant (2013). Cultures of the Internet: The Internet in Britain (PDF). Oxford Internet Institute. p. 6.

- ^ Flood, Joe (2008). "Multinomial Analysis for Housing Careers Survey". Paper to the European Network for Housing Research Conference, Dublin. Retrieved 6 May 2022.

- ^ The Pricing and Hedging of Interest Rate Derivatives: A Practical Guide to Swaps, J H M Darbyshire, 2016, ISBN 978-0995455511

- ^ Giorgia Pasini (2017); Principal Component Analysis for Stock Portfolio Management. International Journal of Pure and Applied Mathematics. Volume 115 No. 1 2017, 153–167

- ^ Libin Yang. An Application of Principal Component Analysis to Stock Portfolio Management. Department of Economics and Finance, University of Canterbury, January 2015.

- ^ Brenner, N., Bialek, W., & de Ruyter van Steveninck, R.R. (2000).

- ^ Jirsa, Victor; Friedrich, R; Haken, Herman; Kelso, Scott (1994). "A theoretical model of phase transitions in the human brain". Biological Cybernetics. 71 (1): 27–35. doi:10.1007/bf00198909. PMID 8054384. S2CID 5155075.

- ^ Benzécri, J.-P. (1973). L'Analyse des Données. Volume II. L'Analyse des Correspondances. Paris, France: Dunod.

- ^ Greenacre, Michael (1983). Theory and Applications of Correspondence Analysis. London: Academic Press. ISBN 978-0-12-299050-2.

- ^ Le Roux; Brigitte and Henry Rouanet (2004). Geometric Data Analysis, From Correspondence Analysis to Structured Data Analysis. Dordrecht: Kluwer. ISBN 9781402022357.

- ^ Timothy A. Brown. Confirmatory Factor Analysis for Applied Research Methodology in the social sciences. Guilford Press, 2006

- ^ Meglen, R.R. (1991). "Examining Large Databases: A Chemometric Approach Using Principal Component Analysis". Journal of Chemometrics. 5 (3): 163–179. doi:10.1002/cem.1180050305. S2CID 120886184.

- ^ H. Zha; C. Ding; M. Gu; X. He; H.D. Simon (Dec 2001). "Spectral Relaxation for K-means Clustering" (PDF). Neural Information Processing Systems Vol.14 (NIPS 2001): 1057–1064.

- ^ Chris Ding; Xiaofeng He (July 2004). "K-means Clustering via Principal Component Analysis" (PDF). Proc. Of Int'l Conf. Machine Learning (ICML 2004): 225–232.

- ^ Drineas, P.; A. Frieze; R. Kannan; S. Vempala; V. Vinay (2004). "Clustering large graphs via the singular value decomposition" (PDF). Machine Learning. 56 (1–3): 9–33. doi:10.1023/b:mach.0000033113.59016.96. S2CID 5892850. Retrieved 2012-08-02.

- ^ Cohen, M.; S. Elder; C. Musco; C. Musco; M. Persu (2014). Dimensionality reduction for k-means clustering and low rank approximation (Appendix B). arXiv:1410.6801. Bibcode:2014arXiv1410.6801C.

- ^ Hui Zou; Trevor Hastie; Robert Tibshirani (2006). "Sparse principal component analysis" (PDF). Journal of Computational and Graphical Statistics. 15 (2): 262–286. CiteSeerX 10.1.1.62.580. doi:10.1198/106186006x113430. S2CID 5730904.

- ^ Alexandre d'Aspremont; Laurent El Ghaoui; Michael I. Jordan; Gert R. G. Lanckriet (2007). "A Direct Formulation for Sparse PCA Using Semidefinite Programming" (PDF). SIAM Review. 49 (3): 434–448. arXiv:cs/0406021. doi:10.1137/050645506. S2CID 5490061.

- ^ Michel Journee; Yurii Nesterov; Peter Richtarik; Rodolphe Sepulchre (2010). "Generalized Power Method for Sparse Principal Component Analysis" (PDF). Journal of Machine Learning Research. 11: 517–553. arXiv:0811.4724. Bibcode:2008arXiv0811.4724J. CORE Discussion Paper 2008/70.

- ^ Peter Richtarik; Martin Takac; S. Damla Ahipasaoglu (2012). "Alternating Maximization: Unifying Framework for 8 Sparse PCA Formulations and Efficient Parallel Codes". arXiv:1212.4137 [stat.ML].

- ^ Baback Moghaddam; Yair Weiss; Shai Avidan (2005). "Spectral Bounds for Sparse PCA: Exact and Greedy Algorithms" (PDF). Advances in Neural Information Processing Systems. Vol. 18. MIT Press.

- ^ Yue Guan; Jennifer Dy (2009). "Sparse Probabilistic Principal Component Analysis" (PDF). Journal of Machine Learning Research Workshop and Conference Proceedings. 5: 185.

- ^ Hui Zou; Lingzhou Xue (2018). "A Selective Overview of Sparse Principal Component Analysis". Proceedings of the IEEE. 106 (8): 1311–1320. doi:10.1109/JPROC.2018.2846588.

- ^ A. N. Gorban, A. Y. Zinovyev, Principal Graphs and Manifolds, In: Handbook of Research on Machine Learning Applications and Trends: Algorithms, Methods and Techniques, Olivas E.S. et al Eds. Information Science Reference, IGI Global: Hershey, PA, USA, 2009. 28–59.

- ^ Wang, Y.; Klijn, J. G.; Zhang, Y.; Sieuwerts, A. M.; Look, M. P.; Yang, F.; Talantov, D.; Timmermans, M.; Meijer-van Gelder, M. E.; Yu, J.; et al. (2005). "Gene expression profiles to predict distant metastasis of lymph-node-negative primary breast cancer". The Lancet. 365 (9460): 671–679. doi:10.1016/S0140-6736(05)17947-1. PMID 15721472. S2CID 16358549. Data online

- ^ Zinovyev, A. "ViDaExpert – Multidimensional Data Visualization Tool". Institut Curie. Paris. (free for non-commercial use)

- ^ Hastie, T.; Stuetzle, W. (June 1989). "Principal Curves" (PDF). Journal of the American Statistical Association. 84 (406): 502–506. doi:10.1080/01621459.1989.10478797.

- ^ A.N. Gorban, B. Kegl, D.C. Wunsch, A. Zinovyev (Eds.), Principal Manifolds for Data Visualisation and Dimension Reduction, LNCSE 58, Springer, Berlin – Heidelberg – New York, 2007. ISBN 978-3-540-73749-0

- ^ Lu, Haiping; Plataniotis, K.N.; Venetsanopoulos, A.N. (2011). "A Survey of Multilinear Subspace Learning for Tensor Data" (PDF). Pattern Recognition. 44 (7): 1540–1551. Bibcode:2011PatRe..44.1540L. doi:10.1016/j.patcog.2011.01.004.

- ^ Kriegel, H. P.; Kröger, P.; Schubert, E.; Zimek, A. (2008). A General Framework for Increasing the Robustness of PCA-Based Correlation Clustering Algorithms. Scientific and Statistical Database Management. Lecture Notes in Computer Science. Vol. 5069. pp. 418–435. CiteSeerX 10.1.1.144.4864. doi:10.1007/978-3-540-69497-7_27. ISBN 978-3-540-69476-2.

- ^ Emmanuel J. Candes; Xiaodong Li; Yi Ma; John Wright (2011). "Robust Principal Component Analysis?". Journal of the ACM. 58 (3): 11. arXiv:0912.3599. doi:10.1145/1970392.1970395. S2CID 7128002.

- ^ T. Bouwmans; E. Zahzah (2014). "Robust PCA via Principal Component Pursuit: A Review for a Comparative Evaluation in Video Surveillance". Computer Vision and Image Understanding. 122: 22–34. doi:10.1016/j.cviu.2013.11.009.

- ^ T. Bouwmans; A. Sobral; S. Javed; S. Jung; E. Zahzah (2015). "Decomposition into Low-rank plus Additive Matrices for Background/Foreground Separation: A Review for a Comparative Evaluation with a Large-Scale Dataset". Computer Science Review. 23: 1–71. arXiv:1511.01245. Bibcode:2015arXiv151101245B. doi:10.1016/j.cosrev.2016.11.001. S2CID 10420698.

- ^ Liao, J. C.; Boscolo, R.; Yang, Y.-L.; Tran, L. M.; Sabatti, C.; Roychowdhury, V. P. (2003). "Network component analysis: Reconstruction of regulatory signals in biological systems". Proceedings of the National Academy of Sciences. 100 (26): 15522–15527. Bibcode:2003PNAS..10015522L. doi:10.1073/pnas.2136632100. PMC 307600. PMID 14673099.

- ^ Liao, T.; Jombart, S.; Devillard, F.; Balloux (2010). "Discriminant analysis of principal components: a new method for the analysis of genetically structured populations". BMC Genetics. 11: 11:94. doi:10.1186/1471-2156-11-94. PMC 2973851. PMID 20950446.

- ^ "Principal Components Analysis". Institute for Digital Research and Education. UCLA. Retrieved 29 May 2018.

Further reading

- Jackson, J.E. (1991). A User's Guide to Principal Components (Wiley).

- Jolliffe, I. T. (1986). Principal Component Analysis. Springer Series in Statistics. Springer-Verlag. pp. 487. CiteSeerX 10.1.1.149.8828. doi:10.1007/b98835. ISBN 978-0-387-95442-4.

- Jolliffe, I. T. (2002). Principal Component Analysis. Springer Series in Statistics. New York: Springer-Verlag. doi:10.1007/b98835. ISBN 978-0-387-95442-4.

- Husson François, Lê Sébastien & Pagès Jérôme (2009). Exploratory Multivariate Analysis by Example Using R. Chapman & Hall/CRC The R Series, London. 224p. ISBN 978-2-7535-0938-2

- Pagès Jérôme (2014). Multiple Factor Analysis by Example Using R. Chapman & Hall/CRC The R Series London 272 p

External links

- University of Copenhagen video by Rasmus Bro on YouTube

- Stanford University video by Andrew Ng on YouTube

- A Tutorial on Principal Component Analysis

- A layman's introduction to principal component analysis on YouTube (a video of less than 100 seconds.)

- StatQuest: Principal Component Analysis (PCA) clearly explained on YouTube

- See also the list of Software implementations

q-제곱

q-제곱  (q × p) 행렬이며,

(q × p) 행렬이며,

B

B

원하는 정보 보유

원하는 정보 보유  노이즈

노이즈

최대화한다.

최대화한다.

p 변수의 단일 그룹화된 관찰을 나타냅니다.

p 변수의 단일 그룹화된 관찰을 나타냅니다.

첫 번째 열은 첫 번째 주성분에 대한 데이터 점 투영이고, 두 번째 열은 두 번째 주성분에 대한 투영 등입니다.

첫 번째 열은 첫 번째 주성분에 대한 데이터 점 투영이고, 두 번째 열은 두 번째 주성분에 대한 투영 등입니다.

단일 수율이라고

단일 수율이라고 ![{\displaystyle {\begin{aligned}\operatorname {cov} (PX)&=\operatorname {E} [PX~(PX)^{*}]\\&=\operatorname {E} [PX~X^{*}P^{*}]\\&=P\operatorname {E} [XX^{*}]P^{*}\\&=P\operatorname {cov} (X)P^{-1}\\\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/0e4800248eafcc33b2c22c5613f06b0c2455faad)

일부 엔트리가 0으로 제한된다는 것입니다.

일부 엔트리가 0으로 제한된다는 것입니다.