분산

Variance확률론 및 통계학에서 분산은 모집단 평균 또는 표본 평균에서 랜덤 변수의 편차 제곱에 대한 기대치입니다.분산은 산포의 측정값으로, 일련의 숫자들이 평균값에서 얼마나 멀리 퍼져 있는지를 나타내는 측정값입니다.분산은 통계학에서 중심적인 역할을 하며, 이를 사용하는 일부 아이디어에는 기술 통계학, 통계 추론, 가설 검정, 적합도 및 몬테 카를로 표본 추출이 포함된다.분산은 데이터의 통계 분석이 일반적인 과학에서 중요한 도구이다.분산은 표준 편차의 제곱, 분포의 두 번째 중심 모멘트 및 랜덤 변수와의 공분산이며, 종종 ^{ s ),Var X)로 표시됩니다. V 또는 {[1]

분산의 척도로서의 분산의 장점은 예상되는 절대편차와 같은 분산의 다른 척도보다 대수적 조작에 더 적응할 수 있다는 것이다. 예를 들어, 상관되지 않은 랜덤 변수의 분산은 분산의 합과 같다.실제 적용에서 분산의 단점은 표준 편차와 달리 단위가 랜덤 변수와 다르다는 것입니다. 따라서 표준 편차는 계산이 완료되면 분산의 척도로 더 일반적으로 보고됩니다.

둘 다 "바리안스"라고 불리는 두 가지 뚜렷한 개념이 있습니다.하나는 위에서 설명한 바와 같이 이론적인 확률 분포의 일부이며 방정식에 의해 정의된다.다른 분산은 관측치 집합의 특성입니다.관측치에서 분산을 계산할 때 이러한 관측치는 일반적으로 실제 시스템에서 측정됩니다.시스템에 가능한 모든 관측치가 있으면 계산된 분산을 모집단 분산이라고 합니다.그러나 일반적으로 부분 집합만 사용할 수 있으며 여기서 계산된 분산을 표본 분산이라고 합니다.표본에서 계산된 분산은 전체 모집단 분산의 추정치로 간주됩니다.아래 절에서 설명하는 것처럼 모집단 분산의 추정치를 계산하는 방법은 여러 가지가 있습니다.

두 종류의 분산은 밀접하게 관련되어 있습니다.방법을 알아보려면 이론 확률 분포를 가설 관측치의 생성자로 사용할 수 있다고 생각해 보십시오.분포를 사용하여 무한한 수의 관측치를 생성하는 경우 해당 무한 집합에서 계산된 표본 분산은 분포의 분산 방정식을 사용하여 계산된 값과 일치합니다.

정의.

XX})의 분산은X({X []({ =\ [의 평균으로부터의 편차 제곱의 예상값입니다.

이 정의에는 이산형, 연속형, 둘 다 또는 혼합형 프로세스에 의해 생성되는 랜덤 변수가 포함됩니다.분산은 랜덤 변수 자체와의 공분산으로도 간주할 수 있습니다.

이 분산은 X X를 하는 확률 분포의 두 번째 누적액과도 동일합니다.이 분산은 Var (X ) \ (X ) 、 V()、 ( ) 、 V( X ) 、 、 X) 、 \ \ ( ) 2 、 2 2 {\2222222 \ stystystyle \ ma square" (마 제곱")분산 표현식은 다음과 같이 확장할 수 있습니다.

즉, X의 분산은 X의 제곱 평균에서 X의 평균 제곱을 뺀 값과 같습니다.방정식의 두 성분이 크기가 비슷할 경우 치명적인 취소가 발생하기 때문에 부동소수점 연산을 사용하는 계산에는 이 방정식을 사용하지 마십시오.안정적인 다른 수치적 대안은 분산 계산 알고리즘을 참조하십시오.

이산 랜덤 변수

랜덤 XX})의 생성기가 확률 질량 1, 2, n {인 경우,

서μ {\는 예상값입니다.그것은,

(이러한 이산 가중 분산을 합계가 1이 아닌 가중치로 지정하면 가중치의 합으로 나눕니다.)

The variance of a collection of equally likely values can be written as

서μ {\는 평균값입니다.그것은,

n\ n \style n \ n}개 의 분산은 평균을 직접 참조하지 않고 서로 [2]점의 모든 쌍방향 제곱 거리의 제곱 편차로 동등하게 표현할 수 있다.

절대 연속 랜덤 변수

랜덤 X({ X에 확률 밀도 f { f가 있고 F { F가 대응하는 누적 분포 함수인 경우,

또는 동등하게

서μ {\는 X{\ X의 예상값입니다.

이 공식에서 d dx 및 에 적분은 각각 Lebegue 및 Lebegue-Stieltjes 적분입니다.

2 ( x가 모든 유한간격 [ br ,{\ , }에서 리만 적분 가능한 경우

여기서 적분은 부적절한 리만 적분이다.

예

지수 분포

모수 θ를 갖는 지수 분포는 확률 밀도 함수가 다음과 같이 주어지는 연속 분포이다.

[0, ]의 인터벌로 설정합니다.그 평균은 다음과 같다.

부품별 통합을 사용하고 이미 계산된 예상 값을 활용하면 다음과 같은 이점이 있습니다.

따라서 X의 분산은 다음과 같이 주어진다.

공정한 주사위

공정한 6면 다이스는 각각 같은 확률 1/6을 갖는 결과 1~6을 갖는 이산 랜덤 변수 X로 모델링할 수 있다.X 의 예상치는(+ + + + +) / /. \ style ( + + + + ) / 6=2 입니다 따라서 X의 분산은

n면 다이의 결과 X의 분산에 대한 일반적인 공식은 다음과 같다.

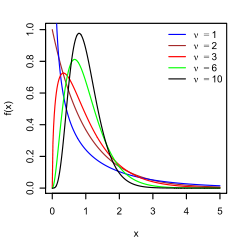

일반적으로 사용되는 확률 분포

다음 표에는 일반적으로 사용되는 확률 분포에 대한 분산이 나와 있습니다.

| 확률 분포 이름 | 확률분포함수 | 의미하다 | 분산 |

|---|---|---|---|

| 이항 분포 | |||

| 기하 분포 | |||

| 정규 분포 | |||

| 균일한 분포(연속) | |||

| 지수 분포 | |||

| 포아송 분포 |

특성.

기본 속성

제곱이 양수이거나 0이므로 분산이 음수가 아닙니다.

상수의 분산은 0입니다.

반대로 랜덤 변수의 분산이 0이면 거의 확실히 상수입니다.즉, 이 값은 항상 동일합니다.

분산은 위치 매개 변수의 변경과 관련하여 변하지 않습니다.즉, 변수의 모든 값에 상수가 추가되면 분산은 변경되지 않습니다.

모든 값이 상수에 따라 조정되는 경우 분산은 해당 상수의 제곱에 따라 조정됩니다.

두 개의 랜덤 변수 합계의 분산은 다음과 같습니다.

서 Cov ( ,) { ,)는 공분산입니다.

선형 조합

일반적으로 N N 랜덤변수 { \{의 합계에서는 다음과 같이 됩니다.

비에나예메 장군의 신원도 확인하세요

이러한 결과는 다음과 같은 선형 조합의 분산을 초래합니다.

1, N이 다음과 같은 경우

상관관계가 없는 것으로 알려져 있습니다.이는 랜덤 1, N이 상관관계가 없는 경우 분산의 합과 같거나 심볼적으로 표현된다는 앞에서 설명한 식에서 바로 나옵니다.

독립 랜덤 변수는 항상 상관 관계가 없으므로(공분산 unc 상관성 및 독립성 참조), 위의 방정식은 랜덤 X , n})이 독립적일 때 특히 유지됩니다.따라서 독립성은 충분하지만 합계의 분산이 분산의 합과 동일하기 위해서는 필요하지 않습니다.

최종성의 문제

Cauchy 분포의 경우와 같이 분포에 유한한 기대값이 없으면 분산도 유한할 수 없습니다.그러나 일부 분포는 기대치가 유한함에도 불구하고 유한한 분산을 가지지 않을 수 있습니다.예를 들어 가 1< 2를 하는 Pareto 분포가 있습니다 1 < \ 2}

분산의 다른 측도보다 분산을 사용하는 한 가지 이유는 상관 관계가 없는 랜덤 변수의 합계(또는 차이)의 분산이 분산의 합계이기 때문입니다.

이 문장은 비에나예메[3] 공식이라고 불리며 [4][5]1853년에 발견되었다.변수가 독립적이지만 상관 관계가 없는 것으로 충분하다는 더 강한 조건을 사용하여 생성되는 경우가 많습니다.따라서 모든 변수의 분산이2 같다면, n으로 나누면 선형 변환이므로, 이 공식은 평균의 분산이 다음과 같은 것을 즉시 암시합니다.

즉, n이 증가하면 평균의 분산이 감소합니다.이 평균 분산 공식은 표본 평균의 표준 오차 정의에 사용되며, 표본 평균은 중심 한계 정리에 사용됩니다.

최초의 진술을 증명하기 위해, 그것은 ...을 증명하는 것으로 충분하다.

그 후 일반적인 결과는 유도된다.정의부터 시작해서

기대 연산자의 선형성과 X와 Y의 독립성(또는 상관 없음) 가정을 사용하면 다음과 같이 더욱 단순해집니다.

상관 관계 및 고정 표본 크기

일반적으로 n개의 변수 합계의 분산은 공분산의 합계입니다.

(참고: 두 번째 등식은 Cov(Xi,Xi) = Var(Xi)라는 사실에서 나옵니다.)

여기서 ( , ) { ( \, \)는 독립된 랜덤 변수(존재하는 경우)에 대해 0인 공분산입니다.공식은 합계의 분산이 성분의 공분산 행렬에 있는 모든 원소의 합과 같다는 것을 나타냅니다.다음 식에서는 합계의 분산이 공분산 행렬의 대각선 합계에 상위 삼각 요소(또는 하위 삼각 요소)의 합계를 두 배 더한 값임을 나타냅니다. 이는 공분산 행렬이 대칭임을 강조합니다.이 공식은 고전 테스트 이론에서 크론바흐 알파 이론에서 사용됩니다.

따라서 변수의 분산이 같고2 개별 변수의 평균 상관 관계가 θ이면 평균의 분산은 다음과 같습니다.

이는 평균의 분산이 상관 관계의 평균과 함께 증가함을 의미합니다.즉, 추가적인 상관 관측치는 평균의 불확실성을 감소시키는 데 있어 추가적인 독립 관측치만큼 효과적이지 않습니다.또한 변수가 단위 분산을 갖는 경우(예: 변수가 표준화되어 있는 경우)에는 다음과 같이 단순화됩니다.

이 공식은 고전 검정 이론의 스피어맨-브라운 예측 공식에 사용됩니다.평균 상관관계가 일정하게 유지되거나 수렴되는 경우 n이 무한대로 되면 이 값은 θ로 수렴됩니다.따라서 동일한 상관 관계 또는 수렴 평균 상관 관계를 갖는 표준화된 변수의 평균의 분산에 대해서는

따라서 많은 수의 표준화된 변수의 평균 분산은 평균 상관 관계와 거의 동일합니다.이는 큰 수의 법칙이 표본 평균이 독립 변수에 대해 수렴할 것이라고 명시되어 있음에도 불구하고 상관 변수의 표본 평균이 일반적으로 모집단 평균에 수렴되지 않는다는 것을 알 수 있습니다.

무작위로 샘플 크기를 가진 신분증

어떤 기준에 따라 몇 개의 관측치가 허용될지 미리 알지 못한 채 표본을 채취하는 경우가 있다.이 경우 표본 크기 N은 변동이 X의 변동에 더해지는 랜덤 변수입니다.

이는 전분산의 법칙에서 비롯됩니다.

N이 포아송 분포를 갖는 경우, display [ ] () \ [N] \{Var 추정치 N = . 따라서 Var \i입니다. n ( ) 2 + n ( \ style \{ ( \ { X } ) ={{_ { x _ { x } + { n } } } } } { n } } } 2 } se se se se se se se se 。

선형 조합의 분산에 대한 행렬 표기법

X X를 의 X,},\의 벡터로 정의하고 c(\ n의 1, { {의 열 벡터로 합니다. c는 이들 랜덤 변수의 선형 조합입니다.서 c c는 c c의 전치입니다.또, 는 X X의 공분산 행렬이라고 합니다.으로 T X c의 분산을 [7]구한다.

즉, 평균의 분산은 (1의 열 벡터를 사용하여) 다음과 같이 쓸 수 있습니다.

변수의 가중치 합

스케일링 특성과 비에나예 공식은 공분산 Cov(aX, bY) = ab Cov(X, Y)의 특성과 함께 다음을 의미한다.

즉, 가중치 합계에서 가중치가 가장 큰 변수는 총량의 분산에서 불균형적으로 큰 가중치를 가집니다.예를 들어, X와 Y가 상관 관계가 없고 X의 무게가 Y의 두 배인 경우 X 분산의 무게는 Y의 네 배입니다.

위의 식은 여러 변수의 가중치 합계로 확장할 수 있습니다.

독립 변수의 곱

두 변수 X와 Y가 독립적일 경우 곱의 분산은 다음과[8] 같습니다.

마찬가지로, 기대의 기본 속성을 사용하여 다음과 같이 구한다.

통계적으로 종속된 변수의 산물

일반적으로 두 변수가 통계적으로 종속된 경우 곱의 분산은 다음과 같습니다.

분해

분산 분해 또는 전분산의 법칙의 일반적인 공식은 다음과 같습니다.XX)와 Y Y가 2개의 랜덤 변수이고 X X의 분산이 존재하는 ,

YY로 지정된X({X의 EXY와 조건부 Var Y로 해석할 수 있습니다.{ displaystyle }(X Y랜덤 변수 Y의 특정 값 y가 주어졌을 때, 이벤트 Y = y가 주어졌을 때 조건부 Eδ ( ∣ ) { Y가 존재한다.이 양은 특정 값 y에 따라 달라집니다.( ) ( ) { g ( y ) = \{ } ( \ Y )} 。랜덤 변수 Y에서 평가된 동일한 함수는 조건부 E ( XY ) () .{ Y)=입니다.

특히 Y{ Y가 가능한 {을(를) 가정한 이산 랜덤 일 , 다음 식에서 총, {}, 오른쪽이 되다

여기서 i Var [ Y ]{ _2}=\ [ Y 마찬가지로 오른쪽의 두 번째 항은

서 i [ Y i _ { { Y μ i= \ \ \ _ { {i} {i} {i} {i} {i} {i}입니다따라서 총 분산은 다음과 같이 구한다.

분산 분석에도 유사한 공식이 적용되며, 여기서 해당 공식은 다음과 같습니다.

서 MS {는 제곱의 평균을 나타냅니다.선형 회귀 분석에서 해당 공식은 다음과 같습니다.

총(관측) 점수는 예측 점수와 오차 점수의 합계이므로 분산의 가산성에서도 도출할 수 있으며, 여기서 후자의 두 점수는 상관 관계가 없다.

편차의 제곱합(제곱합, 에도 유사한 분해가 가능합니다.

Calculation from the CDF

The population variance for a non-negative random variable can be expressed in terms of the cumulative distribution function F using

This expression can be used to calculate the variance in situations where the CDF, but not the density, can be conveniently expressed.

Characteristic property

The second moment of a random variable attains the minimum value when taken around the first moment (i.e., mean) of the random variable, i.e. . Conversely, if a continuous function satisfies for all random variables X, then it is necessarily of the form , where a > 0. This also holds in the multidimensional case.[9]

Units of measurement

Unlike the expected absolute deviation, the variance of a variable has units that are the square of the units of the variable itself. For example, a variable measured in meters will have a variance measured in meters squared. For this reason, describing data sets via their standard deviation or root mean square deviation is often preferred over using the variance. In the dice example the standard deviation is √2.9 ≈ 1.7, slightly larger than the expected absolute deviation of 1.5.

The standard deviation and the expected absolute deviation can both be used as an indicator of the "spread" of a distribution. The standard deviation is more amenable to algebraic manipulation than the expected absolute deviation, and, together with variance and its generalization covariance, is used frequently in theoretical statistics; however the expected absolute deviation tends to be more robust as it is less sensitive to outliers arising from measurement anomalies or an unduly heavy-tailed distribution.

Approximating the variance of a function

The delta method uses second-order Taylor expansions to approximate the variance of a function of one or more random variables: see Taylor expansions for the moments of functions of random variables. For example, the approximate variance of a function of one variable is given by

provided that f is twice differentiable and that the mean and variance of X are finite.

Population variance and sample variance

Real-world observations such as the measurements of yesterday's rain throughout the day typically cannot be complete sets of all possible observations that could be made. As such, the variance calculated from the finite set will in general not match the variance that would have been calculated from the full population of possible observations. This means that one estimates the mean and variance from a limited set of observations by using an estimator equation. The estimator is a function of the sample of n observations drawn without observational bias from the whole population of potential observations. In this example that sample would be the set of actual measurements of yesterday's rainfall from available rain gauges within the geography of interest.

The simplest estimators for population mean and population variance are simply the mean and variance of the sample, the sample mean and (uncorrected) sample variance – these are consistent estimators (they converge to the correct value as the number of samples increases), but can be improved. Estimating the population variance by taking the sample's variance is close to optimal in general, but can be improved in two ways. Most simply, the sample variance is computed as an average of squared deviations about the (sample) mean, by dividing by n. However, using values other than n improves the estimator in various ways. Four common values for the denominator are n, n − 1, n + 1, and n − 1.5: n is the simplest (population variance of the sample), n − 1 eliminates bias, n + 1 minimizes mean squared error for the normal distribution, and n − 1.5 mostly eliminates bias in unbiased estimation of standard deviation for the normal distribution.

Firstly, if the true population mean is unknown, then the sample variance (which uses the sample mean in place of the true mean) is a biased estimator: it underestimates the variance by a factor of (n − 1) / n; correcting by this factor (dividing by n − 1 instead of n) is called Bessel's correction. The resulting estimator is unbiased, and is called the (corrected) sample variance or unbiased sample variance. For example, when n = 1 the variance of a single observation about the sample mean (itself) is obviously zero regardless of the population variance. If the mean is determined in some other way than from the same samples used to estimate the variance then this bias does not arise and the variance can safely be estimated as that of the samples about the (independently known) mean.

Secondly, the sample variance does not generally minimize mean squared error between sample variance and population variance. Correcting for bias often makes this worse: one can always choose a scale factor that performs better than the corrected sample variance, though the optimal scale factor depends on the excess kurtosis of the population (see mean squared error: variance), and introduces bias. This always consists of scaling down the unbiased estimator (dividing by a number larger than n − 1), and is a simple example of a shrinkage estimator: one "shrinks" the unbiased estimator towards zero. For the normal distribution, dividing by n + 1 (instead of n − 1 or n) minimizes mean squared error. The resulting estimator is biased, however, and is known as the biased sample variation.

Population variance

In general, the population variance of a finite population of size N with values xi is given by

where the population mean is

The population variance can also be computed using

This is true because

The population variance matches the variance of the generating probability distribution. In this sense, the concept of population can be extended to continuous random variables with infinite populations.

Sample variance

Biased sample variance

In many practical situations, the true variance of a population is not known a priori and must be computed somehow. When dealing with extremely large populations, it is not possible to count every object in the population, so the computation must be performed on a sample of the population.[10] Sample variance can also be applied to the estimation of the variance of a continuous distribution from a sample of that distribution.

We take a sample with replacement of n values Y1, ..., Yn from the population, where n < N, and estimate the variance on the basis of this sample.[11] Directly taking the variance of the sample data gives the average of the squared deviations:

Here, denotes the sample mean:

Since the Yi are selected randomly, both and are random variables. Their expected values can be evaluated by averaging over the ensemble of all possible samples {Yi} of size n from the population. For this gives:

Hence gives an estimate of the population variance that is biased by a factor of . For this reason, is referred to as the biased sample variance.

Unbiased sample variance

Correcting for this bias yields the unbiased sample variance, denoted :

Either estimator may be simply referred to as the sample variance when the version can be determined by context. The same proof is also applicable for samples taken from a continuous probability distribution.

The use of the term n − 1 is called Bessel's correction, and it is also used in sample covariance and the sample standard deviation (the square root of variance). The square root is a concave function and thus introduces negative bias (by Jensen's inequality), which depends on the distribution, and thus the corrected sample standard deviation (using Bessel's correction) is biased. The unbiased estimation of standard deviation is a technically involved problem, though for the normal distribution using the term n − 1.5 yields an almost unbiased estimator.

The unbiased sample variance is a U-statistic for the function ƒ(y1, y2) = (y1 − y2)2/2, meaning that it is obtained by averaging a 2-sample statistic over 2-element subsets of the population.

Distribution of the sample variance

Being a function of random variables, the sample variance is itself a random variable, and it is natural to study its distribution. In the case that Yi are independent observations from a normal distribution, Cochran's theorem shows that S2 follows a scaled chi-squared distribution:[12]

As a direct consequence, it follows that

and[13]

If the Yi are independent and identically distributed, but not necessarily normally distributed, then[14]

where κ is the kurtosis of the distribution and μ4 is the fourth central moment.

If the conditions of the law of large numbers hold for the squared observations, S2 is a consistent estimator of σ2. One can see indeed that the variance of the estimator tends asymptotically to zero. An asymptotically equivalent formula was given in Kenney and Keeping (1951:164), Rose and Smith (2002:264), and Weisstein (n.d.).[15][16][17]

Samuelson's inequality

Samuelson's inequality is a result that states bounds on the values that individual observations in a sample can take, given that the sample mean and (biased) variance have been calculated.[18] Values must lie within the limits

Relations with the harmonic and arithmetic means

It has been shown[19] that for a sample {yi} of positive real numbers,

where ymax is the maximum of the sample, A is the arithmetic mean, H is the harmonic mean of the sample and is the (biased) variance of the sample.

This bound has been improved, and it is known that variance is bounded by

where ymin is the minimum of the sample.[20]

Tests of equality of variances

Testing for the equality of two or more variances is difficult. The F test and chi square tests are both adversely affected by non-normality and are not recommended for this purpose.

Several non parametric tests have been proposed: these include the Barton–David–Ansari–Freund–Siegel–Tukey test, the Capon test, Mood test, the Klotz test and the Sukhatme test. The Sukhatme test applies to two variances and requires that both medians be known and equal to zero. The Mood, Klotz, Capon and Barton–David–Ansari–Freund–Siegel–Tukey tests also apply to two variances. They allow the median to be unknown but do require that the two medians are equal.

The Lehmann test is a parametric test of two variances. Of this test there are several variants known. Other tests of the equality of variances include the Box test, the Box–Anderson test and the Moses test.

Resampling methods, which include the bootstrap and the jackknife, may be used to test the equality of variances.

History

The term variance was first introduced by Ronald Fisher in his 1918 paper The Correlation Between Relatives on the Supposition of Mendelian Inheritance:[21]

The great body of available statistics show us that the deviations of a human measurement from its mean follow very closely the Normal Law of Errors, and, therefore, that the variability may be uniformly measured by the standard deviation corresponding to the square root of the mean square error. When there are two independent causes of variability capable of producing in an otherwise uniform population distributions with standard deviations and , it is found that the distribution, when both causes act together, has a standard deviation . It is therefore desirable in analysing the causes of variability to deal with the square of the standard deviation as the measure of variability. We shall term this quantity the Variance...

- A frequency distribution is constructed.

- The centroid of the distribution gives its mean.

- A square with sides equal to the difference of each value from the mean is formed for each value.

- Arranging the squares into a rectangle with one side equal to the number of values, n, results in the other side being the distribution's variance, σ2.

Moment of inertia

The variance of a probability distribution is analogous to the moment of inertia in classical mechanics of a corresponding mass distribution along a line, with respect to rotation about its center of mass.[citation needed] It is because of this analogy that such things as the variance are called moments of probability distributions.[citation needed] The covariance matrix is related to the moment of inertia tensor for multivariate distributions. The moment of inertia of a cloud of n points with a covariance matrix of is given by[citation needed]

This difference between moment of inertia in physics and in statistics is clear for points that are gathered along a line. Suppose many points are close to the x axis and distributed along it. The covariance matrix might look like

That is, there is the most variance in the x direction. Physicists would consider this to have a low moment about the x axis so the moment-of-inertia tensor is

Semivariance

The semivariance is calculated in the same manner as the variance but only those observations that fall below the mean are included in the calculation:

For inequalities associated with the semivariance, see Chebyshev's inequality § Semivariances.

Generalizations

For complex variables

If is a scalar complex-valued random variable, with values in then its variance is where is the complex conjugate of This variance is a real scalar.

For vector-valued random variables

As a matrix

If is a vector-valued random variable, with values in and thought of as a column vector, then a natural generalization of variance is where and is the transpose of and so is a row vector. The result is a positive semi-definite square matrix, commonly referred to as the variance-covariance matrix (or simply as the covariance matrix).

If is a vector- and complex-valued random variable, with values in then the covariance matrix is where is the conjugate transpose of [citation needed] This matrix is also positive semi-definite and square.

As a scalar

Another generalization of variance for vector-valued random variables , which results in a scalar value rather than in a matrix, is the generalized variance , the determinant of the covariance matrix. The generalized variance can be shown to be related to the multidimensional scatter of points around their mean.[23]

A different generalization is obtained by considering the Euclidean distance between the random variable and its mean. This results in which is the trace of the covariance matrix.

See also

- Bhatia–Davis inequality

- Coefficient of variation

- Homoscedasticity

- Least-squares spectral analysis for computing a frequency spectrum with spectral magnitudes in % of variance or in dB

- Popoviciu's inequality on variances

- Measures for statistical dispersion

- Variance-stabilizing transformation

Types of variance

References

- ^ Wasserman, Larry (2005). All of Statistics: a concise course in statistical inference. Springer texts in statistics. p. 51. ISBN 9781441923226.

- ^ Yuli Zhang, Huaiyu Wu, Lei Cheng (June 2012). Some new deformation formulas about variance and covariance. Proceedings of 4th International Conference on Modelling, Identification and Control(ICMIC2012). pp. 987–992.

{{cite conference}}: CS1 maint: uses authors parameter (link) - ^ Loève, M. (1977) "Probability Theory", Graduate Texts in Mathematics, Volume 45, 4th edition, Springer-Verlag, p. 12.

- ^ Bienaymé, I.-J. (1853) "Considérations à l'appui de la découverte de Laplace sur la loi de probabilité dans la méthode des moindres carrés", Comptes rendus de l'Académie des sciences Paris, 37, p. 309–317; digital copy available [1]

- ^ Bienaymé, I.-J. (1867) "Considérations à l'appui de la découverte de Laplace sur la loi de probabilité dans la méthode des moindres carrés", Journal de Mathématiques Pures et Appliquées, Série 2, Tome 12, p. 158–167; digital copy available [2][3]

- ^ Cornell, J R, and Benjamin, C A, Probability, Statistics, and Decisions for Civil Engineers, McGraw-Hill, NY, 1970, pp.178-9.

- ^ Johnson, Richard; Wichern, Dean (2001). Applied Multivariate Statistical Analysis. Prentice Hall. p. 76. ISBN 0-13-187715-1.

- ^ Goodman, Leo A. (December 1960). "On the Exact Variance of Products". Journal of the American Statistical Association. 55 (292): 708–713. doi:10.2307/2281592. JSTOR 2281592.

- ^ Kagan, A.; Shepp, L. A. (1998). "Why the variance?". Statistics & Probability Letters. 38 (4): 329–333. doi:10.1016/S0167-7152(98)00041-8.

- ^ Navidi, William (2006) Statistics for Engineers and Scientists, McGraw-Hill, pg 14.

- ^ Montgomery, D. C. and Runger, G. C. (1994) Applied statistics and probability for engineers, page 201. John Wiley & Sons New York

- ^ Knight K. (2000), Mathematical Statistics, Chapman and Hall, New York. (proposition 2.11)

- ^ Casella and Berger (2002) Statistical Inference, Example 7.3.3, p. 331[full citation needed]

- ^ Mood, A. M., Graybill, F. A., and Boes, D.C. (1974) Introduction to the Theory of Statistics, 3rd Edition, McGraw-Hill, New York, p. 229

- ^ Kenney, John F.; Keeping, E.S. (1951) Mathematics of Statistics. Part Two. 2nd ed. D. Van Nostrand Company, Inc. Princeton: New Jersey. http://krishikosh.egranth.ac.in/bitstream/1/2025521/1/G2257.pdf

- ^ Rose, Colin; Smith, Murray D. (2002) Mathematical Statistics with Mathematica. Springer-Verlag, New York. http://www.mathstatica.com/book/Mathematical_Statistics_with_Mathematica.pdf

- ^ Weisstein, Eric W. (n.d.) Sample Variance Distribution. MathWorld—A Wolfram Web Resource. http://mathworld.wolfram.com/SampleVarianceDistribution.html

- ^ Samuelson, Paul (1968). "How Deviant Can You Be?". Journal of the American Statistical Association. 63 (324): 1522–1525. doi:10.1080/01621459.1968.10480944. JSTOR 2285901.

- ^ Mercer, A. McD. (2000). "Bounds for A–G, A–H, G–H, and a family of inequalities of Ky Fan's type, using a general method". J. Math. Anal. Appl. 243 (1): 163–173. doi:10.1006/jmaa.1999.6688.

- ^ Sharma, R. (2008). "Some more inequalities for arithmetic mean, harmonic mean and variance". Journal of Mathematical Inequalities. 2 (1): 109–114. CiteSeerX 10.1.1.551.9397. doi:10.7153/jmi-02-11.

- ^ Ronald Fisher (1918) The correlation between relatives on the supposition of Mendelian Inheritance

- ^ Fama, Eugene F.; French, Kenneth R. (2010-04-21). "Q&A: Semi-Variance: A Better Risk Measure?". Fama/French Forum.

- ^ Kocherlakota, S.; Kocherlakota, K. (2004). "Generalized Variance". Encyclopedia of Statistical Sciences. Wiley Online Library. doi:10.1002/0471667196.ess0869. ISBN 0471667196.

![{\displaystyle \mu =\operatorname {E} [X]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/ce1b41598b8e8f45f57c1550ebb8d5c7ab8e1210)

![\operatorname {Var} (X)=\operatorname {E} \left[(X-\mu )^{2}\right].](https://wikimedia.org/api/rest_v1/media/math/render/svg/55622d2a1cf5e46f2926ab389a8e3438edb53731)

![{\displaystyle {\begin{aligned}\operatorname {Var} (X)&=\operatorname {E} \left[(X-\operatorname {E} [X])^{2}\right]\\[4pt]&=\operatorname {E} \left[X^{2}-2X\operatorname {E} [X]+\operatorname {E} [X]^{2}\right]\\[4pt]&=\operatorname {E} \left[X^{2}\right]-2\operatorname {E} [X]\operatorname {E} [X]+\operatorname {E} [X]^{2}\\[4pt]&=\operatorname {E} \left[X^{2}\right]-\operatorname {E} [X]^{2}\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/4ad35c4161b9cf52868e879d457d8d796094ff02)

예상값입니다.그것은,

예상값입니다.그것은,

대응하는

대응하는 ![{\displaystyle {\begin{aligned}\operatorname {Var} (X)=\sigma ^{2}&=\int _{\mathbb {R} }(x-\mu )^{2}f(x)\,dx\\[4pt]&=\int _{\mathbb {R} }x^{2}f(x)\,dx-2\mu \int _{\mathbb {R} }xf(x)\,dx+\mu ^{2}\int _{\mathbb {R} }f(x)\,dx\\[4pt]&=\int _{\mathbb {R} }x^{2}\,dF(x)-2\mu \int _{\mathbb {R} }x\,dF(x)+\mu ^{2}\int _{\mathbb {R} }\,dF(x)\\[4pt]&=\int _{\mathbb {R} }x^{2}\,dF(x)-2\mu \cdot \mu +\mu ^{2}\cdot 1\\[4pt]&=\int _{\mathbb {R} }x^{2}\,dF(x)-\mu ^{2},\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/cdf3ec706581db5951e939cb3993a5c8289d7da4)

모든 유한

모든 유한![{\displaystyle [a,b]\subset \mathbb {R} ,}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c16929783780dae7bb2272902a6ee9345436b481)

![{\displaystyle \operatorname {E} [X]=\int _{0}^{\infty }\lambda xe^{-\lambda x}\,dx={\frac {1}{\lambda }}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/2fc9d5854b87fd1f6a380b1df34d7d9fffcf9b0b)

![{\displaystyle {\begin{aligned}\operatorname {E} \left[X^{2}\right]&=\int _{0}^{\infty }\lambda x^{2}e^{-\lambda x}\,dx\\&=\left[-x^{2}e^{-\lambda x}\right]_{0}^{\infty }+\int _{0}^{\infty }2xe^{-\lambda x}\,dx\\&=0+{\frac {2}{\lambda }}\operatorname {E} [X]\\&={\frac {2}{\lambda ^{2}}}.\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/206a5ddf1e6d9ce69e6609c702850172ff3e1311)

![{\displaystyle \operatorname {Var} (X)=\operatorname {E} \left[X^{2}\right]-\operatorname {E} [X]^{2}={\frac {2}{\lambda ^{2}}}-\left({\frac {1}{\lambda }}\right)^{2}={\frac {1}{\lambda ^{2}}}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/a5064d28d7da067a7a675ae68d992b83bc339c32)

![{\displaystyle {\begin{aligned}\operatorname {Var} (X)&=\sum _{i=1}^{6}{\frac {1}{6}}\left(i-{\frac {7}{2}}\right)^{2}\\[5pt]&={\frac {1}{6}}\left((-5/2)^{2}+(-3/2)^{2}+(-1/2)^{2}+(1/2)^{2}+(3/2)^{2}+(5/2)^{2}\right)\\[5pt]&={\frac {35}{12}}\approx 2.92.\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/6b1b6a74f544d9422366dc015805d67149030ec7)

![{\displaystyle {\begin{aligned}\operatorname {Var} (X)&=\operatorname {E} \left(X^{2}\right)-(\operatorname {E} (X))^{2}\\[5pt]&={\frac {1}{n}}\sum _{i=1}^{n}i^{2}-\left({\frac {1}{n}}\sum _{i=1}^{n}i\right)^{2}\\[5pt]&={\frac {(n+1)(2n+1)}{6}}-\left({\frac {n+1}{2}}\right)^{2}\\[4pt]&={\frac {n^{2}-1}{12}}.\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/9a476607e0a4d7f3ba660d8f260abd520b2ffbed)

![{\displaystyle f(x\mid a,b)={\begin{cases}{\frac {1}{b-a}}&{\text{for }}a\leq x\leq b,\\[3pt]0&{\text{for }}x<a{\text{ or }}x>b\end{cases}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/a49d9ce0f31f14565d14be7083c467987eb0823f)

다음과 같은 경우

다음과 같은 경우

![{\displaystyle {\begin{aligned}\operatorname {Var} (X+Y)&=\operatorname {E} \left[(X+Y)^{2}\right]-(\operatorname {E} [X+Y])^{2}\\[5pt]&=\operatorname {E} \left[X^{2}+2XY+Y^{2}\right]-(\operatorname {E} [X]+\operatorname {E} [Y])^{2}.\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/19f68b26d8eddd872d85cb9b846a7b8253c30a18)

![{\displaystyle {\begin{aligned}\operatorname {Var} (X+Y)&=\operatorname {E} \left[X^{2}\right]+2\operatorname {E} [XY]+\operatorname {E} \left[Y^{2}\right]-\left(\operatorname {E} [X]^{2}+2\operatorname {E} [X]\operatorname {E} [Y]+\operatorname {E} [Y]^{2}\right)\\[5pt]&=\operatorname {E} \left[X^{2}\right]+\operatorname {E} \left[Y^{2}\right]-\operatorname {E} [X]^{2}-\operatorname {E} [Y]^{2}\\[5pt]&=\operatorname {Var} (X)+\operatorname {Var} (Y).\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/a17cef95ad7c7877b877c4e7bb2b3788ff2dde00)

![{\displaystyle \operatorname {Var} \left(\sum _{i=1}^{n}X_{i}\right)=\operatorname {E} \left[N\right]\operatorname {Var} (X)+\operatorname {Var} (N)\operatorname {E} \left[X\right]^{2}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/73da0abb6abbc8ac847df8e45dc151d3262ab146)

![{\displaystyle \operatorname {E} [N]=\operatorname {Var} (N)}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c09780cf49339279202c5155f367541bd5978065)

열 벡터로

열 벡터로  이들 랜덤 변수의 선형

이들 랜덤 변수의 선형  c

c X

X

![{\displaystyle \operatorname {Var} (XY)=[\operatorname {E} (X)]^{2}\operatorname {Var} (Y)+[\operatorname {E} (Y)]^{2}\operatorname {Var} (X)+\operatorname {Var} (X)\operatorname {Var} (Y).}](https://wikimedia.org/api/rest_v1/media/math/render/svg/217846baaed2d1a73bd83728419c8199c66c06f0)

![{\displaystyle \operatorname {Var} (XY)=\operatorname {E} \left(X^{2}\right)\operatorname {E} \left(Y^{2}\right)-[\operatorname {E} (X)]^{2}[\operatorname {E} (Y)]^{2}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/60f81d984aa103aed089cc56c27406c845fa50da)

![{\displaystyle {\begin{aligned}\operatorname {Var} (XY)={}&\operatorname {E} \left[X^{2}Y^{2}\right]-[\operatorname {E} (XY)]^{2}\\[5pt]={}&\operatorname {Cov} \left(X^{2},Y^{2}\right)+\operatorname {E} (X^{2})\operatorname {E} \left(Y^{2}\right)-[\operatorname {E} (XY)]^{2}\\[5pt]={}&\operatorname {Cov} \left(X^{2},Y^{2}\right)+\left(\operatorname {Var} (X)+[\operatorname {E} (X)]^{2}\right)\left(\operatorname {Var} (Y)+[\operatorname {E} (Y)]^{2}\right)\\[5pt]&-[\operatorname {Cov} (X,Y)+\operatorname {E} (X)\operatorname {E} (Y)]^{2}\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/14f71664172a74f8d3dbf6f1b17addf168e55f11)

2개의 랜덤 변수이고 X

2개의 랜덤 변수이고 X![{\displaystyle \operatorname {Var} [X]=\operatorname {E} (\operatorname {Var} [X\mid Y])+\operatorname {Var} (\operatorname {E} [X\mid Y]).}](https://wikimedia.org/api/rest_v1/media/math/render/svg/d096b66af734c89681ab5cb61b24fbea63a48669)

해석할 수 있습니다.{ displaystyle

해석할 수 있습니다.{ displaystyle  존재한다.이 양은 특정 값 y에 따라 달라집니다.

존재한다.이 양은 특정 값 y에 따라 달라집니다.

(를) 가정한 이산 랜덤

(를) 가정한 이산 랜덤

![{\displaystyle \operatorname {E} (\operatorname {Var} [X\mid Y])=\sum _{i}p_{i}\sigma _{i}^{2},}](https://wikimedia.org/api/rest_v1/media/math/render/svg/dc52b9938aac880c80b76dfe0bacc302c1d0f1d3)

![{\displaystyle \sigma _{i}^{2}=\operatorname {Var} [X\mid Y=y_{i}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/5f02e555171b20f14167f31a43ad480f720a6fa6)

![{\displaystyle \operatorname {Var} (\operatorname {E} [X\mid Y])=\sum _{i}p_{i}\mu _{i}^{2}-\left(\sum _{i}p_{i}\mu _{i}\right)^{2}=\sum _{i}p_{i}\mu _{i}^{2}-\mu ^{2},}](https://wikimedia.org/api/rest_v1/media/math/render/svg/069ee9f564216faf173487039b77447b1ef07da2)

![{\displaystyle \mu _{i}=\operatorname {E} [X\mid Y=y_{i}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/0df777aa646f81fb52b31a3e13f983747fac39dd)

![{\displaystyle \operatorname {Var} [X]=\sum _{i}p_{i}\sigma _{i}^{2}+\left(\sum _{i}p_{i}\mu _{i}^{2}-\mu ^{2}\right).}](https://wikimedia.org/api/rest_v1/media/math/render/svg/5653ed0b0a55e26b4763766d3e118bc05ed569f4)

제곱의 평균을 나타냅니다.선형

제곱의 평균을 나타냅니다.선형

![{\displaystyle \operatorname {Var} \left[f(X)\right]\approx \left(f'(\operatorname {E} \left[X\right])\right)^{2}\operatorname {Var} \left[X\right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/8c58412ffa8fdf818b89bafb3318c4ace7cd8e9b)

![{\displaystyle {\begin{aligned}\sigma ^{2}&={\frac {1}{N}}\sum _{i=1}^{N}\left(x_{i}-\mu \right)^{2}={\frac {1}{N}}\sum _{i=1}^{N}\left(x_{i}^{2}-2\mu x_{i}+\mu ^{2}\right)\\[5pt]&=\left({\frac {1}{N}}\sum _{i=1}^{N}x_{i}^{2}\right)-2\mu \left({\frac {1}{N}}\sum _{i=1}^{N}x_{i}\right)+\mu ^{2}\\[5pt]&=\left({\frac {1}{N}}\sum _{i=1}^{N}x_{i}^{2}\right)-\mu ^{2}\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e37c1ee507b7c4281e55b812bc3cc4f9b29f490c)

![{\displaystyle {\begin{aligned}&{\frac {1}{2N^{2}}}\sum _{i,j=1}^{N}\left(x_{i}-x_{j}\right)^{2}\\[5pt]={}&{\frac {1}{2N^{2}}}\sum _{i,j=1}^{N}\left(x_{i}^{2}-2x_{i}x_{j}+x_{j}^{2}\right)\\[5pt]={}&{\frac {1}{2N}}\sum _{j=1}^{N}\left({\frac {1}{N}}\sum _{i=1}^{N}x_{i}^{2}\right)-\left({\frac {1}{N}}\sum _{i=1}^{N}x_{i}\right)\left({\frac {1}{N}}\sum _{j=1}^{N}x_{j}\right)+{\frac {1}{2N}}\sum _{i=1}^{N}\left({\frac {1}{N}}\sum _{j=1}^{N}x_{j}^{2}\right)\\[5pt]={}&{\frac {1}{2}}\left(\sigma ^{2}+\mu ^{2}\right)-\mu ^{2}+{\frac {1}{2}}\left(\sigma ^{2}+\mu ^{2}\right)\\[5pt]={}&\sigma ^{2}\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/5e777ea322a3d824db39d47bcd745c25951bcb33)

![{\displaystyle {\begin{aligned}\operatorname {E} [{\tilde {S}}_{Y}^{2}]&=\operatorname {E} \left[{\frac {1}{n}}\sum _{i=1}^{n}\left(Y_{i}-{\frac {1}{n}}\sum _{j=1}^{n}Y_{j}\right)^{2}\right]\\[5pt]&={\frac {1}{n}}\sum _{i=1}^{n}\operatorname {E} \left[Y_{i}^{2}-{\frac {2}{n}}Y_{i}\sum _{j=1}^{n}Y_{j}+{\frac {1}{n^{2}}}\sum _{j=1}^{n}Y_{j}\sum _{k=1}^{n}Y_{k}\right]\\[5pt]&={\frac {1}{n}}\sum _{i=1}^{n}\left({\frac {n-2}{n}}\operatorname {E} \left[Y_{i}^{2}\right]-{\frac {2}{n}}\sum _{j\neq i}\operatorname {E} \left[Y_{i}Y_{j}\right]+{\frac {1}{n^{2}}}\sum _{j=1}^{n}\sum _{k\neq j}^{n}\operatorname {E} \left[Y_{j}Y_{k}\right]+{\frac {1}{n^{2}}}\sum _{j=1}^{n}\operatorname {E} \left[Y_{j}^{2}\right]\right)\\[5pt]&={\frac {1}{n}}\sum _{i=1}^{n}\left[{\frac {n-2}{n}}\left(\sigma ^{2}+\mu ^{2}\right)-{\frac {2}{n}}(n-1)\mu ^{2}+{\frac {1}{n^{2}}}n(n-1)\mu ^{2}+{\frac {1}{n}}\left(\sigma ^{2}+\mu ^{2}\right)\right]\\[5pt]&={\frac {n-1}{n}}\sigma ^{2}.\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/9d2657f7f2cccbc5c408aa5b9c839f2db22cc7b2)

![{\displaystyle S^{2}={\frac {n}{n-1}}{\tilde {S}}_{Y}^{2}={\frac {n}{n-1}}\left[{\frac {1}{n}}\sum _{i=1}^{n}\left(Y_{i}-{\overline {Y}}\right)^{2}\right]={\frac {1}{n-1}}\sum _{i=1}^{n}\left(Y_{i}-{\overline {Y}}\right)^{2}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/ac7aceabda7de5a66183e73abc088ff3ac4e3e5b)

![{\displaystyle \operatorname {Var} \left[S^{2}\right]=\operatorname {Var} \left({\frac {\sigma ^{2}}{n-1}}\chi _{n-1}^{2}\right)={\frac {\sigma ^{4}}{(n-1)^{2}}}\operatorname {Var} \left(\chi _{n-1}^{2}\right)={\frac {2\sigma ^{4}}{n-1}}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/5bb1ae4124eef0e05850fa73406d8082bb13d79d)

![{\displaystyle \operatorname {E} \left[S^{2}\right]=\sigma ^{2},\quad \operatorname {Var} \left[S^{2}\right]={\frac {\sigma ^{4}}{n}}\left(\kappa -1+{\frac {2}{n-1}}\right)={\frac {1}{n}}\left(\mu _{4}-{\frac {n-3}{n-1}}\sigma ^{4}\right),}](https://wikimedia.org/api/rest_v1/media/math/render/svg/d3df338ff9496ec301869054c8032cc7f01a86f9)

![{\displaystyle \operatorname {E} \left[(x-\mu )(x-\mu )^{*}\right],}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c7cc7933557809745e2928b688000d26478bde22)

![{\displaystyle \operatorname {E} \left[(X-\mu )(X-\mu )^{\operatorname {T} }\right],}](https://wikimedia.org/api/rest_v1/media/math/render/svg/83bab02d13f2da96c2bbc93990454fa364ffea6b)

![{\displaystyle \operatorname {E} \left[(X-\mu )(X-\mu )^{\dagger }\right],}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f9b430afe926947268de35955a46b5977edadd6a)

![{\displaystyle \operatorname {E} \left[(X-\mu )^{\operatorname {T} }(X-\mu )\right]=\operatorname {tr} (C),}](https://wikimedia.org/api/rest_v1/media/math/render/svg/483e02bc316e8ecfeac1c71f1b2464b4ece2f45c)