로지스틱 회귀 분석

Logistic regression

통계학에서 (이진수) 로지스틱 모형(또는 로짓 모형)은 사건에 대한 로그 오드(확률의 로그)를 하나 이상의 독립 변수("예측 변수")의 선형 조합으로 하여 하나의 사건(두 가지 대안 중)이 발생할 확률을 모형화하는 통계 모형입니다.회귀 분석에서 로지스틱 회귀[1] 분석(또는 로짓 회귀 분석)은 로지스틱 모형의 모수(선형 조합의 계수)를 추정합니다.공식적으로 이항 로지스틱 회귀 분석에는 단일 이항 종속 변수가 존재하며, 여기서 두 값은 "0"과 "1"로 레이블이 지정되며, 독립 변수는 각각 이항 변수(지시 변수에 의해 코드화된 두 클래스) 또는 연속 변수(실제 값)일 수 있습니다.라벨이 붙은 값의 대응 확률은 0(확실히 "0" 값)과 1(확실히 "1" 값) 사이에서 다를 수 있습니다.따라서 라벨은 [2]log-odds를 확률로 변환하는 함수는 로지스틱 함수이므로 이름이 됩니다.log-ods 척도의 측정 단위는 로지트(logit)라고 하며 로지스틱 단위에서는 로지트(logit)로 불리므로 대체 이름이 사용됩니다.①배경 및 ②정식수학의 정의, ③예시를 참고하세요.

이진 변수는 팀이 우승할 확률 등 특정 클래스 또는 이벤트가 발생할 확률을 모델링하기 위해 통계에서 널리 사용되고 있으며( § 어플리케이션 참조), 로지스틱 모델은 [3]약 1970년부터 이진 회귀에 가장 일반적으로 사용되어 왔다.가능한 값이 세 개 이상인 경우(예: 이미지가 고양이, 개, 사자 등) 이항 로지스틱 회귀 분석에서 다항 로지스틱 회귀 분석으로 일반화된 경우 이항 로지스틱 회귀 분석에서 범주형 변수로 일반화할 수 있습니다.여러 범주가 정렬된 경우 순서형 로지스틱 회귀 분석(예: 비례 오즈 순서형 로지스틱[4] 모형)을 사용할 수 있습니다.추가 확장에 대해서는, 「확장」을 참조해 주세요.로지스틱 회귀 모델 자체는 입력 측면에서 출력의 확률을 모델링할 뿐이지만 통계적 분류(분류자가 아님)를 수행하지 않는다. 예를 들어 컷오프 값을 선택하고 컷오프보다 확률이 큰 입력을 하나의 클래스로 분류하는 방법으로 사용할 수 있다.e other. 이것은 바이너리 분류자를 만드는 일반적인 방법입니다.

로지스틱 함수 대신 다른 Sigmoid 함수를 사용하는 이항 변수에 대한 유사한 선형 모형도 사용할 수 있습니다. 특히 프로빗 모형은 § 대안을 참조하십시오.로지스틱 모형의 정의적 특성은 독립 변수 중 하나를 늘리면 각 독립 변수가 자체 모수를 가지면서 주어진 결과의 오즈를 일정한 비율로 곱셈 스케일링한다는 것입니다. 이 값은 이항 종속 변수의 경우 오즈비를 일반화시킵니다.보다 추상적으로, 로지스틱 함수는 베르누이 분포의 자연 모수이며, 이러한 의미에서 실수를 확률로 변환하는 "가장 간단한" 방법입니다.특히 엔트로피를 최대화(추가 정보 최소화)하며, 이러한 의미에서 모델링되는 데이터에 대한 가장 적은 가정을 합니다. ② 최대 엔트로피를 참조하십시오.

로지스틱 회귀 분석의 모수는 가장 일반적으로 MLE(최대우도 추정)를 통해 추정됩니다.선형 최소 제곱과 달리 닫힌 형식 식이 없습니다. § 모형 적합을 참조하십시오.MLE에 의한 로지스틱 회귀 분석은 이항 또는 범주형 반응에 대해 일반 최소 제곱에 의한 선형 회귀(OLS)가 스칼라 반응에 대해 수행하는 것과 유사한 기본적인 역할을 합니다. 단순하고 잘 분석된 기준선 모형입니다. 자세한 내용은 § 선형 회귀 분석과의 비교를 참조하십시오.일반 통계 모델로서의 로지스틱 회귀는 원래 조셉 버크슨에 [5]의해 개발되고 대중화되었으며, 이는 버크슨(1944)에서(1944)의 오류: "로짓(logit)"을 만든 CITEREF 1944도움말)에서 비롯되었다.

| 시리즈의 일부 |

| 회귀 분석 |

|---|

| 모델 |

| 견적 |

| 배경 |

적용들

로지스틱 회귀 분석은 기계 학습, 대부분의 의학 분야 및 사회 과학을 포함한 다양한 분야에서 사용됩니다.예를 들어, 부상 환자의 사망률을 예측하는 데 널리 사용되는 외상 및 부상 심각도 점수(TRISS)는 원래 Boyd가 로지스틱 회귀 분석을 사용하여 개발했다.[6]환자의 중증도를 평가하는 데 사용되는 다른 많은 의료 척도가 로지스틱 [7][8][9][10]회귀 분석을 사용하여 개발되었습니다.로지스틱 회귀를 사용하여 환자의 관찰된 특성(나이, 성별, 체질량 지수, 다양한 혈액 검사 결과 등)을 바탕으로 특정 질병(예: 당뇨병, 관상동맥 심장병)의 발병 위험을 예측할 수 있다.[11][12]또 다른 예는 네팔 유권자가 나이, 소득, 성별, 인종, 거주지, 이전 선거에서의 투표 등을 [13]기준으로 네팔 의회나 네팔 공산당 또는 기타 정당에 투표할지를 예측하는 것이다.이 기술은 엔지니어링에서도 사용할 수 있으며, 특히 주어진 프로세스, 시스템 또는 [14][15]제품의 고장 확률을 예측하기 위해 사용됩니다.고객의 상품 구매 성향 예측, 구독 중단 [16]등 마케팅 애플리케이션에도 활용됩니다.경제학에서, 그것은 한 사람이 결국 노동력을 갖게 될 가능성을 예측하는 데 사용될 수 있고, 사업 적용은 주택 소유자가 담보대출을 연체할 가능성을 예측하는 것이다.로지스틱 회귀를 순차적 데이터로 확장한 조건부 랜덤 필드는 자연 언어 처리에 사용됩니다.

예

문제

간단한 예로 설명 변수 하나와 범주 두 개가 포함된 로지스틱 회귀 분석을 사용하여 다음 질문에 답할 수 있습니다.

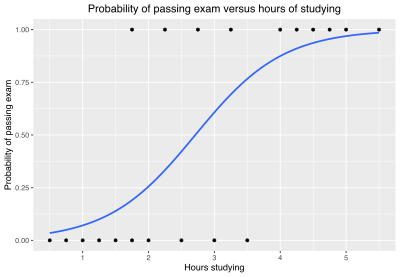

20명의 학생들이 시험을 위해 0시간에서 6시간을 공부한다.공부하는 시간이 학생이 시험에 합격할 확률에 어떤 영향을 미칩니까?

이 문제에 로지스틱 회귀 분석을 사용하는 이유는 "1"과 "0"으로 표시되는 종속 변수의 통과 및 실패 값이 기수가 아니기 때문입니다.문제가 변경되어 합격/실패가 등급 0-100(카드 번호)으로 대체되면 간단한 회귀 분석을 사용할 수 있습니다.

이 표에는 각 학생이 공부한 시간과 합격한 시간(1) 또는 실패한 시간(0)

| 시간(xk) | 0.50 | 0.75 | 1.00 | 1.25 | 1.50 | 1.75 | 1.75 | 2.00 | 2.25 | 2.50 | 2.75 | 3.00 | 3.25 | 3.50 | 4.00 | 4.25 | 4.50 | 4.75 | 5.00 | 5.50 |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 합격(yk) | 0 | 0 | 0 | 0 | 0 | 0 | 1 | 0 | 1 | 0 | 1 | 0 | 1 | 0 | 1 | 1 | 1 | 1 | 1 | 1 |

연구 시간(xk)과 검정 결과(합격의 경우 y = 1, 불합격의 경우 0)로k 구성된 데이터에 로지스틱 함수를 적합하려고 합니다.데이터 포인트는 k k)에서 k k까지 이어지는 첨자 k로 인덱싱됩니다.x 변수를 "설명 변수"라고 하고 y 변수를 "범주 변수"라고 하며, 범주 값 1과 0에 각각 해당하는 "통과" 또는 "실패"의 두 범주로 구성됩니다.

모델

여기서 μ는 위치 파라미터(곡선의 중간점, 서 p / p(\)= s는 스케일 파라미터입니다.이 표현은 다음과 같이 고쳐 쓸 수 있습니다.

서 0 - / { _ 0} = -\ }이며 절편( + x { y = \ _ + \_ {1 ) 및 1 / / s ({\ \ disparamescale \ {}) 스케일)이라고 합니다.x의 함수로서 로그값의 y값과 기울기. 반대로, - / 1 { \mu -\ /\ = / 1 { s1 /\

맞다

로지스틱 회귀 분석에 대한 일반적인 적합도 측도에서는 음의 로그 우도인 로지스틱 손실(또는 로그 손실)을 사용합니다.특정k x 및k y에 대해 p ( k) { }=라고 합니다. k})는 하는 k(\가 단일성이 될 확률이며 k는 0이 될 확률입니다(베르누이 분포 참조).데이터에 가장 적합한 0 1({ 값을 .선형 회귀 분석의 경우 데이터 점으로부터의 적합치 편차 제곱합(yk)인 오차 손실 제곱이 적합도의 측정값으로 간주되며, 이 함수를 최소화할 때 최적 적합치를 구합니다.

k번째 지점의 로그 손실은 다음과 같습니다.

로그 손실은 kdisplaystyle 에 대한 실제 y })의 "대략"으로 해석할 수 있으며, 이는 정보 내용의 척도입니다.로그 손실은 항상 0보다 크거나 같으며, 완벽한 예측(: p k { }=1 k 1{displaystyle }=} 또는 k {} })인 경우에만 0과 같습니다.ts는 더 나쁨(: y k {}= 및 0 { 0 y {}= 및 {1)을 의미하며, 실제 결과는 "더 놀랍습니다."로지스틱 함수의 값은 항상 0과 1 사이이므로 로그 손실은 항상 0보다 크고 무한대보다 작습니다.참고는 yk{\displaystyle y_{k}}은 0또는 1이지만 0<>안 k<1{\displ부터 물류 회귀에 어떠한 지점에서 0의 손실이 될 수 없는은 어디서 모델은 지점에서 데이터 지점(그리고 만약 모든 점 선 위 제로 손실 전체다)를 지나는 0의 손실일 수 있는 선형 회귀, 때와는 다르게.aysty 0 < _ { < 。

이것들은 1개의 식에 조합할 수 있습니다.

이 표현은 실제 분포k(- k에서 예측된분포(\p_{k}, - p_{k}){\의 교차 엔트로피로 더 공식적으로 알려져 있습니다.\( ) y _ { , (1 - )} ) 。확률, 。(합격, 실패)의 ement space.

총 손실의 합계는 전체 마이너스 로그우도 {\이며, 0 \_{과 1(\ _}) 에서 - {\이 최소화된 경우에 가장 적합합니다.

또는 손실을 최소화하는 대신 역(양수) 로그 우도를 최대화할 수 있습니다.

또는 특정 로지스틱 함수에 의해 특정 데이터 집합이 생성될 확률인 우도 함수 자체를 동등하게 최대화합니다.

모수 추정

0 \0}) 1(\ _에서는 θ가 비선형이기 때문에 최적값을 결정하려면 수치적 방법이 필요하다.β를 최대화하는 방법 중 하나는 0 _ 1(\ _에 β의 도함수를 0으로 하는 것입니다.

그리고 최대화 절차는 00})과 β1({1에 대해 위의 두 가지 방정식을 풀면 달성될 수 있으며, 이는 일반적으로 수치적 방법을 사용해야 한다.

위의 데이터를 사용하여 β와 L을 최대화하는 0 _ 1(\ _{의 은 다음과 같습니다.

μ 및 s의 값은 다음과 같습니다.

예측

로지스틱 회귀 방정식에 0 _ 1(\ _{ 계수를 하여 시험에 합격할 확률을 추정할 수 있습니다.

예를 들어, 2시간 공부하는 학생의 경우 x x) 을 방정식에 입력하면 시험에 합격할 확률이 0.25로 추정됩니다.

마찬가지로 4시간 공부하는 학생의 경우 시험에 합격할 확률은 0.87입니다.

이 표는 몇 시간 동안 공부할 수 있는 예상 합격 확률을 보여 줍니다.

| 몇시간. 연구중인 (x) | 합격시험 | ||

|---|---|---|---|

| 로그오드(t) | 확률(et) | 확률(p) | |

| 1 | −2.57 | 0.076 ≈ 1:13.1 | 0.07 |

| 2 | −1.07 | 0.34 ≈ 1:2.91 | 0.26 |

| 0 | 1 | 2 스타일}}) = 0.50 | |

| 3 | 0.44 | 1.55 | 0.61 |

| 4 | 1.94 | 6.96 | 0.87 |

| 5 | 3.45 | 31.4 | 0.97 |

모델 평가

로지스틱 회귀 분석에서는 다음과 같은 출력을 제공합니다.

| 계수 | 표준 오류 | z값 | p-값(Wald) | |

|---|---|---|---|---|

| 가로채기(β0) | −4.1 | 1.8 | −2.3 | 0.021 |

| 시간(β1) | 1.5 | 0.6 | 2.4 | 0.017 |

Wald 테스트에 따르면, 출력은 학습 시간이 시험에 합격할 확률과 유의하게 관련되어 있음을 ( p 0. 017}).Wald 방법보다 로지스틱 회귀 분석의 p-값을 계산하는 데 권장되는[citation needed] 방법은 우도비 검정(LRT)이며, 이 데이터의 p000 0 {\ p 0가 (아래 적합치의 오류 및 유의성 참조).

일반화

이 단순 모형은 이항 로지스틱 회귀 분석의 한 예제이며 두 범주형 값 중 하나를 가정할 수 있는 하나의 설명 변수와 이항 범주형 변수가 있습니다.다항 로지스틱 회귀 분석은 이항 로지스틱 회귀 분석을 일반화하여 설명 변수와 범주 수를 모두 포함하는 것입니다.

배경

로지스틱 함수의 정의

로지스틱 회귀 분석에 대한 설명은 표준 로지스틱 함수에 대한 설명으로 시작할 수 있습니다.로지스틱 함수는 임의의 실제 t t를 사용하여 0과 [2]1 사이의 값을 출력하는 Sigmoid 함수입니다.로짓의 경우 이는 입력 로그오드를 취득하여 출력확률을 갖는 것으로 해석됩니다. 로지스틱 함수 : ( ,) { \ , ) }는 다음과 같이 정의됩니다.

t 간격(-6,6)에 대한 로지스틱 함수의 그래프는 그림 1에 나와 있습니다.

tt는 단일 설명 x xdisplaystyle t의 선형 함수라고 합니다(tt가 다중 설명 변수의 선형 조합인 경우 로 처리됩니다).다음으로t\t를 다음과 같이 할 수 있습니다.

로지스틱 p : R ( , ){ p \는 다음과 같이 쓸 수 있습니다.

로지스틱 모델에서 p { p는 종속 Y { Y가 실패/비사례가 아닌 성공/사례와 같을 확률로 해석됩니다.응답 })가 동일한 분포를 보이지 않는 은 분명합니다 ( X P}= X는 하나의 데이터 Xi X_{와 다른 데이터 포인트 X(\ X는 서로 독립 설계 및 [11]

로지스틱 함수의 역함수 정의

이제 로짓(로그 오즈) 함수를 표준 로지스틱 함수의 - { g = \ ^{- 로 정의할 수 있습니다.다음 사항을 충족하는 것을 쉽게 알 수 있습니다.

마찬가지로, 양쪽을 지수화한 후 확률이 있습니다.

이러한 용어의 해석

위의 방정식에서는 다음과 같은 용어를 사용합니다.

- g는 로짓 함수입니다.g (){ g )의 방정식은 로짓(즉, 오즈의 로그 또는 자연 로그)이 선형 회귀식과 동등함을 나타냅니다.

- in 은 자연대수를 나타냅니다.

- () { p는 예측 변수의 선형 조합에 따라 종속 변수가 케이스와 같을 확률입니다.p( ){ p의 공식은 종속 변수가 대소문자와 같을 확률이 선형 회귀식의 로지스틱 함수 값과 같다는 것을 나타냅니다.이는 선형 회귀식의 값이 음수에서 양의 무한대까지 다를 수 있음을 나타내지만 변환 후 p p 의 범위는 0과 1 사이라는 점에서 중요합니다.

- 0은 선형 회귀 방정식(예측 변수가 0일 때의 기준 값)의 절편이다.

- 1 (\ \ _ x )는 회귀계수에 예측 변수의 값을 곱한 값입니다.

- ee는 지수함수를 나타냅니다.

확률의 정의

종속 변수가 사건(예측 변수의 일부 선형 x {\x})와 같을 확률은 선형 회귀식의 지수 함수와 동일합니다.이것은 로짓이 확률과 선형 회귀 표현식 사이의 연결 함수 역할을 하는 방법을 보여 줍니다.로짓이 음의 무한대와 양의 무한대 사이에 있는 경우, 선형 회귀를 수행하기 위한 적절한 기준을 제공하고 로짓은 쉽게 [2]오즈로 다시 변환됩니다.

따라서 종속 변수가 사례와 동일한 확률을 다음과 같이 정의한다(예측 변수의 조합x(\x)).

승산비

연속 독립 변수의 경우 승산비는 다음과 같이 정의할 수 있습니다.

이 지수관계는 1(\ _ [17]x가 1단위 증가할 때마다 확률은 1(\ e을 곱한다.

2진수 독립 변수의 경우 승산비는 c(\bc})로 정의됩니다.여기서 a, b c 및 d는 2×2 분할표 [18]내의 셀입니다.

다중 설명 변수

복수의 설명 변수가 있는 경우 위의 + 1 { + \ style x } + β 2 + 0+ i i \ style \ { + \ style _ { 1 } { 1 } x { 로 할 수 있다. __{_{이 값을 예측 변수의 값에 대한 로그 확률과 관련된 방정식에 사용할 경우 선형 회귀는 m개의 설명자를 사용한 다중 회귀가 됩니다. j ,,, {\j=1 display, 에 대한 β \j}}은 모두 추정됩니다.

기존 방정식은 다음과 같습니다.

그리고.

서 보통 b {\ b입니다.

정의.

로지스틱 회귀 분석의 기본 설정은 다음과 같습니다.N개의 포인트가 포함된 데이터 세트가 제공됩니다.나는 m입력 변수의 집합으로 구성되어 있각 지점은..., 이진 결과 변수 이 씨(또한 종속 변수, 응답 변수, 출력 변수 또는 클래스라고도), 즉 그것이 두가지 가능한 값은 0(종종 의미" 없"또는"실패")을 취할 수 있는xm,i(또한 독립 변수, 예언자라고 변수 기능 또는 특성이라고 불렀다)x1,i. 또는 1("예" 또는 "성공"을 의미하는 경우가 많습니다.로지스틱 회귀 분석의 목적은 데이터 집합을 사용하여 결과 변수의 예측 모형을 생성하는 것입니다.

선형 회귀 분석과 마찬가지로 결과 변수i Y는 설명 변수1,i x ...에 따라 달라지는 것으로 가정합니다.xm,i 를 클릭합니다.

- 설명 변수

설명 변수는 실수값, 이진수, 범주형 등 모든 유형일 수 있습니다.주요 차이점은 연속형 변수와 이산형 변수 사이의 차이입니다.

(두 개 이상의 가능한 선택지를 참조하는 이산 변수는 일반적으로 더미 변수(또는 지시 변수)를 사용하여 코드화된다. 즉, 이산 변수의 각 가능한 값에 대해 값 0 또는 1을 갖는 별도의 설명 변수가 생성되며, 1은 "변수가 주어진 값을 가지고 있다"를 의미하고 0은 "변수가 존재하지 않는다"를 의미한다.e' 값).

- 결과 변수

공식적으로 결과i Y는 베르누이 분포 데이터로 설명되며, 여기서 각 결과는 눈앞의 결과에 특정되지만 설명 변수에 관련된 관측되지 않은i 확률 p에 의해 결정된다.이는 다음과 같은 동등한 형태로 나타낼 수 있습니다.

이 4행의 의미는 다음과 같습니다.

- 첫 번째 행은 각i Y의 확률 분포를 나타냅니다. 설명 변수에 따라 조정되며, 모수i p를 가진 베르누이 분포를 따릅니다. 이 분포는 시행 i의 경우 1의 결과 확률입니다.위에서 설명한 바와 같이, 각 재판은 각각의 설명 변수를 가지고 있듯이, 각각의 개별 재판은 그 자체의 성공 확률을 가지고 있다.성공 확률i p는 관측되지 않으며, 그 확률을 사용한 개별 베르누이 실험의 결과만 관측된다.

- 두 번째 선은 각 Y의i 기대값이 베르누이 분포의 일반 특성인 성공 확률i p와 같다는 사실을 나타냅니다.즉, 동일한 성공 확률i p를 사용하여 많은 수의 베르누이 시험을 실행한 다음, 모든 1과 0 결과의 평균을 구하면 결과는 p에i 가까울 것입니다.이것은 평균적인 방법으로 하는 것이 단순히 보이는 성공 비율을 계산하기 때문이고, 우리는 이것을 근본적인 성공 확률로 수렴할 것으로 예상하기 때문입니다.

- 세 번째 줄은 베르누이 분포의 확률 질량 함수를 쓰고, 두 가지 가능한 결과를 각각 볼 확률을 지정합니다.

- 네 번째 줄은 확률 질량 함수를 작성하는 또 다른 방법으로, 별도의 사례를 쓸 필요가 없고 특정 유형의 계산에 더 편리합니다.이것은 Y가 0 또는 1의 값만 취할 수 있다는 사실에i 의존합니다.어느 경우든 지수 중 하나는 1로, 그 아래의 값을 "선택"하고 다른 하나는 0으로, 그 아래의 값을 "취소"합니다.따라서 결과는 앞의 행과 같이 p 또는 1 - p가ii 됩니다.

- 선형 예측 함수

로지스틱 회귀 분석의 기본 개념은 선형 예측 함수를 사용하여 확률i p를 모형화함으로써 선형 회귀 분석을 위해 이미 개발된 메커니즘을 사용하는 것입니다. 즉, 눈앞의 모형에 고유하지만 모든 시행에 동일한 설명 변수와 회귀 계수 집합의 선형 조합입니다.특정 데이터 포인트 i에 대한 선형 예측 f {)}는 다음과 같이 작성됩니다.

서 0 , , m {\ _ _은 결과에 대한 특정 설명 변수의 상대적 영향을 나타내는 회귀 계수이다.

모델은 일반적으로 다음과 같이 보다 컴팩트한 형태로 작성됩니다.

- 회귀 계수0 β1, β, ..., β는m 크기 m + 1의 단일 벡터 β로 그룹화된다.

- 데이터점 i마다 절편계수0 β에 대응하여 고정값 1의 추가설명 의사변수0,i x를 가산한다.

- 그 결과 나타나는 설명 변수0,i x, x1,i, ..., x는m,i 크기 m + 1의 단일 벡터i X로 그룹화된다.

이를 통해 다음과 같이 선형 예측 변수 함수를 작성할 수 있습니다.

두 벡터 사이의 점곱에 대한 표기법을 사용합니다.

여러 가지 설명 변수, 두 가지 범주

하나의 설명 변수에 대한 이항 로지스틱 회귀 분석의 위의 예는 임의의 수의 설명 변수1 x, x2,... 및 임의의 수의 값 y ,, y=, 2에 대한 이항 로지스틱 회귀 분석으로 일반화할 수 있습니다.

우선 설명 변수 x1, x2...가 M개인 로지스틱 모형을 고려할 수 있습니다.xM 및 위의 예제와 같이 두 개의 범주형 값(y = 0 및 1)입니다.단순 이항 로지스틱 회귀 모델의 경우, 예측 변수와 1(\ y인 이벤트의 로그 추출(로짓이라고도 함) 사이의 선형 관계를 가정했다.이 선형 관계는 M개의 설명 변수의 경우로 확장될 수 있습니다.

여기서 t는 출력이고 i \ \ style _ { 는 모델의 파라미터입니다.모델 b의 밑이 오일러 수 e로 제한되지 않는 추가적인 일반화가 도입되었다.대부분의 어플리케이션에서 로그의 b b는 보통 e로 간주됩니다.그러나 경우에 따라서는 Base 2 또는 Base 10에서 작업함으로써 결과를 보다 쉽게 전달할 수 있습니다.

보다 간결한 표기법을 위해 설명 변수와 β 계수를( ) -차원 벡터로 지정합니다.

추가 설명 변수0 x =1을 포함합니다.이제 로짓은 다음과 같이 기록될 수 있습니다.

y y의 확률 p에 대한 해결:

- ( ) 1 + b β x + - x b ( t) b( t ) ={\={\

서 Sb(\는 b(\ b의 Sigmoid 함수입니다.위의 공식은 m{{ _이 고정되면 특정 관측치에 대해 y { y= 또는 관측치에 y { y=의 확률을 쉽게 계산할 수 있음을 보여준다.로지스틱 모델의 주요 사용 사례는 관측치 x가 주어지고 1(\1) 확률 p(x)를 추정하는 것입니다.최적 베타 계수는 로그 우도를 최대화하여 다시 찾을 수 있습니다.K 측정의 경우 x를 k번째 측정의 설명 벡터로 정의하고k y를 해당 측정의 범주적 결과로 정의하면k 로그 우도는 위의 M {\ M 경우와 매우 유사한 형식으로 작성할 수 있습니다.

위의 간단한 예시와 같이 최적의 β 매개변수를 찾으려면 수치적 방법이 필요합니다.유용한 기술 중 하나는 각 β 매개변수에 대한 로그 우도의 도함수를 0으로 등가시켜 로그 우도의 최대값에서 유지되는 일련의 방정식을 산출하는 것이다.

여기서mk x는 k번째 측정에서 얻은 x 설명m 변수의 값입니다.

M { M 설명 변수, { b= 및 -3 {{}=-β 11 { \}= 2 2= 2 {displaystyle\displaystyle\의 예를 생각해 보겠습니다.구체적으로 말하면, 모델은 다음과 같습니다.

- }+\}+\facebook_{1}_{{{0

여기서 p는 y y의 이벤트 확률입니다.이는 다음과 같이 해석할 수 있습니다.

- 0 - _}=-은 y자형입니다.예측 1 2 {{}}=0일 때 {} {2} 0일 때 의 로그 값입니다.{\ 10 로 x 0 {\1}=}=0일 때 1 {1일 은 1+) /로 할 수 있습니다

- 1 1 { _ { } 、 { _ {} - x1 1 x1{\ {\ display1 11 11 11 11 11 11 11 11 11 11 11 11 11 11 β1 、 10 β1 β1 β1 β1 β1 β1 、t y y)의 확률도 증가했지만 증가 확률만큼 증가하지는 않았습니다.

- 2 ( 스타일} ( 스타일 가 1 하면 로그 지연이2 ({2)을 합니다. 따라서 2 ({ 가 1 증가하면 y =( y 1)의 은 10(* 102) 증가합니다.ow x2({x_{2의 효과는 1({1})의 효과보다 2배 크지만 확률에 대한 효과는 10배 큽니다. y 스타일 y=1)의확률에 대한 효과는 10배만큼 크지 않습니다. 단지 확률에 대한 효과가 10배 더 큽니다.

다항 로지스틱 회귀 분석:많은 설명 변수와 많은 범주

위의 두 범주(이항 로지스틱 회귀 분석)의 경우, 범주는 "0"과 "1"로 색인화되었고, 두 가지 확률 분포가 있었다.결과가 카테고리 1에 속할 확률은 p { p로, 결과가 카테고리 0에 속할 확률은- x { 1-px로 나타냅니다.두 확률의 합은 합계와 같습니다.

일반적으로, 만약 우리가 가진 M+1{M+1\displaystyle}는 변수(x0 포함)와 N+1{N+1\displaystyle}범주, 우리는+N은 확률 설명하기 위한 벡터에 대해는 단정적인 결과는 y를 설명하는 1{N+1\displaystyle}별도의 확률 분포, 각 범주에 대해, n로 인덱싱 되기 때문이다. xy=n 범주에 속합니다.또한 모든 범주에 걸쳐 이러한 확률의 합계가 통일성과 동일해야 한다.수학적으로 편리한 기저 e를 사용하면 다음과 같은 가능성이 있습니다.

- n(x ) nx 1 + x {\ { \ style } ( { \ x } = { x} = { 1 + { n=^{ n }

0 () ( \ p { } ( { \ { } )을 한 각 확률에는 자체 회귀 세트 n ( \ {} ) { } )이 에 p n (x \ ( \ sylbold { x )의 합계가 됩니다.nity. 다른 확률로 되는 0 (x) ({의 은 인위적이라는 점에 유의하십시오.모든 확률이 그렇게 정의되도록 선택될 수 있습니다.이 특수값 n을 "피봇 지수"라고 하며, 로그 부호(tn)는 피벗 확률로 표현되며, 다시 설명 변수의 선형 조합으로 표현된다.

또한 N 의 한 경우 p( ) = p 1 ( x) ( ) =} ) = ) 1- 0 ( x ) p p p p p p p is is is is is is is is is is is is is is is is is is is is is is is_______________

이제 위의 확률에 의해 K 측정값 또는 데이터 점의 특정 세트가 생성될 로그 우도를 계산할 수 있습니다.각 측정값을 k로 색인화하여 k번째 측정 설명 변수 세트를 k})로 표시하고 범주형 결과를 y 로 표시합니다. 이는 [0,N]의 모든 정수와 같을 수 있습니다.로그 우도는 다음과 같습니다.

여기서 , k) {는 y = n이면k 통합과 같고 그렇지 않으면 0이면 통합과 동일한 표시 함수입니다.두 가지 설명 변수의 경우, 이 지시 함수는 n = 1일 때 y, n = 0일 때 1-y로k 정의되었다k.이것은 편리했지만 [19]필수는 아니었다.다시, 최적의 베타 계수는 일반적으로 수치적 방법을 사용하여 로그우도 함수를 최대화함으로써 구할 수 있다.가능한 솔루션 방법은 각 베타 계수에 대한 로그 우도의 도함수를 0으로 설정하고 베타 계수에 대해 해결하는 것입니다.

서 m \ \{ nm } 은 n \ displaystyle { symbol}} 벡터의 m번째 이고 mk \ nm 은 k번째 측정값의 m번째 설명 변수입니다.데이터로부터 베타 계수를 추정하면, 그 이후의 설명 변수 집합이 가능한 결과 범주 중 하나로 귀결될 확률을 추정할 수 있을 것이다.

해석

로지스틱 회귀 분석에는 다양한 동등한 규격과 해석이 있으며, 이러한 규격은 다양한 유형의 더 일반적인 모형에 적합하고 다른 일반화를 허용합니다.

일반화 선형 모형으로서

로지스틱 회귀 분석에서 사용되는 특정 모형은 표준 선형 회귀 분석 및 이항 값 결과에 사용되는 다른 유형의 회귀 분석과 구별되며, 특정 결과의 확률이 선형 예측 변수 함수에 연결되는 방법입니다.

위에서 설명한 보다 콤팩트한 표기법을 사용하여 다음과 같이 기술합니다.

이 공식은 로지스틱 회귀 분석을 일반화 선형 모델의 한 유형으로 표현합니다. 이 모형은 변수의 기대값의 임의 변환에 위의 형식의 선형 예측 함수를 적합시킴으로써 다양한 유형의 확률 분포를 가진 변수를 예측합니다.

로짓 함수(오즈의 자연 로그)를 사용하여 변환하는 직관은 위에서 설명했습니다.또한 확률(0과 1)을 , + 을 초과하는 변수로 변환하여 방정식 오른쪽에 있는 선형 예측 함수의 전위 범위를 일치시키는 실질적인 효과도 있습니다.

확률i p와 회귀 계수는 모두 관측되지 않으며 이를 결정하는 수단은 모형 자체의 일부가 아닙니다.일반적으로 관측된 데이터에 가장 적합한 값(즉, 이미 관측된 데이터에 대해 가장 정확한 예측을 제공하는 값)을 찾는 일종의 최적화 절차(예: 최대우도 추정)에 의해 결정되며, 일반적으로 가능성이 낮은 값을 제외하려는 정규화 조건(예: 다음과 같은 매우 큰 값)에 따라 결정된다.모든 회귀 계수.정규화 조건의 사용은 최대 우도의 확장인 최대 사후(MAP) 추정을 수행하는 것과 같습니다(정규화는 일반적으로 계수에 0-평균 가우스 사전 분포를 배치하는 것과 동일하지만 다른 정규화도 가능합니다).정규화를 사용하든 사용하지 않든 일반적으로 닫힌 형식의 솔루션을 찾을 수 없습니다. 대신 반복적 수치적 방법(IRLS) 또는 최근에는 L-BFGS [20]방법과 같은 준뉴턴 방법을 사용해야 합니다.

βj 모수 추정치의 해석은 j 설명 변수의 단위 변화에 대한 오즈 로그에 대한 첨가 효과이다.예를 들어 이분법적 설명 변수의 경우 eβ {\e^{\는 남성과 여성의 비교 결과에 대한 확률 추정치이다.

등가 공식은 로지스틱 함수인 로짓 함수의 역함수를 사용합니다.

이 공식은 확률 분포로도 쓸 수 있습니다(특히 확률 질량 함수를 사용).

잠재 변수 모델로서

로지스틱 모형은 잠복 변수 모형과 동일한 공식으로 구성됩니다.이 공식은 이산 선택 모형 이론에서 흔히 볼 수 있으며, 로지스틱 회귀를 밀접하게 연관된 프로빗 모형과 비교할 뿐만 아니라 여러 개의 상관된 선택이 있는 보다 복잡한 특정 모형으로 쉽게 확장할 수 있습니다.

각 시행 i에 대해 다음과 같이 분포되는 연속 잠재 변수i* Y(즉, 관측되지 않은 랜덤 변수)가 있다고 가정합니다.

어디에

즉, 잠복 변수는 선형 예측 변수와 표준 로지스틱 분포에 따라 분포되는 가법 랜덤 오차 변수의 관점에서 직접 작성할 수 있습니다.

그러면i Y는 이 잠재 변수가 양수인지 여부를 나타내는 지표로 볼 수 있습니다.

위치 및 척도가 임의 값으로 설정된 일반 로지스틱 분포 대신 표준 로지스틱 분포를 사용하여 오차 변수를 모형화하는 것은 제한적이지만 실제로는 그렇지 않습니다.회귀 계수를 직접 선택할 수 있으며 오차 변수 분포의 모수 변화를 상쇄하는 데 자주 사용할 수 있습니다.예를 들어 위치 매개 변수가 0이 아닌 로지스틱 오차 변수 분포(평균을 설정)는 위치 매개 변수가 0인 분포에 해당하며, 여기서 가로채기 계수에 μ가 추가됩니다.두 상황 모두 설명 변수 설정에 관계없이 Y에 대해i* 동일한 값을 생성합니다.마찬가지로 임의 척도 모수 s는 척도 모수를 1로 설정한 다음 모든 회귀 계수를 s로 나누는 것과 같습니다.후자의 경우 Y의 결과값은i* 모든 설명 변수 세트에 대해 전자의 경우보다 s의 배만큼 작아집니다.그러나 결정적으로 Y는 항상 0의 같은 쪽에 머물러 있기 때문에 같은i Y를 선택할 수 있습니다.

(이는 척도 모수의 비부상성이 세 개 이상의 선택 항목을 사용할 수 있는 더 복잡한 모형으로 이어지지 않을 수 있음을 예측합니다.)

이 공식은 일반화된 선형 모형으로 표현되고 잠재 변수 없이 앞의 공식과 정확히 동일하다는 것이 밝혀졌습니다.이는 표준 로지스틱 분포의 누적분포함수(CDF)가 로지트 함수의 역함수라는 사실을 사용하여 다음과 같이 나타낼 수 있습니다.

그 후, 다음과 같이 입력합니다.

이산 선택 모형에서 표준인 이 공식은 로지스틱 회귀 분석("로짓 모형")과 프로빗 모형 사이의 관계를 명확하게 합니다. 프로빗 모형은 표준 로지스틱 분포 대신 표준 정규 분포에 따라 오차 변수를 사용합니다.로지스틱 분포와 정규 분포는 둘 다 기본 단일 "종 곡선" 모양과 대칭입니다.유일한 차이점은 로지스틱 분포의 꼬리가 다소 무겁다는 것입니다. 즉, 외곽 데이터에 덜 민감하다는 것입니다(따라서 잘못된 규격이나 잘못된 데이터를 모형화하는 데 다소 더 강력합니다).

이원 잠변수 모형

그러나 또 다른 공식은 두 개의 개별 잠재 변수를 사용한다.

어디에

여기서1 EV(0,1)는 표준 타입 1 극단값 분포이다. 즉,

그리고나서

이 모형에는 종속 변수의 가능한 각 결과에 대해 별도의 잠재 변수와 별도의 회귀 계수 집합이 있습니다.이렇게 분리하는 이유는 다항 로짓 모형에서처럼 로지스틱 회귀 분석을 다항식 범주형 변수로 쉽게 확장할 수 있기 때문입니다.이러한 모형에서는 서로 다른 회귀 계수 집합을 사용하여 가능한 각 결과를 모형화하는 것이 자연스럽습니다.또한 각각의 개별 잠재 변수를 관련 선택을 하는 것과 관련된 이론적 효용으로서 동기를 부여하고, 따라서 효용 이론의 관점에서 로지스틱 회귀를 동기화하는 것이 가능하다. (효용 이론의 관점에서 합리적 행위자는 항상 가장 큰 관련 효용과 함께 선택을 선택한다.)이것은 경제학자들이 이산 선택 모델을 형성할 때 취하는 접근방식이다.이 접근방식은 이론적으로 강력한 기반을 제공하고 모델에 대한 직관을 촉진하기 때문에 다양한 종류의 확장을 쉽게 검토할 수 있기 때문이다(아래 예 참조).

제1종 극단값 분포의 선택은 상당히 제멋대로처럼 보이지만, 그것은 수학을 풀게 하고, 합리적인 선택 이론을 통해 그것의 사용을 정당화할 수 있을 것이다.

두 개의 회귀 계수와 오차 변수 집합이 있고 오차 변수의 분포가 다르기 때문에 이 모형은 분명하지 않지만 이전 모형과 동일한 것으로 나타났습니다.실제로 이 모델은 다음과 같은 대체를 통해 이전 모델로 직접 축소됩니다.

이에 대한 직관은 최대 두 개의 값을 기준으로 선택하기 때문에 정확한 값이 아닌 차이만 중요하므로 어느 정도의 자유도를 효과적으로 제거할 수 있습니다.또 다른 중요한 사실은 두 가지 유형 1 극단값 분포 변수의 차이가 로지스틱 분포(: 1 - 0 - 로지스틱 (,). { _})입니다} 다음과 같이 증명할 수 있습니다

예

예를 들어, 중도 우파 정당, 중도 좌파 정당 및 분리주의 정당(예: 퀘벡이 캐나다에서 분리되기를 원하는 Parti Québécois) 중 하나를 선택하는 주 단위 선거를 생각해 보십시오.그런 다음 각 선택별로 하나씩 세 가지 잠재적 변수를 사용합니다.그런 다음, 효용 이론에 따라, 우리는 잠재 변수를 각각의 선택에서 비롯되는 효용을 나타내는 것으로 해석할 수 있다.우리는 또한 회귀 계수를 관련 요소(즉, 설명 변수)가 효용에 기여하는 강도, 또는 설명 변수의 단위 변화가 주어진 선택의 효용을 변경하는 양을 나타내는 것으로 해석할 수 있다.유권자들은 중도 우파 정당이 특히 부자들에 대한 세금을 낮출 것이라고 기대할 수 있다.이것은 저소득층에게 아무런 혜택도 주지 않을 것이다. 즉, (보통 세금을 내지 않기 때문에) 효용에 변화가 없을 것이다. 중산층에게는 중간 정도의 혜택(즉, 다소 더 많은 돈 또는 적당한 효용 증가)을 줄 것이다. 고소득층에게는 상당한 혜택을 줄 것이다.반면 중도좌파 정당은 세금을 올려 복지 증대와 중산층에 대한 기타 지원으로 상쇄할 것으로 예상된다.이는 저소득층에게 상당한 긍정적 편익, 아마도 중산층에게는 약한 편익, 고소득층에게는 상당한 부정적 편익을 야기할 것이다.마지막으로 분리주의 정당은 경제에 대한 직접적인 조치를 취하지 않고 단순히 분리할 것이다.저소득 유권자나 중산층 유권자는 기본적으로 이것으로부터 뚜렷한 공과금 손익을 기대하지 않을 수 있지만, 고소득 유권자는 회사를 소유할 가능성이 높기 때문에 부정적인 효용을 기대할 수 있다. 이러한 환경에서 사업을 하는 것이 더 어려워지고 아마도 손해를 볼 수도 있다.

이러한 직관은 다음과 같이 표현할 수 있습니다.

| 가운데 오른쪽 | 중앙 왼쪽 | 분리주의자 | |

|---|---|---|---|

| 고소득 | 강한 + | 강한 - | 강한 - |

| 중산층 | 보통 + | 약한 + | 없음. |

| 저소득 | 없음. | 강한 + | 없음. |

이것은 분명히 알 수 있다

- 각 선택 항목에 대해 별도의 회귀 계수 집합이 존재해야 합니다.실용적으로 표현하면, 이것은 매우 쉽게 알 수 있습니다.다른 선택은 순 효용에 대해 서로 다른 영향을 미친다. 더욱이, 효과는 각 개인의 특성에 따라 복잡한 방식으로 다양하기 때문에, 단순히 선택당 단일 추가 특성이 아닌 각 특성에 대해 별도의 계수 세트가 있어야 한다.

- 소득이 연속형 변수이기는 하지만 효용에 미치는 영향은 단일 변수로 취급하기에는 너무 복잡하다.소득에 대한 다항식 회귀가 효과적으로 이루어지도록 직접 범위를 나누거나 더 높은 소득의 힘을 더해야 한다.

"로그 선형" 모델로서

그러나 다른 공식은 위의 쌍방향 잠재 변수 공식과 잠재 변수 없이 더 높은 원래 공식과 결합하고, 그 과정에서 다항 로짓의 표준 공식 중 하나에 대한 링크를 제공한다.

여기서는 확률i p의 로짓(logit)을 선형 예측 변수로 쓰는 대신 선형 예측 변수를 두 개의 결과 각각에 대해 하나씩 두 개로 분리한다.

이원 잠변수 모델과 마찬가지로 두 개의 회귀 계수가 도입되었으며, 두 개의 방정식은 선형 예측 변수로서 관련 확률의 대수를 쓰는 형태로 나타나며, 끝에 항 - Z \style -\Z가 붙는다.이 항은 결과가 분포임을 보증하는 정규화 인자로 작용합니다.이는 양변을 지수화함으로써 알 수 있습니다.

이 형태에서 Z의 목적은 Y에 대한i 결과 분포가 실제로는 확률 분포, 즉 합계가 1이 되도록 하는 것이 분명하다.즉, Z는 단순히 모든 비정규화 확률의 합이며 각 확률을 Z로 나누면 확률이 "정규화"됩니다.즉, 다음과 같습니다.

그리고 결과 방정식은

또는 일반적으로:

이는 다항 로짓에서처럼 이 공식을 세 개 이상의 결과로 일반화하는 방법을 명확하게 보여줍니다.이 일반적인 공식은 와 같이 softmax 함수입니다.

이전 모델과 동등함을 증명하기 위해 상기 은 ( Y 0 ) { ( Y {i } )} ( Y i= ) {( Y _ {i } 1} } 에서는 ()를 독립적으로 지정할 수 없습니다.)=이므로 하나를 알면 다른 하나가 자동으로 결정됩니다.결과적으로, 모델은 식별 불가능하며, β와1 β의0 다중 조합은 가능한 모든 설명 변수에 대해 동일한 확률을 생성한다.사실, 두 상수 벡터를 모두 더하면 동일한 확률이 생성되는 것을 볼 수 있다.

그 결과, 2개의 벡터 중 하나의 임의의 값을 선택함으로써 문제를 단순화하고 식별 가능성을 회복할 수 있습니다. 0 으로 합니다 { \ symbol{ 0 } = \ { then 。

그래서

이 공식은 실제로 이전의 공식과 동등하다는 것을 보여줍니다.(이원잠재변수 제제와 마찬가지로 - 0 { { symbol { { } _ {1} - {\ symbol { _ { } 에서는 동일한 결과가 나타난다.)

다항 로짓 모델의 대부분의 처리는 여기에 제시된 "로그-선형" 공식 또는 위에 제시된 이원 잠변수 공식 중 하나를 확장함으로써 시작된다는 점에 유의하십시오. 둘 다 모델이 다원적 결과로 확장될 수 있는 방법을 명확하게 보여주기 때문입니다.일반적으로 잠재 변수를 사용한 표현은 이산 선택 모델과 효용 이론이 지배하고 있는 계량경제학 및 정치학에서 더 흔하지만, 여기서의 "로그 선형" 공식은 컴퓨터 과학(예: 기계 학습 및 자연 언어 처리)에서 더 흔하다.

단층 퍼셉트론으로서

모델의 공식은 동일합니다.

이 기능 형태는 일반적으로 단층 퍼셉트론 또는 단층 인공 신경망이라고 불립니다.단층 뉴럴 네트워크는 스텝 함수 대신 연속 출력을 계산한다.X = (x1, ..., xk)에 대한 p의i 도함수는 일반 형식에서 계산된다.

여기서 f(X)는 X의 해석 함수이다.이 옵션을 선택하면 단일 계층 신경망은 로지스틱 회귀 분석 모형과 동일합니다.이 함수는 연속 도함수를 가지고 있어 역전파에서 사용할 수 있습니다.이 함수는 도함수가 쉽게 계산되기 때문에 선호된다.

이항 데이터의 경우

밀접하게 관련된 모형은 각 i가 단일 베르누이 시행이 아니라 n개의 독립적인 동일한 분포 시행과 연관되어i 있다고 가정합니다. 여기서 관측치i Y는 관측된 성공 횟수(개별 베르누이 분포 랜덤 변수의 합)이므로 이항 분포를 따릅니다.

이 분포의 예로는 n을 심은 후에i 발아하는 씨앗의 비율i(p)이 있습니다.

기대값의 관점에서 이 모델은 다음과 같이 표현됩니다.

하도록

또는 동등하게:

이 모형은 위의 기본 모형과 동일한 종류의 방법을 사용하여 적합할 수 있습니다.

모델 피팅

이 섹션은 확장해야 합니다.추가하시면 됩니다. (2016년 10월) |

최대우도 추정(MLE)

회귀 계수는 일반적으로 최대우도 [21][22]추정을 사용하여 추정됩니다.정규 분포 잔차를 사용한 선형 회귀 분석과 달리, 우도 함수를 최대화하는 계수 값에 대한 닫힌 형식 식을 찾을 수 없으므로 반복 공정(예: Newton의 방법)을 사용해야 합니다.이 프로세스는 잠정적인 해결책에서 시작하여 개선할 수 있는지 확인하기 위해 약간 수정한 후 더 이상 개선되지 않을 때까지 이 수정을 반복하며 프로세스가 [21]수렴되었다고 합니다.

경우에 따라서는 모델이 컨버전스에 도달하지 못할 수 있습니다.모형의 비수렴은 반복 공정이 적절한 솔루션을 찾을 수 없었기 때문에 계수가 유의하지 않음을 나타냅니다.예측 변수의 대 사례 비율이 크거나 다중 공선성, 희소성 또는 완전 분리 등 여러 가지 이유로 수렴 실패가 발생할 수 있습니다.

- 변수 대 사례의 비율이 크면 Wald 통계(아래에서 설명)가 지나치게 보수적이며 수렴되지 않을 수 있습니다.정규화된 로지스틱 회귀 분석은 특히 이 상황에서 사용하기 위한 것입니다.

- 다중 공선성은 예측 변수 간의 상관 관계가 허용할 수 없을 정도로 높은 것을 나타냅니다.다중 공선성이 증가하면 계수는 치우침 없이 유지되지만 표준 오차는 증가하고 모형 수렴 가능성은 [21]감소합니다.예측 변수 간의 다중 공선성을 탐지하기 위해 다중 공선성이 허용할 수 없을 정도로 높은지 여부를 평가하는 데 사용되는 공차 통계량을 조사하는 유일한 목적으로 관심 예측 변수를 사용하여 선형 회귀 분석을 수행할 수 있습니다.

- 데이터의 희소성은 빈 셀(카운트가 0인 셀)의 비율이 큰 것을 나타냅니다.0 셀 카운트는 범주형 예측 변수에서 특히 문제가 됩니다.연속형 예측 변수를 사용하면 모형이 0 셀 카운트의 값을 추론할 수 있지만 범주형 예측 변수의 경우에는 그렇지 않습니다.자연 로그 0은 정의되지 않은 값이기 때문에 모형에 대한 최종 솔루션에 도달할 수 없기 때문에 모형은 범주형 예측 변수의 셀 카운트를 0으로 수렴하지 않습니다.이 문제를 해결하기 위해 연구자들은 이론적으로 의미 있는 방법으로 범주를 축소하거나 모든 [21]세포에 상수를 추가할 수 있습니다.

- 수렴 부족을 초래할 수 있는 또 다른 수치적 문제는 완전 분리이다. 이는 예측 변수가 기준을 완벽하게 예측하는 경우를 가리킨다. 즉, 모든 경우를 정확하게 분류하고 무한 계수로 가능성을 극대화한다.이 경우 오류가 [2][further explanation needed]있을 수 있으므로 데이터를 다시 검토해야 합니다.

- 또한 지수 함수에 대한 매개변수 형식의 가정을 피하고 링크 함수(예: 프로빗 또는 [23]로짓)의 선택에 강한 국소 우도 또는 비모수 준우도 방법을 통해 반모수 또는 비모수적 접근법을 취할 수 있다.

반복적 최소 제곱(IRLS)

예를 들어 이항 로지스틱 회귀 분석( { y y { y=1은 Newton 방법을 사용하여 Bernouli 분포 프로세스의 로그 우도를 최대화하는 것과 동일한 IRLS(반복적 재가중 최소 제곱)를 사용하여 계산할 수 있습니다.가 벡터 매트릭스 형식으로 작성되어 w T [ 0 , 1,2, ](\^{T}=[\ _ _{ x ( [ ) 1, ,x ) 및 베르누이 의 기대치μ ( ) + - Tx ( i ) { { ( i ) + { - \ { } ^ { } \ { }}}}}}}} w 。

서 S μ( )( 1 - () \ ( \( ) )는 대각선 가중치 입니다.μ [( ) , ( ) , 2 ... { mu \

역행렬 및 ( [ ( ) , ( ) , ]{ style \ } (i) = [ ( ) , ( ) \]^ 반응 변수의 벡터입니다.자세한 것은 문헌을 [24]참조해 주세요.

베이지안

베이지안 통계 컨텍스트에서 사전 분포는 일반적으로 회귀 계수에 배치되며, 예를 들어 가우스 분포의 형태로 배치됩니다.로지스틱 회귀 분석에서는 우도 함수 앞에 켤레가 없습니다.베이지안 추론이 분석적으로 수행되었을 때, 이것은 매우 낮은 차원을 제외하고 후방 분포를 계산하기 어렵게 만들었다.단, OpenB와 같은 자동 소프트웨어는UGS, JAGS, PyMC3, Stan 또는 Turing.jl은 이러한 포스터를 시뮬레이션을 사용하여 계산할 수 있으므로, 결합성의 부족은 문제가 되지 않습니다.그러나 표본 크기나 매개변수 수가 클 경우 전체 베이지안 시뮬레이션은 느릴 수 있으며, 사람들은 종종 변동 베이지안 방법이나 기대 전파와 같은 대략적인 방법을 사용한다.

"10의 법칙'

널리 사용되는 경험칙인 "10개 중 하나 규칙"은 로지스틱 회귀 모델이 설명 변수당 최소 약 10개의 사건(EPV)을 기반으로 할 경우 설명 변수에 안정적인 값을 제공한다고 기술한다. 여기서 사건은 종속 변수의 덜 빈번한 범주에 속하는 경우를 나타낸다.따라서 연구 참가자의 pdisplaystyle p 10k/p에서 발생할 으로 예상되는 사건 심근경색)에 대해k\display k style p style 의 가 하다.그러나 시뮬레이션 연구에 기초하고 안전한 이론적 [25]기반이 없는 이 규칙의 신뢰성에 대해서는 상당한 논란이 있다.만약 우리가(다소 주관적으로)신뢰 구간 커버리지 미만 93%를 일부 authors[26]에 따르면 규칙을 지나치게 어떤 상황에서, 저자들을 생각했습니다."이상 15%문제가 되는 우리를 그 문제 상당히 빈번하다 지..지 나는 형식 이상 7%나 관련된 편견이라는 것은 보수적이다ith2~4 EPV, 5~9 EPV에서는 드물며 10~16 EPV에서도 관찰됩니다.각 문제의 최악의 예는 5~9 EPV로 심각하지 않았으며 보통 10~16 EPV와 비슷했다."[27]

다른 사람들은 다른 기준을 사용하여 위와 일치하지 않는 결과를 발견했다.유용한 기준은 적합된 모형이 모형 개발 표본에서 달성한 것처럼 새 표본에서 동일한 예측 변별을 달성할 것으로 예상되는지 여부입니다.이 기준에서는 후보 변수당 20개의 이벤트가 [28]필요할 수 있습니다.또한 예측 확률의 오차 한계가 0.95 신뢰 [29]수준에서 ±0.1일 정도로 모형의 절편을 정확하게 추정하기 위해서만 96개의 관측치가 필요하다고 주장할 수 있습니다.

오차 및 적합의 유의성

이탈도 및 우도비 검정 - 간단한 경우

모든 적합 절차에서 모형에 다른 적합 모수(예: 로지스틱 회귀 모형의 베타 모수)를 추가하면 거의 항상 모형이 측정된 결과를 예측하는 능력이 향상됩니다.모형이 단순히 데이터의 잡음에 "과적합"하기 때문에 추가 항에 예측 값이 없는 경우에도 마찬가지입니다.다른 적합 매개변수를 추가하여 얻은 개선이 추가 용어를 포함하도록 권장할 만큼 충분한지, 또는 단순히 과적합에서 기대할 수 있는 개선 사항인지에 대한 의문이 제기된다.

즉, 로지스틱 회귀 분석의 경우 로지스틱 모형 적합치와 결과 데이터 사이의 오차를 측정하는 이탈도라는 통계량이 정의됩니다.많은 데이터 점의 한계에서는 이탈도가 카이 제곱 분포되므로 설명 변수의 유의성을 확인하기 위해 카이 제곱 검정을 구현할 수 있습니다.

선형 회귀 분석과 로지스틱 회귀 분석에는 많은 유사점이 있습니다.예를 들어 단순 선형 회귀 분석에서는 K 데이터 포인트 세트(xk, yk)가 y + x {\ y 의 제안된 모델 함수에 적합됩니다.적합치는 각 데이터 점에 대한 잔차의 제곱합(오차항 제곱)을 최소화하는 b 모수를 선택하여 얻을 수 있습니다.

적합을 구성하는 최소값은 ^ {\{\{\epsilon {{로 표시됩니다.

x 변수가 y 결과를k 예측하는 데 아무런 도움이 되지 않는다고 가정하는 null 모형의 개념이 도입될 수 있습니다.데이터 점은 오차항 제곱을 사용하여 y=b0 형식의 null 모형 함수에 적합됩니다.

적합 프로세스는 null 모델에 대한 적합도를하는 b의 값을0 선택하는 것으로 구성됩니다서 \ _ 는 null 모델을 나타냅니다.null 모델은 b { style _ { 0 } =} b b 。서 y \ { }는 y값의k 평균이고 최적화된 2 { \ \ _ { \ }^는 다음과 같습니다.

이는 Y 데이터k 점의 (수정되지 않은) 표본 표준 편차의 제곱에 비례합니다.

다양한kk x에 y 데이터 점을 랜덤하게 할당한 다음 제안된 모형을 사용하여 적합시키는 경우를 생각할 수 있습니다.구체적으로, 우리는k Y 결과의 모든 배열에 대해 제안된 모델의 적합성을 고려할 수 있다.이러한 적합의 최적화된 오차는 결코 Null 모델의 최적 오차보다 작지 않으며, 이러한 최소 오차 간의 차이는 제안된 모델의 자유도에서 Null 모델의 자유도를 뺀 카이-크롬 분포(ki-크롬 분포)를 따른다는 것을 알 수 있다. 이 경우 2-1=1. 카이 제곱 검정을 사용하여 이러한 치환된 y 집합k 중 몇k 개가 원래 y를 사용하여 최소 오차 이하의 오차를 발생시키는지 추정할 수 있으며, 따라서 제안된 모델에 x 변수를 포함시킴으로써 얼마나 중요한 개선이 제공되는지 추정할 수 있습니다.

로지스틱 회귀 분석의 경우 적합도의 측도는 우도 함수 L 또는 해당 로그의 로그 우도 θ입니다.우도함수 L은 선형 회귀의 § \})와 유사하지만 우도가 최소화되지 않고 극대화된다는 점이 다릅니다.된 모델의 최대 로그 우도를 로 나타냅니다.

단순 이항 로지스틱 회귀 분석의 경우 K 데이터 점 집합은 다음과 같은 형식의 함수에 확률론적 의미로 적합됩니다.

서 p() { p는 y { y의 확률입니다.log-ods는 다음과 같습니다.

로그 우도는 다음과 같습니다.

null 모델의 경우 y y= 은 다음과 같습니다.

null 모델의 log-ods는 다음과 같습니다.

로그 우도는 다음과 같습니다.

p ( \ p { \ } ={ } )이 최대 L이므로 늘 모델의 최대 로그 우도는 다음과 같습니다.

의 0 _은 다음과 같습니다.

서 y는 y값의k 평균입니다.다시, Y의 모든k 순열에 대해 제안된 모델의 적합성을 개념적으로 고려할 수 있으며, 이러한 순열 적합치의 최대 로그 우도가 Null 모델보다 결코 작지 않음을 알 수 있습니다.

또한 선형 회귀 분석 사례의 오류와 유사하게 로지스틱 회귀 적합치의 편차를 다음과 같이 정의할 수 있습니다.

항상 양수이거나 0일 것입니다.이러한 선택을 하는 이유는 편차가 적합도를 측정하는 좋은 척도일 뿐만 아니라 대략적인 카이 제곱 분포이며, 데이터 점 수(K)가 증가함에 따라 근사치가 개선되어 무한히 많은 데이터 점의 한계에서 정확히 카이 제곱 분포가 되기 때문입니다.선형 회귀 분석의 경우처럼, 이 사실을 사용하여 랜덤 데이터 점 집합이 제안된 모형에 의해 얻어진 적합치보다 더 나은 적합치를 제공할 확률을 추정할 수 있으며, 따라서 제안된 모형에 x개의k 데이터 점을 포함시킴으로써 모형이 얼마나 유의하게 개선되는지 추정할 수 있습니다.

위에서 설명한 단순한 학생 시험 점수 모델의 경우, null 모델의 로그 우도 은 - ...이다} 단순 모형의 로그 우도 은 - 02988 편차는 D ( ^ -^)) = ...

유의성에 대한 카이 제곱 검정을 사용하여 11.6661에서 1개의 자유도를 갖는 카이 제곱 분포의 적분...무한대 값은 0.00063649와 같습니다.

이는 랜덤k y에 대한 10,000개의 적합치 중 약 6개가 주어진 y보다k 더 나은 적합치(작은 편차)를 가질 것으로 예상할 수 있으므로 제안된 모형에 x 변수와 데이터를 포함하는 것이 귀무 모형에 비해 매우 유의한 개선이라는 결론을 내릴 수 있습니다.즉, 1- 99로 귀무 가설을 기각합니다

적합도 요약

선형 회귀 모형의 적합도는 일반적으로 R을 사용하여2 측정됩니다.로지스틱 회귀 분석에는 직접 아날로그가 없으므로 대신 다음과 같은 다양한[30]: ch.21 방법을 사용할 수 있습니다.

편차 및 우도비 검정

선형 회귀 분석에서는 제곱합 계산을 통한 분산 분할과 관련이 있습니다. 기준의 분산은 기본적으로 예측 변수에 의해 설명되는 분산과 잔차 분산으로 나뉩니다.로지스틱 회귀 분석에서는 제곱합 계산 [31]대신 이탈도가 사용됩니다.이탈도는 선형 회귀[2] 분석의 제곱합과 유사하며 로지스틱 회귀 [31]모형의 데이터에 대한 적합도가 부족하다는 것을 나타내는 측도입니다."포화" 모델을 사용할 수 있는 경우(이론적으로 완벽한 적합을 갖춘 모형), 주어진 모형을 포화 [2]모형과 비교하여 편차가 계산됩니다.이 계산은 우도비 [2]검정을 제공합니다.

위의 방정식에서 D는 편차를 나타내고 ln은 자연대수를 나타냅니다.이 우도비(포화 모형에 대한 적합 모형의 비율)의 로그는 음수 값을 생성하므로 음수 부호가 필요합니다.D는 대략적인 카이 [2]제곱 분포를 따른다는 것을 보여줄 수 있습니다.값이 작을수록 적합 모형이 포화 모형에서 덜 벗어날수록 적합도가 높다는 것을 나타냅니다.카이-제곱 분포를 평가할 때 유의하지 않은 카이-제곱 값은 설명되지 않은 분산을 매우 적게 나타내므로 모형 적합성이 우수합니다.반대로 유의한 카이-제곱 값은 유의한 양의 분산을 설명할 수 없음을 나타냅니다.

포화 모형을 사용할 수 없는 경우(일반적인 경우), 편차는 단순히 -2·(적합 모형의 로그 우도)로 계산되며, 포화 모형의 로그 우도에 대한 참조는 손상 없이 다음에 나오는 모든 항목에서 제거할 수 있습니다.

로지스틱 회귀 분석에서 특히 중요한 두 가지 이탈도 측도, 즉 귀무 이탈도와 모형 이탈도가 있습니다.Null 이탈도는 절편만 있는 모형("예측 변수가 없음"을 의미함)과 포화 모형 간의 차이를 나타냅니다.모형 이탈도는 하나 이상의 예측 변수가 있는 모형과 포화 [31]모형 간의 차이를 나타냅니다.이와 관련하여 Null 모형은 예측 변수를 비교할 기준선을 제공합니다.이탈도는 주어진 모형과 포화 모형 간의 차이에 대한 측도이기 때문에 값이 작을수록 적합도가 높다는 것을 나타냅니다.따라서 예측 변수 또는 예측 변수 집합의 기여도를 평가하려면 null 이탈도에서 모델 이탈도를 빼고 추정된 모수 수의 차이와 동일한 자유도를[2] 갖는 s - 2, \ _}^2 카이-제곱 분포에서 차이를 평가할 수 있다.

허락하다

두 가지 차이점이 있습니다.

모형 이탈도가 귀무 편차보다 유의하게 작으면 예측 변수 또는 예측 변수 집합이 모형의 적합도를 유의하게 개선한다고 결론을 내릴 수 있습니다.이는 선형 회귀 분석에서 [31]예측의 유의성을 평가하기 위해 사용되는 F-검정과 유사합니다.

의사 R 제곱

선형 회귀 분석에서 다중 상관 제곱 R은2 예측 변수에 [31]의해 설명되는 기준의 분산 비율을 나타내므로 적합도를 평가하는 데 사용됩니다.로지스틱 회귀 분석에서는 유사한 측도에 합의된 것은 없지만 각각 제한이 [31][32]있는 여러 개의 경쟁 측도가 있습니다.

이 페이지에서는 가장 일반적으로 사용되는 4개의 인덱스와 덜 일반적으로 사용되는 1개의 인덱스를 조사합니다.

- 우도비2L R

- 콕스와 스넬2CS R

- 나겔케르케2N R

- 맥패든2McF R

- 츄르2T R

호스머-렘쇼 검정

더 호스머-Lemeshow 테스트는 § ^{ 분포를 점근적으로 따르는 검정 통계량을 사용하여 관측된 사건 비율이 모델 모집단의 하위 그룹에서 예상 사건 비율과 일치하는지 여부를 평가한다.이 검정은 예측 확률의 임의 [33]빈화와 상대적으로 낮은 검정력에 의존하기 때문에 일부 통계학자에 의해 사용되지 않는 것으로 간주됩니다.

계수 유의성

모형을 적합시킨 후 연구자들은 개별 예측 변수의 기여도를 조사하려고 할 가능성이 높습니다.이를 위해 회귀 계수를 조사하려고 합니다.선형 회귀 분석에서 회귀 계수는 [31]예측 변수의 각 단위 변화에 대한 기준의 변화를 나타냅니다.그러나 로지스틱 회귀 분석에서 회귀 계수는 예측 변수의 각 단위 변화에 대한 로짓의 변화를 나타냅니다.로짓이 직관적이지 않을 경우, 연구자들은 회귀 계수의 지수 함수인 승산비에 대한 예측 변수의 영향에 초점을 맞출 가능성이 높습니다(정의 참조).선형 회귀 분석에서는 t 검정을 계산하여 회귀 계수의 유의성을 평가합니다.로지스틱 회귀 분석에서는 개별 예측 변수의 유의성을 평가하기 위해 설계된 여러 가지 검정이 있으며 특히 우도비 검정과 Wald 통계량이 있습니다.

우도비 검정

모형 적합도를 평가하기 위해 위에서 설명한 우도비 검정은 주어진 [2][21][31]모형에 대한 개별 "예측 변수"의 기여도를 평가하는 데 권장되는 절차이기도 합니다.단일 예측 변수 모형의 경우 예측 변수 모형의 편차를 단일 자유도를 갖는 카이-제곱 분포에서 귀무 모형의 편차와 비교하기만 하면 됩니다.예측 변수 모형의 이탈도가 유의하게 작으면(두 모형의 자유도 차이를 사용한 카이-제곱 참조), "예측 변수"와 결과 사이에 유의한 연관성이 있다는 결론을 내릴 수 있습니다.일부 일반적인 통계 패키지(예: SPSS)는 우도비 검정 통계를 제공하지만, 이러한 계산 집약적인 검정이 없다면 다중 로지스틱 회귀 분석 [citation needed]사례에서 개별 예측 변수의 기여도를 평가하는 것이 더 어려울 것이다.개별 예측 변수의 기여도를 평가하기 위해 계층적으로 예측 변수를 입력하여 각 새 모형을 이전 모형과 비교하여 각 [31]예측 변수의 기여도를 확인할 수 있습니다.통계학자들 사이에 소위 [weasel words]"단계적" 절차의 적절성에 대한 논쟁이 있다.우려되는 것은 명목 통계적 특성을 보존하지 못하여 [34]오해를 살 수 있다는 것이다.

왈드 통계량

또는 주어진 모형에서 개별 예측 변수의 기여도를 평가할 때 Wald 통계량의 유의성을 조사할 수 있다.선형 회귀 분석의 t-검정과 유사한 Wald 통계량은 계수의 유의성을 평가하는 데 사용됩니다.Wald 통계량은 회귀 계수의 제곱과 계수의 표준 오차 제곱의 비율이며 카이-제곱 [21]분포로 점근적으로 분포됩니다.

여러 통계 패키지(예: SPSS, SAS)가 개별 예측 변수의 기여도를 평가하기 위해 Wald 통계를 보고하지만 Wald 통계에는 한계가 있다.회귀 계수가 크면 회귀 계수의 표준 오차도 커지는 경향이 있어 유형-II 오차 확률이 높아집니다.Wald 통계량은 데이터가 [31]희박한 경우에도 치우치는 경향이 있습니다.

케이스 컨트롤 샘플링

사례가 드물다고 가정합니다.그러면 개체군 내 감염률보다 더 자주 표본을 추출할 수 있습니다.예를 들어 10,000명 중 1명꼴로 발병하는 질병이 있다고 가정하고 데이터를 수집하기 위해서는 완전한 신체검사를 해야 합니다.소수의 병든 사람들을 위한 데이터를 얻기 위해 수천 명의 건강한 사람들을 위한 신체검사를 하는 것은 너무 비쌀 수 있다.따라서, 우리는 더 많은 질병이 있는 개인들, 아마도 모든 희귀한 결과들을 평가할 수 있다.이것은 또한 소급 표본 추출이거나 동등하게 불균형 데이터라고 합니다.일반적으로 사례 수의 5배 비율로 대조군을 추출하면 충분한 대조군 [35]데이터가 생성됩니다.

로지스틱 회귀 분석은 랜덤하게 추출된 데이터가 아니라 불균형 데이터에 대해 추정할 수 있지만 결과에 대한 각 독립 변수의 효과에 대한 정확한 계수 추정치를 산출할 수 있다는 점에서 특이합니다.즉, 이러한 데이터에서 로지스틱 모델을 형성하면 일반 모집단에서 모델이 올바른 경우 을 한 j \ 는 모두 정확합니다.β [35]0은 다음과 같이 정확한 감염률을 알 수 있는 경우 할 수 있습니다.

서 { }는 실제 유병률이고 ~ { {는 샘플의 유병률입니다.

논의

다른 형태의 회귀 분석과 마찬가지로 로지스틱 회귀 분석에서도 연속형 또는 범주형 예측 변수를 하나 이상 사용합니다.그러나 일반 선형 회귀 분석과 달리 로지스틱 회귀 분석은 연속 결과가 아니라 제한된 수의 범주 중 하나에 포함되는 종속 변수를 예측하는 데 사용됩니다(이항 사례의 종속 변수를 베르누이 시행의 결과로 처리).이 차이를 고려할 때 선형 회귀 분석의 가정을 위반하는 것입니다.특히 잔차는 정규 분포를 따를 수 없습니다.또한 선형 회귀 분석에서는 이항 종속 변수에 대해 터무니없는 예측을 할 수 있습니다.필요한 것은 이진 변수를 실제 값(음수 또는 양수)을 취할 수 있는 연속 변수로 변환하는 방법입니다.이를 위해 이항 로지스틱 회귀 분석에서는 먼저 각 독립 변수의 서로 다른 수준에 대해 사건의 발생 확률을 계산한 다음 로그를 사용하여 종속 변수의 변환된 버전으로 연속형 기준을 생성합니다.오즈의 로그는 확률의 로짓이며 로짓은 다음과 같이 정의됩니다.

로지스틱 회귀 분석의 종속 변수는 베르누이이지만 로짓은 제한되지 않은 [2]척도에 있습니다.로짓 함수는 이런 종류의 일반화 선형 모델에서 링크 함수입니다.

Y는 베르누이 분포 반응 변수이고 x는 예측 변수입니다. β 값은 선형 모수입니다.

그런 다음 성공 확률의 로짓이 예측 변수에 적합됩니다.로짓의 예측 값은 자연 로그의 역수인 지수 함수를 통해 예측 오즈로 다시 변환됩니다.따라서 이항 로지스틱 회귀 분석에서 관측된 종속 변수는 0-or-1 변수이지만 로지스틱 회귀 분석에서는 종속 변수가 '성공'일 확률을 연속형 변수로 추정합니다.일부 애플리케이션에서는 확률만 있으면 됩니다.다른 경우에는 종속 변수가 '성공'인지 아닌지에 대한 구체적인 예/아니오 예측이 필요하다. 이 범주형 예측은 계산된 성공 확률에 기초할 수 있으며, 선택된 일부 컷오프 값 이상의 예측 오즈는 성공 예측으로 변환된다.

최대 엔트로피

우도 함수(프로빗 회귀, 포아송 회귀 등)를 최대화하여 적합을 최적화하는 특정 범주형 결과의 확률을 추정하는 데 사용되는 모든 함수 형태 중에서 로지스틱 회귀 솔루션은 최대 엔트로피 솔루션이라는 점에서 [36]독특합니다.이것은 일반적인 속성의 경우입니다.기대값이 주어지면 지수 분포 패밀리는 엔트로피를 최대화합니다.로지스틱 모델의 경우 로지스틱 함수는 베르누이 분포의 자연 모수("표준 형식"이고 로지스틱 함수는 표준 링크 함수)인 반면, 다른 Sigmoid 함수는 비표준 링크 함수이며, 이는 수학적 우아함과 최적화의 용이성을 기반으로 합니다.자세한 내용은 지수 패밀리 maximum 최대 엔트로피 도출을 참조하십시오.

증명

이를 나타내기 위해 라그랑주 승수법을 사용한다.라그랑지안은 엔트로피와 라그랑지 곱셈의 합에 다양한 제약 식을 곱한 것과 같다.단순한 경우를 고려한다고 해서 증명이 그렇게 간단하지는 않기 때문에 일반적인 다항 사례가 고려될 것이다.다양한 확률에 대한 라그랑지안의 도함수를 0으로 등분하면 로지스틱 [36]회귀 분석에서 사용되는 확률에 해당하는 함수 형식을 얻을 수 있습니다.

위의 다항 로지스틱 회귀 분석 섹션과 마찬가지로 x 으로 되며 0 ({}=을 하는 M+({ M의 설명 변수를 합니다.k { ,2, , { k = \ {, 2 \ , \ by by by points by points by , points , points points points points,K are are are are,,,K are ,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,,, = { 1, 2, 2, { display k= \ { display k = \ { \ { k = \ {또한mk 는(+ 1){ - 차원 벡터 k { , k , , M { { _ { _ 0} = \ { x _ 0 k , _ 1 k }, x{ } 로 표시됩니다.0 ~ N 범위의 범주형 변수 y에는 N+ N의 한 값이 있습니다.

p(x)가 y { y 확률이라고 하자n. p ( ) { p_{dispect}=를 하면 k-결과 측정의 확률은 n이다.

라그랑지안은 확률nk p의 함수로 표현될 것이며, 이러한 확률에 대한 라그랑지안의 도함수를 0으로 동등하게 함으로써 최소화할 것이다.중요한 점은 확률이 균등하게 취급되고 그 합계가 합산된다는 사실은 처음부터 가정된 것이 아니라 라그랑주 공식의 일부라는 것이다.

라그랑지안의 첫 번째 기여는 엔트로피입니다.

로그 우도는 다음과 같습니다.

다항 로지스틱 함수를 가정할 때, 베타 계수와 관련된 로그 우도의 도함수는 다음과 같습니다.

여기서 매우 중요한 점은 이 식은 (특히) 베타 계수의 명시적 함수가 아니라는 것이다.이것은nk 확률 p와 데이터의 함수일 뿐입니다.가정된 다항 로지스틱 사례에 특정되지 않고 로그 우도가 최대화되는 상태에 대한 일반적인 설명으로 간주되며 p의 함수nk 형식을 참조하지 않는다.다음으로 (M+1)(N+1)의 피팅 구속조건이 있으며, 라그랑지안의 피팅 구속조건 조건은 다음과 같습니다.

여기서 θ는nm 적절한 라그랑주 승수이다.K 정규화 제약조건은 다음과 같이 기술할 수 있습니다.

따라서 라그랑지안의 정규화 항은 다음과 같다.

여기서 α는k 적절한 라그랑주 승수이다.라그랑지안은 위의 세 가지 항의 합계이다.

확률 중 하나에 대한 라그랑지안의 도함수를 0으로 설정하면 다음과 같이 산출됩니다.

보다 축약된 벡터 표기법 사용:

n 및 k 지수에 소수점을 드롭하고 kdisplaystyle p_})에 해결하면 다음과 같은 결과가 나옵니다.

여기서:

정규화 제약 조건을 적용하면 Z에k 대해 해결하고 확률을 다음과 같이 쓸 수 있습니다.

이지 않습니다(\})에 임의의 상수1)차원 벡터를 추가할 수 있으며 k 확률 값은 변경하지 않고 N+(\ N만 할 수 .displaystyle 위의 다항 로지스틱 회귀 분석 섹션에서 00이 n에서 제외되었습니다0}은(는) 합성에 대해 n= n = β n 0 n - 0 { display { \ { n { n } - { \ { n } { n } } - {\ bold symbold symbol } { }으로 지정되었다

기타 접근법

이항 분류에 로지스틱 회귀 분석을 사용하는 기계 학습 애플리케이션에서 MLE는 교차 엔트로피 손실 함수를 최소화합니다.

로지스틱 회귀 분석은 중요한 기계 학습 알고리즘입니다.목표는 랜덤 Y(\ Y가 0 또는 1일 확률을 모형화하는 것입니다.[37]

{ 로 파라미터화된 일반화 선형 모델 함수를 생각해 보겠습니다.

그러므로,

Y { , { Y \ \ { , \ 、 Pr ( ;\ )는 ( ; ) - h 。} 이제 표본의 모든 관측치가 독립적으로 베르누이 분포되어 있다고 가정하여 우도 함수를 계산한다

일반적으로 로그 가능성은 최대화됩니다.

경사 강하와 같은 최적화 기법을 사용하여 극대화됩니다.

( ,) { ) 쌍이 기본 분포에서 균일하게 그려지고 큰 N의 한계에서 그려진다고 가정하면,

서 H X H X는 엔트로피, 는 조건부 엔트로피입니다.KL은 Kullback-Leibler 발산입니다.이를 통해 모델의 로그 우도를 최대화함으로써 최대 엔트로피 분포에서 모델의 KL 분산을 최소화할 수 있습니다.직감적으로 모수에서 가장 적게 가정하는 모델을 검색합니다.

선형 회귀 분석과의 비교

로지스틱 회귀 분석은 일반화 선형 모형의 특수한 경우로 볼 수 있으므로 선형 회귀 분석과 유사합니다.그러나 로지스틱 회귀 분석 모형은 선형 회귀 분석과 상당히 다른 가정(의존 변수와 독립 변수 간의 관계에 대한 가정)을 기반으로 합니다.특히 이 두 모형 간의 주요 차이는 로지스틱 회귀 분석의 다음 두 가지 특징에서 확인할 수 있습니다.첫째, 조건부 yx(\ yx)는 종속 변수가 2진수이기 때문에 가우스 분포가 아닌 베르누이 분포입니다.둘째, 로지스틱 회귀 분석에서는 결과 자체보다는 특정 결과의 확률을 예측하기 때문에 예측 값은 확률이므로 로지스틱 분포 함수를 통해 (0,1)로 제한됩니다.

대체 수단

로지스틱 모형(로짓 모형)의 일반적인 대안은 관련 이름에서 알 수 있듯이 프로빗 모형입니다.일반화된 선형 모델의 관점에서는 로지스틱 모델은 로짓 함수(역 로지스틱 함수)를 사용하고 프로빗 모델은 프로빗 함수(역 오차 함수)를 사용합니다.마찬가지로, 이 두 가지 방법의 잠재 변수 해석에서 첫 번째 방법은 오차의 표준 로지스틱 분포를 가정하고 두 번째 방법은 [38]오차의 표준 정규 분포를 가정합니다.대신 다른 S자형 함수 또는 오차 분포를 사용할 수 있습니다.

로지스틱 회귀 분석은 Fisher의 1936년 방법인 선형 판별 [39]분석의 대안입니다.선형 판별 분석의 가정이 유효하면 조건을 뒤집어서 로지스틱 회귀 분석을 생성할 수 있습니다.그러나 로지스틱 회귀 분석에는 판별 [40]분석에 대한 다변량 정규 가정이 필요하지 않기 때문에 그 반대는 참이 아닙니다.

선형 예측 변수 효과의 가정은 스플라인 [29]함수와 같은 기법을 사용하여 쉽게 완화될 수 있습니다.

역사

로지스틱 회귀에 대한 자세한 이력은 Cramer(2002)에 나와 있습니다.로지스틱 함수는 인구증가의 모델로 개발되었고 1830년대와 1840년대에 아돌프 케테레의 지도 아래 피에르 프랑수아 베르헐스트에 의해 "로지스틱"이라고 명명되었다. 자세한 [41]내용은 로지스틱 함수 § 역사를 참조하라.Verhulst는 초기 논문(1838년)에서 [42][43]데이터에 곡선을 적합시키는 방법을 지정하지 않았습니다.보다 상세한 논문(1845)에서 Verhulst는 곡선이 세 개의 관측점을 통과하도록 함으로써 모형의 세 가지 매개변수를 결정했는데,[44][45] 이는 예측이 좋지 않았다.

로지스틱 함수는 화학에서 자가 촉매 분석 모델로서 독립적으로 개발되었다(Wilhelm Ostwald,[46] 1883).자기촉매반응이란 하나의 생성물이 동일한 반응의 촉매가 되는 동시에 하나의 반응물의 공급이 고정되는 반응이다.이것은 자연스럽게 인구 증가와 같은 이유로 로지스틱 방정식을 야기한다. 즉, 반작용은 스스로 강화되지만 제약된다.

로지스틱 함수는 1920년 Raymond Pearl과 Lowell Reed에 의해 독자적으로 인구 증가 모델로 재발견되었으며, Pearl & Reed(1920) error: target: Red1920 (로 출판되었다.이 현대 통계에서 사용되게 되었다.그들은 처음에 Verhulst의 작품을 몰랐고 아마도 L로부터 그것에 대해 배웠을 것이다. Gustave du Pasquier, 그러나 그들은 그를 거의 신용하지 않았고 [47]그의 용어를 채택하지 않았다.버헐스트의 우선순위는 인정되었고 1925년 우드니 율레에 의해 "로지스틱"이라는 용어가 부활하여 그 [48]이후 계속 따라오고 있다.Pearl and Reed는 처음에 이 모델을 미국 인구에 적용하였고, 또한 처음에 3개의 지점을 통과함으로써 곡선을 맞췄습니다. Verhulst와 마찬가지로, 이것은 다시 좋지 않은 결과를 [49]낳았습니다.

1930년대에 프로빗 모델은 블리스(1934) 에서 ""이라는 용어를 만든 체스터 잇너 블리스(Chester Itner Bliss에 의해 개발되고 체계화되었으며 가둠(1933 오류의 존 개덤()에 의해생성되었다 Fisher in Fisher (1935) 블리스의 작업의 부록으로서 도움말가 없습니다.프로빗 모델은 주로 바이오아세이에서 사용되었으며, 1860년으로 거슬러 올라가는 초기 연구가 선행되었다. 프로빗 모델 § 역사 참조.프로빗 모델은 로짓 모델의 후속 개발에 영향을 미쳤고 이들 모델은 [50]서로 경쟁했습니다.

로지스틱 모델은 Wilson & Worcester의 Edwin Bidwell Wilson과 그의 제자 Jane Worcester(1943)[51]에 의해 바이오아세이에서 프로빗 모델의 대안으로 처음 사용되었을 가능성이 있다.그러나 프로빗 모델의 일반적인 대안으로서의 로지스틱 모델의 개발은 주로 조셉 버크슨의 수십 년에 걸친 작업에 의한 것이었다. 버크슨(1944)에서 시작된 target:(도움말에서 그는 "probit"와 유추하여 "logit"을 만들고, )을 통해 계속했다.도움말) 및 그 이후 [52]연도.로짓 모델은 처음에 프로빗 모델보다 열등한 것으로 간주되었지만, 특히 1960년에서 1970년 사이에 "점차적으로 [53]로짓과 동등한 기반을 달성했다".1970년까지 로짓 모델은 통계 저널에서 사용되는 프로빗 모델과의 동등성을 달성했고, 이후 이를 능가했다.이러한 상대적 인기는 바이오 어세이 내에서 프로빗을 대체하기보다는 바이오 어세이 외부에서 로짓의 채택과 실제에서의 비공식적인 사용에 기인했다. 로짓의 인기는 로짓 모델의 계산 단순성, 수학적 속성 및 일반성에 기인하여 [3]다양한 분야에서 사용할 수 있다.

그 기간 동안 다양한 개선이 이루어졌으며, 특히 데이비드 콕스는 콕스(1958)[4]에서와 같이 그러했다.

다항 로짓 모델은 Cox(1966년)와 Thiel(1969년)에서 독립적으로 도입되어 로짓 [54]모델의 적용 범위와 인기를 크게 높였다.1973년 대니얼 맥 패든 이산 선택의 이론, 특히 루스의 선택 공리에,[55]이것이 군수 reg에 대한 이론적 기초해 주는 다항 logit 무관한 대안이고 상대적인 선호도로 대안의 해석할 확률의 독립 가정에서 나온 것;를 보여 주면서 다항 logit과 연관시켰다.실체사이온[54]

내선번호

다수의 내선번호가 있습니다.

- 다항 로지스틱 회귀 분석(또는 다항 로짓)은 다원 범주형 종속 변수("분류"라고도 함)의 경우를 처리합니다.값이 세 개 이상인 종속 변수를 갖는 일반적인 경우를 다종 회귀라고 합니다.

- 순서형 로지스틱 회귀 분석(또는 순서형 로짓)은 순서형 종속 변수(순서 값)를 처리합니다.

- 혼합 로짓은 종속 변수의 선택 항목 간의 상관 관계를 허용하는 다항 로짓의 확장입니다.

- 로지스틱 모형의 상호의존 변수 집합으로의 확장은 조건부 랜덤 필드입니다.

- 조건부 로지스틱 회귀 분석에서는 지층이 작을 때 일치하거나 계층화된 데이터를 처리합니다.이것은 주로 관찰 연구의 분석에 사용됩니다.

소프트웨어

대부분의 통계 소프트웨어는 이항 로지스틱 회귀 분석을 수행할 수 있습니다.

- SPSS

- 스타타

- SAS

- R

- 파이썬

LogitStatsmodels 모듈에 있습니다.LogisticRegressionSkikit-learn moduleLogisticRegressorTensorFlow 모듈에 있습니다.- Theano 자습서의 로지스틱 회귀 분석 전체 예제 [2]

- ARD 이전 코드를 사용한 베이지안 로지스틱 회귀 분석, 튜토리얼

- ARD 이전 코드를 사용한 가변 베이즈 로지스틱 회귀 분석, 자습서

- 베이지안 로지스틱 회귀 분석 코드, 자습서

- NCSS

- 매트랩

mnrfit[ Statistics and Machine Learning Toolbox ]('잘못'이 0이 아닌 2로 코드화되어 있음)fminunc/fmincon, fitglm, mnrfit, fitclinear, mle모두 로지스틱 회귀 분석을 수행할 수 있습니다.

- 자바(JVM)

- LibLinear(라이브선형)

- 아파치 플링크

- 아파치 스파크

- SparkML은 로지스틱 회귀 분석을 지원합니다.

- FPGA

Logistic Regresesion IP coreFPGA의 HLS로 설정합니다.

특히 Microsoft Excel의 통계 확장 패키지에는 이 패키지가 포함되어 있지 않습니다.

「 」를 참조해 주세요.

- 로지스틱 함수

- 개별 선택

- Jarrow-Turnbull 모형

- 제한된 종속 변수

- 다항 로짓 모형

- 주문된 로짓

- 호스머-렘쇼 검정

- 브리어 점수

- mlpack - 로지스틱 회귀 분석의 C++ 구현을 포함합니다.

- 로컬 케이스-컨트롤 샘플링

- 로지스틱 모형 트리

레퍼런스

- ^ Tolles, Juliana; Meurer, William J (2016). "Logistic Regression Relating Patient Characteristics to Outcomes". JAMA. 316 (5): 533–4. doi:10.1001/jama.2016.7653. ISSN 0098-7484. OCLC 6823603312. PMID 27483067.

- ^ a b c d e f g h i j k Hosmer, David W.; Lemeshow, Stanley (2000). Applied Logistic Regression (2nd ed.). Wiley. ISBN 978-0-471-35632-5.[페이지 필요]

- ^ a b 크래머 2002, 페이지 10-11

- ^ a b Walker, SH; Duncan, DB (1967). "Estimation of the probability of an event as a function of several independent variables". Biometrika. 54 (1/2): 167–178. doi:10.2307/2333860. JSTOR 2333860.

- ^ 크래머 2002, 8페이지

- ^ Boyd, C. R.; Tolson, M. A.; Copes, W. S. (1987). "Evaluating trauma care: The TRISS method. Trauma Score and the Injury Severity Score". The Journal of Trauma. 27 (4): 370–378. doi:10.1097/00005373-198704000-00005. PMID 3106646.

- ^ Kologlu, M.; Elker, D.; Altun, H.; Sayek, I. (2001). "Validation of MPI and PIA II in two different groups of patients with secondary peritonitis". Hepato-Gastroenterology. 48 (37): 147–51. PMID 11268952.

- ^ Biondo, S.; Ramos, E.; Deiros, M.; Ragué, J. M.; De Oca, J.; Moreno, P.; Farran, L.; Jaurrieta, E. (2000). "Prognostic factors for mortality in left colonic peritonitis: A new scoring system". Journal of the American College of Surgeons. 191 (6): 635–42. doi:10.1016/S1072-7515(00)00758-4. PMID 11129812.

- ^ Marshall, J. C.; Cook, D. J.; Christou, N. V.; Bernard, G. R.; Sprung, C. L.; Sibbald, W. J. (1995). "Multiple organ dysfunction score: A reliable descriptor of a complex clinical outcome". Critical Care Medicine. 23 (10): 1638–52. doi:10.1097/00003246-199510000-00007. PMID 7587228.

- ^ Le Gall, J. R.; Lemeshow, S.; Saulnier, F. (1993). "A new Simplified Acute Physiology Score (SAPS II) based on a European/North American multicenter study". JAMA. 270 (24): 2957–63. doi:10.1001/jama.1993.03510240069035. PMID 8254858.

- ^ a b David A. Freedman (2009). Statistical Models: Theory and Practice. Cambridge University Press. p. 128.

- ^ Truett, J; Cornfield, J; Kannel, W (1967). "A multivariate analysis of the risk of coronary heart disease in Framingham". Journal of Chronic Diseases. 20 (7): 511–24. doi:10.1016/0021-9681(67)90082-3. PMID 6028270.

- ^ Harrell, Frank E. (2001). Regression Modeling Strategies (2nd ed.). Springer-Verlag. ISBN 978-0-387-95232-1.

- ^ M. Strano; B.M. Colosimo (2006). "Logistic regression analysis for experimental determination of forming limit diagrams". International Journal of Machine Tools and Manufacture. 46 (6): 673–682. doi:10.1016/j.ijmachtools.2005.07.005.

- ^ Palei, S. K.; Das, S. K. (2009). "Logistic regression model for prediction of roof fall risks in bord and pillar workings in coal mines: An approach". Safety Science. 47: 88–96. doi:10.1016/j.ssci.2008.01.002.

- ^ Berry, Michael J.A (1997). Data Mining Techniques For Marketing, Sales and Customer Support. Wiley. p. 10.

- ^ "How to Interpret Odds Ratio in Logistic Regression?". Institute for Digital Research and Education.

- ^ Everitt, Brian (1998). The Cambridge Dictionary of Statistics. Cambridge, UK New York: Cambridge University Press. ISBN 978-0521593465.

- ^ 예를 들어, 이 경우 인디케이터 는 ( ) - ( - )2 {{ y)=- ( 로 정의할 수 있습니다.

- ^ Malouf, Robert (2002). "A comparison of algorithms for maximum entropy parameter estimation". Proceedings of the Sixth Conference on Natural Language Learning (CoNLL-2002). pp. 49–55. doi:10.3115/1118853.1118871.

- ^ a b c d e f g Menard, Scott W. (2002). Applied Logistic Regression (2nd ed.). SAGE. ISBN 978-0-7619-2208-7.[페이지 필요]

- ^ Gourieroux, Christian; Monfort, Alain (1981). "Asymptotic Properties of the Maximum Likelihood Estimator in Dichotomous Logit Models". Journal of Econometrics. 17 (1): 83–97. doi:10.1016/0304-4076(81)90060-9.

- ^ Park, Byeong U.; Simar, Léopold; Zelenyuk, Valentin (2017). "Nonparametric estimation of dynamic discrete choice models for time series data" (PDF). Computational Statistics & Data Analysis. 108: 97–120. doi:10.1016/j.csda.2016.10.024.

- ^ 예:Murphy, Kevin P. (2012). Machine Learning – A Probabilistic Perspective. The MIT Press. pp. 245pp. ISBN 978-0-262-01802-9.

- ^ Van Smeden, M.; De Groot, J. A.; Moons, K. G.; Collins, G. S.; Altman, D. G.; Eijkemans, M. J.; Reitsma, J. B. (2016). "No rationale for 1 variable per 10 events criterion for binary logistic regression analysis". BMC Medical Research Methodology. 16 (1): 163. doi:10.1186/s12874-016-0267-3. PMC 5122171. PMID 27881078.

- ^ Peduzzi, P; Concato, J; Kemper, E; Holford, TR; Feinstein, AR (December 1996). "A simulation study of the number of events per variable in logistic regression analysis". Journal of Clinical Epidemiology. 49 (12): 1373–9. doi:10.1016/s0895-4356(96)00236-3. PMID 8970487.

- ^ Vittinghoff, E.; McCulloch, C. E. (12 January 2007). "Relaxing the Rule of Ten Events per Variable in Logistic and Cox Regression". American Journal of Epidemiology. 165 (6): 710–718. doi:10.1093/aje/kwk052. PMID 17182981.

- ^ van der Ploeg, Tjeerd; Austin, Peter C.; Steyerberg, Ewout W. (2014). "Modern modelling techniques are data hungry: a simulation study for predicting dichotomous endpoints". BMC Medical Research Methodology. 14: 137. doi:10.1186/1471-2288-14-137. PMC 4289553. PMID 25532820.

- ^ a b Harrell, Frank E. (2015). Regression Modeling Strategies. Springer Series in Statistics (2nd ed.). New York; Springer. doi:10.1007/978-3-319-19425-7. ISBN 978-3-319-19424-0.

- ^ Greene, William N. (2003). Econometric Analysis (Fifth ed.). Prentice-Hall. ISBN 978-0-13-066189-0.

- ^ a b c d e f g h i j Cohen, Jacob; Cohen, Patricia; West, Steven G.; Aiken, Leona S. (2002). Applied Multiple Regression/Correlation Analysis for the Behavioral Sciences (3rd ed.). Routledge. ISBN 978-0-8058-2223-6.[페이지 필요]

- ^ Allison, Paul D. "Measures of fit for logistic regression" (PDF). Statistical Horizons LLC and the University of Pennsylvania.

- ^ Hosmer, D.W. (1997). "A comparison of goodness-of-fit tests for the logistic regression model". Stat Med. 16 (9): 965–980. doi:10.1002/(sici)1097-0258(19970515)16:9<965::aid-sim509>3.3.co;2-f. PMID 9160492.

- ^ Harrell, Frank E. (2010). Regression Modeling Strategies: With Applications to Linear Models, Logistic Regression, and Survival Analysis. New York: Springer. ISBN 978-1-4419-2918-1.[페이지 필요]

- ^ a b https://class.stanford.edu/c4x/HumanitiesScience/StatLearning/asset/classification.pdf 슬라이드 16

- ^ a b Mount, J. (2011). "The Equivalence of Logistic Regression and Maximum Entropy models" (PDF). Retrieved Feb 23, 2022.

- ^ Ng, Andrew (2000). "CS229 Lecture Notes" (PDF). CS229 Lecture Notes: 16–19.

- ^ Rodríguez, G. (2007). Lecture Notes on Generalized Linear Models. pp. Chapter 3, page 45.

- ^ Gareth James; Daniela Witten; Trevor Hastie; Robert Tibshirani (2013). An Introduction to Statistical Learning. Springer. p. 6.

- ^ Pohar, Maja; Blas, Mateja; Turk, Sandra (2004). "Comparison of Logistic Regression and Linear Discriminant Analysis: A Simulation Study". Metodološki Zvezki. 1 (1).

- ^ 크래머 2002, 페이지 3-5

- ^ Verhulst, Pierre-François (1838). "Notice sur la loi que la population poursuit dans son accroissement" (PDF). Correspondance Mathématique et Physique. 10: 113–121. Retrieved 3 December 2014.

- ^ Cramer 2002, 페이지 4 "그는 그가 어떻게 곡선을 맞추었는지 말하지 않았다."

- ^ Verhulst, Pierre-François (1845). "Recherches mathématiques sur la loi d'accroissement de la population" [Mathematical Researches into the Law of Population Growth Increase]. Nouveaux Mémoires de l'Académie Royale des Sciences et Belles-Lettres de Bruxelles. 18. Retrieved 2013-02-18.

- ^ 크래머 2002, 페이지 4

- ^ 크래머 2002, 7페이지

- ^ 크래머 2002, 페이지 6

- ^ 크래머 2002, 페이지 6-7

- ^ 크래머 2002, 5페이지

- ^ 크래머 2002, 페이지 7-9

- ^ 크래머 2002, 페이지 9

- ^ Cramer 2002, 페이지 8, "일반 확률 함수의 대안으로 로지스틱스의 도입은 조셉 버크슨(1899–1982)이라는 한 사람의 작품입니다."

- ^ 크래머 2002, 페이지 11

- ^ a b Cramer, 페이지 13. 오류:

- ^ McFadden, Daniel (1973). "Conditional Logit Analysis of Qualitative Choice Behavior" (PDF). In P. Zarembka (ed.). Frontiers in Econometrics. New York: Academic Press. pp. 105–142. Archived from the original (PDF) on 2018-11-27. Retrieved 2019-04-20.

- ^ Gelman, Andrew; Hill, Jennifer (2007). Data Analysis Using Regression and Multilevel/Hierarchical Models. New York: Cambridge University Press. pp. 79–108. ISBN 978-0-521-68689-1.

추가 정보

- Cox, David R. (1958). "The regression analysis of binary sequences (with discussion)". J R Stat Soc B. 20 (2): 215–242. JSTOR 2983890.

- Cox, David R. (1966). "Some procedures connected with the logistic qualitative response curve". In F. N. David (1966) (ed.). Research Papers in Probability and Statistics (Festschrift for J. Neyman). London: Wiley. pp. 55–71.

- Cramer, J. S. (2002). The origins of logistic regression (PDF) (Technical report). Vol. 119. Tinbergen Institute. pp. 167–178. doi:10.2139/ssrn.360300.

- 발행처:

- Thiel, Henri (1969). "A Multinomial Extension of the Linear Logit Model". International Economic Review. 10 (3): 251–59. doi:10.2307/2525642. JSTOR 2525642.

- Wilson, E.B.; Worcester, J. (1943). "The Determination of L.D.50 and Its Sampling Error in Bio-Assay". Proceedings of the National Academy of Sciences of the United States of America. 29 (2): 79–85. Bibcode:1943PNAS...29...79W. doi:10.1073/pnas.29.2.79. PMC 1078563. PMID 16588606.

- Agresti, Alan. (2002). Categorical Data Analysis. New York: Wiley-Interscience. ISBN 978-0-471-36093-3.

- Amemiya, Takeshi (1985). "Qualitative Response Models". Advanced Econometrics. Oxford: Basil Blackwell. pp. 267–359. ISBN 978-0-631-13345-2.

- Balakrishnan, N. (1991). Handbook of the Logistic Distribution. Marcel Dekker, Inc. ISBN 978-0-8247-8587-1.

- Gouriéroux, Christian (2000). "The Simple Dichotomy". Econometrics of Qualitative Dependent Variables. New York: Cambridge University Press. pp. 6–37. ISBN 978-0-521-58985-7.

- Greene, William H. (2003). Econometric Analysis, fifth edition. Prentice Hall. ISBN 978-0-13-066189-0.

- Hilbe, Joseph M. (2009). Logistic Regression Models. Chapman & Hall/CRC Press. ISBN 978-1-4200-7575-5.

- Hosmer, David (2013). Applied logistic regression. Hoboken, New Jersey: Wiley. ISBN 978-0470582473.

- Howell, David C. (2010). Statistical Methods for Psychology, 7th ed. Belmont, CA; Thomson Wadsworth. ISBN 978-0-495-59786-5.

- Peduzzi, P.; J. Concato; E. Kemper; T.R. Holford; A.R. Feinstein (1996). "A simulation study of the number of events per variable in logistic regression analysis". Journal of Clinical Epidemiology. 49 (12): 1373–1379. doi:10.1016/s0895-4356(96)00236-3. PMID 8970487.

- Berry, Michael J.A.; Linoff, Gordon (1997). Data Mining Techniques For Marketing, Sales and Customer Support. Wiley.

k

k

단일성이 될 확률이며

단일성이 될 확률이며 0이 될 확률입니다(

0이 될 확률입니다(

방정식에 입력하면 시험에 합격할 확률이 0.25로 추정됩니다.

방정식에 입력하면 시험에 합격할 확률이 0.25로 추정됩니다.

다음과 같이 쓸 수 있습니다.

다음과 같이 쓸 수 있습니다.

종속

종속

하나의 데이터

하나의 데이터

방정식은

방정식은

회귀계수에 예측 변수의 값을 곱한 값입니다.

회귀계수에 예측 변수의 값을 곱한 값입니다.

곱한다.

곱한다. 정의됩니다.여기서 a, b

정의됩니다.여기서 a, b

대한

대한

![{\displaystyle {\begin{aligned}Y_{i}\mid x_{1,i},\ldots ,x_{m,i}\ &\sim \operatorname {Bernoulli} (p_{i})\\\operatorname {\mathbb {E} } [Y_{i}\mid x_{1,i},\ldots ,x_{m,i}]&=p_{i}\\\Pr(Y_{i}=y\mid x_{1,i},\ldots ,x_{m,i})&={\begin{cases}p_{i}&{\text{if }}y=1\\1-p_{i}&{\text{if }}y=0\end{cases}}\\\Pr(Y_{i}=y\mid x_{1,i},\ldots ,x_{m,i})&=p_{i}^{y}(1-p_{i})^{(1-y)}\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/49627157ac00e729a38538029505c210f99955d7)

결과에 대한 특정 설명 변수의 상대적 영향을

결과에 대한 특정 설명 변수의 상대적 영향을

모델의 파라미터입니다.모델 b의 밑이

모델의 파라미터입니다.모델 b의 밑이  보통 e로

보통 e로

고정되면 특정 관측치에 대해 y

고정되면 특정 관측치에 대해 y

예를 생각해 보겠습니다.구체적으로 말하면, 모델은 다음과 같습니다.

예를 생각해 보겠습니다.구체적으로 말하면, 모델은 다음과 같습니다.

1

1

, 결과가 카테고리 0에 속할 확률은

, 결과가 카테고리 0에 속할 확률은

합계가

합계가

표시하고 범주형 결과를 y

표시하고 범주형 결과를 y

y = n이면k 통합과 같고 그렇지 않으면 0이면 통합과 동일한

y = n이면k 통합과 같고 그렇지 않으면 0이면 통합과 동일한

![{\displaystyle \operatorname {logit} (\operatorname {\mathcal {E}} [Y_{i}\mid x_{1,i},\ldots ,x_{m,i}])=\operatorname {logit} (p_{i})=\ln \left({\frac {p_{i}}{1-p_{i}}}\right)=\beta _{0}+\beta _{1}x_{1,i}+\cdots +\beta _{m}x_{m,i}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/2389d119a0c95c1f52b98396ac9762de04067bdd)

![{\displaystyle \operatorname {logit} (\operatorname {\mathcal {E}} [Y_{i}\mid \mathbf {X} _{i}])=\operatorname {logit} (p_{i})=\ln \left({\frac {p_{i}}{1-p_{i}}}\right)={\boldsymbol {\beta }}\cdot \mathbf {X} _{i}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/66290b1bc5ddfd2fc7fc2971372a79ba65e28f89)

남성과 여성의 비교 결과에 대한 확률 추정치이다.

남성과 여성의 비교 결과에 대한 확률 추정치이다. ![{\displaystyle \operatorname {\mathcal {E}} [Y_{i}\mid \mathbf {X} _{i}]=p_{i}=\operatorname {logit} ^{-1}({\boldsymbol {\beta }}\cdot \mathbf {X} _{i})={\frac {1}{1+e^{-{\boldsymbol {\beta }}\cdot \mathbf {X} _{i}}}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/74c2849bc48454b0a177375d2c69c557ffd2836d)

![{\displaystyle {\begin{aligned}\Pr(Y_{i}=1\mid \mathbf {X} _{i})&=\Pr(Y_{i}^{\ast }>0\mid \mathbf {X} _{i})\\[5pt]&=\Pr({\boldsymbol {\beta }}\cdot \mathbf {X} _{i}+\varepsilon _{i}>0)\\[5pt]&=\Pr(\varepsilon _{i}>-{\boldsymbol {\beta }}\cdot \mathbf {X} _{i})\\[5pt]&=\Pr(\varepsilon _{i}<{\boldsymbol {\beta }}\cdot \mathbf {X} _{i})&&{\text{(because the logistic distribution is symmetric)}}\\[5pt]&=\operatorname {logit} ^{-1}({\boldsymbol {\beta }}\cdot \mathbf {X} _{i})&\\[5pt]&=p_{i}&&{\text{(see above)}}\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/67ce399af3b2241cc7121b48c60ceaf626e430c5)

![{\displaystyle {\begin{aligned}\Pr(Y_{i}=1\mid \mathbf {X} _{i})={}&\Pr \left(Y_{i}^{1\ast }>Y_{i}^{0\ast }\mid \mathbf {X} _{i}\right)&\\[5pt]={}&\Pr \left(Y_{i}^{1\ast }-Y_{i}^{0\ast }>0\mid \mathbf {X} _{i}\right)&\\[5pt]={}&\Pr \left({\boldsymbol {\beta }}_{1}\cdot \mathbf {X} _{i}+\varepsilon _{1}-\left({\boldsymbol {\beta }}_{0}\cdot \mathbf {X} _{i}+\varepsilon _{0}\right)>0\right)&\\[5pt]={}&\Pr \left(({\boldsymbol {\beta }}_{1}\cdot \mathbf {X} _{i}-{\boldsymbol {\beta }}_{0}\cdot \mathbf {X} _{i})+(\varepsilon _{1}-\varepsilon _{0})>0\right)&\\[5pt]={}&\Pr(({\boldsymbol {\beta }}_{1}-{\boldsymbol {\beta }}_{0})\cdot \mathbf {X} _{i}+(\varepsilon _{1}-\varepsilon _{0})>0)&\\[5pt]={}&\Pr(({\boldsymbol {\beta }}_{1}-{\boldsymbol {\beta }}_{0})\cdot \mathbf {X} _{i}+\varepsilon >0)&&{\text{(substitute }}\varepsilon {\text{ as above)}}\\[5pt]={}&\Pr({\boldsymbol {\beta }}\cdot \mathbf {X} _{i}+\varepsilon >0)&&{\text{(substitute }}{\boldsymbol {\beta }}{\text{ as above)}}\\[5pt]={}&\Pr(\varepsilon >-{\boldsymbol {\beta }}\cdot \mathbf {X} _{i})&&{\text{(now, same as above model)}}\\[5pt]={}&\Pr(\varepsilon <{\boldsymbol {\beta }}\cdot \mathbf {X} _{i})&\\[5pt]={}&\operatorname {logit} ^{-1}({\boldsymbol {\beta }}\cdot \mathbf {X} _{i})\\[5pt]={}&p_{i}\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/be3b57ca6773ef745cdfd82367611e9394215f9e)

![{\displaystyle {\begin{aligned}\Pr(Y_{i}=0)&={\frac {1}{Z}}e^{{\boldsymbol {\beta }}_{0}\cdot \mathbf {X} _{i}}\\[5pt]\Pr(Y_{i}=1)&={\frac {1}{Z}}e^{{\boldsymbol {\beta }}_{1}\cdot \mathbf {X} _{i}}\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/6e1e2a04fd15f2e5617c0606a7644fe719823960)

![{\displaystyle {\begin{aligned}\Pr(Y_{i}=0)&={\frac {e^{{\boldsymbol {\beta }}_{0}\cdot \mathbf {X} _{i}}}{e^{{\boldsymbol {\beta }}_{0}\cdot \mathbf {X} _{i}}+e^{{\boldsymbol {\beta }}_{1}\cdot \mathbf {X} _{i}}}}\\[5pt]\Pr(Y_{i}=1)&={\frac {e^{{\boldsymbol {\beta }}_{1}\cdot \mathbf {X} _{i}}}{e^{{\boldsymbol {\beta }}_{0}\cdot \mathbf {X} _{i}}+e^{{\boldsymbol {\beta }}_{1}\cdot \mathbf {X} _{i}}}}.\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/1fa489d73be139142872ddccccecd567635525d5)

하나를 알면 다른 하나가 자동으로 결정됩니다.결과적으로, 모델은 식별

하나를 알면 다른 하나가 자동으로 결정됩니다.결과적으로, 모델은 식별 ![{\displaystyle {\begin{aligned}\Pr(Y_{i}=1)&={\frac {e^{({\boldsymbol {\beta }}_{1}+\mathbf {C} )\cdot \mathbf {X} _{i}}}{e^{({\boldsymbol {\beta }}_{0}+\mathbf {C} )\cdot \mathbf {X} _{i}}+e^{({\boldsymbol {\beta }}_{1}+\mathbf {C} )\cdot \mathbf {X} _{i}}}}\\[5pt]&={\frac {e^{{\boldsymbol {\beta }}_{1}\cdot \mathbf {X} _{i}}e^{\mathbf {C} \cdot \mathbf {X} _{i}}}{e^{{\boldsymbol {\beta }}_{0}\cdot \mathbf {X} _{i}}e^{\mathbf {C} \cdot \mathbf {X} _{i}}+e^{{\boldsymbol {\beta }}_{1}\cdot \mathbf {X} _{i}}e^{\mathbf {C} \cdot \mathbf {X} _{i}}}}\\[5pt]&={\frac {e^{\mathbf {C} \cdot \mathbf {X} _{i}}e^{{\boldsymbol {\beta }}_{1}\cdot \mathbf {X} _{i}}}{e^{\mathbf {C} \cdot \mathbf {X} _{i}}(e^{{\boldsymbol {\beta }}_{0}\cdot \mathbf {X} _{i}}+e^{{\boldsymbol {\beta }}_{1}\cdot \mathbf {X} _{i}})}}\\[5pt]&={\frac {e^{{\boldsymbol {\beta }}_{1}\cdot \mathbf {X} _{i}}}{e^{{\boldsymbol {\beta }}_{0}\cdot \mathbf {X} _{i}}+e^{{\boldsymbol {\beta }}_{1}\cdot \mathbf {X} _{i}}}}.\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/4f545a36890435f35e006242acda552c8f62dcd0)

![{\displaystyle p_{i}=\operatorname {\mathcal {E}} \left[\left.{\frac {Y_{i}}{n_{i}}}\,\right|\,\mathbf {X} _{i}\right]\,,}](https://wikimedia.org/api/rest_v1/media/math/render/svg/0123cbc81b998479d4519f00a89ba3d5ba1bfcc5)

![{\displaystyle \operatorname {logit} \left(\operatorname {\mathcal {E}} \left[\left.{\frac {Y_{i}}{n_{i}}}\,\right|\,\mathbf {X} _{i}\right]\right)=\operatorname {logit} (p_{i})=\ln \left({\frac {p_{i}}{1-p_{i}}}\right)={\boldsymbol {\beta }}\cdot \mathbf {X} _{i}\,,}](https://wikimedia.org/api/rest_v1/media/math/render/svg/bdb8db87748853ad7609116b81d41ab7ecaad708)

![{\displaystyle \mathbf {w} ^{T}=[\beta _{0},\beta _{1},\beta _{2},\ldots ]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/daccbf84c2c936e0559016491efe98eaf0eca430)

![{\displaystyle \mathbf {x} (i)=[1,x_{1}(i),x_{2}(i),\ldots ]^{T}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c8fc5f11bdd42f672417a3f4e44b3a4e5be28faa)

![{\displaystyle \mathbf {y} (i)=[y(1),y(2),\ldots ]^{T}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/33cbd315328b6ccfc7f216d65e39f92a8ec48694)

b의 값을0 선택하는 것으로 구성됩니다

b의 값을0 선택하는 것으로 구성됩니다

null 모델을 나타냅니다.null 모델은 b

null 모델을 나타냅니다.null 모델은 b

최대 L이므로 늘 모델의 최대 로그 우도는 다음과 같습니다.

최대 L이므로 늘 모델의 최대 로그 우도는 다음과 같습니다.

![{\displaystyle {\begin{aligned}D_{\text{null}}&=-2\ln {\frac {\text{likelihood of null model}}{\text{likelihood of the saturated model}}}\\[6pt]D_{\text{fitted}}&=-2\ln {\frac {\text{likelihood of fitted model}}{\text{likelihood of the saturated model}}}.\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/d85ab8f60a3e7685815b132b3a80d03d26d9745a)

![{\displaystyle {\begin{aligned}D_{\text{null}}-D_{\text{fitted}}&=-2\left(\ln {\frac {\text{likelihood of null model}}{\text{likelihood of the saturated model}}}-\ln {\frac {\text{likelihood of fitted model}}{\text{likelihood of the saturated model}}}\right)\\[6pt]&=-2\ln {\frac {\left({\dfrac {\text{likelihood of null model}}{\text{likelihood of the saturated model}}}\right)}{\left({\dfrac {\text{likelihood of fitted model}}{\text{likelihood of the saturated model}}}\right)}}\\[6pt]&=-2\ln {\frac {\text{likelihood of the null model}}{\text{likelihood of fitted model}}}.\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/bd851b7e234a5483dbb21da9fff7d9d2419e3e3e)

점근적으로 따르는 검정 통계량을 사용하여 관측된 사건 비율이 모델 모집단의 하위 그룹에서 예상 사건 비율과 일치하는지 여부를 평가한다.이 검정은 예측 확률의 임의

점근적으로 따르는 검정 통계량을 사용하여 관측된 사건 비율이 모델 모집단의 하위 그룹에서 예상 사건 비율과 일치하는지 여부를 평가한다.이 검정은 예측 확률의 임의

실제 유병률이고

실제 유병률이고 샘플의 유병률입니다.

샘플의 유병률입니다.

설명 변수를

설명 변수를

![{\displaystyle {\begin{aligned}&\lim \limits _{N\rightarrow +\infty }N^{-1}\sum _{i=1}^{N}\log \Pr(y_{i}\mid x_{i};\theta )=\sum _{x\in {\mathcal {X}}}\sum _{y\in {\mathcal {Y}}}\Pr(X=x,Y=y)\log \Pr(Y=y\mid X=x;\theta )\\[6pt]={}&\sum _{x\in {\mathcal {X}}}\sum _{y\in {\mathcal {Y}}}\Pr(X=x,Y=y)\left(-\log {\frac {\Pr(Y=y\mid X=x)}{\Pr(Y=y\mid X=x;\theta )}}+\log \Pr(Y=y\mid X=x)\right)\\[6pt]={}&-D_{\text{KL}}(Y\parallel Y_{\theta })-H(Y\mid X)\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/9b300972d40831096c1ab7bdf34338a71eca96d9)