독립 성분 분석

Independent component analysis| 시리즈의 일부 |

| 기계 학습 및 데이터 마이닝 |

|---|

|

신호 처리에서 독립 성분 분석(ICA)은 다변량 신호를 가산 하위 성분으로 분리하는 계산 방법입니다.이것은 최대 1개의 서브컴포넌트가 비가우스 신호이며 서브컴포넌트가 통계적으로 서로 [1]독립적이라고 가정함으로써 이루어집니다.ICA는 블라인드 소스 분리의 특수한 경우입니다.일반적인 적용 예는 시끄러운 [2]방에서 한 사람의 연설을 엿듣는 "칵테일 파티 문제"입니다.

서론

독립 성분 분석은 다변량 신호를 독립 비-가우스 신호로 분해하려고 시도합니다.예를 들어, 소리는 보통 여러 소스에서 나오는 신호의 각 시간 t에 숫자 덧셈으로 구성된 신호입니다.여기서 문제는 이러한 기여 소스를 관측된 총 신호에서 분리할 수 있는가 하는 것입니다.통계적 독립성 가정이 올바른 경우 혼합 신호의 블라인드 ICA 분리는 매우 좋은 [citation needed]결과를 가져옵니다.분석 목적으로 혼합하여 생성해서는 안 되는 신호에도 사용됩니다.

ICA의 간단한 적용은 "칵테일 파티 문제"로, 기본 음성 신호는 방에서 동시에 대화하는 사람들로 구성된 샘플 데이터로부터 분리된다.통상, 지연이나 에코가 없는 것을 전제로 하는 것으로, 문제가 심플화됩니다.필터링 및 지연된 신호는 종속 컴포넌트의 복사이므로 통계적 독립성 가정은 위반되지 않습니다.

컴포넌트에서M개(\ Mtimes N 신호를 구성하기 위한 혼합 가중치를 M×(\ M N 에 배치할 수 있습니다.고려해야 할 중요한 점은 N개의 N개의 소스가 존재하는 원본 신호를 복구하기 위해 N개의 \N개의 관측치(예를 들어 관측된 신호가 오디오인 경우 마이크)가 필요하다는 것입니다.관측치와 소스 신호의 수가 같으면 혼합 행렬은 정사각형( { M이 됩니다.기타 과소판정 사례 <N \ M \ )및 과대판정 사례(> \ M )가 조사되었습니다.

혼합 신호의 ICA 분리가 매우 좋은 결과를 가져오는 것은 혼합 소스 신호의 2가지 가정과 3가지 효과에 기초하고 있습니다.두 가지 전제 조건:

- 소스 신호는 서로 독립적입니다.

- 각 소스 신호의 값은 가우스 분포가 아닙니다.

소스 신호 혼합의 세 가지 효과:

- 독립성:가정 1에 따라 소스 신호는 독립적이지만 신호 혼합은 독립적이지 않습니다.이는 신호 혼합물이 동일한 소스 신호를 공유하기 때문입니다.

- 정규성:중심 한계 정리에 따르면 분산이 유한한 독립 랜덤 변수의 합계는 가우스 분포를 지향한다.

대략적으로 말하면, 두 개의 독립적인 랜덤 변수의 합은 보통 두 개의 원래 변수 중 어느 것보다 가우스 분포에 더 가깝습니다.여기서는 각 신호의 값을 랜덤 변수로 간주합니다. - 복잡성:신호 혼합의 시간 복잡도는 가장 단순한 구성 소스 신호의 시간 복잡도보다 큽니다.

그 원칙들은 ICA의 기본 설립에 기여한다.혼합물 집합에서 추출된 신호가 독립적이고 가우스 히스토그램이 아닌 경우 또는 복잡도가 낮은 경우 소스 [4][5]신호여야 합니다.

컴포넌트 독립성

ICA는 추정된 성분의 통계적 독립성을 극대화하여 독립 성분(요인, 잠재 변수 또는 출처라고도 함)을 찾습니다.독립 프록시를 정의하는 많은 방법 중 하나를 선택할 수 있으며, 이 선택은 ICA 알고리즘의 형식을 지배합니다.ICA의 독립성에 대한 가장 광범위한 두 가지 정의는 다음과 같다.

- 상호 정보 최소화

- 비가우스성의 극대화

ICA 알고리즘의 MMI(Minimization-of-Mutual Information) 패밀리는 Kullback-Leibler Divergence 및 최대 엔트로피와 같은 척도를 사용합니다.중심 한계 정리에 의해 동기 부여되는 ICA 알고리즘의 비-가우스성 계열은 첨도와 음성을 사용한다.

ICA의 일반적인 알고리즘은 실제 반복 알고리즘에 대한 문제의 복잡성을 단순화하고 줄이기 위해 센터링(평균을 추출하여 제로 평균 신호를 생성), 화이트닝(일반적으로 고유값 분해와 함께), 차원성 감소를 전처리 단계로 사용합니다.주성분 분석 또는 특이값 분해를 통해 미백 및 치수 감소를 달성할 수 있습니다.화이트닝은 알고리즘이 실행되기 전에 모든 차원이 동일하게 처리되도록 합니다.ICA의 잘 알려진 알고리즘에는 infomax, FastICA, JADE 및 커널에 의존하지 않는 컴포넌트 분석 등이 있습니다.일반적으로 ICA는 실제 소스 신호의 수, 소스 신호의 고유하게 올바른 순서 또는 소스 신호의 적절한 스케일링(부호 포함)을 식별할 수 없습니다.

ICA는 블라인드 신호 분리에 중요하며 많은 실용적인 응용 분야를 가지고 있습니다.이것은 데이터의 요인 코드 검색과 밀접하게 관련되어 있다(또는 심지어 특별한 경우). 즉, 결과 코드 벡터(손실 없는 부호화)에 의해 고유하게 인코딩되는 각 데이터 벡터의 새로운 벡터 값 표현이다. 그러나 코드 구성요소는 통계적으로 독립적이다.

수학적 정의

선형 독립 성분 분석은 소음 없는 경우와 소음 없는 경우로 나눌 수 있으며, 소음 없는 ICA는 소음 ICA의 특수한 경우이다.비선형 ICA는 별도의 경우로 간주해야 한다.

일반적인 정의

데이터는 관측된 랜덤 x ( 1,…, m) x}=(로 표시됩니다. 및 숨겨진 컴포넌트를 랜덤 벡터 ( 1, , n)T . { \ { s } = ( _ { ,s _ n }^{ } } } 、 \ style { { xdisplaydisplaydisplaydisplaydisplaydisplaydisplaydisplaydisplayboldbolddisplaydisplaydisplaydisplaydisplaydisplaydisplaydisplaydisplaydisplaydisplay displaydisplaydisplaydisplaydisplaydisplaydisplaydisplaydisplaydisplaydisplaydisplaydisplaydisplaybolddisplaydisplaydisplayx, {\을(를) F( 1, n에 의해 측정되는 최대 독립 의 벡터F

생성 모델

선형 노이즈 없음 ICA

관찰된 랜덤 x ( 1, m )의 i (T (은 독립 k{\ k , {\ k의 합으로 생성됩니다.

의 무게에 의해 가중치가 부여됩니다.

동일한 생성 은 x k s { style \ display { k} \ _ { } s _ { k } { \ symbol { a { 와 같은 벡터 으로 될 수 있습니다. 서 관측된 랜덤 x \ syle \ syle \ syle \ syle \ syle \ \ syle \ sylmbold syl { x } _ syl { x _ symbol { { 기본 k{\은 A ( , {\bold\, {\})의 컬럼을 형성하며 x의 을 사용할 수 있습니다 서 s ( s , ) {\}=(

모델 및 실현(샘플) 1, N(\{\}, , {\boldsymbol {}) 랜덤 의 {\displaystyle {x_{과(\의 혼합 를 모두 합니다{ 은w\ {w 벡터를 적응적으로 계산하여 된 {\w}}^{{\}}}의 비용 함수를 설정함으로써 이루어집니다. 또는 상호 정보를 최소화합니다.경우에 따라서는, 선원의 확률 분포에 대한 선험적 지식이 비용 함수에서 사용될 수 있다.

원본 는 관찰된 x{에 혼합 A -({의 역수를 곱하여 복구할 수 있습니다.여기서 혼합 매트릭스는 이라고 가정합니다( m \ n ) 。베이스 벡터의 수가 관찰된 벡터의 보다클 > m \ nm ) 태스크는 오버 컴플리트이지만 의사 역순으로 해결할 수 있습니다.

선형 노이즈 ICA

제로 평균 및 상관없는 노이즈 n~ N( , )( \ n \ N ( , \ } ( \ ) , ) , , , , , , , , , ICA 모델은 + ( \ style { sylbold { } symbold = symbol} ) ) , = symbodymbolsymb

비선형 ICA

소스 혼합은 선형일 필요는 없습니다.파라미터 { }에 혼합 함수 ( ) { f를 사용하면 비선형 ICA 모델은 x ( s)) +n { x ( \)+가 .

식별 가능성

독립 컴포넌트는 소스의 치환과 스케일링까지 식별할 수 있습니다.이 식별가능성에는 다음이 필요합니다.

- 중k(\k})는 가우스입니다.

- 관찰된 혼합물의 m{ m는 추정 수 n n : mn {\ n 이상이어야 합니다. 즉, 혼합 A{\이(가) 역순위로 존재하려면 전체 등급이어야 합니다.

바이너리 ICA

ICA의 특별한 변형은 바이너리 ICA로 신호 소스와 모니터가 모두 바이너리 형식이며 모니터로부터의 관찰은 바이너리 독립 소스의 분리 혼합이다.이 문제는 의료 진단, 다중 클러스터 할당, 네트워크 단층 촬영 및 인터넷 자원 관리를 포함한 많은 영역에서 응용 프로그램을 사용하는 것으로 나타났습니다.

1, , {\},},\m}}을 m{\ m 의 바이너리 변수 세트, 1, { \로 .소스-모니터 연결은 (표준) 혼합 G(\ {G로 표시됩니다. 서 j (\{ij}=은 i번째 소스로부터의 신호가 j번째 모니터에 의해 관찰될 수 있음을 나타냅니다.시스템은 다음과 같이 동작합니다.i(\ i가 활성화되어 있고( 1 {{i}) j( i {{ij} ) 모니터 j(\ j에 연결되어 있는 경우, 모니터(\displaystyle j)가 어떤 액티비티를 관찰합니다( 1}입니다.정식으로 다음과 같은 것이 있습니다.

여기서 는 Boolean AND, 는 Boolean OR입니다.소음은 명시적으로 모델링되지 않고 독립적인 선원으로 취급할 수 있다.

위의 문제는 변수가 연속적이고 빠르게 실행된다고 가정하면 경험적으로[6] 해결할 수 있습니다.ICA는 이진수 관측 데이터에 대해 혼합 G 값)를 얻은 후 G에 라운드 넘버 기법을 적용하여 이진수 값을 구합니다.이 접근방식은 매우 부정확한 결과를 [citation needed]낳는 것으로 나타났습니다.

또 다른 방법은 동적 프로그래밍을 사용하는 것입니다. 즉, 관찰 X를 하위 행렬로 재귀적으로 분할하고 이러한 하위 행렬에 대해 추론 알고리즘을 실행합니다.이 알고리즘으로 이어지는 주요 관찰은 X의 X(\의 하위 textstyle {X입니다. 서 ,j(\}=j)는되지 않은 컴포넌트의 왜곡되지 않은 관찰 매트릭스에 대응합니다. i - 번째 모니터의 실험 결과에 따르면[7] 이 접근방식은 적당한 소음 수준에서 정확합니다.

Generalized Binary ICA 프레임워크는[8] 생성 모델에 대한 지식이 필요하지 않은 광범위한 문제 공식을 도입한다.즉, 이 메서드는 소스 생성 방법에 대한 사전 전제 없이 소스를 독립된 컴포넌트(가능한 한 정보를 잃지 않고)로 분해하려고 합니다.이 문제는 매우 복잡해 보이지만, 분기 및 바운드 검색 트리 알고리즘이나 벡터가 있는 행렬의 단일 곱셈으로 엄격하게 상한을 설정하여 정확하게 해결할 수 있다.

블라인드 소스 분리 방법

프로젝션 추구

신호 혼합물은 가우스 확률 밀도 함수를 갖는 경향이 있고 소스 신호는 비 가우스 확률 밀도 함수를 갖는 경향이 있습니다.각 소스 신호는 가중치 벡터의 내적과 이 내적이 신호 혼합물의 직교 투영을 제공하는 신호 혼합물의 내적을 취함으로써 신호 혼합물의 집합에서 추출할 수 있다.남은 과제는 그러한 무게 벡터를 찾는 것이다.이를 위한 방법 중 하나는 투영 [9][10]추적입니다.

투영 추구는 추출된 신호가 가능한 한 비가우스적이 되도록 한 번에 하나의 투영을 추구합니다.이는 일반적으로 M × M 혼합 해제 행렬을 추정해야 하는 M 신호 혼합에서 M 신호를 동시에 추출하는 ICA와 대조됩니다.ICA에 비해 투사 추구의 실질적인 이점 중 하나는 필요에 따라 M개 미만의 신호를 추출할 수 있다는 것이다.여기서 각 소스 신호는 M요소 가중치 벡터를 사용하여 M개 신호 혼합에서 추출된다.

투영 추구를 사용하여 올바른 무게 벡터를 찾아 다중 소스 신호를 복구할 수 있습니다.

유한 표본에 대한 신호의 확률 밀도 함수의 첨도는 다음과 같이 계산됩니다.

서 y추출된 신호인y(\의 표본 평균입니다.상수 3은 가우스 신호의 첨도가 0이고, 슈퍼 가우스 신호는 양의 첨도가, 서브 가우스 신호는 음의 첨도가 되도록 합니다.분모는 y의 분산이며 측정된 첨도가 신호 분산을 고려하도록 합니다.투영 추구의 목적은 첨도를 최대화하고 추출된 신호를 가능한 비정규적으로 만드는 것입니다.

첨도를 비표준값의 척도로 사용하여 = (,x , )에서 추출된 신호 y x \ \ {w}{의 첨도를 확인할 수 . 무게 w가 원점을 중심으로 회전함에 따라 변화합니다.각 소스 s \{s가 슈퍼 가우스라고 가정하면 다음과 같이 됩니다.

- 추출된 의 첨도는 y \일 때 하게 최대가 되어야 합니다.

- 된 신호의 \displaystyle 이 투영 ({ S_ 또는 ({2})와 직교할 최대가 됩니다. 최적의 무게 벡터는 변환 축 S1과 직교해야 하기 때문입니다.

다중 소스 혼합 신호의 경우 첨도와 그램-슈미트 직교화(GSO)를 사용하여 신호를 복구할 수 있습니다.M차원 공간에 M개의 신호가 혼합되어 있을 때 GSO는 가중치 벡터를 사용하여 이러한 데이터 포인트를 (M-1)차원 공간에 투영한다.GSO를 사용하여 추출된 신호의 독립성을 보장할 수 있습니다.

w의 값을 찾기 위해 구배 강하법을 사용할 수 있습니다.먼저 데이터를 화이트화하고 x를 단위 분산을 갖는 새로운 z(\{와 z ( T{z}, 로 합니다.x로의 분해

각 i / E ( ) { U _ { i } = _ { } / \{ E } ( _ { } { )를 재스케일하고 z \ =\ {U 를 추출합니다 ^{{}. 무게 벡터 w가 단위 길이를 갖는 경우 y의 분산도 입니다 즉 E [( z ) ] 1 \ {E } [ ( \z}^{z} ]따라서 첨도는 다음과 같이 쓸 수 있습니다.

업데이트 프로세스는 다음과 같습니다.

여기서 {\는 w이(가) 최적의 솔루션으로 수렴되도록 위한 작은 상수입니다.각 업데이트 후 n e w w w w w w w ww w \ \ } { frac { { }{ }} { w { \{ w } { w } } { w } { w } { new } 를 설정합니다.다른 알고리즘을 사용하여 무게 w 를 업데이트할 수도 있습니다

또 다른 접근법은 첨도 대신에 부정성을[11][12] 사용하는 것이다.첨도는 특이치에 매우 민감하기 때문에 음성을 사용하는 것이 첨도보다 더 강력한 방법입니다.네겐트로피 방법은 가우스 분포의 중요한 특성에 기초합니다. 가우스 변수는 동일한 분산의 모든 연속 랜덤 변수 중에서 가장 큰 엔트로피를 가집니다.이것이 우리가 가장 비가우스적인 변수를 찾는 이유이기도 하다.간단한 증거는 미분 엔트로피에서 찾을 수 있습니다.

y는 x와 동일한 공분산 행렬의 가우스 랜덤 변수입니다.

부젠트로피의 근사치는 다음과 같다.

증거는 코몬의 [13][11]원본 논문에서 찾을 수 있다; 그것은 Aapo Hyvérinen, Juha Karhunen, Erkki[14] Oja의 독립 성분 분석에서 재현되었다. 이 근사치 역시 첨도증(이상치에 대한 민감도)과 같은 문제를 겪는다.다른 접근법이 [15]개발되었습니다.

에서 선택할 수 있습니다.

- a log ( ( 1u) { } 1} \ ( \ ( _ { ) } } 、 - exp ( - ) { 2 } } } ( \)

인포맥스 기반

Infomax ICA는[16] 기본적으로 투영 추구의 다변량 병렬 버전입니다.투영 추구는 M개의 신호 혼합에서 한 번에 하나씩 일련의 신호를 추출하는 반면 ICA는 M개의 신호를 병렬로 추출합니다.이로 인해 ICA는 [17]예측추구보다 더 견고해지는 경향이 있습니다.

투영 추적 방법은 추출된 신호의 독립성을 보장하기 위해 그램-슈미트 직교화를 사용하는 반면 ICA는 추출된 신호의 독립성을 보장하기 위해 인포맥스와 최대우도 추정치를 사용합니다.추출된 신호의 비정규성은 신호에 적절한 모델 또는 이전 모델을 할당함으로써 달성됩니다.

간단히 말해서 인포맥스에 기반한 ICA의 프로세스는 신호 x 집합과 동일한 독립 모델 누적 분포 함수(cdfs) g 집합이 주어진 경우 신호의 결합을 최대화하는 혼합 해제 W(\ \를 구한다. () { = 서 y x \}는 W {\displaystyle \에 의해 된 신호입니다. W{Wstyle {이(\mathbf {Y} ).따라서 추출된 y - ( ){ 도 독립적입니다. {\ g는 가역 함수이며 신호 모델입니다.소스 신호 모델 확률 밀도 p {\가 추출된 p {\의 확률 밀도 함수와 일치하는 경우 Y{\ Y의 조인트 엔트로피를 최대화하면 x 사이의 정보량도 최대화됨을 유의하십시오. Y \ 따라서 엔트로피를 사용하여 독립 신호를 추출하는 것을 인포맥스라고 합니다.

벡터 Y ( y) \의 엔트로피를 고려합니다.서 x \ \{y =\ { 는 행렬 에 대해 추출된 신호의 집합입니다.{\엔트로피는 다음과 같이 추정할 수 있습니다.

합동 Y {\{는 다변수 형식으로 추출된 신호의 합동 py {\p_{\{y와 관련이 있음을 나타낼 수 있습니다.

서 J \= fracdisplaystyle \ \는 야코비안 행렬이다. ( \ \ { J= ( \ } )} 。 \ ' =s} for for for for for 。

그러므로,

y {\=일 , Y {\는 균일한 분포이며, {\ H는 최대화됨을 알 수 있습니다.부터

서 W는 혼합하지 행렬 W \{W의 행렬식 절대값입니다. 따라서,

그렇게,

H( ) - ∑ ( ) { style H ( \ { } ) = - { \ { { } { } \ { } \ p _ { \{ x } } }、

to achieve the independence of extracted signal.

If there are M marginal pdfs of the model joint pdf are independent and use the commonly super-gaussian model pdf for the source signals , then we have

In the sum, given an observed signal mixture , the corresponding set of extracted signals and source signal model , we can find the optimal unmixing matrix , and make the extracted signals independent and non-gaussian. Like the projection pursuit situation, we can use gradient descent method to find the optimal solution of the unmixing matrix.

Based on maximum likelihood estimation

Maximum likelihood estimation (MLE) is a standard statistical tool for finding parameter values (e.g. the unmixing matrix ) that provide the best fit of some data (e.g., the extracted signals ) to a given a model (e.g., the assumed joint probability density function (pdf) of source signals).[17]

The ML "model" includes a specification of a pdf, which in this case is the pdf of the unknown source signals . Using ML ICA, the objective is to find an unmixing matrix that yields extracted signals with a joint pdf as similar as possible to the joint pdf of the unknown source signals .

MLE is thus based on the assumption that if the model pdf and the model parameters are correct then a high probability should be obtained for the data that were actually observed. Conversely, if is far from the correct parameter values then a low probability of the observed data would be expected.

Using MLE, we call the probability of the observed data for a given set of model parameter values (e.g., a pdf and a matrix ) the likelihood of the model parameter values given the observed data.

We define a likelihood function of :

This equals to the probability density at , since .

Thus, if we wish to find a that is most likely to have generated the observed mixtures from the unknown source signals with pdf then we need only find that which maximizes the likelihood . The unmixing matrix that maximizes equation is known as the MLE of the optimal unmixing matrix.

It is common practice to use the log likelihood, because this is easier to evaluate. As the logarithm is a monotonic function, the that maximizes the function also maximizes its logarithm . This allows us to take the logarithm of equation above, which yields the log likelihood function

If we substitute a commonly used high-Kurtosis model pdf for the source signals then we have

This matrix that maximizes this function is the maximum likelihood estimation.

History and background

The early general framework for independent component analysis was introduced by Jeanny Hérault and Bernard Ans from 1984,[18] further developed by Christian Jutten in 1985 and 1986,[19][20][21] and refined by Pierre Comon in 1991,[13] and popularized in his paper of 1994.[11] In 1995, Tony Bell and Terry Sejnowski introduced a fast and efficient ICA algorithm based on infomax, a principle introduced by Ralph Linsker in 1987.

There are many algorithms available in the literature which do ICA. A largely used one, including in industrial applications, is the FastICA algorithm, developed by Hyvärinen and Oja, which uses the negentropy as cost function.[22] Other examples are rather related to blind source separation where a more general approach is used. For example, one can drop the independence assumption and separate mutually correlated signals, thus, statistically "dependent" signals. Sepp Hochreiter and Jürgen Schmidhuber showed how to obtain non-linear ICA or source separation as a by-product of regularization (1999).[23] Their method does not require a priori knowledge about the number of independent sources.

Applications

ICA can be extended to analyze non-physical signals. For instance, ICA has been applied to discover discussion topics on a bag of news list archives.

Some ICA applications are listed below:[4]

- optical Imaging of neurons[24]

- neuronal spike sorting[25]

- face recognition[26]

- modelling receptive fields of primary visual neurons[27]

- predicting stock market prices[28]

- mobile phone communications[29]

- colour based detection of the ripeness of tomatoes[30]

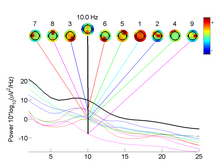

- removing artifacts, such as eye blinks, from EEG data.[31]

- predicting decision-making using EEG[32]

- analysis of changes in gene expression over time in single cell RNA-sequencing experiments.[33]

- studies of the resting state network of the brain.[34]

- astronomy and cosmology[35]

- finance[36]

Availability

ICA can be applied through the following software:

- SAS PROC ICA

- Scikit-learn Python implementation sklearn.decomposition.FastICA

See also

Notes

- ^ "Independent Component Analysis: A Demo".

- ^ Hyvärinen, Aapo (2013). "Independent component analysis: recent advances". Philosophical Transactions: Mathematical, Physical and Engineering Sciences. 371 (1984): 20110534. Bibcode:2012RSPTA.37110534H. doi:10.1098/rsta.2011.0534. ISSN 1364-503X. JSTOR 41739975. PMC 3538438. PMID 23277597.

- ^ Isomura, Takuya; Toyoizumi, Taro (2016). "A local learning rule for independent component analysis". Scientific Reports. 6: 28073. Bibcode:2016NatSR...628073I. doi:10.1038/srep28073. PMC 4914970. PMID 27323661.

- ^ a b Stone, James V. (2004). Independent component analysis : a tutorial introduction. Cambridge, Massachusetts: MIT Press. ISBN 978-0-262-69315-8.

- ^ Hyvärinen, Aapo; Karhunen, Juha; Oja, Erkki (2001). Independent component analysis (1st ed.). New York: John Wiley & Sons. ISBN 978-0-471-22131-9.

- ^ Johan Himbergand Aapo Hyvärinen, Independent Component Analysis For Binary Data: An Experimental Study, Proc. Int. Workshop on Independent Component Analysis and Blind Signal Separation (ICA2001), San Diego, California, 2001.

- ^ Huy Nguyen and Rong Zheng, Binary Independent Component Analysis With or Mixtures, IEEE Transactions on Signal Processing, Vol. 59, Issue 7. (July 2011), pp. 3168–3181.

- ^ Painsky, Amichai; Rosset, Saharon; Feder, Meir (2014). Generalized Binary Independent Component Analysis. IEEE International Symposium on Information Theory (ISIT), 2014. pp. 1326–1330. doi:10.1109/ISIT.2014.6875048. ISBN 978-1-4799-5186-4. S2CID 18579555.

- ^ James V. Stone(2004); "Independent Component Analysis: A Tutorial Introduction", The MIT Press Cambridge, Massachusetts, London, England; ISBN 0-262-69315-1

- ^ Kruskal, JB. 1969; "Toward a practical method which helps uncover the structure of a set of observations by finding the line transformation which optimizes a new "index of condensation", Pages 427–440 of: Milton, RC, & Nelder, JA (eds), Statistical computation; New York, Academic Press

- ^ a b c Pierre Comon (1994) Independent component analysis, a new concept? http://www.ece.ucsb.edu/wcsl/courses/ECE594/594C_F10Madhow/comon94.pdf

- ^ Hyvärinen, Aapo; Erkki Oja (2000). "Independent Component Analysis:Algorithms and Applications". Neural Networks. 4-5. 13 (4–5): 411–430. CiteSeerX 10.1.1.79.7003. doi:10.1016/s0893-6080(00)00026-5. PMID 10946390.

- ^ a b P.Comon, Independent Component Analysis, Workshop on Higher-Order Statistics, July 1991, republished in J-L. Lacoume, editor, Higher Order Statistics, pp. 29-38. Elsevier, Amsterdam, London, 1992. HAL link

- ^ Hyvärinen, Aapo; Karhunen, Juha; Oja, Erkki (2001). Independent component analysis (Reprint ed.). New York, NY: Wiley. ISBN 978-0-471-40540-5.

- ^ Hyvärinen, Aapo (1998). "New approximations of differential entropy for independent component analysis and projection pursuit". Advances in Neural Information Processing Systems. 10: 273–279.

- ^ Bell, A. J.; Sejnowski, T. J. (1995). "An Information-Maximization Approach to Blind Separation and Blind Deconvolution", Neural Computation, 7, 1129-1159

- ^ a b James V. Stone (2004). "Independent Component Analysis: A Tutorial Introduction", The MIT Press Cambridge, Massachusetts, London, England; ISBN 0-262-69315-1

- ^ Hérault, J.; Ans, B. (1984). "Réseau de neurones à synapses modifiables : Décodage de messages sensoriels composites par apprentissage non supervisé et permanent". Comptes Rendus de l'Académie des Sciences, Série III. 299: 525–528.

- ^ Ans, B., Hérault, J., & Jutten, C. (1985). Architectures neuromimétiques adaptatives : Détection de primitives. Cognitiva 85 (Vol. 2, pp. 593-597). Paris: CESTA.

- ^ Hérault, J., Jutten, C., & Ans, B. (1985). Détection de grandeurs primitives dans un message composite par une architecture de calcul neuromimétique en apprentissage non supervisé. Proceedings of the 10th Workshop Traitement du signal et ses applications (Vol. 2, pp. 1017-1022). Nice (France): GRETSI.

- ^ Hérault, J., & Jutten, C. (1986). Space or time adaptive signal processing by neural networks models. Intern. Conf. on Neural Networks for Computing (pp. 206-211). Snowbird (Utah, USA).

- ^ Hyvärinen, A.; Oja, E. (2000-06-01). "Independent component analysis: algorithms and applications". Neural Networks. 13 (4): 411–430. doi:10.1016/S0893-6080(00)00026-5. ISSN 0893-6080. PMID 10946390.

- ^ Hochreiter, Sepp; Schmidhuber, Jürgen (1999). "Feature Extraction Through LOCOCODE" (PDF). Neural Computation. 11 (3): 679–714. doi:10.1162/089976699300016629. ISSN 0899-7667. PMID 10085426. S2CID 1642107. Retrieved 24 February 2018.

- ^ Brown, GD; Yamada,S; Sejnowski, TJ (2001). "Independent components analysis at the neural cocktail party". Trends in Neurosciences. 24 (1): 54–63. doi:10.1016/s0166-2236(00)01683-0. PMID 11163888. S2CID 511254.

- ^ Lewicki, MS (1998). "Areview of methods for spike sorting: detection and classification of neural action potentials". Network: Computation in Neural Systems. 9 (4): 53–78. doi:10.1088/0954-898X_9_4_001. S2CID 10290908.

- ^ Barlett, MS (2001). Face image analysis by unsupervised learning. Boston: Kluwer International Series on Engineering and Computer Science.

- ^ Bell, AJ; Sejnowski, TJ (1997). "The independent components of natural scenes are edge filters". Vision Research. 37 (23): 3327–3338. doi:10.1016/s0042-6989(97)00121-1. PMC 2882863. PMID 9425547.

- ^ Back, AD; Weigend, AS (1997). "A first application of independent component analysis to extracting structure from stock returns". International Journal of Neural Systems. 8 (4): 473–484. doi:10.1142/s0129065797000458. PMID 9730022. S2CID 872703.

- ^ Hyvarinen, A, Karhunen,J & Oja,E (2001a). Independent component analysis. New York: John Wiley and Sons.

- ^ Polder, G; van der Heijen, FWAM (2003). "Estimation of compound distribution in spectral images of tomatoes using independent component analysis". Austrian Computer Society: 57–64.

- ^ Delorme, A; Sejnowski, T; Makeig, S (2007). "Enhanced detection of artifacts in EEG data using higher-order statistics and independent component analysis". NeuroImage. 34 (4): 1443–1449. doi:10.1016/j.neuroimage.2006.11.004. PMC 2895624. PMID 17188898.

- ^ Douglas, P (2013). "Single trial decoding of belief decision making from EEG and fMRI data using independent components features". Frontiers in Human Neuroscience. 7: 392. doi:10.3389/fnhum.2013.00392. PMC 3728485. PMID 23914164.

- ^ Trapnell, C; Cacchiarelli, D; Grimsby, J (2014). "The dynamics and regulators of cell fate decisions are revealed by pseudotemporal ordering of single cells". Nature Biotechnology. 32 (4): 381–386. doi:10.1038/nbt.2859. PMC 4122333. PMID 24658644.

- ^ Kiviniemi, Vesa J.; Kantola, Juha-Heikki; Jauhiainen, Jukka; Hyvärinen, Aapo; Tervonen, Osmo (2003). "Independent component analysis of nondeterministic fMRI signal sources". NeuroImage. 19 (2): 253–260. doi:10.1016/S1053-8119(03)00097-1. PMID 12814576. S2CID 17110486.

- ^ Wang, Jingying; Xu, Haiguang; Gu, Junhua; An, Tao; Cui, Haijuan; Li, Jianxun; Zhang, Zhongli; Zheng, Qian; Wu, Xiang-Ping (2010-11-01). "How to Identify and Separate Bright Galaxy Clusters from the Low-frequency Radio Sky?". The Astrophysical Journal. 723 (1): 620–633. arXiv:1008.3391. Bibcode:2010ApJ...723..620W. doi:10.1088/0004-637X/723/1/620. ISSN 0004-637X.

- ^ Moraux, Franck; Villa, Christophe (2003). "The dynamics of the term structure of interest rates: an Independent Component Analysis". Connectionist Approaches in Economics and Management Sciences: 215–232. doi:10.1007/978-1-4757-3722-6_11. ISBN 978-1-4757-3722-6.

References

- Comon, Pierre (1994): "Independent Component Analysis: a new concept?", Signal Processing, 36(3):287–314 (The original paper describing the concept of ICA)

- Hyvärinen, A.; Karhunen, J.; Oja, E. (2001): Independent Component Analysis, New York: Wiley, ISBN 978-0-471-40540-5 ( Introductory chapter )

- Hyvärinen, A.; Oja, E. (2000): "Independent Component Analysis: Algorithms and Application", Neural Networks, 13(4-5):411-430. (Technical but pedagogical introduction).

- Comon, P.; Jutten C., (2010): Handbook of Blind Source Separation, Independent Component Analysis and Applications. Academic Press, Oxford UK. ISBN 978-0-12-374726-6

- Lee, T.-W. (1998): Independent component analysis: Theory and applications, Boston, Mass: Kluwer Academic Publishers, ISBN 0-7923-8261-7

- Acharyya, Ranjan (2008): A New Approach for Blind Source Separation of Convolutive Sources - Wavelet Based Separation Using Shrinkage Function ISBN 3-639-07797-0 ISBN 978-3639077971 (this book focuses on unsupervised learning with Blind Source Separation)

External links

- What is independent component analysis? by Aapo Hyvärinen

- Independent Component Analysis: A Tutorial by Aapo Hyvärinen

- A Tutorial on Independent Component Analysis

- FastICA as a package for Matlab, in R language, C++

- ICALAB Toolboxes for Matlab, developed at RIKEN

- High Performance Signal Analysis Toolkit provides C++ implementations of FastICA and Infomax

- ICA toolbox Matlab tools for ICA with Bell-Sejnowski, Molgedey-Schuster and mean field ICA. Developed at DTU.

- Demonstration of the cocktail party problem

- EEGLAB Toolbox ICA of EEG for Matlab, developed at UCSD.

- FMRLAB Toolbox ICA of fMRI for Matlab, developed at UCSD

- MELODIC, part of the FMRIB Software Library.

- Discussion of ICA used in a biomedical shape-representation context

- FastICA, CuBICA, JADE and TDSEP algorithm for Python and more...

- Group ICA Toolbox and Fusion ICA Toolbox

- Tutorial: Using ICA for cleaning EEG signals

배치할 수 있습니다.고려해야 할 중요한 점은 N개의

배치할 수 있습니다.고려해야 할 중요한 점은 N개의

(를)

(를)  의해 측정되는 최대 독립

의해 측정되는 최대 독립

혼합

혼합

i번째 소스로부터의 신호가 j번째 모니터에 의해 관찰될 수 있음을 나타냅니다.시스템은 다음과 같이 동작합니다.

i번째 소스로부터의 신호가 j번째 모니터에 의해 관찰될 수 있음을 나타냅니다.시스템은 다음과 같이 동작합니다. 활성화되어 있고(

활성화되어 있고(

Boolean AND,

Boolean AND,  Boolean OR입니다.소음은 명시적으로 모델링되지 않고 독립적인 선원으로 취급할 수 있다.

Boolean OR입니다.소음은 명시적으로 모델링되지 않고 독립적인 선원으로 취급할 수 있다.  하위 행렬로 재귀적으로 분할하고 이러한 하위 행렬에 대해 추론 알고리즘을 실행합니다.이 알고리즘으로 이어지는 주요 관찰은 X

하위 행렬로 재귀적으로 분할하고 이러한 하위 행렬에 대해 추론 알고리즘을 실행합니다.이 알고리즘으로 이어지는 주요 관찰은 X .

.

![K=\frac{\operatorname{E}[(\mathbf{y}-\mathbf{\overline{y}})^4]}{(\operatorname{E}[(\mathbf{y}-\mathbf{\overline{y}})^2])^2}-3](https://wikimedia.org/api/rest_v1/media/math/render/svg/f2ed7961602e0ea393c9890f132b5352d4a0cc84)

첨도를 확인할 수

첨도를 확인할 수

원점을 중심으로 회전함에 따라 변화합니다.각 소스

원점을 중심으로 회전함에 따라 변화합니다.각 소스

단위 분산을 갖는 새로운

단위 분산을 갖는 새로운

![\operatorname{E}[(\mathbf{w}^T \mathbf{z})^2]=1](https://wikimedia.org/api/rest_v1/media/math/render/svg/9f29c4655db008f7c5eaa5ead02b3e2405c0a8df)

![K=\frac{\operatorname{E}[\mathbf{y}^4]}{(\operatorname{E}[\mathbf{y}^2])^2}-3=\operatorname{E}[(\mathbf{w}^T \mathbf{z})^4]-3.](https://wikimedia.org/api/rest_v1/media/math/render/svg/28060dbc6e2d065bcf18f3b40c8a6bf2572df31f)

![\mathbf{w}_{new}=\mathbf{w}_{old}-\eta\operatorname{E}[\mathbf{z}(\mathbf{w}_{old}^T \mathbf{z})^3 ].](https://wikimedia.org/api/rest_v1/media/math/render/svg/430c12e076a4db6617c2323ff75901ad19b805ec)

w

w

선택할 수 있습니다.

선택할 수 있습니다.

구한다.

구한다.

W {\displaystyle \

W {\displaystyle \ 독립적입니다.

독립적입니다. 추출된

추출된

조인트 엔트로피를 최대화하면 x 사이의

조인트 엔트로피를 최대화하면 x 사이의

다변수 형식으로 추출된 신호의 합동

다변수 형식으로 추출된 신호의 합동

최대화됨을 알 수 있습니다.부터

최대화됨을 알 수 있습니다.부터

혼합하지

혼합하지