음성학

Phonetics| 에 관한 시리즈의 일부 | ||||||

| 음성학 | ||||||

|---|---|---|---|---|---|---|

| 언어학 시리즈의 일부 | ||||||

| 하위분야 | ||||||

| 아티큘레이션 | ||||||

| ||||||

| 음향학 | ||||||

| ||||||

| 지각 | ||||||

| ||||||

| 언어학 포털 | ||||||

| 에 관한 시리즈의 일부 |

| 언어학 |

|---|

| |

음성학은 인간이 소리를 생산하고 인식하는 방법이나 수화의 경우 수화의 동등한 측면을 연구하는 언어학의 한 분야입니다.[1] 언어학자들은 언어의 물리적 특성을 전문적으로 연구합니다. 음성학 분야는 전통적으로 인간이 어떻게 음성을 생산하기 위한 움직임을 계획하고 실행하는지와 같은 관련된 연구 질문에 따라 세 가지 하위 분야로 구분되며, 다양한 움직임이 결과적인 소리의 속성에 어떤 영향을 미치는지(acoustic 음성학) 또는 인간이 음파를 언어 정보로 변환하는 방법(auditory 음성학). 전통적으로 음소의 최소 언어 단위는 음소의 음운 단위와 다른 언어의 말소리인 전화입니다. 음소는 전화를 추상적으로 분류한 것이며 특정 언어의 소리를 구별하는 가장 작은 단위로 정의됩니다.[2]

음성학은 인간의 발화의 두 가지 측면을 다룹니다: 인간이 소리를 내는 방식인 생산과 음성이 이해되는 방식인 지각입니다. 언어의 의사소통 방식은 언어가 언어를 생성하고 인식하는 방법을 설명합니다. 영어와 같은 구어-음성 양식을 가진 언어는 구어(입을 사용하여) 음성을 생성하고 음성을 청각적으로(귀를 사용하여) 인식합니다. 호주 수화(Auslan) 및 미국 수화(ASL)와 같은 수화는 수동 시각적 양식을 가지고 있으며, 수동으로(손을 사용하여) 음성을 생성하고 시각적으로(눈을 사용하여) 음성을 인식합니다. ASL과 일부 수화에는 청각 장애인 화자가 촉각 서명에 사용할 수 있는 수동-수동 방언이 추가되어 있는데, 이 방언에서는 수화가 손으로 생성되고 손으로 인식됩니다.

언어 생산은 언어가 아닌 메시지를 발화 또는 서명된 언어 신호로 변환하는 여러 상호 의존적인 과정으로 구성됩니다. 언어적으로 인코딩될 메시지를 식별한 후, 화자는 어휘 선택이라고 하는 프로세스에서 해당 메시지를 표현할 개별 단어( 어휘 항목)를 선택해야 합니다. 음운 부호화 중 단어의 정신적 표현은 생성될 음소의 시퀀스로 단어의 음운 내용이 할당됩니다. 음소는 닫힌 입술이나 특정 위치의 혀와 같은 특정 목표를 나타내는 조음 특징에 대해 지정됩니다. 그런 다음 이러한 음소는 근육으로 보낼 수 있는 일련의 근육 명령으로 조정되고 이러한 명령이 적절하게 실행되면 의도된 소리가 생성됩니다.

이러한 움직임은 공기 흐름을 방해하고 수정하여 음파를 발생시킵니다. 수정은 아티큘레이터에 의해 이루어지며, 아티큘레이션의 장소와 방식은 다른 음향 결과를 생성합니다. 예를 들어, 택(tack)과 자루(sack)라는 단어는 모두 영어의 치조 소리로 시작하지만 혀가 치조 능선에서 얼마나 멀리 떨어져 있는지에 따라 다릅니다. 이 차이는 공기 흐름과 생성되는 소리에 큰 영향을 미칩니다. 마찬가지로, 공기 흐름의 방향과 소스는 소리에 영향을 미칠 수 있습니다. 가장 일반적인 공기 흐름 메커니즘은 폐를 사용하는 폐색성 폐색이지만 성문과 혀는 공기 흐름을 생성하는 데 사용될 수도 있습니다.

언어 지각은 언어적 신호가 청자에 의해 해독되고 이해되는 과정입니다. 음성을 인식하려면 연속 음향 신호를 음소, 형태소 및 단어와 같은 개별 언어 단위로 변환해야 합니다. 청취자는 소리를 정확하게 식별하고 분류하기 위해 언어 범주를 안정적으로 구별할 수 있는 신호의 특정 측면을 우선시합니다. 특정 신호가 다른 신호보다 우선시되지만 신호의 여러 측면이 지각에 기여할 수 있습니다. 예를 들어, 구두 언어가 음향 정보를 우선시하지만, McGurk 효과는 음향 신호가 신뢰할 수 없을 때 시각 정보가 모호한 정보를 구별하는 데 사용된다는 것을 보여줍니다.

현대 음성학에는 세 가지 갈래가 있습니다.

- 아티큘레이터로 소리를 내는 방식을 다루는 아티큘레이터 음성학.

- 다양한 아티큘레이션의 음향 결과를 다루는 음향 음성학.

- 청각 음성학은 청취자가 언어 신호를 인식하고 이해하는 방식을 다룹니다.

역사

고대

최초로 알려진 음성학 연구는 일찍이 기원전 6세기에 산스크리트 문법학자들에 의해 수행되었습니다.[3] 힌두교 학자 파 ṇ니(Pá ṇini)는 이러한 초기 조사자들 중 가장 잘 알려진 사람들 중 한 명입니다. 기원전 350년경에 쓰여진 그의 4부 문법은 현대 언어학에서 영향력이 있으며 여전히 "지금까지 쓰여진 언어 중 가장 완전한 생성 문법"을 나타냅니다.[4] 그의 문법은 현대 언어학의 기초를 형성했고 목소리를 내는 것을 포함한 몇 가지 중요한 음성 원리를 설명했습니다. 이 초기 설명은 공명이 성악 주름이 닫힐 때 음색에 의해 생성되거나 성악 주름이 열릴 때 소음에 의해 생성된다고 설명했습니다. 문법의 음성학적 원리는 이론적 분석의 대상 그 자체라기보다는 그의 이론적 분석의 기초가 된다는 점에서 '원형'으로 여겨지며, 그의 음운론 체계에서 그 원리를 유추할 수 있습니다.[5]

산스크리트어로 음성학을 연구하는 것은 쉬샤(Shiksha)라고 불립니다. 기원전 1,000년경의 타이티리야 우파니샤드는 칙샤를 다음과 같이 정의하고 있습니다.

아! 식샤에 대해 설명해드리겠습니다.

소리와 억양, (모음의) 양과 (자음의) 표현,

(사만)과 연결 (소리의) 균형, 식샤 연구에 대한 많은 것. 1

Taittiriya Uphanish는 1.2, Shikshavalli, Paul Deussen[6] 번역.

현대의

파 ṇ니와 그의 동시대 이후 음성학의 발전은 그리스와 로마 문법학자들의 제한된 조사를 제외하고는 현대까지 제한적이었습니다. indic 문법학자들과 현대 음성학자들 사이의 천년을 맞이하면서, Pā ṇini가 설명하게 된 원동력이었던 구어와 문자 언어의 차이에서 중심이 옮겨졌고, 음성의 물리적 속성에만 집중하기 시작했습니다. 음성학에 대한 지속적인 관심은 1841년 현재의 의미로 "음성학"이라는 용어가 처음 사용되면서 서기 1800년경에 다시 시작되었습니다.[7][3] 의학의 새로운 발전과 오디오 및 시각 녹음 장치의 발전으로 음성학적 통찰력은 새롭고 더 상세한 데이터를 사용하고 검토할 수 있었습니다. 이 현대 음성학의 초기 시기에는 알렉산더 멜빌 벨(Alexander Melville Bell)의 조음 위치에 기반한 영향력 있는 음성 문자의 개발이 포함되었습니다. 보이는 말로 알려져 있는 청각 장애 아동의 구강 교육에서 도구로 두각을 나타냈습니다.[3]

음성학자들은 음성학자들 사이에서 전사와 발견이 일관되게 이루어질 수 있도록 하기 위해 실용적인 음성학의 전통에 크게 의존했습니다. 이 훈련은 소리를 내는 능력뿐만 아니라 말소리를 인식하는 귀 훈련과 제작 훈련을 모두 포함했습니다. 음성학자들은 국제 음성 알파벳의 다양한 소리를 귀로 인식하는 법을 배울 것으로 기대되었고 IPA는 여전히 화자들이 영어의 음성 패턴을 정확하게 생성하는 능력을 테스트하고 인증합니다(다른 언어의 경우 이 연습을 중단했지만).[8] 멜빌 벨(Melville Bell)은 눈에 보이는 말하기 방법을 수정하여 9개의 기수 모음을 만들어내는 키와 배경에 따른 모음 설명을 개발했습니다.[9] 실용 음성학 교육의 일환으로, 음성학자들은 현장 작업 중에 이러한 전화기에 대한 인식과 전사를 고정시키기 위해 이러한 기본 모음을 생성하는 법을 배울 것으로 예상되었습니다.[8] 이 접근법은 1960년대에 피터 라데포그(Peter Ladefogg)가 기악 모음이 조음 표적이 아닌 청각 표적이라는 실험적 증거를 기반으로 비판하여 음성학자가 다른 조음을 판단할 수 있는 조음 앵커를 나타낸다는 주장에 이의를 제기했습니다.[10]

생산.

언어 생산은 비언어적 메시지를 발화 또는 서명된 언어 신호로 변환하는 여러 상호 의존적 과정으로 구성됩니다. 언어학자들은 언어 생산 과정이 일련의 단계(직렬 처리)에서 발생하는지, 생산 과정이 병렬적으로 발생하는지에 대해 논쟁합니다. 언어적으로 인코딩될 메시지를 식별한 후, 화자는 어휘 선택이라고 하는 프로세스에서 해당 메시지를 표현할 개별 단어( 어휘 항목)를 선택해야 합니다. 단어들은 언어학에서 의미 정보라고 불리는 의미를 기반으로 선택됩니다. 어휘 선택은 단어에 대한 의미론적 정보와 문법적 정보를 모두 포함하는 단어의 보조정리를 활성화합니다.[11][a]

발화가 계획된 [b]후 음성학적 인코딩을 거칩니다. 언어 생산의 이 단계에서, 단어들의 정신적 표현은 그들의 음운적 내용을 생산될 음소들의 시퀀스로 할당됩니다. 음소는 닫힌 입술이나 특정 위치의 혀와 같은 특정 목표를 나타내는 조음 특징에 대해 지정됩니다. 그런 다음 이러한 음소는 근육으로 보낼 수 있는 일련의 근육 명령으로 조정되고 이러한 명령이 제대로 실행되면 의도된 소리가 생성됩니다.[13] 따라서 메시지에서 소리로 생산되는 과정은 다음과 같이 요약할 수 있습니다.[c]

- 메시지 계획

- 보조정리선택

- 음운 단어 형태 검색 및 할당

- 아티큘레이션 사양

- 근령

- 아티큘레이션

- 말소리

조음지

성대의 전체 또는 부분적인 수축에 의해 만들어지는 소리를 자음이라고 합니다. 자음은 성대, 보통 입에서 발음되는데, 이 수축의 위치가 결과적인 소리에 영향을 미칩니다. 혀의 위치와 그로 인한 소리 사이의 밀접한 연관성 때문에, 관절의 위치는 음성학의 많은 하위 분야에서 중요한 개념입니다.

소리는 수축의 위치와 수축을 하는 신체의 부분에 따라 부분적으로 분류됩니다. 예를 들어, 영어에서 싸움과 생각이라는 단어는 건축물의 위치보다는 건축물을 만드는 기관에서만 다른 최소 쌍입니다. 싸움에서 "f"는 아래 입술을 치아에 대고 만든 입술 관절입니다. 생각의 "th"는 혀를 이빨에 대고 만드는 언어 치아 관절입니다. 입술이 수축하는 것을 입술이라고 하고 혀로 하는 것을 혀라고 합니다.

혀로 하는 수축은 성대의 여러 부분에서 이루어질 수 있으며, 크게 관상, 등쪽, 근치적인 관절 부위로 분류됩니다. 관상동맥은 혀의 앞쪽으로, 등쪽 관절은 혀의 뒤쪽으로, 근치 관절은 인두에서 만들어집니다.[14] 이러한 구분은 모든 말소리를 구별하고 설명하는 데 충분하지 않습니다.[14] 예를 들어, 영어에서 소리 [s]와 [ʃ]는 둘 다 코로나이지만 입 안의 다른 위치에서 만들어집니다. 이를 설명하기 위해서는 협착이 발생하는 입의 면적을 기준으로 보다 세밀한 관절 부위가 필요합니다.[15]

라비알

입술과 관련된 관절은 세 가지 다른 방법으로 만들어질 수 있습니다: 양 입술(양쪽 입술), 한쪽 입술과 치아로, 그래서 그들은 아래쪽 입술은 능동 관절기, 위쪽 치아는 수동 관절기[16], 그리고 혀와 위쪽 입술(언어 입술).[17] 사용되는 정의에 따라 이러한 종류의 관절 중 일부 또는 전부는 입술 관절의 클래스로 분류될 수 있습니다. 쌍자음은 두 입술로 만들어집니다. 이러한 소리를 내는 데 있어 아랫입술은 윗입술을 만나기 위해 가장 멀리 움직이며, 이 또한 약간 아래로 내려가기도 하지만,[18] 어떤 경우에는 개구(입술 사이의 개구)를 통해 이동하는 공기의 힘으로 인해 입술이 서로 합쳐질 수 있는 것보다 더 빨리 분리될 수 있습니다.[19] 대부분의 다른 관절과 달리 두 관절 모두 연조직으로 만들어지며 치아나 구개와 같은 단단한 표면을 포함하는 관절보다 불완전한 폐쇄로 인해 관절 정지가 발생할 가능성이 높습니다. 양악 정지는 또한 상부 입술이 아래쪽으로 약간의 활발한 움직임을 보이기 때문에 성대의 상부 부분에 있는 아티큘레이터가 아래쪽으로 활발하게 이동한다는 점에서 특이합니다.[20] 언어 자음은 혀의 날이 윗입술에 접근하거나 접촉하면서 만들어집니다. 양악 관절에서와 마찬가지로 윗입술은 더 활동적인 관절을 향해 약간 움직입니다. 이 그룹의 아티큘레이션은 국제 음성 알파벳에 고유한 기호가 없으며, 오히려 정점 기호와 관상 범주에 암시적으로 배치하는 디아크리틱을 결합하여 형성됩니다.[21][22] 그들은 탕고아와 같은 바누아투 고유의 여러 언어에 존재합니다.

입술 아래쪽 입술이 윗니까지 올라오면서 입술 아래쪽 자음이 만들어집니다. 순치 자음은 마찰음이 가장 많은 반면 순치 자음은 유형적으로 일반적입니다.[23] 줄루어,[25] 통가어,[26] 슈비어를 포함한 많은 언어들이 순치증을 가지고 있다고 보고되고 있지만,[24] 어떤 자연어에서도 진정한 순치증이 발생하는지에 대해서는 논쟁이 있습니다.[24]

코로날

관상자음은 혀끝이나 날로 만들어지며, 혀 앞부분의 순발력 때문에 제자리뿐만 아니라 혀의 자세에서도 다양하게 표현됩니다. 관상 관절의 위치는 혀가 닿거나 수축하는 입의 영역을 나타내며 치아, 치조, 치조 후 위치를 포함합니다. 혀끝을 이용한 혀자세는 혀끝을 이용하면 정점이 될 수 있고, 혀끝을 이용하면 라미날이 될 수 있으며, 혀끝을 뒤로 말아서 혀밑을 이용하면 아정점이 될 수 있습니다. 코로나는 모든 방식의 아티큘레이션이 증명된다는 점에서 그룹으로서 독특합니다.[21][27] 호주의 언어들은 그 지역의 언어들 내에서 그리고 그 지역의 언어들 사이에서 나타나는 많은 수의 코로나 대조들로 잘 알려져 있습니다.[28] 치아 자음은 혀의 끝이나 날, 윗니로 만들어집니다. 혀의 부위에 따라 두 그룹으로 나뉘는데, 정단치자음은 혀끝이 치아에 닿아 있고, 치간자음은 혀끝이 치아 앞으로 튀어나오면서 혀끝이 나와 있습니다. 이 두 가지 언어가 서로 대조적으로 사용되는 것은 알려져 있지 않지만, 이 두 가지 언어가 모두 동음이의어로 존재할 수도 있습니다. 치조 자음은 치아 바로 뒤 치조능선에서 혀끝이나 날을 이용하여 만들어지며, 이와 유사하게 정단부 또는 측두부가 될 수 있습니다.[29]

치과용 자음과 치조용 자음은 교차 언어학적으로 자주 대조되어 교차 언어 패턴의 여러 가지 일반화로 이어집니다. 관절의 다른 위치는 그것들을 생산하는 데 사용되는 혀의 부분에서도 대조되는 경향이 있습니다: 치아 멈춤이 있는 대부분의 언어는 치관이 있는 반면, 정점 멈춤이 있는 언어는 일반적으로 정점 멈춤이 있습니다. 타아(Taa, ǃ Xó õ)가 이 패턴의 반례이긴 하지만, 언어들은 같은 장소에 두 개의 자음이 있는 경우가 거의 없습니다. 한 언어에 치과용 스톱 또는 치조용 스톱 중 하나만 있는 경우 치과용 스톱이면 일반적으로 라미날(laminal)이고, 치조용 스톱이면 일반적으로 스톱이 정점이지만, 예를 들어 Temne과 불가리아어는[31] 이 패턴을 따르지 않습니다.[32] 한 언어에 정점과 측두음이 모두 있는 경우 측두음은 이소코처럼 마찰될 가능성이 더 높지만, 다할로는 폐포음이 더 마찰되는 반대 패턴을 보여줍니다.[33]

레트로플렉스 자음은 혀의 위치나 입천장의 위치에 따라 몇 가지 다른 정의가 있습니다. 일반적으로 혀 끝이 어느 정도 위로 말려 있는 관절의 그룹을 나타냅니다. 이러한 방식으로 폐포, 폐포 후 및 구순 부위를 포함한 입천장의 여러 다른 위치에서 역굴절 관절이 발생할 수 있습니다. 혀끝의 아래쪽이 입천장에 닿으면 정점 아래쪽이지만, 정점 후 소리도 역행성으로 설명됩니다.[34] 아첨가 역굴절 정지의 전형적인 예는 드라비다어족 언어에서 흔히 발견되며, 미국 남서부에 고유한 일부 언어에서 치과용 정지와 치조 정지의 대조적인 차이는 치조 정지의 약간 역굴절입니다.[35] 음향적으로, 역굴곡은 더 높은 조형물에 영향을 미치는 경향이 있습니다.[35]

치조능선 바로 뒤에서 일어나는 조음, 즉 치조후 자음은 여러 가지 다른 용어를 사용하여 언급되어 왔습니다. 정측두엽 후 자음은 종종 레트로플렉스(retroflex)라고 불리는 반면, 박음질은 때때로 구개음(palato-alveolar)이라고 불립니다.[36] 호주주의 문헌에서 이러한 박음질 정지는 일반적으로 구개음으로 설명되는 미각 영역보다 더 앞으로 생성되지만 종종 '구개음'으로 설명됩니다.[28] 개개의 해부학적 변화로 인해, 구개-폐포 정지(및 일반적으로 관상)의 정확한 관절은 음성 커뮤니티 내에서 매우 다양할 수 있습니다.[37]

등쪽

등자음은 혀의 끝이나 날이 아닌 혀의 몸통을 이용하여 만든 자음으로, 일반적으로 입천장, 종아리 또는 우불라에서 만들어집니다. 입천장에 있는 경구개에 대항하여 혀의 몸통을 이용하여 구개음을 만듭니다. 이들은 벨라 자음이나 자음 자음과 자주 대조되지만, 자카루와 같이 세 가지를 동시에 대조하는 언어는 드문 경우입니다.[38] 벨러 자음은 혀의 몸통을 벨럼에 대고 만들어 집니다. 거의 모든 언어에는 벨라 스톱이 있습니다. 벨러와 모음 모두 혀의 몸통을 이용하여 만들기 때문에 모음과의 협착에 영향을 많이 받아 경구개까지 앞으로, 또는 우불라까지 뒤로 생성될 수 있습니다. 이러한 변형은 일반적으로 모음 공간과 평행하게 앞, 중앙, 뒤 벨러로 나뉩니다.[39] 그것들은 전형적인 구개 자음의 영역보다 약간 뒤에서 생성되지만 음성적으로 구개 자음과 구별하기 어려울 수 있습니다.[40] 자음은 혀의 몸이 자음에 접촉하거나 접근하여 만들어집니다. 그들은 희귀하며, 약 19 퍼센트의 언어에서 발생하며, 아메리카와 아프리카의 넓은 지역에는 자음이 있는 언어가 없습니다. 자음이 있는 언어에서는 중단이 가장 많고 연속체(나선 포함)가 뒤를 이습니다.[41]

Pharyngeal and laryngeal

목의 수축으로 만들어지는 자음은 인두, 후두의 수축으로 만들어지는 자음은 후두입니다. 후두는 목 아래로 너무 멀리 떨어져 있어 혀로 닿을 수 없기 때문에 성대 주름을 이용하여 후두를 만듭니다. 그러나 인두는 혀의 일부가 도달할 수 있을 정도로 입에 가깝습니다.

라디칼 자음은 제작 과정에서 혀의 뿌리나 후두부를 사용하며, 성대에서 아주 멀리 떨어진 곳에서 생성됩니다.[42] 인두 자음은 인두 벽에 거의 닿을 정도로 혀의 뿌리를 멀리 젖혀서 만듭니다. 생산상의 어려움으로 마찰재와 근사재만 이런 방식으로 생산할 수 있습니다.[43][44] 후두 자음은 후두와 인두의 뒷벽으로 만들어집니다. 후두부 정류장은 다할로에서 기록되었습니다.[44] 성문과 성문 사이의 공동이 너무 작아서 목소리를 낼 수 없기 때문에 유성 후두 자음은 가능하지 않은 것으로 간주됩니다.[45]

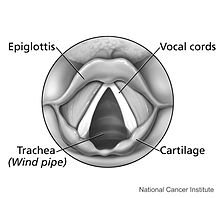

성문 자음은 후두의 성대 주름을 이용하여 생성되는 자음입니다. 발성주름은 음운의 근원이고 구강-비강의 아래에 있기 때문에 유성 성문정지와 같은 다수의 성문자음은 불가능합니다. 무성 성문 정지와 성문 마찰음 2개의 성문 자음 3개가 가능하며 모두 자연어로 증명됩니다.[21] 성대 주름을 닫아 생성되는 성문 정지는 세계 언어에서 특히 흔히 볼 수 있습니다.[45] 많은 언어가 구 경계를 획정하는 데 사용하지만 아랍어와 화틀라 마자텍과 같은 일부 언어는 구 경계를 대조적인 음소로 사용합니다. 또한 성문정지는 이 언어에서 다음 모음의 후두화로 실현될 수 있습니다.[46] 성문정지, 특히 모음 사이에서는 일반적으로 완전한 폐쇄를 형성하지 않습니다. 진정한 성문 정지는 일반적으로 보석으로 장식된 경우에만 발생합니다.[47]

후두부

흔히 "음성 상자"라고 알려진 후두는 음운을 담당하는 기관의 연골 구조입니다. 성대 주름(초드)은 진동하도록 함께 잡거나, 그렇지 않도록 따로 떼어놓습니다. 성대 주름의 위치는 관절 연골의 움직임에 의해 달성됩니다.[48] 내재된 후두 근육은 관절 연골을 움직이게 할 뿐만 아니라 성대 주름의 긴장을 조절하는 역할을 합니다.[49] 성대 주름이 충분히 가깝거나 긴장되지 않으면 산발적으로 진동하거나 전혀 진동하지 않습니다. 그들이 산발적으로 진동하면 정도에 따라 삐걱거리거나 숨소리가 나게 되고, 전혀 진동하지 않으면 무성음이 됩니다.

성대 주름을 올바르게 배치할 뿐만 아니라, 성대 주름을 가로질러 공기가 흐르게 해야 합니다. 그렇지 않으면 성대 주름이 진동하지 않습니다. 음성을 내기 위해 필요한 성문 전체의 압력 차이는 1~2cm HO2(98.0665 – 196.133파스칼)로 추정됩니다.[50] 압력 차는 성문 위의 압력 증가(초광각 압력) 또는 성문 아래의 압력 감소(초광각 압력)로 인해 축음에 필요한 수준 이하로 떨어질 수 있습니다. 성문하압은 호흡근에 의해 유지됩니다. 수축이나 관절이 없는 초자궁 압력은 대기압과 같습니다. 그러나 관절, 특히 자음은 공기 흐름의 수축을 나타내기 때문에 이러한 수축 뒤에 있는 공동의 압력이 증가하여 더 높은 위상 압력이 발생할 수 있습니다.[51]

어휘 접근

어휘 접근 모델에 따르면 두 가지 다른 인지 단계가 사용됩니다. 따라서 이 개념은 어휘 접근의 2단계 이론으로 알려져 있습니다. 첫 번째 단계인 어휘 선택은 기능 수준 표현을 구성하는 데 필요한 어휘 항목에 대한 정보를 제공합니다. 이 항목들은 특정한 의미론적, 통사론적 속성에 따라 검색되지만, 음운론적 형태는 아직 현 단계에서 사용할 수 없습니다. 두 번째 단계인 단어 형태 검색은 위치 수준 표현을 구축하는 데 필요한 정보를 제공합니다.[52]

아티큘레이션 모델

음성을 생성할 때, 아티큘레이터는 공간의 특정 위치를 이동하고 접촉하여 음향 신호에 변화를 일으킵니다. 일부 음성 생산 모델은 이것을 신체 내부(내재적) 또는 외부(외재적)일 수 있는 좌표계에서 아티큘레이션을 모델링하는 기초로 삼습니다. 고유 좌표계는 관절의 위치와 각도로 관절의 움직임을 모델링합니다. 턱의 고유 좌표 모델은 종종 병진과 회전을 나타내는 2~3개의 자유도를 사용합니다. 이들은 턱과 팔의 관절과 달리 관절이 없는 코끼리 몸통과 같은 근육질의 하이드로 스탯인 혀를 모델링하는 데 문제가 있습니다.[53] 생리적 구조가 다르기 때문에 혀의 움직임은 곡선을 따르지만, 언어와 저작 시 턱의 이동 경로는 비교적 직선입니다.[54]

직선 운동은 내재적 공간이 아닌 외재적 공간에서 계획된 대로 아티큘레이션을 주장하는 데 사용되었지만, 외재적 좌표 시스템에는 물리적 좌표 공간뿐만 아니라 음향 좌표 공간도 포함됩니다.[53] 외부 공간에서 움직임이 계획되어 있다고 가정하는 모델은 관찰된 경로 또는 음향 신호를 생성하는 근육 및 관절 위치를 설명하는 역 문제에 직면합니다. 예를 들어, 팔에는 7개의 자유도와 22개의 근육이 있으므로 여러 개의 다른 관절 및 근육 구성이 동일한 최종 위치로 이어질 수 있습니다. 외부 음향 공간에서 계획하는 모델의 경우 물리적 또는 음향 표적에서 이를 달성하는 데 필요한 근육 움직임에 대한 고유한 매핑이 없는 동일한 일대일 매핑 문제도 적용됩니다. 그러나 말은 목적을 위해 진화한 신경 구조를 사용하여 고도로 학습된 기술이기 때문에 역문제에 대한 우려는 과장될 수 있습니다.[55]

평형점 모델은 움직임 목표가 관절에 작용하는 근육 쌍의 위치로 표현된다고 주장함으로써 역 문제에 대한 해결책을 제안합니다.[d] 중요한 것은 근육이 스프링으로 모델링되고, 그 대상이 모델링된 스프링-질량 시스템의 평형점이라는 것입니다. 평형점 모델은 스프링을 사용하여 움직임이 중단되었을 때 쉽게 보상과 반응을 설명할 수 있습니다. 그들은 이러한 근육 위치가 근육의 스프링과 같은 작용이 수렴하는 공간의 점, 평형점으로 표현된다고 가정하기 때문에 좌표 모델로 간주됩니다.[56][57]

음성 생성에 대한 제스처 접근 방식은 관절이 특정 좌표가 아니라 움직임 패턴으로 표현된다는 것을 제안합니다. 최소 단위는 "기능적으로 동등한 조음 운동 패턴으로 주어진 음성 관련 목표(예: 양악 폐쇄)를 참조하여 능동적으로 제어되는" 그룹을 나타내는 제스처입니다.[58] 이 그룹은 움직임을 개별 근육 움직임이 아니라 단일 단위로 함께 작동하는 작업 의존적 근육 그룹으로 보는 조정 구조 또는 "시너지"를 나타냅니다.[59][60] 이는 추상 표현에서 특정 움직임을 인코딩하는 것이 아니라 발화 목표를 달성하는 모든 움직임을 허용하는 고유 좌표 모델의 문제인 발화 계획의 자유도를 줄입니다. 관절은 더 빠른 음성 속도의 관절이 더 느린 음성 속도의 독립적인 제스처의 합성물로 설명될 수 있기 때문에 제스처 모델에 의해 잘 설명됩니다.[61]

음향학

음성은 음파를 발생시키는 기류의 변형에 의해 만들어집니다. 수정은 아티큘레이터에 의해 이루어지며, 아티큘레이션의 장소와 방식은 다른 음향 결과를 생성합니다. 혀의 위치뿐만 아니라 성대의 자세가 결과적인 소리에 영향을 미칠 수 있기 때문에 발화 방식은 말소리를 설명하는 데 중요합니다. 택(tack)과 자루(sack)라는 단어는 모두 영어의 치조 소리로 시작하지만 혀가 치조 능선에서 얼마나 멀리 떨어져 있는지에 따라 다릅니다. 이 차이는 공기 흐름과 생성되는 소리에 큰 영향을 미칩니다. 마찬가지로, 공기 흐름의 방향과 소스는 소리에 영향을 미칠 수 있습니다. 가장 일반적인 공기 흐름 메커니즘은 폐를 사용하는 폐색성 폐색이지만 성문과 혀는 공기 흐름을 생성하는 데 사용될 수도 있습니다.

음성 및 음소 유형

음성 소리의 주요 차이점은 음성화 여부입니다. 소리는 음성화 과정에서 성대 주름이 진동하기 시작할 때 음성화됩니다. 물리적 제약으로 인해 일부 아티큘레이션에서 음소가 어렵거나 불가능할 수도 있지만, 많은 소리가 음소가 있거나 없는 상태에서 생성될 수 있습니다. 관절음이 울리면 주요 소음원은 발성 주름의 주기적인 진동입니다. 무성유음과 같은 아티큘레이션은 음향원이 없고 침묵으로 인해 눈에 띄지만, 마찰음과 같은 다른 무성음은 음소에 관계없이 고유한 음향원을 생성합니다.

음소는 후두의 근육에 의해 제어되며 언어는 이진 음성보다 더 음향적인 세부 사항을 사용합니다. 음소거 중에는 발성 주름이 일정한 속도로 진동합니다. 이 진동은 기본 주파수와 그 고조파로 구성된 주기적인 음향 파형을 생성합니다. 음향파의 기본 주파수는 후두의 근육을 조절하여 조절할 수 있으며, 청취자들은 이 기본 주파수를 음정으로 인식합니다. 언어는 음정 조작을 사용하여 어휘 정보를 성조 언어로 전달하고, 많은 언어가 음정을 사용하여 운율적이거나 실용적인 정보를 표시합니다.

성대 주름이 진동하려면 적절한 위치에 있어야 하고 성문을 통해 공기가 흘러야 합니다.[50] 음소 유형은 완전 개방(음성)에서 완전 폐쇄(영구 정지)에 이르는 성문 상태의 연속체를 모델로 합니다. 진동에 대한 최적의 위치, 그리고 음성에서 가장 많이 사용되는 음소 유형인 모달 음성은 이 두 극단의 중간에 존재합니다. 성문이 조금 넓으면 숨소리가 나오는 반면, 성대 주름이 가까워지면 삐걱거리는 목소리가 나옵니다.[62]

일반적인 음성에서 사용되는 일반적인 음소 패턴은 모달 음성으로, 보컬 주름이 적당한 긴장감과 함께 밀착되어 있습니다. 성대 주름은 완전한 성문 폐쇄와 흡인 없이 주기적이고 효율적으로 단일 유닛으로 진동합니다.[63] 더 멀리 당겨지면 진동하지 않기 때문에 무성 전화를 생성합니다. 단단히 고정되면 성문 정지가 발생합니다.[62]

발성 주름이 모달 목소리보다 약간 더 멀리 떨어져 있으면 숨소리(또는 웅얼거림)와 속삭이는 목소리와 같은 음소 유형을 생성합니다. 성대 인대(성대)를 가로지르는 장력은 모달 음성보다 작아 공기가 더 자유롭게 흐를 수 있습니다. 숨쉬는 목소리와 속삭이는 목소리는 모두 숨쉬는 목소리의 더 주기적인 파형에서 더 시끄러운 속삭이는 목소리의 파형으로 가는 것으로 느슨하게 특징지어지는 연속체에 존재합니다. 음향학적으로 둘 다 더 극단적인 편차를 보이는 속삭이는 목소리로 첫 번째 포맨트를 약화시키는 경향이 있습니다.

보컬 폴드를 더 단단히 붙이면 삐걱거리는 목소리가 나옵니다. 성대 주름 전체의 긴장도는 모달 보이스보다 적지만 서로 단단히 붙잡혀 성대 주름의 인대만 진동합니다.[e] 펄스는 매우 불규칙하며 피치와 주파수 진폭이 낮습니다.[65]

일부 언어는 일부 자음에 대해 음성 구별을 유지하지 [f]않지만 모든 언어는 어느 정도 음성을 사용합니다. 예를 들어, 알려진 모든 모음이 표준적으로 음성화된 모음과 모음에 대한 음소 음성 대조가 있는 언어는 알려져 있지 않습니다.[g] 호흡과 삐걱거리는 목소리와 같은 성문의 다른 위치는 할라파 마자텍과 같은 여러 언어에서 음소를 대조하기 위해 사용되는 반면 영어와 같은 다른 언어에서는 음소가 유음학적으로 존재합니다.

세그먼트의 음성 여부를 판단하는 방법은 여러 가지가 있는데, 가장 간단한 것은 음성 중에 후두를 느끼고 진동이 느껴질 때 기록하는 것입니다. 스펙트로그램 또는 스펙트럼 슬라이스의 음향 분석을 통해 보다 정확한 측정값을 얻을 수 있습니다. 분광 분석에서 유성 세그먼트는 유성 세그먼트의 저주파에서 높은 음향 에너지 영역인 음성 막대를 보여줍니다.[66] 스펙트럼 스플라이스를 검사할 때, 모음 모델이 발음하는 특정 시점의 음향 스펙트럼은 성문의 스펙트럼을 생성하는 입의 필터링을 반대로 합니다. 그런 다음 필터링되지 않은 성문 신호의 계산 모델을 역 필터링된 음향 신호에 맞춰 성문의 특성을 결정합니다.[67] 초음파, 내시경 등 전문 의료장비를 이용한 육안 분석도 가능합니다.[66][h]

모음.

| IPA: 모음 | ||||||||||||||||||||||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| ||||||||||||||||||||||||||||||||

| |

모음은 입에서 만들어지는 부위에 따라 크게 분류되지만, 성대에서 수축 없이 만들어지기 때문에 정확한 설명은 혀 위치의 음향 상관 관계를 측정하는 데 의존합니다. 모음을 만들 때 혀의 위치에 따라 공동이 공명하는 진동수가 달라지는데, 바로 이러한 공명(formant)을 측정하여 모음을 특성화하는 데 사용하는 것이 바로 포먼트(formant)라고 합니다.

모음의 높이는 전통적으로 조음 중 혀의 가장 높은 지점을 말합니다.[68] 높이 매개 변수는 높음(닫힘), 근접 중간(닫힘), 열림(열림), 낮음(열림)의 네 가지 기본 레벨로 나뉩니다. 높이가 중간인 모음을 미드라고 합니다. 약간 열린 가까운 모음과 약간 닫힌 열린 모음을 각각 가까운 모음과 가까운 열린 모음이라고 합니다. 가장 낮은 모음은 혀를 내미는 것뿐만 아니라 턱을 낮추어 발음하기도 합니다.[69]

IPA는 모음의 높이가 7단계라는 것을 암시하지만, 주어진 언어가 7단계 모두를 최소한으로 대조할 수 있는 것은 아닙니다. Chomsky와 Halle는 덴마크어를 묘사하기 위해 모음의 높이가 4단계로 필요한 것으로 보이며 일부 언어에서는 5단계가 필요할 수도 있다고 제안합니다.[70][71]

모음배음은 앞, 중앙, 뒤의 세 단계로 나뉩니다. 언어는 일반적으로 모음 배경의 두 수준 이상을 최소한으로 대조하지 않습니다. Nimboran어와 노르웨이어가 3자 배어 차이가 있다고 주장하는 일부 언어는 Nimboran어와 노르웨이어를 포함합니다.[72]

대부분의 언어에서 모음 생성 중 입술은 둥근 입술 또는 둥근 입술(퍼짐)로 분류될 수 있지만, 압축 및 돌출과 같은 다른 유형의 입술 위치가 설명되어 있습니다. 입술 위치는 키와 등과 상관관계가 있습니다: 앞모음과 낮은 모음은 둥근 경향이 있는 반면, 뒤모음과 높은 모음은 보통 둥근 경향이 있습니다.[73] IPA 차트의 쌍모음은 왼쪽에 펼쳐진 모음이 있고 오른쪽에 둥근 모음이 있습니다.[74]

위에서 설명한 보편적 모음 기능과 함께 일부 언어에는 무성음, 길이 및 무성음 또는 삐걱거림과 같은 다양한 유형의 음소와 같은 추가 기능이 있습니다. 때로는 특정 모음을 설명하기 위해 로틱성, 고급 혀 뿌리, 인두화, 강직성 및 마찰과 같은 더 전문화된 혀 제스처가 필요합니다.[75]

아티큘레이션 방식

조음의 위치를 아는 것만으로는 자음을 완전히 설명할 수 없기 때문에 조음이 일어나는 방식도 마찬가지로 중요합니다. 아티큘레이션 방식은 활성 아티큘레이터가 성대를 정확히 수정, 좁히거나 폐쇄하는 방법을 설명합니다.[76]

정지(stops, splosive)는 기류가 완전히 차단된 자음입니다. 협착 시 입 안에 압력이 쌓이고, 이 압력은 관절이 분리될 때 작은 소리 폭발로 방출됩니다. 벨룸은 비강을 통해 공기가 흐르지 않도록 상승합니다. 벨룸이 낮아져 코로 공기가 흐르게 되면 코가 막히게 됩니다. 그러나 음성학자들은 거의 항상 코막힘을 그저 "비강"이라고 부릅니다.[76] 마찰력은 같은 장소에서 마찰력이 뒤따르는 일련의 정지입니다.[77]

마찰음은 부분적으로 또는 완전히는 아니지만 성대의 일부를 막음으로써 기류가 난류를 일으키는 자음입니다.[76] 파찰란트는 난류 기류가 치아 쪽으로 [78]향하면서 고음의 쉬싱 소리를 내는 특수한 마찰제 유형입니다.[79]

비강(nasal)은 구강 내에 폐쇄가 있고 벨룸이 낮아져 코로 공기가 흐르게 하는 자음입니다.[80]

대략적으로, 아티큘레이터들은 서로 가까이 오지만, 난류 기류를 허용할 정도는 아닙니다.[79]

측음은 성관의 중심을 따라 기류가 막혀 한쪽 또는 양쪽으로 기류가 자유롭게 흐를 수 있는 자음입니다.[79] 측면은 또한 혀의 중심보다 측면의 공기 흐름이 더 크도록 혀가 수축되는 자음으로 정의되었습니다.[81] 첫 번째 정의는 혀 위에 공기가 흐르는 것을 허용하지 않습니다.

트릴은 공기 흐름에 의해 혀나 입술이 움직이는 자음입니다.[82] 협착은 공기 흐름이 소프트 아티큘레이터의 개폐 패턴을 반복적으로 유발하는 방식으로 형성됩니다.[83] 정점 트릴은 일반적으로 두 번 또는 세 번의 진동 주기로 구성됩니다.[84]

탭과 플랩은 혀를 입천장에 대고 던지는 단일하고 빠른 일반적인 정점 제스처로, 매우 빠른 정지와 비슷합니다.[82] 이 용어들은 때때로 상호 교환적으로 사용되지만, 일부 음성학자들은 구별합니다.[85] 두드리는 동작에서 혀는 단 한 번의 동작으로 지붕에 닿는 반면, 플랩에서는 혀가 입의 지붕에 접선 방향으로 움직이며 통과할 때 부딪힙니다.

성문 기류 메커니즘 중에 성문이 닫혀 공기를 가둡니다. 이를 통해 성대에 남아 있는 공기를 별도로 이동할 수 있습니다. 닫힌 성문이 위쪽으로 움직이면 이 공기가 밖으로 이동하여 분출 자음이 됩니다. 또는 성문이 낮아져 입 안으로 더 많은 공기를 빨아들이게 되고, 이로 인해 내향성 자음이 발생할 수 있습니다.[86]

클릭은 혀의 움직임으로 인해 입 안에 공기가 흡입되는 것을 정지시키는 것으로, 이를 벨라리 기류라고 합니다.[87] 딸깍 소리가 나는 동안 두 개의 조음기 클로징 사이에서 공기가 희박해져 전방 클로징이 해제되면 큰 '딸깍' 소리가 납니다. 전방 폐쇄의 해제를 클릭 유입이라고 합니다. 벨러 또는 자색일 수 있는 후방 폐쇄의 해제는 클릭 유출입니다. 클릭은 코이산어, 반투어와 같은 몇몇 아프리카 언어 계열에서 사용됩니다.[88]

폐 및 성문하계

폐는 거의 모든 음성 생산을 주도하며, 음성학에서 폐의 중요성은 폐음에 대한 압력을 만들어내기 때문입니다. 언어를 넘나드는 가장 흔한 종류의 소리는 폐에서 공기를 내뿜는 폐활량입니다.[89] 그 반대의 경우도 가능하지만, 음소로서 폐음향을 가진 언어는 없는 것으로 알려져 있습니다.[90] 스웨덴어와 같은 많은 언어들은 유전적으로 그리고 지리적으로 다양한 여러 언어에서 확언과 같은 병렬 언어 표현을 위해 그것들을 사용합니다.[91] 공격적인 소리와 공격적인 소리 모두 특정 자세로 성대 주름을 잡고 폐를 사용하여 성대 주름을 가로질러 공기를 끌어들여 진동(목소리)하거나 진동하지 않습니다.[89] 폐색성 관절은 생명력이라고 알려진 주어진 호흡 주기에서 숨을 내쉴 수 있는 공기의 양에 의해 제한됩니다.

폐는 두 종류의 압력을 동시에 유지하여 음소를 생성하고 수정하는 데 사용됩니다. 음운을 전혀 내기 위해서는 폐가 성문 위쪽의 압력보다 3~5cm HO2 높은 압력을 유지해야 합니다. 그러나 스트레스와 같은 초분절적 특징에 대해 음성을 수정하기 위해 성문하 압력을 작고 빠르게 조정합니다. 이러한 조정을 위해 많은 흉부 근육이 사용됩니다. 흡입 시 폐와 흉곽이 늘어나기 때문에 폐의 탄성력만으로도 폐활량의 50% 이상에서 축음에 충분한 압력차를 만들 수 있습니다.[92] 활력소 용량의 50% 이상인 호흡근은 안정적인 압력 차를 유지하기 위해 흉곽의 탄성력을 "확인"하는 데 사용됩니다. 그 부피 이하에서는 공기를 적극적으로 배출하여 성문하 압력을 높이는 데 사용됩니다.

말을 하는 동안 호흡 주기는 언어적 및 생물학적 요구를 모두 수용하도록 수정됩니다. 보통 정지한 호흡 주기의 약 60%인 날숨은 호흡 주기의 약 90%로 증가합니다. 대사 요구는 비교적 안정적이기 때문에 대부분의 언어에서 이동하는 총 공기량은 조용한 조수 호흡과 거의 비슷합니다.[93] 18dB(큰 대화)의 음성 강도 증가는 이동하는 공기량에 상대적으로 적은 영향을 미칩니다. 호흡기가 성인만큼 발달하지 않았기 때문에, 어린이들은 성인에 비해 더 많은 비중의 필수 능력을 사용하는 경향이 있고, 숨을 깊이 들이마시는 경향이 있습니다.[94]

소스-필터 이론

이 구간은 확장이 필요합니다. 추가하여 도움을 드릴 수 있습니다. (2020년 2월) |

음성의 소스-필터 모델은 음성 생성 이론으로, 성대 자세와 음향 결과 사이의 연관성을 설명합니다. 이 모델에서 성대는 음향 필터에 결합된 노이즈 소스로 모델링할 수 있습니다.[95] 다른 소음원도 같은 방식으로 모델링할 수 있지만, 많은 경우 소음원은 음성을 내는 과정에서 후두입니다. 시상하부 성대의 모양은 필터 역할을 하며 아티큘레이터의 다른 구성은 다른 음향 패턴을 생성합니다. 이러한 변화는 예측 가능합니다. 성대는 직경이 다양한 한쪽 끝이 폐쇄되고 직경이 다른 튜브 시퀀스로 모델링할 수 있으며 음향 공명 방정식을 사용하여 관절 자세의 음향 효과를 도출할 수 있습니다.[96] 역 필터링 프로세스는 이 원리를 사용하여 음성 중에 음성 주름에 의해 생성되는 소스 스펙트럼을 분석합니다. 예측된 필터의 역방향을 취함으로써, 성대 주름에 의해 생성되는 음향 스펙트럼을 제공함으로써, 시상하부 성대의 음향 효과를 되돌릴 수 있습니다.[97] 이를 통해 다양한 음소 유형을 정량적으로 연구할 수 있습니다.

지각

언어 지각은 언어적 신호가 청자에 의해 해독되고 이해되는 과정입니다.[i] 음성을 인식하려면 연속 음향 신호를 음소, 형태소 및 단어와 같은 개별 언어 단위로 변환해야 합니다.[98] 청취자는 소리를 정확하게 식별하고 분류하기 위해 언어 범주를 안정적으로 구별할 수 있는 신호의 특정 측면을 우선시합니다.[99] 특정 신호가 다른 신호보다 우선시되지만 신호의 여러 측면이 지각에 기여할 수 있습니다. 예를 들어, 구두 언어가 음향 정보를 우선시하지만, McGurk 효과는 음향 신호가 신뢰할 수 없을 때 시각 정보가 모호한 정보를 구별하는 데 사용된다는 것을 보여줍니다.[100]

청취자는 음성 신호를 분할하기 위해 다양한 정보를 사용할 수 있지만 음향 신호와 범주 인식 사이의 관계는 완벽한 매핑이 아닙니다. 공동 관절, 잡음 환경 및 개인차로 인해 범주 내에서 높은 수준의 음향 변동성이 있습니다.[101] 지각 불변성의 문제로 알려진 청취자는 음향 인스턴스화의 가변성에도 불구하고 카테고리를 안정적으로 인식할 수 있습니다.[102] 이를 위해 청취자는 새로운 화자에게 빠르게 적응하고 대화 상대가 만들고 있는 음향적 차이에 맞게 카테고리 간에 경계를 전환합니다.[103]

오디션

소리를 듣는 과정인 오디션은 음성을 인지하는 첫 번째 단계입니다. 아티큘레이터는 음파가 청취자의 귀로 이동하면서 기압에 체계적인 변화를 일으킵니다. 그런 다음 음파가 청취자의 귀 드럼에 닿아 진동을 일으킵니다. 귀고막의 진동은 중이의 세 개의 작은 뼈인 골골에 의해 달팽이관으로 전달됩니다.[104] 달팽이관은 나선형 모양의 유체로 채워진 관으로 기저막을 포함하는 코르티 기관에 의해 길이로 나뉩니다. 기저막은 달팽이관을 통과하면서 두께가 증가하여 서로 다른 위치에서 서로 다른 주파수를 공명시킵니다. 이 의성어 디자인을 통해 귀는 푸리에 변환과 유사한 방식으로 소리를 분석할 수 있습니다.[105]

기저부의 차동 진동은 코르티 기관 내의 모발 세포를 움직이게 합니다. 이것은 모발 세포의 탈분극을 일으키고 궁극적으로 음향 신호를 신경 신호로 변환시킵니다.[106] 모발 세포는 활동 전위를 스스로 생성하지는 않지만, 청각 신경의 섬유와 시냅스에서 신경 전달 물질을 방출하여 활동 전위를 생성합니다. 이러한 방식으로 기저막의 진동 패턴은 뇌간으로 소리에 대한 정보를 전달하는 발화의 시공간 패턴으로 변환됩니다.[107]

운율

자음과 모음 외에도, 음성학은 또한 음절과 구와 같은 분절에 국한되지 않고 더 큰 단위의 말의 특성을 설명합니다. 운율에는 음정, 말소리, 지속 시간 및 소리와 같은 청각적 특성이 포함됩니다. 언어는 이러한 특성을 사용하여 스트레스, 음정 억양 및 억양을 구현합니다. 예를 들어 영어와 스페인어의 스트레스는 음정 및 지속 시간의 변화와 상관관계가 있는 반면, 웨일스어의 스트레스는 지속 시간보다 음정과 더 일관되게 상관관계가 있으며 태국어의 스트레스는 지속 시간과만 상관관계가 있습니다.[108]

음성인식이론

운동 이론과 같은 초기의 음성 인식 이론은 음성 인식과 생성이 밀접하게 연결되어 있다고 주장함으로써 지각 불변성의 문제를 해결하고자 했습니다. 가장 강력한 형태로, 운동 이론은 음성 인식이 청취자가 소리의 조음 표현에 접근할 것을 요구한다고 주장합니다;[109] 소리를 적절하게 분류하기 위해, 청취자는 그 소리를 생산할 조음을 역공학하고 이러한 제스처를 식별함으로써 의도된 언어 범주를 검색할 수 있습니다.[110] 맥거크 효과와 신경학적 부상을 입은 환자의 사례 연구와 같은 연구 결과는 운동 이론에 대한 지지를 제공했지만, 추가 실험은 운동 이론의 강력한 형태를 지지하지 않았습니다. 비록 생산과 인식 사이에 determin이 아닌 관계를 주장하는 더 약한 형태의 운동 이론에 대한 일부 지지가 있습니다.

음성 인식의 후속 이론은 소리 범주에 대한 음향 신호에 초점을 두며 추상주의 이론과 에피소드 이론의 두 가지 넓은 범주로 그룹화할 수 있습니다.[113] 추상주의 이론에서 음성 인식은 필요한 구성 요소로 축소된 신호를 기반으로 이상화된 어휘 객체를 식별하고 화자 변동성에 대응하기 위해 신호를 정규화하는 것을 포함합니다. 예시 모델과 같은 에피소드 이론은 음성 인식이 이전에 들었던 토큰의 상세한 기억(즉, 에피소드 기억)에 액세스하는 것을 포함한다고 주장합니다. 지각 불변성의 문제는 친숙함의 문제로 에피소드 이론에 의해 설명됩니다. 정규화는 추상주의 이론이 주장하는 이산 과정이 아닌 더 다양한 분포에 노출된 부산물입니다.[113]

하위분야

음향 음성학

음향 음성학은 음성의 음향 특성을 다룹니다. 소리의 감각은 고막을 움직이게 하는 압력 변동에 의해 발생합니다. 귀는 이 움직임을 뇌가 소리로 등록하는 신경 신호로 변환합니다. 음향 파형은 이러한 압력 변동을 측정하는 기록입니다.[114]

조음음성학

발화 음성학은 말소리가 만들어지는 방식을 다룹니다.

청각음성학

청각 음성학은 인간이 말소리를 어떻게 인식하는지 연구합니다. 음성 신호를 왜곡하는 청각 시스템의 해부학적 특징으로 인해 인간은 완벽한 음향 기록으로 음성 소리를 경험하지 못합니다. 예를 들어, 데시벨(dB)로 측정된 볼륨의 청각적 인상은 음압의 차이와 선형적으로 일치하지 않습니다.[115]

음향 분석과 청취자가 듣는 것 사이의 불일치는 특히 특정 마찰음과 같이 고주파 에너지가 많은 음성에서 두드러집니다. 이러한 불일치를 조정하기 위해 청각 시스템의 기능 모델이 개발되었습니다.[116]

소리 설명하기

인간의 언어는 다양한 소리를 사용하며, 이를 비교하기 위해서는 언어학자들이 언어에 독립적인 방식으로 소리를 설명할 수 있어야 합니다. 음성 소리는 여러 가지 방법으로 설명할 수 있습니다. 가장 일반적으로 말소리는 소리를 내는 데 필요한 입 움직임으로 언급됩니다. 자음과 모음은 음성학자들이 말소리의 움직임에 의해 정의하는 두 가지 총체적인 범주입니다. 더 세분화된 설명자는 아티큘레이션 장소와 같은 매개변수입니다. 자음을 설명하기 위해 조음 장소, 조음 방법, 목소리를 사용하며, 국제 음성 알파벳 자음 차트의 주요 구분입니다. 모음은 키, 등, 반올림으로 설명됩니다. 수화는 위치, 움직임, 손 모양, 손바닥 방향 및 수동이 아닌 특징과 유사하지만 구별되는 매개변수 세트를 사용하여 기호를 설명합니다. 아티큘레이션 설명 외에도 구두 언어에서 사용되는 소리는 음향을 사용하여 설명할 수 있습니다. 음향학은 아티큘레이션의 결과이기 때문에 두 가지 설명 방법은 조사 중인 음성 특징에 따라 시스템 간의 선택으로 소리를 구별하는 데 충분합니다.

자음은 성대의 완전한 또는 부분적인 폐쇄와 함께 조음되는 말소리입니다. 일반적으로 폐에서 배출되는 기류의 변형에 의해 생성됩니다. 공기 흐름을 만들고 수정하는 데 사용되는 호흡기는 성대(후두상), 후두, 성문하계의 세 영역으로 나뉩니다. 공기 흐름은 (성대 밖으로) 퇴행적일 수도 있고 (성대 안으로) 퇴행적일 수도 있습니다. 폐음에서 기류는 성문하계의 폐에 의해 생성되며 후두와 성대를 통과합니다. 성문음은 폐의 기류 없이 후두의 움직임에 의해 만들어진 기류를 이용합니다. 클릭 자음은 혀를 사용한 공기의 희박화를 통해 조음되며, 이어서 혀의 전방 폐쇄를 해제합니다.

모음은 음절적인 말소리로, 성대에 아무런 방해 없이 발음됩니다.[117] 모음은 일반적으로 명확한 조음 장소가 있는 자음과 달리 기수모음이라고 하는 기준모음 집합과 관련하여 정의됩니다. 모음을 정의하기 위해서는 혀 높이, 혀 뒤쪽, 입술 둥글게 하는 세 가지 속성이 필요합니다. 안정적인 음질로 조음되는 모음을 모노프종(monophthong)이라고 하며, 같은 음절에 있는 두 개의 개별 모음을 조합하는 것을 디프종(diphthong)이라고 합니다.[118] IPA에서 모음은 사람의 입을 나타내는 사다리꼴 모양으로 표현됩니다. 바닥에서 지붕까지 입을 나타내는 세로축과 가로축은 앞뒤 치수를 나타냅니다.[119]

전사

음성 전사는 구두나 수화를 막론하고 언어로 발생하는 전화를 전사하기 위한 시스템입니다. 가장 널리 알려진 음성 표기 체계인 국제 음성 문자(IPA)는 구강 전화를 위한 표준화된 기호 세트를 제공합니다.[120][121] IPA의 표준화된 특성으로 인해 사용자는 다양한 언어, 방언 및 아이디 선택의 전화를 정확하고 일관되게 기록할 수 있습니다.[120][122][123] IPA는 음성학 연구뿐만 아니라 언어 교육, 전문 연기 및 음성 병리학 연구에도 유용한 도구입니다.[122]

어떤 수화도 표준화된 문자 체계를 가지고 있지 않지만, 언어학자들은 악수, 위치, 움직임을 설명하는 그들만의 표기 체계를 개발했습니다. 함부르크 기보 시스템(HamNoSys)은 IPA와 유사한 점에서 다양한 수준의 세부 사항을 허용합니다. KOMVA와 스토코에 시스템과 같은 일부 표기 체계는 사전에 사용하기 위해 설계되었으며, HamNoSys는 직접적으로 핸드셰이프를 나타내는 반면 현지어의 알파벳 문자를 사용하기도 합니다. SignWriting은 아직 청각 장애인 공동체에서 공식적으로 채택되지 않았지만 수화를 위한 배우기 쉬운 글쓰기 시스템을 목표로 합니다.[124]

수화

구어와 달리 수화의 단어는 귀 대신 눈으로 인식됩니다. 표지판은 손, 상체, 머리로 관절형입니다. 주요 아티큘레이터는 손과 팔입니다. 팔의 상대적인 부분은 근위부와 원위부라는 용어로 설명됩니다. 근위부는 몸통에 더 가까운 부분을 말하며, 원위부는 몸통에서 더 멀리 떨어져 있습니다. 예를 들어, 손목 움직임은 팔꿈치 움직임에 비해 원위입니다. 에너지가 덜 필요하기 때문에 원위부 움직임은 일반적으로 생성하기가 더 쉽습니다. 근육의 유연성이나 금기시되는 것과 같은 다양한 요인들이 징후로 간주될 수 있는 것을 제한합니다.[125] 원어민 수화자는 대화 상대의 손을 보지 않습니다. 대신, 그들의 시선은 얼굴에 고정되어 있습니다. 말초 시각은 시야의 중심만큼 초점이 맞춰지지 않기 때문에 얼굴 근처에 관절로 연결된 기호는 손가락 움직임과 위치에 있어 더 미묘한 차이를 인지할 수 있습니다.[126]

구어와 달리 수화에는 손과 같은 두 개의 조음기가 있습니다. 서명자는 의사소통에 방해가 되지 않고 원하는 손을 사용할 수 있습니다. 보편적인 신경학적 한계로 인해 양손의 관절은 일반적으로 양손에 같은 종류의 관절을 갖는데, 이를 대칭 조건(Symmetry Condition)이라고 합니다.[125] 두 번째 보편적 제약 조건은 지배 조건(Dominance Condition)으로, 두 개의 악수가 관련되어 있을 때 한 손이 정지 상태를 유지하고 지배적인 움직이는 손에 비해 더 제한된 악수 세트를 갖는다는 것입니다.[127] 또한 비공식 대화 중에 양손 표지의 한 손이 떨어지는 것이 일반적인데, 이 과정을 위크 드롭(weak drop)이라고 합니다.[125] 구어의 단어들과 마찬가지로, 코아티컬레이션은 기호들이 서로의 형태에 영향을 미칠 수 있습니다. 예를 들어, 인접한 부호의 핸드셰이프가 서로 더 유사해지거나(동화), 약한 드롭(삭제의 예) 등이 있습니다.[128]

참고 항목

참고문헌

메모들

- ^ 언어학자들은 이러한 단계들이 상호작용할 수 있는지 또는 연속적으로 발생하는지 여부에 대해 논의합니다(Dell & Reich (1981)와 Motley, Camden & Baars (1982)를 비교합니다). 설명의 편의를 위해 언어 생산 과정은 일련의 독립적인 단계로 설명되지만 최근의 증거는 이것이 부정확하다는 것을 보여줍니다.[12] 대화형 활성화 모델에 대한 자세한 설명은 Jaeger, Furth & Hilliard(2012)를 참조하십시오.

- ^ 또는 발화의 일부가 계획된 후에; 글라이트만 외 참조. (2007) 메시지가 완전히 계획되기 전에 생산된 증거에 대해

- ^ Sedivy(2019, p. 411)와 Boersma(1998, p. 11)에서 각색.

- ^ 최초의 제안은 Feldman(1966)을 참조하십시오.

- ^ 음소의 해부학에 대한 자세한 내용은 #후두를 참조하십시오.

- ^ 예를 들어 하와이어는 유성음과 무성음을 대조하지 않습니다.

- ^ 일본어와 같이 특정한 맥락에서 모음이 무성음으로 생성되는 언어가 있습니다.

- ^ 음향 모델링에 대한 자세한 내용은 #Articulation models를 참조하십시오.

- ^ 음성 제작과 마찬가지로 언어 신호의 특성은 언어 양식에 따라 다릅니다. 신호는 구두 음성의 경우 음향, 서명된 언어의 경우 시각 또는 수동 촉각 수화의 경우 촉각일 수 있습니다. 간단한 음향 음성은 여기에 설명되어 있습니다. 수화 인식에 대해서는 수화#수화 인식을 참조하십시오.

인용문

- ^ 오그래디 2005, 15페이지.

- ^ Lynch, Matthew (2021-04-07). "The Differences Between a Phone, Phoneme And an Allophone". The Edvocate. Retrieved 2023-02-06.

- ^ a b c 까프리 2017.

- ^ 키파스키 1993, 페이지 2918.

- ^ 키파스키 1993, 페이지 2922-3.

- ^ Deussen, Paul (1980). Sixty Upanishads of the Veda, Volume I. Motilal Banarasidass. p. 222. ISBN 978-8120814684.

- ^ 옥스포드 영어 사전 2018.

- ^ a b 2015년 로치.

- ^ Ladefoged 1960, p. 388.

- ^ Ladefoged 1960.

- ^ Dell & O'Seaghda 1992.

- ^ Sedivy 2019, p. 439.

- ^ 보어스마 1998.

- ^ a b Ladefoged 2001, p. 5.

- ^ Ladefogged & Maddieson 1996, p. 9.

- ^ "IPA: Labiodentals". home.cc.umanitoba.ca. Retrieved 2023-02-06.

- ^ Ladefogged & Maddieson 1996, p. 16.

- ^ 매디슨 1993.

- ^ 후지무라 1961.

- ^ Ladefogged & Maddieson 1996, 페이지 16-17.

- ^ a b c 국제 음성 협회 2015.

- ^ Ladefogged & Maddieson 1996, p. 18.

- ^ Ladefogged & Maddieson 1996, pp. 17-18.

- ^ a b Ladefogged & Maddieson 1996, p. 17.

- ^ 1926년 공작.

- ^ 거스리 1948, 61쪽.

- ^ Ladefogg & Maddieson 1996, pp. 19-31.

- ^ a b Ladefogged & Maddieson 1996, p. 28.

- ^ Ladefogg & Maddieson 1996, 페이지 19-25.

- ^ Ladefogg & Maddieson 1996, pp. 20, 40-1.

- ^ 스캇튼 1984, 페이지 60.

- ^ Ladefogged & Maddieson 1996, p. 23.

- ^ Ladefogged & Maddieson 1996, pp. 23-5.

- ^ Ladefogg & Maddieson 1996, pp. 25, 27-8.

- ^ a b Ladefogged & Maddieson 1996, p. 27.

- ^ Ladefogg & Maddieson 1996, 페이지 27-8.

- ^ Ladefogged & Maddieson 1996, p. 32.

- ^ Ladefogged & Maddieson 1996, p. 35.

- ^ Ladefogg & Maddieson 1996, pp. 33-34.

- ^ Keating & Lahiri 1993, p. 89.

- ^ 매디슨 2013.

- ^ Ladefogged & Maddieson 1996, p. 11.

- ^ 로지 2009, p. 33.

- ^ a b Ladefogged & Maddieson 1996, p. 37.

- ^ a b Ladefogged & Maddieson 1996, p. 38.

- ^ Ladefogged & Maddieson 1996, 페이지 74.

- ^ Ladefogged & Maddieson 1996, p. 75.

- ^ 라데포그 2001, p. 123.

- ^ 세이켈, 드럼라이트 & 킹 2016, p. 222.

- ^ a b 오할라 1997, p. 1.

- ^ Chomsky & Halle 1968, pp. 300–301.

- ^ 알트만 2002.

- ^ a b Löfqvist 2010, p. 359.

- ^ Munhall, Ostry & Flanagan 1991, p. 299, etseq.

- ^ Löfqvist 2010, p. 360.

- ^ 비지 외 1992.

- ^ Löfqvist 2010, p. 361.

- ^ 솔츠만 & 문홀 1989.

- ^ 매팅리 1990.

- ^ Löfqvist 2010, pp. 362–4.

- ^ Löfqvist 2010, p. 364.

- ^ a b Gordon & Ladefoged 2001.

- ^ Gobl & Ni Chasaide 2010, 페이지 399.

- ^ Gobl & Ni Chasaide 2010, 페이지 400-401.

- ^ Gobl & Ni Chasaide 2010, p. 401.

- ^ a b 도슨 & 펠란 2016.

- ^ Gobl & Ni Chasaide 2010, pp. 388, et seq.

- ^ Ladefogged & Maddieson 1996, p. 282.

- ^ 롯지 2009, p. 39.

- ^ Chomsky & Halle 1968.

- ^ Ladefogged & Maddieson 1996, p. 289.

- ^ Ladefogged & Maddieson 1996, p. 290.

- ^ Ladefoged & Maddieson 1996, p. 292-295.

- ^ 롯지 2009, 페이지 40.

- ^ Ladefogged & Maddieson 1996, p. 298.

- ^ a b c Ladefogged & Johnson 2011, p. 14.

- ^ Ladefogged & Johnson 2011, p. 67.

- ^ Ladefogged & Maddieson 1996, p. 145.

- ^ a b c Ladefogged & Johnson 2011, p. 15.

- ^ Ladefogged & Maddieson 1996, p. 102.

- ^ Ladefogged & Maddieson 1996, p. 182.

- ^ a b Ladefogged & Johnson 2011, p. 175.

- ^ Ladefogged & Maddieson 1996, p. 217.

- ^ Ladefogged & Maddieson 1996, p. 218.

- ^ Ladefogged & Maddieson 1996, p. 230-231.

- ^ Ladefogged & Johnson 2011, p. 137.

- ^ Ladefogged & Maddieson 1996, p. 78.

- ^ Ladefoged & Maddieson 1996, p. 246-247.

- ^ a b Ladefoged 2001, p. 1.

- ^ Eklund 2008, p. 237.

- ^ 에클룬드 2008.

- ^ 세이켈, 드럼라이트 & 킹 2016, p. 176

- ^ 세이켈, 드럼라이트 & 킹 2016, p. 171

- ^ 세이켈, 드럼라이트 & 킹 2016, 168-77쪽.

- ^ Johnson 2008, p. 83–5. CITEREFJonson (

- ^ Johnson 2008, p. 104–5. CITEREFJonson (

- ^ Johnson 2008, p. 157. CITEREFJonson (

- ^ Sedivy 2019, p. 259–60.

- ^ Sedivy 2019, p. 269.

- ^ Sedivy 2019, p. 273.

- ^ Sedivy 2019, p. 259.

- ^ Sedivy 2019, p. 260.

- ^ Sedivy 2019, p. 274–85.

- ^ Johnson 2003, 페이지 46-7.

- ^ 존슨 2003, 페이지 47.

- ^ Schacter, Gilbert & Wegner 2011, p. 158-9.

- ^ Yost 2003, p. 130.

- ^ 커틀 2005.

- ^ Sedivy 2019, p. 289.

- ^ a b 갈란투치, 파울러 & 터비 2006.

- ^ Sedivy 2019, p. 292–3.

- ^ 스키퍼, 데블린 & 라메티 2017.

- ^ a b 골딩거 1996.

- ^ 존슨 2003, 페이지 1.

- ^ Johnson 2003, 페이지 46-49.

- ^ Johnson 2003, p. 53.

- ^ Ladefogged & Maddieson 1996, p. 281.

- ^ Gussenhoven & Jacobs 2017, 페이지 26-27.

- ^ 롯지 2009, 페이지 38.

- ^ a b 오그래디 2005, 17페이지.

- ^ 국제 음성 협회 1999.

- ^ a b Ladefoged 2005.

- ^ Ladfogged & Maddieson 1996.

- ^ 베이커 외. 2016, 페이지 242-244.

- ^ a b c Baker et al. 2016, p. 229-235.

- ^ 베이커 외. 2016, 페이지 236.

- ^ 베이커 외. 2016, 페이지 286.

- ^ 베이커 외, 2016, 페이지 239.

인용작

- Abercrombie, D. (1967). Elements of General Phonetics. Edinburgh: Chicago, Aldine Pub. Co.

- Altmann, Gerry (2002). Psycholinguistics : critical concepts in psychology. London: Routledge. ISBN 978-0415229906. OCLC 48014482.

- Baker, Anne; van den Bogaerde, Beppie; Pfau, Roland; Schermer, Trude (2016). The Linguistics of Sign Languages. Amsterdam/Philadelphia: John Benjamins Publishing Company. ISBN 978-90-272-1230-6.

- Baumbach, E. J. M (1987). Analytical Tsonga Grammar. Pretoria: University of South Africa.

- Bizzi, E.; Hogan, N.; Mussa-Ivaldi, F.; Giszter, S. (1992). "Does the nervous system use equilibrium-point control to guide single and multiple joint movements?". Behavioral and Brain Sciences. 15 (4): 603–13. doi:10.1017/S0140525X00072538. PMID 23302290.

- Bock, Kathryn; Levelt, Willem (2002). Atlmann, Gerry (ed.). Psycholinguistics: Critical Concepts in Psychology. Vol. 5. New York: Routledge. pp. 405–407. ISBN 978-0-415-26701-4.

- Boersma, Paul (1998). Functional phonology: Formalizing the interactions between articulatory and perceptual drives. The Hague: Holland Academic Graphics. ISBN 9055690546. OCLC 40563066.

- Caffrey, Cait (2017). "Phonetics". Salem Press Encyclopedia. Salem Press.

- Catford, J. C. (2001). A Practical Introduction to Phonetics (2nd ed.). Oxford University Press. ISBN 978-0-19-924635-9.

- Chomsky, Noam; Halle, Morris (1968). Sound Pattern of English. Harper and Row.

- Cutler, Anne (2005). "Lexical Stress" (PDF). In Pisoni, David B.; Remez, Robert (eds.). The Handbook of Speech Perception. Blackwell. pp. 264–289. doi:10.1002/9780470757024.ch11. ISBN 978-0-631-22927-8. OCLC 749782145. Retrieved 2019-12-29.

- Dawson, Hope; Phelan, Michael, eds. (2016). Language Files: Materials for an Introduction to Linguistics (12th ed.). The Ohio State University Press. ISBN 978-0-8142-5270-3.

- Dell, Gary; O'Seaghdha, Padraig (1992). "Stages of lexical access in language production". Cognition. 42 (1–3): 287–314. doi:10.1016/0010-0277(92)90046-k. PMID 1582160. S2CID 37962027.

- Dell, Gary; Reich, Peter (1981). "Stages in sentence production: An analysis of speech error data". Journal of Memory and Language. 20 (6): 611–629. doi:10.1016/S0022-5371(81)90202-4.

- Doke, Clement M (1926). The Phonetics of the Zulu Language. Bantu Studies. Johannesburg: Wiwatersrand University Press.

- Eklund, Robert (2008). "Pulmonic ingressive phonation: Diachronic and synchronic characteristics, distribution and function in animal and human sound production and in human speech". Journal of the International Phonetic Association. 38 (3): 235–324. doi:10.1017/S0025100308003563. S2CID 146616135.

- Feldman, Anatol G. (1966). "Functional tuning of the nervous system with control of movement or maintenance of a steady posture, III: Mechanographic analysis of the execution by man of the simplest motor task". Biophysics. 11: 565–578.

- Fujimura, Osamu (1961). "Bilabial stop and nasal consonants: A motion picture study and its acoustical implications". Journal of Speech and Hearing Research. 4 (3): 233–47. doi:10.1044/jshr.0403.233. PMID 13702471.

- Galantucci, Bruno; Fowler, Carol; Turvey, Michael (2006). "The motor theory of speech perception reviewed". Psychonomic Bulletin & Review. 13 (3): 361–377. doi:10.3758/BF03193857. PMC 2746041. PMID 17048719.

- Gleitman, Lila; January, David; Nappa, Rebecca; Trueswell, John (2007). "On the give and take between event apprehension and utterance formulation". Journal of Memory and Language. 57 (4): 544–569. doi:10.1016/j.jml.2007.01.007. PMC 2151743. PMID 18978929.

- Gobl, Christer; Ní Chasaide, Ailbhe (2010). "Voice source variation and its communicative functions". The Handbook of Phonetic Sciences (2nd ed.). pp. 378–424.

- Goldinger, Stephen (1996). "Words and voices: episodic traces in spoken word identification and recognition memory". Journal of Experimental Psychology: Learning, Memory, and Cognition. 22 (5): 1166–83. doi:10.1037/0278-7393.22.5.1166. PMID 8926483.

- Gordon, Matthew; Ladefoged, Peter (2001). "Phonation types: a cross-linguistic overview". Journal of Phonetics. 29 (4): 383–406. doi:10.1006/jpho.2001.0147.

- Guthrie, Malcolm (1948). The classification of the Bantu languages. London: Oxford University Press.

- Gussenhoven, Carlos; Jacobs, Haike (2017). Understanding phonology (Fourth ed.). London and New York: Routledge. ISBN 9781138961418. OCLC 958066102.

- Hall, Tracy Alan (2001). "Introduction: Phonological representations and phonetic implementation of distinctive features". In Hall, Tracy Alan (ed.). Distinctive Feature Theory. de Gruyter. pp. 1–40.

- Halle, Morris (1983). "On Distinctive Features and their articulatory implementation". Natural Language and Linguistic Theory. 1 (1): 91–105. doi:10.1007/BF00210377. S2CID 170466631.

- Hardcastle, William; Laver, John; Gibbon, Fiona, eds. (2010). The Handbook of Phonetic Sciences (2nd ed.). Wiley-Blackwell. ISBN 978-1-405-14590-9.

- International Phonetic Association (1999). Handbook of the International Phonetic Association. Cambridge University Press.

- International Phonetic Association (2015). International Phonetic Alphabet. International Phonetic Association.

- Jaeger, Florian; Furth, Katrina; Hilliard, Caitlin (2012). "Phonological overlap affects lexical selection during sentence production". Journal of Experimental Psychology: Learning, Memory, and Cognition. 38 (5): 1439–1449. doi:10.1037/a0027862. PMID 22468803.

- Jakobson, Roman; Fant, Gunnar; Halle, Morris (1976). Preliminaries to Speech Analysis: The Distinctive Features and their Correlates. MIT Press. ISBN 978-0-262-60001-9.

- Johnson, Keith (2003). Acoustic and auditory phonetics (2nd ed.). Blackwell Pub. ISBN 1405101229. OCLC 50198698.

- Johnson, Keith (2011). Acoustic and Auditory Phonetics (3rd ed.). Wiley-Blackwell. ISBN 978-1-444-34308-3.

- Jones, Daniel (1948). "The London school of phonetics". Zeitschrift für Phonetik. 11 (3/4): 127–135. (에서 재인쇄됨)

- Keating, Patricia; Lahiri, Aditi (1993). "Fronted Velars, Palatalized Velars, and Palatals". Phonetica. 50 (2): 73–101. doi:10.1159/000261928. PMID 8316582. S2CID 3272781.

- Kingston, John (2007). "The Phonetics-Phonology Interface". In DeLacy, Paul (ed.). The Cambridge Handbook of Phonology. Cambridge University Press. ISBN 978-0-521-84879-4.

- Kiparsky, Paul (1993). "Pāṇinian linguistics". In Asher, R.E. (ed.). Encyclopedia of Languages and Linguistics. Oxford: Pergamon.

- Ladefoged, Peter (1960). "The Value of Phonetic Statements". Language. 36 (3): 387–96. doi:10.2307/410966. JSTOR 410966.

- Ladefoged, Peter (2001). A Course in Phonetics (4th ed.). Boston: Thomson/Wadsworth. ISBN 978-1-413-00688-9.

- Ladefoged, Peter (2005). A Course in Phonetics (5th ed.). Boston: Thomson/Wadsworth. ISBN 978-1-413-00688-9.

- Ladefoged, Peter; Johnson, Keith (2011). A Course in Phonetics (6th ed.). Wadsworth. ISBN 978-1-42823126-9.

- Ladefoged, Peter; Maddieson, Ian (1996). The Sounds of the World's Languages. Oxford: Blackwell. ISBN 978-0-631-19815-4.

- Levelt, Willem (1999). "A theory of lexical access in speech production". Behavioral and Brain Sciences. 22 (1): 3–6. doi:10.1017/s0140525x99001776. hdl:11858/00-001M-0000-0013-3E7A-A. PMID 11301520. S2CID 152230066.

- Lodge, Ken (2009). A Critical Introduction to Phonetics. New York: Continuum International Publishing Group. ISBN 978-0-8264-8873-2.

- Löfqvist, Anders (2010). "Theories and Models of Speech Production". Handbook of Phonetic Sciences (2nd ed.). pp. 353–78.

- Maddieson, Ian (1993). "Investigating Ewe articulations with electromagnetic articulography". Forschungberichte des Intituts für Phonetik und Sprachliche Kommunikation der Universität München. 31: 181–214.

- Maddieson, Ian (2013). "Uvular Consonants". In Dryer, Matthew S.; Haspelmath, Martin (eds.). The World Atlas of Language Structures Online. Leipzig: Max Planck Institute for Evolutionary Anthropology.

- Mattingly, Ignatius (1990). "The global character of phonetic gestures". Journal of Phonetics. 18 (3): 445–52. doi:10.1016/S0095-4470(19)30372-9.

- Motley, Michael; Camden, Carl; Baars, Bernard (1982). "Covert formulation and editing of anomalies in speech production: Evidence from experimentally elicited slips of the tongue". Journal of Verbal Learning and Verbal Behavior. 21 (5): 578–594. doi:10.1016/S0022-5371(82)90791-5.

- Munhall, K.; Ostry, D; Flanagan, J. (1991). "Coordinate spaces in speech planning". Journal of Phonetics. 19 (3–4): 293–307. doi:10.1016/S0095-4470(19)30346-8.

- O'Connor, J.D. (1973). Phonetics. Pelican. pp. 16–17. ISBN 978-0140215601.

- O'Grady, William (2005). Contemporary Linguistics: An Introduction (5th ed.). Bedford/St. Martin's. ISBN 978-0-312-41936-3.

- Ohala, John (1997). "Aerodynamics of phonology". Proceedings of the Seoul International Conference on Linguistics. 92.

- "Phonetics, n.". Oxford English Dictionary Online. Oxford University Press. 2018.

- Roach, Peter (2015). "Practical Phonetic Training". Peter Roach. Retrieved 10 May 2019.

- Saltzman, Elliot; Munhall, Kevin (1989). "Dynamical Approach to Gestural Patterning in Speech Production" (PDF). Ecological Psychology. 1 (4): 333–82. doi:10.1207/s15326969eco0104_2. Archived from the original (PDF) on 2020-10-28. Retrieved 2018-08-23.

- Scatton, Ernest (1984). A reference grammar of modern Bulgarian. Slavica. ISBN 978-0893571238.

- Schacter, Daniel; Gilbert, Daniel; Wegner, Daniel (2011). "Sensation and Perception". In Charles Linsmeiser (ed.). Psychology. Worth Publishers. ISBN 978-1-4292-3719-2.

- Schiller, Niels; Bles, Mart; Jansma, Bernadette (2003). "Tracking the time course of phonological encoding in speech production: an event-related brain potential study". Cognitive Brain Research. 17 (3): 819–831. doi:10.1016/s0926-6410(03)00204-0. hdl:11858/00-001M-0000-0013-17B1-A. PMID 14561465.

- Sedivy, Julie (2019). Language in Mind: An Introduction to Psycholinguistics (2nd ed.). Oxford University Press. ISBN 978-1605357058.

- Seikel, J. Anthony; Drumright, David; King, Douglas (2016). Anatomy and Physiology for Speech, Language, and Hearing (5th ed.). Cengage. ISBN 978-1-285-19824-8.

- Skipper, Jeremy; Devlin, Joseph; Lametti, Daniel (2017). "The hearing ear is always found close to the speaking tongue: Review of the role of the motor system in speech perception". Brain and Language. 164: 77–105. doi:10.1016/j.bandl.2016.10.004. PMID 27821280.

- Stearns, Peter; Adas, Michael; Schwartz, Stuart; Gilbert, Marc Jason (2001). World Civilizations (3rd ed.). New York: Longman. ISBN 978-0-321-04479-2.

- Trask, R.L. (1996). A Dictionary of Phonetics and Phonology. Abingdon: Routledge. ISBN 978-0-415-11261-1.

- Yost, William (2003). "Audition". In Alice F. Healy; Robert W. Proctor (eds.). Handbook of Psychology: Experimental psychology. John Wiley and Sons. p. 130. ISBN 978-0-471-39262-0.

외부 링크

위키미디어 커먼즈의 음성학 관련 매체

위키미디어 커먼즈의 음성학 관련 매체- 노스캐롤라이나 대학교의 음성학 자료집

- 피터 로치의 "음성학의 작은 백과사전".

- 닐 타펜의 인터랙티브 아티큘레이션 시뮬레이터인 핑크 트롬본.