음성 인식

Speech perception| 다음에 대한 시리즈 일부 | ||||||

| 음성학 | ||||||

|---|---|---|---|---|---|---|

| 언어학 시리즈의 일부 | ||||||

| 부전공 | ||||||

| 아티큘레이션 | ||||||

| ||||||

| 음향학 | ||||||

| ||||||

| 지각 | ||||||

| ||||||

| 언어학 포털 | ||||||

언어 인식은 언어의 소리를 듣고 해석하고 이해하는 과정이다.음성 인식의 연구는 언어학에서의 음운학 및 음성학의 분야와 심리학에서의 인지심리학 및 인식학 분야와 밀접하게 연관되어 있다.음성 인식 연구는 인간의 청취자가 어떻게 음성을 인지하고 이 정보를 사용하여 구어를 이해하는 방법을 알아내려고 한다.음성인식 연구는 음성을 인식할 수 있는 컴퓨터 시스템 구축, 청각 및 언어 장애가 있는 청취자의 음성인식 향상, 외국어 교육 등에 응용이 가능하다.

스피치를 인지하는 과정은 음향신호 수준과 오디션 과정부터 시작된다.(오디션 진행에 대한 자세한 설명은 청력을 참조)초기 청각 신호를 처리한 후 음성 사운드는 음향 신호와 음성 정보를 추출하기 위해 추가로 처리된다.이 음성 정보는 단어 인식과 같은 더 높은 수준의 언어 과정에 사용될 수 있다.

음향 신호

음향 신호는 음성 신호에 포함된 감각 단서로서 음성 인식에 사용되며, 다른 음성 범주에 속하는 음성 소리를 구별하기 위해 사용된다.예를 들어, 음성에서 가장 많이 연구된 신호 중 하나는 음성 시작 시간 또는 VOT이다. VOT는 "b"와 "p"와 같이 음성과 음성의 차이를 나타내는 일차적인 신호다.다른 단서들은 발음이 다른 장소나 발음이 되는 매너에서 발생하는 소리를 구별한다.또한 음성 시스템은 특정 음성 사운드의 범주를 결정하기 위해 이러한 단서들을 결합해야 한다.이것은 종종 음소의 추상적인 표현이라는 관점에서 생각되어진다.이 표현들은 단어 인식과 다른 언어 과정에 사용하기 위해 결합될 수 있다.

특정 음성 사운드를 인지할 때 청취자가 어떤 음향 신호에 민감하게 반응하는지 식별하기가 쉽지 않다.

얼핏 보기에, 우리가 어떻게 말을 인지하는가에 대한 문제의 해결책은 매우 간단해 보인다.지각 단위에 해당하는 음향 파형의 확장을 식별할 수 있다면 음에서 의미까지의 경로가 명확해질 것이다.그러나 이 서신이나 지도는 심지어 45년 동안 이 문제에 대한 연구를 했음에도 불구하고 매우 찾기 어려운 것으로 증명되었다.[1]

음향 파형의 특정 측면이 하나의 언어 단위를 나타내는 경우, 음성 신디사이저를 사용한 일련의 테스트는 그러한 큐 또는 단위를 결정하기에 충분할 것이다.그러나 다음과 같은 두 가지 중요한 장애물이 있다.

- 음성 신호의 한 음향 측면은 언어학적으로 관련된 다른 차원을 나타낼 수 있다.예를 들어 영어의 모음 지속기간은 모음의 스트레스 여부나 음성으로 닫힌 음절이나 음절로 된 음절인지 아닌지를 나타낼 수 있으며, 경우에 따라서는(미국식 영어 /ɛ/, /æ/과 같이) 모음의 정체성을 구별할 수 있다.[2]일부 전문가들은 심지어 지속 시간이 전통적으로 영어로 장단모음이라고 불리는 것을 구별하는데 도움을 줄 수 있다고 주장한다.[3]

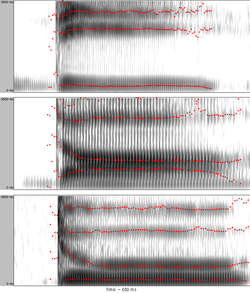

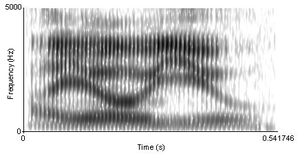

- 하나의 언어 단위는 여러 가지 음향 특성에 의해 계량될 수 있다.예를 들어 고전적인 실험에서 Alvin Liberman(1957)은 다음과 같은 모음(그림 1 참조)에 따라 /d/의 시작 형태 전환이 다르지만, 모두 청취자에 의해 음음 /d/로 해석된다.[4]

선형성 및 분할 문제

청취자는 말을 이산 단위[citation needed](phonemes, 음절, 단어)의 흐름으로 인식하지만, 이러한 선형성은 물리적 음성 신호에서 보기 어렵다(예: 그림 2 참조).말소리는 엄밀히 따르지 않고, 오히려 겹친다.[5]말소리는 앞에 있는 것과 뒤에 오는 것에 의해 영향을 받는다.이러한 영향은 두 개 이상의 세그먼트(그리고 음절 및 단어 경계)에서 발휘될 수 있다.[5]

음성 신호가 선형적이지 않기 때문에 분할 문제가 있다.하나의 지각 단위에 속하는 것으로서 연속된 음성 신호를 구분하는 것은 어렵다.예를 들어, 음소 /d/의 음향 특성은 다음 모음의 생산에 따라 달라진다(동음화 때문에).

불침투성 부족

언어 인식의 연구와 적용은 불침투의 부족이라고 불린 것에서 비롯되는 몇 가지 문제를 다루어야 한다.언어의 음소와 언어에서의 그것의 음향 표현 사이의 믿을 수 있는 지속적인 관계는 찾기 어렵다.이에 대한 몇 가지 이유가 있다.

문맥에 의한 변동

음성 환경은 언어 소리의 음향 특성에 영향을 미친다.예를 들어 /u/ 영어의 경우 관상 자음으로 둘러싸인 경우 앞면이 된다.[6]또는 음성과 무성음성의 경계를 표시하는 음성 시작 시간은 근막, 치경 및 벨라 플롯의 경우 다르며, 이들은 스트레스 또는 음절 내의 위치에 따라 변화한다.[7]

음성 조건 차이로 인한 변동

변동을 일으키는 한 가지 중요한 요인은 다른 언어율이다.많은 음소 대조는 시간적 특성(짧은 대 긴 모음 또는 자음, 붙임 대 프릭스, 플롯 대 글라이드, 음성 대 무성 플롯 등)에 의해 구성되며, 확실히 말하기 템포의 변화에 영향을 받는다.[1]또 다른 주요 변동 요인은 발성 조심성 대 연결된 언어에 전형적으로 나타나는 슬러피함이다(발성 "해결"은 생산되는 소리의 음향 특성에 분명히 반영된다).

서로 다른 스피커 ID로 인한 변동

콘크리트 음성 제작의 결과적인 음향 구조는 개별 스피커의 물리적, 심리적 특성에 따라 달라진다.남자, 여자, 아이들은 일반적으로 음이 다른 목소리를 낸다.스피커는 크기가 서로 다르기 때문에(특히 성별과 나이 때문에), 음성 소리를 인식하는 데 중요한 공명 주파수(공식)는 개인에[8] 따라 절대값이 달라질 것이다(이러한 예시는 그림 3 참조).연구에 따르면 생후 7.5개월의 영아는 성별이 다른 화자가 제시한 정보를 인식할 수 없지만 10.5개월이 되면 유사점을 발견할 수 있다.[9]방언과 외래어 억양 또한 화자와 청자의 사회적 특성처럼 변형을 일으킬 수 있다.[10]

지각 항상성 및 정상화

다양한 스피커와 다양한 조건에도 불구하고, 청취자들은 모음과 자음을 일정한 범주로 인식한다.이는 청취자가 기초 범주에 도달하기 위해 소음(즉, 변동)을 걸러내는 지각 정상화 과정을 통해 달성될 것으로 제안되었다.음역-크기의 차이는 스피커 간에 기형-주파수 변동을 초래하므로, 청취자는 자신의 지각 시스템을 특정 스피커의 음향 특성에 맞춰 조정해야 한다.이것은 절대값보다 포뮬러 원료의 비율을 고려함으로써 이루어질 수 있다.[11][12][13]이 과정을 보컬 정규화라고 한다(예: 그림 3 참조).마찬가지로, 청취자들은 지속시간에 대한 인식을 그들이 듣고 있는 연설의 현재 템포에 맞춰 조절한다고 믿어지고 있다 – 이것은 음성 비율 정상화라고 일컬어진다.

정상화가 실제로 이루어지는지 여부와 그 정확한 성질은 이론적 논란의 문제다(아래 이론 참조).지각 항상성은 언어 인식에만 국한되지 않는 현상이다; 그것은 다른 유형의 지각에도 존재한다.

범주형 인식

범주형 인식은 지각 분화의 과정에 관여한다.사람들은 음성을 분류적으로 인식하는데, 즉, 그들은 범주 내에서보다 범주들 간의 차이를 더 잘 알아차릴 수 있다.그러므로 범주들 사이의 지각 공간은 뒤틀리고, 체처럼[14] 작용하는 범주(또는 "원형")의 중심이나 들어오는 음성 소리를 위한 자석처럼[15] 작용한다.

무성음 투영과 음성 양면 투광 사이의 인위적인 연속체에서, 각각의 새로운 단계는 이전의 VOT 양과 다르다.첫 번째 소리는 미리 음성을 낸 [b], 즉 음의 VOT를 가지고 있다.그리고 나서, BOT를 증가시키면, 그것은 0에 도달한다. 즉, 플롯라이브는 쉽게 흡인되지 않는 무성음이다. [p].점차적으로, 한 번에 동일한 양의 VOT를 더하면, 그 플로시브는 결국 강하게 흡인된 무성 양립자[pʰ]가 된다.(그런 연속체는 1970년 리스트커와 에이브람슨의 실험에 사용되었다.[16]이들이 사용한 사운드는 온라인에서 이용할 수 있다.)예를 들어, 7개의 소리들의 연속에서, 원어민 리스너들은 처음 3개의 소리를 /b/로, 마지막 3개의 소리를 두 범주 사이에 명확한 경계를 가진 /p/로 식별할 것이다.[16]대체 식별(또는 분류) 시험은 불연속 분류 함수를 산출한다(그림 4의 빨간색 곡선 참조).

다양한 VOT 값을 가지지만 서로 일정한 VOT 거리(예를 들어 20ms)를 갖는 두 소리를 구별할 수 있는 능력을 시험할 때, 청취자는 두 소리가 동일한 범주에 속할 경우 찬스 레벨에서, 각 소리가 다른 범주에 속할 경우 거의 100% 레벨에서 연주할 가능성이 있다(파란색 구별법 참조).그림 4).

식별시험과 차별시험에서 모두 결론은 청취자가 범주 간 경계를 넘었는가에 따라 동일한 상대적 증가 VOT에 대한 민감도가 다르다는 것이다.유사한 지각 조정은 다른 음향 신호에 대해서도 입증된다.

하향식 영향

고전적인 실험에서 리차드 M.워렌(1970)은 한 단어의 음운 하나를 기침과 같은 소리로 대체했다.지각적으로, 그의 피실험자들은 아무 어려움 없이 잃어버린 음성 소리를 복원했고 음소 복원 효과로 알려진 현상인 [17]어떤 음소가 방해받았는지 정확히 파악할 수 없었다.따라서 언어 인식의 과정이 반드시 단방향인 것은 아니다.

또 다른 기본적인 실험은 구문 내에서 자연적으로 사용되는 단어의 인식과 격리된 동일한 단어의 인식을 비교했는데, 지각 정확도가 보통 후자의 조건에서 떨어진다는 것을 발견했다.의미지식이 지각에 미치는 영향을 조사하기 위해, Garnes와 Bond(1976)는 유사하게 통신사 문장을 사용했는데, 대상 단어가 연속체를 따라 품질이 변화한 단일 음소(예를 들어 bay/day/gay)에서만 차이가 났다.각자가 자연스럽게 하나의 해석으로 이어진 다른 문장에 넣을 때, 듣는 사람들은 전체 문장의[18] 의미에 따라 모호한 단어를 판단하는 경향이 있었다.[19]즉, 형태학, 구문 또는 의미론과 연결된 상위 수준의 언어 프로세스는 음성 소리를 인식하기 위해 기본적인 음성 인식 과정과 상호 작용할 수 있다.

그것은 예를 들어 단어와 같이 더 높은 단위를 인식하기 전에 청자가 음음을 인식하는 것이 필요하지 않고 어쩌면 불가능할 수도 있다.적어도 음향신호로부터 인식된 실체의 음소체 구조에 관한 기본적인 정보를 얻은 후에, 청취자는 언어에 대한 지식을 이용하여 누락되거나 소음 마스킹된 음소를 보상할 수 있다.보상 메커니즘은 모든 관련 상향식 감각 입력이 없음에도 불구하고 학습된 노래, 구절 및 구절과 같은 문장 수준에서 작동할 수 있다.[20]

습득언어손상

음성 인식에 대한 최초의 가설은 수용성 실어증이라고도 알려진 청각 이해력 결핍증 환자들에게 사용되었다.이후 분류된 장애물이 많아 '말 인식'에 대한 진정한 정의가 도출됐다.[21]'언어 인식'이라는 용어는 탐색 프로세스에 하위 어휘적 문맥을 사용하는 관심 프로세스를 기술한다.특징, 세그먼트(phonemes), 음절 구조(발음의 단위), 음운론적 단어 형태(소리의 그룹화 방법), 문법적 특징, 모페미어(prefix and fixemes), 의미 정보(단어의 의미) 등 다양한 언어와 문법적 함수로 구성된다.초기에는 언어의 음향에 더 관심이 있었다.예를 들어, 그들은 /ba/ 또는 /da/의 차이점을 보고 있었지만, 이제 연구는 자극으로부터 뇌의 반응에 초점을 맞추고 있다.최근 몇 년 동안, 음성 인식이 어떻게 작용하는지에 대한 감각을 만들기 위해 개발된 모델이 있는데, 이 모델은 듀얼 스트림 모델이라고 알려져 있다.이 모델은 심리학자들이 인식을 바라보는 시각에서 확연히 달라졌다.이중 스트림 모델의 첫 번째 섹션은 복측 경로다.이 경로에는 중간 측두회, 하두 측두회, 그리고 아마도 하두 측두회 등이 포함된다.복측통로는 어휘적 또는 개념적 표현에 대한 음운학적 표현을 보여주는데, 이것이 단어의 의미인 것이다.이중 스트림 모델의 두 번째 섹션은 등경로다.이 경로에는 실비아의 두정맥, 하전두회, 전전두엽 및 전두피질이 포함된다.그것의 주된 기능은 감각적 또는 음운학적 자극을 받아 그것을 발현적-운동적 표현(말의 형성)으로 전달하는 것이다.[22]

실어증

실어증은 뇌 손상으로 인한 언어 처리의 손상이다.언어처리의 다른 부분은 손상된 뇌의 부위에 따라 영향을 받고 실어증은 부상 위치나 증상 별자리를 기준으로 더욱 분류된다.브로카의 뇌 부위가 손상되면 종종 언어 생산에 장애로 나타나는 실어증을 표현하게 된다.베르니케 부위의 손상은 종종 언어 처리가 손상된 수용성 실어증을 초래한다.[23]

언어지각이 손상된 실어증은 전형적으로 왼쪽 측두엽이나 두정엽에 위치한 병변이나 손상을 보여준다.어휘적, 의미론적 난이도가 일반적이며, 이해력에 영향을 미칠 수 있다.[23]

아그노시아

아그노시아는 "일반적으로 뇌 손상의 결과로 친숙한 사물이나 자극을 인식하는 능력의 상실 또는 감소"이다.[24]우리의 감각 하나하나에 영향을 미치는 여러 가지 다른 종류의 아그노시아가 있지만, 언어와 관련된 두 가지 가장 흔한 것은 언어 아그노시아와 음파노시아이다.

음성 애그노시아:순수한 단어 청각장애, 즉 언어장애는 사람이 듣거나, 말을 생산하고, 심지어 말을 읽을 수 있는 능력을 유지하지만, 그들은 말을 이해할 수 없거나 적절하게 인식하지 못하는 장애다.이러한 환자들은 말을 적절하게 처리하는데 필요한 모든 기술을 가지고 있는 것처럼 보이지만, 그들은 언어 자극과 관련된 경험이 없는 것으로 보인다.환자들은 "말하는 것은 들을 수 있지만, 번역은 할 수 없다"[25]고 보고했다.그들이 물리적으로 언어의 자극을 받아 처리하고 있음에도 불구하고, 언어의 의미를 결정하는 능력이 없으면, 그들은 근본적으로 언어를 전혀 지각할 수 없다.알려진 치료법은 발견되지 않았지만 사례연구와 실험을 통해 언어장애는 좌뇌나 양쪽 모두의 병변, 특히 오른쪽 임시변통 장애와 관련이 있는 것으로 알려져 있다.[26]

포나그노시아:Fonagnosia는 친숙한 목소리를 전혀 인식하지 못하는 것과 관련이 있다.이런 경우, 음성 자극은 들을 수 있고 심지어 이해될 수도 있지만, 특정 목소리에 대한 연설의 연관성은 없어진다.이는 "개별 음성을 구별하는 요소(timbre, 발성, 프로소디)의 복잡한 음성 특성에 대한 비정상적인 처리" 때문일 수 있다.[27]알려진 치료법은 없지만, 다른 장애들과 함께 음소거증을 경험하기 시작한 간질 여성의 사례보고가 있다.그녀의 EEG와 MRI 결과는 "가돌리늄 강화가 없고 물 분자 확산의 불연속 손상이 있는 오른쪽 피질 두정맥 T2-하이퍼린텐스 병변"을 보여주었다.[27]그래서 비록 어떤 치료법도 발견되지 않았지만, 음파노시아는 사후 두정 피질 기능 장애와 상관관계가 있을 수 있다.

유아 음성 인식

유아들은 언어 습득 과정을 언어 소리 사이의 아주 작은 차이를 감지할 수 있게 됨으로써 시작한다.그들은 가능한 모든 언어 대비를 구별할 수 있다.점차적으로, 그들이 모국어에 노출되면서, 그들의 인식은 언어에 특정한 것이 된다. 즉, 그들은 언어의 음소 범주 내에서 차이를 무시하는 방법을 배운다(예를 들어, 다른 언어에서 대조를 이룰 수 있는 차이점 - 영어는 두 개의 음성 범주의 플롯을 구분하는 반면, 태국은 세 개의 ca를 가진다.tegories; 유아는 모국어 사용에서 어떤 차이가 구별되는지, 그리고 어떤 차이가 아닌지를 반드시 배워야 한다.유아들이 들어오는 소리들을 범주로 분류하는 방법을 배우면서, 관련 없는 차이를 무시하고 대조적인 소리를 강화하는 것을 배우게 되면서, 그들의 인식은 단정적이 된다.유아들은 생후 약 6개월까지 모국어의 서로 다른 모음 음소를 대조하는 것을 배운다.자음 대조군은 생후 11개월 또는 12개월까지 획득된다.[28]일부 연구자들은 유아들이 통계학 학습이라고 불리는 과정을 이용하여 수동적인 경청을 통해 모국어의 소리 범주를 배울 수 있을 것이라고 제안했다.다른 이들은 심지어 특정 소리 범주는 선천적, 즉 유전적으로 특정된다고 주장한다(본태적 범주 대 후천적 범주적 구별성에 대한 논의 참조).

낮둥이 아기에게 정상, 비정상적으로(모노톤으로), 낯선 사람의 목소리가 제시되면 정상적으로 말하는 엄마의 목소리에만 반응한다.인간과 인간이 아닌 소리가 연주될 때 아기들은 인간의 소리 근원에만 고개를 돌린다.청각 학습은 이미 산전 시기에 시작된다는 의견이 제기되어 왔다.[29]

위에서 언급한 헤드턴 절차 외에 유아가 어떻게 언어를 인지하는지를 검사하는 데 사용되는 기술 중 하나는 유아의 흡착률을 측정하는 것이다.이런 실험에서 아기는 소리를 내면서 특별한 젖꼭지를 빨고 있다.첫째, 아기의 정상적인 빨림 속도가 확립된다.그리고 나서 자극이 반복적으로 행해진다.아기가 처음으로 자극을 들으면 빨림 속도가 증가하지만, 아기가 그 자극에 익숙해지면 빨림 속도는 감소하고 레벨이 낮아진다.그리고 나서, 아기에게 새로운 자극이 가해진다.아기가 새로 도입된 자극이 배경 자극과 다르다고 인식하면 빨기 속도가 증가한다는 것을 알 수 있을 것이다.[29]흡인율과 헤드턴 방식은 언어지각을 연구하기 위한 보다 전통적인 행동방식이다.음성 인식을 연구하는 데 도움이 되는 새로운 방법(아래 연구 방법 참조) 중에서 근적외선 분광법은 유아에게 널리 사용되고 있다.[28]

영유아의 다양한 언어의 음성 특성을 구분하는 능력은 9개월 전후로 쇠퇴하기 시작하지만, 이를 충분히 새로운 언어에 노출시킴으로써 이 과정을 되돌릴 수 있다는 사실도 밝혀졌다.Patricia K의 연구에서.쾰, 펑밍 챠오, 휴이메이 류는 중국 만다린어의 모국어 화자에 의해 유아들이 말을 하고 교류한다면, 실제로 영어에서 발견되는 언어 소리와는 매우 다른 만다린 내 다른 음성 소리를 구별할 수 있는 능력을 유지할 수 있는 조건을 갖추는 것이 발견되었다.따라서 올바른 조건을 감안할 때, 유아들이 모국어 이외의 언어로 음성을 구별할 수 있는 능력을 상실하는 것을 예방할 수 있다는 것을 증명할 수 있다.[30]

교차언어와 제2언어

많은 양의 연구는 언어 사용자들이 외국어를 어떻게 인식하는지를 연구해왔다.후자는 제2언어 습득영역에 속한다.

언어는 음소 재고량에 따라 다르다.당연히, 이것은 외국어를 접했을 때 어려움을 만들어낸다.예를 들어, 두 개의 외국어 사운드가 하나의 모국어 범주에 동화된다면, 그것들 사이의 차이는 구별하기가 매우 어려울 것이다.이러한 상황의 전형적인 예로는 일본인 영어 학습자가 /l/와 /r/를 식별하거나 구분하는데 문제가 있을 것이라는 관찰(일본어 사용자별 영어/r/ 및 /l/의 인식 참조)[31]이 있다.

베스트(1995)는 가능한 교차 언어 범주 동화 패턴을 설명하고 그 결과를 예측하는 지각 동화 모델을 제안했다.[32]플레지(1995)는 제2언어(L2) 음성 획득에 관한 여러 가지 가설을 결합한 음성 학습 모델을 공식화하였으며, 간단히 말해서 모국어(L1) 소리와 너무 비슷하지 않은 L2 사운드가 상대적으로 L1 소리와 유사한 L2 사운드에 비해 획득이 용이할 것이라고 예측하였다(이것은 인지되기 때문이다).보다 분명히 학습자에 의한 "숙고"로 간주된다.[33]

언어 또는 청각 장애

언어 또는 청각 장애를 가진 사람들이 어떻게 언어를 인지하는지에 대한 연구는 단지 가능한 치료법을 발견하기 위한 것이 아니다.그것은 비장애적 언어 인식의 기본 원리에 대한 통찰력을 제공할 수 있다.[34]두 가지 연구 분야가 하나의 예로서 작용할 수 있다.

실어증이 있는 청취자

실어증은 언어의 표현과 수신 모두에 영향을 미친다.가장 흔한 두 가지 유형인 표현 실어증과 수용성 실어증은 모두 언어 인식에 어느 정도 영향을 미친다.실어증을 표현하는 것은 언어 이해에 적당한 어려움을 야기한다.수용성 실어증이 이해에 미치는 영향은 훨씬 더 심각하다.실어증은 지각결핍으로 고통받는다는 것에 동의한다.그들은 보통 발음과 발음의 장소를 완전히 구별하지 못한다.[35]다른 특징에 대해서는 어려움이 다양하다.실어증 환자들에게 낮은 수준의 음성 인식 기술이 영향을 미치는지, 아니면 그들의 어려움이 높은 수준의 손상만으로 야기되는지는 아직 입증되지 않았다.[35]

달팽이관 삽입물이 있는 청취자

달팽이관 삽입은 감각 청각 장애가 있는 사람들의 음향 신호에 대한 접근을 복구한다.임플란트에 의해 전달되는 음향 정보는 일반적으로 임플란트 사용자가 시각적 단서가 없어도 자신이 아는 사람의 말을 제대로 인식하기에 충분하다.[36]달팽이관 이식 사용자에게는 알려지지 않은 스피커와 소리를 이해하는 것이 더 어렵다.2세 이후에 임플란트를 받은 아이들의 지각 능력은 성인기에 임플란트를 받은 어린이들에 비해 현저히 우수하다.특히, 이식 전 청각장애 지속시간, 청각장애 시작 연령, 임플란트 나이(이 같은 연령 영향은 임계기간 가설과 관련이 있을 수 있음) 및 임플란트 사용 기간 등 여러 요인들이 지각 성능에 영향을 미치는 것으로 나타났다.선천적인 청각장애와 후천적인 청각장애를 가진 아이들 사이에는 차이점이 있다.청각장애 아동은 청각장애 아동보다 더 나은 결과를 가지고 있으며 달팽이관 이식수술에 더 빨리 적응한다.[36]달팽이관 삽입술과 정상적인 청력을 가진 두 아이 모두에서 모음과 음성 시작 시간은 발음의 장소를 차별하는 능력 이전에 발달에 널리 퍼지게 된다.인공 달팽이관 이식 후 몇 달 후, 달팽이관 이식 수술을 받은 아이들은 음성 인식을 정상화할 수 있다.

잡음

언어 연구의 근본적인 문제 중 하나는 소음을 다루는 방법이다.이는 컴퓨터 인식 시스템이 가지고 있는 인간의 언어를 인식하기가 어렵다는 데서 알 수 있다.특정한 화자의 목소리와 조용한 환경에서 훈련을 받으면 말을 잘 인식할 수 있지만, 이러한 시스템들은 종종 인간이 상대적으로 어렵지 않게 말을 이해할 수 있는 좀 더 현실적인 청취 상황에서 잘 하지 못한다.정상적인 조건에서 뇌에 유지될 수 있는 처리 패턴을 모방하는 것은, 강력한 학습 이력이 연속적인 음성 신호가 완전히 없는 경우 수반되는 극단적인 마스킹 효과를 어느 정도 능가할 수 있기 때문에, 선행 지식은 주요 신경 요인이다.[20]

음악 언어 연결

음악과 인식의 관계에 대한 연구는 언어 인식의 연구와 관련된 신흥 분야다.원래 음악에 대한 신경 신호는 뇌의 우반구에 있는 전문적인 "모듈"로 처리된다는 이론이 있었다.반대로 언어에 대한 신경 신호는 좌뇌의 유사한 "모듈"에 의해 처리되도록 되어 있었다.[37]그러나 fMRI 기계와 같은 기술을 활용, 전통적으로 언어 처리만을 위한 것으로 여겨졌던 뇌의 두 영역인 브로카 영역과 베르니케 영역도 일련의 음악적 화음을 듣는 등 음악 활동 중에 활발해지는 것으로 연구결과 밝혀졌다.[37]2006년 마르키스 외 연구진이 수행한 것과 같은 다른 연구들은 6개월의 음악 훈련을 받은 8세들이 알려지지 않은 외국어를 듣기 위해 했을 때 피치 감지 성능과 전기생리학적 측정치가 모두 증가했다는 것을 보여주었다.[38]

반대로, 일부 연구는, 우리의 언어 인식에 영향을 미치는 음악보다는, 우리의 모국어가 우리의 음악 인식에 영향을 미칠 수 있다는 것을 밝혀냈다.한 예는 트리톤 역설이 있다.삼중수소 역설은 청취자에게 1/2 옥타브(또는 삼중수소) 떨어져 있는 두 개의 컴퓨터 생성 톤(C, F-Sharp 등)을 제시하여 시퀀스의 피치가 하강인지 상승인지를 결정하도록 하는 것이다.다이애나 도이치에 의해 수행된 그러한 연구 중 하나는 영국 남부에서 자란 것과 캘리포니아에서 자란 것 또는 베트남에서 온 것 그리고 모국어가 영어인 캘리포니아에서 온 것 사이의 차이를 보여주면서, 청자의 상승 또는 하강 음조의 해석은 청자의 언어나 방언에 의해 영향을 받는다는 것을 발견했다.[37]2006년에 Southern California 대학의 영어 사용자 그룹과 동아시아 학생 3 그룹을 대상으로 수행된 두 번째 연구는 5세 이전에 음악 훈련을 시작한 영어 사용자들이 완벽한 음조를 가질 확률이 8%라는 것을 발견했다.[37]

언어 현상학

언어의 경험

케이시 오캘러헌은 자신의 글 '체험 스피치'에서 듣고 있는 언어의 이해와 관련해 "말을 듣는 지각적 경험은 경이로운 성격에서 다른지"[39]를 분석한다.그는, 자신이 전혀 알지 못하는 언어를 들을 때와 달리, 그들이 이해하는 언어를 들을 때의 경험은, 그가 개인에게 "경험이 어떤 것인지에 대한 존경심"[39]이라고 정의하는 경이로운 특징의 차이를 보여준다고 주장한다.

만약 단일 언어 원어민 영어 사용자인 주체가 독일어로 연설의 자극을 받게 된다면, 일련의 음운은 단순한 소리로 나타나 독일어를 사용하는 주체에 정확히 같은 자극을 주었을 때와는 매우 다른 경험을 하게 될 것이다.

그는 또한 언어를 배울 때 언어 인식이 어떻게 변하는지 연구한다.일본어를 전혀 모르는 과목에 일본어 언어의 자극이 주어졌다가 일본어를 배운 후 정확히 똑같은 자극을 받았다면, 이 같은 개인은 극히 다른 경험을 하게 될 것이다.

연구방법

음성 인식 연구에 사용되는 방법은 대략 행동, 계산, 그리고 최근에는 신경생리학적 방법의 세 그룹으로 나눌 수 있다.

행동 방법

행동 실험은 참가자의 능동적인 역할에 기초한다. 즉, 대상자들에게 자극을 주고 그에 대한 의식적인 결정을 하도록 요청한다.이것은 식별 시험, 차별 시험, 유사성 등급 등의 형태를 취할 수 있다.이러한 유형의 실험은 청취자들이 어떻게 음성을 인지하고 분류하는지에 대한 기본적인 설명을 제공하는 데 도움이 된다.

사인파 스피치

음성 인식은 또한 사인파 스피치를 통해 분석되었는데, 이는 인간의 목소리가 원래의 스피치에 존재하는 주파수와 진폭을 모방하는 사인파로 대체되는 합성 스피치의 한 형태였다.피실험자들이 이 연설로 처음 발표될 때, 사인파 연설은 무작위 잡음으로 해석된다.그러나 대상자들에게 자극이 실제로 언어라는 것을 알게 되고, 사인파 스피치가 어떻게 인식되는지 "특이하고 거의 즉각적인 변화가 일어난다"[39]는 말을 듣게 된다.

계산 방법

컴퓨터 모델링은 또한 뇌가 어떻게 말을 처리하여 관찰된 행동을 만들어낼 수 있는지를 시뮬레이션하는데 사용되었다.컴퓨터 모델은 음성에 사용되는 음향 신호를 추출하기 위해 소리 신호 자체가 어떻게 처리되는지, 그리고 단어 인식과 같은 더 높은 수준의 과정에 음성 정보가 어떻게 사용되는지를 포함하여, 음성 인식에서 여러 가지 질문을 다루는데 사용되어 왔다.[40]

신경생리학적 방법

신경생리학적 방법은 더 직접적이고 반드시 의식(사전참가)적인 과정이 아닌 정보 활용에 의존한다.피실험자들은 다양한 유형의 과제에서 언어 자극을 받고 뇌의 반응을 측정한다.뇌 자체는 행동 반응을 통해 보이는 것보다 더 민감할 수 있다.예를 들어, 대상자는 차별 테스트에서 두 언어 소리 사이의 차이에 대해 민감성을 보이지 않을 수 있지만, 뇌 반응은 이러한 차이에 대한 민감성을 드러낼 수 있다.[28]언어에 대한 신경 반응을 측정하는 데 사용되는 방법에는 사건 관련 전위, 자기 뇌 촬영, 적외선 근분광법 등이 있다.사건 관련 잠재력에 사용되는 한 가지 중요한 반응은 불일치 부조화인데, 이는 음성 자극이 이전에 피험자가 들었던 자극과 음향적으로 다를 때 발생한다.

신경생리학적 방법은 다음과 같은 몇 가지 이유로 음성 인식 연구에 도입되었다.

행동 반응은 늦은 의식 과정을 반영할 수 있고 맞춤법과 같은 다른 시스템에 의해 영향을 받을 수 있으며, 따라서 낮은 수준의 음향 분포를 기반으로 소리를 인식하는 스피커의 능력을 가릴 수 있다.[41]

시험에 적극적으로 참여할 필요 없이 유아도 시험할 수 있다. 이 기능은 취득 과정에 대한 연구에 매우 중요하다.가능성은 독립적으로 상위 수준의 낮은 수준의 청각 과정을 관찰할 수 있거나 사람이 아닌 여부 speech[42][43]인식을 위한 특화된 모듈이나 여부 복잡한 음향 불변성( 보부족의 불변성 위에)은 recogn의 기저를 이루고 있는 possess로 오래 된 이론적 문제를 해결할 수 있다.ition 아침f [44]발성음

이론들

운동 이론

인간이 음성을 어떻게 인지하는가에 대한 연구에서 가장 초기 연구 중 일부는 Haskins 연구소의 Alvin Liberman과 그의 동료들에 의해 수행되었다.[45]그들은 음성 합성기를 사용하여 /bɑ/에서 /dɑ/까지 연속체를 따라 발음 대신 다양한 음성을 구성했다.청취자들은 어떤 소리를 들었는지 파악하고 두 가지 다른 소리를 구별해 달라는 요청을 받았다.실험 결과는 청취자들이 듣고 있는 소리가 지속적으로 다양함에도 불구하고 소리를 별개의 범주로 분류한다는 것을 보여주었다.그들은 이러한 결과를 바탕으로 인간이 음성을 식별할 수 있는 메커니즘으로서 범주형 인식의 개념을 제안했다.

다른 과제와 방법을 사용한 최근의 연구는 청취자들이 음성 인식에 대한 엄격한 범주적 설명과는 반대로 단일 음성 범주 내에서 음향 차이에 매우 민감하다는 것을 시사한다.

그 범주 지각한 데이터에 대한 이론적인 계정 제공하기 위해, Liberman과 colleagues[46]말 지각," 복잡한 발성 인코딩 연설의 인식에 생산이 연루된 동일한 과정에 의해 디코딩 되어 있다고 생각됐어"[1](이에 종합에 의한 분석이라고 한다)의 운동 이론을 일했다..예를 들어, 영어 자음 /d/는 다른 음성 맥락에 걸쳐 음향 세부 정보가 다를 수 있지만(위 참조), 청취자가 인식하는 모든 /d/는 하나의 범주(음향 치경 도광)에 속하며, 이는 "언어적 표현은 추상적, 표준적, 음성적 표현 또는 이러한 세그먼트의 근간을 이루는 몸짓"이기 때문이다..[1] 지각의 단위를 설명할 때, 리버만은 후에 발음이동작을 버리고 발음이동작에[47] 대한 신경 명령으로 나아가고 심지어 나중에 의도된 발음이동작에까지 진행되었다.[48] 따라서 "발언자의 생산을 결정하는 발음의 신경 표현은 듣는 사람이 인식하는 원위적 대상"이다.[48]이 이론은 모듈화 가설과 밀접하게 연관되어 있는데, 모듈화 가설은 선천적이고 아마도 인간 고유의 것으로 되어 있는 특수 목적 모듈의 존재를 제안한다.

이 이론은 청취자들에 의해 "어쿠스틱 신호가 의도된 몸짓으로 어떻게 번역되는지에 대한 설명을 제공할 수 없다"[49]는 점에서 비판을 받아왔다.더욱이, 언어학적으로 관련성이 있는 정보와 함께 색인 정보(예: 말하는 사람-아이덴티티)가 어떻게 인코딩/디코딩되는지는 불분명하다.

예시론

언어 인식의 예시 모델은 단어 인식과 말하기는 서로 관련이 없고, 말하는 사람 사이의 변화는 걸러내야 할 "소음"이라고 가정하는 위에서 언급한 네 가지 이론과 다르다.

예시적 기반 접근법은 청취자가 단어 인식과 말 인식 모두를 위한 정보를 저장한다고 주장한다.이 이론에 따르면, 언어소리의 특정한 예는 듣는 사람의 기억 속에 저장된다.음성 인식 과정에서, 청취자의 기억 속에 저장된 음절과 같은 기억된 예들을 들어오는 자극과 비교하여 자극이 분류될 수 있도록 한다.마찬가지로, 말을 하는 사람을 알아볼 때, 그 말을 하는 사람에 의해 생성된 말의 모든 기억의 흔적이 활성화되어 말 하는 사람의 정체성이 결정된다.이 이론을 뒷받침하는 것은 존슨에[13] 의해 보고된 몇 가지 실험으로, 우리가 말하는 사람과 친숙하거나 말하는 사람의 성별을 시각적으로 표현할 때 우리의 신호 식별이 더 정확하다는 것을 암시한다.말을 하는 사람이 예측할 수 없거나 성 정체성이 잘못되었을 때, 단어 식별의 오류율은 훨씬 더 높다.

예시 모델은 몇 가지 반대에 직면해야 하는데, 그 중 두 가지는 (1) 들은 모든 말을 저장하기에 불충분한 메모리 용량과, 들은 것을 생산하는 능력에 관한 것이며, (2) 청각적 기억처럼 들릴 말을 만들 때 말하는 사람의 자신의 발현적 제스처도 저장되거나 계산되는지 여부에 관한 것이다.[13][49]

음향 랜드마크 및 특색 있는 특징

케네스 N. 스티븐스는 음향학적 특징과 청각적 특성 사이의 관계로서 음향 랜드마크와 독특한 특징을 제안했다.이 관점에 따르면, 청취자는 수신 신호를 주파수에서 특정 이벤트인 소위 음향 랜드마크에 대해 검사하고 있으며, 수신 신호는 그러한 신호를 발생시킨 동작에 대한 정보를 전달한다.이러한 몸짓은 인간의 관절기의 용량에 의해 제한되고 청취자는 청각 상관관계에 민감하기 때문에, 불변성의 결여는 이 모델에는 존재하지 않는다.랜드마크의 음향 특성은 특색 설정의 기초가 된다.그것들의 묶음들은 독특하게 발음 부분(음절, 음절, 단어)을 명시한다.[50]

이 모델에서, 수신되는 음향 신호는 신호에서 특별한 스펙트럼 이벤트인 소위 랜드마크를 결정하기 위해 먼저 처리되는 것으로 간주된다. 예를 들어 모음은 일반적으로 첫 번째 공식의 높은 주파수로 표시되며, 자음은 신호에서 불연속성으로 지정될 수 있으며, 낮은 진폭과 중간 진폭으로 지정될 수 있다.스펙트럼의 영역을 축소하다이러한 음향 특성은 관절에서 비롯된다.실제로 소음과 같은 외부 조건 때문에 랜드마크의 개선이 필요한 경우 2차 관절 운동을 사용할 수 있다.스티븐스는 교합은 단지 제한적이고 더 나아가 체계적이며 따라서 청취자가 다룰 수 있는 신호의 예측 가능한 변화만을 야기한다고 주장한다.따라서 이 모델 내에서 불변성의 결여라고 불리는 것은 단순히 존재하지 않는다고 주장한다.

랜드마크를 분석하여 그것과 연결된 특정 관절형 사건(지점)을 결정한다.다음 단계에서는 스펙트럼 피크의 주파수, 저주파 영역의 진폭 또는 타이밍과 같은 특정 매개변수의 정신적 측정을 통해 랜드마크 근처의 신호에서 음향 신호를 추출한다.

다음 처리 단계는 음향 신호 통합과 독특한 특징의 파생으로 구성된다.이들은 관절과 관련된 이진 범주(예: [+/- 높음], [+/- 백], 모음의 경우 [+/- 소노란트], [+/- 측면], 또는 자음의 경우 [+/- 비음])이다.

이러한 특징의 묶음은 음성 세그먼트(phonemes, 음절, 단어)를 고유하게 식별한다.이 부분들은 청자의 기억 속에 저장되어 있는 어휘의 일부분이다.단위는 어휘 접근 과정에서 활성화되며, 일치 여부를 확인하기 위해 원래 신호에 매핑된다.그렇지 않을 경우 다른 후보 패턴의 시도가 또 이뤄진다.이러한 반복적인 방식에서, 청취자들은 인지된 음성 신호를 생산하는데 필요한 발현적인 사건들을 재구성한다.따라서 이것은 합성에 의한 분석이라고 할 수 있다.

따라서 이 이론은 언어 인식의 원위적인 대상이 언어의 기초가 되는 발현적 몸짓이라고 주장한다.청취자들은 그들을 언급함으로써 음성 신호를 이해한다.이 모델은 합성에 의한 분석이라고 불리는 것에 속한다.

퍼지-논리적 모델

도미니크 마사로가[51] 개발한 애매모호한 음성 인식 논리 이론은 사람들이 확률론적, 혹은 등급화된 방식으로 음성 소리를 기억한다는 것을 제안한다.그것은 사람들이 프로토타입이라고 불리는 언어의 지각 단위에 대한 설명을 기억한다고 제안한다.각 프로토타입 내에서 다양한 특징이 결합될 수 있다.그러나 형상은 단순한 이항(참 또는 거짓)이 아니라, 소리가 특정 음성 범주에 속할 가능성에 해당하는 퍼지 값이 있다.그러므로, 음성 신호를 인지할 때 우리가 실제로 듣는 것에 대한 우리의 결정은 자극 정보와 특정 프로토타입의 가치 사이의 매칭의 상대적인 선도에 기초한다.최종 결정은 복수의 특징이나 정보의 출처, 심지어 시각적 정보(McGurk 효과를 설명함)[49]에 기초한다.퍼지 논리 이론의 컴퓨터 모델은 음성 소리가 어떻게 분류되는지에 대한 이론의 예측이 인간 청취자의 행동에 대응한다는 것을 증명하기 위해 사용되어 왔다.[52]

음성 모드 가설

스피치 모드 가설은 스피치에 대한 인식은 전문적인 정신 처리를 필요로 한다는 생각이다.[53][54]음성 모드 가설은 포더의 모듈화 이론의 한 갈래다(마음의 모듈화 참조).제한된 자극이 특정 자극인 뇌의 특수 목적 영역에 의해 처리되는 수직 처리 메커니즘을 활용한다.[54]

음성 모드 가설의 두 가지 버전:[53]

- 약한 버전 – 말을 듣는 것은 언어에 대한 사전 지식을 필요로 한다.

- 강력한 버전 – 스피치 듣기는 스피치 인식을 위한 전문적인 스피치 메커니즘을 포함한다.

세 가지 중요한 실험 패러다임이 음성 모드 가설에 대한 증거를 찾기 위해 탐색에서 진화했다.이들은 이분법적인 경청, 범주적 인식, 이중적 인식이다.[53]이러한 범주의 연구를 통해, 특정 음성 모드가 아닌 복잡한 청각 처리가 필요한 청각 코드에 대한 모드가 있을 수 있다는 것을 발견했다.또한 모듈화는 지각 시스템에서 학습되는 것처럼 보인다.[53]그럼에도 불구하고 음성 모드 가설에 대한 증거와 반증거는 여전히 불분명하며 추가적인 연구가 필요하다.

직접실현론

직접실현주의 언어지각론(대부분은 캐롤 파울러와 관련됨)은 보다 일반적인 직접실현주의 이론의 일부로서, 지각은 지각되는 사건의 원위적 근원에 대한 직접적인 회복이 수반되기 때문에 우리가 세계에 대한 직접적인 인식을 가질 수 있게 해준다고 가정한다.음성 인식에 대해서는, 이 이론은 인식의 대상이 실제 발성 운동, 즉 제스처라고 주장하며, 이러한 움직임에 인과적으로 선행되는 추상적인 음소나 (운동 이론에서와 같이) 사건, 즉 의도된 몸짓이 아니라고 주장한다.청취자들은 제스처를 (운동 이론에서와 같이) 특수한 디코더에 의해서가 아니라, 음향 신호에 있는 정보가 그것을 형성하는 제스처를 지정하기 때문에 인식한다.[55]서로 다른 음성 소리를 내는 실제 발현적 제스처 자체가 음성 인식의 단위라고 주장함으로써, 이 이론은 불침투의 부족 문제를 우회한다.

참고 항목

참조

- ^ a b c d Nygaard, L.C., Pisoni, D.B. (1995). "Speech Perception: New Directions in Research and Theory". In J.L. Miller; P.D. Eimas (eds.). Handbook of Perception and Cognition: Speech, Language, and Communication. San Diego: Academic Press.

{{cite encyclopedia}}: CS1 maint : 복수이름 : 작성자 목록(링크) - ^ Klatt, D.H. (1976). "Linguistic uses of segmental duration in English: Acoustic and perceptual evidence". Journal of the Acoustical Society of America. 59 (5): 1208–1221. Bibcode:1976ASAJ...59.1208K. doi:10.1121/1.380986. PMID 956516.

- ^ Halle, M., Mohanan, K.P. (1985). "Segmental phonology of modern English". Linguistic Inquiry. 16 (1): 57–116.

{{cite journal}}: CS1 maint : 복수이름 : 작성자 목록(링크) - ^ Liberman, A.M. (1957). "Some results of research on speech perception" (PDF). Journal of the Acoustical Society of America. 29 (1): 117–123. Bibcode:1957ASAJ...29..117L. doi:10.1121/1.1908635. hdl:11858/00-001M-0000-002C-5789-A. Retrieved 2007-05-17.

- ^ a b Fowler, C.A. (1995). "Speech production". In J.L. Miller; P.D. Eimas (eds.). Handbook of Perception and Cognition: Speech, Language, and Communication. San Diego: Academic Press.

- ^ Hillenbrand, J.M., Clark, M.J., Nearey, T.M. (2001). "Effects of consonant environment on vowel formant patterns". Journal of the Acoustical Society of America. 109 (2): 748–763. Bibcode:2001ASAJ..109..748H. doi:10.1121/1.1337959. PMID 11248979. S2CID 10751216.

{{cite journal}}: CS1 maint : 복수이름 : 작성자 목록(링크) - ^ Lisker, L., Abramson, A.S. (1967). "Some effects of context on voice onset time in English plosives" (PDF). Language and Speech. 10 (1): 1–28. doi:10.1177/002383096701000101. PMID 6044530. S2CID 34616732. Retrieved 2007-05-17.

{{cite journal}}: CS1 maint : 복수이름 : 작성자 목록(링크) - ^ a b Hillenbrand, J., Getty, L.A., Clark, M.J., Wheeler, K. (1995). "Acoustic characteristics of American English vowels". Journal of the Acoustical Society of America. 97 (5 Pt 1): 3099–3111. Bibcode:1995ASAJ...97.3099H. doi:10.1121/1.411872. PMID 7759650. S2CID 10104073.

{{cite journal}}: CS1 maint : 복수이름 : 작성자 목록(링크) - ^ Houston, Derek M.; Juscyk, Peter W. (October 2000). "The role of talker-specific information in word segmentation by infants" (PDF). Journal of Experimental Psychology: Human Perception and Performance. 26 (5): 1570–1582. doi:10.1037/0096-1523.26.5.1570. PMID 11039485. Archived from the original (PDF) on 2014-04-30. Retrieved 1 March 2012.

- ^ Hay, Jennifer; Drager, Katie (2010). "Stuffed toys and speech perception". Linguistics. 48 (4): 865–892. doi:10.1515/LING.2010.027. S2CID 143639653.

- ^ a b Syrdal, A.K.; Gopal, H.S. (1986). "A perceptual model of vowel recognition based on the auditory representation of American English vowels". Journal of the Acoustical Society of America. 79 (4): 1086–1100. Bibcode:1986ASAJ...79.1086S. doi:10.1121/1.393381. PMID 3700864.

- ^ Strange, W. (1999). "Perception of vowels: Dynamic constancy". In J.M. Pickett (ed.). The Acoustics of Speech Communication: Fundamentals, Speech Perception Theory, and Technology. Needham Heights (MA): Allyn & Bacon.

- ^ a b c Johnson, K. (2005). "Speaker Normalization in speech perception" (PDF). In Pisoni, D.B.; Remez, R. (eds.). The Handbook of Speech Perception. Oxford: Blackwell Publishers. Retrieved 2007-05-17.

- ^ Trubetzkoy, Nikolay S. (1969). Principles of phonology. Berkeley and Los Angeles: University of California Press. ISBN 978-0-520-01535-7.

- ^ Iverson, P., Kuhl, P.K. (1995). "Mapping the perceptual magnet effect for speech using signal detection theory and multidimensional scaling". Journal of the Acoustical Society of America. 97 (1): 553–562. Bibcode:1995ASAJ...97..553I. doi:10.1121/1.412280. PMID 7860832.

{{cite journal}}: CS1 maint : 복수이름 : 작성자 목록(링크) - ^ a b Lisker, L., Abramson, A.S. (1970). "The voicing dimension: Some experiments in comparative phonetics" (PDF). Proc. 6th International Congress of Phonetic Sciences. Prague: Academia. pp. 563–567. Retrieved 2007-05-17.

{{cite conference}}: CS1 maint : 복수이름 : 작성자 목록(링크) - ^ Warren, R.M. (1970). "Restoration of missing speech sounds". Science. 167 (3917): 392–393. Bibcode:1970Sci...167..392W. doi:10.1126/science.167.3917.392. PMID 5409744. S2CID 30356740.

- ^ Garnes, S., Bond, Z.S. (1976). "The relationship between acoustic information and semantic expectation". Phonologica 1976. Innsbruck. pp. 285–293.

{{cite conference}}: CS1 maint : 복수이름 : 작성자 목록(링크) - ^ Jongman A, Wang Y, Kim BH (December 2003). "Contributions of semantic and facial information to perception of nonsibilant fricatives" (PDF). J. Speech Lang. Hear. Res. 46 (6): 1367–77. doi:10.1044/1092-4388(2003/106). hdl:1808/13411. PMID 14700361. Archived from the original (PDF) on 2013-06-14. Retrieved 2017-09-14.

- ^ a b Cervantes Constantino, F; Simon, JZ (2018). "Restoration and Efficiency of the Neural Processing of Continuous Speech Are Promoted by Prior Knowledge". Frontiers in Systems Neuroscience. 12 (56): 56. doi:10.3389/fnsys.2018.00056. PMC 6220042. PMID 30429778.

- ^ Poeppel, David; Monahan, Philip J. (2008). "Speech Perception: Cognitive Foundations and Cortical Implementation". Current Directions in Psychological Science. 17 (2): 80–85. doi:10.1111/j.1467-8721.2008.00553.x. ISSN 0963-7214. S2CID 18628411.

- ^ Hickok G, Poeppel D (May 2007). "The cortical organization of speech processing". Nat. Rev. Neurosci. 8 (5): 393–402. doi:10.1038/nrn2113. PMID 17431404. S2CID 6199399.

- ^ a b Hessler, Dorte; Jonkers, Bastiaanse (December 2010). "The influence of phonetic dimensions on aphasic speech perception". Clinical Linguistics and Phonetics. 12. 24 (12): 980–996. doi:10.3109/02699206.2010.507297. PMID 20887215. S2CID 26478503.

- ^ "Definition of AGNOSIA". www.merriam-webster.com. Retrieved 2017-12-15.

- ^ Howard, Harry (2017). "Welcome to Brain and Language". Welcome to Brain and Language.

- ^ Lambert, J. (1999). "Auditory Agnosia with relative sparing of speech perception". Neurocase. 5 (5): 71–82. doi:10.1093/neucas/5.5.394. PMID 2707006.

- ^ a b Rocha, Sofia; Amorim, José Manuel; Machado, Álvaro Alexandre; Ferreira, Carla Maria (2015-04-01). "Phonagnosia and Inability to Perceive Time Passage in Right Parietal Lobe Epilepsy". The Journal of Neuropsychiatry and Clinical Neurosciences. 27 (2): e154–e155. doi:10.1176/appi.neuropsych.14040073. ISSN 0895-0172. PMID 25923865.

- ^ a b c Minagawa-Kawai, Y., Mori, K., Naoi, N., Kojima, S. (2006). "Neural Attunement Processes in Infants during the Acquisition of a Language-Specific Phonemic Contrast". The Journal of Neuroscience. 27 (2): 315–321. doi:10.1523/JNEUROSCI.1984-06.2007. PMC 6672067. PMID 17215392.

{{cite journal}}: CS1 maint : 복수이름 : 작성자 목록(링크) - ^ a b Crystal, David (2005). The Cambridge Encyclopedia of Language. Cambridge: CUP. ISBN 978-0-521-55967-6.

- ^ Kuhl, Patricia K.; Feng-Ming Tsao; Huei-Mei Liu (July 2003). "Foreign-language experience in infancy: Effects of short-term exposure and social interaction on phonetic learning". Proceedings of the National Academy of Sciences. 100 (15): 9096–9101. Bibcode:2003PNAS..100.9096K. doi:10.1073/pnas.1532872100. PMC 166444. PMID 12861072.

- ^ Iverson, P., Kuhl, P.K., Akahane-Yamada, R., Diesh, E., Thokura, Y., Kettermann, A., Siebert, C. (2003). "A perceptual interference account of acquisition difficulties for non-native phonemes". Cognition. 89 (1): B47–B57. doi:10.1016/S0010-0277(02)00198-1. PMID 12499111. S2CID 463529.

{{cite journal}}: CS1 maint : 복수이름 : 작성자 목록(링크) - ^ Best, C. T. (1995). "A direct realist view of cross-language speech perception: New Directions in Research and Theory". In Winifred Strange (ed.). Speech perception and linguistic experience: Theoretical and methodological issues. Baltimore: York Press. pp. 171–204.

- ^ Flege, J. (1995). "Second language speech learning: Theory, findings and problems". In Winifred Strange (ed.). Speech perception and linguistic experience: Theoretical and methodological issues. Baltimore: York Press. pp. 233–277.

- ^ Uhler; Yoshinaga-Itano; Gabbard; Rothpletz; Jenkins (March 2011). "infant speech perception in young cochlear implant users". Journal of the American Academy of Audiology. 22 (3): 129–142. doi:10.3766/jaaa.22.3.2. PMID 21545766.

- ^ a b Csépe, V.; Osman-Sagi, J.; Molnar, M.; Gosy, M. (2001). "Impaired speech perception in aphasic patients: event-related potential and neuropsychological assessment". Neuropsychologia. 39 (11): 1194–1208. doi:10.1016/S0028-3932(01)00052-5. PMID 11527557. S2CID 17307242.

- ^ a b Loizou, P. (1998). "Introduction to cochlear implants". IEEE Signal Processing Magazine. 39 (11): 101–130. doi:10.1109/79.708543.

- ^ a b c d Deutsch, Diana; Henthorn, Trevor; Dolson, Mark (Spring 2004). "Speech patterns heard early in life influence later perception of the tritone paradox" (PDF). Music Perception. 21 (3): 357–72. doi:10.1525/mp.2004.21.3.357. Retrieved 29 April 2014.

- ^ 마키스, C 등(2007).음악가들은 비뮤지션들보다 외국어의 음치 위반을 더 잘 감지한다.행동 및 전기생리학적 증거1453-1463년 "인지 신경과학 저널, 19"

- ^ a b c O'Callaghan, Casey (2010). "Experiencing Speech". Philosophical Issues. 20: 305–327. doi:10.1111/j.1533-6077.2010.00186.x.

- ^ McClelland, J.L. & Elman, J.L. (1986). "The TRACE model of speech perception" (PDF). Cognitive Psychology. 18 (1): 1–86. doi:10.1016/0010-0285(86)90015-0. PMID 3753912. S2CID 7428866. Archived from the original (PDF) on 2007-04-21. Retrieved 2007-05-19.

- ^ Kazanina, N., Phillips, C., Idsardi, W. (2006). "The influence of meaning on the perception of speech sounds" (PDF). PNAS. Vol. 30. pp. 11381–11386. Retrieved 2007-05-19.

{{cite conference}}: CS1 maint : 복수이름 : 작성자 목록(링크)[영구적 데드링크] - ^ Gocken, J.M. & Fox R.A. (2001). "Neurological Evidence in Support of a Specialized Phonetic Processing Module". Brain and Language. 78 (2): 241–253. doi:10.1006/brln.2001.2467. PMID 11500073. S2CID 28469116.

- ^ Dehaene-Lambertz, G., Pallier, C., Serniclaes, W., Sprenger-Charolles, L., Jobert, A., & Dehaene, S. (2005). "Neural correlates of switching from auditory to speech perception" (PDF). NeuroImage. 24 (1): 21–33. doi:10.1016/j.neuroimage.2004.09.039. PMID 15588593. S2CID 11899232. Retrieved 2007-07-04.

{{cite journal}}: CS1 maint : 복수이름 : 작성자 목록(링크) - ^ Näätänen, R. (2001). "The perception of speech sounds by the human brain as reflected by the mismatch negativity (MMN) and its magnetic equivalent (MMNm)". Psychophysiology. 38 (1): 1–21. doi:10.1111/1469-8986.3810001. PMID 11321610.

- ^ Liberman, A.M., Harris, K.S., Hoffman, H.S., Griffith, B.C. (1957). "The discrimination of speech sounds within and across phoneme boundaries" (PDF). Journal of Experimental Psychology. 54 (5): 358–368. doi:10.1037/h0044417. PMID 13481283. Retrieved 2007-05-18.

{{cite journal}}: CS1 maint : 복수이름 : 작성자 목록(링크) - ^ Liberman, A.M., Cooper, F.S., Shankweiler, D.P., & Studdert-Kennedy, M. (1967). "Perception of the speech code" (PDF). Psychological Review. 74 (6): 431–461. doi:10.1037/h0020279. PMID 4170865. Retrieved 2007-05-19.

{{cite journal}}: CS1 maint : 복수이름 : 작성자 목록(링크) - ^ Liberman, A.M. (1970). "The grammars of speech and language" (PDF). Cognitive Psychology. 1 (4): 301–323. doi:10.1016/0010-0285(70)90018-6. Retrieved 2007-07-19.

- ^ a b Liberman, A.M. & Mattingly, I.G. (1985). "The motor theory of speech perception revised" (PDF). Cognition. 21 (1): 1–36. CiteSeerX 10.1.1.330.220. doi:10.1016/0010-0277(85)90021-6. PMID 4075760. S2CID 112932. Retrieved 2007-07-19.

- ^ a b c Hayward, Katrina (2000). Experimental Phonetics: An Introduction. Harlow: Longman.

- ^ Stevens, K.N. (2002). "Toward a model of lexical access based on acoustic landmarks and distinctive features" (PDF). Journal of the Acoustical Society of America. 111 (4): 1872–1891. Bibcode:2002ASAJ..111.1872S. doi:10.1121/1.1458026. PMID 12002871. Archived from the original (PDF) on 2007-06-09. Retrieved 2007-05-17.

- ^ Massaro, D.W. (1989). "Testing between the TRACE Model and the Fuzzy Logical Model of Speech perception". Cognitive Psychology. 21 (3): 398–421. doi:10.1016/0010-0285(89)90014-5. PMID 2758786. S2CID 7629786.

- ^ Oden, G.C., Massaro, D.W. (1978). "Integration of featural information in speech perception". Psychological Review. 85 (3): 172–191. doi:10.1037/0033-295X.85.3.172. PMID 663005.

{{cite journal}}: CS1 maint : 복수이름 : 작성자 목록(링크) - ^ a b c d Ingram, John. C.L. (2007). Neurolinguistics: An Introduction to Spoken Language Processing and its Disorders. Cambridge: Cambridge University Press. pp. 113–127.

- ^ a b Parker, Ellen M.; R.L. Diehl; K.R. Kluender (1986). "Trading Relations in Speech and Non-speech". Attention, Perception, & Psychophysics. 39 (2): 129–142. doi:10.3758/bf03211495. PMID 3725537.

- ^ Randy L. Diehl; Andrew J. Lotto; Lori L. Holt (2004). "Speech perception". Annual Review of Psychology. 55 (1): 149–179. doi:10.1146/annurev.psych.55.090902.142028. PMID 14744213. S2CID 937985.