음성합성

Speech synthesis음성 합성은 인간의 음성을 인공적으로 생산하는 것입니다. 이를 위해 사용되는 컴퓨터 시스템을 음성 합성기라고 하며, 소프트웨어나 하드웨어 제품으로 구현할 수 있습니다. 텍스트 음성 변환 시스템은 정상적인 언어 텍스트를 음성으로 변환합니다. 다른 시스템은 음성 변환과 같은 상징적인 언어 표현을 음성으로 변환합니다.[1] 반대의 과정은 음성 인식입니다.

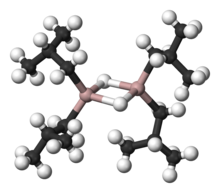

합성 음성은 데이터베이스에 저장된 녹음된 음성 조각을 연결하여 생성할 수 있습니다. 시스템은 저장된 음성 장치의 크기가 다릅니다. 전화기나 전화기를 저장하는 시스템은 가장 큰 출력 범위를 제공하지만 명확성이 부족할 수 있습니다. 특정 사용 영역의 경우 전체 단어나 문장을 저장하여 고품질 출력이 가능합니다. 대안적으로, 합성기는 완전히 "합성"된 음성 출력을 만들기 위해 성대의 모델과 다른 인간의 음성 특성을 통합할 수 있습니다.[2]

음성 합성기의 품질은 사람의 목소리와의 유사성과 명확하게 이해할 수 있는 능력으로 판단됩니다. 지능형 텍스트 음성 변환 프로그램은 시각 장애가 있거나 읽기 장애가 있는 사람들이 가정용 컴퓨터로 쓰여진 단어를 들을 수 있게 해줍니다. 많은 컴퓨터 운영 체제는 1990년대 초부터 음성 합성기를 포함하고 있습니다.

텍스트 음성 변환 시스템(또는 "엔진")은 프론트 엔드와 백 엔드의 두 부분으로 구성됩니다.[3] 프론트 엔드에는 두 가지 주요 작업이 있습니다. 먼저 숫자와 축약어 같은 기호가 포함된 원시 텍스트를 필기 단어에 해당하는 것으로 변환합니다. 이 과정을 흔히 텍스트 정규화, 전처리 또는 토큰화라고 합니다. 그런 다음 프론트엔드는 각 단어에 음성 변환을 할당하고 텍스트를 구문, 절 및 문장과 같은 운율 단위로 나누고 표시합니다. 단어에 음성 전사를 할당하는 과정을 텍스트-음소 간 변환 또는 자소-음소 간 변환이라고 합니다. 프론트 엔드에 의해 출력되는 상징적인 언어 표현은 음성 전사와 운율 정보가 함께 구성됩니다. 합성기라고도 불리는 백엔드는 상징적인 언어적 표현을 소리로 변환합니다. 특정 시스템에서 이 부분에는 목표 운율(음정 윤곽, 음소 지속 시간)의 계산이 포함되며,[4] 이 계산은 출력 음성에 부과됩니다.

역사

전자 신호 처리가 발명되기 훨씬 전에 어떤 사람들은 인간의 말을 모방하기 위해 기계를 만들려고 했습니다. "Brazen Heads"의 존재에 대한 일부 초기 전설은 교황 실베스터 2세 (1003년경), 알베르투스 마그누스 (1198–1280), 로저 베이컨 (1214–1294)을 포함합니다.

1779년, 독일-덴마크 과학자 크리스티안 고틀립 크라첸슈타인은 러시아 제국 과학 예술 아카데미에서 발표한 다섯 개의 긴 모음 소리를 낼 수 있는 인간의 성대를 만든 모델로 1등을 수상했습니다 (국제 음성 알파벳 표기법으로 [a], [e], [i ː], [o ː], [u ː], [u ː]). 1791년 논문에 기술된 헝가리 프레스부르크의 볼프강 폰 켐펠렌(Wolfgang von Kempelen)의 벨로우즈 작동 "음향 기계식 스피치 머신"이 그 뒤를 이었습니다.[6] 이 기계는 혀와 입술 모델을 추가하여 모음뿐만 아니라 자음도 생성할 수 있습니다. 1837년 찰스 휘트스톤은 폰 켐펠렌의 디자인을 바탕으로 한 "말하기 기계"를 제작했고, 1846년 조셉 파버는 "유포니아"를 전시했습니다. 1923년에 페이지는 휘트스톤의 디자인을 부활시켰습니다.[7]

1930년대에 벨 연구소는 음성을 기본적인 음색과 공명으로 자동 분석하는 보코더를 개발했습니다. 보코더에 대한 그의 작업으로부터, 호머 더들리는 그가 1939년 뉴욕 세계 박람회에서 전시했던 The Voder (음성 시연기)라고 불리는 키보드로 작동하는 음성 합성기를 개발했습니다.

프랭클린 S 박사. 쿠퍼와 해스킨스 연구소의 동료들은 1940년대 후반에 패턴 재생을 만들었고 1950년에 완성했습니다. 이 하드웨어 장치에는 여러 가지 버전이 있었지만 현재는 하나만 남아 있습니다. 이 기계는 스펙트로그램 형태의 음성 패턴 사진을 다시 소리로 변환합니다. Alvin Liberman과 동료들은 이 장치를 사용하여 음성적 분절(자음과 모음) 인지를 위한 음향 신호를 발견했습니다.

전자기기

최초의 컴퓨터 기반 음성 합성 시스템은 1950년대 후반에 시작되었습니다. 우메다 노리코(Umeda Noriko) 등은 1968년 일본 전기 기술 연구소에서 일반적인 영어 텍스트 음성 변환 시스템을 최초로 개발했습니다.[8] 1961년 물리학자 존 래리 켈리 주니어와 그의 동료 루이스 게스트먼은[9] IBM 704 컴퓨터를 사용하여 음성을 합성했는데, 이는 벨 연구소의 역사상 가장 중요한 사건 중 하나입니다.[citation needed] 켈리의 보이스 레코더 신시사이저(보코더)는 맥스 매튜스의 음악 반주와 함께 노래 "데이지 벨"을 재창조했습니다. 공교롭게도 아서 C. Clarke는 Bell Labs Murray Hill 시설에서 그의 친구이자 동료인 John Pierce를 방문하고 있었습니다. 클라크는 이 시연에 감명을 받아서 그의 소설 2001: 우주 오디세이의 극 중 클라이맥스 장면에서 [10]HAL 9000 컴퓨터가 우주비행사 데이브 보우먼이 재우는 노래와 같은 노래를 부른다고 합니다.[11] 순수 전자 음성 합성의 성공에도 불구하고 기계적 음성 합성기에 대한 연구는 계속되고 있습니다.[12][third-party source needed]

음성 코딩의 한 형태인 선형 예측 코딩(LPC)은 1966년 나고야 대학의 이타쿠라 후미타다와 일본 전신 전화(NTT)의 사이토 슈조의 연구로 개발이 시작되었습니다. LPC 기술의 추가적인 발전은 Bishnu S에 의해 이루어졌습니다. 아탈과 맨프레드 R. 1970년대 벨 연구소의 슈뢰더.[13] LPC는 이후 1978년부터 Speak & Spell 장난감에 사용된 Texas Instruments LPC Speech Chips와 같은 초기 음성 합성기 칩의 기반이 되었습니다.

1975년 이타쿠라 후미타다는 NTT에서 고압축 음성 코딩을 위한 라인 스펙트럼 쌍(LSP) 방법을 개발했습니다.[14][15][16] 1975년부터 1981년까지 이타쿠라는 LSP 방법을 기반으로 음성 분석 및 합성의 문제를 연구했습니다.[16] 1980년, 그의 팀은 LSP 기반의 음성 합성기 칩을 개발했습니다. LSP는 음성 합성과 코딩을 위한 중요한 기술로 1990년대에 거의 모든 국제 음성 코딩 표준에서 필수 구성 요소로 채택되어 모바일 채널과 인터넷을 통한 디지털 음성 통신의 향상에 기여했습니다.[15]

1975년 MUSA가 출시되었으며, 최초의 음성 합성 시스템 중 하나였습니다. 독립형 컴퓨터 하드웨어와 이탈리아어 읽기를 가능하게 하는 전문 소프트웨어로 구성되었습니다. 1978년에 발매된 두 번째 버전도 "아카펠라" 스타일로 이탈리아어를 부를 수 있었습니다.[17]

1980년대와 1990년대의 지배적인 시스템은 MIT의 Dennis Klatt의 연구에 기반을 둔 DECtalk 시스템과 Bell Labs 시스템이었으며,[18] 후자는 최초의 다국어 독립 시스템 중 하나로 자연어 처리 방법을 광범위하게 사용했습니다.

음성 합성을 특징으로 하는 핸드헬드 전자 제품은 1970년대에 등장하기 시작했습니다. 최초의 것 중 하나는 1976년 시각장애인을 위한 TSI (Telesensory Systems Inc.) Speech+ 휴대용 계산기였습니다.[19][20] 다른 기기들은 1978년 텍사스 인스트루먼트가 제작한 Speak & Spell 장난감과 같이 주로 교육적인 목적을 가지고 있었습니다.[21] 피델리티는 1979년 전자 체스 컴퓨터의 말하기 버전을 출시했습니다.[22] 음성 합성을 특징으로 하는 최초의 비디오 게임은 1980년 선 일렉트로닉스의 emup 아케이드 게임인 Stratovox(일본에서는 Speak & Rescue로 알려져 있음)입니다.[23][24] 음성 합성이 가능한 최초의 개인용 컴퓨터 게임은 1980년 PET 2001용으로 출시된 만비키 쇼우조(샵리프팅 걸)로, 이 게임의 개발자 스즈키 히로시가 합성 음성 파형을 생성하기 위해 "제로 크로스" 프로그래밍 기술을 개발했습니다.[25] 또 다른 초기 예인 Berzerk의 아케이드 버전도 1980년부터 시작되었습니다. Milton Bradley Company는 같은 해에 음성 합성을 이용한 최초의 멀티 플레이어 전자 게임인 Milton을 제작했습니다.

초기 전자 음성 합성기는 로봇처럼 들렸고 종종 거의 이해할 수 없었습니다. 합성된 음성의 품질은 꾸준히 향상되어 왔지만, 2016년[update] 현재 현대 음성 합성 시스템의 출력은 실제 인간의 음성과 분명히 구별할 수 있습니다.

합성된 목소리는 AT&T 벨 연구소의 앤 시달(Ann Syrdal)이 1990년 여성 목소리를 만들 때까지 일반적으로 남성으로 들렸습니다.[26]

커즈와일은 2005년에 비용 대비 성능 비율로 인해 음성 합성기가 저렴해지고 접근성이 향상됨에 따라 텍스트 음성 간 프로그램을 사용하여 더 많은 사람들이 혜택을 볼 것이라고 예측했습니다.[27]

신시사이저 기술

음성 합성 시스템의 가장 중요한 특성은 자연스러움과 지능입니다.[28] 자연스러움은 출력이 인간의 말처럼 얼마나 가깝게 들리는지를 설명하는 반면, 지능성은 출력을 이해하기 쉽게 하는 것입니다. 이상적인 음성 합성기는 자연스럽고 이해하기 쉽습니다. 음성 합성 시스템은 일반적으로 두 가지 특성을 모두 극대화하려고 노력합니다.

합성 음성 파형을 생성하는 두 가지 주요 기술은 연접 합성과 형성 합성입니다. 각 기술에는 장단점이 있으며, 일반적으로 합성 시스템의 의도된 용도에 따라 사용되는 방법이 결정됩니다.

연접합성

연접 합성은 녹음된 음성의 세그먼트들의 연접(함께 끈을 묶는 것)에 기초합니다. 일반적으로 연접 합성은 가장 자연스럽게 들리는 합성 음성을 생성합니다. 그러나 음성의 자연스러운 변화와 파형을 분할하는 자동화된 기술의 특성 사이의 차이로 인해 출력에 청각적 결함이 발생하는 경우가 있습니다. 연접 합성에는 크게 세 가지 하위 유형이 있습니다.

단위선택합성

단위 선택 합성은 녹음된 음성의 대규모 데이터베이스를 사용합니다. 데이터베이스를 작성하는 동안 각 녹음된 발화는 개별 전화, 전화, 하프 폰, 음절, 형태소, 단어, 구 및 문장의 일부 또는 전부로 세분화됩니다. 일반적으로 세그먼트 분할은 파형 및 스펙트로그램과 같은 시각적 표현을 사용하여 "강제 정렬" 모드로 설정된 특수 수정된 음성 인식기를 사용하여 수행됩니다.[29] 그런 다음 기본 주파수(피치), 지속 시간, 음절 내 위치 및 주변 전화 등의 음성 파라미터와 세그먼트화 및 음향 파라미터를 기반으로 음성 데이터베이스 내의 유닛의 인덱스를 생성합니다. 실행 시간에 데이터베이스로부터 후보 유닛들의 최적의 체인을 결정함으로써 원하는 목표 발화가 생성됩니다(단위 선택). 이 프로세스는 일반적으로 특수 가중치 결정 트리를 사용하여 달성됩니다.

장치 선택은 녹음된 음성에 소량의 디지털 신호 처리(DSP)만 적용하기 때문에 가장 큰 자연스러움을 제공합니다. DSP는 종종 녹음된 음성이 덜 자연스럽게 들리지만, 일부 시스템은 파형을 매끄럽게 하기 위해 연결 지점에서 소량의 신호 처리를 사용합니다. 최고의 단위 선택 시스템의 출력은 특히 TTS 시스템이 조정된 상황에서 실제 사람의 목소리와 구별할 수 없는 경우가 많습니다. 그러나 최대의 자연스러움을 위해서는 일반적으로 단위 선택 음성 데이터베이스가 매우 커야 합니다. 일부 시스템에서는 수십 시간의 음성을 나타내는 기가바이트 단위의 기록된 데이터입니다.[30] 또한 단위 선택 알고리즘은 데이터베이스에 더 나은 선택이 존재하는 경우에도 이상적인 합성보다 적은 결과(예: 사소한 단어가 불분명해지는 등)를 초래하는 장소에서 세그먼트를 선택하는 것으로 알려져 있습니다.[31] 최근 연구자들은 단위 선택 음성 합성 시스템에서 부자연스러운 부분을 감지하기 위해 다양한 자동화 방법을 제안했습니다.[32]

디폰 합성

다이폰 합성은 언어에서 발생하는 모든 다이폰(소리에서 소리로의 전환)을 포함하는 최소 음성 데이터베이스를 사용합니다. 다이폰의 수는 언어의 음성학에 따라 달라집니다: 예를 들어, 스페인어는 약 800개의 다이폰을 가지고 있고, 독일어는 약 2500개의 다이폰을 가지고 있습니다. 디폰 합성에서는 각 디폰의 한 가지 예만 음성 데이터베이스에 포함됩니다. 런타임 시, 문장의 목표 운율은 선형 예측 코딩, PSOLA[33] 또는 MBROLA와 같은 디지털 신호 처리 기술 [34]또는 이산 코사인 변환을 사용하는 소스 도메인의 피치 수정과 같은 보다 최근의 기술에 의해 이러한 최소 단위에 중첩됩니다.[35] 디폰 합성은 연접 합성의 음파 결함과 포름트 합성의 로봇 소리 특성으로 인해 어려움을 겪으며 작은 크기 외에는 두 접근법 중 하나의 장점이 거의 없습니다. 이와 같이, 자유롭게 이용할 수 있는 소프트웨어 구현이 다수 존재하기 때문에 연구에서 계속 사용되고 있지만,[citation needed] 상업용 애플리케이션에서의 사용은 감소하고 있습니다. 디폰 합성의 초기 예는 마이클 J. 프리먼에 의해 발명된 교육용 로봇 레아힘입니다.[36] Leachim은 수업 커리큘럼에 관한 정보와 그것이 가르치기 위해 프로그램된 학생들에 대한 특정한 전기 정보를 담고 있었습니다.[37] 그것은 뉴욕 브롱크스의 4학년 교실에서 시험되었습니다.[38][39]

도메인별 합성

도메인별 합성은 사전에 녹음된 단어와 구문을 연결하여 완전한 발화를 만듭니다. 시스템이 출력할 텍스트의 종류가 운송 일정 공지나 기상 보고서와 같이 특정 도메인으로 제한되는 응용 프로그램에서 사용됩니다.[40] 이 기술은 구현하기가 매우 간단하며, 말하는 시계와 계산기와 같은 장치에서 오랫동안 상업적으로 사용되어 왔습니다. 문장 유형의 다양성이 제한되어 있고, 원본 녹음의 운율과 억양이 밀접하게 일치하기 때문에 이러한 시스템의 자연스러움 수준은 매우 높을 수 있습니다.[citation needed]

이러한 시스템은 데이터베이스에 있는 단어와 구에 의해 제한되기 때문에 범용적인 시스템이 아니며 미리 프로그래밍된 단어와 구의 조합만 합성할 수 있습니다. 그러나 자연적으로 사용되는 언어 내에서 단어의 혼합은 많은 변화를 고려하지 않는 한 여전히 문제를 일으킬 수 있습니다. 예를 들어, 영어의 비로틱 방언에서 "clear" / ˈkl ɪə/와 같은 단어의 "r"은 보통 다음 단어가 첫 글자로 모음을 가질 때만 발음됩니다(예: "clear out"은 / ˌkl ɪəɹˈʌʊt/로 실현됨). 프랑스어에서도 마찬가지로, 많은 최종 자음들이 모음으로 시작하는 단어 뒤에 이어지면 더 이상 침묵하지 않게 되는데, 이를 연락이라고 합니다. 이 대안은 단순한 단어 연결 시스템으로 재현할 수 없으며, 상황에 따라 추가적인 복잡성이 필요합니다.

포름산합성

포맷 합성은 런타임에 사람의 음성 샘플을 사용하지 않습니다. 대신 합성된 음성 출력은 가산 합성과 음향 모델(물리적 모델링 합성)을 사용하여 생성됩니다.[41] 기본 주파수, 음성 및 소음 수준과 같은 매개 변수는 인공 음성의 파형을 만들기 위해 시간에 따라 달라집니다. 이 방법을 규칙 기반 합성이라고도 하지만, 많은 연결된 시스템에도 규칙 기반 구성 요소가 있습니다. 포맨트 합성 기술을 기반으로 한 많은 시스템은 인간의 말로 절대 오인되지 않는 인공적인 로봇 소리 음성을 생성합니다. 그러나 최대 자연스러움이 항상 음성 합성 시스템의 목표는 아니며, 형식 합성 시스템은 연결 시스템보다 장점이 있습니다. 포맨트 합성 음성은 매우 빠른 속도에서도 신뢰할 수 있어 일반적으로 연결 시스템을 괴롭히는 음향 결함을 피할 수 있습니다. 고속 합성 음성은 시각 장애인이 스크린 리더를 사용하여 컴퓨터를 빠르게 탐색하는 데 사용됩니다. 포맨트 합성기는 음성 샘플의 데이터베이스를 가지고 있지 않기 때문에 연결된 시스템보다 일반적으로 작은 프로그램입니다. 따라서 메모리 및 마이크로프로세서 전력이 특히 제한된 임베디드 시스템에서 사용할 수 있습니다. 포맨트 기반의 시스템은 출력 발화의 모든 측면을 완벽하게 제어하기 때문에 매우 다양한 운율과 억양을 출력할 수 있어 질문과 진술뿐만 아니라 다양한 감정과 목소리 톤을 전달할 수 있습니다.

비실시간이지만 매우 정확한 억양 제어 정보 합성의 예로는 1970년대 후반에 텍사스 인스트루먼트 장난감 Speak & Spell, 그리고 1980년대 초에 세가 아케이드 기계와[42] TMS5220 LPC 칩을 사용한 많은 아타리, Inc. 아케이드 게임에서[43] 수행된 작업이 있습니다. 이러한 프로젝트에 적합한 억양을 만드는 데는 많은 노력이 필요했으며, 결과는 아직 실시간 텍스트-음성 인터페이스와 일치하지 않습니다.[44]

조음합성

아티큘레이션 합성은 인간의 성대 모델과 그곳에서 일어나는 아티큘레이션 과정을 기반으로 음성을 합성하는 계산 기술을 말합니다. 실험실 실험에 정기적으로 사용되는 최초의 아티큘레이션 합성기는 1970년대 중반 Haskins Laboratories에서 Philip Rubin, Tom Baer, Paul Mermelstein에 의해 개발되었습니다. ASY로 알려진 이 합성기는 1960년대와 1970년대에 Bell Laboratories에서 Paul Mermelstein, Cecil Coker와 동료들에 의해 개발된 보컬 트랙 모델을 기반으로 했습니다.

최근까지 아티큘레이션 합성 모델은 상용 음성 합성 시스템에 통합되지 않았습니다. 주목할 만한 예외는 원래 캘거리 대학의 분사 회사인 트릴리움 사운드 리서치가 개발하고 판매한 NeXT 기반 시스템으로, 대부분의 원래 연구가 수행되었습니다. NeXT의 다양한 화신(1980년대 후반 스티브 잡스에 의해 시작되어 1997년 애플 컴퓨터와 합병됨)이 끝난 후, 트릴리움 소프트웨어는 GNU General Public License 하에 출판되었으며, 작업은 계속해서 그누스스피치로 진행되었습니다. 1994년에 처음 시판된 이 시스템은 Carré의 "특이적 영역 모델"에 의해 제어되는 인간 구강 및 비강의 도파관 또는 전송선 아날로그를 사용하여 완전한 아티큘레이션 기반 텍스트-음성 변환을 제공합니다.

호르헤 C에 의해 개발된 보다 최신의 합성기. Lucero와 동료들은 기관지, 기관, 비강 및 구강에서 성대 주름 생체역학, 성문 공기역학 및 음향파 전파 모델을 통합하여 물리 기반 음성 시뮬레이션의 전체 시스템을 구성합니다.[45][46]

HMM 기반 합성

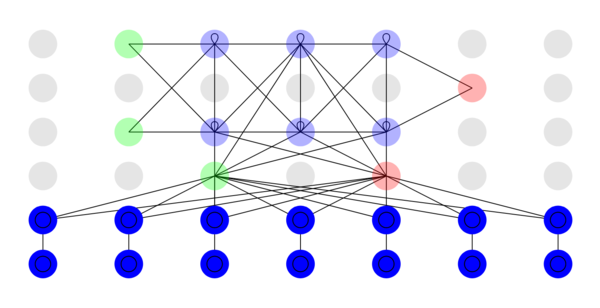

HMM 기반 합성은 은닉 마르코프 모델을 기반으로 하는 합성 방법으로, 통계적 모수 합성이라고도 합니다. 이 시스템에서 음성의 주파수 스펙트럼(vocaltract), 기본 주파수(voice source) 및 지속 시간(prosody)은 HMMs에 의해 동시에 모델링됩니다. 음성 파형은 최대 가능성 기준에 기초하여 HMMs 자체에서 생성됩니다.[47]

사인파 합성

사인파 합성은 포맨트(에너지의 주요 밴드)를 순수한 음색의 휘파람으로 대체하여 음성을 합성하는 기술입니다.[48]

딥러닝 기반 합성

딥 러닝 음성 합성은 딥 뉴럴 네트워크(DNN)를 사용하여 텍스트(텍스트-음성) 또는 스펙트럼(보코더)에서 인공 음성을 생성합니다. 심층 신경망들은 많은 양의 기록된 스피치 및 텍스트-음성 시스템의 경우, 연관된 라벨들 및/또는 입력 텍스트를 사용하여 트레이닝됩니다.

15.ai 은 다중 speaker 모델을 사용합니다. hundreds의 음성이 순차적이 아니라 동시에 훈련되기 때문에 필요한 훈련 시간이 단축되고 이러한 정서적 맥락에 노출되지 않는 음성의 경우에도 모델이 공유된 정서적 맥락을 학습하고 일반화할 수 있습니다. 응용 프로그램이 사용하는 딥 러닝 모델은 결정적이지 않습니다. 동일한 텍스트 문자열에서 음성이 생성될 때마다 음성의 억양이 조금씩 다릅니다. 또한 이 애플리케이션은 추론 중 모델의 가이드 역할을 하는 테이크의 감정을 전달하는 문장 또는 구인 감정 컨텍스트라이저(이 프로젝트에서 만든 용어)를 사용하여 생성된 라인의 감정을 수동으로 변경할 수 있도록 지원합니다.[50][51][52]

일레븐랩스는 주로 음성 감정과 억양을 합성하여 실제와 같은 음성을 생성할 수 있는 브라우저 기반의 AI 지원 텍스트 음성 변환 소프트웨어인 Speech Synthesis로 유명합니다.[53] 회사는 소프트웨어가 사용되는 언어 입력의 맥락에 따라 억양과 전달 속도를 조정하도록 구축되었다고 말합니다.[54] 고급 알고리즘을 사용하여 텍스트의 맥락적 측면을 분석하여 분노, 슬픔, 행복 또는 경보와 같은 감정을 감지하여 시스템이 사용자의 감정을 이해할 수 있도록 [55]하여 보다 현실적이고 인간다운 변곡을 만들어냅니다. 기타 기능에는 다국어 음성 생성 및 상황 인식 음성이 있는 긴 형식의 콘텐츠 생성이 포함됩니다.[56][57]

DNN 기반 음성 합성기는 사람 목소리의 자연스러움에 가까워지고 있습니다. 이 방법의 단점의 예로는 데이터가 충분하지 않을 때의 낮은 견고성, 제어 가능성 부족 및 자동 회귀 모델의 낮은 성능 등이 있습니다.

중국어나 대만어와 같은 성조 언어의 경우 요구되는 성조 산디의 수준이 다르며 때로는 음성 합성기의 출력이 성조 산디의 실수를 초래할 수도 있습니다.[58]

오디오 딥페이크

오디오 딥페이크(음성 복제라고도 함)는 특정 사람들이 말하지 않은 말을 하는 것처럼 들리는 설득력 있는 음성 문장을 만드는 데 사용되는 인공지능의 한 종류입니다.[59][60] 이 기술은 초기에 인간의 삶을 향상시키기 위한 다양한 응용을 위해 개발되었습니다. 예를 들어, 오디오북을 제작하는 데 사용할 수 있고,[61] 목병이나 다른 의학적인 문제로 인해 목소리를 잃은 사람들이 오디오북을 되찾는 것을 도울 수도 있습니다.[62][63] 상업적으로 여러 기회의 문을 열었습니다. 이 기술은 또한 보다 개인화된 디지털 비서와 자연스럽게 들리는 텍스트 음성 변환 및 음성 번역 서비스를 만들 수 있습니다.

최근 오디오 조작이라고 불리는 오디오 딥페이크는 간단한 모바일 기기나 개인용 컴퓨터를 사용하여 광범위하게 접근할 수 있게 되었습니다.[64] 이러한 도구는 오디오를 사용하여 잘못된 정보를 퍼뜨리는 데에도 사용되었습니다.[60] 이로 인해 오디오 기반 소셜 미디어 플랫폼에서 잘못된 정보와 잘못된 정보를 전파하는 역할을 포함하여 오디오 딥페이크 사용의 부작용에 대한 전 세계 대중의 사이버 보안 우려가 발생했습니다.[65] 사람들은 그것들을 프로파간다, 명예훼손 또는 테러에 대한 여론을 조작하는 데 사용할 [66]수 있는 논리적 접근 음성 스푸핑 기술로 사용할 수 있습니다. 인터넷을 통해 매일 방대한 양의 음성 녹음이 전송되고 스푸핑 탐지가 어렵습니다.[67] 오디오 딥페이크 공격자는 정치인과 정부를 포함한 개인과 조직을 표적으로 삼았습니다.[68] 2020년 초 일부 사기꾼들은 인공지능 기반 소프트웨어를 이용해 CEO의 목소리를 사칭해 전화를 통해 약 3500만 달러의 송금을 승인했습니다.[69] 2023년 글로벌 McAfee 조사에 따르면 10명 중 1명이 AI 음성 복제 사기의 표적이 되었다고 보고했습니다. 이러한 표적의 77%가 사기로 인해 손실을 입었다고 보고했습니다.[70][71] 오디오 딥페이크는 현재 금융 소비자에게 배치된 음성 ID 시스템에도 위험을 초래할 수 있습니다.[72][73]2023년, 부사장 기자 조셉 콕스(Joseph Cox)는 자신이 말하는 5분을 녹음한 다음 일레븐랩스(ElevenLabs)가 개발한 도구를 사용하여 은행의 음성 인증 시스템을 물리치는 음성 딥페이크를 만들었다는 연구 결과를 발표했습니다.[74]

과제들

텍스트 정규화 과제

텍스트를 정규화하는 과정은 거의 간단하지 않습니다. 텍스트는 모두 음성 표현으로 확장해야 하는 이질적인 용어, 숫자 및 약어로 가득 차 있습니다. 영어에는 문맥에 따라 다르게 발음되는 철자가 많습니다. 예를 들어, "나의 최근 프로젝트는 내 목소리를 더 잘 투영하는 방법을 배우는 것입니다"는 "프로젝트"의 두 가지 발음을 포함합니다.

대부분의 TTS(Text To Speech) 시스템은 입력 텍스트의 의미론적 표현을 생성하지 않는데, 이는 입력 텍스트를 위한 프로세스가 신뢰할 수 없고, 제대로 이해되지 않으며, 계산적으로 비효율적이기 때문입니다. 따라서 호모그래프의 명확성을 추정하기 위해서는 이웃 단어를 분석하고 발생 빈도에 대한 통계를 사용하는 등 다양한 휴리스틱 기법이 사용됩니다.

최근 TTS 시스템은 HMM을 사용하여 (위에서 논의한) 호모그래피를 명확하게 하는 데 도움이 되는 "말의 일부"를 생성하기 시작했습니다. 이 기술은 "읽기"가 과거 시제를 암시하는 "빨간색"으로 발음되어야 하는지, 아니면 현재 시제를 암시하는 "빨갱이"로 발음되어야 하는지와 같은 많은 경우에 상당히 성공적입니다. 이러한 방식으로 HMM을 사용할 때 일반적인 오류율은 일반적으로 5% 미만입니다. 이러한 기술은 대부분의 유럽 언어에서도 잘 작동하지만 이러한 언어에서는 필수 교육 코퍼스에 액세스하는 것이 종종 어렵습니다.

숫자를 변환하는 방법을 결정하는 것은 TTS 시스템이 해결해야 할 또 다른 문제입니다. 숫자를 단어로 변환하는 것은 간단한 프로그래밍 도전입니다. 예를 들어, "1325"가 "1천 3백 25"가 되는 것처럼 말입니다. 그러나 숫자는 다양한 맥락에서 발생합니다; "1325"는 "하나의 3 2 5", "13 25" 또는 "13 25"로 읽힐 수도 있습니다. TTS 시스템은 종종 주변 단어, 숫자 및 구두점을 기반으로 숫자를 확장하는 방법을 추론할 수 있으며, 때때로 시스템은 컨텍스트가 모호할 경우 컨텍스트를 지정하는 방법을 제공합니다.[75] 로마 숫자도 문맥에 따라 다르게 읽을 수 있습니다. 예를 들어, "헨리 8세"는 "헨리 8세"로 읽히고, "Chapter VIII"는 "Chapter Eight"로 읽습니다.

마찬가지로 약어도 모호할 수 있습니다. 예를 들어, "inches"의 약자 "in"은 "in"이라는 단어와 구별되어야 하며, 주소 "12 St John St."는 "Saint"와 "Street"의 약자를 동일하게 사용합니다. 지능형 프론트 엔드가 있는 TTS 시스템은 모호한 약어에 대해 교육적인 추측을 할 수 있지만, 다른 시스템은 모든 경우에 동일한 결과를 제공하여 "Ulyssess S. Grant"와 같이 무의미한(그리고 때로는 코믹한) 결과물이 "Ulyssess South Grant"로 렌더링됩니다.

텍스트에서 전화로 연결하는 문제

음성 합성 시스템은 단어의 철자를 기반으로 단어의 발음을 결정하기 위해 두 가지 기본적인 접근법을 사용합니다. 이 과정은 종종 텍스트-음소 또는 자소-음소 변환(음소는 언어학자들이 언어의 독특한 소리를 설명하기 위해 사용하는 용어)이라고 불립니다. 텍스트에서 음소로의 변환에 대한 가장 간단한 접근 방식은 사전 기반 접근 방식으로, 한 언어의 모든 단어와 올바른 발음을 포함하는 큰 사전이 프로그램에 의해 저장됩니다. 각 단어의 올바른 발음을 결정하는 것은 사전에서 각 단어를 찾아보고 사전에 명시된 발음으로 철자를 대체하는 문제입니다. 다른 접근 방식은 단어에 발음 규칙을 적용하여 철자에 따라 발음을 결정하는 규칙 기반입니다. 이것은 읽기 학습에 대한 "사운드 아웃", 즉 합성 파닉스의 접근법과 유사합니다.

각 접근 방식에는 장점과 단점이 있습니다. 사전 기반 접근 방식은 빠르고 정확하지만 사전에 없는 단어가 주어지면 완전히 실패합니다. 사전 크기가 증가함에 따라 합성 시스템의 메모리 공간 요구 사항도 증가합니다. 반면 규칙 기반 접근 방식은 어떤 입력에도 적용되지만 규칙의 복잡성은 불규칙한 철자나 발음을 고려하면서 크게 증가합니다. (영어에서 "of"라는 단어는 매우 일반적이지만 "f"가 [v]]로 발음되는 유일한 단어임을 고려하십시오.) 결과적으로 거의 모든 음성 합성 시스템은 이러한 접근 방식을 조합하여 사용합니다.

음소 맞춤법이 있는 언어는 매우 규칙적인 쓰기 시스템을 가지고 있으며 철자를 기반으로 단어의 발음을 예측하는 것은 상당히 성공적입니다. 이러한 언어에 대한 음성 합성 시스템은 종종 규칙 기반 방법을 광범위하게 사용하며, 발음이 철자에서 명확하지 않은 외국 이름 및 외래어와 같은 소수의 단어에 대해서만 사전에 의존합니다. 반면에 영어와 같은 언어의 음성 합성 시스템은 철자 체계가 매우 불규칙적이어서 사전에 의존할 가능성이 높고, 특이한 단어나 사전에 없는 단어에 대해서만 규칙 기반 방법을 사용할 가능성이 높습니다.

평가 과제

음성 합성 시스템의 일관된 평가는 보편적으로 합의된 객관적인 평가 기준이 부족하기 때문에 어려울 수 있습니다. 조직마다 다른 음성 데이터를 사용하는 경우가 많습니다. 음성 합성 시스템의 품질은 (아날로그 또는 디지털 녹음을 포함할 수 있는) 제작 기술의 품질과 음성 재생에 사용되는 시설에 따라 달라집니다. 따라서 음성 합성 시스템을 평가하는 것은 종종 제작 기술과 재생 시설 간의 차이로 인해 손상되어 왔습니다.

그러나 2005년 이후 일부 연구자들은 공통된 음성 데이터 세트를 사용하여 음성 합성 시스템을 평가하기 시작했습니다.[76]

프로소딕과 감성적인 내용

영국 포츠머스 대학의 Amy Drahota와 동료들의 Speech Communication 저널의 한 연구는 음성 녹음을 듣는 사람들이 화자가 웃고 있는지 아닌지를 우연한 수준 이상으로 더 잘 판단할 수 있다고 보고했습니다.[77][78][79] 감정적인 내용을 신호하는 목소리의 특징을 식별하는 것은 합성된 말이 더 자연스럽게 들리게 하는 데 도움이 될 수 있다고 제안했습니다. 이와 관련된 문제 중 하나는 긍정문, 의문문 또는 감탄문인지에 따라 문장의 음정 윤곽을 수정하는 것입니다. 피치 수정을[80] 위한 기술 중 하나는 소스 도메인(선형 예측 잔차)에서 이산 코사인 변환을 사용합니다. 이러한 피치 동기 피치 수정 기법들은 음성 영역들의 통합 선형 예측 잔차 상에 적용되는 동적 플러싱 인덱스를 이용한 에포크 추출과 같은 기법들을 이용하여 합성 음성 데이터베이스의 선험적 피치 마킹을 필요로 합니다.[81]

전용 하드웨어

- 아이코폰

- 일반계기 SP0256-AL2

- National Semiconductor DT1050 Digitalker (Mozer – Forres Mozer)

- 텍사스 인스트루먼트 LPC 음성 칩[82]

하드웨어 및 소프트웨어 시스템

음성 합성을 내장된 기능으로 제공하는 대중적인 시스템입니다.

텍사스 인스트루먼트

1980년대 초, TI는 음성 합성의 선구자로 알려졌으며, TI-99/4 및 4A에 매우 인기 있는 플러그인 음성 합성기 모듈을 사용할 수 있었습니다. 스피치 신시사이저는 여러 카트리지를 구입하면 무료로 제공되었으며 TI가 작성한 많은 비디오 게임(이 프로모션 기간 동안 스피치와 함께 제공되는 게임에는 알피너와 파섹이 포함됩니다)에서 사용되었습니다. 합성기는 선형 예측 코딩의 변형을 사용하며 작은 내장 어휘를 가지고 있습니다. 원래 의도는 신디사이저 장치에 직접 연결된 작은 카트리지를 출시하여 장치의 내장 어휘를 증가시키는 것이었습니다. 그러나 Terminal Emulator II 카트리지에서 소프트웨어 텍스트 음성 변환이 성공하면서 이 계획이 취소되었습니다.

마텔

1982년 Mattel Intellivision 게임 콘솔은 Intellivoice Voice Synthesis 모듈을 제공했습니다. 탈착식 카트리지에 SP0256 Narator 음성 합성기 칩이 포함되어 있습니다. 내레이터는 2kB의 ROM(Read-Only Memory)을 가지고 있었는데, 이를 활용하여 Intellivision 게임에서 문구를 만드는 데 사용할 수 있는 일반 단어의 데이터베이스를 저장했습니다. 오레이터 칩은 외부 메모리에서 음성 데이터를 수신할 수도 있기 때문에 추가로 필요한 단어나 구를 카트리지 내부에 저장할 수 있습니다. 데이터는 단순 디지털화된 샘플이 아닌 칩의 합성 보컬-트랙트 모델의 동작을 수정하기 위해 아날로그-필터 계수의 문자열로 구성되었습니다.

샘.

또한 1982년에 출시된 Software Automatic Mouth는 최초의 상업적인 모든 소프트웨어 음성 합성 프로그램이었습니다. 나중에 Macintalk의 기초로 사용되었습니다. 이 프로그램은 매킨토시가 아닌 애플 컴퓨터(애플 II, 리사 포함), 다양한 아타리 모델, 코모도어 64에 사용할 수 있었습니다. 애플 버전은 DAC가 포함된 추가 하드웨어를 선호했지만 카드가 없을 경우 컴퓨터의 1비트 오디오 출력을 사용할 수 있습니다. Atari는 내장된 POKEY 오디오 칩을 사용했습니다. Atari의 음성 재생은 일반적으로 음성 출력 중에 인터럽트 요청을 비활성화하고 안티칩을 종료합니다. 화면을 켜면 음성 출력이 극도로 왜곡됩니다. 코모도어 64는 64에 내장된 SID 오디오 칩을 사용했습니다.

아타리

운영 체제에 통합된 최초의 음성 시스템은 1983년 Atari사에서 Votrax SC01 칩을 사용하여 설계한 1400XL/1450XL 개인용 컴퓨터입니다. 1400XL/1450XL 컴퓨터는 유한 상태 기계를 사용하여 세계 영어 철자법 텍스트-음성 합성을 가능하게 했습니다.[83] 유감스럽게도 1400XL/1450XL 개인용 컴퓨터는 수량을 출고한 적이 없습니다.

Atari ST 컴퓨터는 플로피 디스크에 "stspeech.tos"와 함께 판매되었습니다.

사과

운영체제에 통합된 최초의 음성 시스템은 애플 컴퓨터의 맥인톡(MacInTalk)이었습니다. 이 소프트웨어는 타사 개발자인 Joseph Katz와 Mark Barton (후에 SoftVoice, Inc.)로부터 라이선스를 받았으며 1984년 매킨토시 컴퓨터가 소개되는 동안 등장했습니다. 이 1월 데모에는 512킬로바이트의 RAM 메모리가 필요했습니다. 결과적으로, 그것은 최초로 출고된 맥의 128 킬로바이트 RAM에서 실행될 수 없었습니다.[84] 그래서 데모는 512k Mac 시제품으로 이루어졌지만, 참석자들은 이 사실을 설명받지 못했고 합성 데모는 Macintosh에게 상당한 흥미를 불러일으켰습니다. 1990년대 초반에 Apple은 시스템 전체의 텍스트 음성 지원을 제공하는 기능을 확장했습니다. 더 빠른 PowerPC 기반 컴퓨터가 도입되면서 더 높은 품질의 음성 샘플링이 포함되었습니다. 애플은 또한 유동적인 명령어 세트를 제공하는 시스템에 음성 인식을 도입했습니다. 보다 최근에, 애플은 샘플 기반의 음성을 추가했습니다. 호기심으로 시작한 애플 매킨토시의 스피치 시스템은 시력에 문제가 있는 사람들을 위해 완벽하게 지원되는 프로그램인 플레인토크로 발전했습니다. VoiceOver는 2005년 Mac OS X Tiger(10.4)에 처음으로 등장했습니다. 10.4 (호랑이)와 10.5 (표범)의 첫 출시 동안 맥 OS X는 단 하나의 표준 음성 전송만 있었습니다. 10.6 (눈표범)부터 시작하여 사용자는 다양한 음성 목록 중에서 선택할 수 있습니다. VoiceOver 음성은 문장 사이에서 사실적으로 들리는 호흡을 취하는 것뿐만 아니라 플레인토크보다 높은 읽기 속도에서 선명도를 향상시키는 것이 특징입니다. Mac OS X에는 텍스트를 가청 음성으로 변환하는 명령줄 기반 응용 프로그램인 say도 포함되어 있습니다. AppleScript Standard Additions에는 스크립트가 설치된 음성을 사용하고 음성 텍스트의 음정, 음성 속도 및 변조를 제어할 수 있는 say 동사가 포함되어 있습니다.

아마존

Alexa에서는 Software as a Service로, AWS에서는[85] Software as a Service(2017년부터)로 사용됩니다.

아미가OS

고급 음성 합성 기능을 갖춘 두 번째 운영 체제는 1985년에 도입된 AmigaOS였습니다. 이 음성 합성은 SoftVoice, Inc.의 Commodore International에 의해 라이선스되었으며, 그는 또한 원래의 MacinTalk 텍스트 음성 변환 시스템을 개발했습니다. American English를 위한 완전한 음성 에뮬레이션 시스템을 특징으로 하며, 남성과 여성의 음성과 "스트레스" 표시 표시기가 모두 아미가의 오디오 칩셋을 통해 가능하게 했습니다.[86] 합성 시스템은 제한되지 않은 영어 텍스트를 표준 음성 코드 세트로 변환하는 번역기 라이브러리와 음성 생성 모델을 구현하는 내레이터 장치로 구분되었습니다. 아미가OS는 또한 높은 수준의 "Speak Handler"를 사용하여 명령 줄 사용자가 텍스트 출력을 음성으로 리디렉션할 수 있습니다. 음성 합성은 타사 프로그램, 특히 워드 프로세서와 교육용 소프트웨어에서 때때로 사용되었습니다. 합성 소프트웨어는 첫 번째 아미가와 크게 변하지 않았습니다.OS 릴리스와 코모도어는 결국 아미가OS 2.1 이후의 음성 합성 지원을 제거했습니다.

미국의 영어 음소 제한에도 불구하고 다국어 음성 합성이 가능한 비공식 버전이 개발되었습니다. 이것은 각 언어에 대한 일련의 규칙이 주어지면 여러 언어를 번역할 수 있는 향상된 버전의 번역기 라이브러리를 사용했습니다.[87]

마이크로소프트 윈도우

최신 윈도우즈 데스크톱 시스템은 SAPI 4 및 SAPI 5 구성 요소를 사용하여 음성 합성 및 음성 인식을 지원할 수 있습니다. SAPI 4.0은 Windows 95 및 Windows 98용 옵션 추가 기능으로 사용할 수 있었습니다. Windows 2000에는 시각 장애가 있는 사람들을 위한 텍스트 음성 변환 유틸리티인 Narator가 추가되었습니다. JAWS for Windows, Window-Eyes, Non-Visual Desktop Access, Supernova 및 System Access와 같은 타사 프로그램은 지정된 웹 사이트, 이메일 계정, 텍스트 문서, Windows 클립보드, 사용자의 키보드 타이핑 등에서 텍스트를 크게 읽는 작업과 같은 다양한 텍스트 음성 변환 작업을 수행할 수 있습니다. 모든 프로그램이 음성 합성을 직접 사용할 수 있는 것은 아닙니다.[88] 일부 프로그램은 플러그인, 확장 또는 추가 기능을 사용하여 텍스트를 크게 읽을 수 있습니다. 시스템 클립보드에서 텍스트를 읽을 수 있는 타사 프로그램을 사용할 수 있습니다.

Microsoft Speech Server는 음성 합성 및 인식을 위한 서버 기반 패키지입니다. 웹 애플리케이션 및 콜센터와 네트워크 사용을 위해 설계되었습니다.

보트락스

1971년부터 1996년까지 Votrax는 여러 상업용 음성 합성기 부품을 생산했습니다. Votrax 신시사이저는 시각장애인을 위한 1세대 Kurzweil Reading Machine에 포함되었습니다.

텍스트 음성 변환 시스템

TTS(Text To Speech)는 컴퓨터가 텍스트를 크게 읽을 수 있는 능력을 말합니다. TTS 엔진은 작성된 텍스트를 음소 표현으로 변환한 다음 음소 표현을 소리로 출력할 수 있는 파형으로 변환합니다. 언어, 방언 및 전문 어휘가 다른 TTS 엔진은 타사 게시자를 통해 사용할 수 있습니다.[89]

안드로이드

안드로이드 버전 1.6은 음성 합성(TTS) 지원을 추가했습니다.[90]

인터넷

현재 전자 메일 클라이언트에서 직접 메시지를 읽을 수 있는 응용 프로그램, 플러그인 및 가젯과 웹 브라우저 또는 구글 툴바에서 웹 페이지를 읽을 수 있습니다. 일부 전문 소프트웨어는 RSS 피드를 설명할 수 있습니다. 한편, 온라인 RSS 내레이터는 사용자가 좋아하는 뉴스 소스를 듣고 팟캐스트로 변환할 수 있도록 하여 정보 전달을 단순화합니다. 반면 온라인 RSS 판독기는 인터넷에 연결된 거의 모든 개인용 컴퓨터에서 사용할 수 있습니다. 사용자는 팟캐스트 수신기의 도움을 받아 생성된 오디오 파일을 휴대용 장치에 다운로드할 수 있고, 걷거나 조깅을 하거나 직장으로 출퇴근하면서 들을 수 있습니다.

인터넷 기반 TTS 분야에서 성장하고 있는 분야는 웹 기반 보조 기술(예: 영국 회사의 'Browsealoud'와 Readspeaker)입니다. 웹 브라우저에 액세스할 수 있는 모든 사람에게(접근성, 편리성, 엔터테인먼트 또는 정보의 이유로) TTS 기능을 제공할 수 있습니다. 비영리 프로젝트인 페디아폰은 2006년에 위키백과와 유사한 웹 기반 TTS 인터페이스를 제공하기 위해 만들어졌습니다.[91]

다른 작업은 BBC와 Google Inc.의 참여 하에 W3C 오디오 인큐베이터 그룹을 통해 W3C의 맥락에서 수행되고 있습니다.

오픈소스

다음과 같은 일부 오픈 소스 소프트웨어 시스템을 사용할 수 있습니다.

- 다양한 언어를 지원하는 eSpeak.

- 디폰 기반의 합성 및 보다 현대적이고 더 나은 사운드 기술을 사용하는 축제 음성 합성 시스템.

- 자유 소프트웨어 재단의 아티큘레이션[92] 합성을 사용하는 그누스 스피치

다른이들

- 하드웨어 기반 인텔리보이스의 상업적 실패 이후, 게임 개발자들은 이후 게임에서[citation needed] 소프트웨어 합성을 거의 사용하지 않았습니다. 아타리 5200 (베이스볼), 아타리 2600 (쿼드런 및 오픈 세서미)와 같은 아타리의 초기 시스템에도 소프트웨어 합성을 사용한 게임이 있었습니다.[citation needed]

- Amazon Kindle, Samsung E6, PocketBook eReader Pro, EnTourage eDGe, 그리고 Bebook Neo와 같은 일부 전자책 리더기들.

- BBC Micro는 Texas Instruments TMS5220 음성 합성 칩을 통합했습니다.

- 1979년과 1981년에 생산된 텍사스 인스트루먼트 가정용 컴퓨터의 일부 모델(텍사스 인스트루먼트 TI-99/4 및 TI-99/4A)은 매우 인기 있는 Speech Synthsizer 주변 장치를 사용하여 텍스트에서 음소로 합성하거나 완전한 단어와 구(텍스트에서 사전)를 암송할 수 있었습니다. TI는 독점 코덱을 사용하여 주로 비디오 게임과 같은 애플리케이션에 완전한 음성 문구를 내장했습니다.[93]

- IBM의 OS/2 Warp 4에는 IBM ViaVoice의 전신인 VoiceType이 포함되었습니다.

- 가민, 마젤란, 톰톰 등이 제작한 GPS 내비게이션 장치는 자동차 내비게이션에 음성 합성을 사용합니다.

- Yamaha는 1999년에 FS1R이라는 포맨트 합성 기능을 포함한 음악 합성기를 제작했습니다. 최대 512개의 개별 모음 및 자음 형식의 시퀀스를 저장하고 재생할 수 있어 짧은 보컬 구문을 합성할 수 있습니다.

디지털 사운드-좋아요

2018년 신경정보처리시스템(NeurIPS) 컨퍼런스에서 구글 연구진은 텍스트-음성 합성을 달성하기 위해 학습을 스피커 검증에서 멀티스피커 텍스트-음성 합성으로 전환하는 작업 '학습을 스피커 검증에서 멀티스피커 텍스트-음성 합성으로 전환'을 발표했습니다. 단 5초의 음성 샘플에서 거의 모든 사람처럼 들리게 만들 수 있습니다.[94]

또한 바이두 리서치의 연구원들은 2018년 뉴어에서 비슷한 목표를 가진 음성 복제 시스템을 발표했습니다.IPS 컨퍼런스,[95] 결과는 다소 설득력이 없습니다.

2019년까지 시만텍 연구원들이 디지털 사운드 라이크 기술이 범죄에 사용된 3건의 사례를 알고 있듯이 디지털 사운드 라이크는 범죄자들의 손에 잡혔습니다.[96][97]

이것은 사실과 함께 허위 정보 상황에 대한 스트레스를 증가시킵니다.

- 2000년대 초반부터 인간의 이미지 합성은 실제 카메라로 촬영한 인간의 시뮬레이션과 실제 카메라로 촬영한 인간을 구분하지 못하는 수준을 넘어 향상되었습니다.

- 기존 2D 영상에서 표정을 거의 실시간으로 위조할 수 있는 2D 영상 위조 기법이 2016년에 제시되었습니다.[98]

- SIGGRAPH 2017에서는 워싱턴 대학교 연구원들이 버락 오바마의 상반신을 오디오로 구동한 디지털 룩을 선보였습니다. 음성과 함께 2D 영상으로 구성된 훈련 자료에서 립싱크와 더 넓은 얼굴 정보를 획득하기 위한 훈련 단계가 완료된 후 애니메이션의 소스 데이터로 음성 트랙으로만 구동되었습니다.[99]

2020년 3월, 다양한 미디어 소스에서 다양한 가상 캐릭터에서 고품질 음성을 생성하는 프리웨어 웹 애플리케이션 15.ai 이 출시되었습니다. 초기 등장인물에는 포털의 글라도스, 마이 리틀 포니: 우정은 마술입니다, 닥터 후의 열 번째 닥터가 포함되었습니다.

음성합성 마크업 언어

XML 호환 형식으로 텍스트를 음성으로 재생하기 위한 여러 마크업 언어가 확립되었습니다. 가장 최근의 것은 2004년에 W3C 권장 사항이 된 SSML(Speech Synthesis Markup Language)입니다. 오래된 음성 합성 마크업 언어로는 자바 음성 마크업 언어(JSML)와 SABLE이 있습니다. 이들 각각이 표준으로 제안되었지만, 어느 것도 널리 채택되지 않았습니다.[citation needed]

음성 합성 마크업 언어는 대화 마크업 언어와 구별됩니다. 예를 들어 VoiceXML에는 텍스트-음성 마크업 외에도 음성 인식, 대화 관리 및 터치 톤 전화 걸기와 관련된 태그가 포함됩니다.[citation needed]

적용들

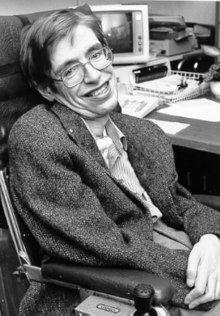

음성 합성은 오랫동안 중요한 보조 기술 도구였으며 이 분야에서의 응용은 중요하고 광범위합니다. 다양한 장애를 가진 사람들을 위해 환경 장벽을 제거할 수 있습니다. 가장 긴 응용 프로그램은 시각 장애가 있는 사람들을 위한 스크린 리더 사용이었지만, 텍스트 음성 변환 시스템은 이제 난독증 및 기타 읽기 장애가 있는 사람들과 글을 읽고 쓰기 전의 어린이들에 의해 일반적으로 사용됩니다.[101] 그들은 또한 일반적으로 전용 음성 출력 통신 보조 장치를 통해 심각한 언어 장애를 가진 사람들을 돕기 위해 자주 사용됩니다.[102] 개인의 성격이나 역사적 목소리와 더 잘 일치하도록 합성 음성을 개인화하는 작업이 가능해지고 있습니다.[103] 음성 합성의 주목할 만한 응용 분야는 Haskins Laboratories의 연구에 기반한 텍스트 음성 변환 소프트웨어와 Votrax가 구축한 블랙박스 합성기를 통합한 Kurzweil Reading Machine for the Blind였습니다.[104]

음성 합성 기술은 게임 및 애니메이션과 같은 엔터테인먼트 제작에도 사용됩니다. 2007년, Animo Limited는 사용자 사양에 따라 내레이션 및 대사를 생성할 수 있는 엔터테인먼트 산업의 고객을 위해 명시적으로 설계된 음성 합성 소프트웨어 FineSpeech를 기반으로 한 소프트웨어 응용 프로그램 패키지 개발을 발표했습니다.[105] 이 애플리케이션은 2008년 NEC Biglobe가 일본 애니메이션 시리즈인 Code Geass: Lelouch of the Rebellion R2의 등장인물들의 목소리로 문구를 만들 수 있는 웹 서비스를 발표했을 때 만기에 이르렀습니다. 15.ai 은 다양한 팬덤에서 콘텐츠 제작에 자주 사용되어 왔습니다. My Little Pony: Friendship Is Magic 팬덤, Team Fortress 2 팬덤, Portal 팬덤, SpongeBob SquarePants 팬덤을 포함합니다.[107]

최근 몇 년 동안 장애 및 장애 의사 소통 보조 장치에 대한 문자 음성 변환이 널리 사용되고 있습니다. 텍스트 음성 변환은 또한 새로운 응용 프로그램을 찾고 있습니다. 예를 들어 음성 인식과 결합된 음성 합성은 자연 언어 처리 인터페이스를 통해 모바일 장치와의 상호 작용을 가능하게 합니다. 일부 사용자는 15.ai 및 외부 음성 제어 소프트웨어를 사용하여 AI 가상 비서를 만들었습니다.

텍스트 음성 변환은 제2외국어 습득에도 사용됩니다. 예를 들어, Voki는 Oddcast가 개발한 교육 도구로, 사용자가 다양한 억양을 사용하여 자신만의 말하는 아바타를 만들 수 있습니다. 이메일, 웹사이트에 포함되거나 소셜 미디어에서 공유할 수 있습니다.

콘텐츠 제작자들은 일레븐랩스의 음성 복제 도구를 사용하여 팟캐스트,[110][111] 내레이션 [112]및 코미디 쇼를 위해 목소리를 재생했습니다.[113][114][115] 출판사와 저자들은 오디오북과 뉴스레터의 내레이션을 위해 일레븐랩스를 사용하기도 했습니다.[116][117]

또 다른 응용 분야는 말하는 머리가 있는 AI 비디오 제작입니다. Elai.io 또는 Synthsia와 같은 웹 앱과 비디오 편집기는 사용자가 텍스트 대 speech 기술을 사용하여 말하는 AI 아바타와 관련된 비디오 콘텐츠를 만들 수 있도록 합니다.

또한 음성 합성은 음성 장애 분석 및 평가를 위한 귀중한 계산 도움이 됩니다. 호르헤 C가 개발한 음성 품질 합성기. Brazilia 대학의 Lucero et al.은 음운의 물리학을 시뮬레이션하고 성대 주파수 지터와 떨림, 기류 소음 및 후두 비대칭 모델을 포함합니다.[45] 합성기는 거칠기, 통기성 및 변형률 수준이 제어된 디스포닉 스피커의 음색을 모방하는 데 사용되었습니다.[46]

가창합성

참고 항목

참고문헌

- ^ Allen, Jonathan; Hunnicutt, M. Sharon; Klatt, Dennis (1987). From Text to Speech: The MITalk system. Cambridge University Press. ISBN 978-0-521-30641-6.

- ^ Rubin, P.; Baer, T.; Mermelstein, P. (1981). "An articulatory synthesizer for perceptual research". Journal of the Acoustical Society of America. 70 (2): 321–328. Bibcode:1981ASAJ...70..321R. doi:10.1121/1.386780.

- ^ van Santen, Jan P. H.; Sproat, Richard W.; Olive, Joseph P.; Hirschberg, Julia (1997). Progress in Speech Synthesis. Springer. ISBN 978-0-387-94701-3.

- ^ Van Santen, J. (April 1994). "Assignment of segmental duration in text-to-speech synthesis". Computer Speech & Language. 8 (2): 95–128. doi:10.1006/csla.1994.1005.

- ^ 헬싱키공과대학교 음성합성의 역사와 발전, 2006년 11월 4일 회수

- ^ Mechanismus der menschlichen Sprache nebst der Beschreibung seiner sprechenden Maschine ("말하는 기계에 대한 설명과 함께 인간의 말의 메커니즘"). 데겐, 빈). (독일어로)

- ^ Mattingly, Ignatius G. (1974). Sebeok, Thomas A. (ed.). "Speech synthesis for phonetic and phonological models" (PDF). Current Trends in Linguistics. Mouton, The Hague. 12: 2451–2487. Archived from the original (PDF) on 2013-05-12. Retrieved 2011-12-13.

- ^ Klatt, D (1987). "Review of text-to-speech conversion for English". Journal of the Acoustical Society of America. 82 (3): 737–93. Bibcode:1987ASAJ...82..737K. doi:10.1121/1.395275. PMID 2958525.

- ^ Lambert, Bruce (March 21, 1992). "Louis Gerstman, 61, a Specialist In Speech Disorders and Processes". The New York Times.

- ^ "Arthur C. Clarke Biography". Archived from the original on December 11, 1997. Retrieved 5 December 2017.

- ^ "Where "HAL" First Spoke (Bell Labs Speech Synthesis website)". Bell Labs. Archived from the original on 2000-04-07. Retrieved 2010-02-17.

- ^ 웨이백 머신에 보관된 의인화 토킹 로봇 와세다-토커 시리즈 2016-03-04

- ^ Gray, Robert M. (2010). "A History of Realtime Digital Speech on Packet Networks: Part II of Linear Predictive Coding and the Internet Protocol" (PDF). Found. Trends Signal Process. 3 (4): 203–303. doi:10.1561/2000000036. ISSN 1932-8346. Archived (PDF) from the original on 2022-10-09.

- ^ Zheng, F.; Song, Z.; Li, L.; Yu, W. (1998). "The Distance Measure for Line Spectrum Pairs Applied to Speech Recognition" (PDF). Proceedings of the 5th International Conference on Spoken Language Processing (ICSLP'98) (3): 1123–6. Archived (PDF) from the original on 2022-10-09.

- ^ a b "List of IEEE Milestones". IEEE. Retrieved 15 July 2019.

- ^ a b "Fumitada Itakura Oral History". IEEE Global History Network. 20 May 2009. Retrieved 2009-07-21.

- ^ Billi, Roberto; Canavesio, Franco; Ciaramella, Alberto; Nebbia, Luciano (1 November 1995). "Interactive voice technology at work: The CSELT experience". Speech Communication. 17 (3): 263–271. doi:10.1016/0167-6393(95)00030-R.

- ^ Sproat, Richard W. (1997). Multilingual Text-to-Speech Synthesis: The Bell Labs Approach. Springer. ISBN 978-0-7923-8027-6.

- ^ [TSI Speech+ & 기타 말하기 계산기]

- ^ Gevariahu, Jonathan, ["TSIS14001A 음성 합성기 LSI 집적회로 가이드"][dead link]

- ^ 브레슬로우 외. US 4326710 : "Talking Electronic Game", 1982년 4월 27일

- ^ 보이스 체스 챌린저

- ^ 게임의 가장 중요한 진화 2011-06-15 Wayback Machine, GamesRadar에서 아카이브됨

- ^ Adlum, Eddie (November 1985). "The Replay Years: Reflections from Eddie Adlum". RePlay. Vol. 11, no. 2. pp. 134-175 (160-3).

- ^ Szczepaniak, John (2014). The Untold History of Japanese Game Developers. Vol. 1. SMG Szczepaniak. pp. 544–615. ISBN 978-0992926007.

- ^ CadeMetz (2020-08-20). "Ann Syrdal, Who Helped Give Computers a Female Voice, Dies at 74". The New York Times. Retrieved 2020-08-23.

- ^ Kurzweil, Raymond (2005). The Singularity is Near. Penguin Books. ISBN 978-0-14-303788-0.

- ^ Taylor, Paul (2009). Text-to-speech synthesis. Cambridge, UK: Cambridge University Press. p. 3. ISBN 9780521899277.

- ^ 앨런 W. 블랙, 모든 사람들에게 완벽한 합성입니다. IEEE TTS 워크샵 2002.

- ^ 존 코미넥과 앨런 W. 블랙. (2003). 음성 합성을 위한 CMU 북극 데이터베이스. CMU-LTI-03-177. 카네기 멜론 대학 컴퓨터 과학 대학 언어 기술 연구소.

- ^ 줄리아 장. 언어학습을 위한 대화편에서의 언어생성과 음성합성, 석사논문, 54페이지 5.6절

- ^ 윌리엄 양 왕과 칼리로이 게오길라. (2011). 단위 선택 음성 합성, IEEE ASRU 2011에서 부자연스러운 단어 수준 세그먼트의 자동 검출.

- ^ "Pitch-Synchronous Overlap and Add (PSOLA) Synthesis". Archived from the original on February 22, 2007. Retrieved 2008-05-28.

- ^ T. 듀토이트, V. 페이지, N. 피에르레트, F. 바타유, O. 반 데어 브렉켄. MBROLA 프로젝트: 상업용이 아닌 용도로 사용되는 고품질 음성 합성기 세트를 지향합니다. ICSLP Proceedings, 1996.

- ^ Muralishankar, R; Ramakrishnan, A.G.; Prathibha, P (2004). "Modification of Pitch using DCT in the Source Domain". Speech Communication. 42 (2): 143–154. doi:10.1016/j.specom.2003.05.001.

- ^ "Education: Marvel of The Bronx". Time. 1974-04-01. ISSN 0040-781X. Retrieved 2019-05-28.

- ^ "1960 - Rudy the Robot - Michael Freeman (American)". cyberneticzoo.com. 2010-09-13. Retrieved 2019-05-23.

- ^ New York Magazine. New York Media, LLC. 1979-07-30.

- ^ The Futurist. World Future Society. 1978. pp. 359, 360, 361.

- ^ L.F. Lamel, J.L. Gauvain, B. Prouts, C. Bouhier, R. Boesch. 방송 메시지의 생성과 합성, ESCA-NATO 워크숍과 음성 기술의 응용, 1993년 9월.

- ^ 다트머스 대학교: Wayback Machine에서 2011-06-08 아카이브된 음악 및 컴퓨터, 1993.

- ^ 예를 들어 Astro Blaster, Space Fury, Star Trek: Strategic Operations Simulator가 있습니다.

- ^ 스타워즈, 파이어폭스, 제다이의 귀환, 로드러너, 제국의 역습, 인디애나 존스, 템플 오브 둠, 720°, 건틀렛, 건틀렛 II, A.P.B., 페이퍼보이, 로드블래스터즈, 빈디케이터 파트 2, 로봇 몬스터 행성으로부터의 탈출.

- ^ John Holmes and Wendy Holmes (2001). Speech Synthesis and Recognition (2nd ed.). CRC. ISBN 978-0-7484-0856-6.

- ^ a b Lucero, J. C.; Schoentgen, J.; Behlau, M. (2013). "Physics-based synthesis of disordered voices" (PDF). Interspeech 2013. Lyon, France: International Speech Communication Association: 587–591. doi:10.21437/Interspeech.2013-161. S2CID 17451802. Retrieved Aug 27, 2015.

- ^ a b Englert, Marina; Madazio, Glaucya; Gielow, Ingrid; Lucero, Jorge; Behlau, Mara (2016). "Perceptual error identification of human and synthesized voices". Journal of Voice. 30 (5): 639.e17–639.e23. doi:10.1016/j.jvoice.2015.07.017. PMID 26337775.

- ^ "The HMM-based Speech Synthesis System". Hts.sp.nitech.ac.j. Retrieved 2012-02-22.

- ^ Remez, R.; Rubin, P.; Pisoni, D.; Carrell, T. (22 May 1981). "Speech perception without traditional speech cues" (PDF). Science. 212 (4497): 947–949. Bibcode:1981Sci...212..947R. doi:10.1126/science.7233191. PMID 7233191. Archived from the original (PDF) on 2011-12-16. Retrieved 2011-12-14.

- ^ Valle, Rafael (2020). "Mellotron: Multispeaker expressive voice synthesis by conditioning on rhythm, pitch and global style tokens". arXiv:1910.11997 [eess].

- ^ Chandraseta, Rionaldi (2021-01-19). "Generate Your Favourite Characters' Voice Lines using Machine Learning". Towards Data Science. Archived from the original on 2021-01-21. Retrieved 2021-01-23.

- ^ Kurosawa, Yuki (2021-01-19). "ゲームキャラ音声読み上げソフト「15.ai」公開中。『Undertale』や『Portal』のキャラに好きなセリフを言ってもらえる". AUTOMATON. AUTOMATON. Archived from the original on 2021-01-19. Retrieved 2021-01-19.

- ^ Yoshiyuki, Furushima (2021-01-18). "『Portal』のGLaDOSや『UNDERTALE』のサンズがテキストを読み上げてくれる。文章に込められた感情まで再現することを目指すサービス「15.ai」が話題に". Denfaminicogamer. Archived from the original on 2021-01-18. Retrieved 2021-01-18.

- ^ "Generative AI comes for cinema dubbing: Audio AI startup ElevenLabs raises pre-seed". Sifted. January 23, 2023. Retrieved 2023-02-03.

- ^ Ashworth, Boone (April 12, 2023). "AI Can Clone Your Favorite Podcast Host's Voice". Wired. Retrieved 2023-04-25.

- ^ WIRED Staff. "This Podcast Is Not Hosted by AI Voice Clones. We Swear". Wired. ISSN 1059-1028. Retrieved 2023-07-25.

- ^ Wiggers, Kyle (2023-06-20). "Voice-generating platform ElevenLabs raises $19M, launches detection tool". TechCrunch. Retrieved 2023-07-25.

- ^ Bonk, Lawrence. "ElevenLabs' Powerful New AI Tool Lets You Make a Full Audiobook in Minutes". Lifewire. Retrieved 2023-07-25.

- ^ Zhu, Jian (2020-05-25). "Probing the phonetic and phonological knowledge of tones in Mandarin TTS models". Speech Prosody 2020. ISCA: ISCA. doi:10.21437/speechprosody.2020-190.

- ^ Lyu, Siwei (2020). "Deepfake Detection: Current Challenges and Next Steps". 2020 IEEE International Conference on Multimedia & Expo Workshops (ICMEW). pp. 1–6. arXiv:2003.09234. doi:10.1109/icmew46912.2020.9105991. ISBN 978-1-7281-1485-9. S2CID 214605906. Retrieved 2022-06-29.

- ^ a b Diakopoulos, Nicholas; Johnson, Deborah (June 2020). "Anticipating and addressing the ethical implications of deepfakes in the context of elections". New Media & Society (published 2020-06-05). 23 (7): 2072–2098. doi:10.1177/1461444820925811. ISSN 1461-4448. S2CID 226196422.

- ^ Chadha, Anupama; Kumar, Vaibhav; Kashyap, Sonu; Gupta, Mayank (2021), Singh, Pradeep Kumar; Wierzchoń, Sławomir T.; Tanwar, Sudeep; Ganzha, Maria (eds.), "Deepfake: An Overview", Proceedings of Second International Conference on Computing, Communications, and Cyber-Security, Lecture Notes in Networks and Systems, Singapore: Springer Singapore, vol. 203, pp. 557–566, doi:10.1007/978-981-16-0733-2_39, ISBN 978-981-16-0732-5, S2CID 236666289, retrieved 2022-06-29

- ^ "AI gave Val Kilmer his voice back. But critics worry the technology could be misused". Washington Post. ISSN 0190-8286. Retrieved 2022-06-29.

- ^ Etienne, Vanessa (August 19, 2021). "Val Kilmer Gets His Voice Back After Throat Cancer Battle Using AI Technology: Hear the Results". PEOPLE.com. Retrieved 2022-07-01.

- ^ Almutairi, Zaynab; Elgibreen, Hebah (2022-05-04). "A Review of Modern Audio Deepfake Detection Methods: Challenges and Future Directions". Algorithms. 15 (5): 155. doi:10.3390/a15050155. ISSN 1999-4893.

- ^ Caramancion, Kevin Matthe (June 2022). "An Exploration of Mis/Disinformation in Audio Format Disseminated in Podcasts: Case Study of Spotify". 2022 IEEE International IOT, Electronics and Mechatronics Conference (IEMTRONICS). pp. 1–6. doi:10.1109/IEMTRONICS55184.2022.9795760. ISBN 978-1-6654-8684-2. S2CID 249903722.

- ^ Chen, Tianxiang; Kumar, Avrosh; Nagarsheth, Parav; Sivaraman, Ganesh; Khoury, Elie (2020-11-01). "Generalization of Audio Deepfake Detection". The Speaker and Language Recognition Workshop (Odyssey 2020). ISCA: 132–137. doi:10.21437/Odyssey.2020-19. S2CID 219492826.

- ^ Ballesteros, Dora M.; Rodriguez-Ortega, Yohanna; Renza, Diego; Arce, Gonzalo (2021-12-01). "Deep4SNet: deep learning for fake speech classification". Expert Systems with Applications. 184: 115465. doi:10.1016/j.eswa.2021.115465. ISSN 0957-4174. S2CID 237659479.

- ^ Suwajanakorn, Supasorn; Seitz, Steven M.; Kemelmacher-Shlizerman, Ira (2017-07-20). "Synthesizing Obama: learning lip sync from audio". ACM Transactions on Graphics. 36 (4): 95:1–95:13. doi:10.1145/3072959.3073640. ISSN 0730-0301. S2CID 207586187.

- ^ Brewster, Thomas. "Fraudsters Cloned Company Director's Voice In $35 Million Bank Heist, Police Find". Forbes. Retrieved 2022-06-29.

- ^ "Generative AI is making voice scams easier to believe". Axios. 13 June 2023. Retrieved 16 June 2023.

- ^ Bunn, Amy (15 May 2023). "Artificial Imposters—Cybercriminals Turn to AI Voice Cloning for a New Breed of Scam". McAfee Blog. Retrieved 16 June 2023.

- ^ Cox, Joseph (23 February 2023). "How I Broke Into a Bank Account With an AI-Generated Voice". Vice. Retrieved 16 June 2023.

- ^ Evershed, Nick; Taylor, Josh (16 March 2023). "AI can fool voice recognition used to verify identity by Centrelink and Australian tax office". The Guardian. Retrieved 16 June 2023.

- ^ Newman, Lily Hay. "AI-Generated Voice Deepfakes Aren't Scary Good—Yet". Wired. ISSN 1059-1028. Retrieved 2023-07-25.

- ^ "Speech synthesis". World Wide Web Organization.

- ^ "Blizzard Challenge". Festvox.org. Retrieved 2012-02-22.

- ^ "Smile -and the world can hear you". University of Portsmouth. January 9, 2008. Archived from the original on May 17, 2008.

- ^ "Smile – And The World Can Hear You, Even If You Hide". Science Daily. January 2008.

- ^ Drahota, A. (2008). "The vocal communication of different kinds of smile" (PDF). Speech Communication. 50 (4): 278–287. doi:10.1016/j.specom.2007.10.001. S2CID 46693018. Archived from the original (PDF) on 2013-07-03.

- ^ Muralishankar, R.; Ramakrishnan, A. G.; Prathibha, P. (February 2004). "Modification of pitch using DCT in the source domain". Speech Communication. 42 (2): 143–154. doi:10.1016/j.specom.2003.05.001.

- ^ Prathosh, A. P.; Ramakrishnan, A. G.; Ananthapadmanabha, T. V. (December 2013). "Epoch extraction based on integrated linear prediction residual using plosion index". IEEE Trans. Audio Speech Language Processing. 21 (12): 2471–2480. doi:10.1109/TASL.2013.2273717. S2CID 10491251.

- ^ E Times. "TI는 전용 음성 합성 칩을 종료하고 Wayback Machine에서 Sensory Archive 2012-05-28로 제품을 이전할 예정입니다." 2001년 6월 14일.

- ^ "1400XL/1450XL Speech Handler External Reference Specification" (PDF). Archived from the original (PDF) on 2012-03-24. Retrieved 2012-02-22.

- ^ "It Sure Is Great To Get Out Of That Bag!". folklore.org. Retrieved 2013-03-24.

- ^ "Amazon Polly". Amazon Web Services, Inc. Retrieved 2020-04-28.

- ^ Miner, Jay; et al. (1991). Amiga Hardware Reference Manual (3rd ed.). Addison-Wesley Publishing Company, Inc. ISBN 978-0-201-56776-2.

- ^ Devitt, Francesco (30 June 1995). "Translator Library (Multilingual-speech version)". Archived from the original on 26 February 2012. Retrieved 9 April 2013.

- ^ "Accessibility Tutorials for Windows XP: Using Narrator". Microsoft. 2011-01-29. Archived from the original on June 21, 2003. Retrieved 2011-01-29.

- ^ "How to configure and use Text-to-Speech in Windows XP and in Windows Vista". Microsoft. 2007-05-07. Retrieved 2010-02-17.

- ^ Jean-Michel Trivi (2009-09-23). "An introduction to Text-To-Speech in Android". Android-developers.blogspot.com. Retrieved 2010-02-17.

- ^ Andreas Bischoff, The Pediaphon – Pediaphon – 휴대전화용 위키백과, PDA와 MP3 플레이어의 연설 인터페이스, 제18차 데이터베이스 및 전문가 시스템 응용 국제 회의 진행, 페이지: 575–579 ISBN 0-7695-2932-1, 2007

- ^ "gnuspeech". Gnu.org. Retrieved 2010-02-17.

- ^ "Smithsonian Speech Synthesis History Project (SSSHP) 1986–2002". Mindspring.com. Archived from the original on 2013-10-03. Retrieved 2010-02-17.

- ^ Jia, Ye; Zhang, Yu; Weiss, Ron J. (2018-06-12), "Transfer Learning from Speaker Verification to Multispeaker Text-To-Speech Synthesis", Advances in Neural Information Processing Systems, 31: 4485–4495, arXiv:1806.04558

- ^ Arık, Sercan Ö.; Chen, Jitong; Peng, Kainan; Ping, Wei; Zhou, Yanqi (2018), "Neural Voice Cloning with a Few Samples", Advances in Neural Information Processing Systems, 31, arXiv:1802.06006

- ^ "Fake voices 'help cyber-crooks steal cash'". bbc.com. BBC. 2019-07-08. Retrieved 2019-09-11.

- ^ Drew, Harwell (2019-09-04). "An artificial-intelligence first: Voice-mimicking software reportedly used in a major theft". Washington Post. Retrieved 2019-09-08.

- ^ Thies, Justus (2016). "Face2Face: Real-time Face Capture and Reenactment of RGB Videos". Proc. Computer Vision and Pattern Recognition (CVPR), IEEE. Retrieved 2016-06-18.

- ^ Suwajanakorn, Supasorn; Seitz, Steven; Kemelmacher-Shlizerman, Ira (2017), Synthesizing Obama: Learning Lip Sync from Audio, University of Washington, retrieved 2018-03-02

- ^ Ng, Andrew (2020-04-01). "Voice Cloning for the Masses". deeplearning.ai. The Batch. Archived from the original on 2020-08-07. Retrieved 2020-04-02.

- ^ Brunow, David A.; Cullen, Theresa A. (2021-07-03). "Effect of Text-to-Speech and Human Reader on Listening Comprehension for Students with Learning Disabilities". Computers in the Schools. 38 (3): 214–231. doi:10.1080/07380569.2021.1953362. hdl:11244/316759. ISSN 0738-0569. S2CID 243101945.

- ^ Triandafilidi, Ioanis I.; Tatarnikova, T. M.; Poponin, A. S. (2022-05-30). "Speech Synthesis System for People with Disabilities". 2022 Wave Electronics and its Application in Information and Telecommunication Systems (WECONF). St. Petersburg, Russian Federation: IEEE. pp. 1–5. doi:10.1109/WECONF55058.2022.9803600. ISBN 978-1-6654-7083-4. S2CID 250118756.

- ^ Zhao, Yunxin; Song, Minguang; Yue, Yanghao; Kuruvilla-Dugdale, Mili (2021-07-27). "Personalizing TTS Voices for Progressive Dysarthria". 2021 IEEE EMBS International Conference on Biomedical and Health Informatics (BHI). Athens, Greece: IEEE. pp. 1–4. doi:10.1109/BHI50953.2021.9508522. ISBN 978-1-6654-0358-0. S2CID 236982893.

- ^ "Evolution of Reading Machines for the Blind: Haskins Laboratories" Research as a Case History" (PDF). Journal of Rehabilitation Research and Development. 21 (1). 1984.

- ^ "Speech Synthesis Software for Anime Announced". Anime News Network. 2007-05-02. Retrieved 2010-02-17.

- ^ "Code Geass Speech Synthesizer Service Offered in Japan". Animenewsnetwork.com. 2008-09-09. Retrieved 2010-02-17.

- ^ Chandraseta, Rionaldi (2021-01-19). "Generate Your Favourite Characters' Voice Lines using Machine Learning". Towards Data Science. Archived from the original on 2021-01-21. Retrieved 2021-01-23.

- ^ Kurosawa, Yuki (2021-01-19). "ゲームキャラ音声読み上げソフト「15.ai」公開中。『Undertale』や『Portal』のキャラに好きなセリフを言ってもらえる". AUTOMATON. AUTOMATON. Archived from the original on 2021-01-19. Retrieved 2021-01-19.

- ^ Yoshiyuki, Furushima (2021-01-18). "『Portal』のGLaDOSや『UNDERTALE』のサンズがテキストを読み上げてくれる。文章に込められた感情まで再現することを目指すサービス「15.ai」が話題に". Denfaminicogamer. Archived from the original on 2021-01-18. Retrieved 2021-01-18.

- ^ "Now hear this: Voice cloning AI startup ElevenLabs nabs $19M from a16z and other heavy hitters". VentureBeat. 2023-06-20. Retrieved 2023-07-25.

- ^ "Sztuczna inteligencja czyta głosem Jarosława Kuźniara. Rewolucja w radiu i podcastach". Press.pl (in Polish). April 9, 2023. Retrieved 2023-04-25.

- ^ Ashworth, Boone (April 12, 2023). "AI Can Clone Your Favorite Podcast Host's Voice". Wired. Retrieved 2023-04-25.

- ^ Knibbs, Kate. "Generative AI Podcasts Are Here. Prepare to Be Bored". Wired. ISSN 1059-1028. Retrieved 2023-07-25.

- ^ Suciu, Peter. "Arrested Succession Parody On YouTube Features 'Narration' By AI-Generated Ron Howard". Forbes. Retrieved 2023-07-25.

- ^ Fadulu, Lola (2023-07-06). "Can A.I. Be Funny? This Troupe Thinks So". The New York Times. ISSN 0362-4331. Retrieved 2023-07-25.

- ^ Kanetkar, Riddhi. "Hot AI startup ElevenLabs, founded by ex-Google and Palantir staff, is set to raise $18 million at a $100 million valuation. Check out the 14-slide pitch deck it used for its $2 million pre-seed". Business Insider. Retrieved 2023-07-25.

- ^ "AI-Generated Voice Firm Clamps Down After 4chan Makes Celebrity Voices for Abuse". www.vice.com. January 30, 2023. Retrieved 2023-02-03.

- ^ "Usage of text-to-speech in AI video generation". elai.io. Retrieved 10 August 2022.

- ^ "AI Text to speech for videos". synthesia.io. Retrieved 12 October 2023.

- ^ Bruno, Chelsea A (2014-03-25). Vocal Synthesis and Deep Listening (Master of Music Music thesis). Florida International University. doi:10.25148/etd.fi14040802.

외부 링크

Wikimedia Commons의 음성 합성 관련 미디어

Wikimedia Commons의 음성 합성 관련 미디어- 컬리의 음성 합성

- 노래하는 로봇 파바로보티와 함께 노래하는 시뮬레이션이나 로봇이 노래를 합성하는 방법에 대한 BBC의 설명.