버추얼 시네마토그래피

Virtual cinematography| 3차원(3D) 컴퓨터 그래픽스 |

|---|

|

| 기초 |

| 주요 용도 |

| 관련 토픽 |

버추얼 시네마토그래피는 컴퓨터 그래픽 환경에서 수행되는 일련의 촬영 기술입니다.실제 물체를 3차원 물체로 재창조하고 실제 카메라 각도 및 시뮬레이션 카메라 각도를 자동으로 생성하는 알고리즘으로 재현하기 위해 종종 스테레오 또는 멀티 카메라 설정으로 실제 물체를 촬영하는 것과 같은 광범위한 주제를 포함합니다.가상 촬영은 불가능한 카메라 각도에서 장면을 촬영하고, 애니메이션 영화의 사진을 만들고, 컴퓨터가 만들어내는 효과의 외관을 조작하는데 사용될 수 있습니다.버추얼 시네마토그래피는 컴퓨터 그래픽 환경에서 실행되는 일련의 촬영 기술입니다.

역사

초기 단계

가상 환경을 통합한 영화의 초기 예는 로빈 윌리엄스가 주연한 1998년 영화 "What Dreams May Come"이다.이 영화의 특수효과팀은 실제 건물 설계도를 사용하여 축척 와이어프레임 모델을 만들어 가상 [1]세계를 만드는 데 사용되었습니다.이 영화는 아카데미 시각효과상, 아트디렉터 길드상 [2]제작디자인상 등 수많은 후보와 상을 받았다."가상 촬영"이라는 용어는 특수 효과 예술가 존 개타와 그의 팀이 그들이 [3]창조한 새로운 영화 기술에 이름을 붙이고자 했던 1999년에 생겨났다.

현대 가상 촬영법

매트릭스 3부작(매트릭스, 매트릭스 새로고침 및 매트릭스 혁명)은 초기 가상 촬영 기술을 사용하여 사실적인 컴퓨터 생성 이미지의 가상 "필름"을 개발했습니다.ESC Entertainment의 John Gaeta와 그의 팀원들의 작업 결과는 배우, 세트, 액션의 사진 같은 CGI 버전을 만드는 것이었습니다.이들의 연구는 2000년 [4]가장 단순한 광 단계를 사용하여 획득한 인체 얼굴의 반사율장 획득 및 후속 시뮬레이션에 대한 Paul Debevec 등의 연구 결과에 기초했다.전통적인 촬영 방식으로는 제작이 불가능하거나 시간이 많이 걸리는 유명한 장면으로는 네오가 100명의 에이전트 스미스와 싸우는 매트릭스 리로디드(2003)의 건장한 싸움과 매트릭스 레볼루션(2003)에서의 마지막 결전의 시작 등이 있다.네오는[5] 디지털 닮은 사람을 다치게 하지 않았다.

매트릭스 3부작에서 영화 제작자들은 관객을 끌기 위해 가상 촬영에 크게 의존했다.사진 감독인 빌 포프는 이 도구를 훨씬 더 교묘하게 사용했다.그럼에도 불구하고, 이러한 장면들은 여전히 높은 수준의 사실성에 도달했고 관객들은 그들이 3D 컴퓨터 그래픽 [6]도구를 사용하여 시각 효과 예술가들이 만든 장면을 실제로 보고 있다는 것을 알아채기 어렵게 만들었다.

스파이더맨2(2004년)에서는 관객들이 마치 스파이더맨과 함께 뉴욕을 누비는 듯한 느낌을 받도록 카메라를 조작했다.모션 캡처 카메라 레이더를 사용하여 카메라맨이 표시된 [7]애니메이션과 동시에 이동합니다.이는 관객들로 하여금 스파이더맨의 관점을 경험하게 하고 현실감을 고조시킨다.어벤져스: 인피니티 워 (2018) 타이탄 시퀀스 씬은 가상 촬영법을 사용하여 제작되었습니다.이 장면을 좀 더 사실적으로 만들기 위해 제작자들은 [8]타이탄의 움직임에 따라 움직일 수 있도록 다른 카메라로 전체 장면을 다시 찍기로 결정했다.영화 제작자들은 합성 렌즈 플레어라고 알려진 것을 제작했고, 플레어는 원래 제작된 영상과 매우 흡사하게 만들었다.고전 애니메이션 영화 라이온 킹이 2019년에 리메이크 되었을 때, 제작자들은 사실적인 애니메이션을 만들기 위해 가상 촬영법을 사용했다.스카와 심바의 마지막 전투 장면에서 카메라맨이 다시 [9]캐릭터의 움직임에 따라 카메라를 움직인다.이 기술의 목표는 관객들을 장면에 더욱 몰입시키는 것입니다.

방법들

포스트 프로덕션에서의 가상 촬영

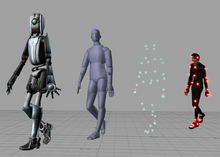

포스트 프로덕션에서는 촬영된 장면을 수정, 리다이렉트 및 확장하기 위해 고급 기술을 사용합니다.스테레오 또는 멀티 카메라 설정은 실제 물체를 3D 물체와 알고리즘으로 재현할 수 있는 방식으로 촬영합니다.추적 도트나 헬멧 카메라와 같은 모션 캡처 장비를 세트에서 사용하여 후작 [10]시 소급 데이터 수집을 용이하게 할 수 있습니다.

포토그래메트리라고 불리는 기계 비전 기술은 3D 스캐너를 사용하여 3D 형상을 포착합니다.예를 들어, 매트릭스 속편에 사용된 Arius 3D 스캐너는 [4]100µm의 작은 주름과 피부 모공과 같은 디테일을 얻을 수 있었다.

영화 제작자들은 또한 세트 모션 캡처 장비 없이 모션 데이터를 캡처하는 멀티 카메라 장치도 실험했습니다.예를 들어, 마커리스 모션 캡쳐와 광학 플로우라고 불리는 멀티 카메라 설정 포토 측량 캡쳐 기술은 매트릭스 [4]영화의 디지털 룩을 비슷하게 만들기 위해 사용되었습니다.

최근 마틴 스콜세지의 범죄 영화 아일랜드맨은 메인 카메라의 양쪽에 위치한 두 대의 디지털 카메라로 구성된 특수 장비를 사용하여 메인 공연과 함께 모션 데이터를 실시간으로 캡처하는 완전히 새로운 얼굴 캡처 시스템을 이용했다.포스트 프로덕션에서 이 데이터는 컴퓨터에서 생성된 버전의 [11][12]배우를 디지털 렌더링하는 데 사용되었습니다.

가상 카메라 장치는 촬영기사에게 3D 세계 내에서 가상 카메라를 조작하고 컴퓨터로 생성된 3D 모델을 촬영할 수 있는 능력을 제공합니다.가상 콘텐츠를 3D 엔진 내의 장면으로 조립하면 마치 처음 동작을 하는 것처럼 다른 각도에서 이미지를 창조적으로 합성하고 재촬영할 수 있습니다.이 사실적인 CGI의 가상 "촬영"은 [4]또한 매트릭스의 총알 타임 장면과 같이 물리적으로 불가능한 카메라 움직임을 가능하게 한다.

또, 가상 촬영 기능을 사용하면, 완전한 가상 세계를 처음부터 구축할 수 있습니다.더 발전된 모션 컨트롤러와 태블릿 인터페이스는 소규모 영화 [13]제작의 예산 제약 내에서 이러한 시각화 기술을 가능하게 했습니다.

온세트 효과

시각 효과의 광범위한 채택은 배우들의 [14]연기를 저해하지 않는 방식으로 이러한 효과를 직접 제작하고자 하는 욕구를 낳았다.이펙트 아티스트는 촬영장에서 가상 촬영 기술을 구현하기 시작했고,[13] 주어진 샷의 컴퓨터 생성 요소를 캡처를 담당하는 배우와 촬영기사들이 볼 수 있게 만들었습니다.

씬(scene)을 디지털로 삽입하지 않고 촬영 전에 효과를 낼 수 있는 실시간 렌더링(real-time rendering)과 같은 기술은 비디오 게임 엔진, 프로젝터, 고급 카메라 등 이전에는 관련이 없는 기술을 활용하여 기존의 촬영 기술과 가상 [15][16][17]촬영 기술을 융합합니다.

최초의 실시간 영화 효과는 인더스트리얼 라이트 & 매직이 에픽 게임즈와 협력하여 2018년 영화 '솔로: 스타워즈 스토리'[15][18]의 고전적인 스타워즈 "광속" 효과를 보여주기 위해 언리얼 엔진을 활용했다.제작자들에 의해 "스테이지크래프트"라고 불리는 이 영화에 사용된 기술은 이후 ILM과 모회사인 디즈니의 2019년 사실적인 리메이크 영화 라이온 [19][20]킹에 의해 다양한 스타워즈 프로젝트에 사용되었다.

가상 촬영 기술을 사용하여 기존 이미지를 스캔하여 표시하는 것이 아니라 사후 제작 시 실시간 효과로 인한 추가 작업을 최소화합니다.촬영장에서의 가상 촬영등의 촬영에는, 고도의 포스트 프로덕션 수법이 필요 없습니다.기존의 CGI 애니메이션을 사용하면 효과를 얻을 수 있습니다.

소프트웨어

- Autodesk Maya는 Windows, OS X 및 Linux에서 실행되는 3D 컴퓨터 그래픽 소프트웨어입니다.

- Autodesk 3ds Max는 Windows 전용 3D 애니메이션, 모델, 게임 및 이미지를 만드는 전문 3D 컴퓨터 그래픽 프로그램입니다.

- 블렌더(소프트웨어)는 무료 오픈 소스 3D 컴퓨터 그래픽 소프트웨어 제품으로 애니메이션 영화, 시각 효과, 아트, 3D 프린팅 모델, 대화형 3D 응용 프로그램 및 비디오 게임을 만드는 데 사용됩니다.

- Arius3D의 Pointstream Software는 픽셀과 그 움직임을 멀티 카메라 설정으로 추적하는 단위로 사용하는 전문적인 고밀도 모션 캡처 및 광학 흐름 시스템입니다.

「 」를 참조해 주세요.

레퍼런스

- ^ Silberman, Steve (2003-05-01). "MATRIX2". Wired. ISSN 1059-1028. Retrieved 2020-04-02.

- ^ What Dreams May Come - IMDb, retrieved 2020-04-02

- ^ "VFXPro - The Daily Visual Effects Resource". 2004-03-18. Archived from the original on 2004-03-18. Retrieved 2020-04-02.

- ^ a b c d "Acquiring the reflectance field of a human face Proceedings of the 27th annual conference on Computer graphics and interactive techniques". doi:10.1145/344779.344855. S2CID 2860203.

{{cite journal}}:Cite 저널 요구 사항journal=(도움말) - ^ 조지 보르슈코프, 이매지나'04에서 발표.'Making of The Superpunch'(PDF).

- ^ David Fincher - Invisible Details, archived from the original on 2021-12-21, retrieved 2020-04-02

- ^ The Amazing Spider-Man 2 - Virtual Cinematography, archived from the original on 2021-12-21, retrieved 2020-04-02

- ^ Avengers: Infinity War VFX Breakdown - Cinematography Weta Digital, retrieved 2020-04-02

- ^ The Lion King - virtual cinematography and VFX, archived from the original on 2021-12-21, retrieved 2020-04-02

- ^ Breznican, Anthony (9 December 2019). "The Irishman, Avengers: Endgame, and the De-aging Technology That Could Change Acting Forever". Vanity Fair. Retrieved 2020-04-03.

- ^ "Robert De Niro said no green screen. No face dots. How 'The Irishman's' de-aging changes Hollywood". Los Angeles Times. 2020-01-02. Retrieved 2020-04-03.

- ^ Desowitz, Bill (2019-12-06). "'The Irishman': How Industrial Light & Magic's Innovative De-Aging VFX Rescued Martin Scorsese's Mob Epic". IndieWire. Retrieved 2020-04-03.

- ^ a b "Virtual Cinematography: Beyond Big Studio Production iDEA: DREXEL LIBRARIES E-REPOSITORY AND ARCHIVES". idea.library.drexel.edu. Retrieved 2020-04-02.

- ^ "Sir Ian McKellen: Filming The Hobbit made me think I should quit acting". Radio Times. Retrieved 2020-04-02.

- ^ a b Roettgers, Janko (2019-05-15). "How Video-Game Engines Help Create Visual Effects on Movie Sets in Real Time". Variety. Retrieved 2020-04-02.

- ^ CISIS 2016 : 2016 10th International Conference on Complex, Intelligent, and Software Intensive Systems : proceedings : Fukuoka Institute of Technology (FIT), Fukuoka, Japan, 6-8 July 2016. Barolli, Leonard,, Xhafa, Fatos,, Ikeda, Makoto,, Fukuoka Institute of Technology,, IEEE Computer Society,, Institute of Electrical and Electronics Engineers. Los Alamitos, CA. ISBN 9781509009879. OCLC 972631841.

{{cite book}}: CS1 유지보수: 기타 (링크) - ^ Choi, Wanho; Lee, Taehyung; Kang, Wonchul (2019). "Beyond the Screen". SIGGRAPH Asia 2019 Technical Briefs on - SA '19. Brisbane, QLD, Australia: ACM Press: 65–66. doi:10.1145/3355088.3365140. ISBN 978-1-4503-6945-9. S2CID 184931978.

- ^ www.unrealengine.com https://www.unrealengine.com/en-US/spotlights/unreal-engine-powers-ilm-s-vr-virtual-production-toolset-on-solo-a-star-wars-story. Retrieved 2020-04-02.

{{cite web}}:누락 또는 비어 있음title=(도움말) - ^ "How Lucasfilm's New "Stagecraft" Tech Brought 'The Mandalorian' to Life and May Change the Future of TV". /Film. 2019-11-20. Retrieved 2020-04-02.

- ^ "'The Lion King's' VR helped make a hit. It could also change movie making". Los Angeles Times. 2019-07-26. Retrieved 2020-04-02.

추가 정보

- Debevec, Paul (2006). "Virtual Cinematography: Relighting through Computation" (PDF). Computer. IEEE. 39 (8): 57–65. doi:10.1109/MC.2006.285. ISSN 0018-9162. S2CID 11904037. Archived from the original (PDF) on 2007-02-09. Retrieved 2006-11-06.

- Jhala, Arnav (2005). "Introduction to Virtual Cinematography" (PDF). North Carolina State University. Archived from the original (PDF) on 2007-01-02. Retrieved 2006-11-06.

{{cite journal}}:Cite 저널 요구 사항journal=(도움말) - Newman, Bruce (2003). "'Matrix' sequel: Virtual Cinematography". San Jose Mercury News. Archived from the original on April 27, 2006. Retrieved 2006-11-07.