생성적 적대 네트워크

Generative adversarial network| 시리즈의 일부 |

| 기계 학습 및 데이터 마이닝 |

|---|

|

GAN(Generative Adversarial Network)은 Ian Goodfellow와 그의 동료들이 2014년 [1]6월에 설계한 기계 학습 프레임워크 클래스입니다.2개의 뉴럴 네트워크는 게임 내에서 서로 경쟁합니다(제로섬 게임 형식으로, 한 에이전트의 이득은 다른 에이전트의 손실입니다).

훈련 세트가 주어지면 이 기술은 훈련 세트와 동일한 통계 정보를 사용하여 새로운 데이터를 생성하는 방법을 학습합니다.예를 들어, 사진에 대해 훈련받은 GAN은 적어도 인간 관찰자들에게 표면적으로 진짜처럼 보이는 새로운 사진을 생성할 수 있으며, 많은 현실적인 특징을 가지고 있다.원래 비지도 학습을 위한 생성 모델의 형태로 제안되었지만, GANs는 반지도 학습,[2] 완전 지도 학습 [3]및 강화 [4]학습에도 유용하다는 것이 입증되었다.

GAN의 핵심 아이디어는 입력이 얼마나 "현실적"으로 보이는지 알 수 있는 또 다른 신경 네트워크인 식별자를 통한 "간접" 훈련에 기초하고 있으며, 그 자체도 [5]동적으로 업데이트되고 있다.즉, 제너레이터는 특정 이미지까지의 거리를 최소화하도록 훈련되지 않고 식별자를 속이기 위해 훈련됩니다.이를 통해 모델은 감독 없이 학습할 수 있습니다.

GAN은 진화생물학에서의 모방과 유사하며, 두 네트워크 간의 진화적 군비경쟁이다.

정의.

수학

각 확률 공간 f _은 GAN 게임을 정의합니다.

발전기와 판별기의 두 가지 플레이어가 있습니다.

제너레이터의 전략 세트는 () \ \ { ( Omega입니다.이것은, ( )\ style \ Omega의 모든 확률 G ( \ style \_ { 의 세트입니다.

식별자의 전략 세트는 마르코프 D: [ , \ \ \} [ 0 , \ \ mathcal { } [, ]의 세트이다

GAN 게임은 객관적인 기능을 가진 제로섬 게임입니다.

생성기는 목표를 최소화하는 것을 목표로 하고 식별기는 목표를 최대화하는 것을 목표로 한다.

직관적으로 말하면 제너레이터의 작업은 G f\ \_ { } \ approx \ _ { }에 하는 것이다. 즉, 자체 출력 분포를 기준 분포에 최대한 가깝게 일치시키는 것이다. 판별자의 작업은 입력이 기준 분포에서 나온 것으로 보일 때 1에 가까운 값을 출력하는 것이다.입력이 제너레이터 분포에서 나온 것처럼 보일 때 0에 가까운 값을 출력합니다.

말로만

생성 네트워크는 후보를 생성하고 식별 네트워크는 후보를 [1]평가합니다.이 콘테스트는 데이터 배포 측면에서 운영됩니다.전형적으로, 생성 네트워크는 잠재 공간에서 관심 있는 데이터 분포로의 매핑을 학습하는 반면, 식별 네트워크는 생성자에 의해 생성된 후보와 실제 데이터 분포를 구별한다.생성 네트워크의 훈련 목표는 차별 네트워크의 오류율을 증가시키는 것이다(즉, 식별자가 합성되지 않았다고 생각하는 (진정한 데이터 [1][6]분포의 일부) 새로운 후보를 생성하여 식별자 네트워크를 "속이는" 것).

알려진 데이터 세트는 식별자를 위한 초기 교육 데이터 역할을 합니다.트레이닝에는 트레이닝 데이터 세트의 샘플과 함께 트레이닝 데이터가 허용 가능한 정확도에 도달할 때까지 프레젠테이션하는 것이 포함됩니다.제너레이터는 식별자를 속이는 데 성공했는지 여부에 따라 훈련됩니다.일반적으로 발생기는 사전 정의된 잠재 공간(예: 다변량 정규 분포)에서 샘플링된 무작위 입력으로 시드됩니다.그 후, 발생기에 의해 합성된 후보를 판별기에 의해 평가한다.독립적 역전파 절차가 양쪽 네트워크에 적용되어 발전기가 더 나은 샘플을 생산하는 반면 판별기는 합성 [7]샘플 플래깅에 더 능숙해진다.이미지 생성에 사용될 때 제너레이터는 일반적으로 디콘볼루션 뉴럴 네트워크이며 식별기는 컨볼루션 뉴럴 네트워크입니다.

기타 통계 기계학습 방법과의 관계

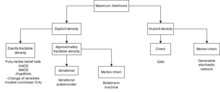

GAN은 암묵적 생성 [8]모델이다. 즉, 흐름 기반 생성 모델과 같은 대안과는 달리, 우도 함수를 명시적으로 모델링하거나 주어진 표본에 해당하는 잠재 변수를 찾기 위한 수단을 제공하지 않는다.

WaveNet 및 PixelRNN과 같은 완전히 가시적인 믿음 네트워크 및 일반적으로 자기 회귀 모델과 비교하여, GAN은 네트워크를 통과하는 여러 개의 경로가 아닌 하나의 완전한 샘플을 하나의 경로로 생성할 수 있습니다.

Boltzmann 머신이나 비선형 ICA에 비해 네트워크에서 사용되는 기능의 종류에 제한이 없습니다.

신경망은 보편적 근사치이기 때문에, GAN은 점근적으로 일치한다.변형 자동 인코더는 범용 근사치일 수 있지만 2017년 현재 [9]입증되지 않았다.

수학적 특성

측정 이론상의 고려 사항

이 섹션에서는 이러한 방법의 배후에 있는 수학 이론의 일부를 제공합니다.

측정 이론에 기초한 현대 확률 이론에서 확률 공간에는 θ-대수가 있어야 합니다.그 결과, GAN 게임을 보다 엄격하게 정의하면 다음과 같은 변경이 이루어집니다.

각 확률 공간 e { {\ \ _은 GAN 게임을 정의합니다.

제너레이터의 전략 세트는 ( ,) { { ( , { \ { ) 。이는 측정 공간,)의 확률 G ( \ \ _ {

식별자의 전략 세트는 마르코프 D:( ) ( [ , ,( [ , ){ style \_ { : ( ( , {\ ) \ { ( }) { ( 0, 1 ) 。

측정 가능성의 문제는 실제로 발생하지 않기 때문에 더 이상 걱정하지 않습니다.

전략 세트의 선택

위에서 설명한 GAN 게임 중 가장 일반적인 버전에서 식별자에 대한 전략 집합은 모든 마르코프 D : [ , 1 { { : \ \ \{ [ , { \ displaystyle \ mu 생성자에 대한 전략 집합은 임의 확률 를 포함한다\ \Omega}

단, 아래와 같이에 대한 최적의 판별기은 결정론적이므로 판별기 전략을 인 함수D : [, 1 {D \ 대부분의 애플리케이션에서 D D는 심층 뉴럴 네트워크 기능입니다

발생기는 이론적으로 G _는 어떤 계산 가능한 확률 분포가 될 수 있지만 는 G Z G - style \ _}=\_{ G로 구현된다.즉, 랜덤 z ~ Z z _로 시작합니다. 서 μ Z \ _Z})는 계산하기 쉬운 확률 분포(예: 균일한 분포 또는 가우스 분포)이며, 다음으로 G: Z ({ G를 정의합니다 는 G의 입니다.

따라서 제너레이터의 전략은 보통 G G로 정의되며 z~ Z z _는 암묵적으로 .이 형식주의에서 GAN 게임의 목표는

생성적 재자극

GAN 아키텍처에는 2개의 주요 컴포넌트가 있습니다.하나는 D ( ,) ( \ \ { G \ _ }( G ,D ), min min min min min min min min min display display ( \ style \ _ { \ )의 최적화를 게임에 캐스팅하는 것입니다.다른 하나는 G _를 Z - 1(\ \ _}\1로 분해하는 것으로, 리파라메트리제이션 트릭으로 이해할 수 있다.

그 중요성을 확인하려면, GAN을 "최대우도 추정과 관련 전략에서 발생하는 다루기 어려운 확률론적 계산"[1]으로 어려움을 겪었던 이전 학습 생성 모델 방법과 비교해야 한다.

동시에, Kingma와[10] Welling and Rezende [11]등은 일반적인 확률적 역전파 방법으로 리파라메트리제이션의 동일한 아이디어를 개발했다.최초의 어플리케이션으로는 변이형 자동 인코더가 있습니다.

이동 순서 및 전략적 균형

대부분의 후속 논문과 마찬가지로 원본 논문에서는 일반적으로 발전기가 먼저 이동하고 판별기가 두 번째로 이동한다고 가정하여 다음과 같은 미니맥스 게임을 제공한다.

만약 발생기와 판별기의 전략 집합이 모두 한정된 수의 전략과 미니맥스 정리에 의해 확장된다면,

그러나 전략 집합이 둘 다 완전히 확장되지 않기 때문에 미니맥스 정리가 적용되지 않고 "균형"의 개념이 섬세해진다.참고로 평형에는 다음과 같은 다른 개념이 있습니다.

- 발전기가 먼저 이동하고 식별기가 두 번째로 이동하는 경우의 평형:

- 판별기가 먼저 이동하고 발전기가 두 번째로 이동하는 경우의 평형:

- 내쉬 평형^ ^ G {}} {}}_{G 동시 이동 순서에서 안정적입니다.

일반 게임의 경우, 이러한 균형은 일치하거나 존재할 필요가 없습니다.원래의 GAN 게임의 경우, 이러한 균형은 모두 존재하며 모두 동일합니다.그러나 보다 일반적인 GAN 게임에서는 이러한 게임들이 반드시 존재하거나 동의하는 [12]것은 아닙니다.

GAN 게임의 주요 정리

원래의 GAN 페이퍼에서는, 다음의 2개의 [1]이론이 실증되었습니다.

정리(최적 판별자는 젠슨-샤논 발산 계산) — 고정 제너레이터 G(\ _에 대해 최적의 응답은 D arg L G { D^{*}=\ {D}, })가 .

젠슨의 부등식에 의해

우리는 그들의 밀도 함수를 취하기를 원하므로, 기준 : r + G { \ mu : = \ _ { } + \ _ { } 를 정의하면 라돈-니코다임 유도체를 취할 수 있다.

거랑 같이...

integrand는 의 바이너리 랜덤 변수 사이의 음의 교차 엔트로피로서, 「r와「로 정의됩니다.「 ( r (x) - K ( ) ( X)라고 쓸 수 있습니다. 서 H H는 이진 엔트로피 함수입니다.그래서...

따라서 식별자의 최적의 전략은 () r ( ){ D (x) = \_ {} ( 입니다.

정기적인 계산 후.

해석:임의의 고정 제너레이터 G _에 대해 최적 판별기는 기준 분포와 제너레이터 분포 사이의 우도비를 추적합니다.

정리(고유 평형점) — 모든 GAN 게임에는 순차 평형 및 내쉬 평형인 ^ ^G { {}}가 합니다.

즉, 제너레이터는 참조를 완벽하게 모방하고 식별기는 모든 입력에 대해 결정적으로 를 합니다.

이전 제안에서,

고정 판별기 D의 경우 세트에 집중된 GG})

젠슨의 부등식에 의해 판별자는 항상 D ~ D ( [ { D)=\ _ _를 으로써 개선될 수 있다.

옌센의 부등식에 의해, 그것은 에 의해 상계이다.

이제 상한을 누릅니다.

상한은 실제로 D 2 D)=에 도달했습니다.

마지막으로 내쉬 평형인지 확인합니다.

G f{ \ _ { G } = \ _ { }인 ,

x 、 D( ) 1 \ x \ \ Omega , \ { D } ( x ) = \ _ { \ {1 2일 경우, 제너레이터에는 어떤 전략도 최적입니다.

GAN 훈련 및 평가

트레이닝

불안정한 컨버전스

GAN 게임은 생성자와 판별자 모두 전체 전략 세트에 액세스할 수 있는 고유한 전역 균형 지점을 가지고 있지만, 제한된 전략 [12]세트를 가지고 있을 때 균형은 더 이상 보장되지 않습니다.

실제로 제너레이터는 Z G - (\ {}^{-의 측정값에만 접근할 수 있습니다.서 G {\는 있는 뉴럴 네트워크에 의해 계산된 균등분포나 정규분포와 같은 ED분포.Similarly, the discriminator has access only to functions of form , a function computed by a neural network with parameters . These restricted strategy sets take up a vanishingly small proportion of their entire strategy sets.[13]

또한 평형이 아직 존재하더라도 가능한 모든 뉴럴 네트워크 함수의 고차원 공간을 탐색해야만 평형을 찾을 수 있다.「GAN」, 「GAN」, 「GAN」, 「GAN」이 있습니다.

collapse( 축소)

GAN은 모드붕괴로 인해 적절히 일반화하지 못하고 입력 데이터에서 모드 전체가 손실되는 경우가 많습니다.예를 들어, 각 자릿수의 많은 샘플을 포함하는 MNIST 데이터 세트에 대해 훈련받은 GAN은 숫자 0의 그림만 생성할 수 있습니다.이것은 첫 번째 논문에서 "헬베티카 시나리오"로 명명되었습니다.

이러한 현상이 발생할 수 있는 한 가지 방법은 발생기가 식별기에 비해 너무 빨리 학습하는 것입니다.만약 판별기 D{D\displaystyle}일정하다면, 그 최적의 발전기만 출력 아그 최대의 요소 xD는 몇 시대에MNIST의 데이터를 생산하는 GAN 훈련 동안은 판별기 어떻게든 약간 고르보다 더 많은 0숫자를 선호한다({\displaystyle \arg \max_{)}())}그래서 예를 들어, .[14].그녀.발생기가 숫자 0만 생성할 수 있는 기회를 포착한 다음 식별기가 개선된 후 로컬 최소값을 벗어날 수 없습니다.

일부 연구자들은 근본적인 문제를 누락 패턴을 알아차리지 못하는 약한 차별적 네트워크로 인식하는 반면, 다른 연구자들은 객관적 기능의 잘못된 선택에 책임을 부여한다.많은 해결책이 제안되었지만,[15][16] 여전히 해결되지 않은 문제입니다.

최첨단 아키텍처인 BigGAN(2019)도 모드 붕괴를 피할 수 없었습니다.저자들은 "훈련의 후반 단계에서 붕괴가 일어나도록 허용하고, 이때까지 모델은 좋은 결과를 얻기 위해 충분히 훈련된다"[17]고 주장했다.

두 개의 시간 척도 업데이트 규칙

2개의 시간 척도 업데이트 규칙(TTUR)은 발전기의 학습 속도를 판별기보다 낮게 하여 GAN 수렴을 보다 안정적으로 하기 위해 제안된다.저자들은 발전기가 "수집된 정보를 캡처하지 않고 새로운 영역으로 꾸준히 판별기를 구동하지 않도록" 판별기보다 느리게 이동해야 한다고 주장했다.

그들은 GAN 게임을 포함한 일반적인 게임 클래스가 TTUR에서 훈련되었을 때 "약간의 가정 하에서 정지된 국소 내쉬 평형으로 수렴"[18]된다는 것을 증명했다.

그들은 또한 모드 붕괴를 피하기 위해 Adam 확률적[19] 최적화를 사용할 것과 GAN 성과를 평가하기 위한 Fréchet 개시 거리를 사용할 것을 제안했다.

소실 경사

반대로 판별기가 제너레이터에 비해 너무 빨리 학습하는 경우 판별기는 G, {\ \mu _{ \ _{ref를 거의 완벽하게 구별할 수 있습니다. 이 경우 G {\는 직접적인 손실이 발생하지 않는 매우 높은 상태로 고착될 수 있습니다. 가 바뀝니다.즉, 구배∇ ( ){ _ { \} L ( G { \} , D _ { \ }} } }는 0에 가깝습니다.이 경우 발전기는 학습할 수 없으며, 소실 구배 [13]문제의 경우이다.

직관적으로 말하면, 식별기는 너무 우수하며, 발전기는 보상을 개선하기 위해 작은 단계(구배 강하 시 작은 단계만 고려됨)를 취할 수 없기 때문에 시도조차 하지 않는다.

이 문제를 해결하기 위한 중요한 방법 중 하나는 Wasserstein GAN입니다.

평가하기

GAN은 일반적으로 발생기의 출력이 얼마나 다양한지 측정하는 인셉션 점수(IS) 또는 발생기의 출력이 기준 세트와 얼마나 유사한지 측정하는 프레셰 인셉션 거리(FID)에 의해 평가된다(예: 인셉션 v3와 같은 학습된 이미지 특성화기에 의해 분류됨).마지막 레이어를 펼칩니다).이미지 생성을 위한 새로운 GAN 아키텍처를 제안하는 많은 논문들은 그들의 아키텍처가 FID 또는 IS의 최첨단 기술을 어떻게 무너뜨리는지를 보고한다.

또 다른 평가방법은 LPIPS(Learned Perceptual Image Patch Similarity)입니다.Learned Perceptual Image f R n {\Imagetext}\ {Rn에서 하여 xdifferential에 대한지도에 대한 학습으로 합니다 {\ 여기서(\는 이미지, 는 이미지, x(\는 이미지 perceptualDifference는 차이(\의 차이)입니다.은 f (x) - f , \}()-}(}(에 근접하도록 미세 조정됩니다그런 다음 이 미세 조정 모델을 하여LPIPS , ) ) : " "() - " ( ) )"\ \{\)-}([20]}.

기타 평가 방법에 대해 검토합니다.[21]

변종

GAN [22]변종들의 진짜 동물원이 있다.대표적인 예는 다음과 같습니다.

조건부 GAN

GAN 게임의 생성기는 확률 공간(\에 확률 분포인 μ 를 합니다.이것은 조건부 GAN의 개념으로 이어지며, 에서 하나의 확률 분포를 생성하지 않고 생성기가 다른 확률 분포를 생성합니다.lity G() \ \ Omega 、 각 클래스 \\ { G ( c) 。

예를 들어 ImageNet과 유사한 이미지를 생성하는 경우 생성기는 클래스 라벨 "cat"이 지정되면 cat 이미지를 생성할 수 있어야 합니다.

원본 논문에서,[1] 저자들은 GAN이 발생기와 식별자 모두에게 라벨을 제공함으로써 조건부 GAN으로 확장될 수 있다는 점에 주목했다.

구체적으로 조건부 GAN 게임은 클래스 라벨이 제공되는 GAN 게임일 뿐입니다.

2017년에 조건부 GAN은 ImageNet의 [23]1000개의 이미지 클래스를 생성하는 방법을 배웠습니다.

대체 아키텍처를 사용하는 GAN

GAN게임은 일반적인 프레임워크로 G와 의 합리적인 파라미터화로 실행할 수 있으며, 원작에서는 다층 퍼셉트론 네트워크와 컨볼루션 뉴럴 네트워크를 사용하여 시연하였다.많은 대체 아키텍처가 시도되었습니다.

Deep Convolution GAN([24]DCGAN): 제너레이터와 식별자 모두에 대해 완전히 Convolution-deconvolution 레이어로 구성된 딥 네트워크,[25] 즉 완전한 Convolution 네트워크만 사용합니다.

Self-Attention GAN(SAGAN):[26] DCGAN에서 시작하여 잔류 연결된 표준 Self-Attention 모듈을 제너레이터 및 식별기에 추가합니다.

트랜스포머 GAN(TransGAN):[27] 발전기와 판별기 모두에 순수 트랜스포머 아키텍처를 사용합니다.컨볼루션-디콘볼루션 레이어가 전혀 없습니다.

Flow-GAN:[28] 발생기에 흐름 기반 생성 모델을 사용하여 우도 함수를 효율적으로 계산할 수 있습니다.

대체 목표를 가진 GAN

많은 GAN 변종들은 단순히 발생기와 판별기에 대한 손실 함수를 변경함으로써 얻어진다.

오리지널 GAN:

비교를 위해 보다 편리한 형태로 원래의 GAN 목표를 다시 캐스트합니다.

원래 GAN, 비포화 손실:

발전기의 이 목표는 더 빠른 [1]수렴을 위해 원본 문서에서 권장되었습니다.

원래 GAN, 최대 가능성:

Wasserstein GAN(WGAN)

Wasserstein GAN은 다음 두 가지 지점에서 GAN 게임을 수정합니다.

- 식별기의 전략 세트는 D \ D의 측정 가능한 함수 세트이다.\유계 립시츠 노름) : D L K \ \ { } \ K) 서 K K는 고정 양의 상수입니다.

- 목적은

그 목적 중 하나는 모드 축소 문제를 해결하는 것입니다(위 [13]참조).저자들은 "실험에서 WGAN 알고리즘에 대한 모드 붕괴의 증거를 본 적이 없다"고 주장한다.

2인 이상 GAN

정보 GAN

조건부 GAN에서는 제너레이터는 노이즈 z(\ z와 c(\ c를 모두 수신하여 G를 생성합니다.식별자는 이미지 라벨 을 수신하고 컴퓨터 D(\ 를 수신합니다.

교육 데이터 세트가 레이블이 없는 경우 조건부 GAN은 직접 작동하지 않습니다.

InfoGAN의 개념은 잠재 공간의 모든 잠재 벡터를 ( { ( : 압축할 수 없는 부분 z {z} 및 정보 부분 c {c로 분해할 수 있도록 명령하고 이를 으로써 발전기가 명령을 준수하도록 유도하는 것입니다. { I c c와 G 간의 정보 G GG 간의 에 대한 요구는 없습니다.

아쉽게도( c ,( z , I ( , ( , c) }}는 일반적으로 다루기 어렵습니다.InfoGAN의 주요 아이디어는 Variational Mutual Information Maximization [34]입니다.하한을 최대화하여 간접적으로 최대화합니다.

InfoGAN 게임은 다음과 [35]같이 정의됩니다.

InfoGAN 게임을 정의하는 세 가지 확률 공간:

- , e) \ ( \ _ { , \ _ { } 참조 이미지의 공간.

- Z _ _ 고정 랜덤 노이즈 발생기.

- C C _ _ 고정 랜덤 정보 생성기.

발전기, Q, 판별기 등 3개 팀으로 구성되어 있습니다.제너레이터와 Q는 한 팀에 있고 식별자는 다른 팀에 있습니다.

목적 함수는

서 L G N ( ,D ) x ~ r , [ D () + z ~Z [ ( - ( ,), D)=\ { _{ref}_{x}_{ref}제너레이터-Q 팀은 목표를 최소화하는 것을 목표로 하고 식별자는 목표를 최대화하는 것을 목표로 합니다.

양방향 GAN(BiGAN)

표준 GAN 생성기는 G : Z X\ G : \ _ { } \ \_ { }의 함수입니다.즉, 잠복 공간 Z \ style \ _ { }에서 이미지 X style \ Omega _ { }로의 매핑입니다.tor is a code for an image , and the generator performs the decoding.이것에 의해, 「인코딩」을 실행하는 다른 네트워크를 트레이닝 해, 인코더와 제너레이터의 쌍으로부터 자동 인코더를 작성하는 것이 자연스럽게 됩니다.

저자들은 이미 원본 [1]논문에서 "\displaystyle x\"가 주어진 z z를 하도록 보조 네트워크를 훈련함으로써 대략적인 추론을 수행할 수 있다"고 언급했다.쌍방향 GAN 아키텍처는 정확히 [36]이 작업을 수행합니다.

BiGAN은 다음과 같이 정의됩니다.

BiGAN 게임을 정의하는 두 가지 확률 공간:

- , X (\},\{X 참조 이미지의 공간.

- Z _{_{ 잠복 공간.

There are 3 players in 2 teams: generator, encoder, and discriminator. The generator and encoder are on one team, and the discriminator on the other team.

The generator's strategies are functions , and the encoder's strategies are functions . The discriminator's strategies are functions .

The objective function is

Generator-encoder team aims to minimize the objective, and discriminator aims to maximize it:

In the paper, they gave a more abstract definition of the objective as:

Applications of bidirectional models include semi-supervised learning,[37] interpretable machine learning,[38] and neural machine translation.[39]

Variational autoencoder GAN (VAEGAN)

Adversarial autoencoder

CycleGAN

CycleGAN is an architecture for performing paired translations between two domains, such as between photos of horses and photos of zebras, or photos of night cities and photos of day cities.

The CycleGAN game is defined as follows:[42]

There are two probability spaces , corresponding to the two domains needed for translations fore-and-back.

There are 4 players in 2 teams: generators , and discriminators .

The objective function is

where is a positive adjustable parameter, is the GAN game objective, and is the cycle consistency loss:

The generators aim to minimize the objective, and the discriminators aim to maximize it:

Unlike previous work like pix2pix,[43] which requires paired training data, cycleGAN requires no paired data. For example, to train a pix2pix model to turn a summer scenery photo to winter scenery photo and back, the dataset must contain pairs of the same place in summer and winter, shot at the same angle; cycleGAN would only need a set of summer scenery photos, and an unrelated set of winter scenery photos.

GANs with particularly large or small scales

BigGAN

The BigGAN is essentially a self-attention GAN trained on a large scale (up to 80 million parameters) to generate large images of ImageNet (up to 512 x 512 resolution), with numerous engineering tricks to make it converge.[17][44]

Invertible data augmentation

When there is insufficient training data, the reference distribution cannot be well-approximated by the empirical distribution given by the training dataset. In such cases, data augmentation can be applied, to allow training GAN on smaller datasets. Naïve data augmentation, however, brings its problems.

Consider the original GAN game, slightly reformulated as follows:

The result of such training would be a generator that mimics . For example, it would generate images that look like they are randomly cropped, if the data augmentation uses random cropping.

The solution is to apply data augmentation to both generated and real images:

The StyleGAN-2-ADA paper points out a further point on data augmentation: it must be invertible.[46] Continue with the example of generating ImageNet pictures. If the data augmentation is "randomly rotate the picture by 0, 90, 180, 270 degrees with equal probability", then there is no way for the generator to know which is the true orientation: Consider two generators , such that for any latent , the generated image is a 90-degree rotation of . They would have exactly the same expected loss, and so neither is preferred over the other.

The solution is to only use invertible data augmentation: instead of "randomly rotate the picture by 0, 90, 180, 270 degrees with equal probability", use "randomly rotate the picture by 90, 180, 270 degrees with 0.1 probability, and keep the picture as it is with 0.7 probability". This way, the generator is still rewarded to keep images oriented the same way as un-augmented ImageNet pictures.

Abstractly, the effect of randomly sampling transformations from the distribution is to define a Markov kernel . Then, the data-augmented GAN game pushes the generator to find some , such that

There are two prototypical examples of invertible Markov kernels:

Discrete case: Invertible stochastic matrices, when is finite.

For example, if is the set of four images of an arrow, pointing in 4 directions, and the data augmentation is "randomly rotate the picture by 90, 180, 270 degrees with probability , and keep the picture as it is with probability ", then the Markov kernel can be represented as a stochastic matrix:

Continuous case: The gaussian kernel, when for some .

For example, if is the space of 256x256 images, and the data-augmentation method is "generate a gaussian noise , then add to the image", then is just convolution by the density function of . This is invertible, because convolution by a gaussian is just convolution by the heat kernel, so given any , the convolved distribution can be obtained by heating up precisely according to , then wait for time . With that, we can recover by running the heat equation backwards in time for .

More examples of invertible data augmentations are found in the paper.[46]

SinGAN

SinGAN pushes data augmentation to the limit, by using only a single image as training data and performing data augmentation on it. The GAN architecture is adapted to this training method by using a multi-scale pipeline.

The generator is decomposed into a pyramid of generators , with the lowest one generating the image at the lowest resolution, then the generated image is scaled up to , and fed to the next level to generate an image at a higher resolution, and so on. The discriminator is decomposed into a pyramid as well.[47]

StyleGAN series

The StyleGAN family is a series of architectures pubilshed by Nvidia's research division.

Progressive GAN

Progressive GAN[48] is a method for training GAN for large-scale image generation stably, by growing a GAN generator from small to large scale in a pyramidal fashion. Like SinGAN, it decomposes the generator as, and the discriminator as .

During training, at first only are used in a GAN game to generate 4x4 images. Then are added to reach the second stage of GAN game, to generate 8x8 images, and so on, until we reach a GAN game to generate 1024x1024 images.

To avoid shock between stages of the GAN game, each new layer is "blended in" (Figure 2 of the paper[48]). For example, this is how the second stage GAN game starts:

- Just before, the GAN game consists of the pair generating and discriminating 4x4 images.

- Just after, the GAN game consists of the pair generating and discriminating 8x8 images. Here, the functions are image up- and down-sampling functions, and is a blend-in factor (much like an alpha in image composing) that smoothly glides from 0 to 1.

StyleGAN-1

StyleGAN-1 is designed as a combination of Progressive GAN with neural style transfer.[49]

The key architectural choice of StyleGAN-1 is a progressive growth mechanism, similar to Progressive GAN. Each generated image starts as a constant array, and repeatedly passed through style blocks. Each style block applies a "style latent vector" via affine transform ("adaptive instance normalization"), similar to how neural style transfer uses Gramian matrix. It then adds noise, and normalize (subtract the mean, then divide by the variance).

At training time, usually only one style latent vector is used per image generated, but sometimes two ("mixing regularization") in order to encourage each style block to independently perform its stylization without expecting help from other style blocks (since they might receive an entirely different style latent vector).

After training, multiple style latent vectors can be fed into each style block. Those fed to the lower layers control the large-scale styles, and those fed to the higher layers control the fine-detail styles.

Style-mixing between two images can be performed as well. First, run a gradient descent to find such that . This is called "projecting an image back to style latent space". Then, can be fed to the lower style blocks, and to the higher style blocks, to generate a composite image that has the large-scale style of , and the fine-detail style of . Multiple images can also be composed this way.

StyleGAN-2

StyleGAN-2 improves upon StyleGAN-1, by using the style latent vector to transform the convolution layer's weights instead, thus solving the "blob" problem.[50]

This was updated by the StyleGAN-2-ADA ("ADA" stands for "adaptive"),[46] which uses invertible data augmentation as described above. It also tunes the amount of data augmentation applied by starting at zero, and gradually increasing it until an "overfitting heuristic" reaches a target level, thus the name "adaptive".

StyleGAN-3

StyleGAN-3[51] improves upon StyleGAN-2 by solving the "texture sticking" problem, which can be seen in the official videos.[52] They analyzed the problem by the Nyquist–Shannon sampling theorem, and argued that the layers in the generator learned to exploit the high-frequency signal in the pixels they operate upon.

To solve this, they proposed imposing strict lowpass filters between each generator's layers, so that the generator is forced to operate on the pixels in a way faithful to the continuous signals they represent, rather than operate on them as merely discrete signals. They further imposed rotational and translational invariance by using more signal filters. The resulting StyleGAN-3 is able to sole the texture sticking problem, as well as generating images that rotate and translate smoothly.

Applications

GAN applications have increased rapidly.[53]

Fashion, art and advertising

GANs can be used to generate art; The Verge wrote in March 2019 that "The images created by GANs have become the defining look of contemporary AI art."[55] GANs can also be used to inpaint photographs[56] or create photos of imaginary fashion models, with no need to hire a model, photographer or makeup artist, or pay for a studio and transportation.[57] GANs have also been used for virtual shadow generation.[58]

Science

GANs can improve astronomical images[59] and simulate gravitational lensing for dark matter research.[60][61][62] They were used in 2019 to successfully model the distribution of dark matter in a particular direction in space and to predict the gravitational lensing that will occur.[63][64]

GANs have been proposed as a fast and accurate way of modeling high energy jet formation[65] and modeling showers through calorimeters of high-energy physics experiments.[66][67][68][69] GANs have also been trained to accurately approximate bottlenecks in computationally expensive simulations of particle physics experiments. Applications in the context of present and proposed CERN experiments have demonstrated the potential of these methods for accelerating simulation and/or improving simulation fidelity.[70][71]

Video games

In 2018, GANs reached the video game modding community, as a method of up-scaling low-resolution 2D textures in old video games by recreating them in 4k or higher resolutions via image training, and then down-sampling them to fit the game's native resolution (with results resembling the supersampling method of anti-aliasing).[72] With proper training, GANs provide a clearer and sharper 2D texture image magnitudes higher in quality than the original, while fully retaining the original's level of details, colors, etc. Known examples of extensive GAN usage include Final Fantasy VIII, Final Fantasy IX, Resident Evil REmake HD Remaster, and Max Payne.[citation needed]

Audio synthesis

This article's tone or style may not reflect the encyclopedic tone used on Wikipedia. (July 2017) |

Generative audio refers to the creation of audio files from databases of audio clips. This technology differs from AI voices such as Apple's Siri or Amazon's Alexa, which use a collection of fragments that are stitched together on demand.

"Generative audio works differently [to traditional digital voices], using neural networks to learn the statistical properties of the audio source in question, then reproducing those properties directly in any context, modelling how speech changes not just second-by-second, but millisecond-by-millisecond."[73]

Concerns about malicious applications

Concerns have been raised about the potential use of GAN-based human image synthesis for sinister purposes, e.g., to produce fake, possibly incriminating, photographs and videos.[74] GANs can be used to generate unique, realistic profile photos of people who do not exist, in order to automate creation of fake social media profiles.[75]

In 2019 the state of California considered[76] and passed on October 3, 2019, the bill AB-602, which bans the use of human image synthesis technologies to make fake pornography without the consent of the people depicted, and bill AB-730, which prohibits distribution of manipulated videos of a political candidate within 60 days of an election. Both bills were authored by Assembly member Marc Berman and signed by Governor Gavin Newsom. The laws went into effect in 2020.[77]

DARPA's Media Forensics program studies ways to counteract fake media, including fake media produced using GANs.[78]

Transfer learning

State-of-art transfer learning research use GANs to enforce the alignment of the latent feature space, such as in deep reinforcement learning.[79] This works by feeding the embeddings of the source and target task to the discriminator which tries to guess the context. The resulting loss is then (inversely) backpropagated through the encoder.

Miscellaneous applications

GAN can be used to detect glaucomatous images helping the early diagnosis which is essential to avoid partial or total loss of vision.[80]

GANs that produce photorealistic images can be used to visualize interior design, industrial design, shoes,[81] bags, and clothing items or items for computer games' scenes.[citation needed] Such networks were reported to be used by Facebook.[82]

GAN's have been used to create forensic facial reconstructions of deceased historical figures.[83]

GANs can reconstruct 3D models of objects from images,[84] generate novel objects as 3D point clouds,[85] and model patterns of motion in video.[86]

GANs can be used to age face photographs to show how an individual's appearance might change with age.[87]

GANs can be used for data augmentation, eg. to improve DNN classifier [88]

GANs can also be used to inpaint missing features in maps,[89] transfer map styles in cartography[90] or augment street view imagery.[91]

Relevance feedback on GANs can be used to generate images and replace image search systems.[92]

A variation of the GANs is used in training a network to generate optimal control inputs to nonlinear dynamical systems. Where the discriminatory network is known as a critic that checks the optimality of the solution and the generative network is known as an Adaptive network that generates the optimal control. The critic and adaptive network train each other to approximate a nonlinear optimal control.[93]

GANs have been used to visualize the effect that climate change will have on specific houses.[94]

A GAN model called Speech2Face can reconstruct an image of a person's face after listening to their voice.[95]

In 2016 GANs were used to generate new molecules for a variety of protein targets implicated in cancer, inflammation, and fibrosis. In 2019 GAN-generated molecules were validated experimentally all the way into mice.[96][97]

Whereas the majority of GAN applications are in image processing, the work has also been done with time-series data. For example, recurrent GANs (R-GANs) have been used to generate energy data for machine learning.[98]

History

The most direct inspiration for GANs was noise-contrastive estimation,[99] which uses the same loss function as GANs and which Goodfellow studied during his PhD in 2010–2014.

Other people had similar ideas but did not develop them similarly. An idea involving adversarial networks was published in a 2010 blog post by Olli Niemitalo.[100] This idea was never implemented and did not involve stochasticity in the generator and thus was not a generative model. It is now known as a conditional GAN or cGAN.[101] An idea similar to GANs was used to model animal behavior by Li, Gauci and Gross in 2013.[102]

Adversarial machine learning has other uses besides generative modeling and can be applied to models other than neural networks. In control theory, adversarial learning based on neural networks was used in 2006 to train robust controllers in a game theoretic sense, by alternating the iterations between a minimizer policy, the controller, and a maximizer policy, the disturbance.[103][104]

In 2017, a GAN was used for image enhancement focusing on realistic textures rather than pixel-accuracy, producing a higher image quality at high magnification.[105] In 2017, the first faces were generated.[106] These were exhibited in February 2018 at the Grand Palais.[107][108] Faces generated by StyleGAN[109] in 2019 drew comparisons with deepfakes.[110][111][112]

Beginning in 2017, GAN technology began to make its presence felt in the fine arts arena with the appearance of a newly developed implementation which was said to have crossed the threshold of being able to generate unique and appealing abstract paintings, and thus dubbed a "CAN", for "creative adversarial network".[113] A GAN system was used to create the 2018 painting Edmond de Belamy, which sold for US$432,500.[114] An early 2019 article by members of the original CAN team discussed further progress with that system, and gave consideration as well to the overall prospects for an AI-enabled art.[115]

In May 2019, researchers at Samsung demonstrated a GAN-based system that produces videos of a person speaking, given only a single photo of that person.[116]

In August 2019, a large dataset consisting of 12,197 MIDI songs each with paired lyrics and melody alignment was created for neural melody generation from lyrics using conditional GAN-LSTM (refer to sources at GitHub AI Melody Generation from Lyrics).[117]

In May 2020, Nvidia researchers taught an AI system (termed "GameGAN") to recreate the game of Pac-Man simply by watching it being played.[118][119]

References

- ^ a b c d e f g h i Goodfellow, Ian; Pouget-Abadie, Jean; Mirza, Mehdi; Xu, Bing; Warde-Farley, David; Ozair, Sherjil; Courville, Aaron; Bengio, Yoshua (2014). Generative Adversarial Nets (PDF). Proceedings of the International Conference on Neural Information Processing Systems (NIPS 2014). pp. 2672–2680.

- ^ Salimans, Tim; Goodfellow, Ian; Zaremba, Wojciech; Cheung, Vicki; Radford, Alec; Chen, Xi (2016). "Improved Techniques for Training GANs". arXiv:1606.03498 [cs.LG].

- ^ Isola, Phillip; Zhu, Jun-Yan; Zhou, Tinghui; Efros, Alexei (2017). "Image-to-Image Translation with Conditional Adversarial Nets". Computer Vision and Pattern Recognition.

- ^ Ho, Jonathon; Ermon, Stefano (2016). "Generative Adversarial Imitation Learning". Advances in Neural Information Processing Systems. 29: 4565–4573. arXiv:1606.03476. Bibcode:2016arXiv160603476H.

- ^ "Vanilla GAN (GANs in computer vision: Introduction to generative learning)". theaisummer.com. AI Summer. April 10, 2020. Archived from the original on June 3, 2020. Retrieved September 20, 2020.

- ^ Luc, Pauline; Couprie, Camille; Chintala, Soumith; Verbeek, Jakob (November 25, 2016). "Semantic Segmentation using Adversarial Networks". NIPS Workshop on Adversarial Training, Dec, Barcelona, Spain. 2016. arXiv:1611.08408. Bibcode:2016arXiv161108408L.

- ^ Andrej Karpathy; Pieter Abbeel; Greg Brockman; Peter Chen; Vicki Cheung; Rocky Duan; Ian Goodfellow; Durk Kingma; Jonathan Ho; Rein Houthooft; Tim Salimans; John Schulman; Ilya Sutskever; Wojciech Zaremba, Generative Models, OpenAI, retrieved April 7, 2016

- ^ Mohamed, Shakir; Lakshminarayanan, Balaji (2016). "Learning in Implicit Generative Models". arXiv:1610.03483 [stat.ML].

- ^ a b Goodfellow, Ian (April 3, 2017). "NIPS 2016 Tutorial: Generative Adversarial Networks". arXiv:1701.00160 [cs].

- ^ Kingma, Diederik P.; Welling, Max (May 1, 2014). "Auto-Encoding Variational Bayes". arXiv:1312.6114.

{{cite journal}}: Cite journal requiresjournal=(help) - ^ Rezende, Danilo Jimenez; Mohamed, Shakir; Wierstra, Daan (June 18, 2014). "Stochastic Backpropagation and Approximate Inference in Deep Generative Models". International Conference on Machine Learning. PMLR: 1278–1286. arXiv:1401.4082.

- ^ a b Farnia, Farzan; Ozdaglar, Asuman (November 21, 2020). "Do GANs always have Nash equilibria?". International Conference on Machine Learning. PMLR: 3029–3039.

- ^ a b c Weng, Lilian (April 18, 2019). "From GAN to WGAN". arXiv:1904.08994.

{{cite journal}}: Cite journal requiresjournal=(help) - ^ "r/MachineLearning - Comment by u/ian_goodfellow on "[R] [1701.07875] Wasserstein GAN". reddit. Retrieved July 15, 2022.

- ^ Lin, Zinan; et al. (December 2018). PacGAN: the power of two samples in generative adversarial networks. 32nd International Conference on Neural Information Processing Systems. pp. 1505–1514. arXiv:1712.04086.

- ^ Mescheder, Lars; Geiger, Andreas; Nowozin, Sebastian (July 31, 2018). "Which Training Methods for GANs do actually Converge?". arXiv:1801.04406 [cs.LG].

- ^ a b Brock, Andrew; Donahue, Jeff; Simonyan, Karen (September 1, 2018). Large Scale GAN Training for High Fidelity Natural Image Synthesis. International Conference on Learning Representations 2019.

- ^ Heusel, Martin; Ramsauer, Hubert; Unterthiner, Thomas; Nessler, Bernhard; Hochreiter, Sepp (2017). "GANs Trained by a Two Time-Scale Update Rule Converge to a Local Nash Equilibrium". Advances in Neural Information Processing Systems. Curran Associates, Inc. 30. arXiv:1706.08500.

- ^ Kingma, Diederik P.; Ba, Jimmy (January 29, 2017). "Adam: A Method for Stochastic Optimization". arXiv:1412.6980.

{{cite journal}}: Cite journal requiresjournal=(help) - ^ Zhang, Richard; Isola, Phillip; Efros, Alexei A.; Shechtman, Eli; Wang, Oliver (2018). "The Unreasonable Effectiveness of Deep Features as a Perceptual Metric": 586–595. arXiv:1801.03924.

{{cite journal}}: Cite journal requiresjournal=(help) - ^ Borji, Ali (February 1, 2019). "Pros and cons of GAN evaluation measures". Computer Vision and Image Understanding. 179: 41–65. arXiv:1802.03446. doi:10.1016/j.cviu.2018.10.009. ISSN 1077-3142. S2CID 3627712.

- ^ Hindupur, Avinash (July 15, 2022), The GAN Zoo, retrieved July 15, 2022

- ^ Odena, Augustus; Olah, Christopher; Shlens, Jonathon (July 17, 2017). "Conditional Image Synthesis with Auxiliary Classifier GANs". International Conference on Machine Learning. PMLR: 2642–2651. arXiv:1610.09585.

- ^ Radford, Alec; Metz, Luke; Chintala, Soumith (2016). "Unsupervised Representation Learning with Deep Convolutional Generative Adversarial Networks". ICLR. S2CID 11758569.

- ^ Long, Jonathan; Shelhamer, Evan; Darrell, Trevor (2015). "Fully Convolutional Networks for Semantic Segmentation": 3431–3440.

{{cite journal}}: Cite journal requiresjournal=(help) - ^ Zhang, Han; Goodfellow, Ian; Metaxas, Dimitris; Odena, Augustus (May 24, 2019). "Self-Attention Generative Adversarial Networks". International Conference on Machine Learning. PMLR: 7354–7363.

- ^ Jiang, Yifan; Chang, Shiyu; Wang, Zhangyang (December 8, 2021). "TransGAN: Two Pure Transformers Can Make One Strong GAN, and That Can Scale Up". arXiv:2102.07074.

{{cite journal}}: Cite journal requiresjournal=(help) - ^ Grover, Aditya; Dhar, Manik; Ermon, Stefano (May 1, 2017). "Flow-GAN: Combining Maximum Likelihood and Adversarial Learning in Generative Models". arXiv:1705.08868.

{{cite journal}}: Cite journal requiresjournal=(help) - ^ Arjovsky, Martin; Bottou, Léon (January 1, 2017). "Towards Principled Methods for Training Generative Adversarial Networks". arXiv:1701.04862.

{{cite journal}}: Cite journal requiresjournal=(help) - ^ Goodfellow, Ian J. (December 1, 2014). "On distinguishability criteria for estimating generative models". arXiv:1412.6515.

{{cite journal}}: Cite journal requiresjournal=(help) - ^ Goodfellow, Ian (August 31, 2016). "Generative Adversarial Networks (GANs), Presentation at Berkeley Artificial Intelligence Lab" (PDF). Archived (PDF) from the original on May 8, 2022.

- ^ Lim, Jae Hyun; Ye, Jong Chul (May 8, 2017). "Geometric GAN". arXiv:1705.02894.

{{cite journal}}: Cite journal requiresjournal=(help) - ^ Mao, Xudong; Li, Qing; Xie, Haoran; Lau, Raymond Y. K.; Wang, Zhen; Paul Smolley, Stephen (2017). "Least Squares Generative Adversarial Networks": 2794–2802.

{{cite journal}}: Cite journal requiresjournal=(help) - ^ Barber, David; Agakov, Felix (December 9, 2003). "The IM algorithm: a variational approach to Information Maximization". Proceedings of the 16th International Conference on Neural Information Processing Systems. NIPS'03. Cambridge, MA, USA: MIT Press: 201–208.

- ^ Chen, Xi; Duan, Yan; Houthooft, Rein; Schulman, John; Sutskever, Ilya; Abbeel, Pieter (2016). "InfoGAN: Interpretable Representation Learning by Information Maximizing Generative Adversarial Nets". Advances in Neural Information Processing Systems. Curran Associates, Inc. 29. arXiv:1606.03657.

- ^ Donahue, Jeff; Krähenbühl, Philipp; Darrell, Trevor (2016). "Adversarial Feature Learning". arXiv:1605.09782 [cs.LG].

- ^ Dumoulin, Vincent; Belghazi, Ishmael; Poole, Ben; Mastropietro, Olivier; Arjovsky, Alex; Courville, Aaron (2016). "Adversarially Learned Inference". arXiv:1606.00704 [stat.ML].

- ^ Xi Chen; Yan Duan; Rein Houthooft; John Schulman; Ilya Sutskever; Pieter Abeel (2016). "InfoGAN: Interpretable Representation Learning by Information Maximizing Generative Adversarial Nets". arXiv:1606.03657 [cs.LG].

- ^ Zhirui Zhang; Shujie Liu; Mu Li; Ming Zhou; Enhong Chen (October 2018). "Bidirectional Generative Adversarial Networks for Neural Machine Translation" (PDF). pp. 190–199.

- ^ Larsen, Anders Boesen Lindbo; Sønderby, Søren Kaae; Larochelle, Hugo; Winther, Ole (June 11, 2016). "Autoencoding beyond pixels using a learned similarity metric". International Conference on Machine Learning. PMLR: 1558–1566. arXiv:1512.09300.

- ^ Makhzani, Alireza; Shlens, Jonathon; Jaitly, Navdeep; Goodfellow, Ian; Frey, Brendan (2016). "Adversarial Autoencoders". arXiv:1511.05644 [cs.LG].

- ^ Zhu, Jun-Yan; Park, Taesung; Isola, Phillip; Efros, Alexei A. (2017). "Unpaired Image-To-Image Translation Using Cycle-Consistent Adversarial Networks": 2223–2232. arXiv:1703.10593.

{{cite journal}}: Cite journal requiresjournal=(help) - ^ Isola, Phillip; Zhu, Jun-Yan; Zhou, Tinghui; Efros, Alexei A. (2017). "Image-To-Image Translation With Conditional Adversarial Networks": 1125–1134. arXiv:1611.07004.

{{cite journal}}: Cite journal requiresjournal=(help) - ^ Brownlee, Jason (August 22, 2019). "A Gentle Introduction to BigGAN the Big Generative Adversarial Network". Machine Learning Mastery. Retrieved July 15, 2022.

- ^ Shengyu, Zhao; Zhijian, Liu; Ji, Lin; Jun-Yan, Zhu; Song, Han (2020). "Differentiable Augmentation for Data-Efficient GAN Training". Advances in Neural Information Processing Systems. 33. arXiv:2006.10738.

- ^ a b c Tero, Karras; Miika, Aittala; Janne, Hellsten; Samuli, Laine; Jaakko, Lehtinen; Timo, Aila (2020). "Training Generative Adversarial Networks with Limited Data". Advances in Neural Information Processing Systems. 33.

- ^ Shaham, Tamar Rott; Dekel, Tali; Michaeli, Tomer (October 2019). "SinGAN: Learning a Generative Model From a Single Natural Image". 2019 IEEE/CVF International Conference on Computer Vision (ICCV). IEEE: 4569–4579. arXiv:1905.01164. doi:10.1109/iccv.2019.00467. ISBN 978-1-7281-4803-8. S2CID 145052179.

- ^ a b Karras, Tero; Aila, Timo; Laine, Samuli; Lehtinen, Jaakko (October 1, 2017). "Progressive Growing of GANs for Improved Quality, Stability, and Variation". arXiv:1710.10196.

{{cite journal}}: Cite journal requiresjournal=(help) - ^ Karras, Tero; Laine, Samuli; Aila, Timo (June 2019). "A Style-Based Generator Architecture for Generative Adversarial Networks". 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). IEEE: 4396–4405. arXiv:1812.04948. doi:10.1109/cvpr.2019.00453. ISBN 978-1-7281-3293-8. S2CID 54482423.

- ^ Karras, Tero; Laine, Samuli; Aittala, Miika; Hellsten, Janne; Lehtinen, Jaakko; Aila, Timo (June 2020). "Analyzing and Improving the Image Quality of StyleGAN". 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). IEEE: 8107–8116. arXiv:1912.04958. doi:10.1109/cvpr42600.2020.00813. ISBN 978-1-7281-7168-5. S2CID 209202273.

- ^ Timo, Karras, Tero Aittala, Miika Laine, Samuli Härkönen, Erik Hellsten, Janne Lehtinen, Jaakko Aila (June 23, 2021). Alias-Free Generative Adversarial Networks. OCLC 1269560084.

- ^ Karras, Tero; Aittala, Miika; Laine, Samuli; Härkönen, Erik; Hellsten, Janne; Lehtinen, Jaakko; Aila, Timo. "Alias-Free Generative Adversarial Networks (StyleGAN3)". nvlabs.github.io. Retrieved July 16, 2022.

- ^ Caesar, Holger (March 1, 2019), A list of papers on Generative Adversarial (Neural) Networks: nightrome/really-awesome-gan, retrieved March 2, 2019

- ^ Robertson, Adi (February 21, 2022). "The US Copyright Office says an AI can't copyright its art". The Verge. Retrieved February 24, 2022.

- ^ Vincent, James (March 5, 2019). "A never-ending stream of AI art goes up for auction". The Verge. Retrieved June 13, 2020.

- ^ Yu, Jiahui, et al. "Generative image inpainting with contextual attention." Proceedings of the IEEE conference on computer vision and pattern recognition. 2018.

- ^ Wong, Ceecee. "The Rise of AI Supermodels". CDO Trends.

- ^ Taif, K.; Ugail, H.; Mehmood, I. (2020). "Cast Shadow Generation Using Generative Adversarial Networks". Computational Science – Iccs 2020. Lecture Notes in Computer Science. 12141: 481–495. doi:10.1007/978-3-030-50426-7_36. ISBN 978-3-030-50425-0. PMC 7302543.

- ^ Schawinski, Kevin; Zhang, Ce; Zhang, Hantian; Fowler, Lucas; Santhanam, Gokula Krishnan (February 1, 2017). "Generative Adversarial Networks recover features in astrophysical images of galaxies beyond the deconvolution limit". Monthly Notices of the Royal Astronomical Society: Letters. 467 (1): L110–L114. arXiv:1702.00403. Bibcode:2017MNRAS.467L.110S. doi:10.1093/mnrasl/slx008. S2CID 7213940.

- ^ Kincade, Kathy. "Researchers Train a Neural Network to Study Dark Matter". R&D Magazine.

- ^ Kincade, Kathy (May 16, 2019). "CosmoGAN: Training a neural network to study dark matter". Phys.org.

- ^ "Training a neural network to study dark matter". Science Daily. May 16, 2019.

- ^ at 06:13, Katyanna Quach 20 May 2019. "Cosmoboffins use neural networks to build dark matter maps the easy way". www.theregister.co.uk. Retrieved May 20, 2019.

- ^ Mustafa, Mustafa; Bard, Deborah; Bhimji, Wahid; Lukić, Zarija; Al-Rfou, Rami; Kratochvil, Jan M. (May 6, 2019). "CosmoGAN: creating high-fidelity weak lensing convergence maps using Generative Adversarial Networks". Computational Astrophysics and Cosmology. 6 (1): 1. arXiv:1706.02390. Bibcode:2019ComAC...6....1M. doi:10.1186/s40668-019-0029-9. ISSN 2197-7909. S2CID 126034204.

- ^ Paganini, Michela; de Oliveira, Luke; Nachman, Benjamin (2017). "Learning Particle Physics by Example: Location-Aware Generative Adversarial Networks for Physics Synthesis". Computing and Software for Big Science. 1: 4. arXiv:1701.05927. Bibcode:2017arXiv170105927D. doi:10.1007/s41781-017-0004-6. S2CID 88514467.

- ^ Paganini, Michela; de Oliveira, Luke; Nachman, Benjamin (2018). "Accelerating Science with Generative Adversarial Networks: An Application to 3D Particle Showers in Multi-Layer Calorimeters". Physical Review Letters. 120 (4): 042003. arXiv:1705.02355. Bibcode:2018PhRvL.120d2003P. doi:10.1103/PhysRevLett.120.042003. PMID 29437460. S2CID 3330974.

- ^ Paganini, Michela; de Oliveira, Luke; Nachman, Benjamin (2018). "CaloGAN: Simulating 3D High Energy Particle Showers in Multi-Layer Electromagnetic Calorimeters with Generative Adversarial Networks". Phys. Rev. D. 97 (1): 014021. arXiv:1712.10321. Bibcode:2018PhRvD..97a4021P. doi:10.1103/PhysRevD.97.014021. S2CID 41265836.

- ^ Erdmann, Martin; Glombitza, Jonas; Quast, Thorben (2019). "Precise Simulation of Electromagnetic Calorimeter Showers Using a Wasserstein Generative Adversarial Network". Computing and Software for Big Science. 3: 4. arXiv:1807.01954. doi:10.1007/s41781-018-0019-7. S2CID 54216502.

- ^ Musella, Pasquale; Pandolfi, Francesco (2018). "Fast and Accurate Simulation of Particle Detectors Using Generative Adversarial Networks". Computing and Software for Big Science. 2: 8. arXiv:1805.00850. Bibcode:2018arXiv180500850M. doi:10.1007/s41781-018-0015-y. S2CID 119474793.

- ^ "Deep generative models for fast shower simulation in ATLAS". 2018.

- ^ SHiP, Collaboration (2019). "Fast simulation of muons produced at the SHiP experiment using Generative Adversarial Networks". Journal of Instrumentation. 14 (11): P11028. arXiv:1909.04451. Bibcode:2019JInst..14P1028A. doi:10.1088/1748-0221/14/11/P11028. S2CID 202542604.

- ^ Tang, Xiaoou; Qiao, Yu; Loy, Chen Change; Dong, Chao; Liu, Yihao; Gu, Jinjin; Wu, Shixiang; Yu, Ke; Wang, Xintao (September 1, 2018). "ESRGAN: Enhanced Super-Resolution Generative Adversarial Networks". arXiv:1809.00219. Bibcode:2018arXiv180900219W.

- ^ "Fake news: you ain't seen nothing yet". The Economist. July 2017. Retrieved July 1, 2017.

- ^ msmash (February 14, 2019). "'This Person Does Not Exist' Website Uses AI To Create Realistic Yet Horrifying Faces". Slashdot. Retrieved February 16, 2019.

- ^ Doyle, Michael (May 16, 2019). "John Beasley lives on Saddlehorse Drive in Evansville. Or does he?". Courier and Press.

- ^ Targett, Ed (May 16, 2019). "California moves closer to making deepfake pornography illegal". Computer Business Review.

- ^ Mihalcik, Carrie (October 4, 2019). "California laws seek to crack down on deepfakes in politics and porn". cnet.com. CNET. Retrieved October 13, 2019.

- ^ Knight, Will (August 7, 2018). "The Defense Department has produced the first tools for catching deepfakes". MIT Technology Review.

- ^ Li, Bonnie; François-Lavet, Vincent; Doan, Thang; Pineau, Joelle (February 14, 2021). "Domain Adversarial Reinforcement Learning". arXiv:2102.07097 [cs.LG].

- ^ Bisneto, Tomaz Ribeiro Viana; de Carvalho Filho, Antonio Oseas; Magalhães, Deborah Maria Vieira (February 2020). "Generative adversarial network and texture features applied to automatic glaucoma detection". Applied Soft Computing. 90: 106165. doi:10.1016/j.asoc.2020.106165. S2CID 214571484.

- ^ Wei, Jerry (July 3, 2019). "Generating Shoe Designs with Machine Learning". Medium. Retrieved November 6, 2019.

- ^ Greenemeier, Larry (June 20, 2016). "When Will Computers Have Common Sense? Ask Facebook". Scientific American. Retrieved July 31, 2016.

- ^ Reconstruction of the Roman Emperors: Interview with Daniel Voshart, retrieved June 3, 2022

- ^ "3D Generative Adversarial Network". 3dgan.csail.mit.edu.

- ^ Achlioptas, Panos; Diamanti, Olga; Mitliagkas, Ioannis; Guibas, Leonidas (2018). "Learning Representations and Generative Models for 3D Point Clouds". arXiv:1707.02392 [cs.CV].

- ^ Vondrick, Carl; Pirsiavash, Hamed; Torralba, Antonio (2016). "Generating Videos with Scene Dynamics". carlvondrick.com. arXiv:1609.02612. Bibcode:2016arXiv160902612V.

- ^ Antipov, Grigory; Baccouche, Moez; Dugelay, Jean-Luc (2017). "Face Aging With Conditional Generative Adversarial Networks". arXiv:1702.01983 [cs.CV].

- ^ Feltus, Christophe (December 2021). "LogicGAN–based Data Augmentation Approach to Improve Adversarial Attack DNN Classifiers". Proceedings of the 2021 International Conference on Computational Science and Computational Intelligence (CSCI): 180–185. doi:10.1109/CSCI54926.2021.00011. ISBN 978-1-6654-5841-2. S2CID 249929238.

- ^ Wu, Abraham Noah; Biljecki, Filip (2022). "GANmapper: geographical data translation". International Journal of Geographical Information Science. 36 (7): 1394–1422. arXiv:2108.04232. doi:10.1080/13658816.2022.2041643. S2CID 247012122.

- ^ Kang, Yuhao; Gao, Song; Roth, Rob (2019). "Transferring Multiscale Map Styles Using Generative Adversarial Networks". International Journal of Cartography. 5 (2–3): 115–141. arXiv:1905.02200. Bibcode:2019arXiv190502200K. doi:10.1080/23729333.2019.1615729. S2CID 146808465.

- ^ Wijnands, Jasper; Nice, Kerry; Thompson, Jason; Zhao, Haifeng; Stevenson, Mark (2019). "Streetscape augmentation using generative adversarial networks: Insights related to health and wellbeing". Sustainable Cities and Society. 49: 101602. arXiv:1905.06464. Bibcode:2019arXiv190506464W. doi:10.1016/j.scs.2019.101602. S2CID 155100183.

- ^ Ukkonen, Antti; Joona, Pyry; Ruotsalo, Tuukka (2020). "Generating Images Instead of Retrieving Them: Relevance Feedback on Generative Adversarial Networks". Proceedings of the 43rd International ACM SIGIR Conference on Research and Development in Information Retrieval: 1329–1338. doi:10.1145/3397271.3401129. hdl:10138/328471. ISBN 9781450380164. S2CID 220730163.

- ^ Padhi, Radhakant; Unnikrishnan, Nishant (2006). "A single network adaptive critic (SNAC) architecture for optimal control synthesis for a class of nonlinear systems". Neural Networks. 19 (10): 1648–1660. doi:10.1016/j.neunet.2006.08.010. PMID 17045458.

- ^ "AI can show us the ravages of climate change". MIT Technology Review. May 16, 2019.

- ^ Christian, Jon (May 28, 2019). "ASTOUNDING AI GUESSES WHAT YOU LOOK LIKE BASED ON YOUR VOICE". Futurism.

- ^ Zhavoronkov, Alex (2019). "Deep learning enables rapid identification of potent DDR1 kinase inhibitors". Nature Biotechnology. 37 (9): 1038–1040. doi:10.1038/s41587-019-0224-x. PMID 31477924. S2CID 201716327.

- ^ Barber, Gregory. "A Molecule Designed By AI Exhibits 'Druglike' Qualities". Wired.

- ^ Mohammad Navid Fekri; Ananda Mohon Ghosh; Katarina Grolinger (2020). "Generating Energy Data for Machine Learning with Recurrent Generative Adversarial Networks". Energies. 13 (1): 130. doi:10.3390/en13010130.

- ^ Gutmann, Michael; Hyvärinen, Aapo. "Noise-Contrastive Estimation" (PDF). International Conference on AI and Statistics.

- ^ Niemitalo, Olli (February 24, 2010). "A method for training artificial neural networks to generate missing data within a variable context". Internet Archive (Wayback Machine). Archived from the original on March 12, 2012. Retrieved February 22, 2019.

- ^ "GANs were invented in 2010?". reddit r/MachineLearning. 2019. Retrieved May 28, 2019.

- ^ Li, Wei; Gauci, Melvin; Gross, Roderich (July 6, 2013). "Proceeding of the fifteenth annual conference on Genetic and evolutionary computation conference - GECCO '13". Proceedings of the 15th Annual Conference on Genetic and Evolutionary Computation (GECCO 2013). Amsterdam, The Netherlands: ACM. pp. 223–230. doi:10.1145/2463372.2465801. ISBN 9781450319638.

- ^ Abu-Khalaf, Murad; Lewis, Frank L.; Huang, Jie (July 1, 2008). "Neurodynamic Programming and Zero-Sum Games for Constrained Control Systems". IEEE Transactions on Neural Networks. 19 (7): 1243–1252. doi:10.1109/TNN.2008.2000204. S2CID 15680448.

- ^ Abu-Khalaf, Murad; Lewis, Frank L.; Huang, Jie (December 1, 2006). "Policy Iterations on the Hamilton–Jacobi–Isaacs Equation for H∞ State Feedback Control With Input Saturation". IEEE Transactions on Automatic Control. doi:10.1109/TAC.2006.884959. S2CID 1338976.

- ^ Sajjadi, Mehdi S. M.; Schölkopf, Bernhard; Hirsch, Michael (December 23, 2016). "EnhanceNet: Single Image Super-Resolution Through Automated Texture Synthesis". arXiv:1612.07919 [cs.CV].

- ^ "This Person Does Not Exist: Neither Will Anything Eventually with AI". March 20, 2019.

- ^ "ARTificial Intelligence enters the History of Art". December 28, 2018.

- ^ Tom Février (February 17, 2019). "Le scandale de l'intelligence ARTificielle".

- ^ "StyleGAN: Official TensorFlow Implementation". March 2, 2019 – via GitHub.

- ^ Paez, Danny (February 13, 2019). "This Person Does Not Exist Is the Best One-Off Website of 2019". Retrieved February 16, 2019.

- ^ Beschizza, Rob (February 15, 2019). "This Person Does Not Exist". Boing-Boing. Retrieved February 16, 2019.

- ^ Horev, Rani (December 26, 2018). "Style-based GANs – Generating and Tuning Realistic Artificial Faces". Lyrn.AI. Archived from the original on November 5, 2020. Retrieved February 16, 2019.

- ^ Elgammal, Ahmed; Liu, Bingchen; Elhoseiny, Mohamed; Mazzone, Marian (2017). "CAN: Creative Adversarial Networks, Generating "Art" by Learning About Styles and Deviating from Style Norms". arXiv:1706.07068 [cs.AI].

- ^ Cohn, Gabe (October 25, 2018). "AI Art at Christie's Sells for $432,500". The New York Times.

- ^ Mazzone, Marian; Ahmed Elgammal (February 21, 2019). "Art, Creativity, and the Potential of Artificial Intelligence". Arts. 8: 26. doi:10.3390/arts8010026.

- ^ Kulp, Patrick (May 23, 2019). "Samsung's AI Lab Can Create Fake Video Footage From a Single Headshot". AdWeek.

- ^ Yu, Yi; Canales, Simon (2021). "Conditional LSTM-GAN for Melody Generation from Lyrics". ACM Transactions on Multimedia Computing, Communications, and Applications. 17: 1–20. arXiv:1908.05551. doi:10.1145/3424116. ISSN 1551-6857. S2CID 199668828.

- ^ "Nvidia's AI recreates Pac-Man from scratch just by watching it being played". The Verge. May 22, 2020.

- ^ Seung Wook Kim; Zhou, Yuhao; Philion, Jonah; Torralba, Antonio; Fidler, Sanja (2020). "Learning to Simulate Dynamic Environments with GameGAN". arXiv:2005.12126 [cs.CV].

External links

- Knight, Will. "5 Big Predictions for Artificial Intelligence in 2017". MIT Technology Review. Retrieved January 5, 2017.

- Karras, Tero; Laine, Samuli; Aila, Timo (2018). "A Style-Based Generator Architecture for Generative Adversarial Networks". arXiv:1812.04948 [cs.NE].

- This Person Does Not Exist – photorealistic images of people who do not exist, generated by StyleGAN

- This Cat Does Not Exist – photorealistic images of cats who do not exist, generated by StyleGAN

- Wang, Zhengwei; She, Qi; Ward, Tomas E. (2019). "Generative Adversarial Networks in Computer Vision: A Survey and Taxonomy". arXiv:1906.01529 [cs.LG].

GAN 게임을 정의합니다.

GAN 게임을 정의합니다.

세트입니다.

세트입니다.![{\displaystyle \mu _{D}:\Omega \to {\mathcal {P}}[0,1]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/dce97271df1c30e57ae96f72c566661f1bae9dad)

![{\displaystyle {\mathcal {P}}[0,1]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/23bc6194efec9e3aaf67b5270e6b8cbc3834d99e)

![{\displaystyle L(\mu _{G},\mu _{D}):=\mathbb {E} _{x\sim \mu _{ref},y\sim \mu _{D}(x)}[\ln y]+\mathbb {E} _{x\sim \mu _{G},y\sim \mu _{D}(x)}[\ln(1-y)]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/b55fdfa10ce4725eae7b3b0816b3860e29120b4a)

GAN 게임을 정의합니다.

GAN 게임을 정의합니다.

![[0,1]](https://wikimedia.org/api/rest_v1/media/math/render/svg/738f7d23bb2d9642bab520020873cccbef49768d)

![{\displaystyle D:\Omega \to [0,1]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/298d9bf50461bcde11bd77e61e9048b0eaabbc12)

심층

심층

![{\displaystyle L(G,D):=\mathbb {E} _{x\sim \mu _{ref}}[\ln D(x)]+\mathbb {E} _{z\sim \mu _{Z}}[\ln(1-D(G(z))]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/ff7e940fc60587316892de1b766d105f3a48ca36)

![{\displaystyle \min _{\mu _{G}}\max _{\mu _{D}}L(\mu _{G},\mu _{D}):=\mathbb {E} _{x\sim \mu _{ref},y\sim \mu _{D}(x)}[\ln y]+\mathbb {E} _{x\sim \mu _{G},y\sim \mu _{D}(x)}[\ln(1-y)]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/efb076f3abb3e487705fb7f05257f59ac913cba2)

![{\displaystyle \mathbb {E} _{x\sim \mu _{ref},y\sim \mu _{D}(x)}[\ln y]\leq \mathbb {E} _{x\sim \mu _{ref}}[\ln \mathbb {E} _{y\sim \mu _{D}(x)}[y]]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/31e886807b731e9a4b642171490fbb6270173038)

![{\displaystyle L(\mu _{G},\mu _{D}):=\mathbb {E} _{x\sim \mu _{ref}}[\ln D(x)]+\mathbb {E} _{x\sim \mu _{G}}[\ln(1-D(x))]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/3116f7998f594b276844af079cce809951e741c6)

![{\displaystyle L(\mu _{G},\mu _{D}):=\int \mu (dx)\left[\rho _{ref}(x)\ln(D(x))+\rho _{G}(x)\ln(1-D(x))\right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/b0fa6d3842815018b7990829b91965796cbc3d9f)

나올 확률이 1

나올 확률이 1

![{\displaystyle \{x|\mathbb {E} _{y\sim \mu _{D}(x)}[\ln(1-y)]=\inf _{x}\mathbb {E} _{y\sim \mu _{D}(x)}[\ln(1-y)]\}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/d9d620c0a45064347c4f08943a9a0bf648a363f8)

![{\displaystyle \arg \max _{\mu _{D}}\min _{\mu _{G}}L(\mu _{G},\mu _{D})=\arg \max _{\mu _{D}}\mathbb {E} _{x\sim \mu _{ref},y\sim \mu _{D}(x)}[\ln y]+\inf _{x}\mathbb {E} _{y\sim \mu _{D}(x)}[\ln(1-y)]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/6f922261b3fe44a040b33cd26b108dd280bc4c1b)

![{\displaystyle D(x)=\mathbb {E} _{y\sim \mu _{D}(x)}[y]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/62b34fdf229109bdb32719d1987b3c18e9f88623)

![{\displaystyle \arg \max _{\mu _{D}}\min _{\mu _{G}}L(\mu _{G},\mu _{D})=\arg \max _{D}\mathbb {E} _{x\sim \mu _{ref}}[\ln D(x)]+\inf _{x}\ln(1-D(x))}](https://wikimedia.org/api/rest_v1/media/math/render/svg/9f7e4eb5a68ce879d600329e8596a119fe723de1)

![{\displaystyle \ln \mathbb {E} _{x\sim \mu _{ref}}[D(x)]+\inf _{x}\ln(1-D(x))=\ln \mathbb {E} _{x\sim \mu _{ref}}[D(x)]+\ln(1-\sup _{x}D(x))}](https://wikimedia.org/api/rest_v1/media/math/render/svg/d9d37462f73cffbdfcf5679fa04d3c90cf2b4897)

)]\leq \ln[\sup _{x}D(x))(1-\sup _{x}D(x))]\leq \ln {\frac {1}{4}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/aa020f2e4783750462ed3350c9ef7d18934ed247)

![{\displaystyle L(\mu _{G},\mu _{D}):=\mathbb {E} _{x\sim \mu _{ref},y\sim \mu _{D}(x)}[\ln(y(1-y))]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/8b2ac15894f8e8cf1d86f5c692c25f62bdcb1f98)

최대화됩니다.

최대화됩니다.

이미지, x(\

이미지, x(\

![{\displaystyle L(\mu _{G},D):=\mathbb {E} _{c\sim \mu _{C},x\sim \mu _{ref}(c)}[\ln D(x,c)]+\mathbb {E} _{c\sim \mu _{C},x\sim \mu _{G}(c)}[\ln(1-D(x,c))]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/018470e5b806a4bf28807f54fce87edded361685)

![{\displaystyle {\begin{cases}\min _{D}L_{D}(D,\mu _{G})=-\mathbb {E} _{x\sim \mu _{ref}}[\ln D(x)]-\mathbb {E} _{x\sim \mu _{G}}[\ln(1-D(x))]\\\min _{G}L_{G}(D,\mu _{G})=-\mathbb {E} _{x\sim \mu _{G}}[\ln(1-D(x))]\end{cases}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/83438b32636de3b08fc5c5e7b8950150791ce3a8)

![{\displaystyle L_{G}=\mathbb {E} _{x\sim \mu _{G}}[\ln D(x)]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/0fa507c647c2e473c5ae1e9ff8324d3e5678a3a5)

![{\displaystyle L_{G}=\mathbb {E} _{x\sim \mu _{G}}[(\exp \circ \sigma ^{-1}\circ D)(x)]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/5802ca7fcd3acb4138f4af911f531a866faf7940)

![{\displaystyle L_{D}=-\mathbb {E} _{x\sim {p}_{ref}}\left[\min \left(0,-1+D\left(x\right)\right)\right]-\mathbb {E} _{x\sim \mu _{G}}\left[\min \left(0,-1-D\left(x\right)\right)\right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c0644f1bfb3c7ff9b835fce995c5723ad217bb61)

![{\displaystyle L_{G}=-\mathbb {E} _{x\sim \mu _{G}}[D\left(x\right)]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/cdd4d471bcff109ba9a253528b4af9973808163b)

![{\displaystyle L_{D}=\mathbb {E} _{x\sim \mu _{ref}}[(D(x)-b)^{2}]+\mathbb {E} _{x\sim \mu _{G}}[(D(x)-a)^{2}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/1ce29c337072014c7420aa16f98132dea66dd19d)

![{\displaystyle L_{G}=\mathbb {E} _{x\sim \mu _{G}}[(D(x)-c)^{2}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/b17a43360234d70453ba840b08962a96eece249a)

립시츠

립시츠

고정 양의 상수입니다.

고정 양의 상수입니다.![{\displaystyle L_{WGAN}(\mu _{G},D):=\mathbb {E} _{x\sim \mu _{G}}[D(x)]-\mathbb {E} _{x\sim \mu _{ref}}[D(x)]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/cb364d3ae8420f48a1e43bf7ac4480e8a38b2475)

![{\displaystyle {\hat {I}}(G,Q)=\mathbb {E} _{z\sim \mu _{Z},c\sim \mu _{C}}[\ln Q(c|G(z,c))];\quad I(c,G(z,c))\geq \sup _{Q}{\hat {I}}(G,Q)}](https://wikimedia.org/api/rest_v1/media/math/render/svg/2f9d0a6292d5fe0efd763c7789986eda14d3386d)

범위는

범위는

![{\displaystyle D:\Omega _{X}\to [0,1]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/22a37008c49fac57a80a9a59f49c34c0273168f6)

![{\displaystyle L(G,E,D)=\mathbb {E} _{x\sim \mu _{X}}[\ln D(x,E(x))]+\mathbb {E} _{z\sim \mu _{Z}}[\ln(1-D(G(z),z))]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/354bd3dd8cbb2f8292e671dd6b42263d323ef532)

![{\displaystyle L(G,E,D)=\mathbb {E} _{(x,z)\sim \mu _{E,X}}[\ln D(x,z)]+\mathbb {E} _{(x,z)\sim \mu _{G,Z}}[\ln(1-D(x,z))]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/5b66ef02b76d9476dc6ec665cb2d84c71fbb4879)

![{\displaystyle D_{X}:\Omega _{X}\to [0,1],D_{Y}:\Omega _{Y}\to [0,1]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/8c4c214517f2a68640295a7c1a6d00850fc084e6)

![{\displaystyle {\begin{cases}\min _{D}L_{D}(D,\mu _{G})=-\mathbb {E} _{x\sim \mu _{ref},T\sim \mu _{trans}}[\ln D(T(x))]-\mathbb {E} _{x\sim \mu _{G}}[\ln(1-D(x))]\\\min _{G}L_{G}(D,\mu _{G})=-\mathbb {E} _{x\sim \mu _{G}}[\ln(1-D(x))]\end{cases}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/d411e3e2a786e29a5778967d031cbdf09adfd9d3)

![{\displaystyle {\begin{cases}\min _{D}L_{D}(D,\mu _{G})=-\mathbb {E} _{x\sim \mu _{ref},T\sim \mu _{trans}}[\ln D(T(x))]-\mathbb {E} _{x\sim \mu _{G},T\sim \mu _{trans}}[\ln(1-D(T(x)))]\\\min _{G}L_{G}(D,\mu _{G})=-\mathbb {E} _{x\sim \mu _{G},T\sim \mu _{trans}}[\ln(1-D(T(x)))]\end{cases}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/708e5984916386bcb839e42a686d22069ee35cd2)

![{\displaystyle [K_{trans}]={\begin{bmatrix}(1-3p)&p&p&p\\p&(1-3p)&p&p\\p&p&(1-3p)&p\\p&p&p&(1-3p)\end{bmatrix}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/ca9754f61e7f936d873ecfa5a7a7237aa2b02c6a)

![{\displaystyle [K_{trans}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e51428b20010e3dbcf0a439c2d948cf775fd1d47)