뉴럴 스타일 전달

Neural style transfer

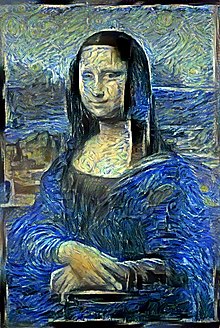

NST(Neural Style Transfer)는 다른 이미지의 외관 또는 시각적 스타일을 채택하기 위해 디지털 이미지 또는 비디오를 조작하는 소프트웨어 알고리즘의 클래스를 말합니다.NST 알고리즘은 이미지 변환을 위해 심층 신경망을 사용하는 것이 특징이다.NST의 일반적인 용도는 예를 들어 명화의 외관을 사용자가 제공한 사진에 옮겨 넣는 등 사진으로부터 인공 미술품을 만드는 것이다.DeepArt와 Prisma를 포함한 몇몇 주목할 만한 모바일 앱은 이를 위해 NST 기술을 사용합니다.이 방법은 전 세계 아티스트와 디자이너가 기존 스타일을 기반으로 새로운 작품을 개발하기 위해 사용해 왔습니다.

이전 스타일의 전송 알고리즘

NST는 이미지 스타일라이제이션의 한 예입니다.비사실적 렌더링 분야에서 20년 이상 연구된 문제입니다.첫 번째 두 가지 예제 기반 스타일 전송 알고리즘은 이미지 유사성과[1] 이미지 [2]퀼팅이었습니다.두 방법 모두 패치 기반 텍스처 합성 알고리즘에 기반했습니다.

트레이닝용 이미지 쌍(사진과 그 사진을 나타내는 아트워크)이 주어지면, 변형을 학습해, 유추에 의해서 새로운 포토로부터 새로운 아트워크를 작성하기 위해서 적용할 수 있습니다.트레이닝용 사진이 없는 경우는, 입력 아트워크를 처리해 제작할 필요가 있습니다.이미지 퀼팅은, 1개의 스타일에서만 실증되고 있습니다만, 이 처리 순서는 필요 없습니다.

NST

NST는 Leon Gatys 등에 의해 "A Neural Algorithm of Artistic Style"이라는 논문에 처음 발표되었고, 원래 ArXiv [3]2015에 발표되었으며,[4] 이후 2016년 동료 검토 CVPR 컨퍼런스에서 승인되었다.원본 문서에서는 ImageNet 데이터 세트를 사용하여 객체 인식을 수행하도록 사전 교육을 받은 VGG-19 아키텍처를[5] 사용했습니다.

구글 AI는 2017년 하나의 심층 컨볼루션 스타일 전송 네트워크가 여러 스타일을 동시에 학습할 수 있는 방식을[6] 도입했다.이 알고리즘에 의해, 비디오 미디어로 행해진 경우에서도, 실시간으로 스타일 보간을 실시할 수 있습니다.

공식화

NST 프로세스에서는 이미지p\ p와 샘플 스타일 p a를 가정합니다.

pp는 CNN을 통해 전송되며 네트워크 액티베이션은 VGG-19 아키텍처의 최신 컨볼루션 층에서 샘플링됩니다.C { C를 샘플로 하여 입력p { p의 '콘텐츠'라고 .

다음 같은 CNN을 통해 스타일를 전송하고 네트워크의 활성화는 CNN의 초기 계층에서 중간 계층으로 샘플링됩니다.이러한 액티베이션은 Gramian 매트릭스 표현으로 인코딩되며 이를 )라고 합니다.\의 스타일'을 나타냅니다

NST의 목표는 c ( \C(x) (p) \display C) = C(p } 및 = S(x) (x) = S(디스플레이 S) 등의 을 적용한 p p의 을 나타내는 출력 x x를 합성하는 것입니다.

그런 다음 반복 최적화(일반적으로 경사 하강)를 xdisplaystyle x가 점진적으로 업데이트되어 손실 함수 오류를 최소화합니다.

(x ) () -C () + S () - (\ \ ( x ) } ( ) - ( ) + ) ,

여기서L2 거리입니다.k(\ k는 스타일라이제이션 효과의 수준을 제어합니다.

트레이닝

x({x})는 처음에 이미지p({p})에 약간의 백색 노이즈를 추가하여 CNN을 통해 공급함으로써 근사됩니다.그런 다음 CNN의 픽셀을 업데이트하기 위해 고정된 x\ x의 무게를 사용하여 이 손실을 네트워크를 통해 연속적으로 전파합니다. 수 천년의 훈련을 거친 후 xa의 과 pp의 과 일치하는 x\ x가 .를 클릭합니다.

알고리즘은 통상 GPU용으로 실장되어 있기 때문에 트레이닝에는 몇 [citation needed]분 걸립니다.

내선번호

NST는 [7]비디오로도 확장되었습니다.

후속 작업을 통해 [clarification needed]영상의 NST 속도가 향상되었습니다.

Fei-Fei Li 등의 논문에서 실시간(Gatys보다 [8]3배 빠른) 결과를 도출하기 위해 다른 정규화된 손실 메트릭과 가속화된 교육 방법을 채택했다.그들의 아이디어는 위에서 정의한 픽셀 기반 손실이 아니라 CNN 내의 상위 계층 간의 차이를 측정하는 '감각적 손실'을 사용하는 것이었다.그들은 대칭 인코더-디코더 CNN을 사용했다.트레이닝에서는 기본적인 NST 방식과 유사한 손실 함수를 사용하지만 Total Variation(TV; 총변동) 손실을 사용하여 출력을 매끄럽게 정규화합니다.트레이닝이 완료되면 네트워크를 사용하여 단일 피드포워드 패스를 사용하여 이미지를 트레이닝 중에 사용되는 스타일로 변환할 수 있습니다.단,[9] 네트워크는 훈련받은 단일 스타일로 제한됩니다.

Chen Dong Dong 등의 작품에서.그들은 [10]출력의 시간적 일관성을 개선하기 위해 피드포워드 네트워크에 대한 광학적 흐름 정보의 융합을 조사했다.

가장 최근에는 단일 특정 스타일에 결합되지 않고 사용자가 제어할 수 있는 스타일의 혼합(예: WCT)[11]을 가능하게 하는 빠른 스타일라이제이션에 대해 특징 변환 기반의 NST 방법이 검토되고 있습니다.

레퍼런스

- ^ "Image Analogies" (PDF). Mrl.nyu.edu. 2001. Retrieved 13 February 2019.

- ^ "Image Quilting". graphics.cs.cmu.edu. 2001. Retrieved 4 February 2021.

- ^ Gatys, Leon A.; Ecker, Alexander S.; Bethge, Matthias (26 August 2015). "A Neural Algorithm of Artistic Style". arXiv:1508.06576 [cs.CV].

- ^ Bethge, Matthias; Ecker, Alexander S.; Gatys, Leon A. (2016). "Image Style Transfer Using Convolutional Neural Networks". Cv-foundation.org. pp. 2414–2423. Retrieved 13 February 2019.

- ^ "Very Deep CNNS for Large-Scale Visual Recognition". Robots.ox.ac.uk. 2014. Retrieved 13 February 2019.

- ^ Dumoulin, Vincent; Shlens, Jonathon S.; Kudlur, Manjunath (9 February 2017). "A Learned Representation for Artistic Style". arXiv:1610.07629 [cs.CV].

- ^ Ruder, Manuel; Dosovitskiy, Alexey; Brox, Thomas (2016). "Artistic Style Transfer for Videos". Pattern Recognition. Lecture Notes in Computer Science. Vol. 9796. pp. 26–36. arXiv:1604.08610. doi:10.1007/978-3-319-45886-1_3. ISBN 978-3-319-45885-4. S2CID 47476652.

- ^ Johnson, Justin; Alahi, Alexandre; Li, Fei-Fei (2016). "Perceptual Losses for Real-Time Style Transfer and Super-Resolution". arXiv:1603.08155 [cs.CV].

- ^ Johnson, Justin; Alahi, Alexandre; Li, Fei-Fei (2016). "Perceptual Losses for Real-Time Style Transfer and Super-Resolution". arXiv:1603.08155 [cs.CV].

- ^ Chen, Dongdong; Liao, Jing; Yuan, Lu; Yu, Nenghai; Hua, Gang (2017). "Coherent Online Video Style Transfer". arXiv:1703.09211 [cs.CV].

- ^ Li, Yijun; Fang, Chen; Yang, Jimei; Wang, Zhaowen; Lu, Xin; Yang, Ming-Hsuan (2017). "Universal Style Transfer via Feature Transforms". arXiv:1705.08086 [cs.CV].

샘플 스타일

샘플 스타일

합니다.\

합니다.\

합성하는 것입니다.

합성하는 것입니다.

스타일라이제이션 효과의 수준을 제어합니다.

스타일라이제이션 효과의 수준을 제어합니다.