순위 매기기 학습

Learning to rank| 시리즈의 일부 |

| 기계 학습 및 데이터 마이닝 |

|---|

|

순위 매기기 또는[1] 기계 학습 순위 매기기(MLR)는 정보 검색 [2]시스템의 순위 매기기 모델 구축에 기계 학습(일반적으로 감독, 반감독 또는 강화 학습)을 적용하는 것이다.교육 데이터는 각 목록의 항목 사이에 일부 순서가 지정된 항목 목록으로 구성됩니다.이 순서는 일반적으로 각 항목에 대해 숫자 또는 서수 점수 또는 이진법 판단(예: "관련성" 또는 "관련성 없음")을 부여함으로써 유도된다.순위 모델을 구성하는 목표는 교육 데이터의 순위와 유사한 방식으로 보이지 않는 새로운 목록의 순위를 정하는 것입니다.

적용들

정보 검색 시

순위는 문서 검색, 협업 필터링, 감정 분석 및 온라인 광고와 같은 많은 정보 검색 문제의 중심 부분입니다.

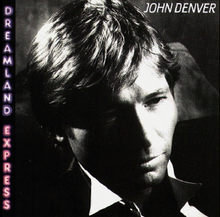

기계학습된 검색엔진의 가능한 아키텍처가 첨부그림에 나타나 있다.

교육 데이터는 각 일치 항목의 관련성 수준과 함께 일치하는 쿼리와 문서로 구성됩니다.인간 평가자(또는 Google이라고 부르는 평가자)에 의해 수동으로 작성될 수 있으며, 평가자는 몇 가지 질문에 대한 결과를 확인하고 각 결과의 관련성을 판단합니다.모든 문서의 관련성을 확인하는 것은 불가능하기 때문에 일반적으로 풀링이라고 하는 기법을 사용합니다.기존 순위 모델에 의해 검색된 상위 몇 개의 문서만 체크됩니다.이 기술은 선택 편견을 일으킬 수 있습니다.또는 클릭스루 로그(즉,[3] 사용자의 클릭을 받은 검색 결과),[4] 쿼리 체인 또는 구글의 (대체된) SearchWiki와 같은 검색 엔진의 기능을 분석하여 교육 데이터를 자동으로 얻을 수 있습니다.클릭스루 로그는 사용자가 상위 검색 결과를 클릭하는 경향에 따라 이미 순위가 높은 것으로 가정하여 편향될 수 있습니다.

트레이닝 데이터는 실제 쿼리에 대한 문서의 관련성을 계산하는 랭킹 모델을 작성하기 위해 학습 알고리즘에 의해 사용된다.

일반적으로 사용자는 검색 쿼리가 단시간(웹 검색의 경우 수백 밀리초 등) 내에 완료될 것으로 예상하므로 코퍼스의 각 문서에서 복잡한 순위 모델을 평가할 수 없으므로 2단계 스킴이 사용됩니다.[5]우선 벡터 공간 모델, 부울 모델, 가중치 [6]AND 또는 BM25와 같은 빠른 쿼리 평가를 가능하게 하는 간단한 검색 모델을 사용하여 잠재적으로 관련된 소수의 문서를 식별한다.이 단계를 \k 문서 검색이라고 하며, 문서의 정적 품질 점수 및 계층형 [7]색인을 사용하는 등 이를 가속화하기 위해 문헌에서 많은 휴리스틱스가 제안되었다.두 번째 단계에서는 더 정확하지만 계산 비용이 많이 드는 기계 학습 모델을 사용하여 이러한 문서의 순위를 다시 매깁니다.

기타 지역

알고리즘의 순위 매기기 학습은 정보 검색 이외의 영역에서도 적용되고 있습니다.

- 일련의 [8]가상번역 순위를 매기기 위한 기계번역

- 단백질 구조 예측 [8]문제에서 후보 3-D 구조의 순위를 매기기 위한 계산 생물학.

- 사용자가 최신 뉴스 [9]기사를 읽은 후 사용자에게 추천하는 관련 뉴스 기사의 순위 리스트를 식별하는 추천 시스템.

- 소프트웨어 엔지니어링에서는 Learning-to-Rank 방식이 장애 [10]현지화에 사용되고 있습니다.

특징 벡터

MLR 알고리즘의 편의를 위해 쿼리-문서 쌍은 보통 특징 벡터라고 불리는 숫자 벡터로 표시됩니다.이러한 접근방식은 때때로 특징 가방이라고 불리며 문서 표현을 위한 정보 검색에서 사용되는 단어 가방 모델 및 벡터 공간 모델과 유사합니다.

이러한 벡터의 성분을 특징, 요인 또는 순위 신호라고 합니다.세 가지 그룹으로 나눌 수 있습니다(문서 검색 기능을 예로 나타냅니다).

- 쿼리에 의존하지 않고 문서에 의존할 수 있는 기능 또는 정적 기능들은 쿼리에 의존하지 않습니다.예를 들어 PageRank 또는 문서 길이입니다.이러한 기능은 인덱싱 중에 오프라인 모드에서 미리 계산할 수 있습니다.검색 질의 [7][11]평가 속도를 높이기 위해 자주 사용되는 문서의 정적 품질 점수(또는 정적 순위)를 계산하는 데 사용할 수 있습니다.

- 쿼리에 의존하는 기능 또는 동적 기능: 문서 내용과 쿼리에 따라 달라지는 기능(TF-IDF 점수 또는 기타 기계에서 학습되지 않은 순위 함수 등)입니다.

- 쿼리 수준 기능 또는 쿼리 기능(쿼리에만 의존)예를 들어 조회에 포함된 단어 수입니다.

잘 알려진 LETOR 데이터 세트에 사용된 기능의 예를 다음에 나타냅니다.

- 특정 쿼리에 대한 문서 영역(제목, 본문, 앵커 텍스트, URL)의 TF, TF-IDF, BM25 및 언어 모델링 점수

- 문서 영역의 길이 및 IDF 합계

- Document의 PageRank, HITS 등급 및 그 변형.

좋은 기능을 선택하고 설계하는 것은 기능 공학이라고 불리는 기계 학습에서 중요한 영역입니다.

평가척도

알고리즘이 트레이닝 데이터를 얼마나 잘 처리하고 있는지 판단하고 다양한 MLR 알고리즘의 성능을 비교하기 위해 일반적으로 사용되는 몇 가지 측정(측정법)이 있습니다.종종 순위 지정 문제는 이러한 메트릭 중 하나와 관련하여 최적화 문제로 재구성됩니다.

품질 측정 순위를 매기는 예:

- 평균 평균 정밀도(MAP);

- DCG 및 NDCG

- Precision@n, NDCG@n. 여기서 "@n"은 메트릭이 상위 n개의 문서에 대해서만 평가됨을 나타냅니다.

- 평균 상호 순위

- 켄달의 타우

- 스피어맨의 노

DCG와 그 정규화된 변형 NDCG는 여러 수준의 관련성을 [12]사용할 때 학술 연구에서 일반적으로 선호된다.MAP, MRR, 정밀도 등의 기타 메트릭은 바이너리 판단에 대해서만 정의됩니다.

최근 DCG 메트릭보다 검색 결과에 대한 사용자의 만족도를 더 잘 모델링할 수 있는 몇 가지 새로운 평가 메트릭이 제안되었습니다.

이 두 메트릭 모두 사용자가 관련성이 낮은 문서를 검토한 후 검색 결과를 더 이상 볼 수 없다는 가정에 기초하고 있습니다.

접근

이 섹션은 확장해야 합니다.추가함으로써 도움이 될 수 있습니다. (2009년 12월) |

Microsoft Research Asia의 Tie-Yan Liu는 그의 저서 Learning to Ranking for Information [1]Retrieval에서 문제의 순위를 매기는 것을 배우기 위한 기존 알고리즘을 분석했습니다.그는 입력 공간, 출력 공간, 가설 공간(모형의 핵심 함수) 및 손실 함수에 따라 점별, 쌍별 및 목록별 접근법의 세 그룹으로 분류했습니다.실제로 목록별 접근법은 종종 쌍별 접근법과 점별 접근법보다 성능이 우수합니다.이 진술은 다수의 벤치마크 데이터 [15]집합에서 서로 다른 순위 매기기 방법의 성능에 대한 대규모 실험에 의해 더욱 뒷받침되었다.

이 섹션에서 x x는 문서나 이미지 등의 평가 대상 객체를 x {)}는 단일값 가설을 , h)) {(\cdot는 2변수 또는 다변수 함수 및 L l( ) )\ l( )\) style l(CD)\cdisplay style cdiscdisplay style l(\) 등의 가설을 나타냅니다.ot은 손실함수를 나타냅니다.

포인트 어프로치

이 경우, 훈련 데이터의 각 질의-문서 쌍에는 숫자 또는 순서 점수가 있다고 가정합니다.그런 다음, 학습-순위 문제는 회귀 문제로 근사할 수 있습니다. 즉, 단일 질의-문서 쌍이 주어진 경우 해당 점수를 예측합니다.공식적으로 말하면, 포인트 접근법은 손실 L (f , , ) \ L ( , x _ j , y { j )을 사용하여 의 실제 값 또는 서수 점수를 예측하는 f () { f ( , x _ j )를하는 것을 목표로 한다.

이러한 목적을 위해 기존의 많은 감독 기계 학습 알고리즘을 쉽게 사용할 수 있습니다.순서형 회귀 및 분류 알고리즘은 단일 쿼리-문서 쌍의 점수를 예측하기 위해 사용되는 경우 점별 접근법에서도 사용할 수 있으며, 이 알고리즘에는 소수의 유한한 값이 필요합니다.

쌍방향 접근법

이 경우, Learning-to-Rank 문제는 분류 문제, 즉 주어진 문서 쌍에서 어떤 문서가 더 나은지 알 수 있는 이진 h ( u , v) { h ( _ {u,_ { } )를 학습하는 것에 의해 대략적으로 나타납니다.분류기는 2개의 이미지를 입력으로 사용하여 손실 L ( u , v , u , L (h ; x _ {u, x {v, u , v ){ L ( h ; x _ {u , y _ v } )를 최소화하는 것이 목표입니다.손실 함수는 평균 반전 횟수를 랭킹에 반영할 수 있다.

많은 경우에, 이진법 선형 분급기 h()u,)'v'){\displaystyle h(x_{너},x_{v})}()){\displaystyle f())}의 채점 기능을 가지고 있다. 예를 들자면, RankNet[16]과 docume의 추정 확률로 h()u,)'v'){\displaystyle h(x_{너},x_{v})}를 정의하는 확률 모델 잘 적응하고 구현됩니다.nt u(\u})는 x 보다 품질이 높습니다.

서 CDF( style 표시은 표준 로지스틱 CDF와 같은 누적 분포 함수입니다.

리스트와이즈 어프로세서

이러한 알고리즘은 교육 데이터의 모든 쿼리에 대해 평균화된 위의 평가 척도 중 하나의 값을 직접 최적화하려고 합니다.대부분의 평가 척도가 순위 모델의 매개변수와 관련된 연속 함수가 아니므로 평가 척도에 대한 연속 근사치 또는 한계를 사용해야 하기 때문에 이는 어렵다.

메서드 리스트

아래에 공개된 순위 지정 학습 알고리즘의 일부 목록이 각 방법의 몇 년 동안의 최초 발표와 함께 나와 있다.

연도 이름. 유형 메모들 1989 OPRF [17] 포인트 다항식 회귀(기계 학습 대신 패턴 인식을 참조하지만 생각은 동일) 1992 SLR [18] 포인트 단계적 로지스틱 회귀 분석 1994 NMOpt [19] 로 2 비메트릭 최적화 1999 다중 가법 회귀 트리(MART) 으로 2개 2000 랭킹 SVM(RankSVM) 으로 2개 클릭스루 로그를 사용하여 순위를 매기는 응용 프로그램에 대해 설명하는 보다 최근의 설명이 [3]있습니다. 2002 장난[20] 포인트로 순서형 회귀. 2003 랭크 부스트 으로 2개 2005 랭크넷 으로 2개 2006 IR-SVM 으로 2개 손실 함수에서 쿼리 수준의 정규화를 사용하여 SVM의 순위를 매깁니다. 2006 람다랭크 쌍으로/목록으로 RankNet. 쌍별 손실 함수에 스왑에 의한 IR 메트릭의 변경을 곱합니다. 2007 에이다랭크 3 2007 프랭크야. 으로 2개 RankNet을 기반으로 다른 손실 함수인 충실도 손실을 사용합니다. 2007 GB랭크 으로 2개 2007 리스트 넷 3 2007 맥랭크 포인트로 2007 Q브랭크 으로 2개 2007 랭크코신 3 2007 랭크GP[21] 3 2007 랭크 RLS 으로 2개 정규화된 최소 제곱 기준 순위입니다.이 작업은 일반 선호 그래프에서 순위를 매기는 방법을 배우는 것으로 확장된다.

2007 SVMmap 3 2008 LambdaSMART/LambdaMART 쌍으로/목록으로 2010년 Yahoo Learning to Ranking 대회에서 람다마트 모델 앙상블을 사용하여 입상.Lambda-submodel-MART의 경우 MART(1999년)[23] "LambdaSMART" 또는 서브모델이 없는 경우 LambdaMART를 기반으로 한다. 2008 리스트 MLE 3 ListNet을 기반으로 합니다. 2008 PermuRank 3 2008 소프트랭크 3 2008 순위 조정[24] 으로 2개 Boosting을 사용하여 순위를 매기는 방법을 학습하기 위한 반감독 접근법입니다. 2008 SSRank Boost[25] 으로 2개 부분적으로 레이블이 지정된 데이터로 학습하기 위한 RankBoost의 확장 기능(순위에 대한 반감독 학습) 2008 소트넷[26] 으로 2개 SortNet은 뉴럴 네트워크를 비교기로 사용하여 객체를 정렬하는 적응형 랭킹 알고리즘입니다. 2009 MP부스트 으로 2개 RankBoost의 크기를 유지하는 변형입니다.한 쌍의 문서 레이블이 더 불평등할수록 알고리즘이 문서의 순위를 매기기가 더 어려워진다는 것입니다. 2009 볼츠랭크 3 이전 방식과 달리, BoltzRank는 쿼리 시간 동안 단일 문서뿐만 아니라 문서 쌍에서도 검색되는 순위 모델을 생성합니다. 2009 베이즈랭크 3 Plackett-Luce Model과 뉴럴 네트워크를 결합하여 의사결정 측면에서 NDCG와 관련된 예상 베이즈 위험을 최소화하는 방법이다. 2010 NDCG 부스트[27] 3 NDCG를 최적화하기 위한 부스트 어프로치. 2010 GB렌드 으로 2개 GBRank를 일부 공유 기능을 사용하여 여러 개의 순위별 학습 문제를 공동으로 해결하는 학습 대 혼합 문제로 확장합니다. 2010 인터벌랭크 및 리스트와이즈 2010 CRR 포인트와 쌍으로 회귀와 랭킹의 조합.확률적 경사 강하를 사용하여 순위 SVM의 점별 2차 손실과 쌍별 힌지 손실의 선형 조합을 최적화한다. 2014 LCR 으로 2개 공동 랭킹에 로컬 하위 순위 가정 적용.제14회 WWW에서 최우수 학생 논문상을 수상했습니다. 2015 페이스넷 쌍으로 심층 컨볼루션 네트워크를 통해 트리플렛 메트릭을 사용하여 얼굴 이미지의 순위를 매깁니다. 2016 XGBoost 쌍으로 다양한 순위 목표 및 평가 지표를 지원합니다. 2017 ES-랭크 리스트적으로 7가지 피트니스 평가 지표를 사용하여 순위를 매기기 위한 진화 전략 학습 2018 DLCM [28] 로 2 초기 순위 목록(로컬 컨텍스트)에서 여러 항목을 반복 뉴럴 네트워크로 인코딩하고 그에 따라 결과 순위를 생성하는 다변수 순위 함수입니다. 2018 폴리랭크[29] 쌍으로 쌍별 비교를 통해 순위와 기본 생성 모델을 동시에 학습합니다. 2018 FATE-Net/FETA-Net [30] 리스트적으로 엔드 투 엔드 교육 가능한 아키텍처. 컨텍스트 효과를 모델링하기 위해 모든 항목을 명시적으로 고려합니다. 2019 패스트 AP [31] 리스트적으로 평균 정밀도를 최적화하여 딥 임베딩 학습 2019 뽕나무 리스트와 하이브리드 전체 데이터 세트에 걸쳐 여러 메트릭을 최대화하는 랭킹 정책을 학습합니다. 2019 다이렉트 랭커 쌍으로 RankNet 아키텍처의 일반화 2019 GSF [32] 로 2 심층 뉴럴 네트워크(neural network)로 구축된 그룹별 스코어링 함수로 항목을 부호화 및 랭킹하는 치환 불변 다변수 랭킹 함수입니다. 2020 RaMBO[33] 리스트적으로 블랙박스 역전파를[34] 사용하여 순위 기반 메트릭 최적화 2020 PRM [35] 쌍으로 항목 간의 종속성과 상호 작용을 모두 인코딩하는 변압기 네트워크 사용자와 항목 간

2020 Set Rank (Set Rank) [36] 로 2 셀프 어텐션네트워크로 항목을 부호화 및 랭킹하는 치환 불변 다변수 랭킹 기능. 2021 파이랭크 [37] 리스트적으로 순위를 매길 수 있는 대리인은 원하는 지표를 정확하게 회복할 수 있으며, 대규모 목록 크기에 맞게 확장되므로 인터넷 규모의 벤치마크를 크게 개선할 수 있습니다.

주의: 대부분의 지도 학습 알고리즘은 포인트별 사례에 적용할 수 있으므로, 순위를 고려하여 특별히 설계된 방법만 위에 나와 있습니다.

역사

Norbert Fuhr은 1992년에 정보 검색에서의 학습 접근법을 매개변수 [38]추정의 일반화라고 설명하면서 MLR의 일반적인 아이디어를 도입했다. 이 접근법의 특정 변형(다항식 회귀를 사용)은 3년 [17]전에 그에 의해 발표되었다.Bill Cooper는 1992년에 같은 목적을 위한 로지스틱 회귀 분석을 제안했고, 그의 버클리 연구 그룹과 함께 TRC의 성공적인 순위 함수를 훈련시키기 위해 그것을 사용했다.Manning [39]등은 이러한 초기 연구가 사용 가능한 훈련 데이터가 거의 없고 기계 학습 기법이 부족하기 때문에 시간 내에 제한된 결과를 달성했다고 주장한다.

NIPS, SIGIR, ICML 등의 여러 회의에서는 2000년대 중반 이후(2012년)부터 순위별 학습 문제에 관한 워크숍이 개최되었습니다.

검색 엔진에 의한 실용화

상용 웹 검색 엔진은 2000년대(10년)부터 기계 학습 순위 시스템을 사용하기 시작했다.이 검색 엔진을 최초로 사용하기 시작한 것은 AltaVista(나중에 Overture, 그리고 Yahoo에 의해 기술이 인수됨)로,[40][41] 2003년 4월에 그라데이션 부스팅 트레이닝된 랭킹 기능을 개시했다.

빙의 검색은 2005년 마이크로소프트 리서치에서 발명한 RankNet [42][when?]알고리즘에 의해 추진된다고 한다.

2009년 11월, 러시아의 검색 엔진 Yandex는[43], 의식하지 않는 의사결정 [44]트리를 사용하는 그라데이션 부스트 방식의 변형인 새로운 독자 사양의 MatrixNet 알고리즘의 도입에 의해서, 검색 품질이 큰폭으로 향상되었다고 발표했다.최근에는 자체 검색엔진의 생산 데이터를 바탕으로 기계학습 랭킹 대회인 '인터넷 수학 2009'[45]도 후원하고 있다.야후는 [46]2010년에도 비슷한 대회를 발표했다.

2008년 현재 구글의 피터 노비그는 검색엔진이 기계로 학습한 순위에 [47]전적으로 의존한다는 사실을 부인했다.Cuil의 CEO인 Tom Costello는 클릭률이나 랜딩 페이지의 시간과 같은 측정 기준에서 기계로 학습한 모델을 능가할 수 있기 때문에 손으로 만든 모델을 선호한다고 제안합니다. 이는 기계로 학습한 모델이 "사람들이 실제로 [48]좋아하는 것이 아니라 사람들이 좋아하는 것을 학습하기 때문"이기 때문입니다.

2017년 1월 이 기술은 오픈 소스 검색 엔진 Apache Solr™[49]에 포함되어 기계 학습 검색 순위를 엔터프라이즈 검색에서도 폭넓게 액세스할 수 있게 되었습니다.

취약성

컴퓨터 비전의 인식 애플리케이션과 유사하게, 최근의 뉴럴 네트워크 기반 순위 알고리즘은 후보와 [50]쿼리 모두에서 은밀한 적대적 공격에 취약한 것으로 밝혀졌다.인간이 감지할 수 없는 작은 동요로, 순위 순서는 임의로 바뀔 수 있다.또한 모델에 구애받지 않는 이전 가능한 적대적 사례가 가능한 것으로 확인되었으며, [50][51]이를 통해 기본 구현에 대한 액세스 없이 상위 시스템에 대한 블랙박스 적대적 공격이 가능합니다.

반대로, 그러한 순위 시스템의 견고성은 매드리 [52]방어와 같은 적대적 방어를 통해 개선될 수 있다.

「 」를 참조해 주세요.

레퍼런스

- ^ a b WWW 2009 컨퍼런스에서 Tie-Yan Liu의 강연 슬라이드는 온라인으로 입수 가능 2017-08-08 Wayback Machine에서 아카이브Tie-Yan Liu (2009), "Learning to Rank for Information Retrieval", Foundations and Trends in Information Retrieval, 3 (3): 225–331, doi:10.1561/1500000016, ISBN 978-1-60198-244-5 완료

- ^ Mehryar Mohri, Afshin Rostamizadeh, Ameet Talwalkar (2012) 기계학습 재단, MIT 9780262018258 프레스.

- ^ a b Joachims, T. (2002), "Optimizing Search Engines using Clickthrough Data" (PDF), Proceedings of the ACM Conference on Knowledge Discovery and Data Mining, archived (PDF) from the original on 2009-12-29, retrieved 2009-11-11

- ^ Joachims T.; Radlinski F. (2005), "Query Chains: Learning to Rank from Implicit Feedback" (PDF), Proceedings of the ACM Conference on Knowledge Discovery and Data Mining, arXiv:cs/0605035, Bibcode:2006cs........5035R, archived (PDF) from the original on 2011-07-27, retrieved 2009-12-19

- ^ B. Cambazoglu; H. Zaragoza; O. Chapelle; J. Chen; C. Liao; Z. Zheng; J. Degenhardt., "Early exit optimizations for additive machine learned ranking systems" (PDF), WSDM '10: Proceedings of the Third ACM International Conference on Web Search and Data Mining, 2010., archived from the original (PDF) on 2019-08-28, retrieved 2009-12-23

- ^ Broder A.; Carmel D.; Herscovici M.; Soffer A.; Zien J. (2003), "Efficient query evaluation using a two-level retrieval process" (PDF), Proceedings of the Twelfth International Conference on Information and Knowledge Management: 426–434, doi:10.1145/956863.956944, ISBN 978-1-58113-723-1, S2CID 2432701, archived from the original (PDF) on 2009-05-21, retrieved 2009-12-15

- ^ a b 섹션 7.1 웨이백Manning C.; Raghavan P.; Schütze H. (2008), Introduction to Information Retrieval, Cambridge University Press 머신에서 2009-07-19 아카이브

- ^ a b Kevin K. Duh (2009), Learning to Rank with Partially-Labeled Data (PDF), archived (PDF) from the original on 2011-07-20, retrieved 2009-12-27

- ^ Yuanhua Lv, Taesup Moon, Pranam Kolari, Zhaohui Zheng, Xuanhui Wang 및 Yi Chang, 뉴스 추천 모델 관련성 학습 2011-08-27 World World Wide Web(WWWWWWW) 국제 컨퍼런스, 2011년 8월 27일 Wayback Machine에서 아카이브되었습니다.

- ^ Xuan, Jifeng; Monperrus, Martin (2014). "Learning to Combine Multiple Ranking Metrics for Fault Localization". 2014 IEEE International Conference on Software Maintenance and Evolution. pp. 191–200. CiteSeerX 10.1.1.496.6829. doi:10.1109/ICSME.2014.41. ISBN 978-1-4799-6146-7. S2CID 11223473. Archived from the original on 2021-10-17. Retrieved 2018-11-02.

- ^ Richardson, M.; Prakash, A.; Brill, E. (2006). "Beyond PageRank: Machine Learning for Static Ranking" (PDF). Proceedings of the 15th International World Wide Web Conference. pp. 707–715. Archived (PDF) from the original on 2009-08-15. Retrieved 2009-11-18.

- ^ "Archived copy". Archived from the original on 2011-01-04. Retrieved 2009-12-14.

{{cite web}}: CS1 maint: 제목으로 아카이브된 복사(링크) - ^ Olivier Chapelle; Donald Metzler; Ya Zhang; Pierre Grinspan (2009), "Expected Reciprocal Rank for Graded Relevance" (PDF), CIKM, archived from the original (PDF) on 2012-02-24

- ^ Gulin A.; Karpovich P.; Raskovalov D.; Segalovich I. (2009), "Yandex at ROMIP'2009: optimization of ranking algorithms by machine learning methods" (PDF), Proceedings of ROMIP'2009: 163–168, archived (PDF) from the original on 2009-11-22, retrieved 2009-11-13 (러시아어)

- ^ Tax, Niek; Bockting, Sander; Hiemstra, Djoerd (2015), "A cross-benchmark comparison of 87 learning to rank methods" (PDF), Information Processing & Management, 51 (6): 757–772, doi:10.1016/j.ipm.2015.07.002, archived from the original (PDF) on 2017-08-09, retrieved 2017-10-15

- ^ Burges, Chris J. C.; Shaked, Tal; Renshaw, Erin; Lazier, Ari; Deeds, Matt; Hamilton, Nicole; Hullender, Greg (1 August 2005). "Learning to Rank using Gradient Descent". Archived from the original on 26 February 2021. Retrieved 31 March 2021.

{{cite journal}}:Cite 저널 요구 사항journal=(도움말) - ^ a b Fuhr, Norbert (1989), "Optimum polynomial retrieval functions based on the probability ranking principle", ACM Transactions on Information Systems, 7 (3): 183–204, doi:10.1145/65943.65944, S2CID 16632383

- ^ a b Cooper, William S.; Gey, Frederic C.; Dabney, Daniel P. (1992), "Probabilistic retrieval based on staged logistic regression", SIGIR '92 Proceedings of the 15th Annual International ACM SIGIR Conference on Research and Development in Information Retrieval: 198–210, doi:10.1145/133160.133199, ISBN 978-0897915236, S2CID 125993

- ^ Bartell, Brian T.; Cottrell Garrison W.; Belew, Richard K. (1994), "Automatic Combination of Multiple Ranked Retrieval Systems", SIGIR '94 Proceedings of the 17th Annual International ACM SIGIR Conference on Research and Development in Information Retrieval: 173–181, doi:10.1007/978-1-4471-2099-5_18, ISBN 978-0387198897, S2CID 18606472, archived from the original on 2018-06-13, retrieved 2020-10-12

- ^ "Pranking". 2001: 641–647. CiteSeerX 10.1.1.20.378.

{{cite journal}}:Cite 저널 요구 사항journal=(도움말) - ^ "RankGP". CiteSeerX 10.1.1.90.220.

{{cite journal}}:Cite 저널 요구 사항journal=(도움말) - ^ Pahikkala, Tapio; Tsivtsivadze, Evgeni; Airola, Antti; Järvinen, Jouni; Boberg, Jorma (2009), "An efficient algorithm for learning to rank from preference graphs", Machine Learning, 75 (1): 129–165, doi:10.1007/s10994-008-5097-z.

- ^ C. 트림(2010).RankNet에서 LambdaRank로 LambdaMA로RT: Wayback Machine에서 2017-11-10년에 아카이브된 개요.

- ^ Rong Jin, Hamed Valizadegan, Hang Li, 랭킹 개선 및 정보 검색 신청, World Wide Web(WW; 월드 와이드 웹) 국제회의, 2008, Wayback Machine에서 2012-04-06년에 아카이브되었습니다.

- ^ Massih-Reza Amini, Vinh Truong, Cyril Goutte, 부분적으로 라벨이 붙은 데이터를 사용하여 초당 순위 함수를 학습하기 위한 부스팅 알고리즘 2010-08-02 국제 ACM SIGIR 컨퍼런스에서 아카이브된 2010-08.Wayback Machine에서 Archived 2010-07-23 코드를 조사 목적으로 사용할 수 있습니다.

- ^ Leonardo Rigutini, Tiziano Papini, Marco Maggini, Franco Scarselli, "SortNet: 신경 기반 정렬 알고리즘에 의한 랭킹 학습" 2011-11-25 Wayback Machine, SIGIR 2008 워크숍에서 아카이브: Learning to Ranking for Information Retrial, 2008, 2008

- ^ Hamed Valizadegan, Rong Jin, Ruofei Zhang, Jianchang Mao, Wayback Machine, Proceeding of Neural Information Processing Systems(NIPS), 2010에서 NDCG 측정 최적화로 순위를 매기는 방법.

- ^ Ai, Qingyao; Bi, Keping; Jiafeng, Guo; Croft, W. Bruce (2018), "Learning a deep listwise context model for ranking refinement", SIGIR '18 Proceedings of the 41st Annual International ACM SIGIR Conference on Research and Development in Information Retrieval: 135–144, doi:10.1145/3209978.3209985, ISBN 9781450356572, S2CID 4956076

- ^ Davidov, Ori; Ailon, Nir; Oliveira, Ivo F. D. (2018). "A New and Flexible Approach to the Analysis of Paired Comparison Data". Journal of Machine Learning Research. 19 (60): 1–29. ISSN 1533-7928. Archived from the original on 2019-10-03. Retrieved 2019-09-17.

- ^ Pfannschmidt, Karlson; Gupta, Pritha; Hüllermeier, Eyke (2018). "Deep Architectures for Learning Context-dependent Ranking Functions". arXiv:1803.05796 [stat.ML].

- ^ Fatih Cakir, Kun He, Xide Xia, Brian Kulis, Stan Sclaroff, In Proc의 Wayback Machine에서 아카이브된 2019-05-14 순위를 매기기 위한 딥 메트릭 학습IEEE 컴퓨터 비전 및 패턴 인식 회의(CVPR), 2019.

- ^ Ai, Qingyao; Wang, Xuanhui; Bruch, Sebastian; Golbandi, Nadav; Bendersky, Michael; Najork, Marc (2019), "Learning Groupwise Multivariate Scoring Functions Using Deep Neural Networks", ICTIR '19: Proceedings of the 2019 ACM SIGIR International Conference on Theory of Information Retrieval: 85–92, doi:10.1145/3341981.3344218, ISBN 9781450368810, S2CID 199441954

- ^ Rolínek, Michal; Musil, Vít; Paulus, Anselm; Vlastelica, Marin; Michaelis, Claudio; Martius, Georg (2020-03-18). "Optimizing Rank-based Metrics with Blackbox Differentiation". arXiv:1912.03500 [cs.LG].

- ^ Vlastelica, Marin; Paulus, Anselm; Musil, Vít; Martius, Georg; Rolínek, Michal (2019-12-04). "Differentiation of Blackbox Combinatorial Solvers". arXiv:1912.02175.

{{cite journal}}:Cite 저널 요구 사항journal=(도움말) - ^ Liu, Weiwen; Liu, Qing; Tang, Ruiming; Chen, Junyang; He, Xiuqiang; Heng, Pheng Ann (2020-10-19). "Personalized Re-ranking with Item Relationships for E-commerce". Proceedings of the 29th ACM International Conference on Information & Knowledge Management. CIKM '20. Virtual Event, Ireland: Association for Computing Machinery: 925–934. doi:10.1145/3340531.3412332. ISBN 978-1-4503-6859-9. S2CID 224281012. Archived from the original on 2021-10-17. Retrieved 2021-04-26.

- ^ Pang, Liang; Xu, Jun; Ai, Qingyao; Lan, Yanyan; Cheng, Xueqi; Wen, Jirong (2020), "SetRank: Learning a Permutation-Invariant Ranking Model for Information Retrieval", SIGIR '20 Proceedings of the 43rd Annual International ACM SIGIR Conference on Research and Development in Information Retrieval: 499–508, doi:10.1145/3397271.3401104, ISBN 9781450380164, S2CID 241534531

- ^ Swezey, Robin; Grover, Aditya; Charron, Bruno; Ermon, Stefano (2021-11-27). "PiRank: Scalable Learning To Rank via Differentiable Sorting". Advances in Neural Information Processing Systems 34 Pre-proceedings. NeurIPS '21. Virtual Event, Ireland. arXiv:2012.06731.

- ^ Fuhr, Norbert (1992), "Probabilistic Models in Information Retrieval", Computer Journal, 35 (3): 243–255, doi:10.1093/comjnl/35.3.243

- ^ Manning C.; Raghavan P.; Schütze H. (2008), Introduction to Information Retrieval, Cambridge University Press. 섹션 7.4 2009-07-21 웨이백머신에서 아카이브, 15.5 웨이백머신에서 아카이브 2010-05-09

- ^ 얀 O. 페더슨2011-07-13년 웨이백 머신에 아카이브된 MLR 스토리

- ^ 미국 특허 7,197,497

- ^ "Bing Search Blog: User Needs, Features and the Science behind Bing". Archived from the original on 2009-11-25. Retrieved 2009-11-19.

- ^ Yandex사의 블로그 엔트리에서는 새로운 랭킹 모델 "Snezhinsk"에 대해 Wayback Machine에서 2012-03-01 아카이브 완료(러시아어)

- ^ 알고리즘은 공개되지 않았지만 [1] Wayback Machine에서 아카이브된 2010-06-01과 [2] Wayback Machine에서 아카이브된 2010-06-01에서 몇 가지 세부 사항이 공개되었습니다.

- ^ "Yandex's Internet Mathematics 2009 competition page". Archived from the original on 2015-03-17. Retrieved 2009-11-11.

- ^ "Yahoo Learning to Rank Challenge". Archived from the original on 2010-03-01. Retrieved 2010-02-26.

- ^ Rajaraman, Anand (2008-05-24). "Are Machine-Learned Models Prone to Catastrophic Errors?". Archived from the original on 2010-09-18. Retrieved 2009-11-11.

- ^ Costello, Tom (2009-06-26). "Cuil Blog: So how is Bing doing?". Archived from the original on 2009-06-27.

- ^ "How Bloomberg Integrated Learning-to-Rank into Apache Solr Tech at Bloomberg". Tech at Bloomberg. 2017-01-23. Archived from the original on 2017-03-01. Retrieved 2017-02-28.

- ^ a b Zhou, Mo; Niu, Zhenxing; Wang, Le; Zhang, Qilin; Hua, Gang (2020). "Adversarial Ranking Attack and Defense". arXiv:2002.11293v2 [cs.CV].

- ^ Li, Jie; Ji, Rongrong; Liu, Hong; Hong, Xiaopeng; Gao, Yue; Tian, Qi (2019). "Universal Perturbation Attack Against Image Retrieval". International Conference on Computer Vision (ICCV 2019): 4899–4908. arXiv:1812.00552. Archived from the original on 2020-07-06. Retrieved 2020-07-04.

- ^ Madry, Aleksander; Makelov, Aleksandar; Schmidt, Ludwig; Tsipras, Dimitris; Vladu, Adrian (2017-06-19). "Towards Deep Learning Models Resistant to Adversarial Attacks". arXiv:1706.06083v4 [stat.ML].

외부 링크

- 경쟁 제품 및 공개 데이터 세트

- 오픈 소스 코드

검색이라고 하며, 문서의 정적 품질 점수 및 계층형

검색이라고 하며, 문서의 정적 품질 점수 및 계층형  문서나 이미지 등의 평가 대상 객체를

문서나 이미지 등의 평가 대상 객체를

2변수 또는 다변수 함수 및 L

2변수 또는 다변수 함수 및 L 손실함수를 나타냅니다.

손실함수를 나타냅니다.

![{\displaystyle {\text{CDF}}(x)={\frac {1}{1+\exp \left[-x\right]}}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/3eba0ba1abb9e542d3ae22be1794685646824900)