신경망

Neural network신경망은 뉴런이라고 불리는 상호 연결된 단위들의 그룹으로 서로 신호를 보냅니다. 뉴런은 생물학적 세포 또는 수학적 모델이 될 수 있습니다. 개별 뉴런은 간단하지만 네트워크에서 함께 많은 뉴런이 복잡한 작업을 수행할 수 있습니다. 신경망에는 크게 두 가지 유형이 있습니다.

- 신경과학에서 생물학적 신경망은 뇌와 복잡한 신경계에서 발견되는 물리적 구조인 시냅스로 연결된 신경 세포 집단입니다.

- 기계 학습에서 인공 신경망은 비선형 함수를 근사화하는 데 사용되는 수학적 모델입니다. 인공 신경망은 인공 지능 문제를 해결하는 데 사용됩니다.

생물학적 신경망

생물학적 신경망은 시냅스에 의해 서로 화학적으로 연결된 생물학적 뉴런의 집단입니다. 주어진 뉴런은 수십만 개의 시냅스에 연결될 수 있습니다.[1] 각각의 뉴런은 연결된 이웃들에게 활동전위라고 불리는 전기화학적 신호를 주고 받습니다. 뉴런은 수신한 신호를 증폭하고 전파하는 흥분적인 역할을 하거나 신호를 억제하는 억제적인 역할을 할 수 있습니다.[1]

신경망보다 작은 상호 연결된 뉴런의 집단을 신경 회로라고 합니다. 매우 큰 상호 연결된 네트워크를 대규모 뇌 네트워크라고 하며, 이들 중 많은 부분이 함께 뇌와 신경계를 형성합니다.

뇌에서 신경망에 의해 생성된 신호는 결국 신경계를 거쳐 근육세포로 가는 신경근육 접합부를 통과하여 수축과 운동을 일으킵니다.[2]

인공신경망

인공 신경망은 비선형 함수를 근사화하는 데 사용되는 수학적 모델입니다. 초기의 인공 신경망이 물리적 기계였다면,[3] 오늘날은 거의 항상 소프트웨어로 구현됩니다.

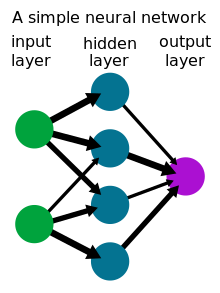

인공 신경망의 뉴런은 일반적으로 층으로 배열되며, 정보는 제1 층(입력 층)에서 하나 이상의 중간 층(숨겨진 층)을 거쳐 최종 층(출력 층)으로 전달됩니다.[4] 각 뉴런에 입력되는 "신호"는 숫자, 구체적으로 이전 레이어에서 연결된 뉴런의 출력의 선형 조합입니다. 각 뉴런이 출력하는 신호는 활성화 함수에 따라 이 숫자에서 계산됩니다. 네트워크의 동작은 뉴런 간 연결의 강도(또는 가중치)에 따라 달라집니다. 네트워크는 일부 기존 데이터 세트에 맞게 경험적 위험 최소화 또는 역전파를 통해 이러한 가중치를 수정하여 학습됩니다.[5]

신경망은 인공 지능의 문제를 해결하는 데 사용되며, 예측 모델링, 적응형 제어, 얼굴 인식, 필기 인식, 일반 게임 플레이 및 생성 AI를 포함한 많은 분야에서 응용 분야를 찾았습니다.

역사

현대 신경망의 이론적 기반은 1873년[6] 알렉산더 베인과 1890년 윌리엄 제임스에 의해 독립적으로 제안되었습니다.[7] 둘 다 인간의 생각이 뇌 안에 있는 많은 신경세포들 사이의 상호작용에서 나왔다고 가정했습니다. 1949년 도널드 헵(Donald Hebb)은 신호가 시냅스를 따라 이동할 때마다 시냅스를 강화하여 신경망이 시간이 지남에 따라 변화하고 학습할 수 있다는 아이디어인 Hebbian learning에 대해 설명했습니다.[8]

인공신경망은 원래 1930년대부터 연결주의의 접근 방식으로 생물학적 신경망을 모델링하는 데 사용되었습니다. 하지만 1943년 워렌 맥컬록과 월터 피츠버그에 의해 간단한 인공신경망인 퍼셉트론이 발명된 [9]것을 시작으로 1957년 프랭크 로젠블랫에 의해 하드웨어로 구현된 것을 시작으로 [3]인공신경망은 기계학습 응용에 점점 더 많이 사용되었습니다. 그리고 생물학적 대응물과 점점 더 다릅니다.

참고 항목

참고문헌

- ^ a b Shao, Feng; Shen, Zheng (9 January 2022). "How can artificial neural networks approximate the brain?". Front Psychol. 13: 970214. doi:10.3389/fpsyg.2022.970214. PMC 9868316. PMID 36698593.

- ^ Levitan, Irwin; Kaczmarek, Leonard (August 19, 2015). "Intercellular communication". The Neuron: Cell and Molecular Biology (4th ed.). New York, NY: Oxford University Press. pp. 153–328. ISBN 978-0199773893.

- ^ a b Rosenblatt, F. (1958). "The Perceptron: A Probabilistic Model For Information Storage And Organization In The Brain". Psychological Review. 65 (6): 386–408. CiteSeerX 10.1.1.588.3775. doi:10.1037/h0042519. PMID 13602029. S2CID 12781225.

- ^ Bishop, Christopher M. (2006-08-17). Pattern Recognition and Machine Learning. New York: Springer. ISBN 978-0-387-31073-2.

- ^ Vapnik, Vladimir N.; Vapnik, Vladimir Naumovich (1998). The nature of statistical learning theory (Corrected 2nd print. ed.). New York Berlin Heidelberg: Springer. ISBN 978-0-387-94559-0.

- ^ Bain (1873). Mind and Body: The Theories of Their Relation. New York: D. Appleton and Company.

- ^ James (1890). The Principles of Psychology. New York: H. Holt and Company.

- ^ Hebb, D.O. (1949). The Organization of Behavior. New York: Wiley & Sons.

- ^ McCulloch, W; Pitts, W (1943). "A Logical Calculus of Ideas Immanent in Nervous Activity". Bulletin of Mathematical Biophysics. 5 (4): 115–133. doi:10.1007/BF02478259.