디지털 이미지 처리

Digital image processing디지털 이미지 처리는 알고리즘을 [1][2]통해 디지털 이미지를 처리하기 위해 디지털 컴퓨터를 사용하는 것입니다.디지털 신호 처리의 하위 카테고리 또는 분야로서 디지털 화상 처리에는 아날로그 화상 처리보다 많은 이점이 있습니다.입력 데이터에 훨씬 광범위한 알고리즘을 적용할 수 있으며 처리 중 노이즈의 축적이나 왜곡 등의 문제를 방지할 수 있습니다.이미지는 2차원(아마도 그 이상)에 걸쳐 정의되기 때문에 디지털 이미지 처리는 다차원 시스템의 형태로 모델링될 수 있습니다.디지털 화상 처리의 생성과 개발은 주로 세 가지 요소에 의해 영향을 받는다. 첫째, 컴퓨터의 발전, 둘째, 수학의 발전(특히 이산 수학 이론의 창조와 개선), 셋째, 환경, 농업, 군사, 산업 및 산업 분야에서 광범위한 응용 분야에 대한 수요.의학이 증가했다.

역사

디지털 화상 처리 또는 디지털 화상 처리의 많은 기술은 1960년대에 벨 연구소, 제트 추진 연구소, 매사추세츠 공대, 메릴랜드 대학 및 기타 몇 가지 연구 시설에서 위성 이미지, 유선 사진 표준에 적용하면서 개발되었습니다.nversion, 의료 이미징, 화상전화, 문자 인식 및 사진 강화.[3]초기 이미지 처리의 목적은 이미지 품질을 향상시키는 것이었습니다.그것은 인간의 시각 효과를 향상시키기 위한 것이었다.화상 처리에서는, 입력은 저화질 화상, 출력은 화질이 개선된 화상이다.일반적인 이미지 처리에는 이미지 확장, 복원, 인코딩 및 압축이 포함됩니다.첫 번째 성공적인 적용은 American Jet Propulation Laboratory(JPL)였다.이들은 1964년 우주탐지기 레인저 7호가 보내온 수천 장의 달 사진에 대해 태양의 위치와 달의 환경을 고려해 기하학적 보정, 그라데이션 변환, 노이즈 제거 등의 화상 처리 기술을 사용했다.컴퓨터에 의한 달 표면 지도의 성공적인 지도가 미치는 영향은 매우 성공적이었다.이후 우주선이 귀환한 10만 장의 사진에 대해 보다 복잡한 화상처리가 이뤄져 달의 지형도, 색채도, 파노라마 모자이크를 얻었고, 이는 놀라운 결과를 얻어 인간이 [4]달에 착륙할 수 있는 탄탄한 기반을 마련했다.

그러나 그 시대의 컴퓨팅 기기에서는 처리 비용이 상당히 비쌌습니다.1970년대에 디지털 이미지 처리가 보급되면서 저렴한 컴퓨터와 전용 하드웨어가 보급되면서 상황이 바뀌었습니다.이것에 의해, 텔레비전 표준의 변환등의 전용의 문제에 대해서, 영상이 리얼타임으로 처리되었습니다.범용 컴퓨터의 속도가 빨라짐에 따라 가장 전문적이고 컴퓨터를 많이 사용하는 작업을 제외한 모든 작업에 전용 하드웨어의 역할을 이어받기 시작했습니다.2000년대에 빠른 컴퓨터와 신호 프로세서가 보급되면서 디지털 화상 처리는 가장 일반적인 이미지 처리 형태가 되었고, 가장 다용도일 뿐만 아니라 가장 저렴한 방법이기 때문에 일반적으로 사용되고 있습니다.

이미지 센서

현대 이미지 센서의 기초는 MOS(Metal-Oxide-Semiconductor) [5]기술인데, 이는 모하메드 M이 MOSFET(MOS 전계효과 트랜지스터)를 발명한 데서 비롯되었다. 1959년 [6]벨 연구소에서 아탈라와 다원캉이 연구했죠이를 통해 CCD(Charge-Coupled Device)와 CMOS [5]센서를 포함한 디지털 반도체 이미지 센서가 개발되었습니다.

전하 결합 장치는 윌러드 S에 의해 발명되었다. 보일과 조지 E. 1969년 [7]벨 연구소의 스미스입니다MOS 기술을 연구하는 동안, 그들은 전하가 자기 기포와 유사하며 작은 MOS 콘덴서에 저장될 수 있다는 것을 깨달았다.일련의 MOS 캐패시터를 일렬로 조립하는 것은 매우 간단했기 때문에, 적절한 전압을 콘덴서에 접속해, 전하를 다른 [5]콘덴서로 전환할 수 있었습니다.CCD는 후에 텔레비전 [8]방송용 최초의 디지털 비디오 카메라에 사용된 반도체 회로입니다.

NMOS 액티브 픽셀 센서(APS)는 1980년대 중반 일본의 올림푸스에 의해 발명되었다.이는 MOSFET 스케일링이 더 작은 마이크론과 그 다음 서브미크론 [9][10]레벨에 도달하는 등 MOS 반도체 디바이스 제조의 진보에 의해 가능해졌다.NMOS APS는 1985년 [11]올림푸스에서 나카무라 츠토무(中村 츠토무)의 팀에 의해 제조되었다.CMOS 능동 화소 센서(CMOS 센서)는 나중에 [12]1993년 NASA 제트 추진 연구소의 에릭 포섬 팀에 의해 개발되었다.2007년에는 CMOS 센서 판매량이 CCD 센서를 [13]앞질렀다.

이미지 압축

디지털 이미지 압축 기술의 중요한 발전은 Nasir Ahmed가 [14]1972년에 처음 제안한 손실 압축 기술인 이산 코사인 변환(DCT)이었다.DCT 압축은 JPEG의 기반이 되었으며, 1992년 [15]공동 사진 전문가 그룹에 의해 도입되었다.JPEG는 이미지를 훨씬 작은 파일 크기로 압축하여 인터넷에서 [16]가장 널리 사용되는 이미지 파일 형식이 되었습니다.고효율 DCT 압축 알고리즘은 디지털 이미지와 디지털 [17]사진의 광범위한 확산에 크게 기여했으며,[18] 2015년 현재[update] 매일 수십억 개의 JPEG 이미지가 생성되었습니다.

디지털 신호 프로세서(DSP)

1970년대에 [19]MOS 기술이 널리 채택되면서 전자 신호 처리는 혁신적이었습니다.MOS 집적회로 기술은 1970년대 [20]초 최초의 싱글칩 마이크로프로세서와 마이크로컨트롤러의 기초가 되었고, 1970년대 [21][22]후반에는 최초의 싱글칩 디지털 신호 프로세서(DSP) 칩의 기초가 되었습니다.DSP 칩은 디지털 화상 [21]처리에 널리 사용되고 있습니다.

이산 코사인 변환(DCT) 이미지 압축 알고리즘은 DSP 칩에 널리 구현되어 있으며, 많은 기업이 DCT 기술을 기반으로 DSP 칩을 개발하고 있습니다.DCT는 부호화, 복호화, 비디오 부호화, 오디오 부호화, 다중화, 제어 신호, 시그널링, 아날로그-디지털 변환, 포맷 휘도 및 색차이에 널리 이용되며 YUV444, YUV411 등의 색 포맷도 동작 추정, 동작 보상, 프레임간 예측 등의 부호화 작업에 이용된다.양자화, 지각적 가중치, 엔트로피 부호화, 가변 부호화 및 움직임 벡터, 그리고 표시 목적을 위한 다른 색상 형식(YIQ, YUV 및 RGB) 간의 역연산 등의 디코딩 작업.DCT는 HDTV 인코더/디코더 [23]칩에도 일반적으로 사용됩니다.

의료 영상

1972년, 영국 회사 EMI 하우스필드의 엔지니어는 머리 진단을 위한 X선 컴퓨터 단층 촬영 장치를 발명했는데, 이것은 보통 컴퓨터 단층 촬영이라고 불린다.CT핵법은 사람의 머리 부분의 투영에 근거해 컴퓨터로 처리되어 단면 이미지를 재구성하는 것으로, 이것을 이미지 재구성이라고 부릅니다.1975년, EMI는 인체 각부의 선명한 단층 촬영 영상을 얻을 수 있는 전신용 CT 장치를 개발하는 데 성공했습니다.1979년, 이 진단 기술은 노벨상을 [4]수상했다.의료용 디지털 화상 처리 기술은 1994년에 [24]Space Foundation Space Technology 명예의 전당에 헌액되었습니다.

임무들

디지털 화상 처리는 훨씬 더 복잡한 알고리즘을 사용할 수 있게 해주며, 따라서 단순한 작업에서 보다 정교한 성능과 아날로그 수단으로는 불가능한 방법의 구현 모두를 제공할 수 있습니다.

특히, 디지털 화상 처리는 다음을 기반으로 한 구체적인 응용 및 실용적인 기술입니다.

디지털 이미지 처리에 사용되는 기술은 다음과 같습니다.

디지털 이미지 변환

필터링

디지털 필터는 디지털 이미지를 흐리게 하거나 선명하게 하기 위해 사용됩니다.필터링은 다음 방법으로 실행할 수 있습니다.

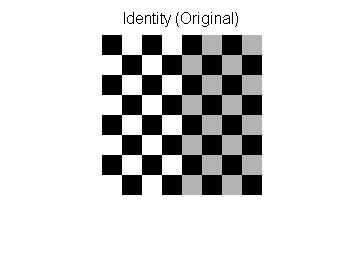

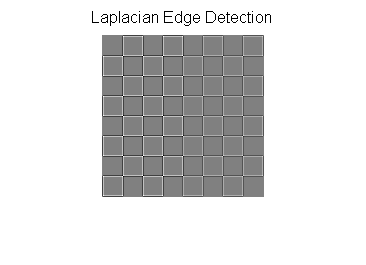

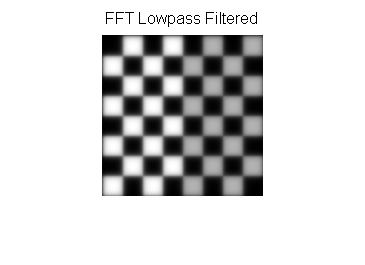

다음 예시는 [26]두 가지 방법을 모두 보여 줍니다.

| 필터 타입 | 커널 또는 마스크 | 예 |

|---|---|---|

| 원본 이미지 |  | |

| 공간 로우패스 |  | |

| 공간 하이패스 |  | |

| 푸리에 표현 | 유사 코드: image = 체커보드 F = 이미지의 푸리에 변환 이미지 표시: log(1+Absolute Value(F)) |  |

| 푸리에 로우패스 |  |  |

| 푸리에 하이패스 |  |  |

푸리에 도메인 필터링 이미지 패딩

이미지는 일반적으로 푸리에 공간으로 변환되기 전에 패딩됩니다. 아래의 하이패스 필터링된 이미지는 다양한 패딩 기법의 결과를 보여줍니다.

| 제로 패딩 | 엣지 패딩 |

|---|---|

|  |

하이패스 필터는 반복된 에지 패딩에 비해 제로 패딩 시 추가 에지를 표시합니다.

필터링 코드 예시

공간 도메인 하이패스 필터링의 MATLAB 예.

img=체커보드(20); % 생성 체커보드 %************************************************************ 클랙스=[0 -1 0; -1 5 -1; 0 -1 0]; 라플라시안 필터 커널(%) X=컨벤트2(img,클랙스); % convolve 테스트 img: % 3x3 라플라시안 커널 수치() 표시하다(X,[]) %는 Laplacian 필터링 완료 직함('라플라시안 에지 감지') 아핀 변환

아핀 변환은 다음 [26]예시와 같이 스케일, 회전, 변환, 미러 및 전단 등의 기본 영상 변환을 가능하게 합니다.

| 변환명 | 아핀 매트릭스 | 예 |

|---|---|---|

| 신원 |  | |

| 반사 |  | |

| 규모. |  | |

| 회전 | 어디 θ).mw-parser-output .sfrac{white-space:nowrap}.mw-parser-output.sfrac.tion,.mw-parser-output.sfrac .tion{디스플레이:inline-block, vertical-align:-0.5em, font-size:85%;text-align:센터}.mw-parser-output.sfrac.num,.mw-parser-output.sfrac .den{디스플레이:블록, line-height:1em, 마진:00.1em}.mw-parser-output.sfrac .den{border-top:1pxsolid}.mw.-parser-output .sr-only{국경:0;클립:rect(0,0,0,0), 높이:1px, 마진:-1px, 오버 플로: 숨어 있었다. 패딩:0;위치:절대, 너비:1px}π/6 =30° | |

| 전단 |  |

아핀 매트릭스를 영상에 적용하기 위해 영상이 각 엔트리가 해당 위치의 픽셀 강도에 해당하는 매트릭스로 변환됩니다.그런 다음 각 픽셀의 위치를 영상에서 해당 픽셀의 좌표를 나타내는 벡터 [x, y]로 나타낼 수 있습니다. 여기서 x 및 y는 영상 매트릭스에서 픽셀의 행과 열입니다.이를 통해 출력 이미지에서 픽셀 값이 복사될 위치를 제공하는 아핀 변환 행렬에 좌표를 곱할 수 있습니다.

단, 변환이 필요한 변환을 허용하려면 3차원 동종 좌표가 필요합니다.세 번째 치수는 일반적으로 0이 아닌 상수(일반적으로 1)로 설정되므로 새 좌표는 [x, y, 1]이 됩니다.이를 통해 좌표 벡터에 3×3 행렬을 곱할 수 있으므로 변환 이동이 가능합니다.그래서 세 번째 차원인 상수 1은 번역을 가능하게 합니다.

행렬 곱셈은 연관성이 있기 때문에 변환이 이루어진 순서대로 각 개별 변환의 행렬을 곱함으로써 여러 아핀 변환을 하나의 아핀 변환으로 결합할 수 있습니다.따라서 점 벡터에 적용하면 벡터 [x, y, 1]에 대해 수행된 모든 개별 변환과 동일한 결과를 얻을 수 있는 단일 행렬이 생성됩니다.따라서 아핀 변환 행렬의 시퀀스는 단일 아핀 변환 행렬로 축소될 수 있습니다.

예를 들어, 2차원 좌표는 원점(0, 0)에 대한 회전만 허용합니다.그러나 3차원 균질 좌표를 사용하여 먼저 모든 점을 (0, 0)으로 변환한 다음 회전을 수행하고 마지막으로 원점(0, 0)을 원래 점(첫 번째 변환과 반대)으로 변환할 수 있습니다.이러한 3개의 아핀 변환을 단일 매트릭스로 결합할 수 있으므로 영상의 [27]모든 점을 중심으로 회전할 수 있습니다.

Morphology를 사용한 이미지 노이즈 제거

수학적 형태학은 영상 노이즈 제거에 적합합니다.구조화 요소는 수학적 형태학에서 중요하다.

다음 예는 구조 요소에 대한 것입니다.Denoise 함수, I로서의 이미지, B로서의 구조 요소는 아래와 같습니다.

예 ) [ 40 5] [ 2 3 style ( I ) ={ && & \& & 5 { }

확장(I, B)(i,j) = { ( + , +) + ( , ) { max { Let Dilation(I,B) = D(I,B)

D(I', B)(1,1) = ( , , +, +, , +, +, + +) ( 스타일 2, , ,1)

침식 정의(I, B)(i,) = n{ ( + , j+ )- ( , n )} {\ min Let Eavoration(I,B) = E(I,B)

E(I', B)(,1) = n(-, , -, , , , - - 3 ) 2 ( min ( - 1, - 2, - 2, - 1, -1 , 15 - - 15 - 15 - - 3 ) 2 ( display min ( 45 - 1 )

팽창(나는 ′)후에)[45506540665525155]{\displaystyle(나는 ')={\begin{bmatrix}45&, 50&, 65\\40&, 66&, 55\\25&, 15&, 5\end{bmatrix}}}후에 침식(나는 ′))[4550654025525155]{\displaystyle(나는 ')={\begin{bmatrix}45&, 50&, 65\\40&을 말한다.2&, 55\\25&, 15&, 5\end{bmatrix}}}

개방방법은 단순 침식 후 팽창하는 반면 폐쇄방법은 그 반대다.실제로는 D(I,B)와 E(I,B)는 Configuration에 의해 구현될 수 있다.

| 구조화 요소 | 마스크 | 코드 | 예 |

|---|---|---|---|

| 원본 이미지 | 없음. | Matlab을 사용하여 원본 이미지 읽기원래의 = 읽다('param.jpg'); 이미지 = rbg2픽셀(원래의); [r, c, 채널.] = 크기(이미지); 인식하다 = 논리적인([1 1 1 ; 1 1 1 ; 1 1 1]); [p, q] = 크기(인식하다); 하프H = 바닥.(p/2); 반W = 바닥.(q/2); 시간을 = 3; 모든 방법으로 3회 노이즈 제거율(%) | |

| 확장 | Matlab을 사용하여 확장기입하다(이미지, "filen_filename.jpg") 추출 최대값 = 제로(크기(이미지), 학급(이미지)); 위해서 i = 1 : 시간을 dil_image = 읽다('filen_filename.jpg'); 위해서 콜 = (반W + 1): (c - 반W) 위해서 배를 젓다 = (하프H + 1) : (r - 하프H) dpointD = 배를 젓다 - 하프H; dpointU = 배를 젓다 + 하프H; dpointL = 콜 - 반W; dpointR = 콜 + 반W; 이웃나라 = dil_image(dpointD:dpointU, dpointL:dpointR); 필터 = 이웃나라(인식하다); 추출 최대값(배를 젓다, 콜) = 맥스.(필터); 끝. 끝. 기입하다(추출 최대값, "filen_filename.jpg"); 끝. | ||

| 침식 | Matlab을 사용하여 침식기입하다(이미지, 'http_ero.jpg'); 추출물 = 제로(크기(이미지), 학급(이미지)); 위해서 i = 1: 시간을 ero_image = 읽다('http_ero.jpg'); 위해서 콜 = (반W + 1): (c - 반W) 위해서 배를 젓다 = (하프H +1): (r -하프H) 포인트 다운 = 배를 젓다-하프H; 포인트 업 = 배를 젓다+하프H; 포인트 왼쪽 = 콜-반W; 포인트 오른쪽 = 콜+반W; 인접국 = ero_image(포인트 다운:포인트 업,포인트 왼쪽:포인트 오른쪽); 필터 = 인접국(인식하다); 추출물(배를 젓다, 콜) = 분(필터); 끝. 끝. 기입하다(추출물, "filen_ero.jpg"); 끝. | ||

| 오프닝 | Matlab을 사용하여 열기기입하다(추출물, "filen_opening.jpg") 압축 해제 = 제로(크기(이미지), 학급(이미지)); 위해서 i = 1 : 시간을 dil_image = 읽다('filen_opening.jpg'); 위해서 콜 = (반W + 1): (c - 반W) 위해서 배를 젓다 = (하프H + 1) : (r - 하프H) dpointD = 배를 젓다 - 하프H; dpointU = 배를 젓다 + 하프H; dpointL = 콜 - 반W; dpointR = 콜 + 반W; 이웃나라 = dil_image(dpointD:dpointU, dpointL:dpointR); 필터 = 이웃나라(인식하다); 압축 해제(배를 젓다, 콜) = 맥스.(필터); 끝. 끝. 기입하다(압축 해제, "filen_opening.jpg"); 끝. | ||

| 클로징 | Matlab을 사용하여 닫기기입하다(추출 최대값, "filen_filename.jpg") 압축 해제 = 제로(크기(이미지), 학급(이미지)); 위해서 i = 1 : 시간을 ero_image = 읽다('filen_filename.jpg'); 위해서 콜 = (반W + 1): (c - 반W) 위해서 배를 젓다 = (하프H + 1) : (r - 하프H) dpointD = 배를 젓다 - 하프H; dpointU = 배를 젓다 + 하프H; dpointL = 콜 - 반W; dpointR = 콜 + 반W; 이웃나라 = ero_image(dpointD:dpointU, dpointL:dpointR); 필터 = 이웃나라(인식하다); 압축 해제(배를 젓다, 콜) = 분(필터); 끝. 끝. 기입하다(압축 해제, "filen_filename.jpg"); 끝. |

노이즈 제거법을 화상에 적용하기 위해 화상을 그레이스케일로 변환한다.노이즈 제거 방법을 사용하는 마스크는 [ 111 {의 논리 매트릭스입니다.노이즈 제거 방법은 높이의 절반, 폭의 절반으로 사진의 중심에서 시작하여 행 번호, 열 번호의 이미지 경계로 끝납니다.네이버는 원래 이미지의 블록으로 경계는 [중앙 아래 점: 위 점, 중앙 왼쪽 점: 중앙 오른쪽 점]입니다.Configuration Neighbor 및 구조화 요소를 선택한 후 중심을 최소 인접 요소로 바꿉니다.

Closing 메서드를 예로 들어 보겠습니다.

확장 우선

- 이미지를 읽고 Matlab을 사용하여 그레이스케일로 변환합니다.

- 이미지 크기를 가져옵니다.반환값 행 번호와 열 번호는 나중에 사용할 경계입니다.

- 구조 요소는 확장 또는 침식 기능에 따라 달라집니다.픽셀의 네이버 최소값은 침식법으로, 네이버 최대값은 확장법으로 이어집니다.

- 확장, 침식 및 닫힘 시간을 설정합니다.

- 원본 이미지와 같은 크기의 제로 매트릭스를 만듭니다.

- 먼저 구조 창으로 확장합니다.

- 구조화 창은 3*3 매트릭스와 컨볼루션입니다.

- 루프 추출의 경우 열 범위 [2 ~ 이미지 높이 - 1]에서 창과 열 범위 [2 ~ 이미지 폭 - 1]의 최소 추출

- 0 매트릭스에 최소값을 채우고 새 이미지 저장

- 경계에 대해서는 여전히 개선할 수 있습니다.메서드에서는 경계가 무시됩니다.패딩 요소를 적용하여 경계를 처리할 수 있습니다.

그런 다음 침식(확장 이미지를 입력으로 사용)

- 원본 이미지와 같은 크기의 제로 매트릭스를 만듭니다.

- 구조 창문에 의한 침식

- 구조화 창은 3*3 매트릭스와 컨볼루션입니다.

- 루프 추출의 경우 열 범위 [2 ~ 이미지 높이 - 1]에서 창과 열 범위 [2 ~ 이미지 폭 - 1]의 최대값 추출

- 제로 매트릭스에 최대값을 채우고 새 이미지 저장

- 경계에 대해서는 여전히 개선할 수 있습니다.메서드에서는 경계가 무시됩니다.패딩 요소를 적용하여 경계를 처리할 수 있습니다.

- 결과는 위의 표와 같습니다.

적용들

디지털 카메라 이미지

디지털 카메라에는 일반적으로 전용 디지털 이미지 처리 하드웨어(전용 칩 또는 다른 칩에 회로 추가)가 포함되어 있어 이미지 센서로부터의 원시 데이터를 표준 이미지 파일 형식으로 색 보정된 이미지로 변환합니다.추가 후 처리 기술은 가장자리 선명도 또는 색채도를 높여 보다 자연스러운 이미지를 만듭니다.

영화

Westworld(1973년)는 디지털 영상 처리를 사용하여 사진을 픽셀링하여 안드로이드의 [28]관점을 시뮬레이션한 최초의 장편 영화이다.영상 처리는 또한 배우의 배경을 자연 또는 예술적 풍경으로 대체하는 채도 키 효과를 내기 위해 널리 사용됩니다.

얼굴 검출

얼굴 검출은 수학적 형태학, 보통 DCT라고 불리는 이산 코사인 변환 및 수평 투영(수학)을 사용하여 구현할 수 있습니다.

기능 기반 방식을 사용하는 일반적인 방법

특징 기반의 얼굴 검출 방법은 피부 톤, 가장자리 검출, 얼굴 모양 및 얼굴 특징(눈, 입 등)을 사용하여 얼굴 검출을 실현하는 것입니다.피부톤, 얼굴형, 그리고 사람 얼굴만이 가지고 있는 모든 독특한 요소들을 특징으로 표현할 수 있습니다.

공정설명

- 얼굴 이미지 배치가 주어진 경우 먼저 얼굴 이미지를 샘플링하여 피부 톤 범위를 추출합니다.피부 톤 범위는 피부 필터에 불과합니다.

- SSIM(구조 유사도 지수 측정)을 적용하여 피부톤 추출 측면에서 영상을 비교할 수 있습니다.

- 일반적으로 피부 필터에는 HSV 또는 RGB 색 공간이 적합합니다.예: HSV 모드, 피부 톤 범위는 [0,48,50] ~ [20,255,255]입니다.

- 피부톤으로 영상을 필터링한 후 얼굴 가장자리를 얻기 위해 Morphology와 DCT를 사용하여 노이즈를 제거하고 누락된 피부 부위를 메웁니다.

- 결손된 피부를 메우기 위해 개방 방법 또는 폐쇄 방법을 사용할 수 있습니다.

- DCT는 톤 같은 피부를 가진 물체를 피하는 것입니다.사람의 얼굴은 항상 질감이 높기 때문이다.

- Sobel 연산자 또는 다른 연산자를 적용하여 면 모서리를 검출할 수 있습니다.

- 눈과 같은 인간의 특징을 배치하려면 투영을 사용하여 투영 히스토그램의 피크를 찾으면 마우스, 머리카락 및 입술과 같은 세부 특징을 얻는 데 도움이 됩니다.

- 투영이란, 통상, 피쳐의 위치인 고주파를 확인하기 위해서 이미지를 투영하는 것입니다.

화질 개선 방법

화질은, 카메라의 진동, 오버노출, 그레이 레벨의 분포가 너무 집중되어 있는 것, 노이즈등의 영향을 받을 가능성이 있습니다.예를 들어, 노이즈 문제는 스무딩 방법을 사용하여 해결할 수 있지만, 그레이 레벨 분포 문제는 히스토그램 균등화를 통해 개선할 수 있습니다.

스무딩 방법

그림에서 불만족스러운 색이 있을 경우 불만족스러운 색 주위에 약간의 색을 취하여 평균화합니다.이렇게 하면 평활 방법을 쉽게 생각할 수 있습니다.

스무딩 방법은 마스크 및 컨볼루션으로 구현할 수 있습니다.다음과 같이 작은 이미지와 마스크를 예로 들 수 있습니다.

image는[ 1 6 1 2 2 } &\ \ & & & & \ \ { } }

마스크는[ / / 1 / 1 / / / 1/ 9 / 1 /9 }{ displaystyle \1/1/9\1/9\1/9&9\\1\nd입니다.

컨볼루션 및 스무딩 후 이미지는 [ 5 9 7 { { } \ \ \ & & \ 1 & \ & 2 \{}}

오버빙 이미지[1, 1], 이미지[1, 2], 이미지[2, 1] 및 이미지[2, 2].

원래 영상 픽셀은 1, 4, 28, 30입니다. 마스크를 평활하면 픽셀이 각각 9, 10, 9, 9가 됩니다.

new image [ , 1 ]= 9 { { { { 1 * ( image [ 0 , 0 ] + image [ 0 , 1 ] + image [ 1, 1 ] + image [ 2 ] + image [ 2 ] + image [ 2 ]

새 이미지 [1, 1] = 플로어 (.9 {displaystyle { { * (2+5+6+3+1+4+1+28+30) = 9 )

new image [ 1, 2 ]= 플로어보드 9{ { * (5+6+5+1+4+6+28+30+2) = 10

새 이미지 [2, 1] = 플로어 (.9 { { {9 * (3+1+4+1+28+30+73+3+2)) = 9 )

새 이미지 [2, 2] = 플로어 (.9 {displaystyle { {1} * (1+4+6+28+30+2+3+2)) = 9 )

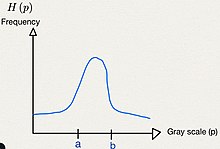

그레이 레벨 히스토그램 방법

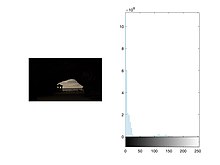

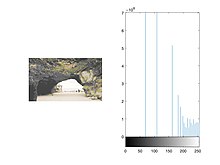

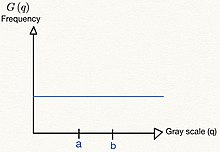

일반적으로 아래와 같은 영상에서 그레이 레벨 히스토그램이 주어집니다.이미지에서 균일한 분포로 히스토그램을 변경하는 것을 보통 히스토그램 균등화라고 합니다.

이산 시간에서 그레이 레벨 히스토그램의 면적은 i ( i) { _ {i= } ( _ { i} )이고 균일한 분포의 면적은θ k () { { i=}^{} ( ( i } } } ( ) ( i} }) ( ) ) ( ) ) ( ) ) ( ) ) ) 。면적이 변하지 않는 것은 분명하므로 i H ( ) i k ( i) { \_ { i=}^{ } ( p { i } = \ _ { }^{ k ( ( _ } )。

균일한 분포에서 i의 은 - 0({ {이며 < < } { 0 < }

연속 시간 방정식은 0 - q 0 d p H( ) s{ \ _ { _ { }^{ {\{ { ds =\ _int _ int _ 입니다.

또한 그레이 레벨 히스토그램 방법은 함수의 정의에 따라 f(p)=q를 만족하는 f{ f를 찾는 것과 같다.

| 개선 방법 | 쟁점. | 개선 전 | 과정 | 개선 후 |

|---|---|---|---|---|

| 스무딩 방법 | 잡음 Matlab을 사용하면 0.01 파라미터의 소금과 후추를 첨가할 수 있습니다. |

| ||

| 히스토그램 등화 | 회색 수준 분포가 너무 중앙 집중화됨 | 히스토그램 등화 참조 |

「 」를 참조해 주세요.

레퍼런스

- ^ Chakravorty, Pragnan (2018). "What is a Signal? [Lecture Notes]". IEEE Signal Processing Magazine. 35 (5): 175–177. Bibcode:2018ISPM...35..175C. doi:10.1109/MSP.2018.2832195. S2CID 52164353.

- ^ Gonzalez, Rafael (2018). Digital image processing. New York, NY: Pearson. ISBN 978-0-13-335672-4. OCLC 966609831.

- ^ Azriel Rosenfeld, Picture Processing by Computer, 뉴욕: Academic Press, 1969년

- ^ a b Gonzalez, Rafael C. (2008). Digital image processing. Woods, Richard E. (Richard Eugene), 1954- (3rd ed.). Upper Saddle River, N.J.: Prentice Hall. pp. 23–28. ISBN 9780131687288. OCLC 137312858.

- ^ a b c Williams, J. B. (2017). The Electronics Revolution: Inventing the Future. Springer. pp. 245–8. ISBN 9783319490885.

- ^ "1960: Metal Oxide Semiconductor (MOS) Transistor Demonstrated". The Silicon Engine. Computer History Museum. Archived from the original on 3 October 2019. Retrieved 31 August 2019.

- ^ James R. Janesick (2001). Scientific charge-coupled devices. SPIE Press. pp. 3–4. ISBN 978-0-8194-3698-6.

- ^ Boyle, William S; Smith, George E. (1970). "Charge Coupled Semiconductor Devices". Bell Syst. Tech. J. 49 (4): 587–593. doi:10.1002/j.1538-7305.1970.tb01790.x.

- ^ Fossum, Eric R. (12 July 1993). "Active pixel sensors: Are CCDS dinosaurs?". In Blouke, Morley M. (ed.). Charge-Coupled Devices and Solid State Optical Sensors III. Proceedings of the SPIE. Vol. 1900. pp. 2–14. Bibcode:1993SPIE.1900....2F. CiteSeerX 10.1.1.408.6558. doi:10.1117/12.148585. S2CID 10556755.

- ^ Fossum, Eric R. (2007). "Active Pixel Sensors". S2CID 18831792.

{{cite journal}}:Cite 저널 요구 사항journal=(도움말) - ^ Matsumoto, Kazuya; et al. (1985). "A new MOS phototransistor operating in a non-destructive readout mode". Japanese Journal of Applied Physics. 24 (5A): L323. Bibcode:1985JaJAP..24L.323M. doi:10.1143/JJAP.24.L323. S2CID 108450116.

- ^ Fossum, Eric R.; Hondongwa, D. B. (2014). "A Review of the Pinned Photodiode for CCD and CMOS Image Sensors". IEEE Journal of the Electron Devices Society. 2 (3): 33–43. doi:10.1109/JEDS.2014.2306412.

- ^ "CMOS Image Sensor Sales Stay on Record-Breaking Pace". IC Insights. 8 May 2018. Archived from the original on 21 June 2019. Retrieved 6 October 2019.

- ^ Ahmed, Nasir (January 1991). "How I Came Up With the Discrete Cosine Transform". Digital Signal Processing. 1 (1): 4–5. doi:10.1016/1051-2004(91)90086-Z. Archived from the original on 10 June 2016. Retrieved 10 October 2019.

- ^ "T.81 – DIGITAL COMPRESSION AND CODING OF CONTINUOUS-TONE STILL IMAGES – REQUIREMENTS AND GUIDELINES" (PDF). CCITT. September 1992. Archived (PDF) from the original on 17 July 2019. Retrieved 12 July 2019.

- ^ "The JPEG image format explained". BT.com. BT Group. 31 May 2018. Archived from the original on 5 August 2019. Retrieved 5 August 2019.

- ^ "What Is a JPEG? The Invisible Object You See Every Day". The Atlantic. 24 September 2013. Archived from the original on 9 October 2019. Retrieved 13 September 2019.

- ^ Baraniuk, Chris (15 October 2015). "Copy protections could come to JPEGs". BBC News. Archived from the original on 9 October 2019. Retrieved 13 September 2019.

- ^ Grant, Duncan Andrew; Gowar, John (1989). Power MOSFETS: theory and applications. Wiley. p. 1. ISBN 9780471828679.

The metal-oxide-semiconductor field-effect transistor (MOSFET) is the most commonly used active device in the very large-scale integration of digital integrated circuits (VLSI). During the 1970s these components revolutionized electronic signal processing, control systems and computers.

- ^ Shirriff, Ken (30 August 2016). "The Surprising Story of the First Microprocessors". IEEE Spectrum. Institute of Electrical and Electronics Engineers. 53 (9): 48–54. doi:10.1109/MSPEC.2016.7551353. S2CID 32003640. Archived from the original on 13 October 2019. Retrieved 13 October 2019.

- ^ a b "1979: Single Chip Digital Signal Processor Introduced". The Silicon Engine. Computer History Museum. Archived from the original on 3 October 2019. Retrieved 14 October 2019.

- ^ Taranovich, Steve (27 August 2012). "30 years of DSP: From a child's toy to 4G and beyond". EDN. Archived from the original on 14 October 2019. Retrieved 14 October 2019.

- ^ Stanković, Radomir S.; Astola, Jaakko T. (2012). "Reminiscences of the Early Work in DCT: Interview with K.R. Rao" (PDF). Reprints from the Early Days of Information Sciences. 60. Archived (PDF) from the original on 13 October 2019. Retrieved 13 October 2019.

- ^ "Space Technology Hall of Fame:Inducted Technologies/1994". Space Foundation. 1994. Archived from the original on 4 July 2011. Retrieved 7 January 2010.

- ^ Zhang, M. Z.; Livingston, A. R.; Asari, V. K. (2008). "A High Performance Architecture for Implementation of 2-D Convolution with Quadrant Symmetric Kernels". International Journal of Computers and Applications. 30 (4): 298–308. doi:10.1080/1206212x.2008.11441909. S2CID 57289814.

- ^ a b Gonzalez, Rafael (2008). Digital Image Processing, 3rd. Pearson Hall. ISBN 9780131687288.

- ^ House, Keyser (6 December 2016). Affine Transformations (PDF). Clemson. Foundations of Physically Based Modeling & Animation. A K Peters/CRC Press. ISBN 9781482234602. Archived (PDF) from the original on 30 August 2017. Retrieved 26 March 2019.

- ^ A Brief, Early History of Computer Graphics in Film Archived 2012년 7월 17일 Wayback Machine, Larry Yaeger, 2002년 8월 16일(최종 업데이트), 2010년 3월 24일 취득

추가 정보

- Solomon, C.J.; Breckon, T.P. (2010). Fundamentals of Digital Image Processing: A Practical Approach with Examples in Matlab. Wiley-Blackwell. doi:10.1002/9780470689776. ISBN 978-0470844731.

- Wilhelm Burger; Mark J. Burge (2007). Digital Image Processing: An Algorithmic Approach Using Java. Springer. ISBN 978-1-84628-379-6.

- R. Fisher; K Dawson-Howe; A. Fitzgibbon; C. Robertson; E. Trucco (2005). Dictionary of Computer Vision and Image Processing. John Wiley. ISBN 978-0-470-01526-1.

- Rafael C. Gonzalez; Richard E. Woods; Steven L. Eddins (2004). Digital Image Processing using MATLAB. Pearson Education. ISBN 978-81-7758-898-9.

- Tim Morris (2004). Computer Vision and Image Processing. Palgrave Macmillan. ISBN 978-0-333-99451-1.

- Tyagi Vipin (2018). Understanding Digital Image Processing. Taylor and Francis CRC Press. ISBN 978-11-3856-6842.

- Milan Sonka; Vaclav Hlavac; Roger Boyle (1999). Image Processing, Analysis, and Machine Vision. PWS Publishing. ISBN 978-0-534-95393-5.

- 라파엘 C.곤잘레스(2008년).디지털 이미지 처리. 프렌티스 홀. ISBN 9780131687288

외부 링크

- Alan Peters의 이미지 처리에 관한 강의.밴더빌트 대학교2016년 1월 7일 갱신.

- 컴퓨터 알고리즘을 사용한 디지털 이미지 처리

![{\displaystyle [111;111;111]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/942ebdef22e25cc555f1fb3dc7ec026a46e95fb2)

찾는 것과 같다.

찾는 것과 같다.