슈퍼컴퓨터

Supercomputer

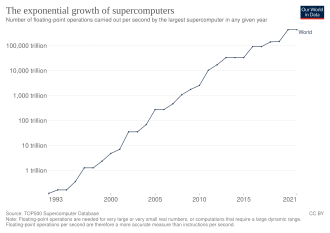

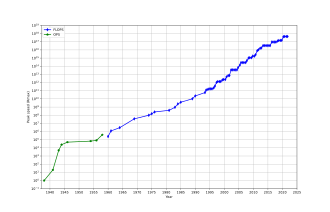

슈퍼컴퓨터는 범용 컴퓨터에 비해 성능이 뛰어난 컴퓨터다. 슈퍼 컴퓨터의 성능은 일반적으로 초당 백만 개의 지침(MIPS) 대신 초당 부동 소수점 운영(FLOPS)으로 측정된다. 2017년부터 10개17 이상의 FLOPS(100조 FLOPS, 100페타FLOPS 또는 100 PFLOPS) 이상의 성능을 발휘할 수 있는 슈퍼컴퓨터가 있다.[3]

비교를 위해, 데스크톱 컴퓨터는 수백 기가FLOPS에서 수십 테라FLOPS 범위의 성능을 가지고 있다.[4][5]

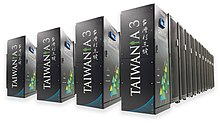

2017년 11월부터 세계에서 가장 빠른 500대 슈퍼컴퓨터는 모두 Linux 기반 운영체제를 운영하고 있다.[6] 미국, 유럽연합, 대만, 일본, 중국에서 더 빠르고, 더 강력하고, 기술적으로 우수한 엑사스케일 슈퍼컴퓨터를 만들기 위한 추가 연구가 진행되고 있다.[7]

슈퍼컴퓨터는 계산과학 분야에서 중요한 역할을 하며 양자역학, 기상예측, 기후연구, 석유 및 가스탐사, 분자 모델링(화학성분들의 구조와 특성, 생물학적 ma) 등 다양한 분야에서 연산적으로 집약적인 광범위한 과제에 사용된다.분자, 중합체, 결정체)와 물리적 시뮬레이션(우주의 초기 순간의 시뮬레이션, 비행기와 우주선 공기역학, 핵무기의 폭발, 핵융합 등). 그들은 암호해석 분야에서 필수적인 존재였다.[8]

슈퍼컴퓨터는 1960년대에 도입되었고 수십 년 동안 가장 빠른 것은 시모어 크레이(Control Data Corporation, CDC), 크레이 리서치(Cray Research), 그리고 그의 이름이나 모노그램이 있는 후속 회사들에 의해 만들어졌다. 첫 번째 그러한 기계는 보다 범용적인 동시대 사람들보다 더 빨리 작동하는 고도로 조정된 재래식 설계였다. 10년 동안, 1~4개의 프로세서가 일반적인 것으로 나타나면서, 병렬 처리의 양이 증가하였다. 1970년대에 대규모 데이터 배열에서 작동하는 벡터 프로세서가 지배하게 되었다. 주목할 만한 예는 1976년의 매우 성공적인 Cray-1이다. 벡터 컴퓨터는 1990년대까지 지배적인 디자인을 유지했다. 그때부터 오늘에 이르기까지 수만 개의 기성 프로세서를 갖춘 대규모 병렬 슈퍼컴퓨터가 표준이 되었다.[9][10]

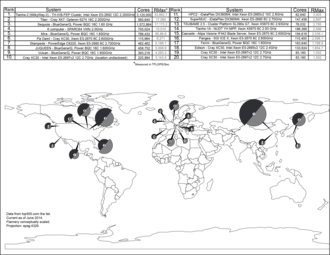

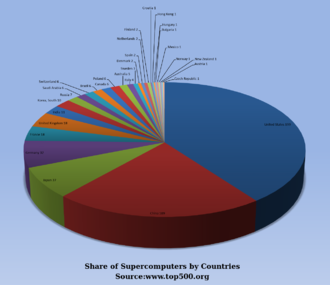

미국은 오랫동안 슈퍼컴퓨터 분야의 선두주자로 있었으며, 처음에는 크레이의 거의 중단 없는 분야 지배를 통해, 나중에는 다양한 기술 기업들을 통해 선두주자로 자리매김했다. 일본은 1980년대와 90년대에 이 분야에서 큰 발전을 이루었고, 중국은 이 분야에서 점점 더 활발해지고 있다. 2020년 6월 현재 TOP500 슈퍼컴퓨터 목록에서 가장 빠른 슈퍼컴퓨터는 일본의 푸가쿠로, LINPACK 벤치마크 점수가 415 PFLOPS이며, 그 다음으로는 서밋이 266.7 PFLOPS이다.[11] 미국은 10위권 중 4개를 가지고 있다; 중국과 이탈리아는 각각 2개를 가지고 있고, 스위스는 1개를 가지고 있다.[11] 2018년 6월, TOP500 목록에 있는 모든 복합 슈퍼컴퓨터가 1 exaFLOPS 기록을 깼다.[12]

역사

1960년 UNIVAC는 오늘날 최초의 슈퍼컴퓨터 중 하나로 여겨지는 리버모어 원자력 연구 컴퓨터(Larc)를 미국 해군 연구 개발 센터를 위해 만들었다. 그것은 새롭게 부상하는 디스크 드라이브 기술보다는 여전히 고속 드럼 메모리를 사용했다.[13] 또한 최초의 슈퍼컴퓨터 중에는 IBM 7030 스트레치가 있었다. IBM 7030은 1955년 어떤 기존 컴퓨터보다 100배 빠른 속도로 컴퓨터를 요청했던 로스 알라모스 국립 연구소를 위해 IBM에 의해 만들어졌다. IBM 7030은 트랜지스터, 자기 코어 메모리, 파이프라인 명령, 메모리 컨트롤러를 통한 프리페치 데이터, 선구적인 랜덤 액세스 디스크 드라이브를 사용했다. IBM 7030은 1961년에 완성되었으며, 100배의 성능 향상의 도전에 부응하지 못하였음에도 불구하고 로스 알라모스 국립 연구소에서 구입하였다. 영국과 프랑스의 고객들도 이 컴퓨터를 구입했고, 그것은 암호 분석을 위해 만들어진 슈퍼 컴퓨터인 IBM 7950 하베스트의 기초가 되었다.[14]

1960년대 초의 세 번째 개척 슈퍼컴퓨터 프로젝트는 톰 킬번 감독이 이끄는 팀이 만든 맨체스터 대학의 아틀라스 프로젝트였다. 그는 아틀라스를 48비트의 100만 단어까지 기억공간을 갖도록 설계했지만, 그런 용량을 가진 자기저장장치가 감당할 수 없었기 때문에 아틀라스의 실제 핵심기억은 1만 6천 단어에 불과했고, 드럼은 9만 6천 단어에 더 많은 메모리를 제공했다. 아틀라스 운영체제는 자기 코어와 드럼 사이에 페이지 형태로 데이터를 교환했다. 아틀라스 운영체제는 슈퍼컴퓨팅에도 시간공유를 도입해 한 번에 둘 이상의 프로그램이 슈퍼컴퓨터에서 실행될 수 있도록 했다.[15] 아틀라스는 페란티와 맨체스터 대학교의 합작회사였으며, 1초에 약 100만 개의 지침이 1마이크로초에 육박하는 처리 속도로 작동하도록 설계되었다.[16]

세이모어 크레이가 설계한 CDC 6600은 1964년에 완성되어 게르마늄에서 실리콘 트랜지스터로 이행하는 것을 알렸다. 실리콘 트랜지스터는 더 빨리 달릴 수 있었고 슈퍼컴퓨터 설계에 냉장고를 도입함으로써 과열 문제를 해결했다.[17] 그래서 CDC6600은 세계에서 가장 빠른 컴퓨터가 되었다. 6600대가 현대의 다른 모든 컴퓨터보다 약 10배 정도 앞섰다는 점에서 슈퍼컴퓨터라 불리며 슈퍼컴퓨터 시장을 규정했는데 이때 100대의 컴퓨터가 각각 800만 달러에 팔렸다.[18][19][20][21]

크레이는 1972년 CDC를 떠나 자신의 회사인 크레이 리서치를 설립했다.[19] CDC를 떠난 지 4년 만인 1976년 크레이는 80MHz 크레용-1을 납품해 역사상 가장 성공한 슈퍼컴퓨터 중 하나가 됐다.[22][23] 크레용-2는 1985년에 출시되었다. 8개의 중앙처리장치(CPU)와 액체냉각, 전자냉각수액인 Fluorinert를 슈퍼컴퓨터 아키텍처를 통해 펌핑했다. 1.9기가플롭스에 도달해 기가플롭 장벽을 깬 최초의 슈퍼컴퓨터가 됐다.[24]

대규모 병렬 설계

1970년대 크레용-1의 연주에 진지하게 도전한 컴퓨터는 일리악 4호뿐이었다. 이 기계는 진정한 대량 병렬 컴퓨터의 첫 번째 실현 사례로, 많은 프로세서가 함께 작동하여 하나의 더 큰 문제의 다른 부분을 해결했다. 이 개념에서 컴퓨터는 데이터의 단일 스트림을 가능한 한 빨리 실행하도록 설계된 벡터 시스템과 대조적으로, 대신 데이터의 개별 부분을 완전히 다른 프로세서에 공급한 다음 결과를 다시 조합한다. 일리악의 디자인은 1966년 256개의 프로세서로 최종 결정되었으며 1970년대 크레용-1의 최고봉인 250 MFLOPS에 비해 최대 1 GFLOPS의 속도를 제공한다. 그러나 개발 문제로 인해 64개의 프로세서만이 구축되었고, 시스템은 크레이보다 훨씬 크고 복잡하면서도 약 200개의 MFLOPS보다 더 빨리 작동할 수 없었다. 또 다른 문제는 시스템용 소프트웨어 쓰기가 어려웠고, 그것으로부터 최고 성능을 얻는 것은 심각한 노력의 문제라는 것이었다.

그러나 일리악 4세의 부분적인 성공은 슈퍼컴퓨팅의 미래를 가리키는 것으로 널리 보여졌다. 크레이는 이에 반대하여, 유명한 조용함을 가지고, "만약 당신이 밭을 갈고 있다면, 어느 것을 사용하는 것이 좋겠는가? 튼튼한 황소 두 마리나 닭 1024마리?"[25] 그러나 1980년대 초까지 여러 팀이 수천 개의 프로세서와 병렬 설계 작업을 하고 있었는데, 특히 MIT에서 연구를 통해 개발된 커넥션 머신(CM)이 그것이다. CM-1은 데이터를 공유하기 위해 네트워크에 연결된 65,536개의 단순화된 사용자 지정 마이크로프로세서를 사용했다. 몇 가지 업데이트된 버전이 뒤따랐다; CM-5 슈퍼 컴퓨터는 초당 수십억 번의 산술 연산이 가능한 대규모 병렬 처리 컴퓨터다.[26]

1982년 오사카 대학의 LINKS-1 컴퓨터 그래픽스 시스템은 257 자일로그 Z8001 제어 프로세서와 257 iAPX 86/20 플로팅 포인트 프로세서를 포함하여 514개의 마이크로프로세서를 가진 대규모 병렬 프로세싱 아키텍처를 사용하였다. 그것은 사실적인 3D 컴퓨터 그래픽을 렌더링하는데 주로 사용되었다.[27] 후지쯔의 1992년형 VPP500은 속도가 더 빠르기 위해 자사의 프로세서가 독성 때문에 보통 마이크로파 어플리케이션용으로 예약된 재료인 GaAs를 사용했기 때문에 이례적이다.[28] 후지쯔의 수치풍동 슈퍼컴퓨터는 벡터 프로세서 166개를 사용해 프로세서당 최고속도가 1.7기가FLOPS(GFLOPS)로 1994년 1위를 차지했다.[29][30] 히타치 SR2201은 고속 3차원 크로스바 네트워크를 통해 연결된 2048개의 프로세서를 사용해 1996년 600 GFLOPS의 최고 성능을 얻었다.[31][32][33] 인텔 파라곤은 1000~4000개의 인텔 i860 프로세서를 다양한 구성으로 보유할 수 있으며 1993년 세계에서 가장 빠른 속도로 순위를 매겼다. 파라곤은 고속 2차원 메시를 통해 프로세서를 연결한 MIMD 기계로, 별도의 노드에서 프로세스가 실행되도록 하고, 메시지 전달 인터페이스를 통해 통신한다.[34]

소프트웨어 개발은 여전히 문제였지만, CM 시리즈는 이 문제에 대한 상당한 연구를 촉발시켰다. 에반스앤서덜랜드 ES-1, 매스파, nCube, 인텔 iPSC, Goodyear MPP 등 많은 기업에서 주문형 하드웨어를 사용한 유사한 설계가 이루어졌으나 1990년대 중반까지 슈퍼컴퓨터를 커스텀 칩을 사용하는 대신 개별 처리 단위로 제작할 수 있을 정도로 범용 CPU 성능이 크게 향상되었다. 21세기 경에는 수만 개의 일반 CPU를 특징으로 하는 디자인이 일반화되었고, 이후 기계들이 혼합물에 그래픽 단위를 추가하였다.[9][10]

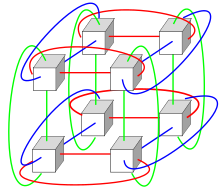

프로세서가 많은 시스템은 일반적으로 두 가지 경로 중 하나를 취한다. 그리드 컴퓨팅 접근방식에서, 분산되고 다양한 관리 영역으로 조직된 많은 컴퓨터의 처리 능력은 컴퓨터가 이용 가능할 때마다 기회적으로 사용된다.[35] 또 다른 접근법에서는 많은 프로세서가 컴퓨터 클러스터와 같이 서로 근접하게 사용된다. 이와 같이 중앙 집중화된 대규모 병렬 시스템에서 인터커넥트의 속도와 유연성이 매우 중요해지고 현대 슈퍼컴퓨터는 향상된 인피니반드 시스템부터 3차원 토러스 인터커넥트에 이르는 다양한 접근방식을 사용해 왔다.[36][37] 중앙집중화와 결합된 멀티코어 프로세서의 사용은 예를 들어 사이클롭스64 시스템에서와 같은 신흥 방향이다.[38][39]

범용 그래픽처리장치(GPGPU)의 가격과 성능, 에너지 효율이 개선되면서 톈허-I, 네불래 등 펫아플롭스 슈퍼컴퓨터가 대거 의존하기 시작했다.[40] 그러나 K 컴퓨터와 같은 다른 시스템은 SPARC 기반 설계와 같은 기존 프로세서를 계속 사용하고 있으며 범용 고성능 컴퓨팅 애플리케이션에서 GPGPU의 전체적인 적용성은 논쟁의 대상이 되어 왔으며, 반면에 GPGPU는 특정 벤치마크에서 점수를 잘 받도록 조정될 수 있고 ev에 대한 전체적인 적용성은 논쟁의 대상이 되었다.응용 프로그램을 조정하기 위해 상당한 노력을 기울이지 않는 한 알고리즘이 제한될 수 있다.[41] 하지만 GPU가 강세를 보이고 있고, 2012년 재규어 슈퍼컴퓨터가 CPU를 GPU로 개조해 타이탄으로 탈바꿈했다.[42][43][44]

고성능 컴퓨터는 업그레이드가 필요하기 전까지 약 3년의 기대 수명 주기를 가진다.[45] Gyoukou 슈퍼컴퓨터는 대규모 병렬 설계와 액체몰입 냉각을 모두 사용한다는 점에서 독특하다.

특수 용도 슈퍼컴퓨터

다수의 특수 목적 시스템이 설계되었으며, 단일 문제에만 전념하고 있다. 이를 통해 특별히 프로그램된 FPGA 칩이나 맞춤형 ASIC를 사용할 수 있어 일반성을 희생시켜 가격 대비 성능 비율을 높일 수 있다. 특수 목적 슈퍼컴퓨터의 예로는 체스 플레이를 위한 벨,[46] 딥 블루,[47] 히드라[48], 천체물리학을 위한 그라비티 파이프,[49] 단백질 구조 예측과 분자 역학을 위한 MDGAPER-3,[50] DES 암호 해독을 위한 딥 크랙 등이 있다.[51]

에너지 사용 및 열 관리

수십 년 동안 열 밀도 관리는 대부분의 중앙집중식 슈퍼컴퓨터의 핵심 이슈로 남아 있었다.[54][55][56] 시스템에 의해 생성되는 많은 양의 열은 다른 시스템 구성 요소의 수명을 줄이는 것과 같은 다른 영향을 미칠 수 있다.[57] 시스템을 통해 Fluorinert 펌핑에서부터 하이브리드 액체-공기 냉각 시스템 또는 정상적인 에어컨 온도의 공기 냉각에 이르기까지 열 관리에 대한 다양한 접근 방식이 있어 왔다.[58][59] 일반적인 슈퍼컴퓨터는 대량의 전력을 소비하는데, 거의 모든 전력을 열로 변환하여 냉각이 필요하다. 예를 들어 톈허-1A는 4.04메가와트(MW)의 전기를 소비한다.[60] 시스템에 전력을 공급하고 냉각하는 데 드는 비용은 상당할 수 있다. 예를 들어, 0.10/kWh의 4MW는 시간당 400달러 또는 연간 약 350만 달러가 된다.

열 관리는 복잡한 전자장치에서 주요 이슈로, 강력한 컴퓨터 시스템에 다양한 방식으로 영향을 미친다.[61] 슈퍼컴퓨팅의 열설계 전력과 CPU 전력 소산 문제는 기존의 컴퓨터 냉각 기술을 능가한다. 그린 컴퓨팅에 대한 슈퍼컴퓨팅 상은 이 문제를 반영한다.[62][63][64]

수천 개의 프로세서를 함께 포장하는 것은 불가피하게 처리해야 할 상당한 양의 열 밀도를 발생시킨다. 크레용-2는 액체로 냉각되었고, 압력을 받아 모듈을 통해 강제로 통과된 플루오르트의 "냉각 폭포"를 사용했다.[58] 그러나 물속에 잠긴 액체 냉각 접근법은 기성품 프로세서에 기초한 멀티캐비넷 시스템에는 실용적이지 않았으며, 시스템 X에서는 리버트 회사와 연계하여 에어컨과 액체 냉각을 결합한 특수 냉각 시스템이 개발되었다.[59]

Blue Gene 시스템에서 IBM은 열 밀도를 처리하기 위해 의도적으로 저전력 프로세서를 사용했다.[65] 2011년에 출시된 IBM Power 775는 수냉이 필요한 요소들을 촘촘히 포장해 놓았다.[66] IBM 아쿠아사르 시스템은 에너지 효율을 달성하기 위해 온수 냉각을 사용하며, 이 물은 건물 난방에도 사용된다.[67][68]

컴퓨터 시스템의 에너지 효율은 일반적으로 "와트당 FLOPS"로 측정된다. In 2008, Roadrunner by IBM operated at 3.76 MFLOPS/W.[69][70] In November 2010, the Blue Gene/Q reached 1,684 MFLOPS/W[71][72] and in June 2011 the top two spots on the Green 500 list were occupied by Blue Gene machines in New York (one achieving 2097 MFLOPS/W) with the DEGIMA cluster in Nagasaki placing third with 1375 MFLOPS/W.[73]

구리선은 강제 공기나 순환 냉매보다 전력 밀도가 훨씬 높은 슈퍼컴퓨터에 에너지를 전달해 폐열을 제거할 수 있기 때문에 냉각 시스템의 폐열 제거 능력은 제한 요인이다.[74][75][76] 2015년[update] 현재 많은 기존 슈퍼컴퓨터는 기계의 실제 피크 수요보다 인프라 용량이 더 많다. 설계자는 일반적으로 슈퍼컴퓨터가 소비하는 이론적 피크 전력 이상을 처리하기 위해 전력 및 냉각 인프라를 보수적으로 설계한다. 미래의 슈퍼컴퓨터를 위한 설계는 전력 제한이 있다. 즉 슈퍼컴퓨터 전체의 열설계 전력, 전력과 냉각 인프라가 처리할 수 있는 양은 예상 정상 전력 소비량보다 다소 많으나 전자 하드웨어의 이론적 최대 전력 소비량에는 미치지 못한다.[77]

소프트웨어 및 시스템 관리

운영 체제

20세기 말부터 슈퍼컴퓨터 운영체제는 슈퍼컴퓨터 아키텍처의 변화를 바탕으로 대대적인 변혁을 거쳤다.[78] 초기 운영체제는 속도를 내기 위해 각 슈퍼컴퓨터마다 맞춤형으로 제작됐지만, 사내 운영체제에서 리눅스 등 일반 소프트웨어 적응으로 옮겨가는 추세다.[79]

현대의 대량 병렬 슈퍼컴퓨터는 일반적으로 여러 종류의 노드를 사용하여 다른 서비스에서 연산을 분리하기 때문에, 예를 들어 컴퓨팅 노드에서 CNK나 CNL과 같은 작고 효율적인 경량 커널을 사용하는 등, 다른 노드에서 다른 운영 체제를 실행하지만 서버나 I/에서는 Linux-파생제와 같은 더 큰 시스템을 사용한다.O 노드.[80][81][82]

기존의 다중 사용자 컴퓨터 시스템에서는 업무 스케줄링이 사실상 처리와 주변 자원에 대한 업무 처리 문제인 반면, 대규모 병렬 시스템에서는 업무 관리 시스템이 컴퓨팅과 통신 자원의 할당을 모두 관리할 필요가 있으며, 수십 개의 하드웨어가 고장 날 때 불가피하게 발생하는 문제를 우아하게 처리할 필요가 있다. 수천 개의 프로세서가 존재한다.[83]

비록 대부분의 현대 슈퍼컴퓨터가 Linux 기반의 운영체제를 사용하지만, 각 제조업체는 고유의 특정한 Linux-파생성을 가지고 있으며, 산업 표준은 존재하지 않는데, 부분적으로는 하드웨어 아키텍처의 차이가 각 하드웨어 설계에 운영체제를 최적화하기 위해 변경을 필요로 한다는 사실에 기인한다.[78][84]

소프트웨어 도구 및 메시지 전달

슈퍼컴퓨터의 병렬 아키텍처들은 종종 그들의 속도를 이용하기 위해 특별한 프로그래밍 기법의 사용을 지시한다. 분산 처리를 위한 소프트웨어 툴로는 MPI, PVM 등 표준 API, VTL, 베어울프 등 오픈소스 소프트웨어 등이 있다.

가장 일반적인 시나리오에서는 느슨하게 연결된 클러스터의 경우 PVM, MPI, 긴밀하게 조정된 공유 메모리 머신의 경우 OpenMP와 같은 환경이 사용된다. 실행될 시스템의 상호 연결 특성에 대한 알고리즘을 최적화하기 위해 상당한 노력이 필요하다. 목표는 CPU가 다른 노드의 데이터를 기다리는 데 시간을 낭비하지 않도록 하는 것이다. GPGPU에는 수백 개의 프로세서 코어가 있으며, CUDA나 OpenCL과 같은 프로그래밍 모델을 사용하여 프로그래밍된다.

게다가 병렬 프로그램을 디버그하고 테스트하는 것은 상당히 어렵다. 그러한 응용 프로그램을 테스트하고 디버깅하기 위해 특수 기법을 사용할 필요가 있다.

분산형 슈퍼컴퓨팅

기회주의적 접근법

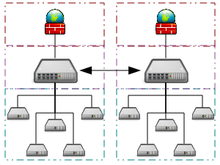

기회주의적인 슈퍼컴퓨팅은 네트워크화된 그리드 컴퓨팅의 한 형태로 느슨하게 연결된 많은 자원봉사자 컴퓨팅 머신의 "슈퍼 가상 컴퓨터"가 매우 큰 컴퓨팅 작업을 수행하는 것이다. 그리드 컴퓨팅은 슈퍼컴퓨팅 성능 저울을 필요로 하는 많은 대규모 병렬 문제들에 적용되어 왔다. 그러나 자원봉사 컴퓨팅에 의존하는 기본 그리드 및 클라우드 컴퓨팅 접근방식은 유동 동적 시뮬레이션과 같은 전통적인 슈퍼컴퓨팅 작업을 처리할 수 없다.[86]

가장 빠른 그리드 컴퓨팅 시스템은 분산 컴퓨팅 프로젝트 폴딩@home(F@h)이다. F[update]@h는 2020년 4월 현재 x86 처리 능력의 2.5 exaFLOPS를 보고하였다. 이 중 100개가 넘는 PFLOPS는 다양한 GPU에서 실행되는 클라이언트에 의해, 나머지는 다양한 CPU 시스템의 클라이언트에 의해 기여된다.[87]

BOINC(Berkeley Open Infrastructure for Network Computing) 플랫폼은 많은 분산 컴퓨팅 프로젝트를 진행한다. BOINC는 2017년[update] 2월 현재 네트워크상에서 76만2,000대 이상의 액티브 컴퓨터(호스트)를 통해 166페타FLOPS 이상의 처리 능력을 기록했다.[88]

2016년[update] 10월 현재, 그레이트 인터넷 메르센 프라임 서치(GIMPS)의 보급형 메르센 프라임 서치(Great Internet Mersenne Prime Search)는 130만 대 이상의 컴퓨터를 통해 약 0.313 PFLOPS를 달성했다.[89] 인터넷 프라임넷 서버는 1997년 이후 가장 초기적이고[citation needed] 가장 성공적인 그리드 컴퓨팅 프로젝트 중 하나인 KIMPS의 그리드 컴퓨팅 접근방식을 지원한다.

준기회적 접근법

준기회성 슈퍼컴퓨팅은 지리적으로 네트워크로 연결된 많은 컴퓨터의 "슈퍼 가상 컴퓨터"가 거대한 처리 능력을 요구하는 컴퓨팅 작업을 수행하는 분산 컴퓨팅의 한 형태다.[90] 준기회성 슈퍼컴퓨팅은 분산된 자원에 대한 업무 할당과 슈퍼컴퓨팅 네트워크 내에서 개별 시스템의 가용성과 신뢰성에 대한 인텔리전스 활용을 더 많이 제어함으로써 기회주의적 그리드 컴퓨팅보다 더 높은 서비스 품질을 제공하는 것을 목표로 한다. 그러나 그리드 내 요구 병렬 컴퓨팅 소프트웨어의 준기회적 분산 실행은 그리드-현상 할당 협정, 공동 할당 하위 시스템, 통신 위상 인식 할당 메커니즘, 내결함성 메시지 라이브러리 통과 및 데이터 사전 조정의 구현을 통해 달성되어야 한다.[90]

고성능 컴퓨팅 클라우드

클라우드 컴퓨팅은 최근 몇 년간 HPC(고성능 컴퓨팅) 사용자 및 개발자의 관심을 끌었다. 클라우드 컴퓨팅은 서비스로서의 소프트웨어, 서비스로서의 플랫폼, 서비스로서의 인프라(IaaS) 등 클라우드에서 이용 가능한 다른 형태의 서비스와 똑같이 HPC를 서비스로서의 형태로 제공하려고 시도한다. HPC 사용자는 확장성, 온디맨드 리소스, 속도 및 저렴한 리소스와 같은 다양한 각도에서 클라우드의 이점을 누릴 수 있다. 반면에, HPC 애플리케이션 이동에도 일련의 어려움이 있다. 이러한 과제의 좋은 예로는 클라우드의 가상화 오버헤드, 리소스의 멀티 테넌시(Multi-tenancy) 및 네트워크 지연 시간 문제가 있다. 이러한 과제를 극복하고 클라우드의 HPC를 보다 현실적인 가능성으로 만들기 위해 현재 많은 연구가 이루어지고 있다.[91][92][93][94]

2016년 펭귄 컴퓨팅, R-HPC, 아마존 웹 서비스, 유니바, 실리콘 그래픽스 인터내셔널, 레스케일, 사발코어, 곰퍼트 등이 HPC 클라우드 컴퓨팅을 제공하기 시작했다. Penguin On Demand(POD) 클라우드는 코드를 실행하는 베어메탈 컴퓨팅 모델이지만 각 사용자에게 가상화된 로그인 노드가 제공된다. POD 컴퓨팅 노드는 가상화되지 않은 10 Gbit/s 이더넷 또는 QDR InfiniBand 네트워크를 통해 연결된다. POD 데이터 센터에 대한 사용자 연결 범위는 50 Mbit/s ~ 1 Gbit/s이다.[95] Penguin Computing은 아마존의 EC2 Elastic Compute Cloud를 인용해 컴퓨팅 노드 가상화가 HPC에 적합하지 않다고 주장한다. Penguin Computing은 또한 HPC 클라우드가 멀리 떨어져 있는 고객에게 컴퓨팅 노드를 할당하여 일부 HPC 애플리케이션의 성능을 저해하는 지연 시간을 유발했을 수 있다고 비판해왔다.[96]

성능측정

기능 대 용량

슈퍼컴퓨터는 일반적으로 용량 컴퓨팅보다는 용량 컴퓨팅의 최대화를 목표로 한다. 역량 컴퓨팅은 일반적으로 최대 컴퓨팅 능력을 사용하여 하나의 큰 문제를 가장 짧은 시간에 해결하는 것으로 간주된다. 흔히 기능 시스템은 다른 컴퓨터가 할 수 없는 크기나 복잡성의 문제를 해결할 수 있다(예: 매우 복잡한 날씨 시뮬레이션 애플리케이션).[97]

이와는 대조적으로, 용량 컴퓨팅은 일반적으로 효율적 비용 효율적인 컴퓨팅 능력을 사용하여 몇 가지 다소 큰 문제 또는 많은 작은 문제를 해결하는 것으로 생각된다.[97] 일상적인 일상 업무를 위해 많은 사용자들을 지원하는 데 자신을 빌려주는 아키텍처들은 많은 용량을 가질 수 있지만, 단 하나의 매우 복잡한 문제를 해결하지 못한다는 점에서, 일반적으로 슈퍼컴퓨터로 여겨지지 않는다.[97]

성능 메트릭

일반적으로 슈퍼컴퓨터의 속도는 범용 컴퓨터의 경우와 마찬가지로 MIPS(초당 백만 개의 명령어)가 아닌 FLOPS(초당 플로팅 포인트 운영)로 측정하고 벤치마킹한다.[98] 이러한 측정은 일반적으로 Tera-와 같은 SI 접두사와 함께 속기 TFLOPS(1012 FLOPS, 발음 Teraflops) 또는 peta-와 결합하여 속기 PFLOPS(1015 FLOPS, 발음 Petaflops)와 함께 사용된다. 페타스케일 슈퍼컴퓨터는 1,000조 플로프를15 처리할 수 있다. Exascale은 ExaFLOPS(EFLOPS) 범위의 컴퓨팅 성능을 제공한다. EFLOPS는 1조 (1018) FLOPS (100만 TFLOPS)이다.

어떤 숫자도 컴퓨터 시스템의 전반적인 성능을 반영할 수 없지만, Linpack 벤치마크의 목표는 컴퓨터가 수치 문제를 얼마나 빨리 해결하는지 근사하게 하는 것이며 그것은 업계에서 널리 사용되고 있다.[99] FLOPS 측정은 실제 워크로드를 실행할 때 일반적으로 달성할 수 없는 프로세서의 이론적 부동소수점 성능(제조업체의 프로세서 사양에서 파생되어 TOP500 목록에 "Rpeak"로 표시됨) 또는 LINPACK 벤치마크에서 파생되어 "Rmax"로 표시되는 달성 가능한 처리량에 기초하여 인용된다. TOP500 목록에서.[100] LINPACK 벤치마크는 일반적으로 큰 행렬의 LU 분해를 수행한다.[101] LINPACK 성능은 일부 실제 문제에 대한 성능 지표를 제공하지만, 예를 들어 더 많은 메모리 대역폭을 요구하거나 더 나은 정수 컴퓨팅 성능을 요구하거나 h를 달성하기 위해 고성능 I/O 시스템이 필요할 수 있는 다른 많은 슈퍼컴퓨터 워크로드의 처리 요구 사항과 반드시 일치하는 것은 아니다.Igh [99]수준의 성능

TOP500 목록

1993년 이후 가장 빠른 슈퍼컴퓨터는 LINPACK 벤치마크 결과에 따라 TOP500 순위에 올랐다. 이 목록은 편견이 없거나 확정적이라고 주장하지는 않지만, 그것은 어느 특정 시간에 이용 가능한 "가장 빠른" 슈퍼 컴퓨터에 대한 현재의 정의로 널리 인용되고 있다.

이것은 TOP500 목록의 맨 위에 등장한 최근의 컴퓨터 목록이며,[102] "피크 속도"는 "Rmax" 등급으로 주어진다. 레노버는 2018년 117대가 생산돼 세계 최대 규모의 TOP500 슈퍼컴퓨터 공급업체가 됐다.[103]

| 연도 | 슈퍼컴퓨터 | Rmax (TFLOP/s) | 위치 |

|---|---|---|---|

| 2020 | 후지쓰 푸가쿠 | 442,010.0 | 일본 고베 시 |

| 2018 | IBM 서밋 | 148,600.0 | 미국 오크리지 |

| 2018 | IBM/Nvidia/Mellanox Sierra | 94,640.0 | 리버모어, 미국 |

| 2016 | 선웨이 타이후라이트 | 93,014.6 | 중국 우시 시 |

| 2013 | NUDT 톈허-2 | 61,444.5 | 중국 광저우 |

| 2019 | 델 프론테라 | 23,516.4 | 미국 오스틴 |

| 2012 | 크레용/HPE 피자 데인트 | 21,230.0 | 스위스 루가노 |

| 2015 | 크레용/HPE 트리니티 | 20,158.7 | 미국 뉴멕시코 주 |

| 2018 | 후지쓰 ABCI | 19,880.0 | 일본 도쿄 |

| 2018 | 레노보 슈퍼MUC-NG | 19,476.6 | 독일 가칭 |

적용들

슈퍼컴퓨터 적용 단계는 다음 표에 요약할 수 있다.

| 디케이드 | 사용 및 컴퓨터 관련 |

|---|---|

| 1970년대 | 기상 예보, 공기역학 연구([104]Cray-1) |

| 1980년대 | 확률론적 분석,[105] 방사선 차폐 모델링[106](CDC Cyber). |

| 1990년대 | Brute force code breaking(EFF DES 크래커)[107] |

| 2000년대 | 합법적인 핵확산금지조약(ASCI Q)[108]을 대체하는 3D 핵실험 시뮬레이션. |

| 2010년대 | 분자역학 시뮬레이션(Tianhe-1A)[109] |

| 2020년대 | 발생방지를 위한 과학연구/전기화학반응연구[110] |

IBM Blue Gene/P 컴퓨터는 인간 대뇌피질의 약 1%에 해당하는 인공 뉴런을 시뮬레이션하는데 사용되어 왔으며, 약 9조개의 연결을 가진 16억 개의 뉴런을 포함하고 있다. 같은 연구그룹도 슈퍼컴퓨터를 이용해 쥐의 뇌전체에 해당하는 인공 뉴런을 다수 시뮬레이션하는 데 성공했다.[111]

현대의 일기예보 또한 슈퍼컴퓨터에 의존한다. 국립해양대기청은 기상 예보를 더 정확하게 하기 위해 수억 개의 관측치를 어루만지기 위해 슈퍼컴퓨터를 사용한다.[112]

2011년, 슈퍼컴퓨팅에서 한계를 극복하기 위한 도전과 어려움은 IBM이 블루워터 페타스케일 프로젝트를 포기함으로써 강조되었다.[113]

첨단 시뮬레이션 및 컴퓨팅 프로그램은 현재 미국의 핵 비축량을 유지하고 시뮬레이션하기 위해 슈퍼컴퓨터를 사용하고 있다.[114]

2020년 초, COVID-19는 세계의 최전방이자 중심이었다. 슈퍼컴퓨터는 확산을 잠재적으로 막을 수 있는 화합물을 찾기 위해 다양한 시뮬레이션을 사용했다. 이들 컴퓨터는 병렬로 연결된 여러 개의 CPU를 사용하여 다른 프로세스를 모델링하는 데 수십 시간 동안 실행된다.[115][116][117]

개발 및 동향

2010년대에는 중국, 미국, 유럽연합(EU) 등이 가장 먼저 경쟁해 1 exaFLOP(10조18 또는 1조 FLOPS) 슈퍼컴퓨터를 만들었다.[118] 에릭 P. 샌디아 국립 연구소의 드베네딕티스 박사는 2주간의 기간을 정확히 커버할 수 있는 완전한 날씨 모델링을 수행하기 위해서는 제타플롭스(10조21 또는 1조 6천억 FLOPS) 컴퓨터가 필요하다고 이론화했다.[119][120][121] 그러한 시스템은 2030년경에 건설될 수 있다.[122]

많은 몬테카를로 시뮬레이션은 무작위로 생성된 데이터 세트를 처리하기 위해 동일한 알고리즘을 사용한다. 특히, 물리적 전송 프로세스, 무작위 경로, 충돌 및 중성자, 광자, 이온, 전자 등의 에너지와 운동량 축적을 기술하는 정수 차등 방정식을 사용한다. 마이크로프로세서를 위한 다음 단계는 세 번째 차원일 수 있다; 그리고 몬테카를로에게 특화된, 많은 층들이 동일할 수 있고, 설계와 제조 과정을 단순화할 수 있다.[123]

고성능 슈퍼컴퓨터 운영비가 오른 것은 주로 전력소비량 증가에 따른 것이다. 1990년대 중반 100킬로와트 범위에서 상위 10대의 슈퍼컴퓨터가 필요했고, 2010년에는 상위 10대의 슈퍼컴퓨터가 1에서 2메가와트 사이에서 필요했다.[124] DARPA가 의뢰한 2010년 연구는 전력 소비량이 Exascale 컴퓨팅을 달성하는 데 있어 가장 보편적인 과제라고 밝혔다.[125] 당시 연간 에너지 소비로 인한 메가와트 가격은 약 100만 달러였다. 슈퍼컴퓨팅 설비는 현대의 멀티코어 중앙처리장치에 의해 증가하는 열량을 효율적으로 제거하기 위해 건설되었다. 2007~2011년 그린 500 슈퍼컴퓨터 목록의 에너지 소비량을 기준으로 했을 때 2011년 1대의 exaFLOPS를 가진 슈퍼컴퓨터는 500메가와트에 가까운 전력 소비량이 필요했을 것이다. 운영체제는 가능한 한 에너지를 절약하기 위해 기존 하드웨어를 위해 개발되었다.[126] 병렬 처리된 애플리케이션을 실행하는 동안 사용하지 않는 CPU 코어는 저전력 상태로 전환되어 일부 슈퍼컴퓨팅 애플리케이션의 에너지 절약 효과를 가져왔다.[127]

슈퍼컴퓨터 운영비용의 증가는 분산형 슈퍼컴퓨터 인프라를 통한 자원 번들화의 추세에 원동력이 되고 있다. 국가 슈퍼컴퓨팅 센터가 미국에 처음 등장했고, 독일과 일본이 그 뒤를 이었다. 유럽연합(EU)은 슈퍼컴퓨팅 애플리케이션 포팅, 확장 및 최적화에 있어 유럽연합 전체의 과학자를 지원하는 서비스를 통해 지속적인 범유럽 슈퍼컴퓨터 인프라를 구축하기 위한 목적으로 유럽 선진 컴퓨팅 파트너십(PRACE)을 출범시켰다.[124] 아이슬란드는 세계 최초의 무배출 슈퍼컴퓨터를 만들었다. 아이슬란드 레이캬비크의 토르 데이터 센터에 위치한 이 슈퍼컴퓨터는 화석 연료보다는 전력 공급을 위해 완전히 재생 가능한 에너지에 의존한다. 더 추운 기후는 또한 능동 냉각의 필요성을 줄여, 컴퓨터 세계에서 가장 친환경적인 시설 중 하나가 된다.[128]

슈퍼컴퓨터 하드웨어에 자금을 대는 것도 점점 어려워졌다. 1990년대 중반 10대 슈퍼컴퓨터의 가격은 약 1000만 유로인 반면 2010년 10대 슈퍼컴퓨터의 경우 4000만~5,000만 유로의 투자가 필요했다.[124] 2000년대에 국가 정부들은 슈퍼컴퓨터를 후원하기 위해 서로 다른 전략을 세웠다. 영국에서는 국가 정부가 슈퍼컴퓨터를 전적으로 지원했고 고성능 컴퓨팅은 국가 기금 기구의 통제 하에 놓였다. 독일은 지역 주 자금과 연방 자금을 통합하여 혼합 자금 지원 모델을 개발했다.[124]

소설로

많은 공상과학소설 작가들은 슈퍼컴퓨터를 그들의 작품에서 묘사해왔다. 그러한 컴퓨터의 역사적 구축 이전과 이후 모두 말이다. 그러한 소설의 많은 부분은 그들이 만든 컴퓨터와 인간 사이의 관계를 다루고 있고 결국 그들 사이에 갈등이 발생할 가능성을 다룬다. 소설 속의 슈퍼컴퓨터의 예로는 HAL-9000, 멀티백, 더 머신 스톱, GLaDOS, 피할 수 없는 갈등, 벌컨의 해머, 콜로서스, WOPR, 딥씽크가 있다.

참고 항목

| 위키미디어 커먼즈에는 슈퍼컴퓨터와 관련된 미디어가 있다. |

참고 및 참조

- ^ "IBM Blue gene announcement". 03.ibm.com. 26 June 2007. Retrieved 9 June 2012.

- ^ "Intrepid". Argonne Leadership Computing Facility. Argonne National Laboratory. Archived from the original on 7 May 2013. Retrieved 26 March 2020.

- ^ "The List: June 2018". Top 500. Retrieved 25 June 2018.

- ^ "AMD Playstation 5 GPU Specs". TechPowerUp. Retrieved 11 September 2021.

- ^ "NVIDIA GeForce GT 730 Specs". TechPowerUp. Retrieved 11 September 2021.

- ^ "Operating system Family / Linux". TOP500.org. Retrieved 30 November 2017.

- ^ 앤더슨, 마크(2017년 6월 21일). "Exascale을 향한 글로벌 경쟁은 슈퍼컴퓨팅, AI를 대규모로 몰고 갈 것이다." 스펙트럼.IEEE.org. 2019년 1월 20일 회수.

- ^ Lemke, Tim (8 May 2013). "NSA Breaks Ground on Massive Computing Center". Retrieved 11 December 2013.

- ^ a b Hoffman, Allan R.; et al. (1990). Supercomputers: directions in technology and applications. National Academies. pp. 35–47. ISBN 978-0-309-04088-4.

- ^ a b Hill, Mark Donald; Jouppi, Norman Paul; Sohi, Gurindar (1999). Readings in computer architecture. pp. 40–49. ISBN 978-1-55860-539-8.

- ^ a b "Japan Captures TOP500 Crown with Arm-Powered Supercomputer - TOP500 website". www.top500.org.

- ^ "Performance Development - TOP500 Supercomputer Sites". www.top500.org.

- ^ Eric G. Swedin; David L. Ferro (2007). Computers: The Life Story of a Technology. JHU Press. p. 57. ISBN 9780801887741.

- ^ Eric G. Swedin; David L. Ferro (2007). Computers: The Life Story of a Technology. JHU Press. p. 56. ISBN 9780801887741.

- ^ Eric G. Swedin; David L. Ferro (2007). Computers: The Life Story of a Technology. JHU Press. p. 58. ISBN 9780801887741.

- ^ The Atlas, University of Manchester, archived from the original on 28 July 2012, retrieved 21 September 2010

- ^ 슈퍼맨, 찰스 머레이, 와일리 & 선즈, 1997.

- ^ Paul E. Ceruzzi (2003). A History of Modern Computing. MIT Press. p. 161. ISBN 978-0-262-53203-7.

- ^ a b Hannan, Caryn (2008). Wisconsin Biographical Dictionary. State History Publications. pp. 83–84. ISBN 978-1-878592-63-7.

- ^ John Impagliazzo; John A. N. Lee (2004). History of computing in education. Springer Science & Business Media. p. 172. ISBN 978-1-4020-8135-4.

- ^ Andrew R. L. Cayton; Richard Sisson; Chris Zacher (2006). The American Midwest: An Interpretive Encyclopedia. Indiana University Press. p. 1489. ISBN 978-0-253-00349-2.

- ^ Mark Donald Hill, Norman Paul Jouppi, Gurindar Sohi 1999 ISBN 978-1-55860-539-8 페이지 41-48

- ^ 에드윈 D의 컴퓨터 과학과 정보 기술에서의 이정표. 2003 ISBN 1-57356-521-0 페이지 65

- ^ 소련의 선전 때문에 소련 슈퍼컴퓨터 M13이 기가플롭스 장벽에 가장 먼저 도달했다는 사실을 가끔 읽을 수 있다. 사실 M13 건물은 1984년에 시작되었지만 1986년 이전에는 가동되지 않았다. 로가체프 유리 바실리예비치, 러시아 가상 컴퓨터 박물관

- ^ "Seymour Cray Quotes". BrainyQuote.

- ^ Steve Nelson (3 October 2014). "ComputerGK.com : Supercomputers".

- ^ "LINKS-1 Computer Graphics System-Computer Museum". museum.ipsj.or.jp.

- ^ "VPP500 (1992) - Fujitsu Global".

- ^ "TOP500 Annual Report 1994". Netlib.org. 1 October 1996. Retrieved 9 June 2012.

- ^ N. Hirose & M. Fukuda (1997). Numerical Wind Tunnel (NWT) and CFD Research at National Aerospace Laboratory. Proceedings of HPC-Asia '97. IEEE Computer SocietyPages. doi:10.1109/HPC.1997.592130.

- ^ H. 후지이, Y. 야스다, H. 아카시, Y. 이나가미, M. 고가, O. 이시하라, M. 시즈완, H. 와다, T. 스미모토, 히타치 SR2201 대량 병렬 프로세서 시스템, 제11회 국제 병렬 처리 심포지엄, 1997년 4월 233–241페이지.

- ^ Y. 이와사키, CP-PACS 프로젝트, 핵물리학 B: 절차보충제, 제60권, 이슈 1-2, 1998년 1월 246~254페이지.

- ^ A.J. van der Steen, 최신 슈퍼컴퓨터 개요, NCF 출판, Stichting Nationale Computer Facilitenten, 네덜란드, 1997년 1월.

- ^ 확장 가능한 입출력: Daniel A에 의해 시스템 밸런스 달성 Reed 2003 ISBN 978-0-262-68142-1페이지 182

- ^ Prodan, Radu; Fahringer, Thomas (2007). Grid computing: experiment management, tool integration, and scientific workflows. pp. 1–4. ISBN 978-3-540-69261-4.

- ^ 나이트, 윌: "IBM은 세계에서 가장 강력한 컴퓨터를 만든다," NewScientist.com 뉴스 서비스, 2007년 6월

- ^ N. R. Agida; et al. (2005). "Blue Gene/L Torus Interconnection Network IBM Journal of Research and Development" (PDF). Torus Interconnection Network. p. 265. Archived from the original (PDF) on 15 August 2011.

- ^ Niu, Yanwei; Hu, Ziang; Barner, Kenneth; Gao, Guang R. (2005). "Performance Modelling and Optimization of Memory Access on Cellular Computer Architecture Cyclops64" (PDF). Network and Parallel Computing. Lecture Notes in Computer Science. 3779. pp. 132–143. doi:10.1007/11577188_18. ISBN 978-3-540-29810-6.

- ^ Gangming Tan, Vugram C에 의한 IBM Cyclops64의 간극성 중심 계산 분석 및 성능 결과. 스레다르와 광 R. 2011년 9월 1-24일 슈퍼컴퓨팅 제56권 제1호

- ^ Prickett, Timothy (31 May 2010). "Top 500 supers – The Dawning of the GPUs". Theregister.co.uk.

- ^ Hans Hacker; Carsten Trinitis; Josef Weidendorfer; Matthias Brehm (2010). "Considering GPGPU for HPC Centers: Is It Worth the Effort?". In Rainer Keller; David Kramer; Jan-Philipp Weiss (eds.). Facing the Multicore-Challenge: Aspects of New Paradigms and Technologies in Parallel Computing. Springer Science & Business Media. pp. 118–121. ISBN 978-3-642-16232-9.

- ^ Damon Poeter (11 October 2011). "Cray's Titan Supercomputer for ORNL Could Be World's Fastest". Pcmag.com.

- ^ Feldman, Michael (11 October 2011). "GPUs Will Morph ORNL's Jaguar into 20-Petaflop Titan". Hpcwire.com.

- ^ Timothy Prickett Morgan (11 October 2011). "Oak Ridge changes Jaguar's spots from CPUs to GPUs". Theregister.co.uk.

- ^ "NETL 슈퍼컴퓨터" 2페이지

- ^ 콘돈, J.H., K.톰슨, "Belle Chess Hardware" 인 컴퓨터 체스 3(ed.M.R.B)의 진보.클라크), 1982년 페르가몬 프레스.

- ^ Hsu, Feng-hsiung (2002). Behind Deep Blue: Building the Computer that Defeated the World Chess Champion. Princeton University Press. ISBN 978-0-691-09065-8.

- ^ 도닝거, U. 로렌츠 체스 몬스터 하이드라. 제14회 FPL(Field-Programmable Logic and Applications) 국제회의의 Proc., 2004, Antwerp – Belgia, LNCS 3203, 페이지 927 – 932

- ^ J 마키노와 M. Taiji, Special Purpose Computer를 이용한 과학 시뮬레이션: 그레이프 시스템즈, 와일리 1998년

- ^ RIKEN 보도자료, 분자역학 시뮬레이션을 위한 원페타FLOPS 컴퓨터 시스템 완성

- ^ Electronic Frontier Foundation (1998). Cracking DES – Secrets of Encryption Research, Wiretap Politics & Chip Design. Oreilly & Associates Inc. ISBN 978-1-56592-520-5.

- ^ Lohr, Steve (8 June 2018). "Move Over, China: U.S. Is Again Home to World's Speediest Supercomputer". New York Times. Retrieved 19 July 2018.

- ^ "Green500 List - November 2018". TOP500. Retrieved 19 July 2018.

- ^ Xue-June Yang; Xiang-Ke Liao; et al. (2011). "The TianHe-1A Supercomputer: Its Hardware and Software". Journal of Computer Science and Technology. 26 (3): 344–351. doi:10.1007/s02011-011-1137-8. S2CID 1389468.

- ^ 슈퍼맨: 찰스 J. 머레이 1997, ISBN 0-471-04885-2, 페이지 133–135에 의한 Symour Cray와 슈퍼컴퓨터 뒤의 기술 마법사 이야기

- ^ 병렬 컴퓨팅 유체역학; Rupak Biswas 2010 ISBN 1-60595-022-X 페이지 401에 의해 편집된 최근 진보와 미래 방향

- ^ 2008, ISBN 1-60456-186-6, 페이지 313–314에 의한 슈퍼컴퓨팅 연구 발전

- ^ a b M. O. Tokhi, Mohammad Alamgir Hossain 2003, ISBN 978-1-85233-599-1, 페이지 201–202에 의한 실시간 신호 처리 및 제어를 위한 병렬 컴퓨팅

- ^ a b 계산과학 – ICCS 2005: 바이디 S가 편집한 제5차 국제회의. Sunderam 2005, ISBN 3-540-26043-9, 페이지 60-67

- ^ "NVIDIA Tesla GPUs Power World's Fastest Supercomputer" (Press release). Nvidia. 29 October 2010.

- ^ Balandin, Alexander A. (October 2009). "Better Computing Through CPU Cooling". Spectrum.ieee.org.

- ^ "The Green 500". Green500.org.

- ^ "Green 500 list ranks supercomputers". iTnews Australia. Archived from the original on 22 October 2008.

- ^ Wu-chun Feng (2003). "Making a Case for Efficient Supercomputing ACM Queue Magazine, Volume 1 Issue 7, 10 January 2003 doi 10.1145/957717.957772". Queue. 1 (7): 54. doi:10.1145/957717.957772. S2CID 11283177.

- ^ "IBM uncloaks 20 petaflops BlueGene/Q super". The Register. 22 November 2010. Retrieved 25 November 2010.

- ^ Prickett, Timothy (15 July 2011). "The Register: IBM 'Blue Waters' super node washes ashore in August". Theregister.co.uk. Retrieved 9 June 2012.

- ^ "IBM Hot Water-Cooled Supercomputer Goes Live at ETH Zurich". IBM News room. 2 July 2010. Archived from the original on 10 January 2011. Retrieved 16 March 2020.

- ^ Martin LaMonica (10 May 2010). "CNet 10 May 2010". News.cnet.com. Retrieved 9 June 2012.

- ^ "Government unveils world's fastest computer". CNN. Archived from the original on 10 June 2008.

performing 376 million calculations for every watt of electricity used.

- ^ "IBM Roadrunner Takes the Gold in the Petaflop Race". Archived from the original on 17 December 2008. Retrieved 16 March 2020.

- ^ "Top500 Supercomputing List Reveals Computing Trends". 20 July 2010.

IBM... BlueGene/Q system .. setting a record in power efficiency with a value of 1,680 MFLOPS/W, more than twice that of the next best system.

- ^ "IBM Research A Clear Winner in Green 500". 18 November 2010.

- ^ "Green 500 list". Green500.org. Archived from the original on 3 July 2011. Retrieved 16 March 2020.

- ^ Saed G. 유니스. "분할 레벨 충전 복구 로직을 이용한 비증상적으로 에너지 컴퓨팅 제로" 1994. 14페이지.

- ^ "Hot Topic – Cooling Supercomputer의 문제" 웨이백 머신에 2015년 1월 18일 보관

- ^ 아난드 랄 심피. "타이탄 슈퍼컴퓨터 내부: 299K AMD x86 Cores 및 18.6K NVIDIA GPUs.". 2012.

- ^ 커티스 스톨리; 조 젝스턴; 스콧 파킨; 마이클 랭; 브라이언 라이히; 윌리엄 러스트. "고성능 컴퓨팅 작업의 전력 소비량 모델링 및 예측". 2014.

- ^ a b David Padua 2011 ISBN 0-387-09765-1페이지 426-429

- ^ 노하우머신: 1998년 ISBN 0-262-63188-1페이지 149-151의 기술 변화에 대한 에세이

- ^ Euro-Par 2004 병렬 처리: 2004년 제10차 국제 유로-파 회의(International Euro-Par Conference, Marco Danelutto, Marco Vanneschi, Domenico Laforenza, ISBN 3-540-22924-8, 835페이지)

- ^ Euro-Par 2006 Parallel Processing: 제12차 국제 유로-파 컨퍼런스, 2006년, 볼프강 E. 나겔, 볼프강 5세 Walter and Wolfgang Lehner ISBN 3-540-37783-2 페이지

- ^ 사다프 R에 의한 오크리지 국립실험실 크레용 XT3의 평가 Alam etal 국제 고성능 컴퓨팅 저널 2008년 2월 22일자 1권 52-80호

- ^ Dror G의 병렬 처리를 위한 Job 스케줄링 전략에서 Yariv Aridor 등의 Blue Gene/L Supercomputer용 개방형 Job Management Architecture. 페이텔슨 2005 ISBN 978-3-540-31024-2페이지 95-101

- ^ "Top500 OS chart". Top500.org. Archived from the original on 5 March 2012. Retrieved 31 October 2010.

- ^ "Wide-angle view of the ALMA correlator". ESO Press Release. Retrieved 13 February 2013.

- ^ Rahat, Nazmul. "Chapter 03 Software and System Management". Cite 저널은 필요로 한다.

journal=(도움말) - ^ Pande lab. "Client Statistics by OS". Folding@home. Stanford University. Retrieved 10 April 2020.

- ^ "BOINC Combined". BOINCstats. BOINC. Archived from the original on 19 September 2010. Retrieved 30 October 2016Note this link will give current statistics, not those on the date last accessed.CS1 maint: 포스트스크립트(링크)

- ^ "Internet PrimeNet Server Distributed Computing Technology for the Great Internet Mersenne Prime Search". GIMPS. Retrieved 6 June 2011.

- ^ a b Kravtsov, Valentin; Carmeli, David; Dubitzky, Werner; Orda, Ariel; Schuster, Assaf; Yoshpa, Benny. "Quasi-opportunistic supercomputing in grids, hot topic paper (2007)". IEEE International Symposium on High Performance Distributed Computing. IEEE. Retrieved 4 August 2011.

- ^ Jamalian, S.; Rajaei, H. (1 March 2015). ASETS: A SDN Empowered Task Scheduling System for HPCaaS on the Cloud. 2015 IEEE International Conference on Cloud Engineering. pp. 329–334. doi:10.1109/IC2E.2015.56. ISBN 978-1-4799-8218-9. S2CID 10974077.

- ^ Jamalian, S.; Rajaei, H. (1 June 2015). Data-Intensive HPC Tasks Scheduling with SDN to Enable HPC-as-a-Service. 2015 IEEE 8th International Conference on Cloud Computing. pp. 596–603. doi:10.1109/CLOUD.2015.85. ISBN 978-1-4673-7287-9. S2CID 10141367.

- ^ Gupta, A.; Milojicic, D. (1 October 2011). Evaluation of HPC Applications on Cloud. 2011 Sixth Open Cirrus Summit. pp. 22–26. CiteSeerX 10.1.1.294.3936. doi:10.1109/OCS.2011.10. ISBN 978-0-7695-4650-6. S2CID 9405724.

- ^ Kim, H.; el-Khamra, Y.; Jha, S.; Parashar, M. (1 December 2009). An Autonomic Approach to Integrated HPC Grid and Cloud Usage. 2009 Fifth IEEE International Conference on E-Science. pp. 366–373. CiteSeerX 10.1.1.455.7000. doi:10.1109/e-Science.2009.58. ISBN 978-1-4244-5340-5. S2CID 11502126.

- ^ Eadline, Douglas. "Moving HPC to the Cloud". Admin Magazine. Admin Magazine. Retrieved 30 March 2019.

- ^ Niccolai, James (11 August 2009). "Penguin Puts High-performance Computing in the Cloud". PCWorld. IDG Consumer & SMB. Retrieved 6 June 2016.

- ^ a b c 하이엔드 컴퓨팅이 이공계 4개 예시 분야에 미치는 잠재적 영향에 관한 위원회(2008년 10월 28일)의 이공계 4개 예시 분야에서의 하이엔드 컴퓨팅의 잠재적 영향 (2008년 10월 28일) ISBN 0-309-12485-9페이지 9

- ^ Xingfu Wu (1999). Performance Evaluation, Prediction and Visualization of Parallel Systems. Springer Science & Business Media. pp. 114–117. ISBN 978-0-7923-8462-5.

- ^ a b Dongarra, Jack J.; Luszczek, Piotr; Petitet, Antoine (2003), "The LINPACK Benchmark: past, present and future" (PDF), Concurrency and Computation: Practice and Experience, 15 (9): 803–820, doi:10.1002/cpe.728, S2CID 1900724

- ^ "Understanding measures of supercomputer performance and storage system capacity". Indiana University. Retrieved 3 December 2017.

- ^ "Frequently Asked Questions". TOP500.org. Retrieved 3 December 2017.

- ^ Intel brochure – 11/91. "Directory page for Top500 lists. Result for each list since June 1993". Top500.org. Retrieved 31 October 2010.

- ^ "Lenovo Attains Status as Largest Global Provider of TOP500 Supercomputers". Business Wire. 25 June 2018.

- ^ "The Cray-1 Computer System" (PDF). Cray Research, Inc. Retrieved 25 May 2011.

- ^ Joshi, Rajani R. (9 June 1998). "A new heuristic algorithm for probabilistic optimization". Computers & Operations Research. 24 (7): 687–697. doi:10.1016/S0305-0548(96)00056-1.

- ^ "Abstract for SAMSY – Shielding Analysis Modular System". OECD Nuclear Energy Agency, Issy-les-Moulineaux, France. Retrieved 25 May 2011.

- ^ "EFF DES Cracker Source Code". Cosic.esat.kuleuven.be. Retrieved 8 July 2011.

- ^ "Disarmament Diplomacy: – DOE Supercomputing & Test Simulation Programme". Acronym.org.uk. 22 August 2000. Retrieved 8 July 2011.

- ^ "China's Investment in GPU Supercomputing Begins to Pay Off Big Time!". Blogs.nvidia.com. Retrieved 8 July 2011.

- ^ Andrew, Scottie. "The world's fastest supercomputer identified chemicals that could stop coronavirus from spreading, a crucial step toward a treatment". CNN. Retrieved 12 May 2020.

- ^ 카쿠, 미치오. 미래의 물리학 (뉴욕: 더블데이, 2011), 65.

- ^ "Faster Supercomputers Aiding Weather Forecasts". News.nationalgeographic.com. 28 October 2010. Retrieved 8 July 2011.

- ^ "IBM Drops 'Blue Waters' Supercomputer Project". International Business Times. 9 August 2011. Retrieved 14 December 2018. – EBSCO를 통해(가입 필요)

- ^ "Supercomputers". U.S. Department of Energy. Retrieved 7 March 2017.

- ^ "Supercomputer Simulations Help Advance Electrochemical Reaction Research". ucsdnews.ucsd.edu. Retrieved 12 May 2020.

- ^ "IBM's Summit—The Supercomputer Fighting Coronavirus". MedicalExpo e-Magazine. 16 April 2020. Retrieved 12 May 2020.

- ^ "OSTP Funding Supercomputer Research to Combat COVID-19 – MeriTalk". Retrieved 12 May 2020.

- ^ "EU $1.2 supercomputer project to several 10-100 PetaFLOP computers by 2020 and exaFLOP by 2022 NextBigFuture.com". NextBigFuture.com. 4 February 2018. Retrieved 21 May 2018.

- ^ DeBenedictis, Erik P. (2004). "The Path To Extreme Computing" (PDF). Zettaflops. Sandia National Laboratories. Archived from the original (PDF) on 3 August 2007. Retrieved 9 September 2020.

- ^ Cohen, Reuven (28 November 2013). "Global Bitcoin Computing Power Now 256 Times Faster Than Top 500 Supercomputers, Combined!". Forbes. Retrieved 1 December 2017.

- ^ DeBenedictis, Erik P. (2005). "Reversible logic for supercomputing". Proceedings of the 2nd conference on Computing frontiers. pp. 391–402. ISBN 978-1-59593-019-4.

- ^ "IDF: Intel says Moore's Law holds until 2029". Heise Online. 4 April 2008. Archived from the original on 8 December 2013.

- ^ Solem, J. C. (1985). "MECA: A multiprocessor concept specialized to Monte Carlo". Proceedings of the Joint los Alamos National Laboratory – Commissariat à l'Energie Atomique Meeting Held at Cadarache Castle, Provence, France 22–26 April 1985; Monte-Carlo Methods and Applications in Neutronics, Photonics and Statistical Physics, Alcouffe, R.; Dautray, R.; Forster, A.; Forster, G.; Mercier, B.; Eds. (Springer Verlag, Berlin). Lecture Notes in Physics. 240: 184–195. Bibcode:1985LNP...240..184S. doi:10.1007/BFb0049047. ISBN 978-3-540-16070-0.

- ^ a b c d Yiannis Cotronis; Anthony Danalis; Dimitris Nikolopoulos; Jack Dongarra (2011). Recent Advances in the Message Passing Interface: 18th European MPI Users' Group Meeting, EuroMPI 2011, Santorini, Greece, September 18-21, 2011. Proceedings. Springer Science & Business Media. ISBN 9783642244483.

- ^ James H. Laros III; Kevin Pedretti; Suzanne M. Kelly; Wei Shu; Kurt Ferreira; John Van Dyke; Courtenay Vaughan (2012). Energy-Efficient High Performance Computing: Measurement and Tuning. Springer Science & Business Media. p. 1. ISBN 9781447144922.

- ^ James H. Laros III; Kevin Pedretti; Suzanne M. Kelly; Wei Shu; Kurt Ferreira; John Van Dyke; Courtenay Vaughan (2012). Energy-Efficient High Performance Computing: Measurement and Tuning. Springer Science & Business Media. p. 2. ISBN 9781447144922.

- ^ James H. Laros III; Kevin Pedretti; Suzanne M. Kelly; Wei Shu; Kurt Ferreira; John Van Dyke; Courtenay Vaughan (2012). Energy-Efficient High Performance Computing: Measurement and Tuning. Springer Science & Business Media. p. 3. ISBN 9781447144922.

- ^ "Green Supercomputer Crunches Big Data in Iceland". intelfreepress.com. 21 May 2015. Archived from the original on 20 May 2015. Retrieved 18 May 2015.

외부 링크

- 맥도넬, 마샬 T. (2013) 슈퍼컴퓨터 설계: 환경, 경제적, 사회적 영향을 포착하기 위한 초기 노력. 화학 및 생체 분자 공학 출판물 및 기타 작품