미디

MIDI이 기사는 대부분의 독자들이 이해하기에는 너무 기술적인 것일 수 있습니다.(2018년 9월)(본 방법 및 |

MIDI(/ ˈm ɪdi/; Musical Instrument Digital Interface)는 음악을 재생, 편집 및 녹음하기 위해 다양한 전자 악기, 컴퓨터 및 관련 오디오 장치를 연결하는 통신 프로토콜, 디지털 인터페이스 및 전기 커넥터를 설명하는 기술 표준입니다.

단일 MIDI 케이블로 최대 16채널의 MIDI 데이터를 전송할 수 있으며, 각 채널은 개별 장치로 라우팅할 수 있습니다.키, 버튼, 노브 또는 슬라이더와의 각각의 상호작용은 음의 피치, 타이밍 및 라우드니스와 같은 음악적 명령을 지정하는 MIDI 이벤트로 변환됩니다.일반적인 MIDI 응용 프로그램 중 하나는 MIDI 키보드 또는 다른 컨트롤러를 재생하고 그것을 사용하여 디지털 사운드 모듈(합성된 음악 소리를 포함함)을 작동시켜 사용자가 키보드 앰프에서 생성한 소리를 듣는 것입니다.MIDI 데이터는 MIDI 또는 USB 케이블을 통해 전송하거나 시퀀서 또는 디지털 오디오 워크스테이션에 기록하여 편집하거나 재생할 수 있습니다.[2]

데이터를 저장하고 교환하는 파일 형식도 정의됩니다.MIDI의 장점은 작은 파일 크기, 수정 및 조작의 용이성, 전자 기기와 신시사이저 또는 디지털로 샘플링된 사운드를 다양하게 선택할 수 있습니다.[3]: 4 키보드로 연주를 녹음하는 MIDI 녹음은 피아노나 다른 건반 악기처럼 들릴 수 있지만, MIDI는 특정한 소리가 아니라 그들의 음에 대한 메시지와 정보를 녹음하기 때문에 이 녹음은 합성되거나 샘플링된 기타나 플루트부터 전체 오케스트라까지 다양한 다른 소리로 변경될 수 있습니다.

MIDI가 개발되기 전에는 서로 다른 제조사의 전자 악기들은 일반적으로 서로 의사소통을 할 수 없었습니다.이것은 음악가가 예를 들어 롤랜드 키보드를 야마하 신디사이저 모듈에 꽂을 수 없다는 것을 의미했습니다.MIDI를 사용하면 어떤 MIDI 호환 키보드(또는 다른 컨트롤러 장치)라도 다른 제조업체에서 만든 다른 MIDI 호환 시퀀서, 사운드 모듈, 드럼 머신, 신시사이저 또는 컴퓨터에 연결할 수 있습니다.

MIDI 기술은 1983년 음악 산업 대표자들로 구성된 패널에 의해 표준화되었으며, MMA(MIDI Manufacturers Association)에 의해 유지되고 있습니다.공식적인 모든 MIDI 표준은 로스앤젤레스의 MMA와 도쿄의 AMEI(Association of Musical Electronics Industry)의 MIDI 위원회가 공동으로 개발하고 발표합니다.2016년, MMA(The MIDI Association)는 MMA(The MIDI Association)를 설립하여 MIDI로 작업하고, 플레이하고, 창작하는 사람들의 글로벌 커뮤니티를 지원했습니다.[4]

역사

1980년대 초에는 서로 다른 회사에서 제조한 전자 악기의 동기화를 위한 표준화된 수단이 없었습니다.[5]제조업체는 CV/게이트, DIN sync 및 DCB(Digital Control Bus)와 같은 기기를 동기화하기 위한 자체적인 표준을 보유하고 있었습니다.[6]Roland의 회장인 Ikutaro Kakehashi는 표준화의 부족이 전자 음악 산업의 성장을 제한하고 있습니다.[6]1981년 6월, 그는 오버하임 전자의 설립자 톰 오버하임에게 표준 개발을 제안했습니다.[5] 톰 오버하임은 독자적인 인터페이스인 오버하임 시스템을 개발했습니다.[7]

카케하시는 오버하임 시스템이 너무 번거롭다고 생각하여 순차 회로의 사장인 데이브 스미스에게 좀 더 간단하고 저렴한 대안을 만들자고 말했습니다.[7]스미스가 미국 회사들과 이 개념을 논의하는 동안, 카케하시는 일본 회사들인 야마하, 코그, 카와이와 함께 이 개념을 논의했습니다.[5]모든 회사의 대표들이 10월에 그 아이디어를 논의하기 위해 만났습니다.[5]처음에는 순차 회로와 일본 회사들만 관심을 가졌습니다.[8]

Smith와 Sequential Circuit 엔지니어 Chet Wood는 Roland의 DCB를 기반으로 다양한 제조업체의 장비 간 통신을 가능하게 하는 범용 인터페이스를 고안했습니다.[6]스미스와 우드는 1981년 10월 오디오 공학회 쇼에서 [9]유니버설 신시사이저 인터페이스라는 논문에서 이 표준을 제안했습니다.[10][11]: 4 표준은 Roland, Yamaha, Korg, Kawai, Sequential Circuit의 대표들에 의해 논의되고 수정되었습니다.[12][13]: 20 카케하시는 UMI(Universal Musical Interface)라는 이름을 좋아했고, 유미(You-Me)라고 발음했지만,[7] 스미스는 이것이 "조금 진부하다"고 느꼈습니다.[14]그러나 그는 신디사이저 대신 악기를 사용하는 것을 좋아했고, MIDI(Musical Instrument Digital Interface)를 제안했습니다.[14][11]: 4 무그 뮤직의 사장인 로버트 무그는 1982년 10월호 키보드에서 MIDI를 발표했습니다.[15]: 276

1983년 겨울 NAMM 쇼에서 스미스는 Propet 600과 Roland JP-6 신디사이저 사이의 MIDI 연결을 시연했습니다.MIDI 사양은 1983년 8월에 발표되었습니다.[5]MIDI 표준은 2013년 테크니컬 그래미 어워드를 수상한 Kakehashi와 Smith에 의해 발표되었습니다.[16][17][18]1983년, 최초의 악기들은 MIDI, Roland Jupiter-6 그리고 Propet 600과 함께 출시되었습니다.1983년에 최초의 MIDI 드럼 머신인 Roland TR-909와 [19][20]최초의 MIDI 시퀀서인 Roland MSQ-700이 출시되었습니다.[21]

MMA(MIDI Manufacturers Association)는 1984년 시카고에서 열린 하계 NAMM 쇼에서 "모든 관심있는 회사"들의 모임 이후에 결성되었습니다.1985년 하계 NAMM 쇼에서 MMA의 두 번째 회의에서 MIDI 1.0 Detail Specification이 발표되었습니다.표준은 계속 발전하여 1991년 표준화된 노래 파일(General MIDI)을 추가하고 USB 및 FireWire와 같은 새로운 연결 표준에 적응했습니다.2016년에는 표준을 계속 감독하기 위해 MIDI 협회가 결성되었습니다.[8]2019년 1월에는 2.0 표준 개발 계획을 발표했습니다.[22]MIDI 2.0 표준은 2020년 겨울 NAMM 쇼에서 소개되었습니다.[23]

BBC는 오픈 소스 기술의 초기 예로 MIDI를 꼽았습니다.스미스는 모든 제조사가 이를 채택해야만 미디가 성공할 수 있다고 믿었고, 그래서 "우리는 그것을 나누어 주어야만 했다.[24]

영향

MIDI의 매력은 원래 대중 음악 제작에 전자 악기를 사용하고자 하는 전문 음악가와 음반 제작자들에 한정되어 있었습니다.이 표준은 서로 다른 악기들이 서로 또는 컴퓨터와 소통할 수 있게 했고, 이것은 전자 악기와 음악 소프트웨어의 판매와 생산의 급속한 확장을 촉진시켰습니다.[13]: 21 이러한 상호 운용성을 통해 하나의 장치를 다른 장치에서 제어할 수 있게 되었고, 이로 인해 하드웨어 음악가가 필요로 하는 양이 줄어들었습니다.[25]MIDI의 도입은 개인용 컴퓨터 시대의 여명과 함께 시작되었고, 샘플러와 디지털 신시사이저의 도입과 동시에 이루어졌습니다.[26]MIDI 기술이 가져온 창의적인 가능성은 1980년대 음악 산업을 되살리는 데 도움을 준 것으로 인정받고 있습니다.[27]

MIDI는 많은 음악가들의 작업 방식을 변화시킨 기능을 도입했습니다.MIDI 시퀀싱은 표기 기술이 없는 사용자가 복잡한 배열을 만들 수 있도록 합니다.[28]각각 여러 개의 MIDI 지원 장치를 작동하는 한 두 명의 멤버로 구성된 음악 활동은 더 많은 음악가 그룹과 비슷한 성능을 제공할 수 있습니다.[29]프로젝트를 위해 외부 음악가를 고용하는 비용을 줄이거나 없앨 [2]: 7 수 있으며 키보드와 시퀀서가 통합된 신디사이저 정도의 작은 시스템에서 복잡한 제작을 실현할 수 있습니다.

MIDI는 또한 홈 레코딩을 확립하는 데 도움이 되었습니다.아티스트는 가정 환경에서 사전 제작을 수행함으로써 부분적으로 완성된 곡을 가지고 녹음실에 도착함으로써 녹음 비용을 절감할 수 있습니다.[2]: 7–8 2022년 가디언지는 MIDI가 USB 컴퓨팅만큼 음악에 중요한 역할을 하고 있으며 "협업과 상호 이익의 중요한 가치 체계"를 나타냈으며, 이는 오늘날의 주요 기술 회사들이 사로잡힌 시장을 선호하여 포기한 것입니다.2022년 현재 스미스의 원래 미디 디자인은 여전히 사용되고 있습니다.[30]

적용들

계기제어

MIDI는 전자 악기나 디지털 악기들이 서로 소통할 수 있고 한 악기가 다른 악기를 제어할 수 있도록 발명되었습니다.예를 들어, 미디 호환 시퀀서는 드럼 사운드 모듈에서 생성되는 비트를 트리거할 수 있습니다.MIDI 개발 이전에 개발된 디지털 부품이 없는 아날로그 신시사이저는 MIDI 메시지를 아날로그 제어 전압으로 변환하는 키트로 개조할 수 있습니다.[15]: 277 MIDI 기기에서 노트를 재생하면 디지털 MIDI 메시지를 생성하여 다른 기기에서 노트를 트리거할 수 있습니다.[2]: 20 원격 제어 기능을 통해 전체 크기의 악기를 더 작은 사운드 모듈로 교체할 수 있으며, 음악가들이 악기를 결합하여 더 풍부한 사운드를 구현하거나 어쿠스틱 피아노와 현과 같은 합성 악기 사운드의 조합을 만들 수 있습니다.[31]또한 MIDI를 사용하면 기타 기기 파라미터(볼륨, 효과 등)를 원격으로 제어할 수 있습니다.

신디사이저와 샘플러에는 전자 또는 디지털 사운드를 형성하기 위한 다양한 도구가 포함되어 있습니다.필터는 음색을 조정하고, 봉투는 음이 트리거된 후 시간이 지남에 따라 소리가 진화하는 방식을 자동화합니다.[32]신시사이저 파라미터는 필터의 주파수, 포락선 공격(음향이 최대치에 도달하는 데 걸리는 시간) 등이 있으며, MIDI를 통해 원격으로 제어할 수 있으며, 효과 장치는 지연 피드백이나 잔향 시간 등의 파라미터가 다릅니다.이러한 파라미터 중 하나에 MIDI CCN(Continuous Controller Number)이 할당되면 해당 번호로 식별되는 수신 메시지에 응답합니다.노브, 스위치 및 페달과 같은 컨트롤을 사용하여 이러한 메시지를 보낼 수 있습니다.조정된 일련의 파라미터들은 패치로서 디바이스의 내부 메모리에 저장될 수 있고, 이러한 패치들은 MIDI 프로그램 변경에 의해 원격으로 선택될 수 있습니다.[a][33]

구성.

MIDI 이벤트는 컴퓨터 소프트웨어나 특수 하드웨어 음악 워크스테이션으로 순서를 매길 수 있습니다.많은 디지털 오디오 워크스테이션(DAW)은 MIDI를 필수 구성 요소로 사용하도록 특별히 설계되었습니다.녹음된 MIDI 메시지를 쉽게 수정할 수 있도록 많은 DAW에서 MIDI 피아노 롤이 개발되었습니다.[34][better source needed]이러한 도구를 사용하면 작곡가가 멀티트랙 녹음과 같은 기존 솔루션보다 훨씬 빠르고 효율적으로 작업을 오디션하고 편집할 수 있습니다.[citation needed]MIDI를 위해 인간 연주자가 연주할 수 없는 작곡을 프로그래밍할 수 있습니다.[35]

MIDI 성능은 사운드를 생성하는 일련의 명령어이기 때문에 오디오 녹음이 불가능한 방식으로 MIDI 녹음을 조작할 수 있습니다.MIDI 배열의 키, 계측기 또는 템포를 변경할 수 있으며,[36]: 227 개별 섹션의 순서를 [37]바꾸거나 개별 노트를 편집할 수도 있습니다.작곡가들은 아이디어를 작곡하고 그것을 재생하는 것을 빠르게 들을 수 있는 능력을 가지고 실험을 할 수 있습니다.[38]: 175

알고리즘 작곡 프로그램은 노래 아이디어나 반주로 사용할 수 있는 컴퓨터로 만든 연주를 제공합니다.[2]: 122

몇몇 작곡가들은 MIDI 1.0과 GM(General MIDI)의 표준 휴대용 명령어와 파라미터 세트를 이용하여 다양한 전자 악기들 간에 음악 데이터 파일을 공유할 수 있습니다.배열된 MIDI 기록을 통해 생성된 데이터는 표준 MIDI 파일(SMF)로 저장하고 디지털 방식으로 배포하여 동일한 MIDI, GM, SMF 표준을 준수하는 컴퓨터 또는 전자 기기로 재생할 수 있습니다.MIDI 데이터 파일은 해당 녹음 오디오 파일보다 훨씬 작습니다.[citation needed]

컴퓨터와 함께 사용

MIDI 등장과 동시에 개인용 컴퓨터 시장은 안정화되었고, 컴퓨터는 음악 제작을 위한 실행 가능한 옵션이 되었습니다.[15]: 324 1983년에 컴퓨터는 주류 음악 제작에 역할을 하기 시작했습니다.[39]1983년에 MIDI 규격이 비준된 직후 몇 년 동안, MIDI 기능은 여러 초기 컴퓨터 플랫폼에 적용되었습니다.1984년에 야마하 CX5M은 MSX 시스템에 MIDI 지원과 시퀀싱을 도입했습니다.[40]

가정용 컴퓨터에서 MIDI의 보급은 1984년 출시된 롤랜드 사의 MPU-401이 MIDI 사운드 처리[41] 및 시퀀싱이 가능한 최초의 MIDI 장착 사운드 카드로서 크게 촉진되었습니다.[42][43]롤랜드는 MPU 사운드 칩을 다른 사운드 카드 제조업체에 판매한 후 범용 표준 MIDI-to-PC 인터페이스를 구축했습니다.[41][44]MIDI가 널리 채택되면서 컴퓨터 기반의 MIDI 소프트웨어가 개발되었습니다.[39]곧이어 애플 II, 매킨토시, 코모도어 64, 아미가, 에이콘 아르키메데스, IBM PC 호환 등 수많은 플랫폼이 MIDI를 지원하기 시작했습니다.[15]: 325–7 1985년 아타리 ST는 MIDI 포트와 함께 기본 시스템의 일부로 출고되었습니다.

2015년 레트로 이노베이션스는 VIC-20을 위한 최초의 미디 인터페이스를 출시하여 전자 음악가와 레트로 컴퓨팅 애호가들이 컴퓨터의 네 가지 음성을 처음으로 사용할 수 있게 했습니다.[45]Retro Innovations는 탠디 컬러 컴퓨터와 드래곤 컴퓨터를 위한 MIDI 인터페이스 카트리지도 만듭니다.[46]

칩튠 음악가들은 MIDI 인터페이스를 사용하여 음악을 작곡하고 제작하고 연주하기 위해 레트로 게임기를 사용하기도 합니다.NES(Nintendo Entertainment System)/Famicom,[47] Game [48]Boy, Game Boy Advance[49], Sega Genesis(메가 드라이브)에서 사용자 지정 인터페이스를 사용할 수 있습니다.[50]

컴퓨터 파일

MIDI 파일은 오디오 녹음이 아닙니다.그보다는 음정이나 템포와 같은 일련의 명령어로 녹음된 동등한 오디오보다 천 배나 적은 디스크 공간을 사용할 수 있습니다.[51][52]작은 파일 크기로 인해 팬이 만든 MIDI 배열은 광대역 인터넷 액세스와 멀티 기가바이트 하드 드라이브가 등장하기 전에 온라인에서 음악을 공유할 수 있는 매력적인 방법이 되었습니다.[53]이에 대한 가장 큰 단점은 사용자의 오디오 카드의 품질의 편차가 크다는 것이며, 실제 샘플로 포함된 오디오 또는 카드에 포함된 합성음에서는 미디 데이터가 상징적으로만 지칭하는 것입니다.고품질의 샘플링된 사운드가 포함된 사운드 카드라도 샘플링된 기기마다 품질이 일관되지 않을 수 있습니다.[51]AdLib 및 Sound Blaster와 그 호환 제품과 같은 초기 예산이 책정된 카드는 낮은 품질의 디지털 아날로그 변환기를 통해 재생되는 Yamaha의 주파수 변조 합성(FM 합성) 기술의[54] 축소 버전을 사용했습니다.이러한 유비쿼터스[54] 카드의 저충실도 재현은[51] 종종 MIDI 자체의 속성으로 여겨집니다.이로 인해 MIDI는 저음질 오디오라는 인식이 생겼고,[55] 실제로는 MIDI 자체에 소리가 나지 않으며, 재생 품질은 전적으로 소리를 내는 장치의 품질에 달려 있습니다.[36]: 227

표준 파일

| 파일 확장자 | .mid |

|---|---|

| 인터넷 매체 유형 | 오디오/ |

| UTI(Uniform Type Identifier) | 공개 midi |

SMF(Standard MIDI File)는 다른 시스템에서 음악 시퀀스를 저장, 전송 및 열 수 있도록 표준화된 방법을 제공하는 파일 형식입니다.표준은 MMA에 의해 개발되고 유지되며, 보통 a를 사용합니다..mid내선[57]이러한 파일의 크기가 작기 때문에 컴퓨터, 휴대폰 벨소리, 웹페이지 저작 및 음악 연하장 등에 널리 사용되었습니다.이러한 파일은 보편적인 용도로 사용되며 노트 값, 타이밍 및 트랙 이름과 같은 정보를 포함합니다.가사는 메타데이터로 포함될 수 있으며, 노래방 기기에 의해 표시될 수 있습니다.[58]

SMF는 소프트웨어 시퀀서 또는 하드웨어 워크스테이션의 내보내기 형식으로 만들어집니다.MIDI 메시지를 하나 이상의 병렬 트랙으로 구성하고 이벤트를 타임스탬프 처리하여 순서대로 재생할 수 있도록 합니다.헤더에는 배열의 트랙 수, 템포 및 파일이 사용하는 세 가지 SMF 형식 중 어느 것을 사용할지 표시자가 포함됩니다.유형 0 파일은 단일 트랙에 병합되는 전체 성능을 포함하고 유형 1 파일은 동기적으로 수행되는 트랙 수를 포함할 수 있습니다.유형 2 파일은 거의 사용되지[59] 않으며 여러 배열을 저장하며, 각 배열에는 고유한 트랙이 있고 순서대로 재생되도록 되어 있습니다.

RMID 파일

Microsoft Windows는 SMF를 RIFF(Resource Interchange File Format) 래퍼에 다운로드 가능한 사운드(DLS)와 함께 RMID 파일로 번들링합니다..rmi내선RIFF-RMID는 XMF(Extensible Music Files)를 선호하여 폐지되었습니다.[60]

소프트웨어

MIDI 시스템에서 개인용 컴퓨터의 가장 큰 장점은 로드되는 소프트웨어에 따라 다양한 용도로 사용할 수 있다는 것입니다.[2]: 55 멀티태스킹을 통해 서로 데이터를 공유할 수 있는 프로그램을 동시에 운영할 수 있습니다.[2]: 65

시퀀서

시퀀싱 소프트웨어는 잘라내기, 복사 및 붙여넣기, 드래그 앤 드롭과 같은 표준 컴퓨터 편집 기능을 사용하여 기록된 MIDI 데이터를 조작할 수 있습니다.키보드 단축키는 워크플로우를 간소화하는 데 사용될 수 있으며, 일부 시스템에서는 편집 기능이 MIDI 이벤트에 의해 호출될 수 있습니다.시퀀서는 각 채널이 다른 소리를 재생하도록 설정할 수 있으며 배치에 대한 그래픽 개요를 제공합니다.음악가를 위한 인쇄 부품을 만드는 데 사용할 수 있는 기보 디스플레이 또는 악보 작성기를 포함한 다양한 편집 도구가 제공됩니다.루프, 양자화, 랜덤화 및 전치와 같은 도구는 정렬 프로세스를 단순화합니다.

비트 생성이 간단하며 그루브 템플릿을 사용하여 다른 트랙의 리드미컬한 느낌을 그대로 재현할 수 있습니다.실시간 컨트롤러 조작을 통해 실감나는 표현을 추가할 수 있습니다.믹싱이 가능하며, 녹음된 오디오 및 비디오 트랙과 MIDI를 동기화 할 수 있습니다.작업을 저장하고 서로 다른 컴퓨터나 스튜디오 간에 이동할 수 있습니다.[61][62]: 164–6

시퀀서는 패턴 그리드를 클릭하여 비트를 생성할 수 있는 드럼 패턴 에디터와 [2]: 118 템포와 키가 서로 일치하는 미리 녹음된 오디오 루프와 MIDI를 결합할 수 있는 ACID Pro와 같은 루프 시퀀서와 같은 대체 형태를 취할 수 있습니다.큐 리스트 시퀀싱은 무대와 방송 제작에서 대화, 효과음, 음악 큐를 유발하는 데 사용됩니다.[2]: 121

표기 소프트웨어

MIDI를 사용하면 키보드로 재생되는 노트를 자동으로 악보로 전사할 수 있습니다.[13]: 213 악보 작성 소프트웨어는 일반적으로 고급 시퀀싱 도구가 없으며, 살아있는 악기 연주자를 위해 설계된 깔끔하고 전문적인 인쇄물을 만드는데 최적화되어 있습니다.[62]: 157 이러한 프로그램은 역동성과 표현 표시, 화음과 가사 표시, 복잡한 악보 스타일을 지원합니다.[62]: 167 점자로 점수를 출력할 수 있는 소프트웨어를 사용할 수 있습니다.[63]

기보 프로그램으로는 피날레, 앙코르, 시벨리우스, 뮤즈스코어, 도리코 등이 있습니다.SmartScore 소프트웨어는 스캔한 악보로 MIDI 파일을 생성할 수 있습니다.[64]

편집자 및 사서

패치 편집기를 사용하면 컴퓨터 인터페이스를 통해 장비를 프로그래밍할 수 있습니다.이것들은 야마하 FS1R과 같은 복잡한 신디사이저의 등장과 함께 필수적인 것이 되었습니다.[65] 야마하 FS1R은 수천 개의 프로그래밍 가능한 매개 변수를 포함하고 있지만 15개의 작은 버튼, 4개의 노브 및 작은 LCD로 구성된 인터페이스를 가지고 있었습니다.[66]디지털 기기는 스위치와 노브가 제공하는 피드백과 직접 제어 기능이 부족하기 때문에 일반적으로 사용자의 실험을 방해하지만 [67]: 393 패치 편집기는 하드웨어 기기와 효과 기기의 소유자에게 소프트웨어 합성기 사용자가 사용할 수 있는 것과 동일한 편집 기능을 제공합니다.[68]어떤 편집기는 특정 기기나 효과 장치를 위해 설계된 반면, 다른 범용 편집기는 다양한 장비를 지원하며 이상적으로 시스템 독점 메시지를 사용하여 설정의 모든 기기의 파라미터를 제어할 수 있습니다.[2]: 129 System Exclusive 메시지는 MIDI 프로토콜을 사용하여 신디사이저의 파라미터에 대한 정보를 보냅니다.

패치 사서들은 장비 모음에 있는 소리들을 정리하고 악기와 컴퓨터 사이에 전체 소리 은행들을 교환하는 전문화된 기능을 가지고 있습니다.이러한 방식으로 장치의 제한된 패치 스토리지는 컴퓨터의 훨씬 더 큰 디스크 용량에 의해 증강됩니다.[2]: 133 컴퓨터로 전송되면 같은 기기의 다른 소유자와 사용자 지정 패치를 공유할 수 있습니다.[69]한때 두 기능을 결합한 유니버설 에디터/라이브러리가 일반적이었고, 옵코드 시스템즈의 갤럭시, 이매직의 사운드 다이버, MOTU의 유니신 등이 있었습니다.비록 이 오래된 프로그램들이 가상 악기를 사용한 컴퓨터 기반 합성의 경향과 함께 대부분 폐기되었지만, Coffeeshopp Patch Base,[70] Sound Quest의 Midi Quest, Sound Tower의 여러 편집자들을 포함한 몇몇 편집자/라이브러리들은 여전히 이용할 수 있습니다.Native Instruments' Korea는 편집자/도서관 개념을 소프트웨어 기기 시대에 도입하기 위한 노력이었지만,[71] 2011년에 폐지되었습니다.[72]

자동반주기 프로그램

동적으로 반주 트랙을 생성할 수 있는 프로그램을 자동 반주 프로그램이라고 합니다.이들은 사용자가 선택한 스타일로 풀 밴드 배열을 생성하고, 그 결과를 재생을 위해 MIDI 사운드 생성 장치로 보냅니다.생성된 트랙은 교육용 또는 연습용 도구로, 라이브 공연을 위한 반주로, 또는 작곡 보조 도구로 사용될 수 있습니다.[73]: 42

합성 및 샘플링

컴퓨터는 소프트웨어를 사용하여 소리를 낼 수 있으며, 소리는 디지털 아날로그 변환기(DAC)를 거쳐 전력 증폭기와 라우드스피커 시스템으로 전달됩니다.[13]: 213 동시에 재생할 수 있는 소리의 수(다성화)는 컴퓨터 CPU의 전력에 따라 달라지며, 재생의 샘플 속도와 비트 깊이는 소리의 품질에 직접적인 영향을 미칩니다.[74]소프트웨어에 구현된 신디사이저는 하드웨어 기기에 반드시 존재하지 않는 타이밍 문제가 있으며, 전용 운영 체제는 데스크톱 운영 체제처럼 백그라운드 작업의 중단이 발생하지 않습니다.이러한 타이밍 문제로 인해 동기화 문제가 발생할 수 있으며 샘플 재생이 중단되면 클릭 및 팝업이 표시됩니다.소프트웨어 신디사이저는 사운드 생성에 추가적인 지연 시간을 나타낼 수도 있습니다.[75]

소프트웨어 합성의 기원은 벨 연구소의 맥스 매튜스가 비실시간 사운드 생성이 가능한 MUSIC-N 프로그래밍 언어를 작성한 1950년대까지 거슬러 올라갑니다.[76]Dave Smith의 Seeer Systems에서 제작한 Reality는 호스트 컴퓨터의 CPU에서 직접 실행되는 초기 신시사이저입니다. Reality는 드라이버를 긴밀하게 통합하여 지연 시간을 낮췄기 때문에 Creative Labs 사운드 카드에서만 실행할 수 있었습니다.[77][78]Syntauri Corporation의 Alpha Syntauri는 또 다른 초기 소프트웨어 기반 신디사이저였습니다.이것은 애플 IIe 컴퓨터에서 실행되었고, 추가 합성을 만들기 위해 소프트웨어와 컴퓨터 하드웨어의 조합을 사용했습니다.[79]Symbol Sound Corporation의 Kyma System과 [76]Creamware/Sonic Core Pulsar/SCOPE 시스템과 같이 일부 시스템은 호스트 CPU의 부하를 줄이기 위해 전용 하드웨어를 사용합니다.[80] 이는 전체 녹음 스튜디오의 기기, 효과 장치 및 믹서에 전원을 공급합니다.[81]컴퓨터 소프트웨어에서 완전한 미디 배열을 구성할 수 있는 기능은 작곡가가 완성된 결과물을 오디오 파일로 직접 렌더링할 수 있게 해줍니다.[31]

게임음악

초기 PC 게임은 플로피 디스크에 배포되었고, MIDI 파일의 작은 크기는 사운드 트랙을 제공하는 실행 가능한 수단이 되었습니다.도스와 초기 윈도우 시대의 게임들은 일반적으로 애드립이나 사운드 블라스터 오디오 카드와의 호환성을 요구했습니다.이 카드들은 사인파의 변조를 통해 소리를 발생시키는 FM 합성을 사용했습니다.이 기술의 선구자인 존 차우닝(John Chowning)은 이 기술이 충분한 사인파를 사용한다면 어떤 소리든 정확하게 재생할 수 있을 것이라고 이론화했지만, 저가의 컴퓨터 오디오 카드는 단 두 개의 사인파만으로 FM 합성을 수행했습니다.카드의 8비트 오디오와 결합하여 "인공적인"[82] 그리고 "원시적인" 소리가 나게 되었습니다.[83]

나중에 구입할 수 있게 된 웨이브테이블 도터보드는 FM 사운드 대신 사용할 수 있는 오디오 샘플을 제공했습니다.이것들은 값이 비쌌지만, 종종 E-mu Proteus와 같은 존경 받는 MIDI 기기의 소리를 사용했습니다.[83]컴퓨터 산업은 1990년대 중반에 16비트 재생이 가능한 웨이브테이블 기반 사운드 카드로 발전했지만, 128개의 General MIDI 기기와 드럼 키트의 좋은 품질의 샘플에 맞추기에는 너무 작은 공간인 2MB의 웨이브테이블 스토리지로 표준화되었습니다.제한된 공간을 최대한 활용하기 위해 일부 제조업체는 12비트 샘플을 저장했다가 재생 시 16비트로 확장했습니다.[84]

기타 어플리케이션

MIDI는 음악 기기와의 연관성에도 불구하고, MIDI 명령을 읽고 처리할 수 있는 모든 전자 기기나 디지털 기기를 제어할 수 있습니다.MIDI는 다수의 비음악 애플리케이션에서 제어 프로토콜로 채택되었습니다.MIDI Show Control은 MIDI 명령을 사용하여 무대 조명 시스템을 지시하고 극장 제작에서 큐드 이벤트를 트리거합니다.VJ와 턴테이블리스트는 클립 큐, 장비 동기화, 기록 시스템은 동기화 및 자동화에 사용합니다.애플모션은 MIDI를 통해 애니메이션 파라미터를 제어할 수 있습니다.1987년 1인칭 슈팅 게임 MIDI Maze와 1990년 아타리 ST 컴퓨터 퍼즐 게임 Oxyd는 MIDI를 사용하여 컴퓨터를 네트워크로 연결했습니다.

장치들

커넥터 및 인터페이스

표준 MIDI 케이블은 180° 5핀 DIN 커넥터에서 끝납니다.일반적인 응용 프로그램에서는 5개 도체 중 접지선(핀 2)과 +5V 데이터 신호를 전달하는 균형 잡힌 한 쌍의 도체(핀 4 및 5) 세 개만 사용합니다.[85][73]: 41 이 커넥터 구성은 한 방향으로만 메시지를 전송할 수 있으므로 양방향 통신을 위해서는 두 번째 케이블이 필요합니다.[2]: 13 팬텀 전동 풋스위치 컨트롤러와 같은 일부 전용 애플리케이션에서는 DC(직류) 전원 전송을 위해 예비 핀을 사용합니다.[86]

옵토 아이솔레이터는 MIDI 연결로부터 MIDI 장치를 전기적으로 분리시켜 접지 루프를[87]: 63 방지하고 전압 스파이크로부터 장비를 보호합니다.[15]: 277 MIDI에는 오류 감지 기능이 없으므로 간섭을 제한하기 위해 최대 케이블 길이를 15m(49ft)로 설정합니다.[88]

대부분의 장치는 입력에서 출력 포트로 메시지를 복사하지 않습니다.세 번째 유형의 포트인 쓰루 포트는 입력 포트에서 수신된 모든 것의 복사본을 방출하여 데이지 체인 방식으로 데이터를 다른 기기로[15]: 278 전달할 수 있습니다.[89]모든 장치가 포트를 통해 기능하는 것은 아니며, 이펙트 유닛 및 사운드 모듈과 같이 MIDI 데이터를 생성하는 기능이 부족한 장치는 아웃 포트를 포함하지 않을 수 있습니다.[67]: 384

관리장치

데이지 체인의 각 장치는 시스템에 지연을 가중시킵니다.MIDI thru box를 사용하면 이를 방지할 수 있는데, MIDI thru box에는 입력 신호의 정확한 복사본을 제공하는 여러 출력이 포함되어 있습니다.MIDI 병합은 여러 장치의 입력을 하나의 스트림으로 결합할 수 있으며, 여러 컨트롤러를 하나의 장치에 연결할 수 있습니다.MIDI 스위치는 여러 장치 간의 전환을 가능하게 하며, 물리적으로 케이블을 다시 배치할 필요가 없습니다.MIDI 라우터는 이 모든 기능을 결합합니다.여기에는 여러 입력 및 출력이 포함되어 있으며, 입력 채널의 모든 조합을 출력 채널의 모든 조합으로 라우팅할 수 있습니다.라우팅 설정은 컴퓨터 소프트웨어를 사용하여 생성하고 메모리에 저장하며 MIDI 프로그램 변경 명령을 통해 선택할 수 있습니다.[2]: 47–50 이를 통해 컴퓨터가 없는 상황에서 장치가 독립형 MIDI 라우터로 작동할 수 있습니다.[2]: 62–3 [90]MIDI 데이터 프로세서는 유틸리티 작업과 특수 효과를 위해 사용됩니다.여기에는 스트림에서 원하지 않는 MIDI 데이터를 제거하는 MIDI 필터와 입력 데이터의 반복 복사본을 설정된 시간에 전송하는 효과인 MIDI 지연이 포함됩니다.[2]: 51

인터페이스

컴퓨터 MIDI 인터페이스의 주된 기능은 MIDI 장치와 컴퓨터 간의 통신을 동기화하는 것입니다.[89]일부 컴퓨터 사운드 카드에는 표준 MIDI 커넥터가 포함되어 있는 반면 다른 카드에는 D-submiature DA-15 게임 포트, USB, FireWire, 이더넷 또는 독점 연결을 포함한 다양한 방법으로 연결됩니다.2000년대 들어 USB 커넥터의 사용이 증가함에 따라 USB가 장착된 컴퓨터로 MIDI 채널을 전송할 수 있는 MIDI-to-USB 데이터 인터페이스가 제공되었습니다.일부 MIDI 키보드 컨트롤러에는 USB 잭이 장착되어 있으며 음악 소프트웨어를 실행하는 컴퓨터에 직접 연결할 수 있습니다.

MIDI의 직렬 전송은 타이밍 문제로 이어집니다.3바이트의 미디 메시지는 전송에 거의 1밀리초가 필요합니다.[91]MIDI는 직렬이기 때문에 한 번에 하나의 이벤트만 전송할 수 있습니다.이벤트가 두 개의 채널에서 동시에 전송될 경우 두 번째 채널의 이벤트는 첫 번째 채널이 끝날 때까지 전송할 수 없으므로 1ms 지연됩니다.이벤트가 모든 채널에서 동시에 전송될 경우 마지막 채널의 전송이 16ms만큼 지연됩니다.이는 이벤트가 동일한 포트의 여러 채널에 비해 여러 포트 간에 확산될 때 타이밍이 향상되기 때문에 여러 포트 내 및 외부 포트를 가진 MIDI 인터페이스의 증가에 기여했습니다.[75]MIDI slop은 MIDI 전송이 지연될 때 발생하는 가청 타이밍 에러를 말합니다.[92]

컨트롤러

MIDI 컨트롤러에는 음을 생성하여 음악을 수행하는 데 사용되는 성능 컨트롤러와 [93]음을 보내지 않고 다른 유형의 실시간 이벤트를 전송하는 컨트롤러가 있습니다.많은 장치들이 두 가지 유형을 결합한 것입니다.

키보드는 단연코 가장 일반적인 유형의 미디 컨트롤러입니다.[69]MIDI는 키보드를 염두에 두고 설계되었으며 키보드가 아닌 모든 컨트롤러는 "대체" 컨트롤러로 간주됩니다.[94]이것은 건반 기반의 음악에 관심이 없던 작곡가들에 의해 한계로 보여졌지만, 표준은 유연함을 증명했고, MIDI 호환성은 기타와 드럼 키트와 관악기의 연주를 모방하는 다른 종류의 제어기들에 도입되었습니다.각각 전문화된 컨트롤러와 실험적인 컨트롤러.[13]: 23 그럼에도 불구하고, MIDI가 설계된 키보드 연주의 일부 기능은 다른 악기의 기능을 완전히 포착하지 못합니다. Jaron Lanier는 이 표준을 기술적인 "락인(lock-in)"[95]의 예로 꼽았는데, 이는 표현 가능한 것을 예상치 못하게 제한했습니다.이러한 단점 중 일부는 프로토콜의 확장에서 해결되었습니다.

소프트웨어 신디사이저는 강력한 파워와 범용성을 제공하지만, 일부 사용자들은 MIDI 키보드와 컴퓨터 키보드 사이의 주의 구분이 재생 경험에서 오는 즉각성의 일부를 빼앗아간다고 느낍니다.[96]실시간 MIDI 제어 전용 장치는 인체공학적 이점을 제공하며 컴퓨터를 통해 액세스하는 인터페이스보다 기기와의 연결감이 뛰어납니다.컨트롤러는 다양한 장비와 함께 작동하도록 설계된 범용 장치이거나 특정 소프트웨어와 함께 작동하도록 설계된 장치일 수 있습니다.후자의 예로는 Akai의 Ableton Live용 APC40 컨트롤러, 그리고 제어판을 MS-20 아날로그 신디사이저에 재현한 Korg의 MS-20ic 컨트롤러가 있습니다.MS-20ic 컨트롤러에는 MS-20 신디사이저의 가상 복제에서 신호 라우팅을 제어하는 데 사용할 수 있는 패치 케이블이 포함되어 있으며 타사 장치도 제어할 수 있습니다.[97]

악기

MIDI 기기에는 MIDI 신호를 주고 받는 포트, 해당 신호를 처리하는 CPU, 사용자 프로그래밍이 가능한 인터페이스, 오디오 회로가 사운드를 생성하는 컨트롤러가 있습니다.운영 체제와 공장의 소리는 대개 ROM(Read Only Memory) 장치에 저장됩니다.[2]: 67–70

MIDI 기기는 일반 MIDI 사운드보드(GM, GS, XG), 전치, MIDI 기기 선택 및 음량 조절을 포함한 온보드 편집, 팬, 리버브 레벨 및 기타 MIDI 컨트롤러로 구성된 독립형 모듈(피아노 스타일 키보드 없이)일 수도 있습니다.일반적으로, MIDI 모듈은 화면을 포함하여, 사용자는 현재 선택된 기능에 대한 정보를 볼 수 있습니다.

신시사이저

신시사이저는 다양한 사운드 생성 기술 중 어느 것을 사용할 수 있습니다.통합 키보드를 포함하거나 MIDI 키보드와 같은 외부 컨트롤러에 의해 트리거될 때 소리를 발생시키는 사운드 모듈로 존재할 수 있습니다.사운드 모듈은 일반적으로 19인치 랙에 장착할 수 있도록 설계됩니다.[2]: 70–72 제조업체는 일반적으로 독립형 버전과 랙 장착형 버전으로 신디사이저를 생산하며, 키보드 버전을 다양한 크기로 제공하는 경우가 많습니다.

샘플러

샘플러는 오디오를 녹음하고 디지털화하여 RAM에 저장하고 재생할 수 있습니다.샘플러는 일반적으로 사용자가 샘플을 편집하여 하드 디스크에 저장하고, 효과를 적용하고, 감산적 신디사이저가 사용하는 것과 동일한 도구로 모양을 만들 수 있습니다.키보드 또는 랙 장착 형태로도 사용할 수 있습니다.[2]: 74–8 샘플 재생을 통해 소리를 생성하지만 녹음 기능이 없는 악기를 "ROMplers"라고 합니다.

샘플러는 당시 메모리와 처리 능력의 비용 때문에 신디사이저처럼 빠르게 실행 가능한 MIDI 기기로 자리 잡지 못했습니다.[15]: 295 최초의 저가형 MIDI 샘플러는 1984년에 소개된 Ensoniq Mirage입니다.[15]: 304 MIDI 샘플러는 일반적으로 샘플링된 파형을 편집하기에 너무 작은 디스플레이로 제한되지만 일부는 컴퓨터 모니터에 연결할 수 있습니다.[15]: 305

드럼머신

드럼 머신은 일반적으로 드럼 및 타악기 사운드를 전문으로 하는 샘플 재생 장치입니다.그들은 일반적으로 드럼 패턴을 만들고 그것들을 노래로 편곡할 수 있게 해주는 시퀀서를 포함합니다.오디오 출력이 여러 개인 경우가 많기 때문에 각 소리 또는 소리 그룹을 개별 출력으로 라우팅할 수 있습니다.개별 드럼 음성은 다른 MIDI 기기나 시퀀서에서 재생할 수 있습니다.[2]: 84

워크스테이션 및 하드웨어 시퀀서

시퀀서 기술은 MIDI보다 앞선 기술입니다. 아날로그 시퀀서는 CV/Gate 신호를 사용하여 Pre-MIDI 아날로그 합성기를 제어합니다.MIDI 시퀀서는 일반적으로 테이프 데크의 전송 기능을 본뜬 전송 기능으로 작동합니다.멀티트랙 레코딩 패러다임을 사용하여 미디 퍼포먼스를 레코딩하고 개별 트랙으로 정렬할 수 있습니다.음악 워크스테이션은 컨트롤러 키보드와 내장 사운드 생성 및 시퀀서를 결합합니다.이것들은 완전한 편곡을 만들고 자신의 내부 사운드를 사용하여 재생하는 데 사용될 수 있으며, 자체적으로 음악 제작 스튜디오로서 기능합니다.일반적으로 파일 저장 및 전송 기능을 포함합니다.[2]: 103–4

효과 단위

일부 효과 단위는 MIDI를 통해 원격 제어가 가능합니다.예를 들어 Eventide H3000 Ultra-harmonizer는 신디사이저로 재생할 수 있을 정도로 광범위한 MIDI 제어를 가능하게 합니다.[15]: 322 페달 형식의 드럼 머신인 Drum Buddy는 속도를 루퍼 페달과 동기화하거나 지연과 같은 시간 기반의 효과를 얻을 수 있도록 MIDI 연결을 가지고 있습니다.

기술사양

이 기사는 특정 청중들만 흥미를 느낄 수 있는 과도한 양의 복잡한 세부사항을 포함하고 있을 수 있습니다. 에 수 을 삭제하여 을 주시기바랍니다. (2020년 2월)( 메시지를 및 |

MIDI 메시지는 초속 31.25kbit의 속도로 직렬로 전송되는 8비트 바이트로 구성됩니다.이 속도는 많은 초기 마이크로프로세서의 동작 속도인 1MHz의 정확한 분할이기 때문에 선택되었습니다.[15]: 286 각 단어의 첫 번째 비트는 바이트가 상태 바이트인지 데이터 바이트인지를 식별하고, 그 다음에 7비트의 정보가 표시됩니다.[2]: 13–14 각 바이트에는 프레이밍을 위해 시작 비트와 정지 비트가 추가되므로 전송을 위해 MIDI 바이트에는 10비트가 필요합니다.[15]: 286

MIDI 링크는 16개의 독립적인 정보 채널을 전달할 수 있습니다.채널 번호는 1~16번입니다.장치는 특정 채널만 청취하고 다른 채널로 전송된 메시지를 무시하도록 구성하거나(옴니 오프 모드), 모든 채널을 청취할 수 있으므로 채널 주소(옴니온)를 효과적으로 무시할 수 있습니다.개별 장치는 단음계(새로운 노트 온 MIDI 명령의 시작은 이전 노트의 종료를 의미함) 또는 다음계(기기의 다음계 한계에 도달할 때까지 여러 노트가 한 번에 울리거나 노트가 감쇠 엔벨로프 끝에 도달하거나 명시적 노트 오프 MIDI 명령이 수신될 때까지 여러 노트가 동시에 울릴 수 있음)일 수 있습니다.수신 장치는 일반적으로 옴니 오프/온 및 모노/폴리 모드의 네 가지 조합으로 모두 설정할 수 있습니다.[2]: 14–18

메시지

MIDI 메시지는 수신 장치의 일부를 제어하는 명령어입니다.MIDI 메시지는 메시지 유형을 나타내는 상태 바이트와 매개 변수를 포함하는 최대 2개의 데이터 바이트로 구성됩니다.[36]MIDI 메시지는 16개 채널 중 하나의 채널에서만 전송되고 해당 채널의 장치에서만 모니터링되는 채널 메시지이거나 모든 장치가 수신하는 시스템 메시지일 수 있습니다.각 수신 장치는 자신의 기능과 관련이 없는 데이터를 무시합니다.[67]: 384 메시지에는 다섯 가지 유형이 있습니다.Channel Voice, Channel Mode, System Common,[98] System Real-Time, System Exclusive.

채널 음성 메시지는 단일 채널을 통해 실시간 성능 데이터를 전송합니다.음의 음정을 나타내는 MIDI 음표 번호, 음이 얼마나 강하게 재생되었는지를 나타내는 속도 값을 포함하는 노트 온 메시지 등이 그 예입니다.및 채널 번호, 노트를 종료하는 노트 오프 메시지, 장치의 패치를 변경하는 프로그램 변경 메시지, 계측기의 파라미터를 조정할 수 있는 제어 변경 메시지.MIDI 노트는 C부터−1 G까지9 할당된 0부터 127까지 번호가 매겨집니다.이는 880 노트 피아노8 범위를 넘어 A에서 C까지 확장되며 8.175799~12543.85Hz의 주파수 범위에 해당합니다.[b]

시스템 전용 메시지

시스템 독점(SysEx) 메시지는 MIDI 표준의 유연성과 수명에 주요한 이유입니다.제조업체들은 표준 MIDI 메시지보다 더 철저하게 장비를 제어하는 독점 메시지를 만들기 위해 이 메시지를 사용합니다.[15]: 287 SysEx 메시지는 어떤 음이 재생되고 얼마나 큰지와 같은 성능 데이터가 아니라 MIDI 프로토콜을 사용하여 신디사이저의 매개 변수에 대한 정보를 보냅니다.SysEx 메시지는 시스템의 특정 장치로 주소가 지정됩니다.각 제조업체에는 SysEx 메시지에 포함된 고유 식별자가 있으므로 대상 장치만 메시지에 응답하고 나머지 장치는 모두 무시할 수 있습니다.많은 계측기에는 SysEx ID 설정도 포함되어 있으므로 컨트롤러가 동일한 모델의 장치 두 개를 독립적으로 어드레싱할 수 있습니다.[99]SysEx 메시지는 MIDI 표준이 제공하는 것 이상의 기능을 포함할 수 있습니다.

구현도

장치는 일반적으로 MIDI 규격에 의해 정의된 모든 유형의 메시지에 응답하지 않습니다.MMA는 사용자가 기기가 어떤 구체적인 기능을 가지고 있는지, 메시지에 어떻게 반응하는지를 확인할 수 있는 방법으로 미디 구현 차트를 표준화하였습니다.[2]: 231 특정 MIDI 구현 차트는 보통 각 MIDI 장치에 대해 장치 설명서 내에 게시됩니다.

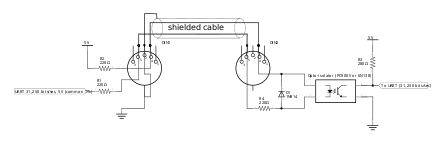

전기사양

전기적 인터페이스를 위한 MIDI 1.0 사양은 완전히 절연된 전류 루프를 기반으로 합니다.MIDI 아웃 포트는 MIDI 아웃 DIN 커넥터의 핀 4, 수신 장치의 MIDI 인 DIN 커넥터의 핀 4, 220 옴 보호 저항 및 옵토 아이솔레이터의 LED를 통해 +5 전압 소스를 명목적으로[c] 공급합니다.그러면 전류는 포트의 MIDI의 핀 5를 통해 원래 장치의 MIDI 아웃 포트 핀 5로 되돌아갑니다. 경로에는 220옴 저항기가 있어 약 5밀리암페어의 공칭 전류를 제공합니다.광 격리기는 갈바닉 격리를 제공하여 두 개의 MIDI 장치 사이에 전도성 경로가 없습니다.따라서 적절하게 설계된 미디 장치는 접지 루프와 유사한 간섭에 상대적으로 영향을 받지 않습니다.이 시스템의 보레이트는 초당 31,250 심볼이며 로직 0은 현재 켜져 있습니다.[100]

MIDI 규격은 핀 2에 연결된 접지 "와이어"와 땋은 또는 호일 실드를 제공하여 핀 4와 5의 두 신호 전달 도체를 보호합니다.MIDI 케이블이 핀 2와 브레이드 또는 포일 실드를 섀시 접지에 연결하도록 되어 있지만, MIDI 아웃 포트에서만 연결해야 합니다. 포트의 MIDI는 핀 2를 연결하지 않고 분리된 상태로 유지해야 합니다.[100]일부 대형 MIDI 장치 제조업체는 최대 전압 격리를 위해 핀 위치 1, 2, 3에서 의도적으로 금속 도체를 생략한 변형된 MIDI 전용 DIN 5핀 소켓을 사용합니다.

확장자

MIDI의 유연성과 광범위한 채택은 표준의 많은 개선을 가져왔고, 원래 의도된 목적을 넘어서는 목적으로 응용을 가능하게 했습니다.

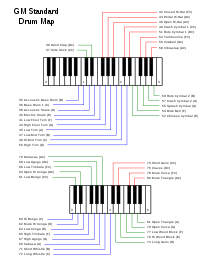

일반 MIDI

MIDI는 프로그램 변경 메시지를 통해 악기의 소리를 선택할 수 있지만, 주어진 프로그램 위치에서 두 악기의 소리가 동일하다는 보장은 없습니다.[101]프로그램 #0은 한 악기의 피아노이거나 다른 악기의 플루트일 수 있습니다.General MIDI (GM) 표준은 1991년에 제정되었으며, 한 장치에서 만들어진 표준 MIDI 파일이 다른 장치에서 재생될 때 비슷한 소리를 낼 수 있도록 표준화된 사운드 뱅크를 제공합니다.GM은 128개의 소리로 이루어진 뱅크를 8개의 관련 악기의 16개 패밀리로 배열하고 각 악기에 특정 프로그램 번호를 할당합니다.10번 채널에 타악기를 배치하고, 각 타악기 소리에 특정 MIDI 노트 값을 매핑합니다.GM 호환 장치는 24 노트 폴리포니를 제공해야 합니다.[102]주어진 프로그램 변경에 따라 GM 호환 기기에서 동일한 계측기 사운드가 선택됩니다.[103]

일반적인 MIDI는 '패치(patches)'라는 정의된 악기 소리의 표준 레이아웃으로 정의되며, '패치(patch)' 번호(프로그램 번호 – PC#)로 정의되며, MIDI 키보드의 키를 누르면 트리거됩니다.이 레이아웃을 통해 MIDI 사운드 모듈 및 기타 MIDI 장치는 사용자가 기대하는 지정된 사운드를 완벽하게 재현할 수 있으며 여러 제조사의 MIDI 장치에 걸쳐 신뢰성 있고 일관된 사운드 팔레트를 유지할 수 있습니다.[104]

GM 표준은 노트 매핑의 변동을 없앱니다.일부 제조업체는 어떤 노트 번호가 중간 C를 나타내야 하는지에 대해 의견이 일치하지 않았지만, GM은 69번 노트가 A440을 재생하도록 명시하고 있으며, 이는 중간 C를 60번 노트로 고정시킵니다. GM 호환 장치는 속도, 애프터터치 및 피치 벤딩에 반응하고 시동 시 지정된 기본값으로 설정되며 특정 컨트롤을 지원해야 합니다.r개의 숫자(예:[105] 유지 페달의 경우) 및 등록된 파라미터 번호).GM Lite라고 불리는 GM의 단순화된 버전은 제한된 처리 능력을 가진 휴대전화와 다른 장치에 사용됩니다.[101]

GS,XG,GM2

GM의 128개 악기 소리 세트가 충분히 크지 않다는 일반적인 의견이 빠르게 형성되었습니다.Roland의 General Standard, 즉 GS 시스템은 추가적인 사운드, 드럼킷 및 효과를 포함하고 있으며, 이를 액세스하는 데 사용할 수 있는 "뱅크 선택" 명령을 제공했으며, 새로운 기능에 액세스하기 위해 MIDI Non-Registered Parameter Numbers(NRPN)를 사용했습니다.1994년 야마하의 확장 일반 MIDI, 즉 XG가 그 뒤를 이었습니다.XG도 마찬가지로 추가 사운드, 드럼킷 및 효과를 제공하지만 편집을 위해 NRPN 대신 표준 컨트롤러를 사용하고 폴리포니를 32개의 음성으로 늘렸습니다.두 표준 모두 GM 사양과 역호환이 가능하지만 서로 호환되지 않습니다.[106]두 표준 모두 창작자 이상으로 채택되지 않았지만, 음악 소프트웨어 타이틀에서 공통적으로 지원됩니다.

일본 AMEI의 회원사들은 1999년에 General MIDI Level 2 규격을 개발하였습니다.GM2는 GM과 하위 호환성을 유지하지만 폴리포니를 32개의 음성으로 늘리고, Sostenuto와 소프트 페달(una corda), RPN 및 Universal System Exclusive Messages와 같은 여러 컨트롤러 번호를 표준화하며, MIDI Tuning Standard를 통합합니다.[107]GM2는 기기의 폴리포니를 처리 능력에 따라 확장할 수 있도록 하는 저전력 기기를 위한 MIDI 변형인 SP-MIDi(Scalable Polyphony MIDI)에서 기기 선택 메커니즘의 기본입니다.[101]

튜닝기준

대부분의 MIDI 신디사이저는 동등한 기질 튜닝을 사용합니다.1992년에 비준된 MTS(MIDI tuning standard)는 대체 튜닝을 허용합니다.[108]MTS는 최대 128개의 패치로 구성된 뱅크에서 마이크로 튜닝이 가능하며 노트 피치를 실시간으로 조정할 수 있습니다.[109]제조업체는 표준을 지원할 필요가 없습니다.그렇지 않은 사용자는 모든 기능을 구현할 필요가 없습니다.[108]

시간코드

시퀀서는 내부 클럭으로 MIDI 시스템을 구동할 수 있지만 시스템에 여러 개의 시퀀서가 있을 경우 공통 클럭에 동기화해야 합니다.Digidesign이 개발한 MTC(MIDI Time [110]Code)는 타이밍을 목적으로 개발된 SysEx 메시지를[111] 구현하며, SMPTE 타임코드 표준으로 번역 및 번역이 가능합니다.[15]: 288 MIDI Clock은 Tempo를 기반으로 하지만 SMPTE 타임 코드는 초당 프레임을 기반으로 하며 Tempo와 무관합니다.MTC는 SMPTE 코드와 마찬가지로 위치 정보를 포함하며 타이밍 펄스가 손실될 경우 자체 조정이 가능합니다.[112]마크 오브 더 유니콘의 MIDI 타임피스와 같은 MIDI 인터페이스는 SMPTE 코드를 MTC로 변환할 수 있습니다.[113]

기계제어

MMC(MIDI Machine Control)는 하드웨어 기록 장치의 전송 제어를 작동하는 SysEx 명령어[114] 세트로 구성됩니다.MMC를 사용하면 시퀀서가 시작, 중지 및 기록 명령을 연결된 테이프 데크 또는 하드 디스크 기록 시스템에 전송하고, 장치를 빨리 감기거나 되감기하여 시퀀서와 같은 지점에서 재생을 시작할 수 있습니다.장치가 MTC를 통해 동기화될 수 있지만 동기화 데이터는 포함되지 않습니다.[115]

컨트롤 표시

MSC(MIDI Show Control)는 조명, 음악 및 사운드 재생, 모션 제어 시스템과 같은 쇼 제어 장치의 시퀀스 및 원격 큐잉을 위한 SysEx 명령어 세트입니다.[117]응용 프로그램으로는 무대 제작, 박물관 전시, 녹음실 통제 시스템, 놀이공원 명소 등이 있습니다.[116]

타임스탬프 표시

MIDI 타이밍 문제에 대한 한 가지 해결책은 MIDI 이벤트를 재생할 시간으로 표시하고 그것을 MIDI 인터페이스의 버퍼에 미리 저장하는 것입니다.데이터를 미리 보내면 바쁜 통로가 전송 링크를 압도하는 많은 양의 정보를 보낼 가능성이 줄어듭니다.인터페이스에 저장된 정보는 더 이상 USB 지터 및 컴퓨터 운영 체제 인터럽트와 관련된 타이밍 문제의 영향을 받지 않으며 높은 정확도로 전송될 수 있습니다.[118]MIDI 타임스탬프는 하드웨어와 소프트웨어가 모두 지원할 때만 작동합니다.MOTU의 MTS, eMagic의 AMT, Steinberg의 Midex 8은 서로 호환되지 않는 구현을 가지고 있었으며, 사용자가 동일한 회사에서 제조한 소프트웨어와 하드웨어를 소유해야 작동할 수 있었습니다.[75]타임스탬프는 FireWire MIDI 인터페이스,[119] Mac OS X Core Audio, Linux ALSA Sequencer에 내장되어 있습니다.

시료덤프기준

SysEx 메시지의 예기치 못한 기능 중 하나는 기기 간 오디오 샘플을 전송하는 데 사용했다는 것입니다.이로 인해 샘플 덤프 표준(SDS)이 개발되었고, 이를 통해 샘플 전송을 위한 새로운 SysEx 형식이 확립되었습니다.[15]: 287 나중에 SDS는 샘플 전체를 전송할 필요 없이 샘플 루프 포인트에 대한 정보를 전송할 수 있는 한 쌍의 명령어로 증강되었습니다.[120]

다운로드 가능한 사운드

1997년에 비준된 DLS(Downloadable Sounds) 규격은 모바일 장치와 컴퓨터 사운드 카드가 다운로드 가능한 사운드 세트로 웨이브 테이블을 확장할 수 있도록 합니다.[121]DLS Level 2 Specification은 2006년에 이어 표준화된 신디사이저 아키텍처를 정의했습니다.Mobile DLS 표준은 DLS 은행을 SP-MIDi와 결합하여 자체 포함 Mobile XMF 파일로 만들 것을 요구합니다.[122]

MIDI 폴리포닉 표현

MPE(MIDI Polyphonic Expression)는 음정을 연속적으로 조절할 수 있도록 하는 MIDI를 사용하는 방법입니다.[123]MPE는 각 노트에 개별적으로 특정 메시지를 적용할 수 있도록 자체 MIDI 채널에 각 노트를 할당하여 동작합니다.[124][123]사양은 AMEI에 의해 2017년 11월에, MMA에 의해 2018년 1월에 발표되었습니다.[125] 컨티뉴엄 핑거보드, 린악기, 롤리 시보드, 센스엘 모프 및 아이겐하프와 같은 악기는 사용자가 코드 내의 개별 음에 대한 음정, 음색 및 기타 뉘앙스를 제어할 수 있도록 합니다.[126]

대체 하드웨어 전송

5핀 DIN으로 전송되는 원래의 31.25 kbit/s 전류 루프 외에도, 동일한 전기 데이터 및 USB, IEEE 1394 a.k.a를 통한 다양한 형태의 MIDI 스트림 전송을 위해 다른 커넥터가 사용되었습니다.FireWire 및 이더넷은 이제 일반적입니다.일부 샘플러와 하드 드라이브 레코더는 SCSI를 통해 서로 간에 MIDI 데이터를 전달할 수도 있습니다.

USB 및 FireWire

1999년 USB-IF의 구성원들은 USB를 통한 MIDI를 위한 표준을 개발하였으며, "MIDI 장치를 위한 범용 직렬 버스 장치 클래스 정의"[127] USB를 통한 MIDI는 MIDI 연결에 사용되던 다른 인터페이스들(직렬, 조이스틱 등)이 개인용 컴퓨터에서 사라지면서 점점 더 보편화되었습니다.Linux, Microsoft Windows, Macintosh OS X 및 Apple iOS 운영 체제에는 "MIDI 장치용 범용 직렬 버스 장치 클래스 정의"를 사용하는 장치를 지원하는 표준 클래스 드라이버가 포함되어 있습니다.일부 제조업체는 사용자 지정 드라이버를 사용하여 클래스 사양과 다르게 작동하도록 설계된 USB를 통해 MIDI 인터페이스를 구현하기를 선택합니다.

애플 컴퓨터는 1990년대에 파이어와이어 인터페이스를 개발했습니다.10년 말 무렵부터 디지털 비디오 카메라에 등장하기 시작했고 1999년에는 G3 매킨토시 모델에 등장했습니다.[128]멀티미디어 응용프로그램과 함께 사용하기 위해 개발되었습니다.[119]USB와 달리 메인 CPU의 신경을 쓰지 않고 스스로 전송을 관리할 수 있는 지능형 컨트롤러를 사용하는 파이어와이어는 기존의 MIDI 장치와 마찬가지로 컴퓨터가 없어도 통신이 가능합니다.[129][130]

XLR 커넥터

Octave-Platau Voyetra-8 신디사이저는 5핀 DIN 대신 XLR3 커넥터를 사용한 초기의 미디 구현이었습니다.MIDI 이전에 출시되었으며 나중에 MIDI 인터페이스로 개조되었지만 XLR 커넥터는 유지했습니다.[131]

직렬 병렬 및 조이스틱 포트

컴퓨터 기반 스튜디오 설정이 보편화되면서 컴퓨터에 직접 연결할 수 있는 미디 장치를 사용할 수 있게 되었습니다.이들은 일반적으로 Blue & White G3 모델이 출시되기 전에 애플이 직렬 포트에 사용했던 8핀 미니 DIN 커넥터를 사용했습니다.유니콘 MIDI Time Piece의 마크와 같이 스튜디오의 중심축으로 사용하기 위한 MIDI 인터페이스는 표준 MIDI 속도의 20배로 작동하는 직렬 포트의 기능을 활용할 수 있는 "빠른" 전송 모드에 의해 가능해졌습니다.[2]: 62–3 [130]미니-DIN 포트는 1990년대 후반의 몇몇 미디 기기에 내장되었고, 그러한 기기들을 컴퓨터에 직접 연결할 수 있게 했습니다.[132]PC의 DB-25 병렬 포트 또는 많은 PC 사운드 카드에 있는 조이스틱 포트를 통해 연결된 장치도 있습니다.[130]

mLAN

야마하는 1999년에 mLAN 프로토콜을 도입했습니다.FireWire를 운송수단으로 사용하는 악기의 근거리 통신망으로 구상되었으며, 다채널 디지털 오디오, 데이터 파일 전송, 타임 코드와 함께 여러 개의 MIDI 채널을 운반할 수 있도록 설계되었으며,[128][129] mLan은 여러 야마하 제품에 사용되었으며, 특히 디지털 믹싱 콘솔과 Motif 신디사이저,그리고 PreSonus FIREstation과 Korg Triton Studio와 같은 타사 제품에서.[133]2007년 이후로 새로운 mlan 제품이 출시되지 않았습니다.

이더넷과 인터넷

MIDI의 컴퓨터 네트워크 구현은 네트워크 라우팅 기능을 제공하며 ZIPI와 같은 MIDI의 이전 대안들이 도입하고자 했던 고대역폭 채널을 제공합니다.1980년대부터 독점적인 구현이 존재해 왔으며, 그 중 일부는 전송을 위해 광섬유 케이블을 사용합니다.[2]: 53–4 인터넷 엔지니어링 태스크 포스의 RTP-MIDi 공개 사양은 업계의 지지를 받았습니다.Apple은 Mac OS X 10.4 이후 버전부터 이 프로토콜을 지원했으며 Windows XP 이상 버전에는 Apple의 구현을 기반으로 하는 Windows 드라이버가 있습니다.[134]

무선

무선 MIDI 전송을 위한 시스템은 1980년대부터 사용되었습니다.[2]: 44 Wi-Fi 및 Bluetooth를 통해 MIDI 및 OSC 신호를 무선으로 전송할 수 있는 여러 상용 송신기가 있으며,[135] iOS 기기는 Wi-Fi 및 OSC를 사용하여 MIDI 제어면 역할을 수행할 수 있습니다.[136]XBee 라디오는 무선 MIDI 송수신기를 Do-it-yourself 프로젝트로 제작할 수 있습니다.[137]Android 장치는 Wi-Fi 및 Bluetooth를 통해 여러 가지 프로토콜을 사용하여 완전한 MIDI 제어 표면으로 기능할 수 있습니다.[138]

TRS 미니잭

일부 장치는 MIDI 데이터를 위해 표준 3.5mm TRS 오디오 미니잭 커넥터를 사용하며, 여기에는 Korg Electribe 2와 Arturia Beatstep Pro가 포함됩니다.둘 다 표준 5핀 DIN 커넥터에 연결되는 어댑터와 함께 제공됩니다.[citation needed][139]이는 MIDI 제조자 협회가 배선을 표준화할 정도로 널리 퍼졌습니다.[140]또한 MIDI-over-minijack 표준 문서에서는 오디오 커넥터와의 혼동을 피하기 위해 3.5mm 커넥터보다 2.5mm 커넥터를 사용할 것을 권장합니다.[141]

미디 2.0

이 기사는 특정 청중들만 흥미를 느낄 수 있는 과도한 양의 복잡한 세부사항을 포함하고 있을 수 있습니다. 에 수 을 삭제하여 을 주시기바랍니다. (2020년 2월)( 메시지를 및 |

MIDI 2.0 표준은 2020년 1월 17일 미국 캘리포니아주 애너하임에서 열린 윈터 NAMM 쇼에서 공개되었습니다.야마하, 롤리, 마이크로소프트, 구글, 그리고 MIDI 협회의 대표들은 역호환성을 유지하면서 양방향 통신을 가능하게 하는 업데이트를 소개했습니다.[142][143]

새로운 프로토콜에 대한 연구는 2005년에 시작되었습니다.[55][144][145]NAMM에서는 유무선 연결을 보여주는 시제품 기기를 비공개로 선보였는데,[144][146] 출시 예정일은 발표하지 않았지만 라이선스 및 제품 인증 정책이 개발되었습니다.[147]제안된 물리 계층 및 전송 계층에는 RTP MIDI 및 Audio Video Bridging/Time-Sensitive Networking과 [130]같은 이더넷 기반 프로토콜과 UDP(User Dataagram Protocol) 기반 전송이 포함되었습니다.[145]

AMEI와 MMA는 구글, 야마하, 스타인버그, 롤랜드, 에이블턴, 네이티브 인스트루먼츠, 롤리 등 주요 제조사의 프로토타입 구현에 대한 상호운용성 테스트 후 완전한 사양이 공개될 것이라고 발표했습니다.[22][125][148]2020년 1월, 롤랜드는 A-88mk를 발표했습니다.MIDI 2.[149]0을 지원하는 II 컨트롤러 키보드

MIDI 2.0은 속성 교환 및 프로파일을 위한 MIDI Capability Inquiry 사양과 MIDI 1.0 및 MIDI 2.0 음성 메시지를 모두 지원하는 고속 전송을 위한 새로운 Universal MIDI Packet 포맷을 포함하고 있습니다.

MIDI 1.0을 운영하는 일부 장치는 일부 2.0 기능을 "리트로핏"할 수 있습니다.2020년 1월 초에 MIDI 제조자 협회에 의해 출시된 이후, 새로운 업데이트에 대한 더 자세한 사항은 아직 나오지 않았습니다.현재 MIDI에는 M2-100-U v1.0 MIDI 2.0 규격 개요, M2-101-UM v1.1 MIDI-CI 규격, M2-102-U v1.0 MIDI-CI 프로파일 공통규칙, M2-103-UM v1.0 MIDI-CI PE 및 M2-104-UM v1.0 UMP 및 MIDI 2.0 프로토콜 규격 등 5가지 구성요소가 있습니다.MIDI 2.0과 관련된 다른 사양으로는 32,000개의 컨트롤러를 사용할 수 있고 넓은 음역의 음역이 향상되었습니다.이러한 향상된 기능은 부동산 교환을 통해 더욱 향상됩니다.[150]

부동산교환

MIDI 2.0의 속성 교환은 JSON 또는 자바스크립트 객체 표기법을 사용합니다.이것은 데이터 세트를 교환하기 위해 사람이 읽을 수 있는 형식을 제공합니다.이를 통해 MIDI 2.0의 다양한 기능을 제공할 수 있습니다. JSON을 사용하면 키보드, 피아노 또는 기타 전기 장치에 상관없이 플러그인이 연결된 장치가 작동하는 사람이 새 장치를 작동할 때마다 설정을 변경하도록 하는 대신 무엇을 하고 있는지, 무엇을 할 수 있는지를 설명할 수 있습니다.예를 들어, 특정한 MIDI 설정이 있는 iOS 기기에 연결된 MIDI 키보드는 이제 Windows 기기에 연결할 수 있으며 수동으로 설정을 변경할 필요가 없습니다.한 장치에 사용되는 모든 음악 구성 요소는 보관되며 다른 장치에서는 자동으로 변경될 수 있습니다.[150]

MIDI capability 문의

MIDI-CI(MIDI Capability Inquiry)는 디바이스 프로파일, 파라미터 교환, MIDI 프로토콜 협상을 구현하기 위한 Universal SysEx 메시지를 지정합니다.[125]사양은 2017년 11월 AMEI에 의해, 2018년 1월 MMA에 의해 공개되었습니다.

매개 변수 교환은 지원되는 컨트롤러, 패치 이름, 계측기 프로파일, 디바이스 구성 및 기타 메타데이터와 같은 디바이스 기능을 조회하고 디바이스 구성 설정을 가져오거나 설정하는 방법을 정의합니다.속성 교환은 JSON 형식의 데이터를 전달하는 System Exclusive 메시지를 사용합니다.프로파일은 드로우바 오르간 및 아날로그 신스와 같은 다양한 기기 유형 또는 여러 제조업체의 기기 간 상호 운용성을 향상시키는 특정 작업을 위한 공통 MIDI 컨트롤러 세트를 정의합니다.프로토콜 협상을 통해 장치는 차세대 프로토콜이나 제조업체별 프로토콜을 사용할 수 있습니다.[148]

범용 MIDI 패킷

MIDI 2.0은 페이로드 유형에 따라 다양한 길이(32, 64, 96 또는 128비트)의 메시지를 포함하는 새로운 Universal MIDI Packet 형식을 정의합니다.이 새로운 패킷 포맷은 총 256개의 MIDI 채널을 지원하며, 16개의 채널 그룹으로 구성되어 있으며, 각 그룹은 MIDI 1.0 Protocol 스트림 또는 새로운 MIDI 2.0 Protocol 스트림을 전달할 수 있으며, 또한 시스템 메시지, 시스템 전용 데이터 및 타임스탬프를 포함하여 여러 개의 동시 노트를 정확하게 렌더링할 수 있습니다.초기 도입을 단순화하기 위해 기존 제품은 명시적으로 MIDI 1.0 메시지만 구현할 수 있도록 했습니다.Universal MIDI Packet은 USB 및 이더넷과 같은 고속 전송을 위한 것으로 기존의 5핀 DIN 연결에서는 지원되지 않습니다.[148]System Real-Time 및 System Common 메시지는 MIDI 1.0에 정의된 내용과 동일합니다.[148]

뉴프로토콜

2019년 1월 기준으로, 새로운 프로토콜의 초안은 MIDI 1.0에 존재하는 모든 핵심 메시지를 지원하지만 정밀도와 해상도를 확장합니다. 또한 많은 새로운 고정밀 컨트롤러 메시지를 정의합니다.[148]규격은 서로 다른 데이터 해상도를 사용하는 MIDI 2.0 Channel Voice와 MIDI 1.0 Channel Voice 메시지 간 변환을 위한 기본 변환 규칙을 정의하며, 256개의 MIDI 2.0 스트림을 16개의 MIDI 1.0 스트림으로 매핑합니다.[151][152]

데이터 전송 형식

System Exclusive 8 메시지는 Universal System Exclusive 메시지에 기반한 새로운 8비트 데이터 형식을 사용합니다.Mixed Data Set 메시지는 대용량 데이터 세트를 전송하기 위한 것입니다.System Exclusive 7 메시지는 이전의 7비트 데이터 형식을 사용합니다.[148]

참고 항목

- ABC 표기법

- 디지털피아노

- 전자 드럼 모듈

- 기타 신시사이저

- 음악 소프트웨어 목록

- 미디 목업

- 뮤직XML

- 음악 매크로 언어

- 오픈 사운드 컨트롤

- 사운드폰트

- 악보작성자

- 신시아

- 합성 음악 모바일 어플리케이션 포맷

메모들

참고문헌

- ^ Swift, Andrew. (May 1997), "A brief Introduction to MIDI", SURPRISE, Imperial College of Science Technology and Medicine, archived from the original on 30 August 2012, retrieved 22 August 2012

- ^ a b c d e f g h i j k l m n o p q r s t u v w x y z Huber, David Miles (1991). The MIDI Manual. Carmel, Indiana: SAMS. ISBN 978-0-672-22757-8.

- ^ "What is MIDI?". Archived from the original on 16 June 2016. Retrieved 31 August 2016.

- ^ samples, Electronic Musician – featuring gear reviews, audio tutorials, loops and. "The MIDI Association Launches at NAMM 2016". Archived from the original on 14 October 2016. Retrieved 31 August 2016.

{{cite web}}: CS1 유지 : 여러 이름 : 저자 목록 (링크) - ^ a b c d e Chadabe, Joel (1 May 2000). "Part IV: The Seeds of the Future". Electronic Musician. Penton Media. XVI (5). Archived from the original on 28 September 2012.

- ^ a b c Kirn, Peter (2011). Keyboard Presents the Evolution of Electronic Dance Music. Backbeat Books. ISBN 978-1-61713-446-3. Archived from the original on 1 February 2017.

- ^ a b c "The life and times of Ikutaro Kakehashi, the Roland pioneer modern music owes everything to". FACT Magazine: Music News, New Music. 2 April 2017. Retrieved 6 September 2018.

- ^ a b "Historical Early MIDI Documents Uncovered". www.midi.org. Retrieved 18 January 2020.

- ^ Smith, Dave; Wood, Chet (1 October 1981). "The 'USI', or Universal Synthesizer Interface". Audio Engineering Society.

- ^ "MIDI History:Chapter 6-MIDI Is Born 1980–1983". www.midi.org. Retrieved 3 January 2023.

- ^ a b Huber, David Miles (1991). The MIDI Manual. Carmel, Indiana: SAMS. ISBN 978-0-672-22757-8.

- ^ Chadabe, Joel (1 May 2000). "Part IV: The Seeds of the Future". Electronic Musician. Penton Media. XVI (5). Archived from the original on 28 September 2012.

- ^ a b c d e 홈즈, 톰.전자음악과 실험음악: 기술과 작곡의 선구자들뉴욕: 루틀리지, 2003

- ^ a b "Dave Smith". KeyboardMag. Retrieved 20 October 2018.

- ^ a b c d e f g h i j k l m n o 매닝, 피터.전자음악과 컴퓨터음악. 1985.옥스포드:옥스퍼드 대학 출판부, 1994.프린트.

- ^ "Technical GRAMMY Award: Ikutaro Kakehashi And Dave Smith". Archived from the original on 22 August 2016. Retrieved 31 August 2016.

- ^ "Ikutaro Kakehashi, Dave Smith: Technical GRAMMY Award Acceptance". 9 February 2013. Archived from the original on 9 December 2014. Retrieved 31 August 2016.

- ^ Vail, Mark (2014). The Synthesizer. New York: Oxford University Press. p. 56. ISBN 978-0-19-539481-8.

- ^ Martin Russ (2004). Sound Synthesis and Sampling. Taylor & Francis. p. 66. ISBN 0-240-51692-3. Archived from the original on 26 October 2017.

- ^ Butler, Mark Jonathan (2006). Unlocking the Groove: Rhythm, Meter, and Musical Design in Electronic Dance Music. Indiana University Press. p. 64. ISBN 0-2533-4662-2.

- ^ "Roland - Company - History - History". Archived from the original on 12 July 2017. Retrieved 17 May 2017.

- ^ a b "The MIDI Manufacturers Association (MMA) and the Association of Music Electronics Industry (AMEI) announce MIDI 2.0™ Prototyping". www.midi.org. Archived from the original on 10 February 2019. Retrieved 20 January 2019.

- ^ Kopf, Dan (30 January 2020). "An Update to a 37-Year-Old Digital Protocol Could Profoundly Change the Way Music Sounds". Quartz. Retrieved 3 February 2020.

- ^ "How MIDI changed the world of music". BBC News. 28 November 2012. Retrieved 4 July 2022.

- ^ Paul, Craner (October 1991). "New Tool for an Ancient Art: The Computer and Music". Computers and the Humanities. 25 (5): 308–309. doi:10.1007/bf00120967. JSTOR 30204425. S2CID 60991034.

- ^ 매칸, 에드워드.락킹 더 클래식: 영국 프로그레시브 록과 카운터컬쳐.뉴욕: 옥스퍼드 대학 출판부, 1997. p.191

- ^ 슈커, 로이.대중음악의 이해.런던: 루틀리지, 1994. p.286

- ^ 데모레스트, 스티븐 M.빌딩 합창 우수성: 합창 리허설에서 시창을 가르칩니다.뉴욕: 옥스퍼드 대학 출판부, 2003. p. 17.

- ^ 퍼터아웃, 안드리안.Mixdown Monthly Archived 2012년 5월 4일 Wayback Machine, #26. 1996년 6월 26일.웹. 2012년 8월 22일

- ^ Stokes, William (3 June 2022). "Dave Smith: the synth genius who made pop's instruments work in harmony". The Guardian. Retrieved 5 June 2022.

- ^ a b 라우, 폴."왜 아직도 MIDI인가요?" – 하이빔 리서치를 통해(구독 필요) 2013년 5월 2일 Wayback Machine Canadian Musician에서 보관.Norris-Whitney Communications Inc. 2008.하이빔 연구 2012년 9월 4일

- ^ Sasso, Len (13 October 2011). "Sound Programming 101". Electronic Musician. NewBay Media. Archived from the original on 17 March 2012.

- ^ Anderton, Craig (May 1995). "MIDI For Guitarists: A Crash Course In MIDI Effects Control". Sound on Sound. SOS Publications. Archived from the original on 10 January 2012.

- ^ "Digital audio workstation – Intro". Archived from the original on 10 January 2012.

- ^ Forbes, Peter (14 March 2002). "PCs hit the write note". The Guardian. Retrieved 1 July 2022.

- ^ a b c 브루스터, 스티븐."비음화 청각 출력".인간-컴퓨터 상호작용 핸드북: 기본, 진화하는 기술 및 새롭게 등장하는 애플리케이션.편집: 줄리 A.Jacko; Andrew Sears.Mahwah: Lawrence Erlbaum Associates, 2003. p.227

- ^ 캠벨, 드류 "클릭, 클릭."오디오" 스테이지 사용법.Vol. 16, No. 3.2003년 3월.

- ^ 맥커찬, 앤.노래하는 뮤즈: 작곡가들은 창작 과정에 대해 말합니다.뉴욕: 옥스퍼드 대학 출판부, 1999. 67-68, 72쪽

- ^ a b Russ, Martin (2012). Sound Synthesis and Sampling. CRC Press. p. 192. ISBN 978-1-136-12214-9. Archived from the original on 28 April 2017. Retrieved 26 April 2017.

- ^ Helen Casabona; David Frederick. Advanced MIDI Applications. Alfred Music. p. 15. ISBN 978-1-4574-3893-6. Archived from the original on 26 October 2017.

- ^ a b IBM PC용 MIDI 인터페이스 2015년 10월 21일 Wayback Machine, Electronic Musician, 1990년 9월

- ^ "Programming the MPU-401". www.piclist.com. Archived from the original on 6 May 2017.

- ^ Roland Corporation MIDI 프로세싱 유닛 MPU-401 기술 참조 매뉴얼

- ^ Peter Manning (2013), Electronic and Computer Music Archived at the Wayback Machine, Oxford University Press, 319페이지

- ^ "VIC-20 MIDI Cartridge". RETRO Innovations. Retrieved 28 February 2021.

- ^ "MIDI Maestro – RETRO Innovations". Retrieved 28 February 2021.

- ^ "Famimimidi Famicom Version". Catskull Electronics. Retrieved 28 February 2021.

- ^ "Teensyboy Pro". Catskull Electronics. Retrieved 28 February 2021.

- ^ "GBA MIDI Synth". Catskull Electronics. Retrieved 28 February 2021.

- ^ "genMDM". Catskull Electronics. Retrieved 28 February 2021.

- ^ a b c 크로포드, 월트 "MIDi and Wave: 언어 대처"온라인으로.제20권 1996년 1월 1일

- ^ Aboukhadijeh, Feross. (August 2018), Announcing BitMidi, retrieved 18 November 2018

- ^ "The Internet's First Hit File Format Wasn't the MP3. It Was MIDI". 8 November 2019. Retrieved 12 October 2020.

- ^ a b 위펜, 폴."신스 스쿨, 파트 3: 디지털 합성(FM, PD & VPM) 2005년 12월 1일 웨이백 머신에서 보관"사운드 온 사운드 1997년 9월프린트.

- ^ a b 바티노, 데이빗.마지막으로: Wayback Machine O'Reilly 디지털 미디어 블로그에서 2012년 8월 16일 MIDI 2.0 아카이브.오라일리 미디어 주식회사 2005년 10월 6일웹. 2012년 8월 22일

- ^ "midi". Apple Developer Documentation: Uniform Type Identifiers. Apple Inc.

- ^ "Standard MIDI Files (SMF) Specification". www.midi.org.

- ^ 하스, 제프리."제3장: Wayback Machine에서 MIDI가 작동하는 방법 10 2015년 6월 7일 아카이브"인디애나 대학교 제이콥스 음대.2010.웹 2012.8.13

- ^ "MIDI Files". midi.org. Music Manufacturers Association. Archived from the original on 22 August 2012.

a Type 2 was also specified originally but never really caught on

- ^ "RIFF 기반 MIDI 파일 포맷 2012년 8월 17일 웨이백 머신에서 아카이브" digitalpreservation.gov .의회도서관.2012년 3월 26일.웹. 2012년 8월 18일

- ^ 겔러맨, 엘리자베스"오디오 편집 SW, 멀티미디어 개발자 귀에 음악"테크니컬 호라이즌스 in Education Journal.제22권, 제2호.1994년9월

- ^ a b c 데스몬드, 피터.중등 음악 교과 과정의 ICT.중등 음악 교육의 측면: 실천에 대한 관점.ed. 게리 스프루스.뉴욕: 루틀리지 팔머, 2002

- ^ 솔로몬, 캐런."유 갓 필 더 뮤직 아카이브 2009년 8월 16일 웨이백 머신" wired.com콘데 나스트.2000년 2월 27일.웹. 2012년 8월 13일.

- ^ 쿡, 자넷 하니만."Musitek Midiscan v2.51 2012년 1월 10일 Wayback Machine에서 보관".사운드 온 사운드.SOS 출판물.1998년 12월.프린트.

- ^ Johnson, Derek (March 1999). "Yamaha FS1R Editor Software". Sound on Sound. Archived from the original on 25 December 2011.

- ^ Johnson, Derek; Poyser, Debbie (December 1998). "Yamaha FS1R". Sound on Sound. Archived from the original on 15 April 2007.

- ^ a b c 깁스, 조나단 (피터 하웰 목사) "일렉트로닉 뮤직"음향 녹음 실습, 4판에드. 존 보윅.옥스포드:옥스퍼드 대학교 출판부, 1996

- ^ "Sound Quest MIDI Quest 11 Universal Editor". squest.com. Archived from the original on 6 March 2014.

- ^ a b "Desktop Music Handbook – MIDI". cakewalk.com. Cakewalk, Inc. 26 November 2010. Archived from the original on 14 August 2012.

- ^ "Patch Base".

- ^ Price, Simon (July 2006). "Native Instruments Kore". Soundonsound.com. Sound on Sound. Archived from the original on 2 June 2013. Retrieved 27 November 2012.

- ^ 토종악기, 한국 단종

- ^ a b 보즈먼, 윌리엄 C.교육 기술: 미국 학교의 모범 사례.라치몬트:Eye on Education, 1999.

- ^ Lehrman, Paul D. (October 1995). "Software Synthesis: The Wave Of The Future?". Sound on Sound. SOS Publications. Archived from the original on 10 January 2012.

- ^ a b c Walker, Martin (March 2001). "Identifying & Solving PC MIDI & Audio Timing Problems". Sound on Sound. SOS Publications. Archived from the original on 10 January 2012.

- ^ a b Miller, Dennis (May 1997). "Sound Synthesis On A Computer, Part 2". Sound on Sound. SOS Publications. Archived from the original on 10 January 2012.

- ^ "MIDI Ancestors and Milestones". New Bay Media. Archived from the original on 30 October 2012.

- ^ Walker, Martin (November 1997). "Reality PC". Sound on Sound. SOS Publications. Archived from the original on 25 February 2015.

- ^ "Syntauri alphaSyntauri Vintage Synth Explorer".

- ^ Wherry, Mark (June 2003). "Creamware SCOPE". Sound on Sound. SOS Publications. Archived from the original on 25 December 2011.

- ^ Anderton, Craig. "Sonic Core SCOPE Xite-1". New Bay Media. Archived from the original on 30 October 2012.

- ^ 데이비드 니콜슨."하드웨어." – 하이빔 리서치를 통해(구독 필요) 2013년 5월 2일 Wayback Machine The Washington Post에서 보관.워싱턴 포스트 뉴스위크 인터랙티브. 1993.하이빔 연구 2012년 9월 4일

- ^ a b Levy, David S. "Aztech의 WavePower daughter card는 FM 수신을 향상시킵니다. (Aztech Labs Inc.의 Sound Blaster 16 또는 Sound Galaxy Pro 16 사운드 카드용 웨이브테이블 합성 애드온 카드) (하드웨어 리뷰) (Evaluation).2013년 5월 2일 웨이백 머신" 컴퓨터 쇼퍼에서 보관.SX2 Media Labs LLC. 1994.High Beam Research. 2012년 9월 4일 – High Beam Research를 통해 (구독 필요)

- ^ Labriola, Don. "MIDi 마스터즈: 웨이브테이블 합성은 저렴한 사운드 카드에 소닉 리얼리즘을 가져다 줍니다. (8개 악기 디지털 인터페이스 사운드 카드 검토) (테스트 방법론, 웨이브테이블 기술의 함정, 향후 웨이브테이블 개발에 관한 관련 기사 포함) (하드웨어 검토) (평가)" – HighBeam Research(구독 필요)를 통해 2013년 5월 2일 Wayback Machine Computer Shopper에서 보관.SX2 Media Labs LLC. 1994.하이빔 연구 2012년 9월 4일

- ^ "5 Pin DIN Electrical Specs". The MIDI Association. Retrieved 8 April 2021.

- ^ 락우드, 데이브."2012년 3월 20일 웨이백 머신에서 TC Electronic G Major 아카이브".사운드 온 사운드.SOS 출판물.2001년 12월.프린트.

- ^ 모닝턴-웨스트, 앨런."디지털 이론".녹음 연습.4판에드. 존 보윅.옥스포드:옥스퍼드 대학 출판부, 1996.

- ^ "Richmond Sound Design – 질문과 대답 2006년 1월 5일 Wayback Machine에서 보관".richmondsounddesign.com .웹. 2012년 8월 5일.

- ^ a b 하스, 제프리."제3장: MIDI 작동 원리 2 2015년 6월 17일 웨이백 머신에서 보관"인디애나 대학교 제이콥스 음대.2010.웹. 2012.8.13.

- ^ Julian Horsey (10 September 2019). "MIDI Router Control Center a modern reinvention of the MIDI router".

- ^ 로빈슨, 허비."Re: 코어 미디 타임스탬핑 2012년 10월 28일 웨이백 머신에서 아카이브".Apple Core 오디오-api 메일링 목록.Apple, Inc. 2005년 7월 18일. 2012년 8월 8일.

- ^ 시락, 롭 "2014년 3월 23일 웨이백 머신에서 보관된 유니콘의 마크"emusician.com .뉴베이 미디어. 2000년 10월 1일.웹. 2012년 8월 8일 검색.

- ^ "2012년 11월 18일 웨이백 머신에서 MIDi Performance Instruments Archived at the Wayback Machine.변화의 도구입니다.제3권, 제1호 (1999년 겨울)롤랜드사

- ^ "MIDI Products". MIDI Manufacturers Association. 1 August 1012. Archived from the original on 16 July 2012.

- ^ Lanier, Jaron (2011). You Are Not a Gadget. New York: Vintage. ISBN 978-0-307-38997-8.

- ^ 프레브, 프란시스."제1회 키보드 명예의 전당"에 실린 "데이브 스미스".키보드 (US). 뉴베이 미디어, LLC2012년 9월.인쇄. p.18

- ^ "Korg 레거시 컬렉션 2012년 9월 16일 웨이백 머신에서 보관".vintagesynth.com .빈티지 신스 익스플로러. n.d. 웹. 2012년 8월 21일

- ^ 하스, 제프리."제3장: MIDI 작동 방법 3 2015년 6월 19일 웨이백 머신에서 보관"인디애나 대학교 제이콥스 음대.2010.웹. 2012.8.13.

- ^ 하스, 제프리."제3장: Wayback Machine에서 MIDI가 작동하는 방법 9 2015년 6월 7일 아카이브"인디애나 대학교 제이콥스 음대.2010.웹. 2012.8.13.

- ^ a b MMA. "MIDI DIN Electrical Specification" (PDF). Archived (PDF) from the original on 22 December 2015. Retrieved 31 August 2016.

- ^ a b c 벨로, 후안 P. "MIDi: Wayback Machine에서 2012년 11월 20일에 보관된 사운드 컨트롤" nyu.edu .2012년 8월 18일 뉴욕 대학교 n.d. 웹

- ^ ""General MIDI Standard". www.harfesoft.de. n.p. n.d. Web". Harfesoft.de. Archived from the original on 28 August 2012. Retrieved 27 November 2012.

- ^ "General MIDI Standard Archived at the Wayback Machine", pgcc.edu프린스 조지스 커뮤니티 칼리지 n.d. 웹

- ^ Ialuna, John. "General MIDI (GM) Level 1 Sound Set". Hit Trax MIDI Files.

- ^ 글랫, 제프."General MIDI 2012년 10월 23일 웨이백 머신에서 보관".2012년 8월 17일 MIDI Technical Fanatic's Brainwashing Center. n.p. n.d. Web. 2012년 8월 17일

- ^ 나글, 폴.2012년 1월 10일 웨이백 머신에서 야마하 MU50 & 야마하 CBX-K1 보관.사운드 온 사운드.SOS 출판물.1995년 9월.프린트.

- ^ "Wayback Machine에서 2012년 1월 3일에 보관된 일반 MIDI에 대하여". midi.orgMIDI제조자협회. n.d. 웹. 2012년 8월 17일

- ^ a b "Wayback Machine에서 2012년 11월 18일 MIDI Tuning Standard Archived", microtonal-synthesis.com . n.p. n.d. Web. 2012년 8월 17일

- ^ "MIDI Tuning Messages". MIDI Manufacturers Association. 17 August 2012. Archived from the original on 30 November 2012.

- ^ 글랫, 제프."2012년 5월 1일 웨이백 머신에서 MIDI 아카이브의 시작"MIDI Technical Fanatic's Brainwashing Center. n.p. n.d. Web. 2012년 8월 13일.

- ^ 글랫, 제프."2012년 2월 12일 웨이백 머신에서 MIDi 타임 코드 아카이브".MIDI Technical Fanatic's Brainwashing Center. n.p. n.d. Web. 2012년 8월 13일.

- ^ 화이트, 폴."SMPTE & MTC (MIDi Time Code) 2012년 1월 10일 웨이백 머신에서 보관" 사운드 온 사운드.SOS 출판물.1996년 6월.프린트.

- ^ ""Q & A". Sweet Notes. Sweetwater Sound. Summer 1996. Web". Sweetwater.com. Archived from the original on 5 December 2012. Retrieved 27 November 2012.

- ^ 글랫, 제프."MMC(MIDi Machine Control) 2012년 11월 27일 웨이백 머신에서 보관".MIDI Technical Fanatic's Brainwashing Center. n.p. n.d. Web.

- ^ "용어집: MMC(MIDI Machine Control) 2012년 12월 5일 웨이백 머신에서 보관" sweetwater.com .스위트워터 사운드. n.d. 웹. 2012년 8월 15일.

- ^ a b "2012년 7월 17일 웨이백 머신에서 보관된 뉴스 페이지".richmondsounddesign.com .Richmond Sound Design, Ltd. 2012년 7월 17일웹. 2012년 8월 17일

- ^ "2012년 6월 21일 웨이백 머신에서 보관된 저렴한 MIDI 쇼 컨트롤 시스템"조명 기술 노트.버지니아 대학이요.2004년 10월 25일.웹. 2012년 8월 17일.

- ^ "용어집: MTS(MIDi Time Stamping) 2012년 12월 5일 웨이백 머신에서 보관". sweetwater.com . ".스위트워터 사운드. n.d. 웹. 2012년 8월 17일

- ^ a b 워커, 마틴."지연에 관한 진실: 2011년 12월 25일 웨이백 머신에서 파트 2 아카이브".사운드 온 사운드.SOS 출판물.2002년 10월.프린트.

- ^ 글랫, 제프.[1]. MIDI Technical Fanatic's Brainwashing Center. n.p. n.d. Web. 2012년 8월 13일.

- ^ "Massey, Howard. "DLS Overview". midi.org. n.d. Web. 27 Aug 2012". Midi.org. Archived from the original on 27 November 2012. Retrieved 27 November 2012.

- ^ ""DLS 1 Spec". midi.org. n.d. Web. 27 Aug 2012". Midi.org. Archived from the original on 30 November 2012. Retrieved 27 November 2012.

- ^ a b MIDI Manufacturers Association (January 2018). "MIDI Polyphonic Expression (MPE) Specification Adopted!". Archived from the original on 2 November 2017. Retrieved 12 February 2018.

- ^ Linn, Roger. "For Developers of MIDI Sound Generators: How to add MPE Capability". Archived from the original on 17 September 2016. Retrieved 8 September 2016.

- ^ a b c "MIDI Manufacturers Association (MMA) Adopts MIDI Capability Inquiry (MIDI-CI) Specification". www.midi.org.

- ^ Robair, Gino. "Three pioneers discuss Multidimensional Polyphonic Expression". ROLI. Electronic Musician. Retrieved 10 January 2019.

- ^ Ashour, Gal 등. usb.org USB 구현자 포럼 2015년 4월 26일 웨이백 머신에서 아카이브. 1999년 11월 1일.웹. 2012년 8월 22일

- ^ a b 위펜, 폴."Wayback Machine에서 2016년 1월 2일에 보관된 소개 TomLAN,사운드 온 사운드.SOS 출판물.2000년 8월.프린트.

- ^ a b 위펜, 폴."2012년 1월 10일 웨이백 머신에서 2부 보관된 소개 TomLAN".사운드 온 사운드.SOS 출판물.2000년 9월.프린트.

- ^ a b c d "MIDi Cables & Transports 2012년 11월 4일 Wayback Machine에서 보관". midi.org음악 제조업자 협회. n.d. 웹. 2012년 8월 27일.

- ^ Vail, Mark. "Voyetra 8: The original rackmount analog polysynth". Keyboardmagazine. Turtle Beach. Archived from the original on 30 June 2013. Retrieved 21 May 2013.

- ^ "CS2x Control Synthesizer 사용 설명서"Yamaha Corporation, 1998.

- ^ ""PreSonus FIREstation". presonus.com. n.p. n.d. Web. 18 Aug 2012". Presonus.com. Archived from the original on 31 December 2012. Retrieved 27 November 2012.

- ^ "rtpMIDi". tobias-erichsen.de .n.p.n.d. Web. 2012년 8월 22일 Windows RTP-MIDi 드라이버 다운로드 Wayback Machine에서 2012년 8월 16일 아카이브

- ^ 킨, 피터."Golden Age of Wireless: KorgiOS Sync, Android + MIDI 하드웨어, 블루투스 MIDI 입력?Wayback Machine"에서 2012년 9월 11일 보관. createdigitalmusic.com . n.p. 2011년 3월 25일.웹.

- ^ ""TouchOSC". hexler.net n.p. n.d. Web. 20 Aug 2012". Hexler.net. Archived from the original on 5 December 2012. Retrieved 27 November 2012.

- ^ "XBee 어댑터 – Wireless Arduino 프로그래밍이 2012년 6월 2일 Wayback Machine에서 보관됨".ladyada.net . n.p. 2011년 5월 17일.웹. 2012년 8월 20일.

- ^ "TouchDAW – DAW controller and MIDI utilities for Android™". Archived from the original on 7 September 2016. Retrieved 31 August 2016.

- ^ "What if we used stereo minijack cables for MIDI?". 26 August 2015.

- ^ "Specification for TRS Adapters Adopted and Released". www.midi.org.

- ^ "It's official: minijack connections are now kosher for MIDI". 21 August 2018.

- ^ "MIDI 2.0 at the 2020 NAMM Show". www.midi.org. Retrieved 18 January 2020.

- ^ "ADC 2019 Features MIDI 2.0 and more". www.midi.org. Retrieved 18 January 2020.

- ^ a b "MMA HD 프로토콜 발표 2011년 5월 14일 웨이백 머신에서 보관", midi.org .MIDI제조자협회. n.d. 웹. 2012년 8월 22일

- ^ a b "2012년 1월 9일 웨이백 머신에서 MMA 아카이브에 의한 MIDI 개발자를 위한 총회". pro-music-news.com친음악 뉴스 2012년 8월 22일 n.d.

- ^ "News: MIDI Manufacturers Association to Host Business Strategy Session on New Advanced Musical Instrument Control Technology at Winter NAMM Show". 17 January 2015. Archived from the original on 14 October 2016. Retrieved 31 August 2016.

- ^ "NAMM 2013: Panel discussion: Past, present and future of MIDI". Future Music. 4 February 2013. Archived from the original on 14 October 2016. Retrieved 31 August 2016 – via YouTube.

- ^ a b c d e f "Details about MIDI 2.0, MIDI-CI, Profiles and Property Exchange". www.midi.org.

- ^ Deahl, Dani (7 January 2020). "Roland's A-88MKII keyboard is a sign that MIDI 2.0 is on the way". The Verge.

- ^ a b "Details about MIDI 2.0™, MIDI-CI, Profiles and Property Exchange". The MIDI Association. Retrieved 21 September 2022.

- ^ "Mike Kent, Florian Bomers, & Brett Porter - Introduction to MIDI 2.0 - YouTube". www.youtube.com. Archived from the original on 11 December 2021.

- ^ "Arne Scheffler and Janne Roeper - Support of MIDI2 and MIDI-CI in VST3 instruments - YouTube". www.youtube.com. Archived from the original on 11 December 2021.

외부 링크

- MIDI

- MIDI제조사협회에서 영문 MIDI 규격을 다운로드 받을 수 있습니다.