MPEG-1

MPEG-1| 파일 이름 확장명 | .dat, .mpg, .mpeg, .mp1, .mp2, .mp3, .m1a, .m2a, .mpa, .mpv |

|---|---|

| 인터넷 미디어 유형 | 오디오/mpeg, 비디오/mpeg |

| 개발자 | MPEG(ISO/IEC JTC 1의 일부) |

| 초기 릴리즈 | 1991년 12월 6일[1] 전) |

| 최신 릴리즈 | ISO/IEC TR 11172-5:1998 1998년 10월; 전 |

| 형식 유형 | 오디오, 비디오, 컨테이너 |

| 연장 위치 | JPEG, H.261 |

| 까지 확장 | MPEG-2 |

| 표준 | ISO/IEC 11172 |

| 오픈 포맷? | 네 |

| 자유 형식? | 네 |

MPEG-1은 비디오와 오디오의 손실 압축에 대한 표준이다.과도한 품질 손실 없이 VHS급 원시 디지털 비디오와 CD 오디오를 약 1.5Mbit/s(각각 26:1, 6:1 압축비)[2]로 압축해 비디오 CD, 디지털 케이블/위성 TV, 디지털 오디오 방송(DAB) 등을 실용적으로 제작했다.[3][4]

오늘날, MPEG-1은 세계에서 가장 광범위하게 호환되는 손실 오디오/비디오 포맷이 되었고, 많은 제품과 기술에서 사용되고 있다.아마도 MPEG-1 표준에서 가장 잘 알려진 부분은 그것이 도입한 MP3 오디오 포맷의 첫 번째 버전일 것이다.

MPEG-1 표준은 ISO/IEC 11172 – Information Technology—최대 약 1.5 Mbit/s의 디지털 스토리지 미디어용 이동 사진 및 관련 오디오 코딩으로 발행된다.

표준은 다음과 같은 5가지 부분으로 구성된다.[5][6][7][8][9]

- 시스템(비디오, 오디오 및 기타 데이터의 저장 및 동기화)

- 비디오(압축된 비디오 콘텐츠)

- 오디오(압축된 오디오 콘텐츠)

- 적합성 테스트(표준 구현의 정확성 테스트)

- 참조 소프트웨어(표준에 따라 인코딩 및 디코딩하는 방법을 보여주는 소프트웨어 예)

역사

영상 부호화를 위한 MPEG-1의 전신은 CCITT(현재의 ITU-T)가 제작한 H.261 표준이었다.H.261에서 확립된 기본 아키텍처는 동작 보정 DCT 하이브리드 비디오 코딩 구조였다.[10][11]인코더에서 블록 기반 모션 추정을 하는 16×16 크기의 매크로블록과 디코더에서 인코더 선택 모션 벡터를 이용한 모션 보정을 사용하며, 8×8 크기의 이산 코사인 변환(DCT), 스칼라 정량화를 이용한 잔류 차이 코딩, 엔트로피 코딩용 가변 길이 코드(Huffman 코드와 같은)를 사용한다.[12]H.261은 최초의 실용적인 비디오 코딩 표준이었으며, 기술된 모든 설계 요소들이 MPEG-1에서도 사용되었다.[13]

공동사진전문가그룹과 CCITT의 전화분야 전문가그룹(각각 JPEG 영상압축표준과 H.261 영상회의표준 작성자)이 개발한 성공적인 협업접근법과 압축기술을 모델로 하여 MPEG(Moving Picture Experts Group) 워킹그룹을 설립하였다.1988년 1월, 야스다 히로시(Nippon Telegraphy and Telephone)와 레오나르도 치아리글리오네(CSELT)[14]의 주도로.MPEG는 표준 비디오 및 오디오 포맷의 필요성에 대처하고, 다소 복잡한 인코딩 방법(예를 들어 모션 벡터의 높은 정밀도를 지원)을 통해 보다 나은 품질을 얻기 위해 H.261을 기반으로 결성되었다.[3][15][16]

MPEG-1 표준의 개발은 1988년 5월에 시작되었다.개별 기업과 기관에서 평가를 위해 비디오 14건, 오디오 코덱 14건이 제출됐다.코덱은 1.5 Mbit/s의 데이터 전송 속도로 계산 복잡성과 주관적(인체 인식) 품질을 광범위하게 테스트했다.이 특정 비트 전송률은 T-1/E-1 라인을 통한 전송과 오디오 CD의 대략적인 데이터 전송 속도로 선택되었다.[17]이 테스트에서 뛰어난 코덱은 표준의 기초로 활용되었고, 추가 특징과 기타 개선사항이 프로세스에 통합되어 더욱 세분화되었다.[18]

전 세계 여러 도시에서 20차례의 풀그룹 회의와 4½년의 개발 및 시험 기간을 거쳐 1992년 11월 초 최종 표준(1~3부)이 승인되어 몇 달 후 발표되었다.[19]MPEG-1 표준의 보고된 완료일은 크게 달라지는데, 대체로 완전한 표준 초안이 1990년 9월에 제작되었고, 그 때부터 사소한 변경 사항만 도입되었다.[3]그 표준 초안은 공개적으로 구입할 수 있었다.[20]이 표준은 1992년 11월 6일 회의를 끝으로 완성되었다.[21]버클리 플래토 멀티미디어 연구 그룹은 1992년 11월에 MPEG-1 디코더를 개발했다.[22]MPEG-1 표준의 첫 번째 초안이 작성되기도 전인 1990년 7월, 두 번째 표준인 MPEG-2에 대한 작업은 [23]MPEG-1 기술을 확장하여 (CCIR 601에 따라) 높은 비트 전송률(3–15 Mbit/s)으로 완전한 방송 품질의 비디오를 제공하고 인터레이스 비디오를 지원하려는 의도로 시작되었다.[24]두 코덱 간의 유사성 때문에 MPEG-2 표준은 MPEG-1 비디오와의 역호환성을 완전히 포함하므로 모든 MPEG-2 디코더가 MPEG-1 비디오를 재생할 수 있다.[25]

특히 MPEG-1 표준은 비트스트림, 디코더 함수를 매우 엄격하게 정의하지만, ISO/IEC-11172-5에서 참조 구현을 제공하고 있지만 MPEG-1 인코딩을 수행하는 방법은 정의하지 않는다.[2]이는 MPEG-1 코딩 효율성이 사용되는 인코더에 따라 크게 달라질 수 있다는 것을 의미하며, 일반적으로 새로운 인코더의 성능이 이전 인코더보다 훨씬 우수하다는 것을 의미한다.[26]ISO/IEC 11172의 최초 3부(시스템, 비디오, 오디오)는 1993년 8월에 발표되었다.[27]

| 부분 | 숫자 | 퍼스트 퍼블릭 개봉일 (초판) | 최신의 수정 | 제목 | 설명 |

|---|---|---|---|---|---|

| 1부 | ISO/IEC 11172-1 | 1993 | 1999[29] | 시스템들 | |

| 2부 | ISO/IEC 11172-2 | 1993 | 2006[30] | 비디오 | |

| 3부 | ISO/IEC 11172-3 | 1993 | 1996[31] | 오디오 | |

| 4부 | ISO/IEC 11172-4 | 1995 | 2007[32] | 컴플라이언스 테스트 | |

| 5부 | ISO/IEC TR 11172-5 | 1998 | 2007[33] | 소프트웨어 시뮬레이션 |

특허

MPEG-1은 그 나이 때문에 더 이상 어떠한 필수 특허도 적용받지 않으므로 면허를 취득하거나 수수료를 지불하지 않고도 사용할 수 있다.[34][35][36][37][38]ISO 특허 데이터베이스에는 2003년에 만료된 ISO 11172, US 4,472,747에 대한 특허 1개가 나열되어 있다.[39]MPEG-1 표준의 거의 완전한 초안은 1991년 12월 6일까지 ISO CD 11172로[20] 공개되었다.[1]2008년 7월 쿠로5힌 기사 "MPEG-1, H.261 및 MPEG-2의 특허 현황"[40]이나 gstreamer-devel[41] 메일링 리스트에 있는 2008년 8월 스레드는 단 하나의 미이행 MPEG-1 비디오와 MPEG-1 오디오 레이어 I/II 특허를 열거할 수 없었다.2009년 5월 메일링 리스트에 대한 논의에서 MPEG-1 오디오 레이어 II를 포함할 수 있는 미국 5,214,678 특허가 언급되었다.[42]1990년에 출원하여 1993년에 출판된 이 특허는 현재 만료되었다.[43]

MP3 기사에서 논의한 바와 같이 MPEG-1 오디오 레이어 III 구현을 위해 특허 수수료를 요구하는 회사가 있었기 때문에 "Layer III 오디오"를 포함한 MPEG-1 디코더와 인코더는 로열티 없이 구현할 수 없었다.MP3에 연결된 세계 모든 특허가 2017년 12월 30일 만료돼 이 포맷은 완전히 무료로 사용할 수 있게 됐다.[citation needed]2017년 4월 23일 프라운호퍼 IIS는 특정 MP3 관련 특허와 소프트웨어에 대한 테크니컬러의 MP3 라이선스 프로그램 충전을 중단했다.[44]

전 특허권자

다음 법인들은 MPEG-1 비디오(ISO/[45]IEC-11172-2) 형식의 특허를 보유하고 있다며 ISO에 선언을 했다.

- BBC

- 다임러 벤츠 AG

- 후지쓰

- IBM

- 마츠시타전기공업

- 미쓰비시 전기

- NEC

- NHK

- 필립스

- 파이오니어 코퍼레이션

- 퀄컴

- 리코

- 소니

- 텍사스 인스트루먼트

- 톰슨 멀티미디어

- 토판 인쇄

- 도시바

- 빅터 컴퍼니 오브 재팬

적용들

- 비디오 재생에 가장 인기 있는 소프트웨어는 지원되는 다른 형식 외에도 MPEG-1 디코딩을 포함한다.

- MP3 오디오의 인기는 MPEG-1 오디오(모두 3겹)를 재생할 수 있는 하드웨어의 대규모 설치 기반을 구축했다.

- "사실상 모든 디지털 오디오 장치"는 MPEG-1 오디오를 재생할 수 있다.[46]지금까지 수백만 개가 팔렸다.

- MPEG-2가 보급되기 전에는 많은 디지털 위성/케이블 TV 서비스가 MPEG-1을 독점적으로 사용하였다.[16][26]

- MPEG-2가 방송사에 널리 보급되었다는 것은 MPEG-1이 대부분의 디지털 케이블과 위성 셋톱 박스와 디지털 디스크와 테이프 플레이어가 역호환성 때문에 재생이 가능하다는 것을 의미한다.

- MPEG-1은 Green Book CD-i와 VCD(Video CD)의 전체 화면 비디오에 사용되었다.

- VCD에 기반을 둔 슈퍼 비디오 CD 표준은 MPEG-1 오디오와 MPEG-2 비디오를 독점적으로 사용한다.

- DVD-비디오 포맷은 주로 MPEG-2 비디오를 사용하지만 MPEG-1 지원은 표준에 명시적으로 정의되어 있다.

- DVD-비디오 표준은 원래 PAL 국가용 MPEG-1 오디오 레이어 II를 요구했지만 AC-3/Dolby Digital-Only 디스크를 허용하도록 변경되었다.MPEG-1 Audio Layer II는 MPEG Multichannel과 같은 형식의 새로운 확장은 거의 지원되지 않지만 DVD에서 여전히 허용된다.

- 대부분의 DVD 플레이어는 MPEG-1을 사용하는 비디오 CD와 MP3 CD 재생도 지원한다.

- 국제 디지털 비디오 방송(DVB) 표준은 주로 MPEG-1 오디오 레이어 II와 MPEG-2 비디오를 사용한다.

- 국제 디지털 오디오 방송(DAB) 표준은 MPEG-1 오디오 레이어 II만을 사용하는데, 이는 특히 고품질, 중간 정도의 디코더 성능 요건 및 오류 허용성 때문이다.

- 디지털 컴팩트 카세트는 PASC(Precision Adaptive Sub-band Coding)를 사용하여 오디오를 인코딩한다.PASC는 MPEG-1 오디오 레이어 I의 초기 버전으로 초당 384킬로비트의 고정 비트 전송률을 가지고 있다.

1부: 시스템

MPEG-1 표준의 파트 1은 시스템을 다루고 있으며 ISO/IEC-11172-1에 정의되어 있다.

MPEG-1 Systems는 인코딩된 오디오, 비디오 및 기타 데이터를 표준 비트스트림에 저장하고 서로 다른 컨텐츠 간의 동기화를 유지하는 데 사용되는 논리적 레이아웃과 방법을 지정한다.이 파일 형식은 미디어에서의 저장과 통신 채널을 통한 전송을 위해 특별히 설계되었으며, 비교적 신뢰할 수 있는 것으로 간주된다.제한된 오류 보호만이 표준에 의해 정의되며, 비트스트림의 작은 오류는 눈에 띄는 결함을 야기할 수 있다.

이 구조물은 나중에 MPEG 프로그램 스트림이라고 명명되었다: "MPEG-1 시스템 설계는 MPEG-2 프로그램 스트림 구조와 본질적으로 동일하다."[47]이 용어는 더 대중적이고 정밀하며(MPEG 전송 스트림과 구별됨) 여기에서 사용된다.

기본 스트림, 패킷 및 클럭 참조

- 기본 스트림(ES)은 MPEG-1 오디오 및 비디오 인코딩 데이터(인코더에서 출력)의 원시 비트림이다.MP3 파일처럼 이 파일들은 스스로 배포될 수 있다.

- 패킷화된 기본 스트림(PES)은 가변 길이의 패킷으로 패킷화된 기본 스트림이며, 즉 ES를 개별 청크로 분할하여 오류 감지를 위해 각 패킷에 CRC(순환 중복 검사) 체크섬이 추가되었다.

- 시스템 클럭 레퍼런스(SCR)는 각 PES의 33비트 헤더에 90kHz의 주파수/정밀도로 저장되는 타이밍 값이며, 27MHz의 정밀도로 추가 타이밍 데이터를 저장하는 추가 9비트 확장이다.[48][49]이것들은 인코더에 의해 삽입되며, 시스템 시간 시계(STC)에서 파생된다.그러나 동시에 인코딩된 오디오 및 비디오 스트림은 버퍼링, 인코딩, 지터 및 기타 지연으로 인해 동일한 SCR 값을 가지지 않는다.

프로그램 스트림

프로그램 스트림(PS)은 다수의 패킷화된 기본 스트림(보통 하나의 오디오 및 비디오 PES)을 하나의 스트림으로 결합하여 동시 전달을 보장하고 동기화를 유지하는 것과 관련이 있다.PS 구조는 멀티플렉스 또는 컨테이너 형식으로 알려져 있다.

PTS(Presentation Time Stamp)는 PS에 존재하여 오디오와 비디오 SCR 값 사이의 불가피한 차이를 교정한다(타임베이스 보정).PS 헤더에서 90kHz PTS 값은 디코더에게 어떤 비디오 SCR 값이 어떤 오디오 SCR 값과 일치하는지 알려준다.[48]PTS는 MPEG 프로그램의 일부를 표시할 시기를 결정하며, 디코더가 버퍼에서 데이터를 폐기할 수 있는 시기를 결정하는 데도 사용된다.[50]비디오나 오디오 중 하나는 디코더에 의해 디코더에 의해 다른 한 부분의 해당 세그먼트가 도착하여 디코딩될 때까지 지연될 것이다.

PTS 취급은 문제가 될 수 있다.디코더는 연결(순차적으로 결합)된 여러 프로그램 스트림을 수용해야 한다.이로 인해 동영상 중간에 있는 PTS 값이 0으로 재설정되고, 이 값이 다시 증가하기 시작한다.이러한 PTS 포장 격차는 디코더가 특별히 다루어야 하는 타이밍 문제를 야기할 수 있다.

추가로 B-프레임 때문에 디코딩 타임 스탬프(DTS)가 필요하다.비디오 스트림에서 B-프레임을 사용하는 경우 인접 프레임을 인코딩하고 디코딩해야 한다(정렬 프레임).DTS는 PTS와 상당히 유사하지만 순차 프레임만 취급하는 대신 앵커(P- 또는 I-) 프레임 앞에 다음 B-프레임(아래 설명되는 프레임 유형)을 디코딩하고 디스플레이할 시기를 디코더에게 알려주는 적절한 타임 스탬프를 포함하고 있다.비디오에 B 프레임이 없으면 PTS와 DTS 값은 동일하다.[51]

멀티플렉싱

PS를 생성하기 위해 멀티플렉서는 (2개 이상의) 패킷화된 기본 스트림을 상호 분리한다.이는 동시 스트림의 패킷이 동일한 채널을 통해 전송될 수 있도록 하며, 두 패킷이 정확히 동시에 디코더에 도착하도록 보장된다.이것은 시간 분할 다중화 사례다.

각 스트림에서 얼마나 많은 데이터가 인터리브 세그먼트(인터리브의 크기)에 있어야 하는지를 결정하는 것은 복잡하지만, 중요한 요건이다.부적절한 인터리빙은 수신기가 다른 동시 스트림을 해독하기에 충분한 데이터(예: 비디오)를 얻기 전에 저장 가능한 스트림보다 한 개 더 많은 스트림을 얻으므로 버퍼 언더플로우 또는 오버플로우를 초래할 수 있다.MPEG VBV(Video Buffering Verifier)는 멀티플렉스 PS가 지정된 데이터 처리 속도와 버퍼 크기를 가진 장치에 의해 디코딩될 수 있는지 여부를 결정하는 데 도움이 된다.[52]이는 멀티플렉서와 인코더에 피드백을 제공하여 멀티플렉스 크기를 변경하거나 규정 준수를 위해 필요한 비트 전송률을 조정할 수 있도록 한다.

2부: 비디오

MPEG-1 표준의 파트 2는 비디오를 다루며 ISO/IEC-11172-2에 정의되어 있다.그 디자인은 H.261의 영향을 많이 받았다.

MPEG-1 비디오 스트림이 요구하는 데이터 속도를 현저하게 줄이기 위해 지각 압축 방법을 이용한다.그것은 인간의 눈이 완전히 인지할 수 있는 제한된 능력을 가지고 있는 사진의 특정 빈도와 영역에서 정보를 감소시키거나 완전히 무시한다.또한 비디오에서 공통적으로 사용되는 시간적(시간 경과)과 공간적(사진 전체) 중복성을 이용하여 다른 방법보다 더 나은 데이터 압축을 달성한다.(비디오 압축 참조)

컬러 스페이스

MPEG-1에 비디오를 인코딩하기 전에 색 공간은 Y′CbCr(Y′=Luma, Cb=Chroma Blue, Cr=Chroma Red)로 변환된다.루마(밝음, 해상도)는 크로마(색, 색, 색, 색, 위상)와 별도로 저장되며, 심지어 빨강과 파랑으로 구분된다.

크롬은 또한 4:2:0으로 서브샘플링되는데, 이는 수직 분해능 반, 수평 분해능 반, 즉 영상의 루마 성분에 사용되는 샘플 수의 1/4에 불과하다는 것을 의미한다.[2]일부 색 구성 요소에 대한 고해상도 사용은 디지털 컬러 카메라의 이미지 캡처 센서에 일반적으로 사용되는 Bayer 패턴 필터와 개념적으로 유사하다.인간의 눈은 색상(Cr 및 Cb 성분)보다 밝기의 작은 변화(Y 성분)에 훨씬 더 민감하기 때문에, 크로마 서브샘플링은 압축이 필요한 비디오 데이터의 양을 줄이는 데 매우 효과적인 방법이다.그러나 미세한 디테일이 있는 비디오에서(높은 공간 복잡성) 이것은 크로마 앨리어싱 아티팩트로 나타날 수 있다.다른 디지털 압축 공예품에 비해 이 문제가 골칫거리가 되는 경우는 매우 드물 것으로 보인다.서브샘플링 때문에 일반적으로 Y′CbCr 4:2:0 비디오는 짝수 치수(수평 및 수직으로 2로 구분)를 사용하여 저장된다.

Y′CbCr 색상은 다소 다른 색상 형식에 보다 적절하게 적용되지만 표기법을 단순화하기 위해 비공식적으로 YUV라고 불리는 경우가 많다.마찬가지로 루마와 크로마 대신에 휘도와 색도라는 용어를 사용하는 경우가 많다.

해상도/비트레이트

MPEG-1은 최대 4095×4095(12비트), 비트 전송률은 최대 100Mbit/s까지 지원한다.[16]

MPEG-1 비디오는 가장 일반적으로 소스 입력 형식(SIF) 해상도: 352×240, 352×288 또는 320×240을 사용하여 볼 수 있다.1.5 Mbit/s 미만의 비트 전송률과 결합된 비교적 낮은 분해능은 제한된 파라미터 비트스트림(CPB)으로 알려진 것을 구성하고, 나중에 MPEG-2에서 "Low Level"(LL) 프로필로 이름을 바꾸었다.이것은 모든 디코더가 MPEG-1을 준수하는 것으로 간주하기 위해 처리할 수 있어야 하는 최소 비디오 규격이다.이는 품질과 성능의 균형을 잘 유지하기 위해 선택되어 당시의 합리적인 저렴한 하드웨어를 사용할 수 있게 되었다.[3][16]

프레임/그림/블록 유형

MPEG-1은 다른 용도로 사용되는 여러 프레임/그림 유형을 가지고 있다.가장 중요하지만 가장 간단한 것은 I-프레임이다.

아이프레임

"I-프레임"은 "Intra-frame"의 약어로, 다른 프레임과 독립적으로 디코딩할 수 있기 때문에 소위 "Intra-frame"이다.그것들은 애니메이션에서 사용되는 키 프레임과 다소 유사한 기능 때문에 I-픽처스 또는 키프레임으로도 알려져 있다.I-프레임은 기준 JPEG 영상과 사실상 동일한 것으로 간주할 수 있다.[16]

MPEG-1 비디오를 통한 고속 탐색은 가장 가까운 I-프레임에서만 가능하다.비디오를 자르는 경우 세그먼트의 첫 번째 I-프레임 이전에 비디오 세그먼트의 재생을 시작할 수 없다(적어도 계산적으로 집약적인 재인코딩 없이는 가능하지 않다).이 때문에 애플리케이션 편집에는 I-프레임 전용 MPEG 영상이 사용된다.

I-프레임 전용 압축은 매우 빠르지만 파일 크기가 매우 크다. 즉, 특정 비디오가 일시적으로 얼마나 복잡한지에 따라 일반적으로 인코딩되는 MPEG-1 비디오보다 3배(또는 그 이상) 더 큰 요소를 생성한다.[3]I-프레임 전용 MPEG-1 비디오는 MJPEG 비디오와 매우 유사하다.비트스트림을 만들 때 몇 가지 제한사항(색상 공간과 정량화 매트릭스)이 뒤따른다면, 매우 고속 및 이론적으로 무손실(실제 반올림 오류가 있다) 변환이 한 형식에서 다른 형식으로 이루어질 수 있을 정도.[53]

I-프레임 사이의 길이는 그림 그룹(GOP) 크기로 알려져 있다.MPEG-1은 일반적으로 15–18의 GOP 크기를 사용한다. 즉, 14-17 비 I-프레임(P-프레임과 B-프레임의 일부 조합)마다 1 I-프레임을 사용한다.보다 지능적인 인코더를 사용하면 GOP 크기가 동적으로 선택되며, 사전 선택된 최대 한계치까지 선택된다.[16]

하드웨어 디코더에서 가장 많이 사용되는 정밀도가 낮은 구현에서 복잡한 디코딩, 디코더 버퍼 크기, 데이터 오류 후 복구 시간, 탐색 능력, IDCT 오류의 누적 등으로 인해 I-프레임 사이의 프레임의 최대 개수에 제한이 있다(IEEE-1180 참조).

P-프레임

"P-프레임"은 "Predected-frame"의 약칭이다.그것들은 또한 전방으로 예측된 프레임 또는 인터프레임이라고도 불릴 수 있다(B-프레임은 또한 인터프레임이다).

P-프레임은 비디오의 시간적(시간 경과에 따른) 중복성을 이용하여 압축을 개선하기 위해 존재한다.P-프레임은 바로 앞에 있는 프레임(I-프레임 또는 P-프레임)과의 이미지 차이만 저장한다(이 기준 프레임을 앵커 프레임이라고도 한다).

P-프레임과 앵커 프레임의 차이는 프레임의 각 매크로 블록에서 모션 벡터를 사용하여 계산한다(아래 참조).그러한 모션 벡터 데이터는 디코더가 사용할 수 있도록 P-프레임에 내장된다.

P-프레임은 전방으로 예측된 블록 외에 코딩된 블록을 얼마든지 포함할 수 있다.[54]

동영상이 한 프레임에서 다음 프레임(컷 등)으로 급격히 바뀌면 I프레임으로 인코딩하는 것이 더 효율적이다.

B-프레임

"B-프레임"은 "양방향 프레임" 또는 "예측 프레임"을 의미한다.그것들은 또한 거꾸로 예측된 프레임이나 B-픽쳐로도 알려져 있다.B 프레임은 이전 프레임과 미래의 프레임(즉, 두 개의 앵커 프레임)을 모두 사용하여 예측을 할 수 있다는 점을 제외하면 P 프레임과 상당히 유사하다.

따라서 플레이어가 B-프레임 이후에 다음 I- 또는 P-앵커 프레임을 순차적으로 디코딩하고 표시하기 전에 먼저 디코딩해야 한다.이는 B-프레임을 디코딩하는 데 더 큰 데이터 버퍼가 필요하며 디코딩과 인코딩 중에 지연이 증가한다는 것을 의미한다.이를 위해서는 컨테이너/시스템 스트림에 디코딩 타임 스탬프(DTS) 기능도 필요하다(위 참조).이와 같이 B프레임은 오래전부터 많은 논란의 대상이 되어 왔으며, 영상에서는 피하기도 하고, 하드웨어 디코더의 전폭적인 지원을 받지 못하는 경우도 있다.

B-프레임에서는 다른 프레임이 예측되지 않는다.이 때문에, 필요한 경우 매우 낮은 비트레이트 B 프레임을 삽입하여 비트레이트 제어를 도울 수 있다.만약 이것이 P-프레임으로 수행된다면, 미래 P-프레임은 그것으로부터 예측될 것이고 전체 시퀀스의 품질을 낮출 것이다.그러나 이와 유사하게, 미래 P-프레임은 여전히 그것과 이전의 I- 또는 P-앵커 프레임 사이의 모든 변화를 인코딩해야 한다.B 프레임은 또한 물체 뒤의 배경이 여러 프레임에 걸쳐 드러나는 비디오나 장면 변경과 같은 퇴색 전환에서도 유용할 수 있다.[3][16]

B-프레임은 역방향으로 예측되거나 양방향으로 예측되는 블록 외에 코딩된 블록과 정방향으로 예측되는 블록을 얼마든지 포함할 수 있다.[16][54]

D-프레임

MPEG-1은 이후 비디오 표준에서 찾을 수 없는 고유한 프레임 유형을 가지고 있다."D-프레임" 또는 DC-픽쳐는 DC 변환 계수만 사용하여 인코딩된 독립적으로 코드화된 이미지(내부 프레임)이므로(D-프레임을 인코딩할 때 AC 계수가 제거된다(아래 DCT 참조) 품질이 매우 낮다.D-프레임은 I-, P- 또는 B-프레임에서 절대 참조되지 않는다.예를 들어, D 프레임은 고속으로 비디오를 탐색할 때 비디오의 빠른 미리 보기에만 사용된다.[3]

성능이 다소 높은 디코딩 장비를 사용할 경우 D프레임 대신 I프레임을 디코딩하면 빠른 미리보기를 할 수 있다.이는 I-프레임이 DC 계수와 함께 AC 계수를 포함하기 때문에 더 높은 품질의 미리보기를 제공한다.인코더는 신속한 I-프레임 디코딩 기능이 디코더로 이용 가능하다고 가정할 수 있는 경우 D-프레임을 전송하지 않음으로써 비트를 절약할 수 있다(따라서 비디오 콘텐츠의 압축을 개선함).이 때문에 D-프레임은 MPEG-1 비디오 인코딩에서 실제로 사용되는 경우가 거의 없으며, D-프레임 기능은 이후의 비디오 코딩 표준에 포함되지 않았다.

매크로블록

MPEG-1은 정량화를 위해 일련의 8×8 블록의 비디오에서 작동한다.그러나 모션 벡터에 필요한 비트 레이트를 줄이기 위해, 그리고 크로마(색상)는 4의 인수로 서브샘플링되기 때문에 각 쌍의 (빨간색 및 파란색) 크로마 블록은 4개의 서로 다른 루마 블록에 해당한다.해상도가 16×16인 이 6개 블록 세트는 함께 처리되어 매크로 블록이라고 불린다.

매크로 블록은 (색상) 비디오의 가장 작은 독립 단위다.모션 벡터(아래 참조)는 매크로 블록 레벨에서만 작동한다.

비디오의 높이나 너비가 16의 정확한 배수가 아닐 경우 전체 행과 전체 매크로 블록 열을 인코딩하고 디코딩하여 그림을 채워야 한다(추가 디코딩된 픽셀은 표시되지 않지만).

모션 벡터

비디오에서 시간 중복의 양을 줄이기 위해 변경되는 블록만 업데이트된다(최대 GOP 크기까지).이것은 조건부 보충이라고 알려져 있다.그러나 이것만으로는 그다지 효과적이지 않다.이전에 인코딩된 물체의 위치만 변경되었더라도 물체 및/또는 카메라가 이동하면 프레임의 상당 부분을 업데이트해야 할 수 있다.모션 추정을 통해 인코더는 이러한 움직임을 보상하고 대량의 중복 정보를 제거할 수 있다.

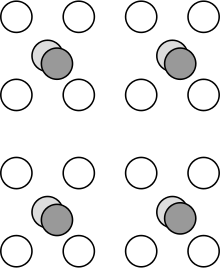

인코더는 현재 매크로 블록의 영역에서 (인코더 고유) 사전 정의된 반경 한계까지 다이아몬드 패턴으로 앵커 프레임(이전의 I- 또는 P-프레임)에서 비디오의 인접 부분과 현재 프레임을 비교한다.일치하는 것이 발견되면, 이전 비디오 영역에서 현재의 매크로 블록까지의 방향과 거리(즉, 동작의 벡터)만 인터프레임(P- 또는 B-프레임)으로 인코딩하면 된다.그림을 재구성하기 위해 디코더에 의해 수행되는 이 과정의 역순을 모션 보상이라고 한다.

그러나 매크로블록이 현재 그림과 완벽하게 일치하는 경우는 드물다.추정 일치 면적과 실제 프레임/매크로 블록 간의 차이를 예측 오차라고 한다.예측오차의 양이 클수록 프레임에 데이터를 추가로 인코딩해야 한다.효율적인 비디오 압축을 위해서는 인코더가 모션 추정을 효과적이고 정확하게 수행할 수 있는 것이 매우 중요하다.

모션 벡터는 픽셀 수(펠이라고도 함)를 기준으로 화면에 두 영역 사이의 거리를 기록한다.MPEG-1 비디오는 한 픽셀의 절반인 절반인 절반인 절반의 모션 벡터(MV) 정밀도를 사용한다.MV의 정밀도가 미세할수록 일치가 정확해질 가능성이 높고 압축도 효율적이다.그러나 더 높은 정밀도로의 절충이 있다.MV 정밀도는 MV를 나타내기 위해 더 많은 양의 데이터를 사용하게 되는데, 이는 모든 MV의 프레임에 더 많은 숫자가 저장되어야 하고, 인코더와 디코더에 대한 매크로 블록의 보간 수준이 증가함에 따라 코딩 복잡성이 증가하고, 더 높은 정밀 MV를 가진 수익(최소 이득)이 감소하기 때문이다. Half-pel 정밀도는 그 시점의 이상적인 트레이드오프로 선택되었다.(참조: Qpel

인접한 매크로블록은 매우 유사한 모션 벡터를 가질 가능성이 높기 때문에, 이 중복 정보는 DPCM 인코딩을 통해 상당히 효과적으로 압축될 수 있다.각 매크로 블록에 대한 MV 간 차이(작은)만 최종 비트스트림에 저장하면 된다.

P-프레임은 이전의 앵커 프레임과 비교하여 매크로 블록당 하나의 모션 벡터를 가지고 있다.그러나 B 프레임은 이전 앵커 프레임과 미래의 앵커 프레임에서 각각 하나씩, 두 개의 모션 벡터를 사용할 수 있다.[54]

부분적인 매크로블록, 그리고 매크로블록 경계선에 정확히 떨어지지 않는 비디오로 인코딩된 검은 테두리/막대는 움직임 예측에 혼란을 야기한다.블록 패딩/경계 정보는 매크로 블록이 비디오의 다른 영역과 밀접하게 일치하는 것을 방지하므로, 화면 경계를 따라 수십 개의 부분 매크로 블록마다 훨씬 더 큰 예측 오류 정보를 인코딩해야 한다.DCT 인코딩 및 정량화(아래 참조)도 블록에 큰/샤프 그림 대조가 있을 때 거의 효과적이지 않다.

훨씬 더 심각한 문제는 그림이 (일반적으로) 검은색으로 전환되는 중요한 무작위 에지 노이즈를 포함하는 매크로 블록에 존재한다.위의 모든 문제는 에지 소음에도 적용된다.게다가, 추가된 무작위성은 단순히 크게 압축하는 것이 불가능하다.이러한 모든 효과는 비디오의 품질을 현저히 떨어뜨릴 것이다(또는 비트 전송률을 증가시킬 것이다).

DCT

각 8×8 블록은 우선 전방 이산 코사인 변환(FDCT)을 적용한 다음 정량화 과정을 적용하여 인코딩된다.FDCT 공정(그 자체로)은 이론적으로 손실이 없으며, (정량화 및 반올림 오류가 없는 경우) 원래 값을 재현하기 위해 역 DCT(IDCT)를 적용하면 역전할 수 있다.실제로 인코더(다음 절에서 설명한 바와 같이)의 정량화와 디코더의 IDCT 근사 오류에 의해 도입된 (때로는 큰) 반올림 오류가 있다.디코더 IDCT 근사치의 최소 허용 정확도는 ISO/IEC 23002-1에 의해 정의된다(2006년 이전부터 IEEE 1180-1990에 의해 지정됨).

FDCT 프로세스는 8×8 블록의 압축되지 않은 픽셀 값(밝기 또는 색상 차이 값)을 8×8 인덱스 배열의 주파수 계수 값으로 변환한다.그 중 하나는 (통계적으로 분산이 높은) "DC 계수"로, 8×8 블록 전체의 평균값을 나타낸다.나머지 63개 계수는 통계적으로 더 작은 "AC 계수"로, 각각 DC 계수로 대표되는 플랫 블록 값에서 사인파 편차를 나타내는 양의 값 또는 음의 값을 갖는다.

인코딩된 8×8 FDCT 블록의 예:

DC 계수 값은 한 블록에서 다음 블록으로 통계적으로 상관되므로 DPCM 인코딩을 사용하여 압축한다.각 DC 값과 블록의 왼쪽에서 DC 계수 값 사이의 (작은) 차이만 최종 비트스트림에 표시하면 된다.

또한 DCT를 적용하여 수행되는 주파수 변환은 정량화를 적용하기 전에 신호를 더 적은 수의 고진도 값으로 효율적으로 집중시키기 위한 통계적 장식 기능을 제공한다(아래 참조).

수량화

정량화는 본질적으로 신호의 정확도를 감소시키는 과정으로, 이를 보다 큰 단계 크기로 나누고 정수 값으로 반올림(즉, 가장 가까운 배수를 찾아내고 나머지를 폐기)한다.

프레임 수준 정량기는 주어진 프레임에서 얼마나 많은 정보가 제거될지를 결정하는 0에서 31까지의 숫자다(인코더는 일반적으로 극한값의 일부를 생략/비활성화한다).프레임 수준 정량기는 일반적으로 특정 사용자 지정 비트 전송률을 유지하기 위해 인코더에 의해 동적으로 선택되거나 사용자가 직접 지정한 (비공통적으로 훨씬 덜함)이다.

"정량화 행렬"은 64개의 숫자(0부터 255까지의 범위)로 이루어진 문자열로, 인코더에게 각 시각 정보의 조각이 얼마나 상대적으로 중요하거나 중요하지 않은지 알려준다.매트릭스의 각 숫자는 비디오 이미지의 특정 주파수 구성요소에 해당한다.

정량화 행렬의 예:

정량화는 DCT 블록의 64개 주파수 값을 각각 취하여 프레임 레벨 정량기로 나눈 다음 정량화 매트릭스에서 해당 값으로 나누는 방식으로 이루어진다.마지막으로 결과는 반올림된다.이것은 그림의 일부 주파수 구성요소의 정보를 상당히 감소시키거나 완전히 제거한다.일반적으로 고주파 정보는 시각적으로 덜 중요하므로 고주파수는 훨씬 더 강력하게 정량화된다(비례적으로 감소).MPEG-1은 실제로 블록 내(I-block)와 블록 간(P- 및 B-)의 두 개의 개별 정량화 매트릭스를 사용하므로 서로 다른 블록 유형의 정량화가 독립적으로 수행될 수 있으므로 보다 효과적으로 수행할 수 있다.[3]

이 정량화 프로세스는 대개 상당한 수의 AC 계수를 0(스스로프 데이터로 알려져 있음)으로 감소시키고, 다음 단계에서 엔트로피 코딩(무손실 압축)에 의해 더 효율적으로 압축될 수 있다.

계량화된 DCT 블록의 예:

정량화는 대량의 데이터를 제거하며, MPEG-1 비디오 인코딩의 주된 손실 처리 단계다.이것은 또한 막힘, 컬러 밴딩, 노이즈, 링잉, 변색, 기타 등 대부분의 MPEG-1 비디오 압축 아티팩트의 주요 원천이기도 하다.비디오가 불충분한 비트 전송률로 인코딩될 때, 따라서 인코더는 비디오의 많은 부분을 통해 높은 프레임 수준의 정량제(강력한 정량화)를 사용하도록 강요될 때 이러한 현상이 일어난다.

엔트로피 부호화

MPEG-1 비디오의 인코딩에서 몇 단계는 무손실이며, 이는 디코딩 시 정확히 동일한 (원래) 값을 생성하기 위해 역전된다는 것을 의미한다.이러한 무손실 데이터 압축 단계는 (정량화와 달리) 노이즈를 추가하거나 내용을 변경하지 않기 때문에 소음 없는 코딩이라고 부르기도 한다.[46]무손실 압축은 가능한 한 많은 중복성을 제거하는 것을 목표로 하기 때문에, 정보이론 분야에서는 엔트로피 코딩이라고 알려져 있다.

정량화된 DCT 블록의 계수는 오른쪽 하단을 향해 0이 되는 경향이 있다.최대 압축은 상단 왼쪽에서 시작하여 Run-length 인코딩 기법을 사용하여 DCT 블록의 지그재그 스캔을 통해 달성할 수 있다.

DC 계수 및 동작 벡터는 DPCM 인코딩된다.

RLE(Run-Length Encryption)는 반복을 압축하는 간단한 방법이다.연속적인 문자열을 아무리 길어도 몇 바이트로 대체할 수 있어 반복하는 값과 몇 번을 기록한다.예를 들어, 만약 누군가가 "5나인"이라고 말한다면, 여러분은 그들이 99999라는 숫자를 의미한다는 것을 알 것이다.

RLE는 정량화 후 특히 효과적이며, 많은 수의 AC 계수가 현재 0(스스로스 데이터라고 함)이며, 단지 두어 바이트로 나타낼 수 있기 때문이다.이것은 런 길이와 런엔딩 캐릭터를 코딩하는 특별한 2차원 허프먼 테이블에 저장된다.

허프먼 코딩은 엔트로피 코딩의 매우 대중적이고 비교적 간단한 방법으로, 데이터 크기를 줄이기 위해 MPEG-1 비디오에 사용된다.이 데이터는 자주 반복되는 문자열을 찾기 위해 분석된다.그런 다음 이러한 문자열은 특수 테이블에 배치되며, 가장 자주 반복되는 데이터에 가장 짧은 코드가 할당된다.이것은 이러한 형태의 압축으로 데이터를 가능한 한 작게 유지한다.[46]테이블이 구성되면 데이터의 문자열은 테이블의 해당 항목을 참조하는 (much small) 코드로 대체된다.디코더는 단순히 이 과정을 뒤집어서 원본 데이터를 만든다.

이것이 비디오 인코딩 프로세스의 마지막 단계여서 허프먼 코딩의 결과는 MPEG-1 비디오 "비트스트림"으로 알려져 있다."

특정 애플리케이션을 위한 GOP 구성

I-프레임은 프레임 내에 완전한 프레임 정보를 저장하므로 무작위 액세스에 적합하다.P-프레임은 이전 프레임(I 또는 P)에 상대적인 모션 벡터를 사용하여 압축을 제공한다. B-프레임은 최대 압축을 제공하지만 이전 프레임뿐만 아니라 다음 프레임을 필요로 한다.따라서 B-프레임 가공은 디코딩된 쪽에서 더 많은 버퍼가 필요하다.이러한 요인에 따라 GOP(Group of Pictures) 구성을 선택해야 한다.I-프레임 전용 시퀀스는 최소 압축을 제공하지만 임의 액세스, FF/FR 및 편집성에 유용하다.I- 및 P-프레임 시퀀스는 적당한 압축을 제공하지만 일정 수준의 무작위 액세스 FF/FR 기능을 추가한다.I-, P- 및 B-프레임 시퀀스는 매우 높은 압축을 제공하지만 코딩/디코딩 지연도 크게 증가한다.따라서 그러한 구성은 화상전화 또는 화상회의 애플리케이션에 적합하지 않다.

I-프레임의 일반적인 데이터 전송 속도는 픽셀당 1비트인 반면 P-프레임은 픽셀당 0.1비트, B-프레임은 픽셀당 0.015비트다.[55]

3부: 오디오

MPEG-1 표준의 파트 3은 오디오를 다루며 ISO/IEC-11172-3에 정의되어 있다.

MPEG-1 오디오는 정신 음향학을 이용하여 오디오 스트림이 요구하는 데이터 속도를 현저히 감소시킨다.그것은 인간의 귀가 들을 수 없는 특정 부분을 감소시키거나 완전히 무시한다. 왜냐하면 그것들은 귀가 제한된 주파수에 있기 때문이다. 또는 다른 (일반적으로 더 큰) 소리에 의해 가려지기 때문이다.[56]

채널 인코딩:

- 모노

- 조인트 스테레오 – 명암 인코딩

- 조인트 스테레오 – Layer III 전용으로 인코딩된 M/S

- 스테레오

- 이중(상관되지 않은 모노 채널 2개)

- 샘플링 속도: 32000, 44100, 48000Hz

- 계층 I에 대한 비트 전송률: 32, 64, 96, 128, 160, 192, 224, 256, 288, 288, 320, 352, 384, 416 및 448 kbit/s[57]

- 계층 II에 대한 비트 전송률: 32, 48, 56, 64, 80, 96, 112, 128, 160, 192, 224, 256, 320 및 384 kbit/s

- 계층 III에 대한 비트 전송률: 32, 40, 48, 56, 64, 80, 96, 112, 128, 160, 192, 224, 256 및 320 kbit/s

MPEG-1 오디오는 3단으로 나뉜다.각각의 상위 계층은 계산적으로 더 복잡하고 일반적으로 이전보다 낮은 비트 전송률에서 더 효율적이다.[16]상위 계층들이 하위 계층들에 의해 구현된 기술을 재사용하기 때문에 계층들은 반반적으로 역호환된다."전체" 레이어 II 디코더는 또한 레이어 I 오디오를 재생할 수 있지만, 모든 상위 레벨 플레이어가 "전체"인 것은 아니지만, 레이어 III 오디오는 재생할 수 없다.[56]

1층

MPEG-1 Audio Layer I는 MPEG-1 Audio Layer II의 단순화된 버전이다.[18]Layer I는 매우 낮은 지연과 보다 미세한 해상도를 위해 더 작은 384-표본 프레임 크기를 사용한다.[26]이것은 원격 회의, 스튜디오 편집 등과 같은 어플리케이션에 유리하다.1990년 이용 가능한 하드웨어에서 실시간 인코딩을 용이하게 하기 위해 계층 II보다 복잡성이 낮다.[46]

레이어 1호는 그 시대에 제한된 채택을 보였으며, 가장 두드러진 것은 384 kbit/s의 비트 전송률로 필립스의 사라진 디지털 컴팩트 카세트에 사용되었다.[2]도입 이후 디지털 처리의 실질적인 성능 향상으로, 레이어 1은 빠르게 불필요하고 쓸모 없게 되었다.

Layer I 오디오 파일은 일반적으로 ".mp1" 또는 ".m1a" 확장자를 사용한다.

레이어 II

MPEG-1 Audio Layer II(MP2의 첫 번째 버전, 흔히 MUSICAM이라고 [56]함)는 스테레오 사운드를 위해 약 192 kbit/s의 고품질을 제공하도록 설계된 손실성 오디오 형식이다.MP2 오디오 디코딩은 MP3, AAC 등에 비해 계산적으로 간단하다.

히스토리/MUSICAM

MPEG-1오디오 레이어 II는 MUSICAM(독일의 유니버설 Subband 통합을 위한 그리고 미국을 개조했다)오디오 코덱, 센터 commun에 의해 개발된 d'études에서 파생된 것 드 télévision 것은 télécommunications(CCETT), 필립스, 원자로 Rundfunktechnik(IRT/CNET)[16][18][58]은 유레카 147pan-Europeaninter-governmental 사건의 일환으로.earch와 드디지털 오디오 방송 발전을 위한 개발 계획

MPEG-1 오디오의 주요 기능은 필터 뱅크, 시간 도메인 처리, 오디오 프레임 크기 등 MUSICAM에서 직접 물려받았다.그러나 개선이 이루어졌고, 최종 MPEG-1 Audio Layer II 표준에서는 실제 MUSICAM 알고리즘이 사용되지 않았다.레이어 II를 지칭하는 MUSICAM이라는 용어의 널리 사용되는 용어는 전적으로 부정확하며 기술적, 법적 이유 둘 다 때문에 낙담한다.[56]

기술적 세부사항

MP2는 시간 도메인 인코더다.그것은 시간 주파수 매핑을 위해 낮은 지연 32 서브밴드 폴리파싱 필터 뱅크를 사용한다. 앨리어싱을 방지하기 위해 중복되는 범위(즉, 폴리파싱)를 가지고 있다.[59]정신 음향 모델은 청각 마스킹 원리와 동시 마스킹 효과, 청각의 절대 임계값(ATS)을 기반으로 한다.레이어 II 프레임의 크기는 1152-샘플(동급)으로 고정되어 있다.

시간 영역은 오디오 파형의 짧고 이산적인 샘플/청크에 대해 분석 및 정량화가 수행되는 방식을 가리킨다.이것은 인코딩된 오디오를 변환하고 출력하는 방법을 결정하기 전에 샘플을 몇 배 더 분석해야 하는 주파수 영역 인코딩(MP3)과는 달리 인코딩하기 전에 샘플이 분석되기 때문에 적은 수의 샘플만 분석되기 때문에 낮은 지연을 제공한다.이것은 또한 복잡하고 무작위적이고 일시적인 충동(예: 퍼커션 악기, 박수)에서 더 높은 성능을 제공함으로써 프리에코와 같은 공예품을 피할 수 있다.

32 서브밴드 필터 뱅크는 32개의 진폭 계수를 반환하는데, 이는 오디오의 동일한 크기의 주파수 대역/세그먼트 각각에 1개씩, 약 700Hz 폭(오디오의 샘플링 주파수에 따라 다름)이다.그런 다음 인코더는 정신 음향 모델을 사용하여 중요도가 낮은 오디오 정보를 포함하는 서브밴드(sub-band)를 결정하므로, 정량화가 들리지 않거나 적어도 훨씬 덜 눈에 띄는 곳을 결정한다.[46]

이 정신 음향 모델은 1024 포인트의 빠른 푸리에 변환(FFT)을 사용하여 적용되었다.프레임당 1152개의 샘플 중 주파수 범위의 상단과 하단에 있는 64개의 샘플은 이 분석을 위해 무시된다.그들은 아마도 결과를 바꿀 만큼 충분히 중요하지 않을 것이다.정신 음향 모델은 경험적으로 결정된 마스킹 모델을 사용하여 어떤 서브밴드가 마스킹 임계값에 더 기여하는지, 그리고 각 모델이 인식되지 않고 얼마나 많은 정량화 소음을 포함할 수 있는지를 결정한다.청각의 절대 한계치(ATS) 이하의 소리는 완전히 폐기된다.그런 다음 사용 가능한 비트는 그에 따라 각 서브밴드에 할당된다.[56][59]

일반적으로, 하위 대역은 더 큰 소리를 가진 이웃한 (즉 유사한 주파수) 하위 대역보다 더 조용한 소리(즉, 더 큰 소리(더 큰 소리)를 포함하는 경우 덜 중요하다.또한 "소음" 구성요소는 일반적으로 "토날" 구성요소보다 더 중요한 마스킹 효과를 가진다.[58]

덜 중요한 서브밴드는 정량화에 의해 정확도가 감소한다.여기에는 기본적으로 주파수 범위(계수의 진폭), 즉 소음 층을 높이는 것이 포함된다.그런 다음 디코더가 각 서브밴드를 적절한 주파수 범위로 다시 확장하는 데 사용할 증폭계수를 계산한다.[60][61]

레이어 II는 또한 선택적으로 조인트 스테레오의 한 형태인 인텐시티 스테레오 코딩을 사용할 수 있다.즉, 두 채널의 6kHz 이상의 주파수는 하나의 단일(모노) 채널로 결합/다운 혼합되지만, 각 채널의 상대 강도(볼륨, 진폭)에 대한 "측면 채널" 정보는 보존되어 비트스트림에 별도로 인코딩된다.재생 시에는 싱글 채널이 좌우 스피커를 통해 재생되며, 각 채널에 강도 정보가 적용되어 스테레오 사운드의 착각을 준다.[46][58]이 지각적 속임수는 "streo retrevency"라고 알려져 있다.이렇게 하면 그다지 인지할 수 있는 충실도의 손실 없이 오디오 비트 전송률을 더 줄일 수 있지만, 매우 높은 품질(투명) 오디오를 제공하지 않기 때문에 일반적으로 비트 전송률이 더 높은 경우에는 사용되지 않는다.[46][59][62][63]

품질

지금까지 구현된 가장 중요한 조건에서 전문가들에 의한 주관적 오디오 테스트에서는 MP2가 16비트 44.1kHz CD 오디오에 대해 256kbit/s로 투명한 오디오 압축을 제공하는 것으로 나타났다(아마도 더 최근의 인코더는 훨씬 더 우수한 성능을 발휘해야 한다).[2][58][59][64]CD 오디오의 1:6 압축비는 1:8을 조금 넘는 지각 엔트로피 추정 상한에 상당히 가깝기 때문에 특히 인상적이다.[65][66]훨씬 더 높은 압축을 달성하는 것은 감지할 수 있는 정보를 삭제하지 않고는 불가능하다.

MP2는 카스타넷, 교향악단, 남성과 여성 목소리, 특히 삼각형, 글록켄스피엘, 청중 박수와 같은 복잡하고 고에너지 과도현상(임펄스)과 같은 중요한 오디오 자료에서 특히 높은 오디오 부호화 표준으로 남아 있기 때문에 선호되는 손실 오디오 부호화 표준으로 남아 있다.[26]보다 최근의 시험, 열등한 matrixed 모드로 도통 받았음에도 불구하고(호환성을 위해)[2][59]율 약간 돌비 디지털(AC-3)과 error—and의 마진은 대부분 내에 고급 오디오 부호화(AAC)( 같은 훨씬 더 최근 오디오 코덱보다 더 낮은 실질적으로 s.은 MPEG멀티 채널(MP2에 따라) 보여 왔다uperi또는 청중들의 박수 같은 경우에.[67][68]이것이 MP2 오디오가 계속해서 광범위하게 사용되는 한 가지 이유다.그러나 MPEG-2 AAC 스테레오 검증 테스트는 크게 다른 결론에 도달하여 AAC가 절반의 비트 전송률로 MP2보다 우수한 성능을 제공하는 것으로 나타났다.[69]이전과 이후의 시험과 이러한 차이가 나는 이유는 분명하지 않지만, 이상하게도, 후자의 시험에는 특히 박수갈채의 표본이 없다.

Layer II 오디오 파일은 일반적으로 ".mp2" 또는 ".m2a" 확장자를 사용한다.

레이어 3

MPEG-1 오디오 레이어 III(MP3의 첫 번째 버전)는 단일 채널(BRI) ISDN 링크를 통한 모노럴 오디오의 경우 약 64 kbit/s, 스테레오 사운드의 경우 128 kbit/s로 허용 가능한 품질을 제공하도록 설계된 손실성 오디오 형식이다.

기록/ASPEC

MPEG-1 오디오 레이어 III는 디지털 오디오 방송의 개발을 위한 EUREKA 147 범유럽간 정부간 연구 개발 이니셔티브의 일환으로 프라운호퍼에 의해 개발된 적응 스펙트럼 지각 엔트로피 코딩(ASPEC) 코덱에서 도출되었다.ASPEC은 레이어 II 모델(프레임 크기, 필터 뱅크, FFT 등)에 맞게 개조되어 레이어 III가 되었다.[18]

ASPEC was itself based on Multiple adaptive Spectral audio Coding (MSC) by E. F. Schroeder, Optimum Coding in the Frequency domain (OCF) the doctoral thesis by Karlheinz Brandenburg at the University of Erlangen-Nuremberg, Perceptual Transform Coding (PXFM) by J. D. Johnston at AT&T Bell Labs, and Transform coding of audio signals by Y. Mahieux와 J. Petit at Institute für Rundfunktechnik (IRT/CNET)[70]

기술적 세부사항

MP3는 주파수 영역 오디오 변환 인코더다.일부 하위 계층 기능을 활용하지만 MP3는 MP2와는 사뭇 다르다.

MP3는 MP2와 같은 1152개의 샘플에서 작동하지만 주파수 영역(MDCT) 처리와 정량화가 효과를 발휘하려면 분석을 위해 여러 프레임을 취해야 한다.1152개의 샘플 크기 출력 프레임을 유지하면서 비트 버퍼를 사용하여 이 가변 비트 전송률(VBR) 인코딩을 활성화하는 가변 샘플 수를 출력한다.이로 인해 출력 전 지연 시간이 상당히 길어져 MP3는 편집이나 기타 처리가 필요한 스튜디오 어플리케이션에 적합하지 않은 것으로 간주되고 있다.[59]

MP3는 32개의 서브밴드 폴리피싱 필터 뱅크의 혜택을 받지 못하며, 대신 각 출력물에 대한 18포인트 MDCT 변환을 사용하여 데이터를 576개의 주파수 구성요소로 분할하고 주파수 영역에서 처리한다.[58]이 과밀성은 MP3가 훨씬 더 미세한 정신음향 모델을 가질 수 있도록 하며, 각 대역에 적절한 정량화를 보다 세심하게 적용하여 훨씬 더 나은 저비트율 성능을 제공한다.

주파수 영역 처리는 또한 일부 한계를 부과하여, 12 또는 36 × Layer II보다 더 나쁜 시간 분해능을 유발한다.이것은 더 큰 창에 퍼지는 퍼커시브 이벤트와 다른 고주파 이벤트와 같은 일시적인 소리 때문에 정량화 아티팩트를 야기한다.이것은 가청성과 프리에코를 유발한다.[59]MP3는 이러한 효과를 줄이기 위해 사전 에코 검출 루틴과 어려운 구절에서 일시적으로 비트 전송률을 높일 수 있는 VBR 인코딩을 사용한다.또한 일반적인 36개 검체 정량화 윈도우 간에 전환이 가능하며, 대신 3배 짧은 12개 검체 창을 사용하여 정량화 유물의 시간(시간) 길이를 줄일 수 있다.[59]그러나 MP3의 시간적 응답을 가장 심각한 아티팩트를 피할 수 있을 정도로 충분하게 만들기 위해 상당히 작은 창 크기를 선택할 때, MP3는 고정된 톤 구성 요소의 주파수 영역 압축에 있어서 훨씬 덜 효율적이 된다.

레이어 II에 맞추기 위해 하이브리드 시간 영역(필터 뱅크)/주파수 영역(MDCT) 모델을 사용하도록 강요 받는 것은 처리 시간을 낭비하고 앨리어싱 아티팩트를 도입함으로써 품질을 떨어뜨린다.MP3에는 이 문제를 가리기 위한 앨리어싱 취소 단계가 있지만, 대신 오디오에 인코딩되어야 하는 주파수 영역 에너지를 생성한다.이것은 대부분의 사람들이 청력이 제한되어 있는 주파수 범위의 상단으로 밀려나며, 청력이 일으키는 왜곡이 덜 들리게 되기를 바라고 있다.

레이어 II의 1024 포인트 FFT는 모든 샘플을 완전히 포함하지는 않으며, 정량화 인자를 결정해야 하는 MP3 서브밴드 몇 개를 모두 생략한다.대신 MP3는 전지구 및 개별 마스킹 임계값을 계산하기 위해 스펙트럼 추정에 FFT 분석의 두 패스를 사용한다.이를 통해 1152개의 모든 샘플을 커버할 수 있다.둘 중 가장 어려운 오디오와 함께 보다 중요한 패스부터 글로벌 마스킹 임계값 레벨을 활용한다.

MP3는 레이어 II의 인코딩 조인트 스테레오 외에 중간/측면(중간/측면, m/s, MS, 매트릭스) 조인트 스테레오를 사용할 수 있다.중/사이드 스테레오에서는 양 채널의 특정 주파수 범위가 단일(중간, 중간, L+R) 모노 채널로 병합되는 한편, 좌우 채널의 음차는 별도(측면, L-R) 채널로 저장된다.인텐시티 스테레오와는 달리 이 과정은 오디오 정보를 전혀 버리지 않는다.그러나 양자화와 결합하면 공예품을 과장할 수 있다.

좌우 채널 간 차이가 작을 경우 사이드 채널이 작아져 50% 비트레이트 절감 효과와 관련 품질 개선 효과를 얻을 수 있다.왼쪽과 오른쪽의 차이가 클 경우, 중간/측면 조인트 스테레오 인코딩이 어떠한 이점도 제공하지 않기 때문에 표준(구체, 왼쪽/오른쪽) 스테레오 인코딩을 선호할 수 있다.MP3 인코더는 프레임 단위로 m/s 스테레오와 풀 스테레오 사이를 전환할 수 있다.[58][63][71]

MP3는 레이어 I, II와 달리 비트레이트를 더욱 줄이기 위해 가변 길이 허프먼 코딩(지각 후)을 사용하여 더 이상의 품질 손실 없이 비트레이트를 더욱 줄인다.[56][59]

품질

MP3의 미세하고 선별적인 정량화는 저비트율에서 MP2보다 월등히 우수하다.그것은 거의 동일한 오디오 음질을 레이어 II에 15% 낮은 비트 전송률(대략)으로 제공할 수 있다.[68][69]128 kbit/s는 MP3의 "스위트 스팟"으로 간주된다. 즉, 대부분의 음악에서 일반적으로 받아들여질 수 있는 품질의 스테레오 사운드를 제공하고 비트 레이트를 더 증가시킴으로써 품질 향상이 줄어들고 있다는 뜻이다.MP3는 또한 2층보다 덜 귀찮은 유물을 전시하는 것으로 간주되는데, 이 유물은 둘 다 너무 낮은 비트 전송률로 사용되어 충실한 재생산을 제공할 수 없다.

Layer III 오디오 파일은 확장자 ".mp3"를 사용한다.

MPEG-2 오디오 확장

MPEG-2 표준은 MPEG-1 오디오에 대한 몇 가지 확장을 포함한다.[59]이를 MPEG-2 BC라고 하며 MPEG-1 오디오와 역호환된다.[72][73][74][75]MPEG-2 오디오는 ISO/IEC 13818-3에 정의되어 있다.

- MPEG 멀티채널 – 역호환성 5.1 채널 [25]서라운드 사운드

- 샘플링 속도: 16000, 22050, 24000Hz

- 비트 전송률: 8, 16, 24, 32, 40, 48, 56, 64, 80, 96, 112, 128, 144, 160 kbit/s

이러한 샘플링 속도는 MPEG-1 오디오에 대해 원래 정의한 샘플링의 정확히 절반이다.그것들은 낮은 비트 전송률로 오디오를 인코딩할 때 더 높은 음질을 유지하기 위해 도입되었다.[25]짝수 비트 전송률은 MPEG-1 오디오가 기존(c.94)보다 매우 낮은 비트 전송률(즉, 음성) 오디오 코덱보다 높은 품질을 제공할 수 있다는 것이 테스트 결과 밝혀졌기 때문에 도입되었다.[76]

제4부: 적합성 시험

MPEG-1 표준의 파트 4는 적합성 시험을 다루고 있으며 ISO/IEC-11172-4에 정의되어 있다.

적합성: 적합성을 테스트하기 위한 절차.

MPEG-1 오디오 및 비디오 디코더의 적합성을 테스트하기 위한 두 세트의 지침과 참조 비트스트림 및 인코더에 의해 생성된 비트스트림을 제공한다.[16][23]

5부: 참조 소프트웨어

MPEG-1 표준의 파트 5는 참조 소프트웨어를 포함하고 있으며 ISO/IEC TR 11172–5에 정의되어 있다.

시뮬레이션:참조 소프트웨어.

오디오 및 비디오의 인코딩 및 디코딩, 멀티플렉싱 및 디멀티플렉싱에 대한 C 참조 코드.[16][23]

여기에는 LAME과 TooLAME이 원래 기반이었던 ISO Dist10 오디오 인코더 코드가 포함된다.

파일 확장자

.mpg는 MPEG-1 또는 MPEG-2 오디오 및 비디오 압축을 위한 다수의 파일 확장자 중 하나이다.MPEG-1 Part 2 비디오는 오늘날 드물며, 이 확장자는 일반적으로 MPEG 프로그램 스트림(MPEG-1 및 MPEG-2에서 정의됨) 또는 MPEG 전송 스트림(MPEG-2에서 정의됨)을 가리킨다..m2ts와 같은 다른 접미사들도 이 경우 MPEG-2 TS를 정밀한 용기를 명시하는 것이 존재하지만, 이것은 MPEG-1 매체와 거의 관련성이 없다.

.mp3는 MP3 오디오(일반적으로 MPEG-1 오디오, 때로는 MPEG-2 오디오)를 포함하는 파일의 가장 일반적인 확장명이다.MP3 파일은 전형적으로 무포함식의 원시 오디오 스트림이다. MP3 파일에 태그를 붙이는 일반적인 방법은 미디어 정보는 보존하지만 플레이어에 의해 폐기되는 각 프레임의 "쓰레기" 세그먼트에 데이터를 쓰는 것이다.이것은 많은 점에서 얼마나 날것인가와 비슷하다.AAC 파일에는 태그가 지정되지만, 오늘날에는 iTunes와 같이 덜 지원되고 있다.

이 방법이 적용되지만, .mpg는 일반적으로 MPEG-2 Part 7 Containers에 원시 AAC 또는 AAC를 추가하지 않는다..aac 확장자는 일반적으로 이러한 오디오 파일을 나타낸다.

참고 항목

- MPEG The Moving Picture Experts Group, MPEG-1 표준 개발자

- MP3 MPEG-1 오디오 레이어 III에 대한 기술적 세부 정보 감소

- MPEG 멀티채널 MPEG-1 오디오 레이어 II로 호환되는 5.1 채널 서라운드 사운드 확장

- MPEG-2 MPEG-1 표준의 직접적인 계승.

- ISO/IEC JTC 1/SC 29

- 구현

- Libavcodec에는 MPEG-1/2 비디오/오디오 인코더 및 디코더가 포함됨

- Mjpegtools MPEG-1/2 비디오/오디오 인코더

- TooLame 고품질 MPEG-1 오디오 레이어 II 인코더.

- LIME 고품질 MP3 오디오 인코더.

- Musepack A 형식은 원래 MPEG-1 오디오 레이어 II를 기반으로 하지만 지금은 호환되지 않는다.

참조

- ^ a b PatelK, 스미스는 BC, 로우 LA(1993-09-01)."소프트웨어 MPEG비디오 디코더의 성능".제1차 ACM국제 회의 멀티 미디어에 회보.ACM멀티 미디어.뉴욕:미국 컴퓨터 학회:75–82. doi:10.1145/166266.166274.아이 에스비엔 978-0-89791-596-0.신문에 기준 3에 위원회 초안 표준/IEC11172 12월 6일 1991년이다.

- ^ a b c d e f Adler, Mark; Popp, Harald; Hjerde, Morten (November 9, 1996), MPEG-FAQ: multimedia compression [1/9], faqs.org, archived from the original on January 4, 2017, retrieved 2016-11-11

- ^ a b c d e f g h Le Gall, Didier (April 1991), MPEG: a video compression standard for multimedia applications (PDF), Communications of the ACM, archived (PDF) from the original on 2017-01-27, retrieved 2016-11-11

- ^ Chiariglione, Leonardo (October 21, 1989), Kurihama 89 press release, ISO/IEC, archived from the original on August 5, 2010, retrieved 2008-04-09

- ^ ISO/IEC JTC 1/SC 29 (2009-10-30). "Programme of Work — Allocated to SC 29/WG 11, MPEG-1 (Coding of moving pictures and associated audio for digital storage media at up to about 1,5 Mbit/s)". Archived from the original on 2013-12-31. Retrieved 2009-11-10.

- ^ ISO. "ISO/IEC 11172-1:1993 – Information technology – Coding of moving pictures and associated audio for digital storage media at up to about 1,5 Mbit/s – Part 1: Systems". Archived from the original on 2016-11-12. Retrieved 2016-11-11.

- ^ MPEG. "About MPEG – Achievements". chiariglione.org. Archived from the original on 2008-07-08. Retrieved 2009-10-31.

- ^ MPEG. "Terms of Reference". chiariglione.org. Archived from the original on 2010-02-21. Retrieved 2009-10-31.

- ^ a b MPEG. "MPEG standards – Full list of standards developed or under development". chiariglione.org. Archived from the original on 2010-04-20. Retrieved 2009-10-31.

- ^ Lea, William (1994). Video on demand: Research Paper 94/68. House of Commons Library. Archived from the original on 20 September 2019. Retrieved 20 September 2019.

- ^ "History of Video Compression". ITU-T. Joint Video Team (JVT) of ISO/IEC MPEG & ITU-T VCEG (ISO/IEC JTC1/SC29/WG11 and ITU-T SG16 Q.6). July 2002. pp. 11, 24–9, 33, 40–1, 53–6. Retrieved 3 November 2019.

- ^ Ghanbari, Mohammed (2003). Standard Codecs: Image Compression to Advanced Video Coding. Institution of Engineering and Technology. pp. 1–2. ISBN 9780852967102.

- ^ "The History of Video File Formats Infographic". RealNetworks. 22 April 2012. Retrieved 5 August 2019.

- ^ Hans Geog Musmann, Genesis of the MP3 Audio Coding Standard (PDF), archived from the original (PDF) on 2012-01-17, retrieved 2011-07-26

- ^ Fogg, Chad (April 2, 1996), MPEG-2 FAQ, University of California, Berkeley, archived from the original on August 29, 2000, retrieved 2008-04-09

- ^ a b c d e f g h i j k l Fogg, Chad (April 2, 1996), MPEG-2 FAQ (archived website), University of California, Berkeley, archived from the original on 2008-06-16, retrieved 2016-11-11

- ^ Chiariglione, Leonardo (March 2001), Open source in MPEG, Linux Journal, archived from the original on 2011-07-25, retrieved 2008-04-09

- ^ a b c d Chiariglione, Leonardo; Le Gall, Didier; Musmann, Hans-Georg; Simon, Allen (September 1990), Press Release – Status report of ISO MPEG, ISO/IEC, archived from the original on 2010-02-14, retrieved 2008-04-09

- ^ Meetings, ISO/IEC, archived from the original on 2010-02-10, retrieved 2008-04-09

- ^ a b "The MPEG-FAQ, Version 3.1". Archived from the original on 2009-07-23. Retrieved 2008-10-12.

Q. Well, then how do I get the documents, like the MPEG I draft? A. MPEG is a draft ISO standard. It's [sic] exact name is ISO CD 11172. [...] You may order it from your national standards body (e.g. ANSI in the USA) or buy it from companies like OMNICOM [...]

- ^ "MPEG Press Release" (Press release). ISO/IEC JTC1/SC29/WG11. 6 November 1992. Archived from the original on 12 August 2010. Retrieved 7 May 2018.

- ^ "Archived copy". Archived from the original on 2008-10-06. Retrieved 2008-07-13.

{{cite web}}: CS1 maint: 타이틀(링크)로 보관된 복사본 : CS1 maint: 타이틀로 보관된 복사본(링크) A Continuous Media Player, Lawrence A.Rowe와 Brian C.스미스, 프로크 3번지샌디에이고 CA의 디지털 오디오 및 비디오를 위한 네트워크 및 OS 지원 워크샵 (1992년 [dead link]11월 - ^ a b c Achievements, ISO/IEC, archived from the original on 2008-07-08, retrieved 2008-04-03

- ^ Chiariglione, Leonardo (November 6, 1992), MPEG Press Release, London, 6 November 1992, ISO/IEC, archived from the original on 12 August 2010, retrieved 2008-04-09

- ^ a b c Wallace, Greg (April 2, 1993), Press Release, ISO/IEC, archived from the original on August 6, 2010, retrieved 2008-04-09

- ^ a b c d Popp, Harald; Hjerde, Morten (November 9, 1996), MPEG-FAQ: multimedia compression [2/9], faqs.org, archived from the original on January 4, 2017, retrieved 2016-11-11

- ^ "INTERNATIONAL ORGANISATION FOR STANDARDISATION ORGANISATION INTERNATIONALE DE NORMALISATION ISO". 26 July 2010. Archived from the original on 26 July 2010. Retrieved 7 May 2018.

- ^ ISO/IEC JTC 1/SC 29 (2010-07-17). "MPEG-1 (Coding of moving pictures and associated audio for digital storage media at up to about 1,5 Mbit/s)". Archived from the original on 2013-12-31. Retrieved 2010-07-18.

- ^ ISO. "ISO/IEC 11172-1:1993 – Information technology – Coding of moving pictures and associated audio for digital storage media at up to about 1,5 Mbit/s – Part 1: Systems". Archived from the original on 2017-08-30. Retrieved 2016-11-11.

- ^ ISO. "ISO/IEC 11172-2:1993 – Information technology – Coding of moving pictures and associated audio for digital storage media at up to about 1,5 Mbit/s – Part 2: Video". Archived from the original on 2017-08-30. Retrieved 2016-11-11.

- ^ ISO. "ISO/IEC 11172-3:1993 – Information technology – Coding of moving pictures and associated audio for digital storage media at up to about 1,5 Mbit/s – Part 3: Audio". Archived from the original on 2017-05-15. Retrieved 2016-11-11.

- ^ ISO. "ISO/IEC 11172-4:1995 – Information technology – Coding of moving pictures and associated audio for digital storage media at up to about 1,5 Mbit/s – Part 4: Compliance testing". Archived from the original on 2017-08-30. Retrieved 2016-11-11.

- ^ ISO. "ISO/IEC TR 11172-5:1998 – Information technology – Coding of moving pictures and associated audio for digital storage media at up to about 1,5 Mbit/s – Part 5: Software simulation". Archived from the original on 2017-08-30. Retrieved 2016-11-11.

- ^ Ozer, Jan (October 12, 2001), Choosing the Optimal Video Resolution: The MPEG-2 Player Market, extremetech.com, archived from the original on June 7, 2011, retrieved 2016-11-11

- ^ Comparison between MPEG 1 & 2, archived from the original on 2012-02-10, retrieved 2016-11-11

- ^ MPEG 1 And 2 Compared, Pure Motion Ltd., 2003, archived from the original on 2005-12-14, retrieved 2008-04-09

- ^ Dave Singer (2007-11-09). "homework] summary of the video (and audio) codec discussion". Archived from the original on December 21, 2016. Retrieved November 11, 2016.

- ^ "MPEG-1 Video Coding (H.261)". Library of Congress, Digital Preservation. October 21, 2014. Archived from the original on January 11, 2017. Retrieved 2016-11-11.

- ^ "ISO Standards and Patents". Archived from the original on 2016-11-15. Retrieved 2016-11-11.

Search for 11172

- ^ MPEG-1, H.261 및 MPEG-2의 특허 현황

- ^ "[gst-devel] Can a MPEG-1 with Audio Layers 1&2 plugin be in plugins-good (patentwise)?". SourceForge.net. 2008-08-23. Archived from the original on 2014-02-02. Retrieved 2016-11-11.

- ^ "Archived copy". lists.whatwg.org. Archived from the original on 19 July 2011. Retrieved 11 January 2022.

{{cite web}}: CS1 maint: 타이틀로 보관된 사본(링크) - ^ http://patft1.uspto.gov/netacgi/nph-Parser?patentnumber=5214678 2012-07-13을 아카이브에 보관.오늘 "디지털 신호의 서브밴드 부호화를 이용한 디지털 전송 시스템" 파일:1990년 5월 31일, 1993년 5월 25일 부여, 2010년 5월 31일 만료?

- ^ "mp3". Fraunhofer Institute for Integrated Circuits IIS. Archived from the original on 22 March 2018. Retrieved 7 May 2018.

- ^ "ISO Standards and Patents". ISO. Retrieved 10 July 2019.

- ^ a b c d e f g Grill, B.; Quackenbush, S. (October 2005), MPEG-1 Audio, ISO/IEC, archived from the original on 2010-04-30

- ^ Chiariglione, Leonardo, MPEG-1 Systems, ISO/IEC, archived from the original on 2016-11-12, retrieved 2016-11-11

- ^ a b Pack Header, archived from the original on 2016-10-27, retrieved 2016-11-11

- ^ Fimoff, Mark; Bretl, Wayne E. (December 1, 1999), MPEG2 Tutorial, archived from the original on November 12, 2016, retrieved 2016-11-11

- ^ Fimoff, Mark; Bretl, Wayne E. (December 1, 1999), MPEG2 Tutorial, archived from the original on November 5, 2016, retrieved 2016-11-11

- ^ Fimoff, Mark; Bretl, Wayne E. (December 1, 1999), MPEG2 Tutorial, archived from the original on November 5, 2016, retrieved 2016-11-11

- ^ Fimoff, Mark; Bretl, Wayne E. (December 1, 1999), MPEG2 Tutorial, archived from the original on November 12, 2016, retrieved 2016-11-11

- ^ Acharya, Soam, 스미스, 브라이언(1998년), 압축력을 번 트랜스 코딩 MPEG, Cornell대학, IEEE컴퓨터 학회 IEEE국제 회의 멀티 미디어 컴퓨팅에 시스템의 페이지의 주 3이면 2011-02-23에 원래에서 보관 시(:양자화 매트릭스 다르다고 말한다, 현명한 독서가 필요합니다만 그냥 불량자 문제 그리고 2016-11-11 – 돌려받지 못 했다. )(등록을 하여야 하)선택할 수

- ^ a b c Wee, Susie J.; Vasudev, Bhaskaran; Liu, Sam (March 13, 1997), Transcoding MPEG Video Streams in the Compressed Domain, Hewlett-Packard, CiteSeerX 10.1.1.24.633, archived from the original on 2007-08-17, retrieved 2016-11-11

- ^ "Archived copy". Archived from the original on 2009-05-03. Retrieved 2009-05-03.

{{cite web}}: CS1 maint: 타이틀로 보관된 사본(링크) - ^ a b c d e f Thom, D.; Purnhagen, H. (October 1998), MPEG Audio FAQ Version 9, ISO/IEC, archived from the original on 2010-02-18, retrieved 2016-11-11

- ^ MPEG Audio Frame Header, archived from the original on 2015-02-08, retrieved 2016-11-11

- ^ a b c d e f Church, Steve, Perceptual Coding and MPEG Compression, NAB Engineering Handbook, Telos Systems, archived from the original on 2001-05-08, retrieved 2008-04-09

- ^ a b c d e f g h i j Pan, Davis (Summer 1995), A Tutorial on MPEG/Audio Compression (PDF), IEEE Multimedia Journal, p. 8, archived from the original (PDF) on 2004-09-19, retrieved 2008-04-09

- ^ Smith, Brian (1996), A Survey of Compressed Domain Processing Techniques, Cornell University, p. 7, archived from the original on 2011-02-23, retrieved 2008-04-09(필요한 경우)

- ^ Cheng, Mike, Psychoacoustic Models in TwoLAME, twolame.org, archived from the original on 2016-10-22, retrieved 2016-11-11

- ^ Grill, B.; Quackenbush, S. (October 2005), MPEG-1 Audio, archived from the original on 2008-04-27, retrieved 2016-11-11

- ^ a b Herre, Jurgen (October 5, 2004), From Joint Stereo to Spatial Audio Coding (PDF), International Conference on Digital Audio Effects, p. 2, archived from the original (PDF) on April 5, 2006, retrieved 2008-04-17

- ^ C.그루인과 T.Ryden, 저비트율 오디오 코덱에 대한 주관적 평가, 제10차 국제 AES 회의, 페이지 91 - 102, 런던 1991

- ^ J. Johnston, Proc에서 소음 마스킹 기준을 이용한 지각 엔트로피 추정.ICASSP-88, 페이지 2524-2527, 1988년 5월.

- ^ J. Johnston, 지각 소음 기준을 이용한 오디오 신호의 변환 코딩, IEEE 저널, 제6권, 제2권, 제2권, 제314권-323권, 1988년 2월.

- ^ Wustenhagen 외, 다채널 오디오 코덱의 주관적 청취 테스트, AES 105차 컨벤션 페이퍼 4813, 샌프란시스코 1998

- ^ a b B/MAE Project Group (September 2007), EBU evaluations of multichannel audio codecs (PDF), European Broadcasting Union, archived from the original (PDF) on 2008-10-30, retrieved 2008-04-09

- ^ a b Meares, David; Watanabe, Kaoru; Scheirer, Eric (February 1998), Report on the MPEG-2 AAC Stereo Verification Tests (PDF), ISO/IEC, p. 18, archived from the original (PDF) on April 14, 2008, retrieved 2016-11-11

- ^ Painter, Ted; Spanias, Andreas (April 2000), Perceptual Coding of Digital Audio (Proceedings of the IEEE, VOL. 88, NO. 4) (PDF), Proceedings of the IEEE, archived from the original (PDF) on September 16, 2006, retrieved 2016-11-11

- ^ Amorim, Roberto (September 19, 2006), GPSYCHO - Mid/Side Stereo, LAME, archived from the original on December 16, 2016, retrieved 2016-11-11

- ^ ISO (October 1998). "MPEG Audio FAQ Version 9 – MPEG-1 and MPEG-2 BC". ISO. Archived from the original on 2010-02-18. Retrieved 2016-11-11.

- ^ D. Thom, H. Purnhagen, and the MPEG Audio Subgroup (October 1998). "MPEG Audio FAQ Version 9 - MPEG Audio". Archived from the original on 2011-08-07. Retrieved 2016-11-11.

{{cite web}}: CS1 maint : 복수이름 : 작성자 목록(링크) - ^ MPEG.ORG. "AAC". Archived from the original on 2007-08-31. Retrieved 2009-10-28.

- ^ ISO (2006-01-15), ISO/IEC 13818-7, Fourth edition, Part 7 – Advanced Audio Coding (AAC) (PDF), archived (PDF) from the original on 2009-03-06, retrieved 2016-11-11

- ^ Chiariglione, Leonardo (November 11, 1994), Press Release, ISO/IEC, archived from the original on August 8, 2010, retrieved 2008-04-09