고대역폭 메모리

High Bandwidth Memory

| 컴퓨터 메모리 및 데이터 스토리지 유형 |

|---|

| 휘발성 |

| 비휘발성 |

HBM(High Bandwidth Memory)은 삼성, AMD 및 SK하이닉스가 초기에 출시한 3D 스택 동기식 다이내믹 랜덤 액세스 메모리(SDRAM)용 고속 컴퓨터 메모리 인터페이스입니다.고성능 그래픽 액셀러레이터, 네트워크 디바이스, 고성능 데이터센터 AI ASIC 및 FPGA 및 일부 슈퍼컴퓨터(NEC SX-Aurora TSUBASA 및 Fujitsu A64FX [1]등)와 함께 사용됩니다.HBM 메모리 칩은 2013년 SK하이닉스가 처음 [2]생산했고,[3][4] HBM을 최초로 사용한 장치는 2015년 AMD 피지 GPU였다.

고대역폭 메모리는 2013년 10월에 JEDEC에 [5]의해 업계 표준으로 채택되었습니다.2세대인 HBM2는 2016년 [6]1월에 JEDEC에 의해 승인되었다.

테크놀로지

HBM은 DDR4나 GDDR5보다 [7]훨씬 작은 폼 팩터로 소비전력을 줄이면서 대역폭을 더 크게 만듭니다.이것은 최대 8개의 DRAM 다이와 버퍼 회로 및 테스트 [8]로직을 포함할 수 있는 옵션의 베이스 다이로 적층함으로써 실현됩니다.스택은 종종 실리콘 인터포저 [9][10]등의 기판을 통해 GPU 또는 CPU의 메모리 컨트롤러에 연결됩니다.또는 메모리 다이(Die)를 CPU 또는 GPU 칩에 직접 스택할 수도 있습니다.다이는 스택 내에서 스루실리콘비아(TSV)와 마이크로펌프에 의해 수직으로 상호 연결됩니다.HBM 기술은 원리는 비슷하지만 마이크론 [11]테크놀로지가 개발한 하이브리드 메모리 큐브(HMC) 인터페이스와 호환되지 않습니다.

HBM 메모리버스는 DDR4나 GDDR5 등의 다른 DRAM 메모리에 비해 폭이 매우 넓습니다.D램 다이 4개(4-Hi)의 HBM 스택에는 다이당 128비트 채널이 2개씩 있어 총 8채널, 총 폭은 1024비트입니다.따라서 4개의 4개의 Hi HBM 스택이 있는 그래픽 카드/GPU에는 4096비트 폭의 메모리 버스가 있습니다.이에 비해 GDDR 메모리의 버스 폭은 32비트이며 512비트 메모리 인터페이스를 [12]갖춘 그래픽 카드용 채널은 16개입니다.HBM은 패키지당 최대 4GB를 지원합니다.

DDR4 또는 GDDR5에 비해 메모리 접속 수가 많아지려면 HBM 메모리를 GPU(또는 다른 프로세서)[13]에 접속하는 새로운 방법이 필요했습니다.AMD와 Nvidia는 모두 메모리와 GPU를 연결하기 위해 특별한 용도로 제작된 실리콘 칩을 사용했습니다.이 인터포저는 메모리와 프로세서가 물리적으로 가까이 있어야 메모리 경로를 줄일 수 있다는 장점이 있습니다.그러나 반도체 소자 제작은 프린트 기판 제작보다 비용이 훨씬 많이 들기 때문에 최종 제품에 비용이 추가됩니다.

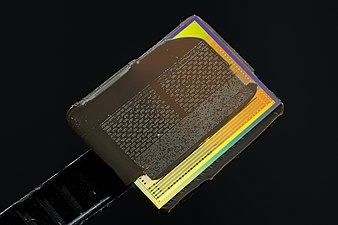

AMD Rade on R9 Nano 그래픽 카드의 GPU 패키지에 탑재된 HBM 메모리

인터페이스

HBM DRAM은 분산 인터페이스를 통해 호스트 컴퓨팅 다이와 긴밀하게 결합됩니다.인터페이스는 독립된 채널로 분할됩니다.채널은 서로 완전히 독립적이며 서로 동기화할 필요는 없습니다.HBM DRAM은 와이드 인터페이스 아키텍처를 사용하여 고속 저전력 동작을 실현합니다.HBM DRAM은 500MHz 차분 클럭 CK_t/CK_c를 사용합니다(서픽스 '_t'는 차분 쌍의 컴포넌트인 'true' 또는 'positive'를 나타내고 '_c'는 '보완적'을 나타냅니다).명령어는 CK_t, CK_c의 상승 에지에 등록됩니다.각 채널 인터페이스는 128비트 데이터 버스를 DDR(Double Data Rate)로 작동합니다.HBM은 핀당1 GT/s(1비트 전송)의 전송 레이트를 지원하므로 패키지 대역폭은 총 128GB/[14]s가 됩니다.

HBM2

또한 2세대 고대역폭 메모리인 HBM2는 스택당 최대 8개의 다이(die)를 지정하고 핀 전송 속도를 최대 2GT/s까지 2배로 높입니다.1024비트의 와이드 액세스를 유지하는 HBM2는 패키지당 256GB/s의 메모리 대역폭에 도달할 수 있습니다.HBM2 사양에서는 패키지당 최대 8GB를 사용할 수 있습니다.HBM2는 가상현실과 [15]같은 성능에 민감한 소비자 애플리케이션에 특히 유용할 것으로 예상됩니다.

2016년 1월 19일, 삼성은 HBM2의 초기 양산을 [16][17]스택당 최대 8GB로 발표했다.SK하이닉스도 [18]2016년 8월 4GB 스택 출시를 발표했다.

Rade on RX Vega 64 GPU의 HBM2 인터포저는 HBM이 제거되어 있지만 GPU는 그대로입니다.

HBM2E

2018년 말, JEDEC은 HBM2 사양에 대한 업데이트를 발표하여 대역폭과 [19]용량을 늘렸습니다.공식 사양에서는 스택당 최대 307 GB/s (유효 데이터 레이트 2.5 Tbit/s)가 지원되고 있지만, 이 속도로 동작하는 제품은 이미 제공되고 있습니다.또한 업데이트에서는 12-Hi 스택(12개의 다이) 지원이 추가되어 스택당 최대 24GB의 용량이 가능합니다.

2019년 3월 20일, 삼성은 스택당 8개의 다이,[20] 3.2 GT/s의 전송 속도를 특징으로 하는 Flashbolt HBM2E를 발표했다.

2019년 8월 12일 SK하이닉스는 스택당 8개의 다이, 전송 속도 3.6 GT/s, 총 16GB,[21][22] 460GB/s의 HBM2E를 발표했습니다.SK하이닉스는 2020년 7월 2일 양산이 [23]시작됐다고 발표했다.

HBM3

2020년 말, 마이크론은 HBM2E 표준이 업데이트 될 것이라고 발표했고, HBMnext로 알려진 다음 표준(나중에 HBM3로 개명)을 공개했다.이는 HBM2에서 HBM2E로 대체되는 큰 세대 도약이었습니다. 이 새로운 VRAM은 2022년 4분기에 출시될 예정입니다.이 경우 이름에서 알 수 있듯이 새로운 아키텍처가 도입될 수 있습니다.

아키텍처는 정비될 수 있지만 누출은 업데이트된 HBM2E 표준과 유사한 성능을 나타냅니다.이 RAM은 데이터센터 GPU에서 [24][25][26][27]주로 사용됩니다.

2021년 중반 SK하이닉스는 패키지당 5.2기가비트/초 I/O 속도와 665GB/초의 대역폭을 갖춘 HBM3 규격의 일부 사양과 최대 16개의 2.5D [28][29]및 3D 솔루션을 공개했다.

HBM3에 대한 JEDEC 표준이 완성되기 전인 2021년 10월 20일, SK 하이닉스는 HBM3 메모리 디바이스의 개발을 완료했다고 발표한 최초의 메모리 벤더였습니다.SK하이닉스에 따르면 메모리는 6.4Gbps/핀으로 동작하며, 이는 공식적으로 3.2Gbps/핀으로 동작하는 JEDEC 표준 HBM2E의 데이터 전송 속도를 두 배로 높이며, 이는 SK하이닉스의 3.6Gbps/핀 HBM2E보다 78% 더 빠른 속도이다.HBM3의 기본 버스 폭은 변경되지 않고 단일 메모리 스택의 폭은 1024비트입니다.SK하이닉스는 16GB와 24GB 두 가지 용량으로 메모리를 8Hi와 12Hi 스택으로 각각 정렬할 예정이다.스택은 각각 30μm 두께의 16Gb D램 8개 또는 12개로 구성되며, TSV([30][31][32]Through Silicon Vias)를 사용하여 상호 연결됩니다.

Anandtech의 Ryan Smith에 따르면 SK하이닉스 1세대 HBM3 메모리의 밀도는 최신 HBM2E 메모리와 동일하며 차세대 부품의 총 메모리 용량을 늘리려면 디바이스 벤더가 일반적으로 사용하던 8층 스택에서 12층까지 메모리를 사용해야 한다고 합니다.Tom's Hardware의 Anton Shilov에 따르면 고성능 컴퓨팅 GPU 또는 FPGA는 일반적으로 4~6개의 HBM 스택을 사용하기 때문에 SK 하이닉스의 HBM3 24GB 스택에서는 3.2TB/s 또는 4.9TB/s의 메모리 대역폭을 얻을 수 있다고 합니다.[30]그는 또 SK하이닉스의 HBM3 칩이 HBM2나 HBM2E [31]칩처럼 직사각형이 아닌 사각형이라고 지적했다.더 레지스터의 Chris Mellor에 따르면 JEDEC이 아직 HBM3 표준을 개발하지 않은 상황에서 SK 하이닉스가 미래적이고 더 빠른 [32]표준으로 디자인을 수정해야 한다는 것을 의미할 수 있다.

JEDEC은 2022년 [33]1월 27일 HBM3 표준을 공식적으로 발표했다.메모리 채널의 수는 HBM2e의 경우 128비트 8채널에서 HBM3의 경우 64비트 16채널로 2배 증가했습니다.따라서 인터페이스의 총 데이터 핀 수는 [34]1024개입니다.

2022년 6월 SK하이닉스는 업계 최초로 엔비디아 H100 GPU에 탑재되는 HBM3 메모리 양산을 시작했다고 밝혔다.이 메모리는 H100에 "최대 819 GB/s"[35]의 메모리 대역폭을 제공합니다.

HBM-PIM

2021년 2월 삼성은 메모리 처리(PIM)를 탑재한 HBM 개발을 발표했다.이 새로운 메모리는 대용량 데이터 처리를 증가시키기 위해 메모리 내부에 AI 컴퓨팅 기능을 가져옵니다.DRAM에 최적화된 AI 엔진을 각 메모리 뱅크 내부에 배치하여 병렬 처리를 가능하게 하고 데이터 이동을 최소화한다.삼성은 이를 통해 시스템 성능을 2배 향상시키고 에너지 소비량을 70% 이상 절감하면서 [36]시스템의 나머지 부분에 하드웨어나 소프트웨어를 변경할 필요가 없다고 주장합니다.

역사

배경

다이스택 메모리는 플래시 메모리 업계에서 처음 상용화됐다.도시바는 2007년 [37]4월 8개의 다이가 쌓여있는 낸드플래시 메모리 칩을 선보인 데 이어 하이닉스반도체는 2007년 [38]9월 24개의 다이가 쌓여있는 낸드플래시 칩을 선보였다.

스루실리콘 비아(TSV) 기술을 이용한 3D 스택 랜덤 액세스 메모리(RAM)는 2009년 9월 8GB D램 칩(DDR3 SDRAM 다이 4개로 스택)을 최초로 개발해 2011년 6월 출시했다.2011년에는 SK하이닉스가 TSV [2]기술을 적용한 16GB DDR3 메모리(40nm급)를, 9월에는 삼성전자가 TSV 기반 3D 적층형 32GB DDR3(30nm급)를 선보인 데 이어 [39]10월에는 삼성마이크론테크놀로지가 TSV 기반 하이브리드 메모리 큐브(HMC)를 발표했다.

JEDEC은 4개의 128비트 채널과 싱글 데이터 레이트 클로킹을 갖춘 HBM의 전신인 와이드 IO [40]메모리의 JESD229 표준을 2011년 12월에 몇 년간의 작업 끝에 처음 발표했습니다.최초의 HBM 표준 JESD235는 2013년 10월에 도입되었습니다.

발전

고대역폭 메모리의 개발은 2008년 AMD에서 컴퓨터 메모리의 전력 소비와 폼 팩터의 증가를 해결하기 위해 시작되었습니다.이후 몇 년 동안 AMD는 AMD의 선임 펠로우인 Bryan [41]Black이 이끄는 팀과 함께 다이스택 문제를 해결하기 위한 절차를 개발했습니다.AMD는 HBM에 대한 비전을 실현하기 위해 메모리 업계, 특히 3D 스택 [2][38]메모리 경험이 있는 국내 [41]업체 SK하이닉스를 비롯해 인터포저 업계(대만 UMC)와 패키징 업계(암코어 테크놀로지,[41] ASE) 협력사를 영입했다.

HBM 개발은 SK하이닉스가 HBM 메모리칩을 [2]처음 개발한 2013년 완료됐다.HBM은 2010년 [5]AMD와 SK하이닉스의 제안에 따라 2013년 10월 JEDEC에 의해 업계 표준 JESD235로 채택되었습니다.2015년 이천의 하이닉스 공장에서 대량 생산이 시작됐다.

HBM을 이용한 최초의 GPU는 2015년 6월에 출시된 AMD 피지로 AMD Radeon [3][42][43]R9 Fury X를 탑재했습니다.

삼성전자는 2016년 1월 HBM2 [16][17]조기 양산을 시작했다.같은 달, HBM2는 JEDEC에 의해 표준 JESD235a로서 받아들여졌습니다.[6]HBM2를 활용한 첫 GPU 칩은 2016년 [44][45]4월 공식 발표된 엔비디아 테슬라 P100이다.

2016년 6월 인텔은 8스택의 HDRAM을 탑재한 Xeon Phi 프로세서 패밀리를 출시했습니다.HCDRAM은 Micron의 HBM 버전입니다.2016년 8월 핫칩스에서 삼성과 하이닉스는 모두 차세대 HBM 메모리 [46][47]기술을 발표했다.양사 모두 고밀도, 대역폭, 소비전력 절감을 기대할 수 있는 고성능 제품을 발표했습니다.삼성은 대중 시장을 겨냥해 개발 중인 저가형 HBM도 발표했다.버퍼 다이를 제거하고 TSV 수를 줄이면 전체 대역폭(200GB/s)이 감소하지만 비용이 절감됩니다.

엔비디아는 2022년 [48]3월 22일 HBM3를 채용한 세계 최초의 GPU인 Nvidia Hopper GH100 GPU를 발표했다.

「 」를 참조해 주세요.

- 스택드 DRAM

- eDRAM

- 칩 스택 멀티칩 모듈

- 하이브리드 메모리 큐브: Micron Technology(2011년)의 스택형 메모리 표준

레퍼런스

- ^ ISSCC 2014 Trends Archived 2015-02-06 Wayback Machine 페이지 118 "고대역폭 DRAM"

- ^ a b c d "History: 2010s". SK Hynix. Retrieved 8 July 2019.

- ^ a b Smith, Ryan (2 July 2015). "The AMD Radeon R9 Fury X Review". Anandtech. Retrieved 1 August 2016.

- ^ Morgan, Timothy Prickett (March 25, 2014). "Future Nvidia 'Pascal' GPUs Pack 3D Memory, Homegrown Interconnect". EnterpriseTech. Retrieved 26 August 2014.

Nvidia will be adopting the High Bandwidth Memory (HBM) variant of stacked DRAM that was developed by AMD and Hynix

- ^ a b 고대역폭 메모리(HBM) DRAM(JESD235), JEDEC, 2013년 10월

- ^ a b "JESD235a: High Bandwidth Memory 2". 2016-01-12.

- ^ HBM: 대역폭이 부족한 프로세서를 위한 메모리 솔루션 2015-04-24 Wayback Machine, Kim Joonyoung and Kim Yonsu, SK Highix // Hot Chips 26, 2014년 8월

- ^ Sohn et.al. (Samsung) (January 2017). "A 1.2 V 20 nm 307 GB/s HBM DRAM With At-Speed Wafer-Level IO Test Scheme and Adaptive Refresh Considering Temperature Distribution". IEEE Journal of Solid-State Circuits. 52 (1): 250–260. Bibcode:2017IJSSC..52..250S. doi:10.1109/JSSC.2016.2602221. S2CID 207783774.

{{cite journal}}: CS1 maint :url-status (링크) - ^ "What's Next for High Bandwidth Memory". 17 December 2019.

- ^ "Interposers".

- ^ DRAM 인터페이스의 방향2018-06-15 Wayback Machine // EETimes, 2014년 4월 18일 "하이브리드 메모리 큐브(HMC) 및 HBM(High-Bandwidth Memory)라는 경쟁 기술은 컴퓨팅 및 네트워킹 애플리케이션을 대상으로 합니다. 이러한 접근 방식은 논리 칩 위에 여러 개의 DRAM 칩을 쌓아 올립니다."

- ^ High Bandwidth Memory(HBM; 고대역폭 메모리) 규격의 개요.NVidia, Sr. Research Scientist, Mike O'Connor // 메모리 포럼 – 2014년 6월 14일

- ^ Smith, Ryan (19 May 2015). "AMD Dives Deep On High Bandwidth Memory – What Will HBM Bring to AMD?". Anandtech. Retrieved 12 May 2017.

- ^ "High-Bandwidth Memory (HBM)" (PDF). AMD. 2015-01-01. Retrieved 2016-08-10.

- ^ Valich, Theo (2015-11-16). "NVIDIA Unveils Pascal GPU: 16GB of memory, 1TB/s Bandwidth". VR World. Retrieved 2016-01-24.

- ^ a b "Samsung Begins Mass Producing World's Fastest DRAM – Based on Newest High Bandwidth Memory (HBM) Interface". news.samsung.com.

- ^ a b "Samsung announces mass production of next-generation HBM2 memory – ExtremeTech". 19 January 2016.

- ^ Shilov, Anton (1 August 2016). "SK Hynix Adds HBM2 to Catalog". Anandtech. Retrieved 1 August 2016.

- ^ "JEDEC Updates Groundbreaking High Bandwidth Memory (HBM) Standard" (Press release). JEDEC. 2018-12-17. Retrieved 2018-12-18.

- ^ "Samsung Electronics Introduces New High Bandwidth Memory Technology Tailored to Data Centers, Graphic Applications, and AI Samsung Semiconductor Global Website". www.samsung.com. Retrieved 2019-08-22.

- ^ "SK Hynix Develops World's Fastest High Bandwidth Memory, HBM2E". www.skhynix.com. August 12, 2019. Retrieved 2019-08-22.

- ^ "SK Hynix Announces its HBM2E Memory Products, 460 GB/S and 16GB per Stack".

- ^ "SK hynix Starts Mass-Production of High-Speed DRAM, "HBM2E"". 2 July 2020.

- ^ "Micron reveals HBMnext, a successor to HBM2e".

- ^ "Micron Announces HBMnext as Eventual Replacement for HBM2e in High-End GPUs". 14 August 2020.

- ^ "Micron Introduces HBMnext, GDDR6X, Confirms RTX 3090 - ExtremeTech".

- ^ "Micron unveils HBMnext, the successor to HBM2e for next-next-gen GPUs TweakTown".

- ^ "SK Hynix expects HBM3 memory with 665 GB/S bandwidth".

- ^ "HBM3 to Top 665 GBPS Bandwidth per Chip, SK Hynix Says". 9 June 2021.

- ^ a b Smith, Ryan (2021-10-20). "SK Hynix Announces Its First HBM3 Memory: 24GB Stacks, Clocked at up to 6.4Gbps". Anandtech. Retrieved 2021-10-22.

- ^ a b Shilov, Anton (2021-10-20). "SK Hynix Develops HBM3 DRAMs: 24GB at 6.4 GT/s over a 1024-Bit Bus". Tom's Hardware. Retrieved 2021-10-22.

- ^ a b Chris Mellor (2021-10-20). "SK hynix rolls out 819GB/s HBM3 DRAM". The Register. Retrieved 2021-10-24.

- ^ "JEDEC Publishes HBM3 Update to High Bandwidth Memory (HBM) Standard JEDEC".

- ^ Prickett Morgan, Timothy (6 April 2022). "The HBM3 roadmap is just getting started". TheNextPlatform. Retrieved 4 May 2022.

- ^ "SK hynix to Supply Industry's First HBM3 DRAM to NVIDIA (press release)". news.skhynix.com. 2022-06-08.

- ^ "Samsung Develops Industry's First High Bandwidth Memory with AI Processing Power".

- ^ "TOSHIBA COMMERCIALIZES INDUSTRY'S HIGHEST CAPACITY EMBEDDED NAND FLASH MEMORY FOR MOBILE CONSUMER PRODUCTS". Toshiba. April 17, 2007. Archived from the original on November 23, 2010. Retrieved 23 November 2010.

- ^ a b "Hynix Surprises NAND Chip Industry". Korea Times. 5 September 2007. Retrieved 8 July 2019.

- ^ Kada, Morihiro (2015). "Research and Development History of Three-Dimensional Integration Technology". Three-Dimensional Integration of Semiconductors: Processing, Materials, and Applications. Springer. pp. 15–8. ISBN 9783319186757.

- ^ "WIDE I/O SINGLE DATA RATE (WIDE I/O SDR) standard JESD229" (PDF).

{{cite web}}: CS1 maint :url-status (링크) - ^ a b c AMD의 고대역폭 메모리(HBM): 아름다운 메모리 만들기, AMD

- ^ Smith, Ryan (19 May 2015). "AMD HBM Deep Dive". Anandtech. Retrieved 1 August 2016.

- ^ [1] AMD가 혁신적인 HBM 테크놀로지를 탑재한 세계 최초의 그래픽 패밀리 등 PC 게임 신시대를 맞이하다

- ^ Smith, Ryan (5 April 2016). "Nvidia announces Tesla P100 Accelerator". Anandtech. Retrieved 1 August 2016.

- ^ "NVIDIA Tesla P100: The Most Advanced Data Center GPU Ever Built". www.nvidia.com.

- ^ Smith, Ryan (23 August 2016). "Hot Chips 2016: Memory Vendors Discuss Ideas for Future Memory Tech – DDR5, Cheap HBM & More". Anandtech. Retrieved 23 August 2016.

- ^ Walton, Mark (23 August 2016). "HBM3: Cheaper, up to 64GB on-package, and terabytes-per-second bandwidth". Ars Technica. Retrieved 23 August 2016.

- ^ "NVIDIA Announces Hopper Architecture, the Next Generation of Accelerated Computing".

외부 링크

- 고대역폭 메모리(HBM) DRAM(JESD235), JEDEC, 2013년 10월

- Lee, Dong Uk; Kim, Kyung Whan; Kim, Kwan Weon; Kim, Hongjung; Kim, Ju Young; et al. (9–13 Feb 2014). "A 1.2V 8Gb 8‑channel 128GB/s high-bandwidth memory (HBM) stacked DRAM with effective microbump I/O test methods using 29nm process and TSV". 2014 IEEE International Solid-State Circuits Conference – Digest of Technical Papers. IEEE (published 6 March 2014): 432–433. doi:10.1109/ISSCC.2014.6757501. ISBN 978-1-4799-0920-9. S2CID 40185587.

- HBM과 HBM2의 비교, GDDR5와 GDDR5X의 메모리 비교