아이 트래킹

Eye tracking아이 트래킹은 시선(시선 위치) 또는 머리에 대한 눈의 움직임을 측정하는 과정이다.아이 트래커는 눈의 위치와 눈의 움직임을 측정하기 위한 장치입니다.아이 트래커는 시각 시스템 연구, 심리학, 심리언어학, 마케팅, 인간과 컴퓨터의 상호작용을 위한 입력 장치 및 제품 디자인에 사용됩니다.아이 트래커는 재활 및 보조 애플리케이션(예: 휠체어, 로봇 팔 및 보철물 제어)에도 점점 더 많이 사용되고 있습니다.눈동자의 움직임을 측정하는 방법에는 여러 가지가 있습니다.가장 인기 있는 변형은 눈의 위치를 추출하는 비디오 이미지를 사용합니다.다른 방법은 검색 코일을 사용하거나 전기 적층도를 기반으로 합니다.

역사

1800년대에, 직접적인 관찰을 이용하여 안구 운동에 대한 연구가 이루어졌다.예를 들어, 1879년 루이 에밀 자발(Louis Emile Javal)은 독서는 이전에 가정한 대로 텍스트를 따라 눈을 부드럽게 쓸어내는 것이 아니라 일련의 짧은 정지(고정이라고 함)와 빠른 [1]성욕을 수반한다고 관찰했다.이러한 관찰은 1900년대에 탐구된 독서에 관한 중요한 질문을 제기하였다.어떤 단어에 눈이 멈추나요?얼마나요?그들은 언제 이미 본 단어로 퇴보합니까?

에드먼드 휴이는[2] 눈동자를 위한 구멍이 있는 콘택트렌즈 같은 것을 사용하여 초기 아이 트래커를 만들었다.렌즈는 눈의 움직임에 따라 움직이는 알루미늄 포인터에 연결되어 있었다.Huey는 퇴행을 연구하고 수량화했고(성케이드의 극히 일부만이 퇴행이다), 그는 문장의 일부 단어들이 고정되지 않는다는 것을 보여주었다.

최초의 비침입적 시선 추적기는 눈에 반사된 광선을 사용한 후 필름에 기록하는 시카고의 가이 토마스 버스웰에 의해 만들어졌다.버스웰은 체계적인 연구를 독서와 그림 [5]보기로 만들었다[3][4].

1950년대에, Alfred L[6]. Yarbus는 시선 추적 연구를 수행했고, 그의 1967년 책은 종종 인용된다.그는 피험자에게 주어진 과제가 피험자의 눈 움직임에 매우 큰 영향을 미친다는 것을 보여주었다.그는 고정과 관심사 사이의 관계에 대해서도 썼다.

모든 기록...안구운동의 특성이 사진의 소재와 어떻게 만들어졌는지, 평평하거나 거의 [7]평평하다는 전제 하에 완전히 독립적이거나 아주 약간만 의존한다는 것을 결정적으로 보여준다."

사진의 조사에서의 순환 패턴은, 「그림에 보이는 것 뿐만이 아니라, 관찰자가 직면하고 있는 문제나,[8] 그림으로부터 얻고 싶은 정보에 의해서도 좌우된다」.

눈의 움직임의 기록은 관찰자의 주의력이 보통 그림의 특정 요소에 의해서만 유지된다는 것을 보여준다.눈의 움직임은 인간의 사고 과정을 반영합니다; 그래서 관찰자의 생각은 눈의 움직임의 기록으로부터 어느 정도 따라갈 수 있습니다.이러한 기록으로부터 관찰자의 눈을 끄는 요소(결과적으로 관찰자의 사고)가 어떤 순서로, 그리고 얼마나 [7]자주 나타나는지 쉽게 판단할 수 있다.

관찰자의 관심은 종종 중요한 정보를 제공하지 않지만 그의 의견으로는 그렇게 할 수 있는 요소에 쏠린다.관찰자는 종종 특정 상황에서 특이한 요소, 낯선 요소, 이해할 수 없는 [9]요소 등에 주의를 집중합니다.

...고정점을 바꾸면 관찰자의 눈은 반복적으로 같은 그림 요소로 돌아갑니다.지각에 소요되는 추가 시간은 이차적인 요소를 조사하는 데 사용되는 것이 아니라 가장 중요한 요소를 [10]재점검하는 데 사용됩니다.

1970년대에는 시선 추적 연구, 특히 독서 연구가 급속히 확대되었다.이 기간 동안의 연구에 대한 좋은 개요는 레이너에 [13]의해 제공됩니다.

1980년에 저스트와[14] 카펜터는 "고정된 것과 처리되는 것 사이에 현저한 차이가 없다"는 영향력 있는 강안심 가설을 공식화했다.만약 이 가설이 맞다면, 피실험자가 단어나 사물을 볼 때, 그 혹은 그녀는 또한 그것에 대해 생각한다. 그리고 정확히 기록된 고정만큼 오랫동안.이 가설은 종종 아이 트래킹을 사용하는 연구자들에 의해 당연하게 받아들여진다.그러나 시선이 마주치는 기법은 공공연하고 은밀한 주의를 분산시키고 고정된 것과 처리되는 것을 구별하기 위해 흥미로운 옵션을 제공한다.

1980년대 동안, 눈-마인드 가설은 종종 은밀한 관심,[15][16] 즉 사람들이 자주 하는 무언가에 대한 관심에 비추어 의문을 제기했습니다.눈 추적 기록 중에 은밀한 주의가 일반적인 경우, 결과 스캔 경로와 고정 패턴은 종종 주의력이 어디에 있었는지가 아니라 눈이 어디를 보고 있었는지만 보여주며 인지 처리를 나타내지 못할 것이다.

1980년대는 또한 인간과 컴퓨터의 상호작용에 관한 질문에 답하기 위해 아이 트래킹을 사용하는 것이 탄생했다.특히, 연구원들은 사용자들이 컴퓨터 [17]메뉴에서 명령을 검색하는 방법을 조사했다.게다가 컴퓨터는 주로 [17]장애 사용자를 돕기 위해 연구원들이 실시간으로 아이 트래킹 결과를 사용할 수 있게 했다.

최근에는 사용자들이 서로 다른 컴퓨터 인터페이스와 어떻게 상호작용하는지를 연구하기 위해 아이 트래킹을 사용하는 것이 증가하고 있다.연구자들이 하는 구체적인 질문은 다양한 인터페이스가 [17]사용자에게 얼마나 쉬운지와 관련이 있다.시력 추적 연구 결과는 인터페이스 설계의 변화로 이어질 수 있습니다.또 다른 최근의 연구 분야는 웹 개발에 초점을 맞추고 있다.여기에는 사용자가 드롭다운 메뉴에 어떻게 반응하는지 또는 웹 사이트에 주의를 집중하여 개발자가 광고를 [18]게재할 위치를 알 수 있도록 하는 방법이 포함됩니다.

Hoffman에 [19]따르면, 현재 합의된 것은 시각적 주의력은 항상 눈보다 약간(100~250ms) 앞에 있다는 것이다.하지만 관심이 새로운 위치로 이동하자마자, 눈은 [20]따라가고 싶어할 것이다.

특정 인지 과정은 여전히 [21]장면의 특정 물체에 대한 고정으로부터 직접 추론할 수 없습니다.예를 들면, 화상의 얼굴에 고정하는 것은, 인식, 호불호, 곤혹 등을 나타낼 수 있다.그러므로, 시력 추적은 종종 자기성찰적 언어 프로토콜과 같은 다른 방법론과 결합된다.

휴대용 전자기기의 발달로 현재 뛰어난 성능을 얻을 수 있는 휴대용 헤드마운트 아이 트래커는 일상생활 [22]환경을 겨냥한 연구 및 시장 응용 분야에서 점점 더 많이 사용되고 있다.이와 같은 진보로 인해 연구실 [23]및 적용 환경에서 고정 중에 발생하는 작은 눈의 움직임에 대한 연구가 증가했습니다.

21세기에는 인공지능(AI)과 인공신경망의 사용이 눈 추적 작업과 분석을 완성하는 실행 가능한 방법이 되었다.특히, 컨볼루션 뉴럴 네트워크는 이미지 중심 작업을 위해 설계되었기 때문에 아이 트래킹에 적합합니다.AI를 통해, 시선 추적 작업과 연구는 인간 관찰자에 의해 감지되지 않았을 수 있는 추가 정보를 산출할 수 있다.또한 딥러닝의 실천은 충분한 샘플 데이터가 주어졌을 때 주어진 작업에서 주어진 신경망이 개선될 수 있도록 한다.그러나,[24] 이것은 상대적으로 많은 양의 교육 데이터를 필요로 한다.

아이 트래킹에서 AI의 잠재적 활용 사례는 의료 애플리케이션부터[25] 운전자[24] 안전, 게임[26] 이론,[27][28][29] 심지어 교육 및 훈련 애플리케이션까지 광범위한 주제를 다룹니다.

트래커 타입

아이 트래커는 여러 가지 방법 중 하나로 눈의 회전을 측정하지만, 주로 세 가지 범주 중 하나로 분류됩니다.

- 눈에 부착된 물체(특수 콘택트렌즈)의 움직임 측정

- 눈에 직접 닿지 않는 광학 추적

- 눈 주위에 배치된 전극을 사용하여 전위를 측정합니다.

아이어태치트래킹

첫 번째 타입은 거울이나 자기장 센서가 내장된 특수 콘택트렌즈 등 눈에 부착되어 있으며, 눈이 회전할 때 크게 미끄러지지 않는 것을 전제로 부착물의 움직임을 측정한다.딱 맞는 콘택트렌즈를 사용한 측정은 안구운동의 매우 민감한 기록을 제공하며, 자기탐색 코일은 안구운동의 역학과 기초 생리를 연구하는 연구자들이 선택하는 방법이다.이 방법을 사용하면 수평,[30] 수직 및 비틀림 방향으로 눈의 움직임을 측정할 수 있습니다.

옵티컬 트래킹

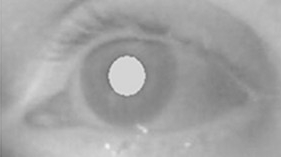

두 번째 넓은 범주는 눈의 움직임을 측정하기 위해 비접촉 광학적인 방법을 사용한다.빛(일반적으로 적외선)은 눈에서 반사되어 비디오 카메라 또는 기타 특수 설계된 광학 센서에 의해 감지됩니다.그런 다음 정보를 분석하여 반사 변화로부터 눈의 회전을 추출합니다.비디오 기반 아이 트래커는 일반적으로 각막 반사(첫 번째 Purkinje 이미지)와 동공 중앙을 시간 경과에 따라 추적하는 특징으로 사용합니다.보다 민감한 타입의 아이 트래커인 듀얼 퍼킨제 아이 [31]트래커는 각막 전면(퍼킨제 이미지 첫 번째)과 렌즈 후면(퍼킨제 이미지 네 번째)의 반사를 추적하는 특징으로 사용합니다.더 민감한 추적 방법은 망막 혈관과 같은 눈 내부의 특징을 촬영하고 눈이 회전할 때 이러한 특징을 따르는 것입니다.광학 방법, 특히 비디오 기록에 기초한 방법은 시선 추적에 널리 사용되며 비침습적이고 저렴하다는 점에서 선호된다.

전위 측정

세 번째 범주는 눈 주위에 전극을 배치하여 측정된 전위를 사용합니다.눈은 완전한 어둠 속에서 그리고 눈을 감으면 감지될 수 있는 안정적인 전위장의 근원입니다.각막에 양극이 있고 망막에 음극이 있는 쌍극자에 의해 생성되도록 모델링할 수 있습니다.한쪽 눈 주위의 피부에 배치된 두 쌍의 접촉 전극을 사용하여 도출할 수 있는 전기 신호를 Electrooculogram(EOG)이라고 합니다.눈이 중심 위치에서 주변으로 이동하면 망막은 하나의 전극에 접근하고 각막은 반대쪽 전극에 접근합니다.이 쌍극자의 방향과 결과적으로 전위장의 변화는 측정된 EOG 신호의 변화를 초래합니다.반대로, 이러한 안구 움직임의 변화를 분석함으로써 추적할 수 있다.공통 전극 설정으로 인해 수평 및 수직의 두 가지 개별 이동 구성 요소를 식별할 수 있습니다.세 번째 EOG 구성요소는 방사형 EOG [32]채널로, 이는 일부 후두피 전극을 참조하는 EOG 채널의 평균입니다.이 방사형 EOG 채널은 성막 시작 시 안구외 근육에서 발생하는 성막 스파이크 전위에 민감하며, 작은 성막도 [33]신뢰할 수 있는 검출을 가능하게 합니다.

EOG 신호 진폭과 사케이드 크기 사이의 잠재적 편차 및 가변 관계 때문에 느린 눈의 움직임을 측정하고 시선 방향을 감지하는 데 EOG를 사용하는 것은 어렵다.그러나 EOG는 시선의 이동과 관련된 천식적인 눈의 움직임을 측정하고 깜박임을 감지하는 매우 강력한 기술이다.비디오 기반 아이 트래커와 달리 EOG는 눈을 감고도 눈의 움직임을 기록할 수 있어 수면 연구에 활용할 수 있다.현재 비디오 기반 아이 트래커와 달리 낮은 계산 능력을 필요로 하며 다양한 조명 조건에서 작동하며 내장형 웨어러블 시스템으로 [34][35]구현할 수 있는 매우 가벼운 접근 방식입니다.따라서 모바일 일상 상황 및 수면 중 REM 단계에서 안구 움직임을 측정하기 위한 선택 방법입니다.EOG의 주요 단점은 비디오 트래커에 비해 시선 방향 정확도가 상대적으로 떨어진다는 것이다.즉, 눈의 움직임의 시간은 결정될 수 있지만 피사체가 정확히 어디를 보고 있는지 정확하게 판단하기는 어렵다.

테크놀로지 및 기술

현재 가장 널리 사용되고 있는 디자인은 비디오 기반의 아이 트래커입니다.카메라는 한쪽 눈 또는 양쪽 눈에 초점을 맞추고 시청자가 어떤 자극을 볼 때 눈의 움직임을 기록한다.대부분의 현대식 아이 트래커는 각막 반사(CR)를 만들기 위해 동공의 중심과 적외선/근적외선 비시준광을 사용합니다.눈동자 중심과 각막 반사 사이의 벡터를 사용하여 표면 또는 시선 방향의 시점을 계산할 수 있습니다.일반적으로 아이 [36]트래커를 사용하기 전에 개인의 간단한 보정 절차가 필요합니다.

적외선/근적외선(활성광이라고도 함) 눈 추적 기술에는 밝은 부필과 어두운 부필의 두 가지 일반적인 유형이 사용됩니다.이들 차이는 광학에 대한 광원의 위치에 기초한다.조도가 광로와 동축일 경우, 눈은 빛이 망막에 반사되어 붉은 눈과 유사한 밝은 동공 효과를 만들어냄에 따라 역반사체로 작용합니다.광로에서 광원이 오프셋되면, 망막으로부터의 역반사가 [37]카메라로부터 멀어져 있기 때문에 동공은 어두워 보인다.

밝은 부필 트래킹은 홍채/부필 대비가 향상되어 모든 홍채 색소 침착으로 아이 트래킹이 더욱 견고해지고 속눈썹 및 기타 가려짐 [38]기능으로 인한 간섭이 크게 감소합니다.또한 완전한 어둠에서 매우 밝은 조명 조건에서도 추적을 수행할 수 있습니다.

덜 사용되는 또 다른 방법은 패시브 라이트라고 알려져 있습니다.그것은 가시광선을 이용하여 빛을 비추는데,[37] 이것은 사용자에게 약간의 주의를 분산시킬 수 있다.이 방법의 또 다른 과제는 동공의 콘트라스트가 활성광법에 비해 낮기 때문에 대신 [39]홍채의 중심을 이용해 벡터를 계산하는 것이다.이 계산에서는 홍채와 백색 강막의 경계를 검출해야 합니다(림버스 추적).눈꺼풀의 [40]폐색에 의한 수직 눈동자 움직임의 또 다른 난관을 제시합니다.

시선 추적 설정은 매우 다양합니다.어떤 것은 머리에 장착되고, 어떤 것은 머리가 안정되어야 하며(예를 들어 턱받이 사용), 어떤 것은 원격으로 작동하며 동작 중에 머리를 자동으로 추적합니다.대부분은 최소 30Hz의 샘플링 속도를 사용합니다.50/60Hz가 일반적이지만 오늘날 많은 비디오 기반 아이 트래커는 240, 350 또는 1000/1250Hz로 작동하며 고정 안구 움직임을 포착하거나 새케이드 역학을 올바르게 측정하는 데 필요한 속도입니다.

눈동자의 움직임은 일반적으로 고정과 성막으로 구분된다. 즉, 시선이 특정 위치에서 정지할 때와 다른 위치로 이동할 때 각각이다.그 결과 발생하는 일련의 고정 및 천을 스캔 경로라고 합니다.부드러운 추구는 움직이는 물체를 따라가는 눈을 말합니다.고정 안구 운동에는 미세낭종(microscades)이 포함된다: 고정 시도 중에 발생하는 작은 무의식적인낭종(macadcades)입니다.대부분의 눈으로부터의 정보는 고정이나 원활한 추적 중에 제공되지만,[41] 성대모사에서는 제공되지 않습니다.

스캔 패스는 인지적 의도, 흥미 및 경도 분석에 유용합니다.다른 생물학적 요인(성별과 같은 간단한 요인도 스캔 경로에 영향을 줄 수 있습니다.인간-컴퓨터 상호작용(HCI)의 시선 추적은 일반적으로 사용적합성 목적 또는 시선 기반 [42]인터페이스라고도 알려진 시선 교환 디스플레이의 입력 방법으로서 스캔 경로를 조사한다.

데이터 프레젠테이션

다양한 유형의 아이 트래커가 기록한 데이터의 해석은 한 명 이상의 사용자의 시각적 행동을 그래픽으로 재개할 수 있도록 이를 애니메이션화하거나 시각적으로 표현하는 다양한 소프트웨어를 사용한다.비디오는 일반적으로 AOI(관심 영역)를 식별하기 위해 수동으로 코딩되거나 최근 인공지능을 사용한다.그래픽 프레젠테이션은 분석할 수 있는 측면에서 제한적이기 때문에 연구 결과의 기초가 되는 경우가 드물다. 예를 들어, 눈 추적에 의존하는 연구는 일반적으로 안구 운동 이벤트와 그 매개변수의 정량적 측정이 필요하다. 다음과 같은 시각화가 가장 일반적으로 사용된다.

인터페이스상의 포인트의 애니메이션 표현 이 방법은 시각적인 행동을 개별적으로 조사하여 사용자가 각 순간의 어디에 시선을 집중시켰는지를 나타낼 때 사용됩니다.이미지에 나타난 것과 같이, 이전의 선케이드의 움직임을 나타내는 작은 패스를 보완합니다.

saccade 패스의 정적 표현 이것은 위에서 설명한 것과 매우 유사하지만 정적 방식이라는 차이가 있습니다.이를 해석하려면 애니메이션보다 더 높은 수준의 전문지식이 필요합니다.

열 지도 주로 사용자 그룹에서 시각적 탐색 패턴의 집적 분석에 사용되는 대체 정적 표현입니다.이러한 표현에서, '핫' 구역 또는 밀도가 높은 구역은 사용자가 더 높은 빈도로 (자신의 주의가 아닌) 시선을 집중시키는 위치를 지정한다.열 지도는 안과 추적 [43]연구를 위한 가장 잘 알려진 시각화 기법입니다.

사각지대 지도 또는 초점 지도 이 방법은 사용자가 시각적으로 덜 참여하는 구역을 명확하게 표시하는 열 지도의 단순화된 버전입니다. 따라서 가장 관련성이 높은 정보를 더 쉽게 이해할 수 있습니다. 즉, 사용자가 보지 못한 구역에 대한 더 많은 정보를 제공합니다.

기울기 지도 열 지도와 마찬가지로, 기울기 지도는 처음 검은색 캔버스 위에 주의를 끄는 물체를 밝게 표시하여 초점 영역을 나타냅니다.특정 물체에 초점을 맞출수록 더 밝게 나타납니다.[44]

시선 추적과 시선 추적

아이 트래커는 반드시 일부 기준 프레임에 대해 눈의 회전을 측정합니다.이것은 보통 측정 시스템에 연결되어 있습니다.따라서 EOG 또는 헬멧에 장착된 비디오 기반 시스템과 같이 측정 시스템이 머리에 장착된 경우, 아이 인 헤드의 각도가 측정됩니다.세계 좌표에서 시야선을 추론하려면 헤드를 일정한 위치에 유지하거나 헤드의 움직임도 추적해야 한다.이 경우 헤드 방향을 아이인헤드 방향에 가산하여 시선 방향을 결정한다.

측정 시스템이 공막 검색 코일 또는 테이블 장착 카메라(원격) 시스템과 같이 테이블 장착형인 경우 시선 각도는 월드 좌표로 직접 측정됩니다.일반적으로 이러한 상황에서는 머리 이동이 금지됩니다.예를 들어 머리 위치는 물림 막대나 이마 지지대를 사용하여 고정된다.머리 중심의 기준 프레임은 세계 중심의 기준 프레임과 동일합니다.또는 구어체로 말하면, 아이인헤드 자세가 시선 방향을 직접 결정합니다.

일부 결과는 머리 움직임도 [45]허용되는 자연 조건에서의 인간의 눈 움직임에 대해서도 사용할 수 있다.눈과 머리의 상대적인 위치는 일정한 시선 방향에도 불구하고 높은 시각 [46]영역의 신경 활동에 영향을 미칩니다.

연습

안구 회전의 메커니즘과 역학에 대한 많은 연구가 이루어졌지만, 대부분의 경우 시선 방향을 추정하는 것이 눈 추적의 목표입니다.예를 들어, 사용자는 이미지의 어떤 특징이 눈을 끄는지에 관심이 있을 수 있습니다.아이 트래커가 절대적인 시선 방향을 제공하는 것이 아니라 시선 방향의 변화만 측정할 수 있다는 것을 깨닫는 것이 중요합니다.피사체가 무엇을 보고 있는지 정확하게 판단하기 위해서는 피사체가 한 점 또는 일련의 점을 보고, 아이 트래커는 각 시선 위치에 해당하는 값을 기록하는 몇 가지 보정 절차가 필요하다. (망막의 특징을 추적하는 기술도 명세가 없기 때문에 정확한 시선 방향을 제공할 수 없다.)시각축이 망막과 만나는 정확한 지점을 표시하는 fic 해부학적 특징(실제로 이렇게 안정된 단일 지점이 있는 경우)정확하고 신뢰할 수 있는 보정은 유효하고 반복 가능한 안구 운동 데이터를 얻기 위해 필수적이며, 이는 비언어 피험자나 불안정한 시선을 가진 사람들에게 중요한 과제가 될 수 있다.

각 아이 트래킹 방법에는 장점과 단점이 있으며, 아이 트래킹 시스템의 선택은 비용과 적용에 따라 달라집니다.Attention Tracking과 같은 오프라인 메서드와 온라인 프로시저가 있습니다.비용과 민감성 사이에는 균형이 있으며, 가장 민감한 시스템은 수 만 달러의 비용이 들며, 제대로 작동하기 위해서는 상당한 전문 지식이 필요합니다.컴퓨터와 비디오 기술의 진보로 인해 많은 애플리케이션에 유용하고 [47]사용하기 쉬운 비교적 저렴한 시스템이 개발되었습니다.그러나 잘못 정렬되거나 제대로 보정되지 않은 시스템은 매우 잘못된 데이터를 생성할 수 있기 때문에 결과를 해석하려면 여전히 어느 정도의 전문 지식이 필요합니다.

어려운 상황에서 차를 운전할 때 눈길 추적

스위스 연방공과대학(Swiss Federal Institute of Technology) 팀이 특수 헤드 카메라로 두 그룹의 운전자의 눈동자를 촬영했습니다.초보 운전자와 숙련된 운전자들은 좁은 도로의 커브에 접근할 때 눈의 움직임을 기록했습니다.영상 시리즈가 원본[49] 필름 프레임에서 축소되어 이미지당 2개의 아이 픽션을 보여줌으로써 이해를 개선했습니다.

이들 각각은 실시간으로 약 0.5초에 대응합니다.

일련의 이미지는 일반적인 초보자와 숙련된 운전자의 눈 고정 #9~#14의 예를 보여줍니다.

상단 이미지를 비교해보면 숙련된 운전자가 커브를 체크하고 고정 번호 9번까지 남겨둔 반면 초보 운전자는 도로를 확인하고 주차된 차량까지의 거리를 추정해야 한다.

중간 이미지에서는 숙련된 운전자가 마주 오는 차가 보이는 위치에 완전히 집중하고 있습니다.초보 운전자는 주차된 차에 시야를 집중한다.

반면 운전 경험이 많고 아직도 농후하던 시각에 그 곡선의 위험한 요지입니다:만약 차를 것으로 보이는, 운전자는 양보하는 것 때문에 오른쪽으로 대신 자동차 주차에 합격할 멈추에는 그들의 말초 시력을 사용할 수 있는 아래 이미지에서 초보자 왼쪽 벽과 자동차 주차 사이의 거리 추정하는 바쁘다.[50]

보다 최근의 연구들은 또한 실제 운전 [51][23]조건에서의 눈 움직임을 측정하기 위해 머리에 장착된 눈 추적을 사용하고 있다.

젊은 층과 노인의 보행 시력 추적

걷는 동안, 노인들은 어린 피실험자들보다 굴곡 시력에 더 의존한다.그들의 보행 속도는 아마도 말초 시력 저하로 인해 제한된 시야에 의해 감소된다.

젊은 피실험자들은 걸을 때 중심 시력과 주변 시력을 모두 활용한다.주변 시야를 통해 [52]걷는 과정을 보다 빠르게 제어할 수 있습니다.

적용들

인지과학, 심리학(특히 심리언어학, 시각세계 패러다임), 인간-컴퓨터 상호작용(HCI), 인적 요소와 인체공학, 마케팅 연구와 의학 연구(신경학 진단)[53]를 포함한 다양한 분야가 눈 추적 기술을 사용합니다.특정 애플리케이션에는 언어 읽기, 음악 읽기, 인간 활동 인식, 광고, 스포츠 재생, 운전자 및 조종사의 주의 산만 감지 및 인지 부하 추정 및 심각한 운동 [23]장애를 가진 사람들의 컴퓨터 작동 수단에서의 눈 움직임 추적이 포함된다.가상현실 분야에서 아이 트래킹은 사용자의 [54]시선 내에 그래픽 영역만 렌더링함으로써 처리 부하를 줄이는 등 다양한 목적으로 헤드마운트 디스플레이에 사용된다.

상용 어플리케이션

최근 몇 년 동안 아이 트래킹 기술의 정교함과 접근성이 높아짐에 따라 상업 분야에 대한 관심이 높아지고 있습니다.애플리케이션에는 웹 사용성, 광고, 스폰서십, 패키지 디자인 및 자동차 엔지니어링이 포함됩니다.일반적으로, 상업적인 눈 추적 연구는 눈 추적기가 눈 활동을 기록하는 동안 소비자 표본에 목표 자극을 제시함으로써 기능한다.표적 자극의 예로는 웹사이트, 텔레비전 프로그램, 스포츠 이벤트, 영화 및 광고, 잡지 및 신문, 패키지, 선반 디스플레이, 소비자 시스템(ATM, 계산 시스템, 키오스크) 및 소프트웨어가 포함될 수 있다.결과 데이터를 통계적으로 분석하고 그래픽으로 렌더링하여 특정 시각적 패턴의 증거를 제공할 수 있습니다.고정, 주머니, 동공 확장, 깜박임 및 기타 다양한 행동을 조사함으로써 연구자들은 주어진 매체나 제품의 효과에 대해 많은 것을 결정할 수 있다.이러한 종류의 연구를 사내에서 완료하고 있는 기업도 있지만, 아이 트래킹 서비스나 분석을 실시하고 있는 민간 기업도 많다.

상업적인 아이 트래킹 연구의 한 분야는 웹 사용성입니다.종래의 사용법에서는, 클릭 패턴이나 스크롤 패턴에 관한 정보를 제공하는 것이 많은 경우, 아이 트래킹에서는, 클릭간의 유저와의 상호작용이나 클릭간의 유저의 시간을 분석할 수 있기 때문에, 어느 기능이 가장 눈길을 끄는지에 대한 귀중한 통찰을 얻을 수 있습니다.혼동을 일으키며 완전히 무시됩니다.특히 아이 트래킹은 검색 효율성, 브랜딩, 온라인 광고, 내비게이션 조작성, 전체적인 디자인 및 기타 많은 사이트 컴포넌트 평가에 사용할 수 있습니다.분석은 주 클라이언트 사이트와 더불어 시제품 또는 경쟁 사이트를 대상으로 할 수 있습니다.

아이 트래킹은 다양한 광고 매체에서 일반적으로 사용됩니다.광고, 인쇄 광고, 온라인 광고 및 후원 프로그램은 모두 현재의 시선 추적 기술로 분석에 도움이 됩니다.한 가지 예는 옐로우 페이지에 게재된 광고에 대한 눈의 움직임 분석입니다.한 연구는 어떤 특정한 특징들이 사람들로 하여금 광고를 주목하게 하는지, 그들이 특정한 순서로 광고를 보는지, 그리고 시청 시간이 어떻게 달라지는지에 초점을 맞췄다.이 연구는 광고 크기, 그래픽, 컬러, 카피가 모두 광고에 대한 관심에 영향을 미친다는 것을 밝혀냈다.이를 알면 연구자는 소비자 샘플이 타깃 로고, 제품 또는 광고에 얼마나 자주 고정되는지 매우 상세하게 평가할 수 있습니다.따라서 광고주는 실제 시각적 [55]주의의 관점에서 주어진 캠페인의 성공을 수량화할 수 있습니다.이것의 또 다른 예는 검색 엔진 결과 페이지에서 저작자 스니펫이 유료 광고나 최초의 [56]유기적인 결과보다 더 많은 관심을 받았다는 것을 발견한 연구입니다.

그러나 상업적인 시선 추적 연구의 또 다른 예는 채용 분야이다.한 연구에서는 모집자가 LinkedIn 프로필을 선별하고 결과를 [57]히트맵으로 제시하는 방법을 분석했습니다.

안전 응용 프로그램

2017년 과학자들은 심층 신경망과 컨볼루션 신경망으로 심층 통합 신경망([24]DINN)을 구축했다.딥 러닝을 이용해 운전자의 이미지를 살펴보고 눈의 상태를 분류해 졸음 정도를 파악하는 것이 목표였다.충분한 이미지가 있으면 DINN은 드라이버의 점멸 시기, 점멸 빈도, 시간을 이상적으로 판단할 수 있습니다.이를 통해 운전자가 얼마나 피곤한 것처럼 보이는지 판단할 수 있어 효과적으로 시선 추적 운동을 할 수 있다.DINN은 2,400명 이상의 피험자의 데이터에 대해 교육을 받았고, 96%-99.5%의 피험자의 상태를 정확하게 진단했습니다.대부분의 다른 인공지능 모델은 [24]90% 이상의 속도로 수행되었습니다.이 기술은 운전자의 졸음을 감지하는 또 다른 방법을 이상적으로 제공할 수 있습니다.

게임 이론 응용 프로그램

2019년 한 연구에서 컨볼루션 뉴럴 네트워크(CNN)는 다른 CNN이 얼굴 [26]특징을 식별할 수 있는 것과 같은 방식으로 개별 체스 조각을 식별할 수 있는 능력을 가지고 구축되었다.그런 다음 다양한 기술 수준의 체스 선수 30명으로부터 시선 추적 입력 데이터를 제공받았다.CNN은 이 데이터를 이용해 체스판의 어떤 부분에 주의를 기울이는지 알아내기 위해 시선추정을 이용했다.그런 다음 보드의 그러한 부분을 설명하기 위해 중요도 지도를 작성하였다.궁극적으로, CNN은 선수들의 다음 움직임을 예측하기 위해 이사회와 조각에 대한 지식과 중요도를 결합할 것이다.뉴럴 네트워크 시스템이 훈련을 받은 훈련 데이터 세트에 관계없이, 무작위로 가능한 이동을 선택한 경우보다 더 정확하게 다음 동작을 예측했으며, 주어진 플레이어와 상황에 대해 그려진 유의도 맵은 54% 이상 [26]유사했습니다.

보조 테크놀로지

심각한 운동 장애를 가진 사람들은 싱글 스위치 스캔 기술보다 빠르고 직관적으로 [59][60]조작할 수 있기 때문에 컴퓨터와 상호작용할 때 아이 트래킹을[58] 사용할 수 있습니다.자동차 장애 뇌 Palsy[61]나 근 위축성 측색 경화로 인한 자주, 그리고 Severe 음성 및 침해(SSMI)사용자 소프트웨어는 형태의 screen[63]에 spo를 발생시키기 위해 텍스트 음성 변환 소프트웨어를 사용하는 아이콘, 단어와 문자를 표시합니다 Augmentative 대체 통신(AAC)aid,[62]으로 알려져 사용하는 연설에 영향을 미친다.ken 출력이다.[64]최근 연구자들은 로봇[65] 팔과 전동 휠체어를 [66]제어하기 위해 시선 추적도 연구했다.아이 트래킹은 또한 시각적 검색 [67]패턴을 분석하고, 안진 유무를 감지하며,[68] 독서 중 시선의 움직임을 분석하여 학습 장애의 초기 징후를 감지하는 데 도움이 된다.

항공 응용 프로그램

아이 트래킹은 이미 비행 안전을 위해 스캔 경로와 고정 기간을 비교하여 조종사 [69]훈련생의 진행 상황을 평가하고, 조종사의 [70]기술을 평가하고, 승무원의 공동 주의력과 상황 [71]인식을 분석함으로써 연구되었다.군용기의 헬멧 장착 디스플레이[72] 시스템 및 다기능[73] 디스플레이와 상호작용하기 위한 시선 추적 기술도 연구되었다.헬멧 장착 디스플레이 시스템(HMDS)[72]에서 헤드업 타깃 잠금 및 헤드업 타깃 획득을 위한 아이 트래커의 유용성을 조사하기 위한 연구가 실시되었다.조종사들의 피드백에 따르면 기술은 유망하지만 하드웨어와 소프트웨어 구성요소는 [72]아직 성숙하지 않았다.시뮬레이터 환경에서 다기능 디스플레이와의 상호작용에 대한 연구는 아이 트래킹이 응답 시간과 인지 부하를 기존 시스템보다 크게 개선할 수 있음을 보여주었다.또한, 연구는 조종사의 인지 하중을 추정하기 위해 고정 및 동공 반응의 측정을 이용하여 조사했다.인지 하중을 추정하는 것은 개선된 [74]비행 안전성으로 차세대 적응형 콕핏 설계에 도움이 될 수 있다.시선 추적은 조종사의 [75][23]피로를 감지하는 데도 유용합니다.

자동차 애플리케이션

최근 자동차 분야에서는 수동적 및 능동적 방식으로 아이 트래킹 기술이 조사되고 있습니다.미국 도로 교통 안전국은 운전 중 이차 작업을 수행하기 위한 글라스 시간을 측정하여 차량에 과도하게[76] 주의를 산만하게 하는 장치를 도입하지 않도록 함으로써 안전을 증진하는 데 사용하였습니다. 주의 산만 감지와 더불어, 시선 추적도 [77]IVIS와 상호작용하기 위해 사용됩니다.초기 연구는[78] HDD(Head Down Display)와의 상호작용을 위한 시선 추적 시스템의 효과를 조사했지만, 2차 작업을 수행하는 동안 운전자는 여전히 도로에서 눈을 떼야 했다.최근 연구에서는 오프로드에서 시선을 분산시키는 [79]HUD(Head Up Display)와의 시선 제어 상호 작용을 조사했습니다.시력 추적은 운전자의 인지 부하를 모니터링하여 잠재적인 주의 산만함을 감지하는 데에도 사용됩니다.연구자들은[80] 다양한 생리학적 매개 변수로부터 운전자의 인지 부하를 추정하기 위해 다른 방법을 탐색했지만, 안구 매개 변수의 사용은 [81][82]IVIS와의 상호작용에 더하여 운전자의 인지 부하를 모니터링하기 위해 기존의 아이 트래커를 사용하는 새로운 방법을 탐색했다.

엔터테인먼트 애플리케이션

2021년형 비디오 게임 Before Your Eyes는 플레이어의 깜박임을 등록 및 판독하여 [83][84]게임과 상호작용하는 주요 방법으로 사용합니다.

엔지니어링 어플리케이션

아이 트래킹 기술의 광범위한 사용은 최근 몇 년 동안 경험적 소프트웨어 엔지니어링에서의 사용을 조명하고 있습니다.시선 추적 기술과 데이터 분석 기술은 연구자들이 소프트웨어 엔지니어링 개념의 이해 가능성을 조사하기 위해 사용됩니다.여기에는 비즈니스 프로세스 [85]모델의 이해 가능성 및 UML 액티비티 다이어그램 및 EER [86]다이어그램과 같은 소프트웨어 엔지니어링에서 사용되는 다이어그램이 포함됩니다.고정, 스캔 경로, 스캔 경로 정밀도, 스캔 경로 호출, 관심 영역/관련 영역 고정 등의 아이 트래킹 메트릭을 모델 및 다이어그램의 이해 가능성 측면에서 계산, 분석 및 해석한다.이 연구결과는 적절한 모델 관련 솔루션을 사용하여 다이어그램과 모델의 이해도를 높이고 소프트웨어 엔지니어 및 모델러의 작업 메모리 용량, 인지 부하, 학습 스타일 및 전략과 같은 개인 관련 요소를 개선하는 데 사용됩니다.

프라이버시 문제

스마트폰,[87] 노트북[88],[89][90] 가상현실 헤드셋을 포함한 다양한 가전제품에서 아이 트래킹이 일반적인 기능이 될 것으로 예상됨에 따라 이 기술이 소비자 [91][92]사생활에 미치는 영향에 대한 우려가 제기되어 왔다.기계 학습 기술의 도움으로 시선 추적 데이터는 사용자의 민족성, 성격 특성, 두려움, 감정, 관심사, 기술, 신체적 및 정신적 건강 [93]상태에 대한 정보를 간접적으로 드러낼 수 있다.이러한 추론이 사용자의 인식이나 승인 없이 도출된 경우, 이는 추론 공격으로 분류될 수 있습니다.눈 활동이 항상 자발적인 통제 하에 있는 것은 아니다. 예를 들어, "자극으로 인한 시선, 동공 확장, 눈의 떨림, 그리고 자발적인 깜빡임은 대부분 소화 및 호흡과 유사하게 의식적인 노력 없이 발생한다."[93]따라서, 시선 추적 사용자들이 자신에 대해 드러내는 정보의 양을 추정하거나 통제하는 것은 어려울 수 있다.

「 」를 참조해 주세요.

메모들

- ^ Huey & 1908/1968에서 보고

- ^ Huey, Edmund (1968) [originally published 1908]. The Psychology and Pedagogy of Reading (Reprint ed.). MIT Press.

- ^ Buswell, G.T. (1922). "Fundamental reading habits: a study of their development". Supplementary Educational Monographs. No. 21. Chicago: University of Chicago.

- ^ Buswell, G.T. (1937). "How adults read". Supplementary Educational Monographs. No. 45. Chicago: University of Chicago.

- ^ Buswell, G.T. (1935), How people look at pictures: a study of the psychology and perception in art, University of Chicago Press, Trove 12223957

- ^ Yarbus, Alfred L. (1967). Eye movements and vision (PDF). New York: Plenum Press. ISBN 978-1-4899-5379-7. Retrieved 24 March 2022.

- ^ a b 야버스 1967, 190페이지

- ^ 야버스 1967, 페이지 194

- ^ 야버스 1967, 191페이지

- ^ 야버스 1967, 193페이지

- ^ a b "Visual Perception: Eye Movements in Problem Solving". www.learning-systems.ch.

- ^ [1] 2011-07-06년 Wayback Machine에서 아카이브 완료

- ^ 레이너 1978

- ^ Just & Carpenter 1980

- ^ Posner, Michael I. (1980). "Orienting of Attention". Quarterly Journal of Experimental Psychology. SAGE Publications. 32 (1): 3–25. doi:10.1080/00335558008248231. ISSN 0033-555X. PMID 7367577. S2CID 2842391.

- ^ Wright, R.D.; Ward, L.M. (2008). Orienting of Attention. Oxford University Press. ISBN 978-0-19-802997-7.

- ^ a b c Robert J. K. Jacob; Keith S. Karn (2003). "Eye Tracking in Human–Computer Interaction and Usability Research: Ready to Deliver the Promises". In Hyona; Radach; Deubel (eds.). The Mind's Eye: Cognitive and Applied Aspects of Eye Movement Research. Oxford, England: Elsevier Science BV. CiteSeerX 10.1.1.100.445. ISBN 0-444-51020-6.

- ^ Schiessl, Michael; Duda, Sabrina; Thölke, Andreas; Fischer, Rico. "Eye tracking and its application in usability and media research" (PDF).

- ^ Hoffman, James E. (2016). "Visual attention and eye movements". In Pashler, H. (ed.). Attention. Studies in Cognition. Taylor & Francis. pp. 119–153. ISBN 978-1-317-71549-8.

- ^ Deubel, Heiner (1996). "Saccade target selection and object recognition: Evidence for a common attentional mechanism". Vision Research. 36 (12): 1827–1837. doi:10.1016/0042-6989(95)00294-4. PMID 8759451. S2CID 16916037.

- ^ Holsanova, Jana (2007). "Användares interaktion med multimodala texter" [User interaction with multimodal texts]. In L. Gunnarsson; A.-M. Karlsson (eds.). Ett vidgat textbegrepp (in Swedish). pp. 41–58.

- ^ Cognolato M, Atzori M, Müller H (2018). "Head-mounted eye gaze tracking devices: An overview of modern devices and recent advances". Journal of Rehabilitation and Assistive Technologies Engineering. 5: 205566831877399. doi:10.1177/2055668318773991. PMC 6453044. PMID 31191938.

- ^ a b c d Alexander, Robert; Macknik, Stephen; Martinez-Conde, Susana (2020). "Microsaccades in applied environments: Real-world applications of fixational eye movement measurements". Journal of Eye Movement Research. 12 (6). doi:10.16910/jemr.12.6.15. PMC 7962687. PMID 33828760.

- ^ a b c d Zhao, Lei; Wang, Zengcai; Zhang, Guoxin; Qi, Yazhou; Wang, Xiaojin (15 November 2017). "Eye state recognition based on deep integrated neural network and transfer learning". Multimedia Tools and Applications. 77 (15): 19415–19438. doi:10.1007/s11042-017-5380-8. ISSN 1380-7501. S2CID 20691291.

- ^ Stember, J. N.; Celik, H.; Krupinski, E.; Chang, P. D.; Mutasa, S.; Wood, B. J.; Lignelli, A.; Moonis, G.; Schwartz, L. H.; Jambawalikar, S.; Bagci, U. (August 2019). "Eye Tracking for Deep Learning Segmentation Using Convolutional Neural Networks". Journal of Digital Imaging. 32 (4): 597–604. doi:10.1007/s10278-019-00220-4. ISSN 0897-1889. PMC 6646645. PMID 31044392.

- ^ a b c Louedec, Justin Le; Guntz, Thomas; Crowley, James L.; Vaufreydaz, Dominique (2019). "Deep learning investigation for chess player attention prediction using eye-tracking and game data". Proceedings of the 11th ACM Symposium on Eye Tracking Research & Applications - ETRA '19. New York, New York, USA: ACM Press: 1–9. arXiv:1904.08155. Bibcode:2019arXiv190408155L. doi:10.1145/3314111.3319827. ISBN 978-1-4503-6709-7. S2CID 118688325.

- ^ Nadu, T (2015). "A review: Towards quality improvement in real time eye-tracking and gaze detection". International Journal of Applied Engineering Research. 10 (6).

- ^ Nückles, M (2021). "Investigating visual perception in teaching and learning with advanced eye-tracking methodologies: Rewards and challenges of an innovative research paradigm". Educational Psychology Review. 33 (1): 149–167. doi:10.1007/s10648-020-09567-5. S2CID 225345884.

- ^ Alexander, RG; Waite, S; Macknik, SL; Martinez-Conde, S (2020). "What do radiologists look for? Advances and limitations of perceptual learning in radiologic search". Journal of Vision. 20 (10): 17. doi:10.1167/jov.20.10.17. PMC 7571277. PMID 33057623.

- ^ Robinson, David A. (October 1963). "A Method of Measuring Eye Movemnent Using a Scieral Search Coil in a Magnetic Field". IEEE Transactions on Bio-medical Electronics. Institute of Electrical and Electronics Engineers. 10 (4): 137–145. doi:10.1109/tbmel.1963.4322822. ISSN 0096-0616. PMID 14121113.

- ^ Crane, H.D.; Steele, C.M. (1985). "Generation-V dual-Purkinje-image eyetracker". Applied Optics. 24 (4): 527–537. Bibcode:1985ApOpt..24..527C. doi:10.1364/AO.24.000527. PMID 18216982. S2CID 10595433.

- ^ Elbert, T., Lutzenberger, W., Rockstroh, B., Birbaumer, N., 1985.EEG에서 안구 아티팩트를 제거합니다.EOG에 대한 생물물리학적 접근법.뇌파 클리닉 뉴로피시올 60, 455-463

- ^ Keren, A.S.; Yuval-Greenberg, S.; Deouell, L.Y. (2010). "Saccadic spike potentials in gamma-band EEG: Characterization, detection and suppression". NeuroImage. 49 (3): 2248–2263. doi:10.1016/j.neuroimage.2009.10.057. PMID 19874901. S2CID 7106696.

- ^ Bulling, A.; Roggen, D.; Tröster, G. (2009). "Wearable EOG goggles: Seamless sensing and context-awareness in everyday environments". Journal of Ambient Intelligence and Smart Environments. 1 (2): 157–171. doi:10.3233/AIS-2009-0020. hdl:20.500.11850/352886.

- ^ Sopic, D., Aminifar, A. 및 Atienza, D.(2018).전자 유리:간질 발작을 실시간으로 감지하는 웨어러블 시스템입니다.회선 및 시스템에 관한 IEEE 국제 심포지엄(ISCAS)에서.

- ^ Witzner Hansen, Dan; Qiang Ji (March 2010). "In the Eye of the Beholder: A Survey of Models for Eyes and Gaze". IEEE Trans. Pattern Anal. Mach. Intell. 32 (3): 478–500. doi:10.1109/tpami.2009.30. PMID 20075473. S2CID 16489508.

- ^ a b Gneo, Massimo; Schmid, Maurizio; Conforto, Silvia; D’Alessio, Tommaso (2012). "A free geometry model-independent neural eye-gaze tracking system". Journal of NeuroEngineering and Rehabilitation. 9 (1): 82. doi:10.1186/1743-0003-9-82. PMC 3543256. PMID 23158726.

- ^ The Eye: 인간의 시각에 대한 조사, Wikimed

- ^ Sigut, J; Sidha, SA (February 2011). "Iris center corneal reflection method for gaze tracking using visible light". IEEE Transactions on Bio-Medical Engineering. 58 (2): 411–9. doi:10.1109/tbme.2010.2087330. PMID 20952326. S2CID 206611506.

- ^ Hua, H; Krishnaswamy, P; Rolland, JP (15 May 2006). "Video-based eyetracking methods and algorithms in head-mounted displays". Optics Express. 14 (10): 4328–50. Bibcode:2006OExpr..14.4328H. doi:10.1364/oe.14.004328. PMID 19516585.

- ^ Purves, D; et al. (2001). "What Eye Movements Accomplish". Neuroscience (2nd ed.). Sunderland, MA: Sinauer Assocs.

- ^ Majaranta, P., Aoki, H., Donegan, M., Hansen, H.W., Hansen, J., Hyrskykari, A., Raihae, K.J., 시선 상호작용 및 시선 추적 응용 프로그램: 보조 테크놀로지의 진보, IGI Global, 2011

- ^ Nielsen, J.; Pernice, K. (2010). Eyetracking Web Usability. New Rideres Publishing. p. 11. ISBN 978-0-321-71407-7. Retrieved 28 October 2013.

- ^ Le Meur, O; Baccino, T (2013). "Methods for comparing scanpaths and saliency maps: strengths and weaknesses". Behavior Research Methods. 45 (1).

- ^ Einhäuser, W; Schumann, F; Bardins, S; Bartl, K; Böning, G; Schneider, E; König, P (2007). "Human eye-head co-ordination in natural exploration". Network: Computation in Neural Systems. 18 (3): 267–297. doi:10.1080/09548980701671094. PMID 17926195. S2CID 1812177.

- ^ Andersen, R. A.; Bracewell, R. M.; Barash, S.; Gnadt, J. W.; Fogassi, L. (1990). "Eye position effects on visual, memory, and saccade-related activity in areas LIP and 7a of macaque". Journal of Neuroscience. 10 (4): 1176–1196. doi:10.1523/JNEUROSCI.10-04-01176.1990. PMC 6570201. PMID 2329374. S2CID 18817768.

- ^ Ferhat, Onur; Vilariño, Fernando (2016). "Low Cost Eye Tracking: The Current Panorama". Computational Intelligence and Neuroscience. 2016: 1–14. doi:10.1155/2016/8680541. PMC 4808529. PMID 27034653.

- ^ 훈지커 2006.다음 데이터를 기반으로 합니다.코헨, A. S. (1983)정보제공 베파렌 폰 쿠르벤, Psychologie für die Praxis 2/83, Bulletin der Schweizerischen Stiftung für Angewandte Psychologie.

- ^ 코헨, A. S. (1983)Informationsaufnahme beim Befahren von Kurven, Psychologie für die Praxis 2/83, Bullet der Schweizerischen Stiftung für Angewandte Psychologie

- ^ 2006년 헌지커 사진

- ^ Grüner, M; Ansorge, U (2017). "Mobile eye tracking during real-world night driving: A selective review of findings and recommendations for future research". Journal of Eye Movement Research. 10 (2). doi:10.16910/JEMR.10.2.1. PMC 7141062. PMID 33828651.

- ^ Itoh, Nana; Fukuda, Tadahiko (2002). "Comparative Study of Eye Movements in Extent of Central and Peripheral Vision and Use by Young and Elderly Walkers". Perceptual and Motor Skills. 94 (3_suppl): 1283–1291. doi:10.2466/pms.2002.94.3c.1283. PMID 12186250. S2CID 1058879.

- ^ Duchowski, A. T. (2002). "A breadth-first survey of eye-tracking applications". Behavior Research Methods, Instruments, & Computers. 34 (4): 455–470. doi:10.3758/BF03195475. PMID 12564550. S2CID 4361938.

- ^ Rogers, Sol. "Seven Reasons Why Eye-tracking Will Fundamentally Change VR". Forbes. Retrieved 16 December 2021.

- ^ Lohse, Gerald; Wu, D. J. (1 February 2001). "Eye Movement Patterns on Chinese Yellow Pages Advertising". Electronic Markets. 11 (2): 87–96. doi:10.1080/101967801300197007. S2CID 1064385.

- ^ 「시선 추적 연구:검색 결과에서 Google Authority를 사용하는 것의 중요성"

- ^ "3 seconds is enough to screen candidate's profile. Eye tracking research results". Element's Blog - nowości ze świata rekrutacji, HR Tech i Element (in Polish). 21 February 2019. Retrieved 3 April 2021.

- ^ Corno, F.; Farinetti, L.; Signorile, I. (August 2002). "A cost-effective solution for eye-gaze assistive technology". IEEE International Conference on Multimedia and Expo. 2: 433–436. doi:10.1109/ICME.2002.1035632. ISBN 0-7803-7304-9. S2CID 42361339. Retrieved 5 August 2020.

- ^ Pinheiro, C.; Naves, E. L.; Pino, P.; Lesson, E.; Andrade, A.O.; Bourhis, G. (July 2011). "Alternative communication systems for people with severe motor disabilities: a survey". BioMedical Engineering OnLine. 10 (1): 31. doi:10.1186/1475-925X-10-31. PMC 3103465. PMID 21507236.

- ^ Saunders, M.D.; Smagner, J.P.; Saunders, R.R. (August 2003). "Improving methodological and technological analyses of adaptive switch use of individuals with profound multiple impairments". Behavioral Interventions. 18 (4): 227–243. doi:10.1002/bin.141.

- ^ "Cerebral Palsy (CP)". Retrieved 4 August 2020.

- ^ Wilkinson, K.M.; Mitchell, T. (March 2014). "Eye tracking research to answer questions about augmentative and alternative communication assessment and intervention". Augmentative and Alternative Communication. 30 (2): 106–119. doi:10.3109/07434618.2014.904435. PMC 4327869. PMID 24758526.

- ^ Galante, A.; Menezes, P. (June 2012). "A gaze-based interaction system for people with cerebral palsy". Procedia Technology. 5: 895–902. doi:10.1016/j.protcy.2012.09.099.

- ^ BLISCHAK, D.; LOMBARDINO, L.; DYSON, A. (June 2003). "Use of speech-generating devices: In support of natural speech". Augmentative and Alternative Communication. 19 (1): 29–35. doi:10.1080/0743461032000056478. PMID 28443791. S2CID 205581902.

- ^ Sharma, V.K.; Murthy, L. R. D.; Singh Saluja, K.; Mollyn, V.; Sharma, G.; Biswas, Pradipta (August 2020). "Webcam controlled robotic arm for persons with SSMI". Technology and Disability. 32 (3): 179–197. arXiv:2005.11994. doi:10.3233/TAD-200264. S2CID 218870304. Retrieved 5 August 2020.

- ^ Eid, M.A.; Giakoumidis, N.; El Saddik, A. (July 2016). "A novel eye-gaze-controlled wheelchair system for navigating unknown environments: case study with a person with ALS". IEEE Access. 4: 558–573. doi:10.1109/ACCESS.2016.2520093. S2CID 28210837.

- ^ Jeevithashree, D. V.; Saluja, K.S.; Biswas, Pradipta (December 2019). "A case study of developing gaze-controlled interface for users with severe speech and motor impairment". Technology and Disability. 31 (1–2): 63–76. doi:10.3233/TAD-180206. S2CID 199083245. Retrieved 5 August 2020.

- ^ Jones, M.W.; Obregón, M.; Kelly, M.L.; Branigan, H.P. (May 2008). "Elucidating the component processes involved in dyslexic and non-dyslexic reading fluency: An eye-tracking study". Cognition. 109 (3): 389–407. doi:10.1016/j.cognition.2008.10.005. PMID 19019349. S2CID 29389144. Retrieved 5 August 2020.

- ^ Calhoun, G. L; Janson (1991). "Eye line-of-sight control compared to manual selection of discrete switches". Armstrong Laboratory Report AL-TR-1991-0015.

- ^ Fitts, P.M.; Jones, R.E.; Milton, J.L (1950). "Eye movements of aircraft pilots during instrument-landing approaches". Aeronaut. Eng. Rev. Retrieved 20 July 2020.

- ^ Peysakhovich, V.; Lefrançois, O.; Dehais, F.; Causse, M. (2018). "The neuroergonomics of aircraft cockpits: the four stages of eye-tracking integration to enhance flight safety". Safety. 4 (1): 8. doi:10.3390/safety4010008.

- ^ a b c de Reus, A.J.C.; Zon, R.; Ouwerkerk, R. (November 2012). "Exploring the use of an eye tracker in a helmet mounted display". National Aerospace Laboratory Technical Report NLR-TP-2012-001.

- ^ DV, JeevithaShree; Murthy, L R.D.; Saluja, K. S.; Biswas, P. (2018). "Operating different displays in military fast jets using eye gaze tracker". Journal of Aviation Technology and Engineering. 8 (4). Retrieved 24 July 2020.

- ^ Babu, M.; D V, JeevithaShree; Prabhakar, G.; Saluja, K.P.; Pashilkar, A.; Biswas, P. (2019). "Estimating pilots' cognitive load from ocular parameters through simulation and in-flight studies". Journal of Eye Movement Research. 12 (3). doi:10.16910/jemr.12.3.3. PMC 7880144. PMID 33828735. Retrieved 3 August 2020.

- ^ Peißl, S.; Wickens, C. D.; Baruah, R. (2018). "Eye-tracking measures in aviation: A selective literature review". The International Journal of Aerospace Psychology. 28 (3–4): 98–112. doi:10.1080/24721840.2018.1514978. S2CID 70016458.

- ^ "Visual-Manual NHTSA Driver Distraction Guidelines for In-Vehicle Electronic Devices".

- ^ 미국 특허 8928585B2, Mondragon, Christopher K. & Bleacher, Brett, 2015-01-06 발행, Thales Avionics Inc.에 할당

- ^ Poitschke, T.; Laquai, F.; Stamboliev, S.; Rigoll, G. (2011). "Gaze-based interaction on multiple displays in an automotive environment" (PDF). IEEE International Conference on Systems, Man, and Cybernetics (SMC): 543–548. doi:10.1109/ICSMC.2011.6083740. ISBN 978-1-4577-0653-0. ISSN 1062-922X. S2CID 9362329.

- ^ Prabhakar, G.; Ramakrishnan, A.; Murthy, L.; Sharma, V.K.; Madan, M.; Deshmukh, S.; Biswas, P. (2020). "Interactive Gaze & Finger controlled HUD for Cars". Journal of Multimodal User Interface. 14: 101–121. doi:10.1007/s12193-019-00316-9. S2CID 208261516.

- ^ Marshall, S. (2002). "The index of cognitive activity: Measuring cognitive workload". In Proc. 7th Conference on Human Factors and Power Plants: 7-5–7-9. doi:10.1109/HFPP.2002.1042860. ISBN 0-7803-7450-9. S2CID 44561112.

- ^ Duchowski, A. T.; Biele, C.; Niedzielska, A.; Krejtz, K.; Krejtz, I.; Kiefer, P.; Raubal, M.; Giannopoulos, I. (2018). "The Index of Pupillary Activity Measuring Cognitive Load vis-à-vis Task Difficulty with Pupil Oscillation". ACM SIGCHI Conference on Human Factors. doi:10.1145/3173574.3173856. S2CID 5064488.

- ^ Prabhakar, G.; Mukhopadhyay, A.; Murthy, L.; Modiksha, M. A. D. A. N.; Biswas, P. (2020). "Cognitive load estimation using Ocular Parameters in Automotive". Transportation Engineering. 2: 100008. doi:10.1016/j.treng.2020.100008.

- ^ McGuire, Keegan (8 April 2021). "What The Critics Are Saying About Before Your Eyes". looper.com. Archived from the original on 23 April 2021.

- ^ von Au, Caspar (24 April 2021). "Computerspiel "Before Your Eyes" wird mit den Augen gesteuert" [Video game "Before Your Eyes" is controlled with your eyes]. Bayerischer Rundfunk (in German). Archived from the original on 26 April 2021.

- ^ Petrusel, Razvan; Mendling, Jan; Reijers, Hajo A. (2017). "How visual cognition influences process model comprehension". Decision Support Systems. C (96): 1–16. doi:10.1016/j.dss.2017.01.005. ISSN 0167-9236.

- ^ Sözen, Nergiz; Say, Bilge; Kılıç, Özkan (27 November 2020). "An Experimental Study Towards Investigating the Effect of Working Memory Capacity on Complex Diagram Understandability". TEM Journal. Association for Information Communication Technology Education and Science: 1384–1395. doi:10.18421/tem94-09. ISSN 2217-8333. S2CID 229386117.

- ^ Dickson, Ben (19 February 2017). "Unlocking the potential of eye tracking technology". TechCrunch. Retrieved 8 April 2021.

- ^ Reddy, Venkateshwar (15 April 2019). "Eye Tracking Technology: Applications & Future Scope". IndustryARC. Retrieved 8 April 2021.

- ^ Rogers, Sol (5 February 2019). "Seven Reasons Why Eye-tracking Will Fundamentally Change VR". Forbes. Retrieved 13 May 2020.

- ^ Stein, Scott (31 January 2020). "Eye tracking is the next phase for VR, ready or not". CNET. Retrieved 8 April 2021.

- ^ Stanley, Jay (6 May 2013). "The Privacy-Invading Potential of Eye Tracking Technology". American Civil Liberties Union. Retrieved 8 April 2021.

- ^ Blain, Loz (29 March 2021). "Eye tracking can reveal an unbelievable amount of information about you". New Atlas. Retrieved 8 April 2021.

- ^ a b Kröger, Jacob Leon; Lutz, Otto Hans-Martin; Müller, Florian (2020). "What Does Your Gaze Reveal About You? On the Privacy Implications of Eye Tracking". Privacy and Identity Management. Data for Better Living: AI and Privacy. Cham: Springer International Publishing. doi:10.1007/978-3-030-42504-3_15. ISBN 978-3-030-42503-6. ISSN 1868-4238.

레퍼런스

- Cornsweet, TN; Crane, HD (1973). "Accurate two-dimensional eye tracker using first and fourth Purkinje images". J Opt Soc Am. 63 (8): 921–8. Bibcode:1973JOSA...63..921C. doi:10.1364/josa.63.000921. PMID 4722578.

- Cornsweet, TN (1958). "New technique for the measurement of small eye movements". JOSA. 48 (11): 808–811. Bibcode:1958JOSA...48..808C. doi:10.1364/josa.48.000808. PMID 13588456.

- Hunziker, Hans-Werner (2006). Im Auge des Lesers: foveale und periphere Wahrnehmung – vom Buchstabieren zur Lesefreude [In the eye of the reader: foveal and peripheral perception – from letter recognition to the joy of reading] (in German). Transmedia Stäubli Verlag Zürich. ISBN 978-3-7266-0068-6.

- Just, MA; Carpenter, PA (1980). "A theory of reading: from eye fixation to comprehension" (PDF). Psychol Rev. 87 (4): 329–354. doi:10.1037/0033-295x.87.4.329. PMID 7413885.

- Rayner, K (1978). "Eye movements in reading and information processing". Psychological Bulletin. 85 (3): 618–660. CiteSeerX 10.1.1.294.4262. doi:10.1037/0033-2909.85.3.618. PMID 353867.

- Rayner, K (1998). "Eye movements in reading and information processing: 20 years of research". Psychological Bulletin. 124 (3): 372–422. CiteSeerX 10.1.1.211.3546. doi:10.1037/0033-2909.124.3.372. PMID 9849112.

- 로마노 버그스트롬, 제니퍼(2014).사용자 경험 설계의 아이 트래킹.모건 카우프만입니다ISBN 978-0-12-408138-3.

- Bojko, Aga(2013).아이 트래킹 사용자 경험(연구 실무 가이드)로젠펠트 미디어ISBN 978-1-933820-10-1.

상업용 아이 트래킹

- Pieters, R.; Wedel, M. (2007). "Goal Control of Visual Attention to Advertising: The Yarbus Implication". Journal of Consumer Research. 34 (2): 224–233. CiteSeerX 10.1.1.524.9550. doi:10.1086/519150.

- Pieters, R.; Wedel, M. (2004). "Attention Capture and Transfer by elements of Advertisements". Journal of Marketing. 68 (2): 36–50. CiteSeerX 10.1.1.115.3006. doi:10.1509/jmkg.68.2.36.27794. S2CID 15259684.