치명적인 간섭

Catastrophic interference| 시리즈의 일부 |

| 기계 학습 및 데이터 마이닝 |

|---|

|

대재앙적 망각으로도 알려진 대재앙적 간섭은 인공 신경 네트워크가 새로운 [1][2]정보를 학습할 때 이전에 학습한 정보를 완전히 그리고 갑자기 잊어버리는 경향입니다.신경망은 인지과학에 대한 네트워크 접근과 연결주의 접근의 중요한 부분이다.이러한 네트워크를 통해 기억과 학습과 같은 인간의 능력을 컴퓨터 시뮬레이션을 사용하여 모델링할 수 있습니다.메모리의 접속주의 모델을 작성할 때 고려해야 할 중요한 문제는 치명적인 간섭입니다.원래는 맥클로스키와 코헨(1989년),[1] 래트클리프(1990년)[2]의 연구에 의해 과학계의 주목을 받았다.그것은 '민감성-안정성[3]' 딜레마 또는 '안정성-가소성' [4]딜레마의 급진적인 표현이다.특히, 이러한 문제는 새로운 정보에 민감하지만 새로운 정보에 의해 중단되지는 않는 인공 신경망을 만드는 과제를 의미한다.룩업 테이블과 접속주의 네트워크는 안정성 가소성 [5]스펙트럼의 반대편에 있습니다.전자는 새로운 정보가 존재하더라도 완전히 안정적이지만, 새로운 입력으로부터 일반 원리를 추론하는 능력이 부족하다.한편, 표준 역전파 네트워크와 같은 접속주의 네트워크는 보이지 않는 입력으로 일반화할 수 있지만, 새로운 정보에 매우 민감합니다.역전파 모델은 일반화하는[according to whom?][citation needed] 인간의 능력을 반영하는 한 인간 기억의 좋은 모델로 간주될 수 있지만, 이러한 네트워크는 종종 인간의 기억보다 안정성을 덜 보인다.특히 이러한 역전파 네트워크는 치명적인 간섭을 받기 쉽습니다.이러한 네트워크와 달리 인간은 일반적으로 치명적인 [6]망각 현상을 보이지 않기 때문에 이는 인간의 기억을 모델링할 때 문제가 된다.

치명적인 간섭 이력

재앙적 간섭이라는 용어는 원래 McCloskey와 Cohen(1989)에 의해 만들어졌지만, Ratcliff(1990)[2]의 연구에 의해 과학계의 주목을 받게 되었다.

시퀀셜 러닝 문제:McCloskey and Cohen (1989)

McCloskey와 Cohen(1989)은 역전파 신경망 모델링에 대한 두 가지 다른 실험 중 치명적인 간섭의 문제에 주목했다.

- 실험 1: 세부 사항 및 2가지 추가 사항 학습

첫 번째 실험에서 그들은 네트워크가 모든 문제를 적절하게 표현하고 응답할 수 있을 때까지 17개의 한 자릿수 문제(1+1~9+1, 1+2~1+9)로 구성된 단일 훈련 세트에 대해 표준 역전파 신경 네트워크를 훈련했습니다.실제 출력과 원하는 출력 사이의 오차는 훈련 세션 동안 꾸준히 감소했으며, 이는 네트워크가 시험 기간 동안 목표 출력을 더 잘 나타내는 방법을 배웠음을 반영합니다.다음으로 17개의 한 자리수 2의 문제(2+1~2+9)와 1+2~9+2+2)로 구성된 단일 트레이닝 세트에 대해 네트워크가 모두 적절하게 대응될 때까지 네트워크를 훈련했습니다.그들은 그들의 절차가 어린이가 그들의 추가 사실을 배우는 방법과 비슷하다고 언급했다.2가지 사실에 대한 각 학습 시험 후 네트워크는 1가지 사실과 2가지 추가 사실에 대한 지식을 테스트했습니다.하나의 사실처럼, 두 개의 사실도 네트워크를 통해 쉽게 알 수 있었다.그러나 McCloskey와 Cohen은 네트워크가 2개의 추가 문제를 1회 학습한 후에도 추가 문제에 대해 적절하게 답변할 수 없다는 점에 주목했습니다.사실에 대응하여 생성된 출력 패턴은 종종 올바른 번호의 출력 패턴보다 잘못된 번호의 출력 패턴과 유사합니다.이는 엄청난 양의 오류로 간주됩니다.또한, 두 훈련 세트에 포함된 문제 2+1과 2+1은 심지어 두 가지 사실의 첫 번째 학습 시험 동안 극적인 혼란을 보였다.

- 실험 2: Barnes and Underwood(1959) 연구[7] 복제

두 번째 연결주의자 모델에서 맥클로스키와 코헨은 반스와 언더우드(1959)의 인간 소급 간섭에 대한 연구를 재현하려고 시도했다.이들은 모델을 A-B 및 A-C 목록에 대해 교육하고 입력 벡터(입력 패턴)의 컨텍스트 패턴을 사용하여 목록을 구분했습니다.구체적으로 네트워크는 A 자극과 A-B 컨텍스트 패턴을 나타낼 때 올바른 B 응답으로 응답하고 A 자극과 A-C 컨텍스트 패턴을 나타낼 때 올바른 C 응답으로 응답하도록 훈련되었다.모델이 A-B 및 A-C 항목에 대해 동시에 훈련되었을 때, 네트워크는 쉽게 모든 관련성을 올바르게 학습했습니다.순차적 훈련에서는 A-B 목록이 먼저 훈련되고 그 다음에 A-C 목록이 훈련되었다.A-C 리스트의 각 프레젠테이션 후에, A-B 리스트와 A-C 리스트의 양쪽 모두에 대해서 퍼포먼스를 측정했습니다.반즈 및 언더우드 연구의 A-C 목록에 있는 50%의 정답으로 이어지는 교육량이 역전파 네트워크에 의한 거의 0%의 정답으로 이어진다는 것을 발견했습니다.게다가 네트워크에서는, B 의 응답 패턴을 제공하도록 요구되었을 때에, C 의 응답 패턴과 같은 응답을 표시하는 경향이 있는 것을 알 수 있었습니다.이는 A-C 목록이 A-B 목록을 덮어쓴 것으로 보입니다.이것은 개라는 단어를 배운 후에, 대변이라는 단어를 배운 후에, 여러분이 고양이라는 단어를 잘 인식하지 못하고 대신 개라는 단어와 함께 나타낼 때 대변이라는 단어를 떠올린다는 것을 발견하는 것에 비유될 수 있다.

McCloskey와 Cohen은 숨겨진 단위 수 변경, 학습 속도 매개 변수 값 변경, A-B 목록에 대한 과잉 훈련, 특정 연결 가중치 동결, 0.1과 0.9 대신 목표 값 변경 등 여러 조작을 통해 간섭을 줄이려고 했다.그러나 이러한 조작은 네트워크에 의해 나타나는 치명적인 간섭을 만족스럽게 감소시키지 못했습니다.

전체적으로 McCloskey와 Cohen(1989)은 다음과 같은 결론을 내렸다.

- 적어도 일부 간섭은 새로운 학습이 다음을 나타내는 것과 관련된 가중치를 변경할 때마다 발생할 것이다.

- 새로운 학습의 양이 많을수록 오래된 지식의 혼란은 커진다.

- 학습이 순차적이지만 동시 학습이 아닌 경우 역전파 네트워크에서 간섭이 치명적이었다.

학습과 망각 기능에 의해 부과되는 제약: 래트클리프(1990)

Ratcliff(1990)는 표준 인식 기억 절차에 적용된 여러 세트의 역전파 모델을 사용했으며, 이 과정에서 항목이 순차적으로 [2]학습되었다.인식 성능 모델을 검사한 후, 그는 두 가지 주요 문제를 발견했습니다.

- 잘 학습된 정보는 소규모 및 대규모 역전파 네트워크에서 모두 새로운 정보가 학습됨에 따라 비극적으로 잊혀졌습니다.

심지어 새로운 정보를 사용한 한 번의 학습 시험에서도 맥클로스키와 코헨([1]1989)의 연구 결과와 병행하여 오래된 정보가 상당히 손실되었다.또한 Ratcliff는 결과 출력이 종종 이전 입력과 새로운 입력의 혼합이라는 것을 발견했습니다.대규모 네트워크에서 그룹(예: AB 및 CD)에서 학습한 항목은 개별적으로 학습한 항목(예: A 및 B, C...)보다 잊어버리는 것에 더 강했다.그러나 그룹으로 학습한 항목에 대한 망각은 여전히 컸다.네트워크에 새로운 숨겨진 유닛을 추가해도 간섭은 줄어들지 않았습니다.

- 네트워크가 더 많이 학습할수록 연구 항목과 이전에 보이지 않았던 항목 간의 차별이 감소했습니다.

이 발견은 배움과 함께 차별이 증가한다는 것을 나타내는 인간의 기억력에 관한 연구와 모순된다.Ratcliff는 이전 입력과 새 입력에 선택적으로 반응하는 '응답 노드'를 추가하여 이 문제를 완화하려고 시도했습니다.그러나 이러한 응답 노드가 모든 입력에 대해 활성화되기 때문에 이 방법은 작동하지 않았습니다.콘텍스트 패턴을 사용한 모델도 신품목과 구품목을 구별하는 데 실패했다.

제안 솔루션

치명적인 간섭의 주된 원인은 분산형 [8][9][10]신경망의 숨겨진 층에서의 표현과 중복되는 것으로 보인다.분산 표현에서는 각 입력이 많은 노드의 가중치에 변화를 일으키는 경향이 있습니다.치명적인 망각은 "지식이 저장되는" 많은 가중치가 변경되면 사전 지식이 그대로 유지될 가능성이 낮기 때문에 발생합니다.순차 학습 중에 입력이 혼합되어 새로운 입력이 오래된 [9]입력 위에 겹쳐집니다.이것을 개념화하는 또 다른 방법은 학습을 무게 공간을 [11]통한 움직임으로 시각화하는 것입니다.이 가중치 공간은 네트워크가 가질 수 있는 모든 가능한 가중치 조합의 공간적 표현에 비유할 수 있습니다.네트워크는 패턴 세트를 나타내는 방법을 처음 학습할 때 가중치 공간 내에서 이러한 [10]패턴을 모두 인식할 수 있는 점을 찾습니다.단, 네트워크가 새로운 패턴 세트를 학습하면 가중치 공간 내에서 새로운 [10]패턴의 인식만이 유일한 관심사가 되는 곳으로 이동합니다.두 패턴 세트를 모두 인식하려면 네트워크는 가중치 공간 내에서 새로운 패턴과 오래된 패턴을 모두 인식하기에 적합한 장소를 찾아야 합니다.

다음은 역전파 신경망의 치명적인 간섭을 성공적으로 줄이기 위한 경험적 지원을 제공하는 많은 기술입니다.

직교성

표현 오버랩을 줄이기 위한 초기 기술의 대부분은 입력 벡터 또는 숨겨진 단위 활성화 패턴을 서로 직교시키는 것을 포함했습니다.르완도프스키와 리(1995)[12]는 입력 벡터가 서로 직교할 경우 순차적으로 학습된 패턴 사이의 간섭이 최소화된다는 점에 주목했다.입력 벡터는 두 벡터에 걸친 요소의 쌍별 곱이 0이 되면 서로 직교한다고 한다.예를 들어 패턴 [0,0,1,0] 및 [0,1,0,0]은 (0×0 + 0×1 + 1×0 + 0×0) = 0이기 때문에 직교라고 한다.은닉층에서 직교 표현을 생성할 수 있는 기술 중 하나는 양극성 특징 부호화(즉,[10] 0과 1이 아닌 -1과 1을 사용하여 부호화)를 포함한다.직교 패턴은 서로에 대한 간섭을 줄이는 경향이 있습니다.그러나 모든 학습 문제가 이러한 유형의 벡터를 사용하여 표현될 수 있는 것은 아니며, 일부 연구는 직교 [2]벡터에 간섭의 정도가 여전히 문제가 있다고 보고한다.

노드 샤프닝 기술

French(1991)[8]에 따르면 노드 액티베이션의 상호작용 또는 액티베이션 오버랩에 의해 피드포워드 역전파 네트워크에서 치명적인 간섭이 발생합니다.이것은 은닉층의 분산 표현에서 발생합니다.매우 현지화된 표현을 사용하는 뉴럴네트워크에서는 숨겨진 레이어에서의 오버랩이 없기 때문에 치명적인 간섭이 발생하지 않습니다.따라서 프랑스에서는 숨겨진 레이어에서의 액티베이션오버랩 값을 줄이면 분산 네트워크에서의 치명적인 간섭을 줄일 수 있다고 제안했습니다.구체적으로 그는 이것이 숨겨진 계층에서 분산된 표현을 '반분포된' 표현으로 변경함으로써 이루어질 수 있다고 제안했다.'반분산' 표현은 각 표현에 대해 액티브한 숨겨진 노드가 적거나 이러한 노드의 활성화 값이 낮기 때문에 숨겨진 계층에서 서로 다른 입력의 표현이 중복되지 않게 됩니다.프랑스어는 이를 은닉 계층에서 가장 활성화된 노드의 특정 수의 활성화를 약간 증가시키고, 다른 모든 장치의 활성화를 약간 감소시킨 다음 이러한 활성화 변화를 반영하도록 입력에서 은닉 계층 가중치를 변경하는 기술인 '활성화 샤프닝'을 통해 수행할 수 있다고 권고했다(와 유사).에러 역전파).

신규성 규칙

Kortge(1990)[13]는 재앙적 간섭을 완화하기 위해 '고귀한 규칙'이라고 불리는 신경망을 훈련하는 학습 규칙을 제안했다.이름에서 알 수 있듯이, 이 규칙은 신경 네트워크가 이전 입력과 다른 새로운 입력의 구성요소만 학습하도록 도와줍니다.따라서 신규성 규칙은 이전에는 정보 저장에 전념하지 않았던 가중치만 변경함으로써 숨겨진 단위에서의 표현의 중복을 감소시킨다.신규성 규칙을 적용하기 위해 학습 중에 입력 패턴을 다른 구성요소를 나타내는 신규성 벡터로 대체한다.신규성 규칙을 표준 역전파 네트워크에서 사용할 경우,[13] 새로운 항목이 순차적으로 제시될 때 오래된 항목이 잊혀지거나 잊혀지는 일은 없다.단, 이 규칙은 자동 인코더 또는 자동 어소시에이션네트워크에서만 사용할 수 있습니다.이 네트워크에서는 출력 레이어의 타깃 응답이 입력 패턴과 동일합니다.

사전 훈련 네트워크

McRae와 Hetherington([9]1993)은 인간은 대부분의 신경 네트워크와 달리 무작위 가중치 집합으로 새로운 학습 과제를 맡지 않는다고 주장했다.오히려, 사람들은 작업에 풍부한 사전 지식을 가져오는 경향이 있고, 이것은 간섭의 문제를 피하는 데 도움이 됩니다.그들은 네트워크가 순차적 학습 과제를 시작하기 전에 무작위 데이터 표본에 대해 사전 훈련을 받을 때, 이러한 사전 지식은 자연스럽게 새로운 정보가 통합될 수 있는 방법을 제약할 것이라는 것을 보여주었다.이는 영어, 훈련 등 고도의 내부 구조를 가진 도메인으로부터의 데이터의 랜덤샘플이 해당 도메인 내에서 발견되는 규칙성 또는 반복 패턴을 포착하기 때문에 발생합니다.도메인은 규칙성에 기초하기 때문에, 새로 학습된 항목은 이전에 학습된 정보와 유사한 경향이 있으며, 이로 인해 네트워크는 기존 데이터에 대한 간섭 없이 새로운 데이터를 통합할 수 있습니다.특히, 이전에 훈련받은 데이터와 동일한 규칙성 패턴을 따르는 입력 벡터는 숨겨진 계층에서 급격하게 다른 활성화 패턴을 유발하거나 가중치를 급격하게 변경해서는 안 된다.

리허설

로빈스(1995)[14]는 리허설 메커니즘에 의해 치명적인 망각을 막을 수 있다고 설명했다.즉, 새로운 정보가 추가되면 뉴럴 네트워크는 이전에 학습한 정보 중 일부에 대해 재교육됩니다.그러나 일반적으로 이전에 학습한 정보는 이러한 재교육에 제공되지 않을 수 있습니다.이를 위한 솔루션은 '의사 리허설'입니다.이 경우 네트워크는 실제 이전 데이터에 대해 재트레인을 받지 않고 데이터를 표현합니다.이 일반적인 메커니즘에 따라 몇 가지 방법이 있습니다.

유사 반복 네트워크

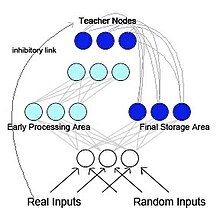

프랑스(1997)는 의사 반복 역전파 네트워크를 제안했다 (그림 [5]2 참조).이 모델에서는 네트워크는 기능적으로는 구별되지만 상호 작용하는 2개의 서브 네트워크로 분리됩니다.이 모델은 생물학적으로 영감을 받아 McCleland 등(1995년)[15]의 연구에 기초하고 있습니다.McCleland와 동료들은 해마와 신피질이 분리 가능하지만 상호 보완적인 기억 시스템으로 작용하며, 단기 기억 저장에는 해마와 장기 기억 저장에는 신피질이 작용한다고 제안했습니다.해마에 처음 저장된 정보는 재활성화 또는 재생을 통해 신피질에 "전송"될 수 있습니다.의사 재귀 네트워크에서는 서브 네트워크 중 하나가 해마와 같은 초기 처리 영역으로서 기능하여 새로운 입력 패턴을 학습하는 기능을 한다.다른 서브 네트워크는 신피질과 같은 최종 저장 영역 역할을 합니다.그러나 McCleland 등(1995년) 모델과 달리 최종 저장 영역은 내부적으로 생성된 표현을 초기 처리 영역으로 다시 보냅니다.이것에 의해, 반복 네트워크가 작성됩니다.프랑스는 오래된 표현과 새로운 표현을 섞는 것이 급진적인 망각을 줄일 수 있는 유일한 방법이라고 제안했다.뇌는 원래 입력 패턴에 접근할 수 없기 때문에신피질에 피드백되는 패턴은 내부에서 생성된 의사 패턴이라고 불립니다이러한 의사 패턴은 이전[14] 입력의 근사치이며 새로운 입력의 학습과 함께 인터리브될 수 있습니다.

자기 갱신 메모리

또한 Ans와 Rouset(1997)[16]에서 영감을 받고 독립적으로[14][5] 백프로그래테이션에 의해 훈련된 분산 네트워크에서 순차적 학습 작업이 수행될 때 치명적인 간섭을 극복하는 메모리 자가 갱신 기능을 가진 2-네트워크 인공 신경 아키텍처를 제안했다.원칙은 이전에 학습한 정보를 반영하는 내부에서 생성된 의사 패턴 또는 '의사 메모리'와 동시에 새로운 외부 패턴을 학습하는 것이다.이 모델이 피드포워드 멀티레이어 네트워크에서 기존의 의사[14][5] 히어를 사용하는 모델과 주로 구별되는 것은 의사 패턴 생성에 사용되는 잔향[further explanation needed] 프로세스입니다.단일 랜덤 시드로부터 다수의 액티비티를 재투입한 후, 이 프로세스는 의사 리허설에서 사용되는 액티비티의 단일 피드포워드 패스보다 접속 가중치 내에서 분산된 지식의 깊은 구조를 최적으로 포착하는 데 더 적합한 비선형 네트워크 어트랙터에 도달하는 경향이 있습니다.메모리 자가 갱신 절차는 전송 프로세스[17] 및 패턴의 시간적 시퀀스의 시리얼 학습에서 치명적인 망각 [18]없이 매우 효율적인 것으로 나타났습니다.

생성 재생

최근 몇 년 동안, 심층 생성 모델의 능력의 발전 덕분에 의사 리허설이 다시 인기를 얻고 있다.이러한 심층 생성 모델을 사용하여 리허설할 "의사 데이터"를 생성하는 경우, 이 방법을 일반적으로 생성 [19]재생이라고 합니다.이러한 생성 재생은 특히 입력 [20][21]레벨이 아닌 숨겨진 레이어에서 재생이 실행되는 경우 치명적인 망각을 효과적으로 방지할 수 있습니다.

잠재 학습

잠재학습은 Gutstein & Stump(2015)[22]이 전송 학습을 이용하여 치명적인 간섭을 줄이기 위해 사용하는 기법입니다.이 접근방식은 학습되는 새로운 클래스에 최적의 인코딩을 찾아 기존 응답에 치명적인 간섭을 일으킬 가능성이 가장 낮습니다.Error Correcting Output Code(ECOC;[23] 오류 정정 출력 코드)를 사용한1 세트의 클래스 식별을 학습한 네트워크에서는, 새로운 클래스에 대한 네트워크의 평균 응답을 관찰하는 것에 의해서, 새로운 클래스에 최적인 부호화가 선택됩니다.이러한 평균 응답은 새로운 클래스에 전혀 노출되지 않고 원래 클래스 집합을 학습하는 동안 발생했기 때문에 '최근 학습한 인코딩'이라고 한다.이 용어는 1930년 [24]톨먼에 의해 소개된 잠복학습의 개념에서 차용되었다.실제로 이 기술은 새로운 클래스에 대한 네트워크 응답을 이미 학습된 클래스에 대한 기존 응답과 최대한 일관되게 함으로써 치명적인 간섭을 피하기 위해 전송 학습을 사용합니다.

탄력적 중량 통합

Kirkpatrick 외 연구진(2017)[25]은 다중 작업에서 단일 인공 신경망을 순차적으로 훈련하는 방법인 탄성 체중 통합(EWC)을 제안했다.이 기술은 이전에 학습된 작업에 대해 다른 것보다 훈련된 신경망의 일부 가중치가 더 중요하다고 가정한다.새로운 작업에 대한 신경망의 훈련 동안, 네트워크의 무게에 대한 변화는 중요도가 커질수록 덜해진다.네트워크 가중치의 중요성을 추정하기 위해, EWC는 확률론적 메커니즘, 특히 피셔 정보 매트릭스를 사용하지만,[26][27][28] 이는 다른 방법으로도 수행될 수 있다.

레퍼런스

- ^ a b c McCloskey, Michael; Cohen, Neal J. (1989). Catastrophic Interference in Connectionist Networks: The Sequential Learning Problem. Psychology of Learning and Motivation. Vol. 24. pp. 109–165. doi:10.1016/S0079-7421(08)60536-8. ISBN 978-0-12-543324-2.

- ^ a b c d e Ratcliff, Roger (1990). "Connectionist models of recognition memory: Constraints imposed by learning and forgetting functions". Psychological Review. 97 (2): 285–308. doi:10.1037/0033-295x.97.2.285. PMID 2186426.

- ^ Hebb, Donald Olding (1949). The Organization of Behavior: A Neuropsychological Theory. Wiley. ISBN 978-0-471-36727-7. OCLC 569043119.[페이지 필요]

- ^ Carpenter, Gail A.; Grossberg, Stephen (1 December 1987). "ART 2: self-organization of stable category recognition codes for analog input patterns". Applied Optics. 26 (23): 4919–4930. Bibcode:1987ApOpt..26.4919C. doi:10.1364/AO.26.004919. PMID 20523470.

- ^ a b c d French, Robert M (December 1997). "Pseudo-recurrent Connectionist Networks: An Approach to the 'Sensitivity-Stability' Dilemma". Connection Science. 9 (4): 353–380. doi:10.1080/095400997116595.

- ^ González, Oscar C; Sokolov, Yury; Krishnan, Giri P; Delanois, Jean Erik; Bazhenov, Maxim (4 August 2020). "Can sleep protect memories from catastrophic forgetting?". eLife. 9: e51005. doi:10.7554/eLife.51005. PMC 7440920. PMID 32748786.

- ^ Barnes, Jean M.; Underwood, Benton J. (August 1959). "'Fate' of first-list associations in transfer theory". Journal of Experimental Psychology. 58 (2): 97–105. doi:10.1037/h0047507. PMID 13796886.

- ^ a b French, Robert M. (1991). Using Semi-Distributed Representations to Overcome Catastrophic Forgetting in Connectionist Networks (PDF). Proceedings of the 13th Annual Cognitive Science Society Conference. New Jersey: Lawrence Erlbaum. pp. 173–178. CiteSeerX 10.1.1.1040.3564.

- ^ a b c "Catastrophic Interference is Eliminated in Pre-Trained Networks". Proceedings of the Fifteenth Annual Conference of the Cognitive Science Society: June 18 to 21, 1993, Institute of Cognitive Science, University of Colorado-Boulder. Psychology Press. 1993. pp. 723–728. ISBN 978-0-8058-1487-3.

- ^ a b c d French, R (1 April 1999). "Catastrophic forgetting in connectionist networks". Trends in Cognitive Sciences. 3 (4): 128–135. doi:10.1016/S1364-6613(99)01294-2. PMID 10322466. S2CID 2691726.

- ^ Lewandowsky, Stephan (1991). "Gradual unlearning and catastrophic interference: a comparison of distributed architectures". In Hockley, William E.; Lewandowsky, Stephan (eds.). Relating Theory and Data: Essays on Human Memory in Honor of Bennet B. Murdock. Psychology Press. pp. 445–476. ISBN 978-1-317-76013-9.

- ^ Lewandowsky, Stephan; Li, Shu-Chen (1995). "Catastrophic interference in neural networks". Interference and Inhibition in Cognition. pp. 329–361. doi:10.1016/B978-012208930-5/50011-8. ISBN 978-0-12-208930-5.

- ^ a b 코트지, C. A. (1990년)연결주의 네트워크의 일시적 기억.인: 제12회 인지과학회 연차총회(764-771쪽).힐스데일, 뉴저지 주: 로렌스 얼바움

- ^ a b c d Robins, Anthony (June 1995). "Catastrophic Forgetting, Rehearsal and Pseudorehearsal". Connection Science. 7 (2): 123–146. doi:10.1080/09540099550039318.

- ^ McClelland, James L.; McNaughton, Bruce L.; O'Reilly, Randall C. (July 1995). "Why there are complementary learning systems in the hippocampus and neocortex: Insights from the successes and failures of connectionist models of learning and memory". Psychological Review. 102 (3): 419–457. doi:10.1037/0033-295X.102.3.419. PMID 7624455.

- ^ Ans, Bernard; Rousset, Stéphane (December 1997). "Avoiding catastrophic forgetting by coupling two reverberating neural networks". Comptes Rendus de l'Académie des Sciences, Série III. 320 (12): 989–997. Bibcode:1997CRASG.320..989A. doi:10.1016/S0764-4469(97)82472-9.

- ^ Ans, Bernard; Rousset, Stéphane (March 2000). "Neural networks with a self-refreshing memory: Knowledge transfer in sequential learning tasks without catastrophic forgetting". Connection Science. 12 (1): 1–19. doi:10.1080/095400900116177. S2CID 7019649.

- ^ Ans, Bernard; Rousset, Stéphane; French, Robert M.; Musca, Serban (June 2004). "Self-refreshing memory in artificial neural networks: learning temporal sequences without catastrophic forgetting". Connection Science. 16 (2): 71–99. doi:10.1080/09540090412331271199. S2CID 13462914.

- ^ Mocanu, Decebal Constantin; Torres Vega, Maria; Eaton, Eric; Stone, Peter; Liotta, Antonio (18 October 2016). "Online Contrastive Divergence with Generative Replay: Experience Replay without Storing Data". arXiv:1610.05555 [cs.LG].

- ^ Shin, Hanul; Lee, Jung Kwon; Kim, Jaehong; Kim, Jiwon (December 2017). Continual learning with deep generative replay. NIPS'17: Proceedings of the 31st International Conference on Neural Information Processing Systems. Curran Associates. pp. 2994–3003. ISBN 978-1-5108-6096-4.

- ^ van de Ven, Gido M.; Siegelmann, Hava T.; Tolias, Andreas S. (13 August 2020). "Brain-inspired replay for continual learning with artificial neural networks". Nature Communications. 11 (1): 4069. Bibcode:2020NatCo..11.4069V. doi:10.1038/s41467-020-17866-2. PMC 7426273. PMID 32792531.

- ^ Gutstein, Steven; Stump, Ethan (2015). "Reduction of catastrophic forgetting with transfer learning and ternary output codes". 2015 International Joint Conference on Neural Networks (IJCNN). pp. 1–8. doi:10.1109/IJCNN.2015.7280416. ISBN 978-1-4799-1960-4. S2CID 18745466.

- ^ Dietterich, T. G.; Bakiri, G. (1 January 1995). "Solving Multiclass Learning Problems via Error-Correcting Output Codes". Journal of Artificial Intelligence Research. 2: 263–286. doi:10.1613/jair.105. S2CID 47109072.

- ^ Tolman, E.C.; Honzik, C.H. (1930). "'Insight' in Rats". Publications in Psychology. University of California. 4: 215–232.

- ^ Kirkpatrick, James; Pascanu, Razvan; Rabinowitz, Neil; Veness, Joel; Desjardins, Guillaume; Rusu, Andrei A.; Milan, Kieran; Quan, John; Ramalho, Tiago; Grabska-Barwinska, Agnieszka; Hassabis, Demis; Clopath, Claudia; Kumaran, Dharshan; Hadsell, Raia (14 March 2017). "Overcoming catastrophic forgetting in neural networks". Proceedings of the National Academy of Sciences. 114 (13): 3521–3526. doi:10.1073/pnas.1611835114. PMC 5380101. PMID 28292907.

- ^ Zenke, Friedemann; Poole, Ben; Ganguli, Surya (2017). "Continual Learning Through Synaptic Intelligence". Proceedings of Machine Learning Research. 70: 3987–3995. arXiv:1703.04200. PMC 6944509. PMID 31909397.

- ^ Aljundi, Rahaf; Babiloni, Francesca; Elhoseiny, Mohamed; Rohrbach, Marcus; Tuytelaars, Tinne (2018). "Memory Aware Synapses: Learning What (Not) to Forget". Computer Vision – ECCV 2018. Lecture Notes in Computer Science. Vol. 11207. pp. 144–161. arXiv:1711.09601. doi:10.1007/978-3-030-01219-9_9. ISBN 978-3-030-01218-2. S2CID 4254748.

- ^ Kutalev, Alexey (2020). "Natural Way to Overcome Catastrophic Forgetting in Neural Networks". Modern Information Technologies and IT-Education. 16 (2): 331–337. arXiv:2005.07107. doi:10.25559/SITITO.16.202002.331-337. S2CID 218628670.