계층형 시간 메모리

Hierarchical temporal memory계층형 시간 메모리(HTM)는 Numenta에 의해 개발된 생물학적 제약이 있는 기계 인텔리전스 기술입니다.HTM은 2004년 Jeff Hawkins와 Sandra Blakeslee의 저서 On Intelligence에서 처음 기술되었으며 오늘날 스트리밍 데이터의 이상 검출에 주로 사용됩니다.이 기술은 신경과학과 포유류(특히 인간) 뇌의 신피질에 있는 피라미드 뉴런의 생리와 상호작용에 기초하고 있다.

HTM의 핵심에는 상위 시퀀스를 저장, 학습, 추론 및 호출할 수 있는 학습 알고리즘이 있습니다.대부분의 다른 기계 학습 방법과 달리, HTM은 레이블이 없는 데이터에서 시간 기반 패턴을 지속적으로 학습한다(감독되지 않은 프로세스).HTM은 노이즈에 강하고 대용량입니다(동시에 복수의 패턴을 학습할 수 있습니다).HTM을 컴퓨터에 적용하면 예측,[1] 이상 검출,[2] 분류, 그리고 궁극적으로는 센서 모터 애플리케이션에 [3]매우 적합합니다.

HTM은 Numenta의 샘플 애플리케이션과 Numenta 파트너의 몇 가지 상용 애플리케이션을 통해 소프트웨어에서 테스트 및 구현되었습니다.

구조 및 알고리즘

일반적인 HTM 네트워크는 나무 모양의 레벨 계층입니다(아래 설명과 같이 신피질의 '층'과 혼동하지 마십시오).이러한 레벨은 영역(또는 노드)이라고 불리는 작은 요소로 구성됩니다.계층 내의 단일 레벨에는 여러 영역이 포함될 수 있습니다.계층 수준이 높을수록 영역 수가 적은 경우가 많습니다.계층 수준이 높을수록 더 복잡한 패턴을 기억하기 위해 조합함으로써 하위 수준에서 학습한 패턴을 재사용할 수 있습니다.

각 HTM 영역에는 동일한 기본 기능이 있습니다.학습 및 추론 모드에서 감각 데이터(예: 눈의 데이터)는 하위 레벨 영역으로 온다.생성 모드에서는 하위 레벨 영역이 특정 카테고리의 생성된 패턴을 출력한다.보통 최상위 레벨에는 가장 일반적이고 영구적인 카테고리(개념)가 저장되어 있는 단일 영역이 있습니다.이러한 카테고리(개념)는 낮은 레벨의 작은 개념(시간과 공간에[clarification needed] 제약이 있는 개념)을 결정하거나 그에 따라 결정됩니다.추론 모드로 설정하면 영역(각 레벨)은 "자녀" 영역에서 올라오는 정보를 메모리에 있는 범주의 확률로 해석합니다.

각 HTM 영역은 공간 패턴을 식별하여 기억함으로써 학습합니다.이 패턴은 동시에 발생하는 경우가 많은 입력 비트의 조합입니다.그런 다음 차례로 발생할 가능성이 있는 공간 패턴의 시간적 시퀀스를 식별합니다.

진화하는 모델로서

HTM은 Jeff Hawkins의 Thousand Brains Theory of Intelligence의 알고리즘 구성요소입니다.그래서 신피질에 대한 새로운 발견은 시간이 지남에 따라 변화하는HTM 모델에 점차 통합됩니다새로운 발견이 모델의 이전 부분을 반드시 무효화하지는 않기 때문에 한 세대의 아이디어가 반드시 연속된 모델에서 제외되는 것은 아니다.이 이론의 진화하는 성질 때문에, HTM [4]알고리즘에는 몇 세대에 걸쳐 다음과 같이 간단하게 설명되고 있습니다.

제1세대 : zeta 1

HTM 알고리즘의 제1세대는 제타 1이라고 불리기도 합니다.

트레이닝

훈련 중에 노드(또는 영역)는 입력으로 공간 패턴의 시간 시퀀스를 받는다.학습 프로세스는 다음 두 단계로 구성됩니다.

- 공간 풀링은 (입력에서) 자주 관찰되는 패턴을 식별하고 "공생"으로 기억한다.서로 유의하게 유사한 패턴은 동일한 우연으로 취급됩니다.다수의 가능한 입력 패턴이 관리 가능한 기존의 일치수로 감소한다.

- 시간 풀링(temporal pooling)은 훈련 시퀀스에서 서로 따를 가능성이 높은 일치성을 시간 그룹으로 분할한다.패턴의 각 그룹은 입력 패턴의 "원인"(또는 On Intelligence의 "이름")을 나타냅니다.

공간 풀링과 시간 풀링의 개념은 현재 HTM 알고리즘에서 여전히 매우 중요하다.일시적 풀링은 아직 잘 이해되지 않았으며, 그 의미는 (HTM 알고리즘이 진화함에 따라) 시간이 지남에 따라 변화했다.

추론

추론 중에 노드는 패턴이 알려진 각 일치에 속할 확률 집합을 계산합니다.그런 다음 입력이 각 시간 그룹을 나타낼 확률을 계산합니다.그룹에 할당된 확률 집합을 입력 패턴에 대한 노드의 "믿음"이라고 합니다(간단한 구현에서는 노드의 믿음은 오직 하나의 승리 그룹으로 구성됩니다).이러한 믿음은 계층의 다음 상위 레벨에 있는 하나 이상의 "부모" 노드에 전달된 추론의 결과입니다.

노드에 대한 "예상하지 않은" 패턴은 하나의 시간 그룹에 속할 지배적인 확률을 가지지 않지만 여러 그룹에 속할 확률은 거의 동일하다.패턴의 시퀀스가 교육 시퀀스와 유사한 경우, 패턴이 수신되는 한 그룹에 할당된 확률이 자주 변경되지 않습니다.노드의 출력은 크게 변화하지 않고 시간의[clarification needed] 분해능이 손실됩니다.

보다 일반적인 방식에서 노드의 믿음은 임의의 수준에서 임의의 노드의 입력으로 전송될 수 있지만 노드 간의 연결은 여전히 고정된다.상위 노드는 이 출력을 다른 하위 노드의 출력과 결합하여 자체 입력 패턴을 형성합니다.

위와 같이 각 노드에서는 시공간 분해능이 상실되기 때문에 상위 노드에 의해 형성된 믿음은 더 넓은 시공간 범위를 나타낸다.이것은 인간의 두뇌에 의해 인식되는 물리적 세계의 구성을 반영하기 위한 것입니다.큰 개념(예: 원인, 행동 및 객체)은 더 느리게 변화하고 더 빠르게 변화하는 작은 개념으로 구성됩니다.Jeff Hawkins는 뇌가 외부 세계의 조직과 일치하고, 예측하고, 영향을 미치도록 이러한 종류의 계층을 진화시켰다고 가정합니다.

Zeta 1 HTM의 기능에 대한 자세한 내용은 Numenta의 이전 [5]문서에서 확인할 수 있습니다.

제2세대: 피질학습 알고리즘

종종 피질 학습 알고리즘(CLA)으로 불리는 HTM 학습 알고리즘의 2세대는 제타 1과 크게 달랐다.그것은 뇌 활동과 생물학적으로 더 사실적인 뉴런 모델(HTM의 맥락에서 종종 세포라고도 함)[6]을 나타내기 위해 희박한 분산 표현(즉, 요소가 2진수, 1 또는 0이고 1비트의 수가 0비트에 비해 작은 데이터 구조)이라고 불리는 데이터 구조에 의존한다.이 HTM 세대에는 Sparse Distributed Representation(SDR; 희소 분산 표현)을 출력하는 공간 풀링 [7]알고리즘과 복잡한 시퀀스를 표현하고 예측하는 방법을 학습하는 시퀀스 메모리 알고리즘의 [8]2가지 핵심 컴포넌트가 있습니다.

이 신세대에서는 대뇌피질의 층과 미니콜럼을 다루고 부분적으로 모델링한다.각 HTM 레이어(위에서 설명한 바와 같이 HTM 계층의 HTM 레벨과 혼동하지 말 것)는 고도로 상호 연결된 여러 개의 미니콜럼으로 구성됩니다.HTM 레이어는 입력으로부터 스퍼스 분산 표현을 생성하기 때문에 미니컬럼의 고정 퍼센티지가 항상[clarification needed] 활성화 됩니다.미니컬럼넘은 같은 수용장을 가진 세포들의 집단으로 이해된다.각 미니컬럼넘에는 몇 가지 이전 상태를 기억할 수 있는 셀이 있습니다.셀은 active, inactive 및 predictive의 3가지 상태 중 하나입니다.

공간 풀링

각 미니컬럼넘의 수신 필드는 훨씬 더 많은 노드 입력에서 랜덤으로 선택되는 고정 입력 수입니다.(특정) 입력 패턴에 따라 일부 미니컬럼은 액티브한 입력값과 어느 정도 관련지어집니다.공간 풀링은 가장 활동적인 미니컬럼을 비교적 일정하게 선택하고 액티브한 미니컬럼 근처에 있는 다른 미니컬럼을 비활성화(금지)합니다.유사한 입력 패턴은 안정적인 미니컬럼 세트를 활성화하는 경향이 있습니다.각 계층에서 사용되는 메모리의 양은 더 복잡한 공간 패턴을 학습하기 위해 증가하거나 더 단순한 패턴을 학습하기 위해 감소시킬 수 있습니다.

활성 셀, 비활성 셀 및 예측 셀

위에서 언급했듯이, 미니콜럼의 세포(또는 뉴런)는, 어느 시점에서도, 활성, 비활성, 또는 예측 상태에 있을 수 있다.처음에는 셀이 비활성화됩니다.

세포는 어떻게 활성화 되는가?

액티브 미니컬럼넘의 1개 이상의 셀이 예측 상태(아래 참조)인 경우, 현재 시간 스텝으로 액티브하게 되는 유일한 셀이 됩니다.액티브한 미니컬럼넘의 셀이 모두 예측 상태(초기 시간 스텝 중 또는 이 미니컬럼넘의 활성화가 예상되지 않은 경우)가 아닌 경우 모든 셀이 활성화됩니다.

세포는 어떻게 예측이 가능합니까?

셀이 활성화되면 몇 가지 이전 단계에서 활성화되는 경향이 있는 가까운 셀에 대한 연결이 점차 형성됩니다.따라서 셀은 접속된 셀이 활성화 되어 있는지 여부를 체크함으로써 기존의 시퀀스를 인식하는 방법을 학습합니다.다수의 접속 셀이 활성화 되어 있는 경우, 이 셀은 시퀀스의 몇 안 되는 다음 입력 중 하나를 예상하고 예측 상태로 전환됩니다.

미니컬럼버른의 생산량

레이어의 출력에는, 액티브 상태와 예측 상태의 양쪽 모두의 미니 컬럼이 포함됩니다.따라서 미니콜럼은 오랜 시간에 걸쳐 활성화되며, 이는 부모 계층에서 볼 수 있는 더 큰 시간적 안정성으로 이어집니다.

추론 및 온라인 학습

피질 학습 알고리즘은 각각의 새로운 입력 패턴에서 연속적으로 학습할 수 있으므로 별도의 추론 모드가 필요하지 않다.추론 중에 HTM은 입력 스트림을 이전에 학습한 시퀀스의 fragment에 일치시키려고 합니다.이를 통해 각 HTM 계층은 인식된 시퀀스의 지속 가능성을 항상 예측할 수 있습니다.예측 시퀀스의 인덱스는 레이어의 출력입니다.예측은 입력 패턴보다 덜 자주 변경되는 경향이 있기 때문에, 이는 상위 계층 수준에서 출력의 시간적 안정성을 증가시킵니다.예측은 또한 시스템이 예측한 것을 추론하도록 바이어스함으로써 시퀀스의 결측 패턴을 채우고 애매한 데이터를 해석하는 데 도움이 됩니다.

CLA의 적용

피질 학습 알고리즘은 현재 Numenta(Grok[9] 등)에 의해 상용 SaaS로 제공되고 있다.

CLA의 유효성

2011년 9월, Jeff Hawkins에게 피질 학습 알고리즘에 관한 다음의 질문이 제기되었습니다. "모델에 대한 변경이 좋은지 나쁜지 어떻게 알 수 있습니까?"이에 대해 제프는 "두 가지 범주가 있습니다. 하나는 신경과학을 보는 것이고, 다른 하나는 기계 지능을 다루는 방법입니다.신경과학 분야에서는 우리가 할 수 있는 많은 예측들이 있고, 그것들을 시험해 볼 수 있습니다.만약 우리의 이론이 광범위한 신경과학 관찰을 설명한다면, 그것은 우리가 올바른 방향으로 가고 있다는 것을 말해준다.기계학습 세계에서는 실제 문제에서 얼마나 잘 작동하는지만 신경 쓰지 않습니다.우리의 경우 그것은 두고 볼 일이다.지금까지 아무도 풀지 못했던 문제를 풀 수 있는 범위 내에서 사람들은 주목하게 될 것이다."[10]

제3세대 : 감각운동 추론

제3세대는 제2세대에 구축되어 신피질의 [11][12]감각운동 추론이론을 추가한다.이 이론은 계층 구조의 모든 수준에서 피질 컬럼이 시간에 따라 물체의 완전한 모델을 학습할 수 있고 물체의 특정 위치에서 특징이 학습될 수 있다고 제안합니다.이 이론은 2018년에 확장되었고 천뇌 [13]이론으로 언급되었다.

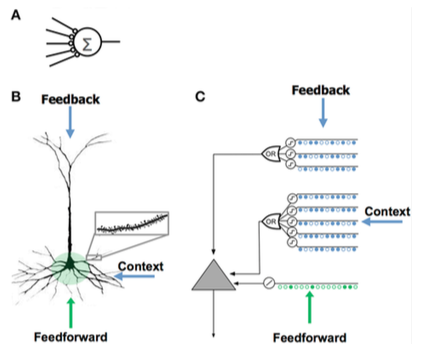

뉴런 모델 비교

뉴런 모델 비교 인공신경망(ANN) 신피질피라미달뉴런(생물뉴런) HTM 모델[8] 뉴런 - 시냅스가 적다

- 덴드라이트 없음

- 총 입력 × 중량

- 시냅스의 가중치를 수정하여 학습합니다.

- 수상돌기에 있는 수천 개의 시냅스가

- 활성 수상돌기: 세포는 수백 가지의 고유한 패턴을 인식합니다.

- 수지상 세그먼트에서 일련의 시냅스가 동시에 활성화되면 NMDA 스파이크와[clarification needed] 소마에서 탈분극이[clarification needed] 발생한다.

- 셀 입력 소스:

- 소마에 가까운 시냅스를 형성하고 활동 전위로 직접 이어지는 피드포워드 입력

- NMDA 스파이크는 보다 원위부[clarification needed] 기저부에서 발생한다.

- 소마를 탈분극시키는 원추상 수상돌기(보통 체세포 활동 전위를 생성하기에 충분하지 않음)

- 새로운 시냅스를 성장시킴으로써 학습한다.

- 신피질층 2/3 및 5의 피라미드 세포에서 영감을 얻음

- 수천 개의 시냅스

- 활성 수상돌기: 세포는 수백 가지의 고유한 패턴을 인식합니다.

- 일련의 시냅스를 가진 각 동시 검출기 어레이를 사용하여 수상돌기와 NMDA 스파이크를 모델링한다.

- 새로운 시냅스의 성장을 모델링하여 학습합니다.

HTM과 신피질 비교

HTM은 신피질에서 계층적으로 관련된 피질 영역의 특징인 기능을 구현하려고 합니다.신피질 영역은 HTM 계층에서 하나 이상의 레벨에 해당하는 반면 해마는 가장 높은 HTM 레벨과 원격으로 유사합니다.단일 HTM 노드는 특정 영역 내의 피질 컬럼 그룹을 나타낼 수 있습니다.

이것은 주로 기능적 모델이지만, HTM의 알고리즘을 [14][15]신피질 층의 신경 연결 구조와 관련짓기 위한 몇 가지 시도가 있었다.신피질은 6개의 수평층으로 이루어진 수직 기둥으로 구성되어 있다.신피질의 6개 세포층은 HTM 계층의 수준과 혼동해서는 안 됩니다.

HTM 노드는 열당 약 20개의 HTM "세포"를 가진 피질 열(80~100개의 뉴런)의 일부를 모델링하려고 시도합니다.HTM은 입력의 공간적 및 시간적 특징을 감지하기 위해 레이어 2의 열당 1셀과 시간적 풀링의 경우 레이어 3의 열당 1-212셀로 레이어 2와 3만을 모델링한다.HTM과 대뇌의 핵심은 입력의 노이즈와 변화를 처리하는 능력이다. 입력은 항상 약 2%의 열만 활성 상태인 "희소 분포 표현"을 사용한 결과이다.

HTM은 위에서 설명한 것과 같이 피질의 학습과 가소성의 일부를 모델링하려고 합니다.HTM과 뉴런의 차이는 다음과 같습니다.[16]

- 엄밀하게 이진 신호와 시냅스

- 시냅스 또는 수상돌기의 직접적인 억제 없음(그러나 간접적으로 시뮬레이션됨)

- 현재 모델 레이어 2/3 및 4만 (5 또는 6은 제외)

- no "no "paramed" 컨트롤(레이어 5)

- 영역 간 피드백 없음(높은 레이어 6에서 낮은 레이어 1)

분산 표현은 희박

메모리 컴포넌트를 뉴럴 네트워크와 통합하는 것은 분산 표현과[17][18] 자기 조직 지도에 대한 초기 연구로 거슬러 올라가는 오랜 역사를 가지고 있습니다.예를 들어, sparse distributed memory(SDM; 희소 분산 메모리)에서는 뉴런이 기본적으로 주소 인코더 및 [19][20]디코더로 기능하는 콘텐츠 주소 지정 가능 메모리의 메모리 주소로 사용됩니다.

컴퓨터는 1과 0의 모든 조합이 가능한 32비트 단어와 같은 고밀도 표현으로 정보를 저장합니다.반면 뇌는 희박한 분산표현(SDR)[21]을 사용한다.인간의 신피질에는 약 160억 개의 뉴런이 있지만, 항상 극소수의 뉴런만이 활동합니다.뉴런의 활동은 컴퓨터 속의 작은 부분과 같기 때문에 표현은 희박합니다.80년대에[19] NASA에 의해 개발된 SDM과 잠복 의미 분석에 사용된 벡터 공간 모델과 유사하게, HTM은 희박한 [22]분포 표현을 사용한다.

HTM에서 사용되는 SDR은 액티브한 비트의 비율이 적은 다수의 비트로 구성된 데이터의 바이너리 표현(1s)입니다.일반적인 실장에는 2048개의 컬럼과 64K의 인공 뉴런이 있으며, 동시에 액티브한 비트는 40개밖에 없습니다.대부분의 비트가 특정 표현에서 "미사용"되는 것은 효율이 낮아 보일 수 있지만 SDR은 기존의 고밀도 표현에 비해 두 가지 주요 이점이 있습니다.첫째, SDR은 표현이 소량의 액티브비트(희소)에 걸쳐 공유(분산)되는 의미에 의해 파손이나 애매모호성에 내성이 있습니다.조밀한 표현에서는 단일 비트를 플립하면 의미가 완전히 바뀌지만 SDR에서는 단일 비트가 전체 의미에 큰 영향을 미치지 않을 수 있습니다.이는 SDR의 두 번째 장점으로 이어집니다.표현의 의미는 모든 액티브비트에 분산되기 때문에 두 표현 간의 유사성은 그들이 나타내는 오브젝트의 의미적 유사성의 척도로 사용될 수 있습니다.즉, SDR의 2개의 벡터가 같은 위치에 1s가 있는 경우, 그 Atribute는 의미상 유사합니다.SDR의 비트는 의미적 의미를 가지며 그 의미는 비트 전체에 [22]분산됩니다.

의미 접기[23] 이론은 이러한 SDR 속성을 기반으로 하여 언어 의미론을 위한 새로운 모델을 제안하며, 여기서 단어는 단어-SDR로 인코딩되고 용어, 문장 및 텍스트 사이의 유사성은 간단한 거리 측정으로 계산할 수 있다.

다른 모델과의 유사성

베이지안 네트워크

베이지안 네트워크에 비유되는 HTM은 트리 모양의 계층 구조로 배열된 노드의 집합으로 구성됩니다.계층내의 각 노드는, 수신하는 입력 패턴과 시간 시퀀스의 원인 배열을 검출한다.베이지안 신념 수정 알고리즘은 피드 포워드 및 피드백 믿음을 자식 노드에서 부모 노드로 전파하기 위해 사용됩니다.단, HTM은 자기 훈련(각 노드가 명확한 패밀리 관계를 갖는 등)이 가능하며 시간에 민감한 데이터에 대처하고 은밀한 주의를 위한 메커니즘을 부여할 수 있기 때문에 베이지안 네트워크와의 유사성은 제한됩니다.

베이지안 신앙 전파에 기초한 계층적 피질 계산 이론은 앞서 리 타이싱과 데이비드 멈포드에 [24]의해 제안되었다.HTM은 이러한 아이디어와 대부분 일치하지만 시각 [25]피질에서 불변 표현을 다루는 것에 대한 세부사항을 추가합니다.

뉴럴 네트워크

신피질의 세부사항을 모델링하는 다른 시스템과 마찬가지로, HTM은 인공 신경망으로 볼 수 있습니다.HTM에서 일반적으로 사용되는 트리 모양의 계층은 기존 신경망의 일반적인 토폴로지와 유사합니다.HTM은 피질 열(80~100개의 뉴런)과 더 적은 수의 HTM "뉴론"으로 그들의 상호작용을 모델링하려고 시도합니다.현재 HTM의 목표는 일반적인 컴퓨터의 능력 내에서 이미지 처리와 같이 즉시 유용하게 만들 수 있는 영역 내에서 뉴런과 네트워크의 많은 기능을 포착하는 것입니다.예를 들어, 상위 레벨로부터의 피드백과 모터 제어는 아직 그러한 피드백을 통합하는 방법을 이해하지 못했기 때문에 시도되지 않으며, 가변 시냅스 대신 바이너리를 사용하는 것은 현재의 HTM 기능에서 충분하다고 판단되었기 때문이다.

LAMINART와 Stephen Grossberg에 의해 연구된 유사한 신경 네트워크는 신경생리학 및 정신물리학 데이터를 설명하기 위해 시간적 프레임워크에서 피질의 인프라와 뉴런의 행동을 모두 모델링하려고 시도한다.다만, 이러한 네트워크는, 현시점에서는,[26] 현실적인 적용에는 너무 복잡합니다.

HTM은 또한 HMAX로 알려진 시각 피질의 복부 흐름을 모델링하는 접근방식을 포함하여 Tomaso Poggio의 작업과 관련이 있다.다양한 AI 아이디어에 대한 HTM의 유사성은 인공지능 [27]저널 2005년 12월호에 기술되어 있다.

네오인지트론

1987년 후쿠시마 쿠니히코 교수가 제안한 계층형 다층 신경망인 네오인지트론은 최초의 딥 러닝 뉴럴 네트워크 모델 [28]중 하나이다.

NuPIC 플랫폼 및 개발 도구

Numenta Platform for Intelligent Computing(NuPIC)은 사용 가능한HTM 구현의1개입니다일부는 Numenta에 의해 제공되며 일부는 HTM 오픈소스 커뮤니티에 의해 개발 및 유지보수됩니다.

NuPIC는 C++와 Python 양쪽에서 Spatial Pooling과 Temporal Memory의 구현을 포함합니다.또한 3개의 API가 포함되어 있습니다.사용자는 알고리즘을 직접 구현하여 HTM 시스템을 구축하거나 Network API를 사용하여 네트워크를 구축할 수 있습니다.Network API는 다양한 피질층 간의 복잡한 연관성을 구축하는 유연한 프레임워크입니다.

NuPIC 1.0은 2017년 7월에 출시되었으며, 이후 코드베이스가 유지보수 모드로 전환되었습니다.현재 Numenta 리서치 코드베이스에 대한 연구는 계속되고 있습니다.

적용들

NuPIC를 사용하면 다음과 같은 상용 애플리케이션을 사용할 수 있습니다.

- Grok – IT 서버의 이상 검출(www.grokstream.com 참조)

- 피질.io – 고도의 자연어 처리 (www.cortical.io 참조)

NuPIC에서는 다음 도구를 사용할 수 있습니다.

- HTM Studio – 고객 자신의 데이터를 사용하여 시계열에서 이상을 찾아냅니다(numenta.com/htm-studio/ 참조).

- Numenta Anomaly Benchmark (뉴멘타 이상 벤치마크)– HTM 이상을 다른 이상 검출 기술과 비교합니다(numenta.com/numenta-anomaly-benchmark/ 참조).

NuPIC에서 사용할 수 있는 어플리케이션의 예를 다음에 나타냅니다.numenta.com/applications/ 를 참조해 주세요.

- 주식용 HTM – 주식시장 이상 추적 예시(샘플 코드)

- 부정 동작 검출– 인간 행동의 이상 검출 예시 (백서 및 샘플 코드)

- 지리공간 추적 – 시공간에서 이동하는 목표에서 이상을 찾아내는 예(백서 및 샘플 코드)

「 」를 참조해 주세요.

- 네오인지트론

- 딥 러닝

- 컨볼루션 뉴럴 네트워크

- 강력한 AI

- 인공의식

- 인지 아키텍처

- 인텔리전스에 대해서

- 메모리 예측 프레임워크

- 신념 수정

- 믿음의 전파

- 바이오닉스

- 인공지능 프로젝트 목록

- 메모리 네트워크

- 신경 튜링 기계

- 다중 트레이스 이론

관련 모델

레퍼런스

- ^ Cui, Yuwei; Ahmad, Subutai; Hawkins, Jeff (2016). "Continuous Online Sequence Learning with an Unsupervised Neural Network Model". Neural Computation. 28 (11): 2474–2504. arXiv:1512.05463. doi:10.1162/NECO_a_00893. PMID 27626963. S2CID 3937908.

- ^ Ahmad, Subutai; Lavin, Alexander; Purdy, Scott; Agha, Zuha (2017). "Unsupervised real-time anomaly detection for streaming data". Neurocomputing. 262: 134–147. doi:10.1016/j.neucom.2017.04.070.

- ^ "Preliminary details about new theory work on sensory-motor inference". HTM Forum. 2016-06-03.

- ^ 유튜브에서의 HTM 회고전

- ^ "Numenta old documentation". numenta.com. Archived from the original on 2009-05-27.

- ^ Jeff Hawkins가 YouTube에서 피질 학습 알고리즘을 설명하는 강의

- ^ Cui, Yuwei; Ahmad, Subutai; Hawkins, Jeff (2017). "The HTM Spatial Pooler—A Neocortical Algorithm for Online Sparse Distributed Coding". Frontiers in Computational Neuroscience. 11: 111. doi:10.3389/fncom.2017.00111. PMC 5712570. PMID 29238299.

- ^ a b Hawkins, Jeff; Ahmad, Subutai (30 March 2016). "Why Neurons Have Thousands of Synapses, a Theory of Sequence Memory in Neocortex". Front. Neural Circuits. 10: 23. doi:10.3389/fncir.2016.00023. PMC 4811948. PMID 27065813.

- ^ "Grok Product Page". grokstream.com.

- ^ Laserson, Jonathan (September 2011). "From Neural Networks to Deep Learning: Zeroing in on the Human Brain" (PDF). XRDS. 18 (1). doi:10.1145/2000775.2000787. S2CID 21496694.

- ^ Hawkins, Jeff; Ahmad, Subutai; Cui, Yuwei (2017). "A Theory of How Columns in the Neocortex Enable Learning the Structure of the World". Frontiers in Neural Circuits. 11: 81. doi:10.3389/fncir.2017.00081. PMC 5661005. PMID 29118696.

- ^ 신피질이 하는 일의 절반을 놓쳤나요? YouTube에서의 인식의 기초로서의 동심 위치

- ^ "Numenta publishes breakthrough theory for intelligence and cortical computation". eurekalert.org. 2019-01-14.

- ^ Hawkins, Jeff; Blakeslee, Sandra. On Intelligence.

- ^ George, Dileep; Hawkins, Jeff (2009). "Towards a Mathematical Theory of Cortical Micro-circuits". PLOS Computational Biology. 5 (10): e1000532. Bibcode:2009PLSCB...5E0532G. doi:10.1371/journal.pcbi.1000532. PMC 2749218. PMID 19816557.

- ^ "HTM Cortical Learning Algorithms" (PDF). numenta.org.

- ^ Hinton, Geoffrey E. (1984). "Distributed representations". Archived from the original on 2017-11-14.

{{cite journal}}:Cite 저널 요구 사항journal=(도움말) - ^ Plate, Tony (1991). "Holographic Reduced Representations: Convolution Algebra for Compositional Distributed Representations" (PDF). IJCAI.

- ^ a b Kanerva, Pentti (1988). Sparse distributed memory. MIT press. ISBN 9780262111324.

- ^ Snaider, Javier; Franklin, Stan (2012). Integer sparse distributed memory (PDF). Twenty-fifth international flairs conference. S2CID 17547390. Archived from the original (PDF) on 2017-12-29.

- ^ Olshausen, Bruno A.; Field, David J. (1997). "Sparse coding with an overcomplete basis set: A strategy employed by V1?". Vision Research. 37 (23): 3311–3325. doi:10.1016/S0042-6989(97)00169-7. PMID 9425546. S2CID 14208692.

- ^ a b Ahmad, Subutai; Hawkins, Jeff (2016). "Numenta NUPIC – sparse distributed representations". arXiv:1601.00720 [q-bio.NC].

- ^ De Sousa Webber, Francisco (2015). "Semantic Folding Theory And its Application in Semantic Fingerprinting". arXiv:1511.08855 [cs.AI].

- ^ Lee, Tai Sing; Mumford, David (2002). "Hierarchical Bayesian Inference in the Visual Cortex". Journal of the Optical Society of America A. 20 (7): 1434–48. CiteSeerX 10.1.1.12.2565. doi:10.1364/josaa.20.001434. PMID 12868647.

- ^ George, Dileep (2010-07-24). "Hierarchical Bayesian inference in the visual cortex". dileepgeorge.com. Archived from the original on 2019-08-01.

- ^ Grossberg, Stephen (2007). Cisek, Paul; Drew, Trevor; Kalaska, John (eds.). Towards a unified theory of neocortex: Laminar cortical circuits for vision and cognition. Technical Report CAS/CNS-TR-2006-008. For Computational Neuroscience: From Neurons to Theory and Back Again (PDF) (Report). Amsterdam: Elsevier. pp. 79–104. Archived from the original (PDF) on 2017-08-29.

- ^ "ScienceDirect – Artificial Intelligence". 169 (2). December 2005: 103–212.

{{cite journal}}:Cite 저널 요구 사항journal=(도움말) - ^ Fukushima, Kunihiko (2007). "Neocognitron". Scholarpedia. 2 (1): 1717. Bibcode:2007SchpJ...2.1717F. doi:10.4249/scholarpedia.1717.

외부 링크

공식적인

- 피질 학습 알고리즘 개요(2013년 5월 입수)

- HTM 피질 학습 알고리즘 (PDF 2011년 9월)

- 주식회사 누멘타

- HTM 피질 학습 알고리즘 아카이브

- Numenta의 Subutai Ahmad가 2009년부터 컴퓨터 기계 협회 강연

- OnIntelligence.org 포럼은 관련 토픽, 특히 모델 및 시뮬레이션 토픽 포럼에 대한 논의를 위한 인터넷 포럼입니다.

- 계층형 임시 메모리(Microsoft PowerPoint 프레젠테이션)

- 피질학습 알고리즘 튜토리얼: CLA 기초, YouTube에서 HTM 모델이 사용하는 피질학습 알고리즘(CLA)에 대해 설명합니다.

다른.

- Davide Maltoni의 계층형 시간 메모리에 의한 패턴 인식, 2011년 4월 13일

- 딜레프 조지의 HTM에 뿌리를 둔 대리 스타트업

- The Gartner Fellows: Jeff Hawkins 인터뷰 by Tom Austin, Gartner, 2006년 3월 2일

- 신흥 기술: Jeff Hawkins, Debra D'Agostino와 Edward H. Baker, CIO Insight, 2006년 5월 1일

- 스테파니 올슨 씨, 씨넷 News.com, 2006년 5월 12일 "뇌를 마이크로칩에 담습니다"

- Evan Ratliff의 "The Thinking Machine", 와이어드, 2007년 3월

- Jeff Hawkins, IEEE Spectrum, 2007년 4월

- 신피질 – 메모리 예측 프레임워크 – GNU General Public License를 사용한 오픈 소스 구현

- 계층적 시간기억 관련 논문 및 서적