지식 그래프 포함

Knowledge graph embedding표현학습에서 지식표현학습(KRL)이라고도 하는 지식그래프 내장(KGE)은 지식그래프의 의미적 의미를 보존하면서 지식그래프의 실체와 관계를 저차원적으로 표현하는 것을 배우는 기계학습 과제다.[1][1][2][3]내재된 표현을 활용하여 지식 그래프(KGs)는 링크 예측, 삼중 분류, 실체 인식, 클러스터링, 관계 추출과 같은 다양한 애플리케이션에 사용될 수 있다.[1][4]

정의

기업 E{E\displaystyle}, 관계 R{R\displaystyle}의 지식 그래프 G={E, R, F}{\displaystyle{{G\mathcal}}=\{E,R,F\}}와 사실 F{F\displaystyle}는 사실 .[5]은 트리플(h, r, t)∈는 링크 r∈ R{\displaystyle r\을 나타낸다 F{\displaystyle(h,r,t)\in F}.에서h E 와 꼬리 t t의 R}.문헌에서 흔히 3중(또는 사실)을 나타내기 위해 사용되는 또 다른 표기법은< a r l > 이다이 표기법을 자원기술 프레임워크(RDF)라고 한다.[1][5]지식 그래프는 특정 영역과 관련된 지식을 나타낸다. 이러한 구조화된 표현을 활용하면, 지식 그래프는 몇 가지 개선 단계를 거친 후에 그 영역으로부터 새로운 지식의 한 조각을 추론할 수 있다.[6]그러나, 오늘날 사람들은 실제 애플리케이션에서 사용하기 위해 데이터의 급격한 증가와 계산상의 비효율성에 대처해야 한다.[3][7]

지식 그래프를 내장하면 지식 그래프 의 각 실체와 관계가 임베딩 차원이라고 하는 주어진 d 의 벡터로 변환된다[7]일반적인 경우, 엔티티와 관계에 대해 서로 다른 내장 치수를 가질 수 있다[7]지식 그래프의 모든 실체와 관계에 대한 내장 벡터 모음은 다양한 작업에 보다 쉽게 사용할 수 있는 도메인의 밀도 높고 효율적인 표현이다.[7]

지식 그래프 임베딩은 다음과 같은 4가지 측면으로 특징지어진다.[1]

- 표현 공간:실체와 관계가 표현되는 저차원 공간.[1]

- 점수 매기기 기능:세 개의 포함된 표현에 대한 선도의 척도.[1]

- 모델 인코딩:엔티티와 관계의 내재된 표현이 서로 상호 작용하는 양식.[1]

- 추가 정보:포함된 표현을 풍부하게 할 수 있는 지식 그래프에서 제공되는 모든 추가 정보.[1]보통, 특별 채점 기능은 각각의 추가 정보에 대한 일반 채점 기능에 통합된다.[5][1][8]

임베딩 절차

모델을 포함하는 모든 다른 지식 그래프는 사실의 의미적 의미를 배우기 위해 대략 같은 절차를 따른다.[7]우선 지식 그래프의 내재된 표현을 배우기 위해 실체와 관계의 내장 벡터를 임의의 값으로 초기화한다.[7]그런 다음, 정지 조건에 도달할 때까지 훈련 세트에서 시작하여, 알고리즘은 임베딩을 지속적으로 최적화한다.[7]일반적으로 정지 조건은 훈련 세트보다 오버피팅에 의해 주어진다.[7]각 반복에 대해 훈련 세트에서 b 크기 b 를 샘플링하고, 배치의 각 3배마다 무작위로 손상된 사실(즉, 지식 그래프에 참된 사실을 나타내지 않는 3배)을 샘플링한다.[7]삼중의 부패는 삼중의 머리나 꼬리(또는 둘 다)를 사실을 거짓으로 만드는 다른 개체로 대체하는 것을 포함한다.[7]원래 트리플과 손상된 트리플을 트레이닝 배치에 추가한 뒤 임베딩이 업데이트돼 채점 기능을 최적화한다.[5][7]알고리즘의 끝에서 학습된 임베딩은 3배에서 의미적 의미를 추출해야 하며 지식 그래프에서 참된 사실을 올바르게 표시해야 한다.[5]

가성음

알고리즘 계산 엔티티 및 관련 임베딩 입력:교육 세트 ={( , , t) 엔티티 E 관계 세트 R 내장 k{\ 출력:엔티티 및 관계 내장형 초기화: E 및 r 내장형(벡터)은 랜덤하게 초기화되며, 은 , \{,b //교육 세트 랜덤 표본of size b for each in do // sample a corrupted fact or triple 은(는) 동안 손실 기능을 최소화하여 업데이트 임베딩 종료

성과지표

이러한 지수는 종종 모델의 내장 품질을 측정하는 데 사용된다.인덱스의 단순성 때문에 대규모에서도 임베딩 알고리즘의 성능을 평가하기에 매우 적합하다.[10]의 모든순위 예측 으로 Q {\displaystyle 을(를) 지정하면 다음과 같은 세 가지 성능 지수를 정의할 수 있다.Hits@K, MR, MRR.[10]

히츠@K

Hits@K 또는 줄여서 H@K는 첫 번째 상위 K 모델 예측에서 정확한 예측을 찾을 확률을 측정하는 성능 지수다.[10]보통 = 을(를) 사용한다[10]Hits@K는 주어진 두 세 배 사이의 관계를 정확하게 예측하기 위한 임베딩 모델의 정확도를 반영한다.[10]

Hits@K={ Q :< Q [ , \in Q:q<k\}}}}{ [

값이 클수록 예측 성능이 향상된다는 것을 의미한다.[10]

평균 순위(MR)

평균 순위는 가능한 모든 항목 중에서 모델이 예측한 항목의 평균 순위 위치다.[10]

값이 작을수록 모형이 좋다.[10]

평균 역수 순위(MRR)

평균 역수 순위는 정확하게 예측된 3배수의 수를 측정한다.[10]첫 번째 예측 삼중수소가 맞으면 1이 추가되고, 두 번째 예측이 맞으면 가 합계된다.[10]

평균 역수 순위는 일반적으로 검색 알고리즘의 효과를 정량화하는 데 사용된다.[10]

지수가 클수록 모형이 좋다.[10]

적용들

머신러닝 과제

KGC(Knowledge Graph Completion)는 내장된 지식 그래프 표현에서 지식을 추론하는 기법의 집합체다.[11]특히 이 기법은 누락된 실체나 관계를 추론하는 3중 유추법을 완성한다.[11]해당 서브태스크는 링크 또는 엔티티 예측(즉, 삼중의 다른 실체와 관계를 고려한 임베딩에서 기업을 추정)과 관계 예측(즉, 두 실체를 연결하는 가장 타당한 관계를 예측)으로 명명된다.[11]

트리플 분류는 이항 분류 문제다.[1]훈련된 모델은 삼중수소가 참인지 거짓인지를 판단하기 위해 임베딩을 사용하여 삼중수소의 타당성을 평가한다.[11]결정은 모델 점수 함수와 주어진 임계값으로 이루어진다.[11]클러스터링은 2D 공간에서 닫힌 유사한 의미 실체의 표현을 응축하기 위해 희박한 지식 그래프의 내장된 표현을 활용하는 또 다른 응용 프로그램이다.[4]

실제 애플리케이션

지식 그래프 포함의 사용은 많은 응용 프로그램에 점점 더 널리 퍼지고 있다.추천자 시스템의 경우 지식 그래프 임베딩의 활용은 일반적인 강화학습의 한계를 극복할 수 있다.[12][13]이러한 종류의 추천자 시스템을 훈련시키려면 사용자들로부터 엄청난 양의 정보가 필요하지만 지식 그래프 기법은 아이템 상관관계의 사전 지식으로 이미 구성된 그래프를 사용하고 추천서로부터 추론하기 위해 내장함으로써 이 문제를 해결할 수 있다.[12]약물 용도 변경은 이미 승인된 약물을 사용하는 것이지만, 처음에 설계되었던 약과는 다른 치료 목적으로 사용된다.[14]방대한 문헌과 생물의학 데이터베이스의 가용성을 활용하여 구축된 생물의학 지식 그래프를 이용하여 이미 존재하는 약물과 질병의 새로운 연관성을 추론하는 연결 예측 과제를 이용할 수 있다.[14]지식 그래프 임베딩은 사회 정치의 영역에서도 사용될 수 있다.[4]

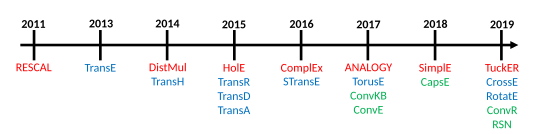

모델

(또는 사실)F ={< , i n , i > 지식 그래프의 내장 모델은 지식 그래프에 존재하는 각 실체 및 관계에 대해 연속 벡터 표현을 생성한다[7] , , t) 은(는 , IR d {\ {I이 있는 트리플의 해당 내장물이다. 및 여기서 디스플레이 스타일 은(는) 엔티티에 대한 내장 이고 k 스타일 은(는) 관계를 위한 내장 차원이다.[7]주어진 모델의 점수 함수는 f ( , 에 의해 표시되며, 관계가 내재된 경우 꼬리의 내장으로부터 머리 내장까지의 거리를 측정하거나, 다시 말해 특정 사실에 대한 내재된 표현에 대한 타당성을 계량화한다.[5]

로시 외 연구진은 임베딩 모델에 대한 분류법을 제안하고 세 가지 주요 모델군인 텐서 분해 모델, 기하학적 모델 및 딥러닝 모델을 식별한다.[5]

텐서 분해 모형

텐서 분해는 지식 그래프를 나타내기 위해 다차원 매트릭스를 사용하는 지식 그래프를 내장한 모델로,[1][5][17] 특정 영역을 철저히 기술하는 지식 그래프의 간극 때문에 부분적으로 알 수 있다.[5]특히 이들 모델은 3방향(3D) 텐서(tensor)를 사용하는데, 이 텐서(tensor)는 실체와 관계 임베딩인 저차원 벡터(bector)로 인수된다.[5][17]그third-order 텐서가 적절한 방법론 때문에 그것이 존재 entities,[17]고 이런 이유로, 필요성은 없선험적인 네트워크 structure,[15]더라도 fr을 겪는다를 훈련시키기 위해서 이 등급의 모델, 쉽고 초인 등. 알 것은 간단하다 사이의 관계의 부재한 지식 그래프를 나타내는 방법이다.om 높은-데이터의 차원 및 첨사성.[5][17]

바이린린 모델

이 모델군은 관계를 통한 실체들 간의 연결을 내장하기 위해 선형 방정식을 사용한다.[1]특히 관계의 내재적 표현은 2차원 매트릭스다.[5]이러한 모델들은 내장 절차 중에 단일 사실만을 사용하여 내장형 표현을 계산하고 동일한 실체 또는 관계에 대한 다른 연관성을 무시한다.[18]

- DistMult[19]: 관계의 임베딩 매트릭스가 대각 행렬이기 때문에 점수 매트릭스에서는 비대칭 사실을 구분할 수 없다.[5][5][18]

- 콤플렉스[20]: 디스트멀트는 대각 행렬을 사용하여 임베딩 관계를 나타내지만 복잡한 벡터 공간과 은둔자 제품에 표현을 추가하기 때문에 대칭적 사실과 비대칭적 사실을 구별할 수 있다.[5][17]이 접근방식은 시간과 공간 비용 측면에서 큰 지식 그래프까지 확장 가능하다.[20]

- 유추[21]: 이 모델은 유도 추론을 시뮬레이션하기 위해 지식 그래프의 유사 구조를 내장하고 있다.[21][5][1]다른 목적 함수를 사용하여, 유추의 이론적 일반성과 계산적 확장성이 우수하다.[21]유추에 의해 생산된 임베딩이 디스트물, 컴플렉스, 홀E의 임베딩을 완전히 회복한다는 것이 증명되었다.[21]

- SimpleE[22]: 이 모델은 지식 그래프 사실의 머리인지 꼬리인지에 따라 각 실체에 대한 관계에 대한 내장 벡터와 각 실체에 대한 두 개의 독립 내장 벡터를 학습하는 시논 폴리아디드 분해(CPD)의 개선이다.[22]SimplE 두 실체 embeddings 반비례 관계와 이 방법으로(h, r, t){\displaystyle(h,r,t)}과(t, r− 1, h){\displaystyle(t,r^{-1},h)}.[7][17]의 평균은 CPD점수를 사용하는 자발적으로 학습의 문제점 그들은 subje의 역할에 나타나는, SimplE 독립체 사이의 관계를 해결한다.ct나사실 안에 이의를 제기하고 비대칭 관계를 포함할 수 있다.[5]

비 이선형 모델

- HolE:[23] HolE는 지식 그래프의 임베디드 표현을 만들기 위해 순환상관을 이용하는데,[23] 이는 매트릭스 제품을 압축한 것으로 볼 수 있지만, 순환상관성이 상통하지 않기 때문에 비대칭 관계를 표현할 수 있는 기능을 유지하면서 더 계산적으로 효율적이고 확장성이 높다.[18]홀리는 푸리에와 함께 사용하면 콤플렉스 특례로 볼 수 있어 홀로그래픽과 복합 임베딩이 연결된다.[1]

- Tucker:[24] Tucker는 지식 그래프를 공유 코어와의 벡터 모음에서 터커 분해(즉, 개체와 관계의 내장)를 사용하여 분해될 수 있는 텐서(tensor)로 본다.[24][5]코어 텐서의 무게는 임베딩과 함께 학습되며, 엔트리의 상호 작용 수준을 나타낸다.[25]각 실체와 관계에는 고유한 내재 차원이 있으며, 코어 텐서의 크기는 상호 작용하는 실체의 형태와 관계에 의해 결정된다.[5]사실의 주체와 대상의 임베딩은 동일한 방식으로 요약되어 Tucker를 완전히 표현하게 하며, RESCAL , DistMult, CompletEx, SimplyE와 같은 임베딩 모델은 Tucker의 특별한 공식으로 표현될 수 있다.[24]

기하학적 모형

이 모델 계열에 의해 정의된 기하학적 공간은 사실의 머리와 꼬리 사이의 기하학적 변환으로서 관계를 암호화하고 있다.[5]이러한 이유로 꼬리의 내장을 계산하기 위해서는 머리 임베딩에 변환 을(를) 적용해야 하며, 거리 함수 을(를) 사용하여 임베딩의 선도를 측정하거나 사실의 신뢰성을 얻는다.[5]

기하학적 모델은 텐서 분해 모델과 유사하지만, 두 모델의 주된 차이점은 변환 의 적용성을 그것이 정의된 기하학적 공간에 보존해야 한다는 것이다.[5]

순수 번역 모델

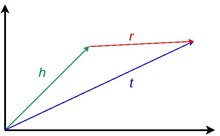

이 등급의 모델들은 워드2vec에 소개된 번역 불변성의 아이디어에서 영감을 받았다.[7]순수 번역 모델은 실체가 정의되는 기하학적 공간에서 적절한 관계형 번역을 적용한 후 실체의 내장형 벡터가 서로 가까이 있다는 사실에 의존한다.[18]다시 말해, 사실을 감안할 때, 관계 임베딩에 헤드의 임베딩이 추가되었을 때, 예상되는 결과는 꼬리의 임베딩이어야 한다.[5]내재된 실체의 폐쇄성은 어떤 거리 측정에 의해 부여되며, 사실의 신뢰성을 계량화한다.[17]

- TransE[9]: 이 모델은 임베딩이 나타나는 각 사실에서 한 벡터섬 방정식을 만족하도록 강제하는 점수 매김 기능을 사용한다: h+ r= [7] .각 실체와 관계가 단 하나의 사실에만 나타나고, 이러한 이유로 실제로 일대다, 다대일, 비대칭적 관계를 잘 나타내지 못하면 임베딩은 정확할 것이다.[5][7]

- TransH[26]: 그것은 관계의 유형을 정확하게 표현하는 문제를 해결하기 위해 초면체를 기하학적 공간으로 도입하는 TransE의 진화다.[26]TransH에서 각 관계는 상호 작용하는 실체에 기초하여 서로 다른 하이퍼플레인 상에서 서로 다른 내장된 표현을 가진다.[7]따라서, 예를 들어, 사실의 점수 함수를 계산하기 위해서는, 머리와 꼬리의 내장된 표현은 관계의 정확한 하이퍼플레인 위에 관계 투영 매트릭스를 사용하여 투영될 필요가 있다.[1][7]

- TransR[27]: TransR은 두 개의 다른 공간을 사용하여 실체와 관계를 내재된 표현과 관계를 나타내며 [1][18]실체와 관계의 의미 공간을 완전히 분리하기 때문에 TransH의 진화다.[7]또한 TransR은 관계 투영 매트릭스를 사용하여 실체의 내장을 관계 공간에 변환한다.[7]

- TransD:[28] 사실을 감안할 때, TransR에서, 사실의 머리와 꼬리는 두 가지 다른 유형의 실체에 속할 수 있다. 예를 들어 사실( p e i n 오바마와 미국은 두 개의 실체지만 하나는 사람이고 다른 하나는 국가다.[28][7]매트릭스 곱셈은 또한 투영을 계산하기 위한 TransR에서 값비싼 절차다.[7][28]이러한 맥락에서, TransD는 치수 복잡성을 줄이면서 투영 매트릭스를 대체하는 동적 매핑을 계산하기 위해 각 도면요소 관계 쌍에 대해 두 개의 벡터를 사용한다.[1][7][28]첫 번째 벡터는 개체와 관계의 의미적 의미를 나타내기 위해 사용되며, 두 번째 벡터는 매핑 매트릭스를 계산하기 위한 것이다.[28]

- TransA:[29] 모든 번역 모델들은 그들의 표현 공간에서 점수 함수를 정의하지만, 그들은 이 미터법 손실을 지나치게 단순화한다.[29]실체와 관계의 벡터 표현이 완벽하지 않기 때문에 h+ 의 순수 번역은 에서 멀어질 수 있고 구형 등전위 유클리드 거리는 어느 실체가 가장 가까운 실체인지 구별하기 어렵다.[29]대신 TransA는 내장 치수에 가중치를 부여하기 위해 적응형 마할라노비스 거리를 타원형 표면과 함께 도입하여 모호성을 제거한다.[1][7][29]

추가 임베딩이 있는 변환 모델

지식 그래프의 각 요소와 그 공통 표현 사실에 추가 정보를 연관시킬 수 있다.[1]각 실체와 관계는 지식 그래프로 도메인의 전체적인 설명을 개선하기 위해 텍스트 설명, 가중치, 제약 조건 등을 통해 풍부해질 수 있다.[1]지식 그래프를 내장하는 동안, 이 정보는 더 많은 수의 벡터를 학습하는 비용과 함께 실체 및 관계의 일반적인 내장형 표현과 함께 이러한 특성에 대한 전문 임베딩을 학습하는 데 사용될 수 있다.[5]

- STransE:[30]이 모델은 TransE의 조합과 일대다, 다대일, 다대일 관계를 더 잘 표현할 수 있는 방식으로 내장되는[30] 구조의 결과물이다.[5]이를 위해 모델은 에 포함된 각 r 및 에 대해 두 개의 추가 독립 을 포함한다.[30]각각의 추가적인 매트릭스는 특정한 관계가 사실의 머리나 꼬리와 상호 작용한다는 사실에 기초하여 사용된다.[30]즉 벡터 변환을 적용하기 전에 팩트 에 를 곱하고 꼬리에 를 곱한 경우[7]

- 크로스E:[31] 크로스오버 상호작용은 관련 정보 선택에 사용할 수 있으며, 내장 절차에 매우 유용할 수 있다.[31]교차 상호작용은 정보 선택에 있어 두 가지 뚜렷한 기여를 제공한다. 즉, 관계에서 실체로의 상호작용과 실체에서 관계로의 상호작용이다.[31]이것은 관계, 예를 들어 'president_of'는 대상을 사실의 대상에 연결하는 실체의 유형을 자동으로 선택한다는 것을 의미한다.[31]이와 유사하게, 어떤 사실의 실체가 관련 삼중수소의 대상을 예측하기 위해 선택해야 하는 추론 경로인지를 부적절하게 결정한다.[31]CrossE, 그렇게 하기 위해서,element-wise 제품을 사용하더라도, CrossE, 신경 네트워크 아키텍처에 의존하지 않는다 h{h\displaystyle}과 r{r\displaystyle}.[5][31일]사이의 상호 작용을 계산하는 데, 이 방법론 그런 architec에 인코딩될 수 있는 보시는 추가적인 상호 작용 매트릭스 C{C\displaystyle}를 배우게 된다.ture.[1]

로토 변환 모델

이 모델 계열은 번역에 추가 또는 대체하여 회전과 같은 변환을 사용한다.[5]

- TorusE:[32] TransE의 정규화 기간은 주체를 구면 공간에 내장하게 하고, 결과적으로 기하학적 공간의 번역 특성을 잃게 한다.[32]이 문제를 해결하기 위해 TorusE는 이 특정한 경우 n차원 torus 공간인 컴팩트 Lie 그룹의 사용을 활용하고 정규화의 사용을 피한다.[1][32]TorusE는 TransE의 L1과 L2 규범을 대체하는 거리 함수를 정의한다.[5]

- RotatE:[33] RotatE는 오일러의 아이덴티티에서 영감을 받아 복잡한 에서헤드 h {\ h}에서테일 t {\ t으)로 회전하면서 관계 을 나타내는 Hadmard 제품을 사용하는 것을 포함한다.[33]삼중의 각 요소에 대해, 임베딩의 복잡한 부분은 축에 대한 반시계방향 회전을 기술하는데, 이는 오일러의 아이덴티티로 설명할 수 있는 반면에, 관계 벡터의 계수는 1이다.[33]모델은 지식 그래프에서 대칭, 비대칭, 반전, 구성 관계를 내장할 수 있는 것으로 나타났다.[33]

딥러닝 모델

이 임베딩 모델 그룹은 입력 데이터인 지식 그래프에서 패턴을 학습하기 위해 심층 신경 네트워크를 사용한다.[5]이 모델들은 실체의 유형과 관계, 시간 정보, 경로 정보, 언더레이 구조화된 정보를 구별하고 지식 그래프의 모든 특징을 나타내는 거리 기반 및 의미 기반 모델의 한계를 해결할 수 있는 일반성을 가지고 있다.[18][1]지식 그래프 임베딩을 위한 딥러닝의 사용은 교육 단계에서 비용이 더 많이 들고, 데이터에 화가 났으며, 다른 임베딩 모델에서 오는 지식 그래프의 사전 교육된 임베딩 표현을 필요로 하더라도 좋은 예측 성능을 보여주었다.[1][5]

콘볼루션 신경망

이 모델 제품군은 완전히 연결된 레이어를 사용하는 대신, 비선형 특성을 학습하여 파라미터가 거의 없는 복잡한 구조를 내장할 수 있는 저차원 필터를 적용하여 입력 데이터를 복잡하게 하는 하나 이상의 콘볼루션 레이어를 사용한다.[1][5][18]

- ConvE:[34] ConvE는 딥러닝 모델과 계산비용의 좋은 트레이드오프 표현성을 나타내는 임베딩 모델인데,[17] 실제로 DistMult에 비해 매개변수를 8배 적게 사용한 것으로 나타났다.[34]ConvE는 지식 그래프의 실체와 관계를 나타내기 위해 d {\ 크기의 임베딩을 사용한다.[5][34]트리플의 점수 함수를 계산하기 위해 콘벤E는 간단한 절차를 적용한다: 첫 번째 콩카테네를 적용하고 트리플 헤드의 임베딩과 관계를 단일 데이터로 병합[; 이 행렬은 2D 콘볼루션 레이어의 입력으로 사용된다.[5][17]그 후 결과는 매트릭스 에 의해 매개변수로 된 선형 변환 파라미터를 적용하는 밀도층을 통과하고, 마지막에 내부 제품과 함께 꼬리 3중으로 연결된다.[5][18]ConvE는 또한 평가 절차에서 특히 효율적이다: 1-N 스코어링, 모델 일치, 머리와 관계, 모든 꼬리를 동시에 사용하여 다른 모델의 1-1 평가 프로그램과 비교했을 때 많은 평가 시간을 절약한다.[18]

- ConvR:[35] ConvR은 기업과 관계 사이의 가능한 모든 상호작용을 깊이 표현하기 위한 적응형 경련 네트워크다.[35]이 작업의 경우, ConvR은 각 관계에 대한 콘볼루션 필터를 계산하고, 필요한 경우 이러한 필터를 관심 있는 실체에 적용하여 콘볼루션 형상을 추출한다.[35]트리플 점수를 계산하는 절차는 콘벤지와 동일하다.[5]

- ConvKB:[36]ConvKB은 주어진 삼중(h, r, t){\displaystyle(h,r,t)}의 점수 기능 계산하기 위해,}}차원의 변형 없이와 사이즈 1× 3{\dis의 돌림형 필터의 시리즈를 통과하는 입력[h;r는]{\displaystyle{\ce{[h;{{r}}\mathcal,]}d×3{\displaystyle d\times 3}을 생산한다.놀[36] 이 결과는 최종 점수를 산출하는 뉴런 1개만으로 촘촘한 층을 먹여준다.[36]단일 최종 뉴런은 이 구조를 사실이거나 거짓일 수 있는 이항 분류기로 만든다.[5]ConvE와의 차이점은 실체의 차원성이 변경되지 않는다는 것이다.[17]

캡슐 신경망

이 모델 계열은 캡슐 신경망을 이용하여 공간 정보를 잃지 않고 입력의 특징을 인식할 수 있는 보다 안정적인 표현을 만들어 낸다.[5]네트워크는 경련층으로 구성되지만 캡슐로 구성되며, 캡슐의 전반적인 결과는 동적 프로세스 루틴에 의해 결정된 더 높은 캡슐로 보내진다.[5]

- CapsE:[37] CapsE implements a capsule network to model a fact .[37] Like in ConvKB, each triple element is concatenated to built a matrix and is used to feed to a convolutional layer to extract the convolutional features.[5][37]그리고 나서 이러한 특징들은 연속 벡터를 만들기 위해 캡슐로 리디렉션된다. 벡터는 더 길고, 더 많은 사실이 사실이다.[37]

재발 신경망

이 종류의 모델은 반복되는 신경망을 이용한다.[5]이 구조의 장점은 단지 정교한 단일 사건보다는 일련의 사실들을 암기하는 것이다.[38]

- RSN:[38] 임베딩 절차 중에 유사한 실체가 유사한 관계를 갖는다고 일반적으로 가정한다.[38]실제로 임베딩은 사실의 역사가 아닌 진행 중인 사실만으로 계산되기 때문에 이러한 유형의 정보는 활용되지 않는다.[38]RSN(Recurrent Stopping Network)은 반복 신경망을 사용하여 무작위 걷기 샘플링을 사용하여 관계 경로를 학습한다.[5][38]

모델 성능

모델의 임베딩 정확도를 평가하는 데 더 자주 사용되는 지식 그래프 임베딩을 위한 머신러닝 과제는 링크 예측이다.[1][3][5][6][7][18]로시 외 연구진은 이 모델에 대한 광범위한 벤치마크를 작성했지만, 다른 조사에서도 유사한 결과가 나왔다.[5][3][7][18][25]벤치마크에는 5개의 데이터셋 [9]FB15k,[9][39] WN18, FB15k-237, [34]WN18RR, YAGO3-10이 포함된다.[40]보다 최근에는 이러한 데이터셋이 실제 애플리케이션과 멀리 떨어져 있으며, 다른 데이터셋은 표준 벤치마크로서 통합되어야 한다는 것이 논의되고 있다.[41]

| 데이터 집합 이름 | 서로 다른 엔티티 수 | 상이한 관계수 | 삼배수 |

|---|---|---|---|

| FB15k[9] | 14951 | 1345 | 584,113 |

| WN18[9] | 40943 | 18 | 151,442 |

| FB15k-237[39] | 14541 | 237 | 310,116 |

| WN18RR[34] | 40943 | 11 | 93,003 |

| 야이고3-10[40] | 123182 | 37 | 1,089,040 |

| 모델명 | 메모리 복잡성 | FB15K(히츠@10) | FB15K(MR) | FB15K(MRR) | FB15K - 237(히츠@10) | FB15K - 237(MR) | FB15K - 237(MRR) | WN18(히츠@10) | WN18(MR) | WN18(MRR) | WN18RR(히츠@10) | WN18RR(MR) | WN18RR(MRR) | YAGO3-10(히츠@10) | YAGO3-10(MR) | YAGO3-10 (MRR) |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 디스트물[19] | 0.863 | 173 | 0.784 | 0.490 | 199 | 0.313 | 0.946 | 675 | 0.824 | 0.502 | 5913 | 0.433 | 0.661 | 1107 | 0.501 | |

| 콤플렉스[20] | 0.905 | 34 | 0.848 | 0.529 | 202 | 0.349 | 0.955 | 3623 | 0.949 | 0.521 | 4907 | 0.458 | 0.703 | 1112 | 0.576 | |

| 유추[21] | 0.837 | 126 | 0.726 | 0.353 | 476 | 0.202 | 0.944 | 808 | 0.934 | 0.380 | 9266 | 0.366 | 0.456 | 2423 | 0.283 | |

| 심플E[22] | 0.836 | 138 | 0.726 | 0.343 | 651 | 0.179 | 0.945 | 759 | 0.938 | 0.426 | 8764 | 0.398 | 0.631 | 2849 | 0.453 | |

| 홀리[23] | 0.867 | 211 | 0.800 | 0.476 | 186 | 0.303 | 0.949 | 650 | 0.938 | 0.487 | 8401 | 0.432 | 0.651 | 6489 | 0.502 | |

| 터커[24] | 0.888 | 39 | 0.788 | 0.536 | 162 | 0.352 | 0.958 | 510 | 0.951 | 0.514 | 6239 | 0.459 | 0.680 | 2417 | 0.544 | |

| 트랜스E[9] | 0.847 | 45 | 0.628 | 0.497 | 209 | 0.310 | 0.948 | 279 | 0.646 | 0.495 | 3936 | 0.206 | 0.673 | 1187 | 0.501 | |

| STransE[30] | 0.796 | 69 | 0.543 | 0.495 | 357 | 0.315 | 0.934 | 208 | 0.656 | 0.422 | 5172 | 0.226 | 0.073 | 5797 | 0.049 | |

| 크로스E[31] | 0.862 | 136 | 0.702 | 0.470 | 227 | 0.298 | 0.950 | 441 | 0.834 | 0.449 | 5212 | 0.405 | 0.654 | 3839 | 0.446 | |

| 토루스E[32] | 0.839 | 143 | 0.746 | 0.447 | 211 | 0.281 | 0.954 | 525 | 0.947 | 0.535 | 4873 | 0.463 | 0.474 | 19455 | 0.342 | |

| 로타테[33] | 0.881 | 42 | 0.791 | 0.522 | 178 | 0.336 | 0.960 | 274 | 0.949 | 0.573 | 3318 | 0.475 | 0.570 | 1827 | 0.498 | |

| 콘베[34] | 0.849 | 51 | 0.688 | 0.521 | 281 | 0.305 | 0.956 | 413 | 0.945 | 0.507 | 4944 | 0.427 | 0.657 | 2429 | 0.488 | |

| 컨브KB[36] | 0.408 | 324 | 0.211 | 0.517 | 309 | 0.230 | 0.948 | 202 | 0.709 | 0.525 | 3429 | 0.249 | 0.604 | 1683 | 0.420 | |

| 콘브르[35] | 0.885 | 70 | 0.773 | 0.526 | 251 | 0.346 | 0.958 | 471 | 0.950 | 0.526 | 5646 | 0.467 | 0.673 | 2582 | 0.527 | |

| 캡스E[37] | 0.217 | 610 | 0.087 | 0.356 | 405 | 0.160 | 0.950 | 233 | 0.890 | 0.559 | 720 | 0.415 | 0 | 60676 | 0.000 | |

| RSN[38] | 0.870 | 51 | 0.777 | 0.444 | 248 | 0.280 | 0.951 | 346 | 0.928 | 0.483 | 4210 | 0.395 | 0.664 | 1339 | 0.511 |

도서관

- GitHub의 KGE

- 깃허브에 피크2베크

- GitHub의 DGL-KE

- 깃허브의 파이킨

- 깃허브의 토치케이지

- MampiGraph on GitHub

- GitHub의 OpenKE

- 깃허브에 있는 스키킷크게

- GitHub의 Fast-TransX

참고 항목

참조

- ^ a b c d e f g h i j k l m n o p q r s t u v w x y z aa Ji, Shaoxiong; Pan, Shirui; Cambria, Erik; Marttinen, Pekka; Yu, Philip S. (2021). "A Survey on Knowledge Graphs: Representation, Acquisition, and Applications". IEEE Transactions on Neural Networks and Learning Systems. PP: 1–21. arXiv:2002.00388. doi:10.1109/TNNLS.2021.3070843. ISSN 2162-237X. PMID 33900922. S2CID 211010433.

- ^ Mohamed, Sameh K; Nováček, Vít; Nounu, Aayah (2019-08-01). Cowen, Lenore (ed.). "Discovering Protein Drug Targets Using Knowledge Graph Embeddings". Bioinformatics. 36 (2): 603–610. doi:10.1093/bioinformatics/btz600. hdl:10379/15375. ISSN 1367-4803. PMID 31368482.

- ^ a b c d Lin, Yankai; Han, Xu; Xie, Ruobing; Liu, Zhiyuan; Sun, Maosong (2018-12-28). "Knowledge Representation Learning: A Quantitative Review". arXiv:1812.10901 [cs.CL].

- ^ a b c Abu-Salih, Bilal; Al-Tawil, Marwan; Aljarah, Ibrahim; Faris, Hossam; Wongthongtham, Pornpit; Chan, Kit Yan; Beheshti, Amin (2021-05-12). "Relational Learning Analysis of Social Politics using Knowledge Graph Embedding". Data Mining and Knowledge Discovery. 35 (4): 1497–1536. arXiv:2006.01626. doi:10.1007/s10618-021-00760-w. ISSN 1573-756X. S2CID 219179556.

- ^ a b c d e f g h i j k l m n o p q r s t u v w x y z aa ab ac ad ae af ag ah ai aj ak al am an ao ap aq ar as Rossi, Andrea; Barbosa, Denilson; Firmani, Donatella; Matinata, Antonio; Merialdo, Paolo (2020). "Knowledge Graph Embedding for Link Prediction: A Comparative Analysis". ACM Transactions on Knowledge Discovery from Data. 15 (2): 1–49. arXiv:2002.00819. doi:10.1145/3424672. ISSN 1556-4681. S2CID 211011226.

- ^ a b Paulheim, Heiko (2016-12-06). Cimiano, Philipp (ed.). "Knowledge graph refinement: A survey of approaches and evaluation methods". Semantic Web. 8 (3): 489–508. doi:10.3233/SW-160218.

- ^ a b c d e f g h i j k l m n o p q r s t u v w x y z aa ab ac Dai, Yuanfei; Wang, Shiping; Xiong, Neal N.; Guo, Wenzhong (May 2020). "A Survey on Knowledge Graph Embedding: Approaches, Applications and Benchmarks". Electronics. 9 (5): 750. doi:10.3390/electronics9050750.

- ^ Guo, Shu; Wang, Quan; Wang, Bin; Wang, Lihong; Guo, Li (2015). "Semantically Smooth Knowledge Graph Embedding". Proceedings of the 53rd Annual Meeting of the Association for Computational Linguistics and the 7th International Joint Conference on Natural Language Processing (Volume 1: Long Papers). Beijing, China: Association for Computational Linguistics: 84–94. doi:10.3115/v1/P15-1009. S2CID 205692.

- ^ a b c d e f g Bordes, Antoine; Usunier, Nicolas; Garcia-Durán, Alberto; Weston, Jason; Yakhnenko, Oksana (May 2013). "Translating embeddings for modeling multi-relational data". Proceedings of the 26th International Conference on Neural Information Processing Systems - Volume 2. NIPS'13. Lake Tahoe, Nevada: Curran Associates Inc.: 2787–2795.

- ^ a b c d e f g h i j k l Chen, Zhe; Wang, Yuehan; Zhao, Bin; Cheng, Jing; Zhao, Xin; Duan, Zongtao (2020). "Knowledge Graph Completion: A Review". IEEE Access. 8: 192435–192456. doi:10.1109/ACCESS.2020.3030076. ISSN 2169-3536. S2CID 226230006.

- ^ a b c d e Cai, Hongyun; Zheng, Vincent W.; Chang, Kevin Chen-Chuan (2018-02-02). "A Comprehensive Survey of Graph Embedding: Problems, Techniques and Applications". arXiv:1709.07604 [cs.AI].

- ^ a b Zhou, Sijin; Dai, Xinyi; Chen, Haokun; Zhang, Weinan; Ren, Kan; Tang, Ruiming; He, Xiuqiang; Yu, Yong (2020-06-18). "Interactive Recommender System via Knowledge Graph-enhanced Reinforcement Learning". arXiv:2006.10389 [cs.IR].

- ^ Liu, Chan; Li, Lun; Yao, Xiaolu; Tang, Lin (August 2019). "A Survey of Recommendation Algorithms Based on Knowledge Graph Embedding". 2019 IEEE International Conference on Computer Science and Educational Informatization (CSEI): 168–171. doi:10.1109/CSEI47661.2019.8938875. ISBN 978-1-7281-2308-0. S2CID 209459928.

- ^ a b Sosa, Daniel N.; Derry, Alexander; Guo, Margaret; Wei, Eric; Brinton, Connor; Altman, Russ B. (2020). "A Literature-Based Knowledge Graph Embedding Method for Identifying Drug Repurposing Opportunities in Rare Diseases". Pacific Symposium on Biocomputing. Pacific Symposium on Biocomputing. 25: 463–474. ISSN 2335-6936. PMC 6937428. PMID 31797619.

- ^ a b Nickel, Maximilian; Tresp, Volker; Kriegel, Hans-Peter (2011-06-28). "A three-way model for collective learning on multi-relational data". Proceedings of the 28th International Conference on International Conference on Machine Learning. ICML'11. Bellevue, Washington, USA: Omnipress: 809–816. ISBN 978-1-4503-0619-5.

- ^ Nickel, Maximilian; Tresp, Volker; Kriegel, Hans-Peter (2012-04-16). "Factorizing YAGO: scalable machine learning for linked data". Proceedings of the 21st International Conference on World Wide Web. WWW '12. Lyon, France: Association for Computing Machinery: 271–280. doi:10.1145/2187836.2187874. ISBN 978-1-4503-1229-5. S2CID 6348464.

- ^ a b c d e f g h i j Alshahrani, Mona; Thafar, Maha A.; Essack, Magbubah (2021-02-18). "Application and evaluation of knowledge graph embeddings in biomedical data". PeerJ Computer Science. 7: e341. doi:10.7717/peerj-cs.341. ISSN 2376-5992. PMC 7959619. PMID 33816992.

- ^ a b c d e f g h i j k Wang, Meihong; Qiu, Linling; Wang, Xiaoli (2021-03-16). "A Survey on Knowledge Graph Embeddings for Link Prediction". Symmetry. 13 (3): 485. Bibcode:2021Symm...13..485W. doi:10.3390/sym13030485. ISSN 2073-8994.

- ^ a b Yang, Bishan; Yih, Wen-tau; He, Xiaodong; Gao, Jianfeng; Deng, Li (2015-08-29). "Embedding Entities and Relations for Learning and Inference in Knowledge Bases". arXiv:1412.6575 [cs.CL].

- ^ a b c Trouillon, Théo; Welbl, Johannes; Riedel, Sebastian; Gaussier, Éric; Bouchard, Guillaume (2016-06-20). "Complex Embeddings for Simple Link Prediction". arXiv:1606.06357 [cs.AI].

- ^ a b c d e Liu, Hanxiao; Wu, Yuexin; Yang, Yiming (2017-07-06). "Analogical Inference for Multi-Relational Embeddings". arXiv:1705.02426 [cs.LG].

- ^ a b c Kazemi, Seyed Mehran; Poole, David (2018-10-25). "SimplE Embedding for Link Prediction in Knowledge Graphs". arXiv:1802.04868 [stat.ML].

- ^ a b c Nickel, Maximilian; Rosasco, Lorenzo; Poggio, Tomaso (2015-12-07). "Holographic Embeddings of Knowledge Graphs". arXiv:1510.04935 [cs.AI].

- ^ a b c d Balažević, Ivana; Allen, Carl; Hospedales, Timothy M. (2019). "TuckER: Tensor Factorization for Knowledge Graph Completion". Proceedings of the 2019 Conference on Empirical Methods in Natural Language Processing and the 9th International Joint Conference on Natural Language Processing (EMNLP-IJCNLP): 5184–5193. arXiv:1901.09590. doi:10.18653/v1/D19-1522. S2CID 59316623.

- ^ a b Ali, Mehdi; Berrendorf, Max; Hoyt, Charles Tapley; Vermue, Laurent; Galkin, Mikhail; Sharifzadeh, Sahand; Fischer, Asja; Tresp, Volker; Lehmann, Jens (2021). "Bringing Light into the Dark: A Large-scale Evaluation of Knowledge Graph Embedding Models under a Unified Framework". IEEE Transactions on Pattern Analysis and Machine Intelligence. PP: 1. arXiv:2006.13365. doi:10.1109/TPAMI.2021.3124805. PMID 34735335. S2CID 220041612.

- ^ a b Wang, Zhen (2014). "Knowledge Graph Embedding by Translating on Hyperplanes". AAAI Publications, Twenty-Eighth AAAI Conference on Artificial Intelligence.

- ^ Lin, Yankai; Liu, Zhiyuan; Sun, Maosong; Liu, Yang; Zhu, Xuan (2015-01-25). "Learning entity and relation embeddings for knowledge graph completion". Proceedings of the Twenty-Ninth AAAI Conference on Artificial Intelligence. AAAI'15. Austin, Texas: AAAI Press: 2181–2187. ISBN 978-0-262-51129-2.

- ^ a b c d e Ji, Guoliang; He, Shizhu; Xu, Liheng; Liu, Kang; Zhao, Jun (July 2015). "Knowledge Graph Embedding via Dynamic Mapping Matrix". Proceedings of the 53rd Annual Meeting of the Association for Computational Linguistics and the 7th International Joint Conference on Natural Language Processing (Volume 1: Long Papers). Beijing, China: Association for Computational Linguistics: 687–696. doi:10.3115/v1/P15-1067. S2CID 11202498.

- ^ a b c d Xiao, Han; Huang, Minlie; Hao, Yu; Zhu, Xiaoyan (2015-09-27). "TransA: An Adaptive Approach for Knowledge Graph Embedding". arXiv:1509.05490 [cs.CL].

- ^ a b c d e Nguyen, Dat Quoc; Sirts, Kairit; Qu, Lizhen; Johnson, Mark (June 2016). "STransE: a novel embedding model of entities and relationships in knowledge bases". Proceedings of the 2016 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies. San Diego, California: Association for Computational Linguistics: 460–466. arXiv:1606.08140. doi:10.18653/v1/N16-1054. S2CID 9884935.

- ^ a b c d e f g Zhang, Wen; Paudel, Bibek; Zhang, Wei; Bernstein, Abraham; Chen, Huajun (2019-01-30). "Interaction Embeddings for Prediction and Explanation in Knowledge Graphs". Proceedings of the Twelfth ACM International Conference on Web Search and Data Mining: 96–104. arXiv:1903.04750. doi:10.1145/3289600.3291014. ISBN 9781450359405. S2CID 59516071.

- ^ a b c d Ebisu, Takuma; Ichise, Ryutaro (2017-11-15). "TorusE: Knowledge Graph Embedding on a Lie Group". arXiv:1711.05435 [cs.AI].

- ^ a b c d e Sun, Zhiqing; Deng, Zhi-Hong; Nie, Jian-Yun; Tang, Jian (2019-02-26). "RotatE: Knowledge Graph Embedding by Relational Rotation in Complex Space". arXiv:1902.10197 [cs.LG].

- ^ a b c d e f Dettmers, Tim; Minervini, Pasquale; Stenetorp, Pontus; Riedel, Sebastian (2018-07-04). "Convolutional 2D Knowledge Graph Embeddings". arXiv:1707.01476 [cs.LG].

- ^ a b c d Jiang, Xiaotian; Wang, Quan; Wang, Bin (June 2019). "Adaptive Convolution for Multi-Relational Learning". Proceedings of the 2019 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies, Volume 1 (Long and Short Papers). Minneapolis, Minnesota: Association for Computational Linguistics: 978–987. doi:10.18653/v1/N19-1103. S2CID 174800352.

- ^ a b c d Nguyen, Dai Quoc; Nguyen, Tu Dinh; Nguyen, Dat Quoc; Phung, Dinh (2018). "A Novel Embedding Model for Knowledge Base Completion Based on Convolutional Neural Network". Proceedings of the 2018 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies, Volume 2 (Short Papers): 327–333. arXiv:1712.02121. doi:10.18653/v1/N18-2053. S2CID 3882054.

- ^ a b c d e Nguyen, Dai Quoc; Vu, Thanh; Nguyen, Tu Dinh; Nguyen, Dat Quoc; Phung, Dinh (2019-03-06). "A Capsule Network-based Embedding Model for Knowledge Graph Completion and Search Personalization". arXiv:1808.04122 [cs.CL].

- ^ a b c d e f Guo, Lingbing; Sun, Zequn; Hu, Wei (2019-05-13). "Learning to Exploit Long-term Relational Dependencies in Knowledge Graphs". arXiv:1905.04914 [cs.AI].

- ^ a b Toutanova, Kristina; Chen, Danqi (July 2015). "Observed versus latent features for knowledge base and text inference". Proceedings of the 3rd Workshop on Continuous Vector Space Models and Their Compositionality. Beijing, China: Association for Computational Linguistics: 57–66. doi:10.18653/v1/W15-4007. S2CID 5378837.

- ^ a b Mahdisoltani, F.; Biega, J.; Suchanek, Fabian M. (2015). "YAGO3: A Knowledge Base from Multilingual Wikipedias". CIDR. S2CID 6611164.

- ^ Hu, Weihua; Fey, Matthias; Zitnik, Marinka; Dong, Yuxiao; Ren, Hongyu; Liu, Bowen; Catasta, Michele; Leskovec, Jure (2021-02-24). "Open Graph Benchmark: Datasets for Machine Learning on Graphs". arXiv:2005.00687 [cs.LG].

외부 링크

| 스콜리아는 지식 그래프 포함에 대한 주제 프로파일을 가지고 있다. |

꼬리 t

꼬리 t

(를) 지정하면 다음과 같은 세 가지 성능 지수를 정의할 수 있다.Hits@K, MR, MRR.

(를) 지정하면 다음과 같은 세 가지 성능 지수를 정의할 수 있다.Hits@K, MR, MRR.

합계된다.

합계된다.![{\displaystyle MRR={\frac {1}{|Q|}}\sum _{q\in Q}{\frac {1}{q}}\in [0,1]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/adf9b1771d7ac872c4d3082c26b15e8eb9f3e512)

(를) 사용하여 임베딩의 선도를 측정하거나 사실의 신뢰성을 얻는다.

(를) 사용하여 임베딩의 선도를 측정하거나 사실의 신뢰성을 얻는다.

![{\displaystyle {\ce {[h;{\mathcal {r}}]}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/4754a8e29d7b4ccd4cf13de3052aef0922840171)

![{\displaystyle {\ce {[h;{\mathcal {r}};t]}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/fb32c4cfc9fa12eb799777f7234990ce33b3d544)