라소(통계)

Lasso (statistics)통계학 및 기계학습에서 라소(최소 절대수축 및 선택 연산자, 또한 Lasso 또는 LASSO)는 결과 통계모델의 예측 정확도와 해석가능성을 높이기 위해 변수 선택과 정규화를 모두 수행하는 회귀분석 방법이다.원래 지구물리학에서 도입되었고,[1] 후에 로버트 티비시라니([2]Robert Tibshirani)가 이 용어를 만들었다.

라소는 원래 선형 회귀 모델을 위해 제조되었다.이 간단한 사례는 추정기에 대한 상당한 양을 보여준다.여기에는 능선 회귀 분석과 최상의 부분 집합 선택과의 관계, 라소 계수 추정치와 소위 소프트 임계값 설정 사이의 연결이 포함된다.또한 (표준 선형 회귀와 마찬가지로) 공변량이 공변량일 경우 계수 추정치가 고유할 필요는 없다는 것을 보여준다.

선형 회귀 분석을 위해 원래 정의되었지만 라소 정규화는 일반화된 선형 모형, 일반화된 추정 방정식, 비례 위험 모델 및 M-추정자를 포함한 다른 통계적 모델로 쉽게 확장된다.[2][3]부분집합 선택을 수행하는 라소의 능력은 제약조건의 형태에 의존하며 기하학, 베이지안 통계학, 볼록 분석 등 다양한 해석을 가지고 있다.

동기

Rasso는 회귀 모형의 예측 정확도와 해석 가능성을 개선하기 위해 도입되었다.모형에 사용할 알려진 공변량의 축소 집합을 선택한다.[2][1]

역사

라소는 계수의 적합과 벌칙 모두에 대해 1} 벌칙을 사용한 이전 작업을 바탕으로 1986년 지구물리학 문헌에서 독자적으로 개발되었다.통계학자 로버트 티비시라니(Robert Tibshirani)가 독자적으로 재발견하여 1996년 브레이만의 비부정적인 가사를 바탕으로 대중화하였다.[1][4]

라소 이전에는 공변량을 선택하는 데 가장 널리 사용되는 방법이 단계적 선택이었다.그러한 접근법은 단지 소수의 공변량만이 결과와 강한 관계를 가질 때와 같은 특정한 경우에 예측 정확도를 개선할 뿐이다.그러나 다른 경우에는 예측오차를 증가시킬 수 있다.

당시 예측 정확도를 높이기 위해 가장 많이 사용된 기법은 능선 회귀였다.능선 회귀 분석은 과도한 적합성을 줄이기 위해 회귀 계수의 제곱 합계를 고정 값보다 작게 축소하여 예측 오차를 개선하지만 공변량 선택을 수행하지 않으므로 모형을 더 해석할 수 있게 만드는 데 도움이 되지 않는다.

라소는 회귀계수의 절대값 합계가 고정값보다 작도록 강요함으로써 이러한 두 가지 목표를 달성하는데, 이는 특정 계수를 0으로 강제하며, 이들 계수는 예측에 영향을 미치지 않는다.이 아이디어는 계수의 크기를 축소하는 능선 회귀 분석과 유사하지만, 능선 회귀 분석은 계수를 0으로 설정하는 경향이 있다.

기본형식

최소 제곱

각각 p 공변량과 단일 결과물로 구성된 N개의 사례로 구성된 표본을 고려하십시오. 가 결과가 되게 하고 ( , 2,… , ) i}{i}}}}}{}}}}}}}}}}}}}}}{{{}}}}}}}}}}}}}}}}}}}}}}}}}는 i 케이스의 공변 벡터가 된다.그렇다면 라소의 목적은 해결하는 것이다.

Here is the constant coefficient, is the coefficient vector, and is a prespecified free parameter that determines the degree of regularization.

=( ) 가 되도록 X X을(를) 공변량 행렬로 지정 및 I 스타일 은(는) 의 i행으로 표현은 다음과 같이 더욱 간결하게 쓸 수 있다.

여기서 = ( = 1 p) / p \}\는 표준 p이다.

포인트 의 스칼라 평균과 y 의 을 β 0 {\ 에 대한 결과 추정치는 0= 0이다. }-{\ 이렇게 해서

따라서 영점 조정된 변수를 사용하는 것이 표준이다.또한 공변량은 일반적으로 용액이 척도에 달라지지 않도록 로 표준화된다

다시 쓰는 것이 도움이 될 수 있다.

소위 라그랑지 형식으로

서 t 과(와) 사이의 정확한 관계는 데이터에 의존한다.

직교 공변량

이제 라소 추정기의 몇 가지 기본적인 성질을 고려할 수 있다.

공변량이( x x ) = j 이 되도록 먼저 직교라고 가정함, where is the inner product and is the Kronecker delta, or, equivalently, , then using subgradient methods it can be shown that

은(는) 작은 값을 0으로 설정하고 큰 값을 하드 임계값 연산자로 손대지 않고 0을 향해 정확하게 0으로 변환하기 때문에 소프트 임계값 연산자로 일컬어지며, 종종 }로 표시된다.

능선 회귀 분석의 목적은 최소화하는 것이다.

양보하는

리지 회귀 분석은 모든 계수를 균일한 계수+ N )- 로 축소하고 계수를 0으로 설정하지 않는다.

또한 최소화하는 것이 목표인 최량 부분 집합 선택을 사용한 회귀 분석과도 비교할 수 있다.

여기서 \_}}은 " 0 으로, z의 m 성분이 0이 아닌 경우 = \로 정의된다.이 경우, 라는 것을 보여줄 수 있다.

여기서 은(는) 소위 하드 임계값 기능이고 그 인수가 참이면 1이고 그렇지 않으면 0) 표시 함수다.

따라서 라소는 최적의 부분 집합 선택 사례에서처럼 모든 계수의 크기를 축소하고 일부 계수의 크기를 0으로 설정하기 때문에 능선 및 최적 부분 집합 선택 회귀 분석의 특징을 모두 공유한다.또한, 능선 회귀 분석은 모든 계수의 스케일을 상수 인수로 하는 반면, 라소는 계수를 상수 값으로 환산하고 계수가 도달하면 0으로 설정한다.

In one special case two covariates, say j and k, are identical for each observation, so that , where . Then the values of and 라소 목적 기능을 최소화하는 은(는) 고유하게 결정되지 않는다.In fact, if some in which , then if replacing by and by , while keeping all the other fixed는 새로운 해결책을 제공하므로, 라소 객관적 기능은 일련의 유효한 미니마이저들을 가지고 있다.[5]이 단점을 해결하기 위해 엘라스틱 네트 정규화를 포함한 몇 가지 라소의 변형들이 고안되었다.

일반형식

라소 정규화는 일반화된 선형 모델, 일반화된 추정 방정식, 비례 위험 모델 및 M-추정기와 같은 다른 객관적 기능으로 확장될 수 있다.[2][3]목표함수 부여

에 대한 해답은 라스로 정규화.

서 만 을 적용하고 {\displaystyle 은(는 기본 사례에서 벌칙을 적용하지 않은 것처럼 허용되는 값을 자유롭게 취할 수 있다.

해석

기하학적 해석

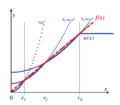

라소는 계수를 0으로 설정할 수 있지만 표면적으로 유사한 능선 회귀 분석은 할 수 없다.이는 제약 경계 모양의 차이 때문이다.라소와 능선 회귀 모두 동일한 목표 함수를 최소화하는 것으로 해석할 수 있다.

그러나 다른 제약조건에 대해서는 다음과 같다: β β 1β }\t},β t \ \그림에는 } 표준에 의해 정의된 제약 영역은 그 모서리가 축(일반적으로 교차 폴리토프)에 놓이도록 회전된 사각형인 반면, 표준에 의해 정의된 영역은 원(일반적으로 n-sphere)이며, 회전 불변하며, th따라서, 구석이 없다.그림에서 볼 수 있듯이, 표시된 선과 같이 경계에 접하는 볼록한 물체는 하이퍼큐브의 코너(또는 고차원 등가물)에 부딪힐 가능성이 높은데, 여기에 대한 의 일부 구성요소는 동일하게 0인 반면, n-sphere의 경우, 일부 구성요소가 있는 경계의 점들이 있다. 의 구성 요소는 0이며 볼록 물체는 의 일부 구성 요소가 0인 지점에 더 이상 접촉할 가능성이 없으며, 이들 구성 요소 중 어느 것도 0인 지점에 도달하지 않는다.

정확성-단순성 트레이드오프를 통해 λ의 해석 용이성 향상

라소의 크기를 조정하여 주어진 값인 {\ \과(와) 관련된 축소 정도를 예측하고 영향을 미치도록 할 수 있다[6] X 은(는) z-점수로 표준화되고 y 은(평균 0) 중심인 것으로 가정한다. 이 귀무 가설의 회귀 계수를 L S{\가 되도록 한다.은(는) 데이터에 최적화된 일반 최소 제곱 솔루션을 가리킨다.그런 다음 우리는 데이터 최적화 솔루션의 표본 내 정확성과 가설의 값을 고수하는 단순성 사이의 트레이드오프로 라그랑지안을 정의할 수 있다.[7]결과적으로

여기서 는 다음과 같이 지정된다.첫 번째 분수는 상대적 정확도, 두 번째 분율 상대적 단순성, 그리고 두 사이의 균형 을(를) 나타낸다.

Given a single regressor, relative simplicity can be defined by specifying as , which is the maximum amount of deviation from when . Assuming that = 솔루션 경로는 R

= 인 경우 일반 최소 제곱 용액(OLS)이 사용된다.The hypothesized value of is selected if is bigger than . Furthermore, if , then represents the proportional influence of , × % \lambda 은(는) 데이터 최적화 OLS 솔루션에 대한 가설 값 영향의 최소량을 백분율로 측정한다.

-norm을 사용하여 단일 regressor가 주어지는 0으로부터의 편차를 벌충하는 경우, 솔루션 경로는 다음과 같다.

. Like , moves in the direction of the point when is close to zero; but unlike , the 이(가) 증가하면 영향력이 감소한다(그림 참조).

복수의 리레스터를 주어진 경우, 파라미터를 활성화하는 순간(즉, 0 도 정확도에 대한 레지스터의 기여에 의해 결정된다.일단.

의 75%는 가정된 0 값 대신 제한되지 않은 OLS 솔루션을 사용할 경우 샘플 내 정확도가 75% 향상됨을 의미한다.각 가설에서 벗어나는 개별 기여는 x 행렬로 계산할 수 있다.

여기서 ~ = y- 0 = 2 R회 계산하면 R⊗ R의 대각선 원소가 R대각선 값은 0보다 작거나 1보다 작을 수 있다.Regressor가 상관 관계가 없는 경우, i의 t h displaystyle r^{\ 대각선 요소에 단순히 와 y} 의 r^{} 에 해당된다

의 적응 lasso의 rescaled 버전, 나는 OLSb원q 적응 lasso을 설정하여 얻을 수 있어요, 만약 regressors 있uncorrelated β 0, 나는{\displaystyle q_{{\mbox{적응 lasso}} 난})b_{OLS,i}-\beta _{0,i}}.[8], 그 순간은 나는 하루에 500파운드 h{\displaystyle i^{월}}파라미터를 활성화에 의해서 주어진다 −.월e t i 의 대각선 원소. 이 0의 벡터라고 가정하면,

즉, regressor와 상관관계가 없는 , 은(는) 0 의 최소 영향을 다시 지정한다 regressor가 상관관계가 있는 경우에도 \이 가장 높은 대각 요소와 같을 때 회귀 파라미터가 활성화된다. R

These results can be compared to a rescaled version of the lasso by defining , which is the average absolute deviation of 의 OLS regressor가 상관관계가 없다고 가정할 때 t {\^{ regressor의 활성화 순간은 다음과 같다.

For , the moment of activation is again given by . If is a vector of zeros and a subset of relevant parameters are equally responsib 2= 의 완벽한 적합을 위해이 부분 집합은 1 값 1 p 에서 활성화된다The moment of activation of a relevant regressor then equals . In other words, the inclusion of irrelevant regressors delays the moment that relevant regressors are activated by this 재질의 라소적응형 라소와 라소는 '1ASTC' 추정기의 특별한 경우다.후자는 regressor 사이의 절대 상관관계가 사용자 지정 값보다 큰 경우에만 파라미터를 함께 그룹화한다.[6]

베이지안 해석

능선회귀는 계수에 정상적인 사전분포가 할당된 선형회귀로 해석할 수 있듯이, 라소는 계수에 라플라스 이전분포가 있는 선형회귀로 해석할 수 있다.라플라스 분포는 0(첫 번째 파생상품은 0으로 불연속됨)으로 급격히 정점을 이루며, 정규 분포보다 확률 질량을 0에 더 가깝게 집중시킨다.이는 라소가 일부 계수를 0으로 설정하는 경향이 있는 반면, 능선 회귀 분석은 그렇지 않은 이유에 대한 대체 설명을 제공한다.[2]

볼록 이완 해석

또한 라소는 최상의 부분 집합 선택 회귀 문제의 볼록한 완화로 볼 수 있는데, 이는 일부 k 공변량의 목표 함수 값 중 가장 작은 값을 초래하는 의 부분 집합을 찾는 것이다 여기서 n은 공변량의 총 수입니다.The " norm", , (the number of nonzero entries of a vector), is the limiting case of " norms", of the form (where the quotation marks signify that these are not really norms for since is not convex for , so the triangle inequality does not hold).따라서 p = 1은 " p 규범"이 볼록(따라서 실제로 표준)인 가장 작은 값이기 때문에, las x so 에 의해 정의된 영역이 선체의 볼록이기 때문에, 어떤 의미에서는 최상의 서브셋 선택 문제에 대한 최고의 볼록 근사이다.< x에서 p < 1 에 대해 정의된 영역

일반화

라소 변형은 원래 기법의 한계를 고치고 그 방법을 특정 문제에 더 유용하게 만들기 위해 만들어졌다.이 모든 것들은 공변량들 사이의 의존성을 존중하거나 이용하는데 초점을 맞추고 있다.

탄성 순 정규화는 예측 변수의 수가 표본 크기보다 클 때 성능을 향상시키고, 강하게 상관된 변수를 함께 선택할 수 있게 하며, 전체적인 예측 정확도를 향상시키는 능선 회귀와 같은 페널티를 추가한다.[5]

그룹 라소는 관련 공변량 그룹을 단일 단위로 선택할 수 있도록 하는데, 다른 공변량 없이 일부 공변량을 포함하는 것이 말이 되지 않는 설정에 유용할 수 있다.[9]그룹 라소의 추가 확장은 개별 그룹 내에서 가변 선택을 수행하고 그룹 간 중첩을 허용한다(오버랩 그룹 라소).[10][11]

퓨전된 라소는 문제의 공간적 또는 일시적 특성을 설명할 수 있으며, 시스템 구조와 더 잘 일치하는 추정치를 도출한다.[12]라소 정규화된 모델은 하위 각도 방법, 최소 각도 회귀 분석(LARS), 근위부 그라데이션 방법을 포함한 기법을 사용하여 적합할 수 있다.정규화 매개변수에 대한 최적 값을 결정하는 것은 모델이 잘 수행되는지 확인하는 중요한 부분이다. 일반적으로 교차 검증을 사용하여 선택된다.

탄성망

2005년 조우(Zou)와 헤스티(Heastie)가 탄성 그물을 선보였다.[5]p > n (공변량의 수가 표본 크기보다 큰 경우) 라소는 공변량을 n개만 선택할 수 있고(결과와 더 많은 공변량이 연관되어 있는 경우에도) 상관성이 높은 공변량 집합에서 하나의 공변량을 선택하는 경향이 있다.또한 n > p에도 불구하고, 강하게 상관된 공변량이 주어지면 능선회귀가 더 잘 수행되는 경향이 있다.

탄력 그물은 }} 벌칙 조건 부여를 추가하여 라소를 확장한다.

어떤 것이 해결과 맞먹는다.

이 문제는 간단한 라소 형태로 쓰여질 수 있다.

내버려 두는

- , ,

그러면 = + {\ {\frac {{\이 되는데, 공변량이 서로 직교할 때 이 경우

그래서 탄력적인 순벌칙의 결과는 라소와 능선벌칙의 효과를 합친 것이다.

일반적인 사례로 돌아가면, 이제 페널티 기능이 엄격히 볼록해진다는 것은 )= ( k) j= [5] 일반적으로 >

이(가) 정규화되기 때문에 표본 상관 행렬인 경우.

따라서 상관성이 높은 공변량은 regression \ }}모두에 따라 유사도의 회귀 계수가 비슷한 경향이 있는데, 이는 라소와 다르다.강하게 상관된 공변량이 유사한 이 현상을 그룹화 효과라고 한다.유전자를 질병에 묶는 것과 같은 응용 프로그램에서는 라소처럼 각 상관 공변량 집합에서 하나를 선택하는 것보다 관련된 공변량을 모두 찾는 것이 바람직하므로 그룹화가 바람직하다.[5]또한 각 그룹에서 한 개만 선택하면 모형이 덜 견고하기 때문에(그래서 리지 회귀가 라소를 능가하는 경우가 많다) 일반적으로 예측 오차가 커진다.

그룹 라소

2006년 위안과 린은 공변량의 사전 정의된 그룹을 모델 내외로 공동으로 선택할 수 있도록 그룹 라소를 도입했다.[9]이는 많은 설정에서 유용하며, 아마도 가장 분명히 범주형 변수가 이항 공변량의 집합으로 코드화된 경우 유용할 것이다.이 경우 그룹 라소는 범주형 공변량을 인코딩하는 모든 변수를 함께 포함하거나 제외할 수 있다.그룹화가 자연스러운 또 다른 배경은 생물학 연구에 있다.유전자와 단백질은 흔히 알려진 경로에 놓여있기 때문에 어떤 경로가 결과와 관련이 있는지는 개별 유전자의 여부보다 더 중요할 수 있다.그룹 라소의 객관적 기능은 표준 라소 목표를 자연스럽게 일반화하는 것이다.

여기서 설계 행렬 및 공변량 벡터{\이(가) 각 J 그룹에 하나씩 설계 행렬 X 및 공변량 벡터 의 모음으로 대체되었다.덧붙여 벌칙항은 이제 2 }}개의 규범에 대한 합이 공변량이 자신의 그룹에 속하고 j= 에 의해 정의된다 그러면 표준 라소로 감소하는 반면, = 만 있는 경우에는 능선 회귀로 감소한다위약금은 각 그룹이 정의한 서브스페이스에서 표준으로 감소하므로, 능선회귀가 할 수 없는 것처럼 그룹에서 일부 공변량만 선택할 수 없다.그러나 벌칙은 표준 라소에서와 같이 서로 다른 아공간 규범에 대한 합이기 때문에 제약조건에는 일부 비차이 포인트가 있어 일부 서브스페이스가 동일하게 0에 해당한다.따라서 일부 서브스페이스에 해당하는 계수 벡터를 0으로 설정하고 다른 서브스페이스는 축소할 수 있다.단, 각 그룹 서브 스페이스에 1페널티를 추가하면 그룹 내 개별 공변량을 선택할 수 있는 이른바 스파스 그룹 라소까지 그룹 라소를 확장할 수 있다.[10]또 다른 확장인 중첩된 그룹 라소는 예를 들어 유전자가 두 경로에서 발생하는 경우 그룹 간에 공변량을 공유할 수 있다.[11]

퓨전라소

어떤 경우에는 연구 중인 현상이 시계열이나 영상 기반 데이터와 같이 분석 중에 반드시 고려해야 하는 중요한 공간적 또는 시간적 구조를 가질 수 있다.2005년에 티비시라니와 동료들은 이러한 유형의 데이터로 라소의 사용을 확장하기 위해 퓨전된 라소를 도입했다.[12]퓨전된 라소 목표 기능은

첫 번째 구속조건은 라소 구속조건인 반면, 두 번째 구속조건은 시간적 또는 공간적 구조와 관련하여 큰 변화를 직접적으로 벌하는 것으로, 계수가 시스템의 근본 논리를 반영하기 위해 부드럽게 변화하도록 강제한다.클러스터형 라소는[13] 퓨전 라소의 일반화로, 그 효과에 따라 관련 공변량을 식별하고 그룹화한다(코퍼펙트).기본 아이디어는 0이 아닌 계수가 군집하도록 계수의 차이를 벌충하는 것이다.이는 다음과 같은 정규화를 사용하여 모델링할 수 있다.

이와는 대조적으로 변수는 고도로 상관된 그룹으로 군집화하여 각 군집으로부터 하나의 대표적인 공변량을 추출할 수 있다.[14]

융합된 라소 문제를 해결하는 알고리즘과 그것의 일부 일반화가 존재한다.알고리즘은 한정된 수의 운영에서 정확히 해결할 수 있다.[15]

준규범 및 교량 회귀 분석

라소, 탄성 네트, 그룹, 퓨전 라소는 및 2}}의 규범(필요한 경우 가중치 포함)에서 페널티 기능을 구성한다.브리지 회귀 분석에서는 일반 p 규범( 1 1과 퀘이시노름(<1> [17]을 사용한다.예를 들어, p=1/2의 경우, 라그랑지안 양식의 라소 목표의 아날로그는 해결하는 것이다.

어디에

부분적 준규범 p ^{<< 1{\ 01은 이론적, 경험적으로 데이터 분석에서 보다 의미 있는 결과를 제공한다고 주장한다.[18]이러한 준규범들의 비합치성은 최적화 문제를 복잡하게 한다.이 문제를 해결하기 위해 기능 최소화를 위한 기대 최소화 절차를 개발하여[19] 시행한다[16].

where is an arbitrary concave monotonically increasing function (for example, gives the lasso penalty and gives the 디스플레이 벌칙).

최소화를 위한 효율적인 알고리즘은 부분적인 2차적 근사치(PQSQ)에 기초한다.[19]

적응라소

적응형 라소는 Zou가 선형 회귀[20] 분석을 위해 2006년에, Zhang과 Lu가 비례 위험 회귀 분석을 위해 2007년에 도입했다.[21]

선행라소

이전 라소는 장 외 연구진이 특정 공변량의 중요성과 같은 사전 정보를 통합하기 위해 2016년 일반화된 선형 모델에 도입했다.[22]이전의 라소에서는 그러한 정보를 유사 반응(이전 반응이라고 함) p 로 요약한 후 라소 벌칙으로 통상적인 객관적 함수에 추가 기준 함수를 추가한다.일반성의 상실 없이 선형 회귀에서는 새로운 목적 함수를 다음과 같이 기록할 수 있다.

에 해당하는

the usual lasso objective function with the responses being replaced by a weighted average of the observed responses and the prior responses (called the adjusted response values by the p더 높은 정보

이전 lasso에서는 매개 변수 을(를) 밸런싱 매개 변수라고 부르는데, 이는 데이터와 이전 정보의 상대적 중요성의 균형을 맞춘다는 것이다.인 = =의 경우 이전의 lasso는 lasso로 축소된다.만약 = 인 경우, 이전 라소는 모델에 적합한 사전 정보에 전적으로 의존할 것이다.또한 밸런싱 매개 변수 은(는) 베이지안 관점에서 이전 분포의 의 분산을 제어한다는 또 다른 매력적인 해석을 가지고 있다.

선행 라소는 선행정보가 고품질일 때 매개변수 추정과 예측(추정오차와 예측오차가 작음)에 더 효율적이며, 균형잡힌 매개변수 을(를) 잘 선택하여 낮은 품질의 사전정보에 강하다

라소 솔루션 컴퓨팅

라소의 손실 기능은 다를 수 없지만, 볼록 분석과 최적화 이론으로부터 다양한 기법이 개발되어 라소의 솔루션 경로를 계산하게 되었다.여기에는 좌표 강하,[23] 하위 각도 방법, 최소 각도 회귀 분석(LARS) 및 근위부 그라데이션 방법이 포함된다.[24]하위 단계적 방법은 모든 점에서 객관적 기능이 다를 수 없는 경우에 대한 구배 강하 및 확률적 구배 강하와 같은 전통적인 방법의 자연적 일반화다.LARS는 라소 모델과 밀접하게 연계된 방식으로, 모든 상황에서 성능이 좋지 않을 수 있지만 효율적으로 장착할 수 있도록 하는 경우가 많다.LARS는 완전한 솔루션 경로를 생성한다.[24]근위 방법은 유연성과 성능 때문에 대중화되었고 활발한 연구의 한 분야다.방법의 선택은 특정한 라소 변종, 데이터 및 가용 자원에 따라 달라질 것이다.그러나 근위부 방법은 일반적으로 성능이 좋다.

정규화 파라미터 선택

정규화 매개변수( )를 선택하는 것은 라소의 기본 부분이다.좋은 값은 수축과 가변선택의 강도를 조절하기 때문에 라소의 성능에 필수적이며, 이는 적당히 예측 정확도와 해석성을 모두 향상시킬 수 있다.그러나 정규화가 너무 강해지면 중요한 변수가 생략되고 계수가 과도하게 축소되어 예측 역량과 회의 중 둘 다 해칠 수 있다.교차 검증은 종종 정규화 파라미터를 찾는 데 사용된다.

베이시안 정보 기준(BIC)과 Akaike 정보 기준(AIC)과 같은 정보 기준은 계산 속도가 빠르고 성능은 작은 표본에서 덜 변동하기 때문에 교차 검증보다 선호될 수 있다.[25]정보 기준은 모델의 표본 내 정확도를 극대화하는 동시에 유효 매개변수/자유도를 저하시킴으로써 추정자의 정규화 매개변수를 선택한다.Zou 등은 0에서 벗어나는 매개변수의 수를 세어 유효 자유도를 측정할 것을 제안했다.[26]모델의 자유도가 정규화 파라미터에 의해 더 강력한 불이익을 받을 경우에도 증가하기 때문에 카우프만과 로제트[27], 잰슨 등은 자유도 접근에 결함이 있는 것으로 간주했다.[28]대안으로 위에서 정의한 상대적 단순성 측정치를 사용하여 유효 매개변수 수를 계산할 수 있다.[25]라소의 경우, 이 조치는 다음과 같다.

- ,

정규화 매개 변수가 에서 0으로 감소함에 따라 단조롭게 에서 p 으로 증가한다.

선택한 응용프로그램

라소(LASSO)는 경제·금융 분야에 적용돼 예측을 개선하고 기업 파산 예측 문헌이나 [29]고성장 기업 예측 등 때로는 방치된 변수를 선택하는 것으로 나타났다.[30]

참고 항목

참조

- ^ a b c Santosa, Fadil; Symes, William W. (1986). "Linear inversion of band-limited reflection seismograms". SIAM Journal on Scientific and Statistical Computing. SIAM. 7 (4): 1307–1330. doi:10.1137/0907087.

- ^ a b c d e f g Tibshirani, Robert (1996). "Regression Shrinkage and Selection via the lasso". Journal of the Royal Statistical Society. Series B (methodological). Wiley. 58 (1): 267–88. JSTOR 2346178.

- ^ a b Tibshirani, Robert (1997). "The lasso Method for Variable Selection in the Cox Model". Statistics in Medicine. 16 (4): 385–395. CiteSeerX 10.1.1.411.8024. doi:10.1002/(SICI)1097-0258(19970228)16:4<385::AID-SIM380>3.0.CO;2-3. PMID 9044528.

- ^ Breiman, Leo (1995). "Better Subset Regression Using the Nonnegative Garrote". Technometrics. 37 (4): 373–84. doi:10.1080/00401706.1995.10484371.

- ^ a b c d e Zou, Hui; Hastie, Trevor (2005). "Regularization and Variable Selection via the Elastic Net". Journal of the Royal Statistical Society. Series B (statistical Methodology). Wiley. 67 (2): 301–20. doi:10.1111/j.1467-9868.2005.00503.x. JSTOR 3647580.

- ^ a b Hoornweg, Victor (2018). "Chapter 8". Science: Under Submission. Hoornweg Press. ISBN 978-90-829188-0-9.

- ^ Motamedi, Fahimeh; Sanchez, Horacio; Mehri, Alireza; Ghasemi, Fahimeh (October 2021). "Accelerating Big Data Analysis through LASSO-Random Forest Algorithm in QSAR Studies". 37 (19). Bioinformatics: 1–7. doi:10.1093/bioinformatics/btab659. ISSN 1367-4803.

{{cite journal}}:Cite 저널은 필요로 한다.journal=(도움말) - ^ Zou, Hui (2006). "The Adaptive Lasso and Its Oracle Properties" (PDF).

- ^ a b Yuan, Ming; Lin, Yi (2006). "Model Selection and Estimation in Regression with Grouped Variables". Journal of the Royal Statistical Society. Series B (statistical Methodology). Wiley. 68 (1): 49–67. doi:10.1111/j.1467-9868.2005.00532.x. JSTOR 3647556.

- ^ a b 푸이그, 아르나우 티보, 아미 비젤, 알프레드 오. 히어로 III. "다차원 수축-스레스홀딩 연산자.통계 신호 처리, SSP'09, IEEE, 페이지 113–116에 관한 제15차 워크샵의 진행.

- ^ a b 야곱, 로랑, 기욤 오보진스키, 장필리프 베르트."중첩이 있는 그룹 라소 및 그래프 라소".2009년 캐나다 몬트리올에서 열린 제26회 머신러닝 국제회의의 프로시저에 출연.

- ^ a b 티비라니, 로버트, 마이클 선더스, 사하론 로셋, 지주, 키스 나이트.2005. "Fused lasso를 통한 Sparsity and Smoothness".영국 왕립통계학회지.시리즈 B(통계학적 방법론) 67(1)91–108.https://www.jstor.org/stable/3647602.

- ^ She, Yiyuan (2010). "Sparse regression with exact clustering". Electronic Journal of Statistics. 4: 1055–1096. doi:10.1214/10-EJS578.

- ^ Reid, Stephen (2015). "Sparse regression and marginal testing using cluster prototypes". Biostatistics. 17 (2): 364–76. arXiv:1503.00334. Bibcode:2015arXiv150300334R. doi:10.1093/biostatistics/kxv049. PMC 5006118. PMID 26614384.

- ^ Bento, Jose (2018). "On the Complexity of the Weighted Fused Lasso". IEEE Letters in Signal Processing. 25 (10): 1595–1599. arXiv:1801.04987. Bibcode:2018ISPL...25.1595B. doi:10.1109/LSP.2018.2867800. S2CID 5008891.

- ^ a b Mirkes E.M. PQSQ 정규화된 회귀 리포지토리 GitHub.

- ^ 푸, 원장 J. 1998."다리 대 라소"컴퓨터 및 그래픽 통계 저널 7 (3).테일러 & 프랜시스: 397-416.

- ^ Aggarwal C.C., Hinneburg A., Keim D.A.(2001) "고차원 공간에서의 거리 측정의 놀라운 행동에 대하여"인: Van den Bussche J, Vianu V. (eds) 데이터베이스 이론 - ICDT 2001.ICDT 2001.컴퓨터 과학 강의 노트, 1973.스프링거, 베를린 하이델베르크 420-434쪽

- ^ a b A.N. Gorban, Mirkes, E.M., Zinovyev, A. (2016) "빠르고 견고한 기계 학습을 위한 임의 오류 기능의 2차 근사치"뉴럴 네트워크 84, 28-38

- ^ 조우(2006, JASA)

- ^ 장·루(2007년, 바이오메트리카)

- ^ Jiang, Yuan (2016). "Variable selection with prior information for generalized linear models via the prior lasso method". Journal of the American Statistical Association. 111 (513): 355–376. doi:10.1080/01621459.2015.1008363. PMC 4874534. PMID 27217599.

- ^ 제롬 프리드먼, 트레버 헤스티, 로버트 티비라니.2010. "좌표 강하를 통한 일반화된 선형 모델의 정규화 경로"통계 소프트웨어 저널 33(1) : 1-21.https://www.jstatsoft.org/article/view/v033i01/v33i01.pdf.

- ^ a b 에프론, 브래들리, 트레버 헤스티, 이아인 존스톤, 로버트 티비라니.2004. "최저 각도 회귀".통계 연보 제32조 (2)수학통계연구소: 407–51.https://www.jstor.org/stable/3448465.

- ^ a b Hoornweg, Victor (2018). "Chapter 9". Science: Under Submission. Hoornweg Press. ISBN 978-90-829188-0-9.

- ^ Zou, Hui; Hastie, Trevor; Tibshirani, Robert (2007). "On the 'Degrees of Freedom' of the Lasso". The Annals of Statistics. 35 (5): 2173–2792. doi:10.1214/009053607000000127.

- ^ Kaufman, S.; Rosset, S. (2014). "When does more regularization imply fewer degrees of freedom? Sufficient conditions and counterexamples". Biometrika. 101 (4): 771–784. doi:10.1093/biomet/asu034. ISSN 0006-3444.

- ^ Janson, Lucas; Fithian, William; Hastie, Trevor J. (2015). "Effective degrees of freedom: a flawed metaphor". Biometrika. 102 (2): 479–485. doi:10.1093/biomet/asv019. ISSN 0006-3444. PMC 4787623. PMID 26977114.

- ^ Shaonan, Tian; Yu, Yan; Guo, Hui (2015). "Variable selection and corporate bankruptcy forecasts". Journal of Banking & Finance. 52 (1): 89–100. doi:10.1016/j.jbankfin.2014.12.003.

- ^ Coad, Alex; Srhoj, Stjepan (2020). "Catching Gazelles with a Lasso: Big data techniques for the prediction of high-growth firms". Small Business Economics. 55 (1): 541–565. doi:10.1007/s11187-019-00203-3.

표준

표준 스칼라 평균과

스칼라 평균과

, z의 m 성분이 0이 아닌 경우

, z의 m 성분이 0이 아닌 경우

![{\displaystyle s\in [0,1]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/aff1a54fbbee4a2677039524a5139e952fa86eb9)

(평균 0) 중심인 것으로 가정한다.

(평균 0) 중심인 것으로 가정한다.

대각선 원소가

대각선 원소가

해당된다

해당된다

대해 정의된 영역

대해 정의된 영역

![{\displaystyle {\begin{aligned}&\min _{\beta }\left\{{\frac {1}{N}}\sum _{i=1}^{N}\left(y_{i}-x_{i}^{t}\beta \right)^{2}\right\}\\[4pt]&{\text{ subject to }}\sum _{j=1}^{p}|\beta _{j}|\leq t_{1}{\text{ and }}\sum _{j=2}^{p}|\beta _{j}-\beta _{j-1}|\leq t_{2}.\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/a75f99fe3b19232504b470197d1158638ad10255)

0으로 감소함에 따라

0으로 감소함에 따라