표준 RAID 레벨

Standard RAID levels컴퓨터 스토리지에서 표준 RAID 레벨은 스트라이핑, 미러링 또는 패리티 기술을 사용하여 여러 범용 컴퓨터 하드 디스크 드라이브(HDD)에서 신뢰할 수 있는 대용량 데이터스토어를 생성하는 기본 RAID 구성(독립 디스크의 다중 배열 또는 저렴한 디스크의 다중 배열)으로 구성됩니다.가장 일반적인 유형은 RAID 0(스트라이핑), RAID 1(미러링) 및 그 변형, RAID 5(분산 패리티), RAID 6(듀얼 패리티)입니다.RAID 10(미러 스트라이핑) 또는 RAID 01(스트라이프 세트 미러링) 등, 복수의 RAID 레벨을 조합 또는 네스트 할 수도 있습니다.RAID 레벨 및 관련 데이터 형식은 SNIA(Storage Networking Industry Association)에 의해 DDF([1]Common RAID Disk Drive Format) 표준으로 표준화됩니다.수치는 식별자 역할만 하며 성능, 신뢰성, 생성 또는 기타 메트릭을 나타내지 않습니다.

대부분의 RAID 레벨은 하드웨어 장애나 불량 섹터/판독 에러(하드 에러)에 대한 적절한 보호와 복구를 제공할 수 있지만 사용자 에러, 소프트웨어 오작동, 말웨어 감염 등의 치명적인 장애(화재, 물)나 소프트 에러에 의한 데이터 손실에는 대응하지 않습니다.중요한 데이터의 경우, RAID는 대규모 데이터 손실 방지 및 복구 스킴의 하나의 구성 요소일 뿐 백업 계획을 대체할 수는 없습니다.

RAID 0

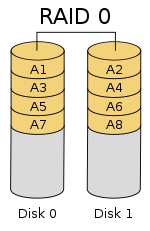

RAID 0(스트라이프 세트 또는 스트라이프 볼륨이라고도 함)은 패리티 정보, 용장성 또는 폴트 톨러런스 없이 데이터를 2개 이상의 디스크에 균등하게 분할("스트라이프")합니다.RAID 0은 폴트 톨러런스나 용장성을 제공하지 않기 때문에, 1대의 드라이브에 장해가 발생했을 경우, 어레이 전체에 장해가 발생합니다.모든 디스크에 데이터가 스트라이핑 되어 있기 때문에, 장해가 발생하면 데이터가 완전하게 손실됩니다.이 설정은,[2][3] 통상은 스피드를 목표로 실장됩니다.RAID 0은 일반적으로 성능을 높이기 위해 사용되지만, 2개 이상의 물리 [4]디스크에서 대규모 논리 볼륨을 생성하는 방법으로도 사용할 수 있습니다.

RAID 0 의 설정은, 사이즈가 다른 디스크를 사용해 작성할 수 있습니다만, 각 디스크에 의해서 어레이에 추가되는 스토리지 용량은, 최소의 디스크 사이즈로 제한됩니다.예를 들어 120GB 디스크가 320GB 디스크와 함께 스트라이핑되는 경우 어레이 크기는 120GB × 2 = 240GB가 됩니다.다만, 일부의 RAID 실장에서는, 나머지 200 GB 를 다른 용도로 사용할 수 있습니다.

이 섹션의 다이어그램은 데이터가 A1을 사용하여 2개의 디스크에서 스트라이프로 분산되는 방법을 보여 줍니다.A2는 첫 번째 스트라이프로서 A3:A4는 두 번째 등입니다.RAID 0 어레이의 작성중에 스트라이프 사이즈가 정의되면, 항상 스트라이프 사이즈를 유지할 필요가 있습니다.스트라이프에 병렬로 액세스하기 때문에 n-드라이브 RAID 0 어레이는 싱글 디스크 레이트의 n배 높은 데이터 레이트를 가진 단일 대형 디스크로 나타납니다.

성능

n개의 드라이브로 구성된 RAID 0 어레이는 개별 드라이브 속도의 최대 n배까지 데이터 읽기 및 쓰기 전송 속도를 제공하지만 데이터의 용장성은 없습니다.그 결과, RAID 0은 주로[5] 과학 컴퓨팅이나 [6]컴퓨터 게임 등, 높은 퍼포먼스를 필요로 하는 애플리케이션이나 신뢰성이 낮은 애플리케이션에 사용됩니다.

데스크탑 애플리케이션의 벤치마크에 따라서는, RAID 0 의 퍼포먼스가 1 [7][8]대의 드라이브보다 약간 우수합니다.또 다른 기사는 이러한 주장을 조사하여 스트라이핑이 항상 성능을 향상시키지는 않지만(특정 상황에서는 실제로는 비 RAID 설정보다 느리지만) 대부분의 상황에서는 상당한 성능 향상을 가져올 것이라고 결론지었다.[9][10]합성 벤치마크는 RAID 0 설정에서 여러 HDD 또는 SSD를 사용할 경우 단일 드라이브 성능과 비교하여 성능 향상 수준이 다르다는 것을 보여줍니다.그러나 일부 합성 벤치마크는 동일한 [11][12]비교에 대한 성능 저하도 보여줍니다.

RAID 1

RAID 1은, 2개 이상의 디스크에 있는 데이터 세트의 정확한 카피(또는 미러)로 구성됩니다.기존의 RAID 1 미러 페어에는 2개의 디스크가 포함됩니다.이 구성에서는 데이터가 어레이에 속하는 모든 디스크에서 미러링되고 어레이의 크기가 최소 멤버 디스크 크기만큼만 가능하므로 여러 디스크에 걸쳐 패리티, 스트라이핑 또는 디스크 공간 스패닝이 제공되지 않습니다.이 레이아웃은 읽기 성능 또는 신뢰성이 쓰기 성능이나 결과 데이터 스토리지 [13][14]용량보다 더 중요한 경우에 유용합니다.

적어도 1개의 멤버 드라이브가 [15]동작하고 있는 한 어레이는 계속 동작합니다.

성능

모든 읽기 요구는 어레이 내의 모든 드라이브에서 처리 및 처리할 수 있습니다.따라서 I/O 부하의 특성에 따라 RAID 1 어레이의 랜덤 읽기 퍼포먼스는 각 멤버의 퍼포먼스 [a]합계와 동등할 수 있으며 쓰기 퍼포먼스는 단일 디스크 수준입니다.다만, RAID 1 어레이로 다른 속도의 디스크를 사용하고 있는 경우, 전체적인 기입 퍼포먼스는 가장 느린 [14][15]디스크의 속도와 같습니다.

합성 벤치마크는 RAID 1 설정에서 여러 HDD 또는 SSD를 사용할 경우 단일 드라이브 성능과 비교하여 다양한 수준의 성능 향상을 보여줍니다.그러나 일부 합성 벤치마크는 동일한 [11][12]비교에 대한 성능 저하도 보여줍니다.

RAID 2

실제로는 거의 사용되지 않는 RAID 2는 데이터를 블록이 아닌 비트 수준에서 스트라이핑하고 오류 수정에 Hamming 코드를 사용합니다.디스크는 컨트롤러에 의해 동기화되어 동일한 각도 방향으로 회전하므로(동시에[16] 인덱스에 도달), 일반적으로 여러 요청을 [17][18]동시에 처리할 수 없습니다.그러나 높은 속도의 Hamming 코드에 따라 많은 스핀들이 병렬로 작동하여 동시에 데이터를 전송하므로 32개의 데이터 비트가 동시에 전송되는 DataVault에서처럼 "매우 높은 데이터 전송 속도"가 가능합니다[19].

모든 하드 디스크 드라이브가 내부 에러 수정을 실장하고 있기 때문에, 외부 Hamming 코드의 복잡성은 패리티에 비해 거의 메리트가 없기 때문에, RAID 2는 거의 실장되어 있지 않습니다.이것은 현재 [17][18]사용되지 않는 유일한 원래의 RAID 레벨입니다.

RAID 3

실제로는 거의 사용되지 않는 RAID 3은 전용 패리티 Disk와 함께 바이트 수준 스트라이핑으로 구성됩니다.RAID 3의 특징 중 하나는 일반적으로 여러 요청을 동시에 처리할 수 없다는 것입니다. 이는 정의상 단일 데이터 블록이 세트의 모든 멤버에 분산되어 각 디스크의 동일한 물리적 위치에 존재하기 때문입니다.따라서 모든 I/O 작업에는 모든 디스크에서 작업이 필요하며 일반적으로 동기화된 스핀들이 필요합니다.

따라서 비압축 비디오 편집과 같이 긴 시퀀셜 읽기 및 쓰기에서 가장 높은 전송 속도를 요구하는 애플리케이션에 적합합니다.랜덤 디스크 위치에서 작은 읽기 및 쓰기를 수행하는 애플리케이션은 이 수준에서 [18]최악의 성능을 얻을 수 있습니다.

모든 디스크가 동기식으로(락스텝으로) 회전해야 한다는 요건은 다른 RAID 레벨에 비해 큰 이점을 제공하지 않는 설계상의 고려사항을 추가했습니다.RAID 3과 RAID 4는 모두 RAID [20]5로 빠르게 대체되었습니다. RAID 3은 보통 하드웨어에 구현되어 있으며 성능 문제는 대용량 디스크 [18]캐시를 사용하여 해결되었습니다.

RAID 4

RAID 4는 전용 패리티 디스크를 사용한 블록 레벨의 스트라이핑으로 구성됩니다.그 결과 RAID 4는 파일 시스템이 RAID-4를 인식하고 이를 보완하지 않는 한 모든 패리티 데이터를 단일 [21]디스크에 써야 하기 때문에 랜덤 읽기 성능은 떨어지지만 우수한 성능을 제공합니다.

RAID 4의 장점은 새로 추가된 디스크가 0바이트로 완전히 채워져 있으면 패리티 재계산 없이 온라인으로 빠르게 확장할 수 있다는 것입니다.

그림 1에서 블록 A1의 읽기 요청은 디스크 0에서 처리됩니다.블록 B1에 대한 동시 읽기 요청은 대기해야 하지만 B2에 대한 읽기 요청은 디스크 1에 의해 동시에 처리될 수 있습니다.

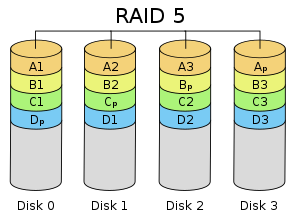

RAID 5

RAID 5는 분산 패리티가 있는 블록 레벨의 스트라이핑으로 구성됩니다.RAID 4와는 달리 패리티 정보는 드라이브 간에 분산됩니다.1개의 드라이브를 제외한 모든 드라이브가 동작해야 합니다.단일 드라이브에 장애가 발생한 경우 데이터가 [5]손실되지 않도록 분산된 패리티에서 후속 읽기를 계산할 수 있습니다.RAID 5 에는,[22] 적어도 3 개의 디스크가 필요합니다.

RAID 5 디스크 드라이브 어레이에는 디스크 [23]전체의 쓰기 순서에 따라 다음과 같은 많은 데이터 레이아웃과 패리티가 있습니다.

- 디스크 어레이에서 왼쪽에서 오른쪽 또는 오른쪽에서 왼쪽으로 기록된 데이터 블록의 순서, 디스크 0에서 N까지의 데이터 블록 및

- 스트라이프 시작 또는 끝의 패리티 블록 위치

- 이전 스트라이프의 패리티에 대한 스트라이프의 첫 번째 블록 위치.

오른쪽 그림은 1) 데이터 블록이 왼쪽에서 오른쪽으로 기록되고 2) 스트라이프 끝에 패리티 블록이 표시되고 3) 다음 스트라이프의 첫 번째 블록이 이전 스트라이프의 패리티 블록과 같은 디스크에 없는 것을 나타내고 있습니다.이 레이아웃은 왼쪽 비동기 RAID 5[23] 레이아웃으로 지정할 수 있습니다.이 레이아웃은 RAID Advisory [25]Board가 발행한 RAID Book의 마지막[24] 에디션에서 식별된 유일한 레이아웃입니다.동기 레이아웃에서는 다음 스트라이프의 데이터 첫 번째 블록이 이전 스트라이프의 패리티 블록과 동일한 드라이브에 기록됩니다.

RAID 4와 비교하여 RAID 5의 분산 패리티는 모든 RAID 멤버 간에 전용 패리티 디스크의 스트레스를 해소합니다.또한 모든 RAID 멤버가 쓰기 요청에 참여하기 때문에 쓰기 성능이 향상됩니다.스트라이핑(RAID 0) 설정만큼 효율적이지는 않지만 패리티는 여전히 기록되어야 하므로 [26]더 이상 병목 현상이 아닙니다.

이후 패리티 계산은 완전한 스트라이프에 위치한 배열에 경험에 작은 변화:최악의 경우에 하나고 논리적인 부문도 쓸 것이 원래 분야가 태만히 함으로써 평가 분야 읽을 원본 데이터가 패리티에서 제거되어야 할 amplification[표창 필요한]를 쓰다 보면 새 데이터를 pa.로 계산되rity고 둘 다새 데이터 섹터와 새 패리티 섹터가 작성됩니다.

RAID 6

RAID 6은 다른 패리티 블록을 추가하여 RAID 5를 확장합니다.따라서 모든 멤버 디스크에 [27]2개의 패리티 블록이 분산된 블록 수준의 스트라이핑을 사용합니다.

RAID 5와 같이 RAID 6 디스크 어레이의 레이아웃은 데이터 블록의 기입 방향, 데이터 블록에 대한 패리티 블록의 위치 및 후속 스트라이프의 첫 번째 데이터 블록이 이전 스트라이프의 마지막 패리티 블록과 동일한 드라이브에 기입되는지 여부에 따라 많이 있습니다.오른쪽에 있는 그림은 이러한 레이아웃 중 하나일 뿐입니다.

SNIA(Storage Networking Industry Association)에 따르면 RAID 6의 정의는 다음과 같습니다.「2개의 디스크 에러가 동시에 발생했을 경우, RAID 어레이의 모든 가상 디스크에 대한 읽기 및 쓰기 요구를 계속 실행할 수 있는 모든 형태의 RAID.듀얼 체크 데이터 계산(패리티 및 리드-Solomon), 직교 듀얼 패리티 체크 데이터 및 대각 패리티를 포함한 여러 방법이 RAID 레벨 [28]6을 구현하기 위해 사용되었습니다."

성능

RAID 6은 읽기 작업에 대한 성능 저하가 없지만 패리티 계산과 관련된 오버헤드로 인해 쓰기 작업에 대한 성능 저하가 있습니다.퍼포먼스는 제조원의 스토리지 아키텍처(소프트웨어, 펌웨어 또는 펌웨어 및 고도의 패리티 계산을 위한 특수 ASIC 사용)에서 RAID 6을 구현하는 방법에 따라 크게 달라집니다.RAID 6 는, RAID 5 와 같은 속도로 읽어낼 수 있습니다.물리 드라이브의 [29]수는 동일합니다.

대각 또는 직교 이중 패리티를 사용하는 경우 쓰기 작업을 위해 두 번째 패리티 계산이 필요합니다.이것에 의해, RAID-6 기입의 CPU 오버헤드가 싱글 패리티 RAID 레벨에 비해 2배로 됩니다.리드 솔로몬 코드를 사용하는 경우 두 번째 패리티 계산이 필요하지 않습니다.리드 솔로몬은 모든 용장 정보를 특정 스트라이프 내에 포함할 수 있다는 장점이 있습니다.

단순화된 패리티 예시

데이터를 \\n개의 분산한다고 가정합니다.당사의 목표는 신드롬으로 알려진 2개의 패리티 P(\와 Q \를 정의함으로써 이들 중 2개가 손실된 경우에도 복원력이 뛰어난 n+(\ n+ 드라이브의 시스템을 하는 것입니다.둘 이상의 독립적 증후군을 생성하려면k > k }의 데이터 청크에 대해 패리티 계산을 수행해야 합니다.실제로 일반적인 선택은 청크 k {\ k입니다. 즉, 바이트당 데이터 스트라이핑하는 것입니다.데이터 의 base-2 표현( D을 0 1. k- 로 . })는 0 또는 1 중 하나입니다.

를 사용하는 경우 단순한 패리티 계산을 사용할 수 있으므로 일반적인 경우 시스템을 사용하는 데 도움이 됩니다.첫 번째 패리티 P \{P의 경우 RAID 5와 같이 스트라이프 전체에 걸친 데이터의 단순 XOR을 계산합니다.이것은 쓰여져 있다

비트 시프트를 해제하여 손실된 D33})를 복구합니다.또한 나머지 데이터로 P \ {P Q {Q의 XOR을 계산하여 2개의 데이터 디스크 장애로부터 복구할 수 있습니다.위의 예에서 0도 손실된 경우,

이 시스템은 더 많은 수의 에 적용되지 됩니다 >k \ n k。그 이유는 시프트 를 k({ k의 청크에 반복 적용하면 원래 위치로 돌아가기 때문입니다.위의 알고리즘을k개의 디스크를 하는 시스템에 하려고 하면두 방정식의 오른쪽은 D 0 s h i f k ( k ) 0 Dk \ style \ D_k})가 .=0}\k 첫 번째 방정식과 동일합니다이렇게 하면 결측값에 대해 풀어야 하는 방정식의 절반만 얻을 수 있습니다.

일반 패리티 시스템

패리티 기능을 보다 신중하게 선택하면 훨씬 더 많은 드라이브를 지원할 수 있습니다.우리가 직면한 문제는 에 걸친 방정식의 시스템이 고유한 해답을 가지도록 하는 것이므로 다항식 이론으로 눈을 돌린다.m ({ m인 갈로아 를 고려합니다.이 필드는 에대한 적절한 kp에 다항식 / () {에 대해 형상화됩니다.데이터는 다음과 같습니다. D k - x - + - k +. .. + +d { D} }+^{ Galois 필드에 입력합니다. ,. ., n - F() { _ , .\ GF가 이러한 방식으로 필드 요소로 인코딩된 하드 드라이브 전체의 데이터 스트라이프에 대응한다고 합니다.필드에서의 추가를 나타낼 때는 을, 곱셈을 나타낼 때는 연결을 사용합니다. {\의 재사용은 의도적인 것입니다.이는 유한 의 덧셈이 XOR 연산자를 나타내기 때문에 두 요소의 합계는 다항식 계수에 대한 XOR 계산과 같기 때문입니다.

필드의 나는 다음과 같이 g{\displaystyle g^{나는}분야의 발전기 요소}각 나는 <non-negative을 위해;입니다 나이 − 1{\displaystyle i<, m-1}. 이 값의 길이가 0~{0\displaystyle}를 제외한 g의 힘을 같이 쓸 수 있는 분야의 각 요소를 의미한다. 한정된 필드{\displaystyle g}guarante은 다르다.기 위해하나 이상의 제너레이터가 있어야 합니다.이러한 g 하나를 선택하고 다음과 같이P {\{Q {\ \ {를 정의합니다.

이전과 같이 첫 번째 P는 각 스트라이프의 XOR에 불과하지만 현재는 다항식으로 해석됩니다. g의 효과는 데이터 [30]청크에 대해 신중하게 선택된 선형 피드백 시프트 레지스터의 작용으로 볼 수 있습니다.부호화가 반복되기 전에 k k회만 할 수 있었던 단순화된 예시와 달리 g{ g를 여러 번 적용하면 m - m의 고유한 반전 함수가 됩니다. 2의 데이터를 지원합니다

1개의 데이터 청크가 손실되면 이전과 같은 상황이 됩니다.두 개의 데이터 청크가 손실된 경우 복구 공식을 대수적으로 계산할 수 있습니다. 및 가 i ij의 손실값이라고 가정하고 D D의 다른 값을 사용하여 A(\ A와B(\ B를 찾습니다.

두 번째 방정식에서 를 풀고 첫 번째 방정식에 연결하면 D ( -i + 1) -1 ( - BA) { j } ( ^ { m - i + } \ ) ( g D_

P와 달리 Q의 계산은 / ( (x)\의 다항식 곱셈을 수반하기 때문에 비교적 CPU를 많이 사용합니다.이는 하드웨어 구현 또는 FPGA를 사용하여 완화할 수 있습니다.

비교

다음 표에 표준 RAID 레벨에 관한 고려사항의 개요를 나타냅니다.어느 경우든 어레이 공간 효율은 드라이브 수 n으로 표현됩니다. 이 표현식은 사용 가능한 드라이브 용량의 합계에 대한 비율을 나타내는 0과 1 사이의 소수 값을 나타냅니다.예를 들어, RAID 3에 3개의 드라이브를 배열하면 어레이 공간 효율성이 1 - 1/n = 1 - 1/3 = 2/3 ≈ 67%가 됩니다. 따라서 이 예에서 각 드라이브의 용량이 250GB이면 어레이의 총 용량은 750GB이지만 데이터 스토리지에 사용할 수 있는 용량은 500GB에 불과합니다.RAID 구성에 따라서는 이른바 데이터 스크러빙 중에 발생한 장애를 검출할 수도 있습니다.

지금까지의 디스크는 신뢰성이 낮아져, RAID 레벨은, 디스크 장해에 가세해 어레이내의 어느 디스크에 장해가 발생하고 있는지를 검출하기 위해서도 사용되었습니다.Patterson 등이 지적한 바와 같이 RAID의 초기 단계에서도 많은 디스크(전부는 아니지만)는 이미 오류 수정 코드를 사용하여 내부 오류를 검색할 수 있었습니다.특히 장애를 검출하기 위한 미러링된 디스크 세트를 갖추는 것으로 충분했지만 오류를 [31]수정하지 않고 디스크 어레이에서 장애가 발생한 디스크를 검출하기에는 2개의 디스크로는 충분치 않았습니다.최신 RAID 어레이는 대부분 디스크 자체의 장애 식별 능력에 의존합니다. 디스크는 스크럽의 일부로 인식될 수 있습니다.중복 정보는 고장 드라이브를 식별하는 대신 누락된 데이터를 재구성하는 데 사용됩니다.복구할 수 없는 읽기 오류가 발생하면 드라이브에 장애가 발생한 것으로 간주됩니다. 이 오류는 드라이브에서 데이터 읽기를 여러 번 재시도했다가 실패한 후에 발생합니다.또한 읽기 요청을 [32]적시에 이행하기 위해 기업용 드라이브는 TLER의 일부로 일반 사용자 드라이브보다 훨씬 적은 시도 횟수로 오류를 보고할 수 있습니다.

| 레벨 | 묘사 | 최소 드라이브[b] 수 | 공간 효율 | 폴트 톨러런스 | 장애 분리 | 읽기 퍼포먼스 | 쓰기 성능 |

|---|---|---|---|---|---|---|---|

| 단일 디스크의 인자로서 | |||||||

| RAID 0 | 패리티 또는 미러링을 사용하지 않는 블록 레벨 스트라이핑 | 2 | 1 | 없음. | 드라이브 펌웨어만 | n | n |

| RAID 1 | 패리티 또는 스트라이핑 없는 미러링 | 2 | 1/n | n - 1 드라이브 장애 | 드라이브 펌웨어 또는 n > 2의 경우 투표 | n[a][15] | 1[c][15] |

| RAID 2 | 오류 수정을 위한 해밍 코드가 있는 비트 레벨 스트라이핑 | 3 | 1 - 1/n2 로그 (n + 1) | 1대의[d] 드라이브에 장해가 발생. | 드라이브 펌웨어 및 패리티 | 경우에 따라 다르지요 | 경우에 따라 다르지요 |

| RAID 3 | 전용 패리티를 사용한 바이트 레벨 스트라이핑 | 3 | 1~1/n | 1대의 드라이브에 장해가 발생. | 드라이브 펌웨어 및 패리티 | n − 1 | n − 1[e] |

| RAID 4 | 전용 패리티를 사용한 블록 레벨 스트라이핑 | 3 | 1~1/n | 1대의 드라이브에 장해가 발생. | 드라이브 펌웨어 및 패리티 | n − 1 | n − 1[e][필요한 건] |

| RAID 5 | 분산 패리티를 사용한 블록 레벨 스트라이핑 | 3 | 1~1/n | 1대의 드라이브에 장해가 발생. | 드라이브 펌웨어 및 패리티 | n[e] | 싱글 섹터: 1/4 풀 스트라이프: n[e][citation needed] - 1 |

| RAID 6 | 이중 분산 패리티를 사용한 블록 레벨 스트라이핑 | 4 | 1 ~ 2/n | 2개의 드라이브 장애 | 드라이브 펌웨어 및 패리티 | n[e] | 싱글 섹터: 1/6 풀 스트라이프: n[e][citation needed] - 2 |

시스템의 영향

단일 SSD, RAID 0, RAID 1, RAID 10 및 RAID 5 등 5개 스토리지 구성의 5개 파일 시스템의 I/O 성능을 측정한 결과, 8개의 SSD가 장착된 RAID 0 및 RAID 5의 F2FS가 각각 EXT4보다 5배, 50배 더 우수한 것으로 나타났습니다.또한 RAID 컨트롤러는 고속 [33]SSD를 탑재한 RAID 시스템을 구축하는 데 있어 중대한 병목현상이 될 수 있습니다.

네스트 RAID

2개 이상의 표준 RAID 레벨의 조합.RAID 0+1 또는 RAID 01, RAID 0+3 또는 RAID 03, RAID 1+0 또는 RAID 10, RAID 5+0 또는 RAID 50, RAID 6+0 또는 RAID 60, RAID 10+0 또는 RAID 100이라고도 합니다.

비표준 변종

표준 RAID 레벨과 중첩 RAID 레벨 외에 비표준 RAID 레벨과 비RAID 드라이브 아키텍처도 있습니다.비 RAID 드라이브 아키텍처는 유사한 용어와 두문자어, 특히 JBOD("디스크 묶음", SPAN/BIG 및 MID("아이돌 디스크의 대량 배열")로 불립니다.

메모들

레퍼런스

- ^ "Common raid Disk Data Format (DDF)". SNIA.org. Storage Networking Industry Association. Retrieved 2013-04-23.

- ^ "RAID 0 Data Recovery". DataRecovery.net. Retrieved 2015-04-30.

- ^ "Understanding RAID". CRU-Inc.com. Retrieved 2015-04-30.

- ^ "How to Combine Multiple Hard Drives Into One Volume for Cheap, High-Capacity Storage". LifeHacker.com. 2013-02-26. Retrieved 2015-04-30.

- ^ a b Chen, Peter; Lee, Edward; Gibson, Garth; Katz, Randy; Patterson, David (1994). "RAID: High-Performance, Reliable Secondary Storage". ACM Computing Surveys. 26 (2): 145–185. CiteSeerX 10.1.1.41.3889. doi:10.1145/176979.176981. S2CID 207178693.

- ^ de Kooter, Sebastiaan (2015-04-13). "Gaming storage shootout 2015: SSD, HDD or RAID 0, which is best?". GamePlayInside.com. Retrieved 2015-09-22.

- ^ "Western Digital's Raptors in RAID-0: Are two drives better than one?". AnandTech.com. AnandTech. July 1, 2004. Retrieved 2007-11-24.

- ^ "Hitachi Deskstar 7K1000: Two Terabyte RAID Redux". AnandTech.com. AnandTech. April 23, 2007. Retrieved 2007-11-24.

- ^ "RAID 0: Hype or blessing?". Tweakers.net. Persgroep Online Services. August 7, 2004. Retrieved 2008-07-23.

- ^ "Does RAID0 Really Increase Disk Performance?". HardwareSecrets.com. November 1, 2006.

- ^ a b Larabel, Michael (2014-10-22). "Btrfs RAID HDD Testing on Ubuntu Linux 14.10". Phoronix. Retrieved 2015-09-19.

- ^ a b Larabel, Michael (2014-10-29). "Btrfs on 4 × Intel SSDs In RAID 0/1/5/6/10". Phoronix. Retrieved 2015-09-19.

- ^ "FreeBSD Handbook: 19.3. RAID 1 – Mirroring". FreeBSD.org. 2014-03-23. Retrieved 2014-06-11.

- ^ a b "Which RAID Level is Right for Me?: RAID 1 (Mirroring)". Adaptec.com. Adaptec. Retrieved 2014-01-02.

- ^ a b c d "Selecting the Best RAID Level: RAID 1 Arrays (Sun StorageTek SAS RAID HBA Installation Guide)". Docs.Oracle.com. Oracle Corporation. 2010-12-23. Retrieved 2014-01-02.

- ^ "RAID 2". Techopedia. Techopedia. Retrieved 11 December 2019.

- ^ a b Vadala, Derek (2003). Managing RAID on Linux. O'Reilly Series (illustrated ed.). O'Reilly. p. 6. ISBN 9781565927308.

- ^ a b c d Marcus, Evan; Stern, Hal (2003). Blueprints for high availability (2, illustrated ed.). John Wiley and Sons. p. 167. ISBN 9780471430261.

- ^ RAID북, 제4판, RAID Advisory Board, 1995년 6월, 페이지 101

- ^ Meyers, Michael; Jernigan, Scott (2003). Mike Meyers' A+ Guide to Managing and Troubleshooting PCs (illustrated ed.). McGraw-Hill Professional. p. 321. ISBN 9780072231465.

- ^ Natarajan, Ramesh (2011-11-21). "RAID 2, RAID 3, RAID 4 and RAID 6 Explained with Diagrams". TheGeekStuff.com. Retrieved 2015-01-02.

- ^ "RAID 5 Data Recovery FAQ". VantageTech.com. Vantage Technologies. Retrieved 2014-07-16.

- ^ a b "RAID Information - Linux RAID-5 Algorithms". Ashford computer Consulting Service. Retrieved February 16, 2021.

- ^ Massigilia, Paul (February 1997). The RAID Book, 6th Edition. RAID Advisory Board. pp. 101–129.

- ^ "Welcome to the RAID Advisory Board". RAID Advisory Board. April 6, 2001. Archived from the original on 2001-04-06. Retrieved February 16, 2021. Wayback Machine}에서 마지막으로 유효한 아카이브된 웹 페이지

- ^ Koren, Israel. "Basic RAID Organizations". ECS.UMass.edu. University of Massachusetts. Retrieved 2014-11-04.

- ^ "Sun StorageTek SAS RAID HBA Installation Guide, Appendix F: Selecting the Best RAID Level: RAID 6 Arrays". Docs.Oracle.com. 2010-12-23. Retrieved 2015-08-27.

- ^ "Dictionary R". SNIA.org. Storage Networking Industry Association. Retrieved 2007-11-24.

- ^ Faith, Rickard E. (13 May 2009). "A Comparison of Software RAID Types".

{{cite journal}}:Cite 저널 요구 사항journal=(도움말) - ^ Anvin, H. Peter (May 21, 2009). "The Mathematics of RAID-6" (PDF). Kernel.org. Linux Kernel Organization. Retrieved November 4, 2009.

- ^ Patterson, David A.; Gibson, Garth; Katz, Randy H. (1988). "A case for redundant arrays of inexpensive disks (RAID)" (PDF). Proceedings of the 1988 ACM SIGMOD International Conference on Management of Data - SIGMOD '88: 112. doi:10.1145/50202.50214. ISBN 0897912683. S2CID 52859427. Retrieved 25 June 2022.

A single parity disk can detect a single error, but to correct an error we need enough check disks to identify the disk with the error. [...] Most check disks in the level 2 RAID are used to determine which disk failed, for only one redundant parity disk is needed to detect an error. These extra disks are truly “redundant” since most disk controllers can already detect If a dusk failed either through special signals provided in the disk interface or the extra checking information at the end of a sector

- ^ "Enterprise vs Desktop Harddrives" (PDF). Intel.com. Intel. p. 10.

- ^ Park, Chanhyun; Lee, Seongjin; Won, Youjip (2014). An Analysis on Empirical Performance of SSD-Based RAID. Information Sciences and Systems. Vol. 2014. pp. 395–405. doi:10.1007/978-3-319-09465-6_41. ISBN 978-3-319-09464-9.

추가 정보

- "Learning About RAID". Support.Dell.com. Dell. 2009. Archived from the original on 2009-02-20. Retrieved 2016-04-15.

- RAID(Redundant Arrays of Inspensive Disks), 운영 체제의 38장: Remzi H. Arpaci-Dusseau와 Andrea C의 Three Easy Pieces 책.아르파시두소

Q

Q

데이터 청크에 대해 패리티 계산을 수행해야 합니다.실제로 일반적인 선택은 청크

데이터 청크에 대해 패리티 계산을 수행해야 합니다.실제로 일반적인 선택은 청크

(가) 실패했습니다.계산 가능

(가) 실패했습니다.계산 가능

손실된 경우,

손실된 경우,

고려합니다.이 필드는

고려합니다.이 필드는 ![{\displaystyle F_{2}[x]/(p(x))}](https://wikimedia.org/api/rest_v1/media/math/render/svg/5a94539f2b3a0114d3e0d1f244a9a4a657b0995d)

대해 형상화됩니다.데이터는 다음과 같습니다.

대해 형상화됩니다.데이터는 다음과 같습니다.

효과는 데이터

효과는 데이터  고유한 반전 함수가

고유한 반전 함수가  데이터를 지원합니다

데이터를 지원합니다

i

i

풀고 첫 번째 방정식에 연결하면 D

풀고 첫 번째 방정식에 연결하면 D