NetApp FAS

NetApp FASNetApp FAS는 ONTAP 운영 체제를 실행하는 NetApp의 컴퓨터 스토리지 제품이며, ONTAP, AFF, ASA, FAS라는 용어는 종종 동의어로 사용된다.공식 명칭은 아니지만 '필러'는 동의어로도 쓰인다.FAS 시스템에는 세 가지 유형이 있으며,하이브리드, All-Flash 및 All-SAN 어레이:

- 하이브리드 Fabric-Attached 스토리지(또는 단순 FAS)[1]라고 하는 HDD 또는 SSD 드라이브를 사용하는 NetApp 전용 맞춤형 구축 하드웨어 어플라이언스

- SSD 드라이브만 있고 대기 시간이 짧은 All-Flash FAS(또는 단순히 AFF)를 위해 최적화된 ONTAP을 갖춘 NetApp 전용 맞춤형 구축 하드웨어 어플라이언스

- 모든 SAN 어레이는 AFF 플랫폼을 기반으로 구축되며 SAN 기반 데이터 프로토콜 연결만 제공

ONTAP은 NFS 및 SMB와 같은 파일 기반 프로토콜을 사용하여 네트워크를 통해 스토리지를 제공할 수 있으며, 파이버 채널 네트워크의 파이버 채널 프로토콜을 통한 SCSI, FCoE(Fibre Channel over Ethernet), iSCSI 및 FC-NVMe 전송 계층과 같은 블록 기반 프로토콜도 사용할 수 있다.Unified ONTAP이라는 SAN 프로토콜과 NAS 프로토콜을 모두 지원할 수 있는 ONTAP 기반 시스템, All-SAN이라는 ASA ID를 가진 AFF 시스템.

ONTAP을 실행하는 NetApp 스토리지 시스템은 대용량 Disk 어레이에 물리적 스토리지를 구현하십시오.

대부분의 대형 스토리지 시스템은 마이크로소프트 윈도우즈 서버, VxWorks 또는 튜닝된 Linux와 같은 운영 체제를 갖춘 범용 컴퓨터로 구현되지만, ONTAP 기반 하드웨어 어플라이언스는 WAFL 파일 시스템을 갖춘 고도로 사용자 지정된 하드웨어와 독점적인 Data ONTAP 운영 체제를 사용하며, 이 모든 것은 NetApp 창립자 David Hitz 및 J에 의해 원래 설계되었다.ames Lau는 특히 스토리지 서비스 용도로 사용됨.ONTAP은 NetApp의 내부 운영 체제로서, 높은 레벨과 낮은 레벨의 스토리지 기능에 특별히 최적화되어 있음그것은 FreeB에서 부팅된다.SD는 독립형 커널 공간 모듈로서, FreeBSD의 일부 기능(예: 명령 인터프리터 및 드라이버 스택)을 사용한다.

모든 NetApp ONTAP 기반 하드웨어 어플라이언스는 배터리 지원 비휘발성 RAM 또는 NVDIMM으로,[citation needed] 휘발성 메모리만 있는 기존 시스템보다 더 빠르게 안정적인 스토리지에 쓰기를 커밋할 수 있는 NVDIMM을 가지고 있다.병렬 SCSI를 통해 외부 디스크 엔클로저에 연결된 초기 스토리지 시스템, 최신 모델(2009년[update] 기준)은 파이버 채널 및 SAS(Serial Attach SCSI) SCSI 전송 프로토콜을 사용한다.디스크 엔클로저(쉘브)는 파이버 채널 하드 디스크 드라이브와 병렬 ATA, 직렬 ATA 및 직렬 연결 SCSI를 사용한다.NVLOG에 더 이상 사용되지 않는 AFF A800 NVRAM PCI 카드를 시작으로 메모리 버스에 직접 연결된 NVDIMM 메모리로 대체되었다.

구현자는 종종 파이버 채널, InfiniBand, 10기가비트 이더넷, 40기가비트 이더넷 또는 100기가비트 이더넷 등 개인 고속 링크를 사용하여 고가용성 클러스터에 두 개의 스토리지 시스템을 구성한다.Data ONTAP 8 운영 체제의 "클러스터 모드"에서 실행할 때 이러한 클러스터를 단일 네임스페이스로 추가로 그룹화할 수 있다.

내부 아키텍처

최신 NetApp FAS, AFF 또는 ASA 시스템은 PCI를 사용하는 Intel 프로세서가 장착된 맞춤형 컴퓨터로 구성된다.각 FAS, AFF 또는 ASA 시스템은 NVRAM이라 불리는 비휘발성 랜덤 액세스 메모리를 독점 PCI NVRAM 어댑터 또는 NVDIMM 기반 메모리의 형태로 갖추고 있어 성능 향상을 위해 모든 쓰기를 기록하고 계획되지 않은 종료 시 데이터 로그를 앞으로 재생한다.두 스토리지 시스템을 클러스터로 함께 연결할 수 있는데, NetApp(2009년 기준)에서는 덜 모호한 용어인 "Active/Active"를 사용한다.

하드웨어

각 스토리지 시스템 모델에는 프로세서, RAM, 비휘발성 메모리의 세트 구성이 함께 제공되며, 사용자는 구매 후 확장할 수 없다.일부 엔트리 포인트 스토리지 컨트롤러를 제외하고 NetApp FAS, ASA 및 AFF 시스템은 일반적으로 추가 네트워크, 테이프 및/또는 Disk 연결을 위해 최소한 하나의 PCIe 기반 슬롯을 사용할 수 있다.2008년 6월 NetApp은 집중적인 랜덤 읽기를 수행하는 워크로드의 성능을 최적화하기 위해 PAM(성능 가속화 모듈)을 발표했다.이 선택적 카드는 PCIe 슬롯에 들어가 디스크와 스토리지 시스템 캐시와 시스템 메모리 사이에 추가 메모리(또는 캐시)를 제공하여 성능을 향상시킨다.

AFF

APP A 시리즈라고도 하는 All-Flash FASUsually, AFF systems based on the same hardware as FAS but first one optimized and works only with SSD drives on the back end while the second one can use HDD and SSD as a cache: for example, AFF A700 & FAS9000, A300 & FAS8200, A200 & FAS2600, A220 & FAS2700 use the same hardware, but AFF systems do not include Flash Cache cards.또한 AFF 시스템은 타사 스토리지 어레이 가상화 기능을 통해 FlexArray를 지원하지 않는다.AFF는 유니파이드 시스템으로 SAN 및 NAS 데이터 프로토콜 연결을 제공할 수 있으며, FAS 시스템의 기존 SAN 및 NAS 프로토콜 외에도 AFF는 32Gbit/s FC 포트가 있는 시스템을 위한 블록 기반 NVMe/FC 프로토콜을 보유하고 있다.AFF & FAS는 동일한 펌웨어 이미지를 사용하며, 최종 사용자에게 거의 모든 눈에 띄는 기능은 스토리지 시스템 모두에서 동일하다.그러나 내부 데이터는 ONTAP에서 다르게 처리되고 처리된다.예를 들어 AFF 시스템은 FAS 시스템과 비교하여 서로 다른 쓰기 할당 알고리즘을 사용한다.AFF 시스템은 더 빠른 기본 SSD 드라이브를 가지고 있기 때문에 ONTAP 시스템의 인라인 데이터 중복제거는 거의 눈에 띄지 않는다([2]저급 시스템에 대한 성능 영향 약 2%).

로서

따라서 ONTAP을 실행하는 모든 SAN 어레이는 AFF 플랫폼에 기반하여 기능 및 기능을 상속받으며, 내부적으로 처리되고 처리된 데이터는 AFF 시스템과 동일하다.다른 모든 ONTAP 기반 하드웨어 및 소프트웨어 플랫폼을 Unified ONTAP이라고 할 수 있으므로 SAN 및 NAS 데이터 프로토콜을 통해 유니파이드 액세스를 제공할 수 있다.ASA 시스템의 ONTAP 아키텍처는 FAS & AFF와 동일하며 변경 사항이 없음AFP 및 FAS 시스템과 동일한 펌웨어 이미지를 사용하는 ASA 시스템ASA는 AFF와 동일하며, 유일한 차이점은 SAN 프로토콜을 통한 네트워크를 통한 스토리지 액세스에 있다. ASA는 블록 장치(LUN 또는 NVMe 네임스페이스)에 대한 대칭 활성/활성 액세스를 제공하는 반면, Unified ONTAP 시스템은 블록 프로토콜에 ALUA 및 ANA를 계속 사용한다.

저장

NetApp은 SATA, Fibre Channel, SAS 또는 SSD 디스크 드라이브를 사용하며, 이 드라이브를 RAID(Redundant Array of Nonsible Disks 또는 Dedundant Array of Independent Disks) 그룹으로 그룹화하여 최대 28개(데이터 Disk 26개 + 패리티 Disk 2개)로 구성한다.SSD 최적화 ONTAP OS가 설치된 SSD 드라이브만 포함된 NetApp FAS 스토리지 시스템(AFF(AFAS(All-Flash FAS)

디스크

FAS, ASA 및 AFF 시스템은 각 포트가 HA 쌍으로 각 컨트롤러에 연결된 2개의 포트가 있는 엔터프라이즈급 HDD 및 SSD(즉, NVMe SSD) 드라이브를 사용하고 있다.HDD 및 SSD 드라이브는 NetApp에서만 구입할 수 있으며 FAS/AFF 플랫폼용 NetApp의 Disk 쉘프에만 설치할 수 있다.물리적 HDD 및 SSD 드라이브, 파티션의 파티션 및 타사 어레이에서 가져온 LUN과 FlexArray 기능을 Disk로 간주함.ONTAP Select & ONTAP Cloud와 같은 SDS 시스템에서는 가상 Disk 또는 ONTAP 내의 RDM과 같은 논리적 블록 스토리지도 Disk로 간주된다.ONTAP을 사용하면 전체 물리적 HDD 또는 SSD 드라이브, LUN 또는 물리적 HDD 또는 SSD 드라이브의 파티션이 될 수 있으므로 일반적인 용어인 "Disk drive"와 "Disk drive permission"을 혼동하지 마십시오.하지 마십시오.HA 쌍 구성의 FlexArray 기능이 있는 타사 어레이에서 가져온 LUN은 HA 쌍의 두 노드에서 모두 액세스할 수 있어야 한다.각 디스크에는 디스크를 소유하고 서비스하는 컨트롤러를 표시하는 소유권이 있다.Aggregate는 단일 노드가 소유한 디스크만 포함할 수 있으므로, FlexVol 볼륨, LUN, 파일 공유가 단일 컨트롤러와 함께 제공되므로 노드 및 그 위에 있는 모든 개체에서 소유한 각 Aggregate를 포함할 수 있다.각 컨트롤러는 자체 Disk를 보유하여 동일한 데이터를 제공하지 않더라도 두 노드를 동시에 활용할 수 있는 Aggregate할 수 있다.

ADP

플랫폼 및 사용 사례에 따라 ONTAP 기반 시스템에서 ADP(Advanced Drive Partitioning)를 사용할 수 있다.ADP는 NetApp Disk 쉘프의 네이티브 Disk 드라이브에서만 사용할 수 있으며, FlexArray 기술은 ADP를 지원하지 않으며, ONTAP Select의 타사 드라이브에서도 지원됨.이 기술은 주로 ONTAP 기반 시스템의 일부 아키텍처 요구사항을 극복하고 Disk 드라이브 수를 줄이는 데 사용되었다.ADP에는 루트 데이터 파티셔닝(Root-Data-Data 파티셔닝(RD2) 스토리지 풀의 세 가지 유형이 있다.루트 데이터 파티셔닝은 FAS & AFF 시스템에서 사용할 수 있으며, 드라이브에 작은 루트 파티션을 생성하여 시스템 루트 Aggregate를 생성하는 데 사용할 수 있으며, 따라서 이러한 목적으로 3개의 Disk 드라이브 전체를 사용하지 마십시오.이와는 대조적으로, 디스크 드라이브의 많은 부분이 데이터 집계에 사용될 것이다.루트 데이터 파티셔닝은 루트 데이터 파티셔닝과 동일한 이유로 AFF 시스템에서만 사용되며, 루트 파티셔닝 후 남은 드라이브의 큰 부분을 두 개의 추가 파티션(보통 각 파티션은 두 개의 컨트롤러 중 하나에 할당됨)으로 균등하게 분할하여 최소 드라이브 수를 줄임AFF 시스템을 필요로 하고 값비싼 SSD 공간을 위한 낭비를 줄여야 한다.FAS 시스템에서 사용되는 스토리지 풀 파티셔닝 기술은 각 SSD 드라이브를 4개씩 균등하게 분할하여 나중에 FlashPool 캐시 가속화에 사용할 수 있으며, 몇 개의 SSD 드라이브만 최대 4개의 데이터 Aggregate로 분할할 수 있으므로 FlashCache 캐슁 기술을 통해 해당 드라이브에 필요한 SSD 드라이브를 최소화할 수 있음종양학

ONTAP의 NetApp RAID

NetApp ONTAP 시스템에서는 RAID와 WAFL이 긴밀하게 통합되어 있다.ONTAP 기반 시스템에는 다음과 같은 몇 가지 RAID 유형을 사용할 수 있는 경우

- RAID 4(전용 패리티 디스크 1개 포함)는 RAID 그룹에서 드라이브 1개만 장애 발생 가능.

- RAID 그룹 내에서 2개의 전용 패리티 Disk가 있는 RAID-DP를 통해 2개의 드라이브가 동시에 고장날 [3]수 있음

- RAID-TEC3개의 전용 패리티 드라이브가 있는 미국 특허 7640484는 RAID 그룹에서 모든 3개의 드라이브가 동시에 고장 나도록 허용한다.[4]

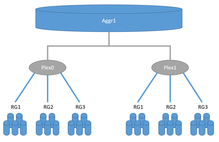

RAID-DP의 이중 패리티는 RAID 6와 유사한 디스크 손실 복원력으로 이어진다. NetApp은 WAFL을 통해 기존 RAID-4 스타일의 전용 패리티 디스크의 쓰기 성능 저하를 극복하고 각 스토리지 시스템 내에서 NVRAM(비휘발성 메모리)을 새로이 사용한다.[5]각 Aggregate는 하나 또는 두 개의 플렉스로 구성되며 플렉스는 하나 이상의 RAID 그룹으로 구성된다.일반적인 ONTAP 기반 스토리지 시스템은 각 Aggregate에 플렉스가 1개뿐이며, 로컬 SyncMirror 또는 MetroCluster 구성에 사용되는 플렉스가 2개뿐입니다.각 RAID 그룹은 대개 동일한 유형, 속도, 기하학 및 용량의 디스크 드라이브로 구성된다.NetApp Support를 사용하면 크기가 동일하거나 더 크고 유형, 속도 및 형상이 다른 RAID 그룹에 임시로 드라이브를 설치할 수 있지만,일반 데이터 Aggregate는 RAID 그룹이 두 개 이상 포함된 경우 Aggregate 전체에서 동일한 RAID 그룹을 가지고 있어야 하며, 동일한 RAID 그룹 크기가 권장되지만 NetApp은 마지막 RAID 그룹에서 예외를 허용하고 Aggregate 전체 RAID 그룹 크기의 절반만큼 작게 구성할 수 있다.예를 들어 이러한 Aggregate는 RG0:16+2, RG1:16+2, RG2:7+2의 3개의 RAID 그룹으로 구성될 수 있다.Aggregate 내에서 ONTAP은 사용자가 액세스할 수 있는 데이터를 저장하기 위해 유연한 볼륨(FlexVol)을 설정하십시오.

Aggregate는 FlshPool로 사용되며 하이브리드 Aggregate라고 하는 HDD 및 SSD 드라이브와 함께 사용 가능.Flash Pool 하이브리드에서는 일반 Aggregate와 마찬가지로 하이브리드 Aggregate에 적용되는 동일한 규칙을 HDD와 SSD 드라이브에 별도로 적용하므로, 두 가지 RAID 유형을 가질 수 있다. 즉, 모든 HDD 드라이브에 대한 RAID 유형과 단일 하이브리드 Aggregate에 있는 모든 SSD 드라이브에 대한 RAID 유형이다.예를 들어 RAID-TEC(RG0:18+3, RG1:18+3)를 사용하는 SAS HDD와 RAID-DP(RG3:6+2)를 사용하는 SSD가 해당된다.ONTAP을 실행하는 NetApp 스토리지 시스템은 RAID 0과 유사한 기본 RAID 그룹을 결합할 수 있으며, 또한 NetApp FAS 시스템의 FlexArray 기능에서는 타사 LUN을 RAID 0과 유사한 Plex로 결합할 수 있다. ONTAP을 실행하는 NetApp 스토리지 시스템을 MetroCluster 및 SyncMirror 구성에 구현할 수 있으며, 이러한 구성에서는 상대적으로 기술을 사용하고 있다.o Aggregate에서 두 플렉스 사이의 미러링 데이터가 포함된 RAID 1

| AFF 및 FAS 시스템의 데이터 Aggregate용 RAID 그룹 크기(드라이브 수) | |||||||||

|---|---|---|---|---|---|---|---|---|---|

| 드라이브 유형 | 최소 | 체납 | 최대 | 최소 | 체납 | 최대 | 최소 | 체납 | 최대 |

| RAID 4 | RAID-DP | RAID-TEC | |||||||

| NVMe SSD | 3 | 8 | 14 | 5 | 24 | 28 | 7 | 25 | 29 |

| SSD | |||||||||

| SAS | 16 | 24 | |||||||

| SATA 또는 NL-SAS < 6TB | 7 | 14 | 20 | 21 | |||||

| SATA 또는 NL-SAS(6TB, 8TB) | 14 | ||||||||

| MSATA(6TB, 8TB) | 불가능 | ||||||||

| MSATA < 6TB | 20 | ||||||||

| MSATA >= 10TB | 불가능 | ||||||||

| SATA 또는 NL-SAS >= 10TB | |||||||||

플래시 풀

NetApp Flash Pool은 하이브리드 NetApp FAS 시스템의 기능으로, 단일 데이터 Aggregate에서 HDD 드라이브 및 SSD 드라이브를 사용한 하이브리드 Aggregate를 생성할 수 있다.HDD와 SSD 드라이브는 모두 별도의 RAID 그룹을 형성한다.SSD는 쓰기 작업에도 사용되었기 때문에 Flash Cache와는 달리 RAID 이중화가 필요하지만 HDD와 SSD에는 서로 다른 RAID 유형을 사용할 수 있다. 예를 들어 RAID-TEC에는 20개의 HDD 8TB, RAID-DP 960GB에는 4개의 SSD를 단일 Aggregate에 저장할 수 있다.SSD가 캐시로 추가된 Aggregate의 FlexVol 볼륨에 대한 읽기-쓰기 작업을 위해 캐시로 사용되는 SSD RAID와 향상된 성능.Flash Cache와 유사하게 Flash Pool 캐시는 읽기 작업을 위한 정책을 가지고 있지만 Aggregate에 위치한 각 FlexVol 볼륨에 개별적으로 적용되는 쓰기 작업을 포함하므로 일부 볼륨에서는 사용하지 않도록 설정할 수 있고 다른 볼륨에서는 SSD 캐시의 이점을 활용할 수 있다.둘 다 FlashCache &, FlashPool 동시에 최소한 4SSD디스크 필요한(2데이터, 1평가 지수와 1 뜨거운 예비)은 플래쉬 풀 기술로 골재 활성화 단일 FlexVol에서 데이터 캐시 하는 데 사용되지만 그것은 또한 4(저장 조)에 상륙했습니다. 그리고 두 컨트롤러 사이에 그 조각들을 SSD를 분할하여에 ADP기술 사용이 가능하다.그렇게각 컨트롤러는 적은 양의 SSD가 있을 때 SSD 캐시의 이점을 누릴 수 있다.Flash Pool은 FlexArray와 함께 사용할 수 없으며 NetApp의 Disk 쉘프에 있는 NetApp FAS 네이티브 Disk 드라이브에서만 사용할 수 있음

FlexArray

FlexArray는 NetApp FAS 기능을 통해 SAN 프로토콜을 통해 타사 스토리지 시스템 및 기타 NetApp 스토리지 시스템을 시각화하고 NetApp의 Disk 쉘프 대신 사용할 수 있도록 지원FlexArray 기능을 사용하면 타사 스토리지 어레이에서 RAID 보호를 수행해야 하므로 NetApp의 RAID 4, RAID-DP 및 RAID-TEC는 이러한 구성에서 사용되지 않는다.타사 어레이의 LUN 하나 이상을 RAID 0과 유사한 단일 Aggregate에 추가할 수 있음. FlexArray는 라이센스 기능임.

NetApp 스토리지 암호화

NSE(NetApp Storage Encryption)는 낮은 수준의 하드웨어 기반 전체 Disk 암호화(FDE/SED) 기능을 갖춘 특수 용도 빌드 Disk를 사용하며, FIPS 인증 자체 암호화 드라이브도 지원하며, 모든 NetApp ONTAP 기능 및 프로토콜과 거의 호환되지만 MetroCluster는 제공하지 않는다.NSE 기능은 전반적으로 스토리지 시스템에 거의 성능에 영향을 주지 않는다.ONTAP을 실행하는 스토리지 시스템의 NetApp NVE(NetApp Volume Encryption)와 유사한 NSE 기능은 암호화 키를 IBM Security Key Lifecycle Manager 및 SafeNet KeySecure와 같은 KMIP 프로토콜을 사용하는 온보드 키 관리자 또는 전용 키 관리자 시스템에 로컬로 저장할 수 있다.NSE는 유휴 데이터 암호화로, 물리적 디스크 도난으로부터만 보호하고 정상적인 운영 및 실행 시스템에서 추가적인 데이터 보안 보호 기능을 제공하지 않는다.NetApp은 ONTAP 9.2와 함께 NetApp 암호화 모듈(TPM)을 위한 NIST 암호화 모듈 검증 프로그램을 통과했다.[6]

메트로클러스터

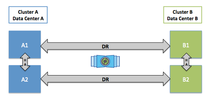

MetroCluster(MC)는 FAS 및 AFF 시스템에서 두 사이트 간의 동기식 복제를 통해 메트로 고가용성을 제공하는 무료 기능이며, 이 구성에는 추가 장비가 필요하다.7-Mode(이전 OS) 및 Cluster-Mode(또는 cDOT - 최신 버전의 ONTAP OS)의 두 가지 모드에서 사용 가능MCC로 알려진 Cluster-Mode의 MetroCluster. MetroCluster는 RAID SyncMirror(RSM) 및 플렉스 기법을 사용하며, 한 사이트 수의 디스크는 플렉스로 집계된 하나 이상의 RAID 그룹을 형성하는 반면, 두 번째 사이트에서는 CRS(Configuration Replication Service) 및 NVLog Replate와 동일한 유형 및 RAID 구성을 가진 디스크 수가 있다.고드름한 플렉스는 비휘발성 메모리가 있는 화합물의 다른 플렉스에 동시에 복제한다.두 개의 플렉스는 하나의 사이트 두 번째 사이트에 저장된 데이터와 재해 발생 시 데이터에 대한 읽기-쓰기 액세스를 제공하는 Aggregate를 형성한다.MetroCluster FlexArray 기술 지원.MetroCluster 구성은 MC가 작동하는 데 필요한 추가 네트워크 카드를 설치할 수 있는 기능을 제공하는 미드레인지 및 하이엔드 모델에서만 가능하다.

MCC

MetroCluster를 사용하면 클러스터 또는 MCC(Cluster MetroCluster)를 구성할 수 있는 사이트당 하나 이상의 스토리지 노드를 보유할 수 있다.원격 및 로컬 HA 퍼터 노드는 동일한 모델이어야 한다.MCC는 각각 두 사이트 중 하나에 위치한 두 개의 클러스터로 구성된다.두 군데만 있을 수 있다.MCC 구성에서 각 원격 및 로컬 스토리지 노드 1개는 두 사이트에 걸쳐 Metro HA 또는 재해 복구 Pare(DR Pare)를 형성하고, 2개의 로컬 노드(파트너가 있는 경우)는 로컬 HA 패어를 형성하므로 각 노드는 비휘발성 메모리에 데이터를 동기적으로 복제하며, 2개의 노드(원격 및 로컬 노드 1개)는 두 개의 노드(있는 경우)가 있다.MCC로 구성된 각 사이트(단일 노드 클러스터 2개)에서 스토리지 노드 1개만 활용할 수 있다. 8 노드 MCC는 각각 4개 노드(2HA 쌍)의 2개 클러스터로 구성되며, 각 스토리지 노드는 원격 파트너 1개 및 로컬 HA 파트너 1개만 구성되며, 이러한 구성에서는 각 사이트 클러스터가 2개의 서로 다른 스토리지 노드 모델로 구성될 수 있다.작은 거리의 경우 MetroCluster는 노드당 최소 하나의 FC-VI 이상의 iWARP 카드를 필요로 한다.ONTAP 소프트웨어 버전 9.2 이상이 탑재된 FAS 및 AFF 시스템은 FC-VI 카드를 활용하며, 장거리의 경우 Disk 쉘프 스택당 전용 파이버 채널 스위치 4개(각 사이트에 2개)와 FC-SAS 브리지 2개가 필요하므로 2개 사이트에 대해 최소 4개, 장거리 DWDM을 사용하는 최소 2개의 다크 파이버 ISL 링크가 필요하다.데이터 볼륨, LUN 및 LIF는 데이터의 출처가 있는 단일 사이트 내에서만 클러스터의 스토리지 노드 간에 온라인 마이그레이션 가능: 사이트에서 클러스터의 전체 클러스터를 사용하지 않도록 설정하고 트라우마하는 MetroCluster 전환 작업을 사용하지 않는 한 사이트 간에 클러스터 기능을 사용하여 개별 볼륨, LUN 또는 LIF를 마이그레이션할 수 없음명백히 그것의 클라이언트와 애플리케이션은 모든 데이터에 대한 접근을 다른 사이트로 전환한다.

MCC-IP

ONTAP 9.3 MCC-IP(MetroCluster over IP)를 시작으로 전용 백엔드 파이버 채널 스위치, FC-SAS 브리지 및 전용 다크 파이버 ISL이 필요 없이 도입되었으며, 이전에는 MetroCluster 구성에 필요했다.초기에는 A700 및 FAS9000 시스템만 MCC-IP를 지원했다. MCC-IP는 4노드 구성, 즉 2노드 고가용성 시스템(총 2개 사이트)에서만 사용할 수 있다.ONTAP 9.4를 통해 MCC-IP는 A800 시스템과 고급 드라이브 파티셔닝을 지원하며, ADPv2라고도 한다.ADPv2는 All-Flash 시스템에서만 지원됨.MCC-IP 구성은 ADPv2로 분할된 SSD 드라이브가 있는 단일 Disk 쉘프를 지원한다.IP를 통한 MetroCluster는 ISL이 설치된 이더넷 클러스터 스위치가 필요하며 동기식 복제를 위해 각 스토리지 컨트롤러에 iWARP 카드를 활용한다.ONTAP 9.5 MCC-IP를 시작으로 최대 700km까지 거리를 지원하고 SVM-DR 기능, AFF A300 및 FAS8200 시스템 지원

운영 체제

Data ONTAP(이전의 Data ONTAP)이라는 독점 OS를 사용하는 NetApp 스토리지 시스템스토리지 시스템에서 운영 체제의 주요 목적은 고객에게 필요한 데이터 프로토콜을 사용하여 무중단 방식으로 데이터를 제공하고 고가용성, 재해 복구 및 데이터 백업과 같은 기능을 통해 부가 가치를 제공하는 것이다.ONTAP OS는 FlexClone, SnapMirror, SnapLock, MetroCluster 등과 같은 엔터프라이즈급 데이터 관리 기능을 제공하며, 대부분의 기능은 스냅샷 기반 WAFL 파일 시스템 기능이다.

WAFL

WAFL은 NetApp의 독점 OS ONTAP에서 강력한 버전 파일 시스템으로서 최종 사용자가 파일 시스템에서 이전 버전의 파일을 볼 수 있도록 스냅샷을 제공한다.스냅샷이 숨겨진 디렉토리에 표시됨~snapshotWindows(SMB) 또는.snapshotUnix(NFS)용.기존 또는 유연한 볼륨에 대해 최대 1024개의 스냅샷을 만들 수 있다.ONTAP은 "WAFL 스냅샷" 기술을 기반으로 "FlexClones"로 쓰기 가능한 "가상 클론"을 만들 수 있는 추가 기능을 제공하지만 스냅샷은 읽기 전용입니다.

ONTAP은 스냅샷 작업 간에 Disk 블록의 변경 사항을 추적하여 스냅샷을 구현함파일 시스템에서 루트 인노드의 복사본만 가져가면 되기 때문에 몇 초 만에 스냅샷을 설정할 수 있다.이는 몇 시간이 걸릴 수 있는 모든 스토리지 블록을 복사해야 하는 일부 다른 스토리지 벤더가 제공하는 스냅샷과는 다르다.

7MTT

Data ONTAP 8을 실행하는 각 NetApp FAS 시스템은 7-Mode 또는 클러스터 모드 간에 전환할 수 있다.실제로 각 모드는 FAS 시스템용 단일 펌웨어 이미지로 출하된 7-Mode와 Cluster-Mode 모두 7-Mode가 더 이상 사용되지 않는 8.3까지 자체 버전의 WAFL을 갖춘 별도의 OS였다.이제 전환 툴에서 7-Mode에서 ONTAP 9로의 SnapLock 마이그레이션이 지원됨FAS 시스템에서는 모드 전환이 가능하지만 WAFL이 호환되지 않고 기존 7-Mode FAS 시스템에서 새로운 Cluster-Mode로 데이터를 마이그레이션하기 위해 7MTT 툴이라는 서버 기반 애플리케이션이 도입되었기 때문에 Disk의 모든 데이터를 먼저 폐기해야 한다.

- SnapMirror 기반 복제(Copy-based transition)를 통해 스토리지 벤더 기능만 사용하여 계획된 다운타임으로 모든 데이터를 마이그레이션할 수 있음복사 기반 전환에는 모든 데이터를 마이그레이션할 경우 소스 시스템보다 더 작은 공간을 가진 새로운 컨트롤러와 디스크가 필요하다.SAN과 NAS 데이터 모두 가능하다.

- 7-Mode 8.2.1과 Cluster-Mode 8.3.2 WAFL 호환성을 시작으로, 7-Mode를 실행하는 기존 컨트롤러를 Cluster-Mode 및 계획된 다운타임으로 교체하는 복사 없는 전환이라는 7MTT 도구에 도입되었으며, 새로운 시스템에는 새로운 컨트롤러를 위한 루트 Aggregate가 있는 추가 시스템 Disk가 필요함(이것은 b일 수 있음)e 6개 이하의 디스크).무복사 전환의 경우 데이터 복사가 필요 없기 때문에 새로운 컨트롤러 재구성에만 도움이 되는 7MTT 툴이 필요 없다.SAN 및 NAS 데이터 변환 모두 지원됨

7MTT 이외에도 프로토콜 유형에 따라 데이터를 마이그레이션하는 두 가지 경로가 있다.

- NetApp FAS 시스템에 통합된 외부 LUN 가져오기(FLI) 기능을 통해 SAN 프로토콜을 통해 데이터를 복사할 수 있으며, ONTAP을 실행하는 새로운 스토리지 시스템은 호스트 재구성 및 최소 다운타임이 필요한 기존 스토리지 시스템 간에 SAN 프록시로 배치되어 SAN 데이터를 복사할 수 있음FIL은 이전 7-Mode 시스템과 일부 경쟁사 스토리지 시스템 모델에 대해 사용 가능하다.

- NetApp XCP의 무료 호스트 기반 유틸리티를 통해 NAS 데이터를 복사할 수 있으므로, 새로운 NAS 서버를 위한 클라이언트 시스템 재구성을 위한 다운타임을 최소화하면서 SMB 또는 NFS 프로토콜을 사용하는 소스 서버에서 ONTAP 시스템으로 데이터를 복사하는 모든 유틸리티를 사용하여 호스트 기반 복사 프로세스를 처리할 수 있다.

이전 제한 사항

ONTAP 8이 출시되기 전에 개별 Aggregate 크기는 FAS250 모델의 경우 최대 2TB로 제한되었고 다른 모든 모델의 경우 16TB로 제한되었다.

디스크 드라이브의 밀도 증가와 함께 Aggregate 크기에 대한 제한은 전체 시스템의 성능을 제한하는 데 기여했다.NetApp은 대부분의 스토리지 벤더와 마찬가지로 디스크 쓰기를 여러 스핀들(디스크 드라이브)에 병렬화하여 전체 시스템 성능을 향상시킴따라서 대용량 드라이브로 단일 Aggregate에 추가할 수 있는 스핀들 수를 제한하고, 따라서 Aggregate 성능을 제한하십시오.

또한 각 Aggregate는 Disk 유형에 따라 약 7-11%의 스토리지 용량 오버헤드를 발생시킨다.Aggregate가 많은 시스템에서는 스토리지 용량이 손실될 수 있다.

그러나 오버헤드는 NTFS 또는 EXT3와 같은 파일 시스템의 오버헤드와 유사한 일반적인 파일 시스템 오버헤드와 디스크 레벨의 추가 블록 체크섬으로 인해 발생한다.블록 체크섬은 디스크 드라이브 수준에서 데이터 오류가 데이터 손실을 초래하지 않도록 하는 데 도움이 된다.

Data ONTAP 8.0은 새로운 64비트 Aggregate 형식을 사용하므로 FlexVolume의 크기 제한이 약 100TB(스토리지 플랫폼에 따라 다름)로 증가하고 최신 모델(스토리지 플랫폼에 따라 다름)에서는 Aggregate의 크기 제한이 100TB 이상으로 증가하므로 성능 향상을 위해 대규모 스핀들 수를 구성할 수 있는 기능이 복원됨스토리지 효율성.([1])

퍼포먼스

AI 성능 테스트(이미지 왜곡 비활성화):

| AI | 레스넷-50 | 레스넷-152 | ||||||

|---|---|---|---|---|---|---|---|---|

| 4 GPU | 8 GPU | 16 GPU | 32 GPU | 4 GPU | 8 GPU | 16 GPU | 32 GPU | |

| NetApp A700 Nvidia | 1131 | 2048 | 4870 | |||||

| NetApp A800 Nvidia | 6000 | 11200 | 22500 | |||||

| AI | 알렉스넷 | |||

|---|---|---|---|---|

| 4 GPU | 8 GPU | 16 GPU | 32 GPU | |

| NetApp A700 Nvidia | 4243 | 4929 | ||

| NetApp A800 Nvidia | ||||

모델 이력

이 목록은 일부 모델을 생략할 수 있다.spec.org, netapp.com 및 storageperformance.org에서 가져온 정보

| 모델 | 상태 | 방출된 | CPU | 주 시스템 메모리 | 비휘발성 메모리 | 원시용량 | 벤치마크 | 결과 |

|---|---|---|---|---|---|---|---|---|

| FASSERV | 중단됨 | 1993 - 01 | 50MHz Intel i486 | ?MB | 4MB | 14 GB | ? | |

| FASSERV | 중단됨 | 1994 - 01 | 50MHz Intel i486 | ?MB | 4MB | 14 GB | ? | |

| 파서버 1300 | 중단됨 | 1994 - 01 | 50MHz Intel i486 | ?MB | 4MB | 14 GB | ? | |

| FASSERVER 1400 | 중단됨 | 1994 - 01 | 50MHz Intel i486 | ?MB | 4MB | 14 GB | ? | |

| 파서버 | 중단됨 | 1995 - 01 | 50MHz Intel i486 | 256MB | 4MB | ? GB | 640 | |

| F330 | 중단됨 | 1995 - 09 | 90MHz 인텔 펜티엄 | 256MB | 8MB | 117 GB | 1310 | |

| F220 | 중단됨 | 1996 - 02 | 75MHz 인텔 펜티엄 | 256MB | 8MB | ? GB | 754 | |

| F540 | 중단됨 | 1996 - 06 | 275 MHz DEC 알파 21064A을 | 256MB | 8MB | ? GB | 2230 | |

| F210 | 중단됨 | 1997 - 05 | 75MHz 인텔 펜티엄 | 256MB | 8MB | ? GB | 1113 | |

| F230 | 중단됨 | 1997 - 05 | 90MHz 인텔 펜티엄 | 256MB | 8MB | ? GB | 1610 | |

| F520 | 중단됨 | 1997 - 05 | 275 MHz DEC 알파 21064a | 256MB | 8MB | ? GB | 2361 | |

| F630 | 중단됨 | 1997 - 06 | 500MHz DEC 알파 21164a | 512MB | 32MB | 464 GB | 4328 | |

| F720 | 중단됨 | 1998 - 08 | 400MHz DEC 알파 21164a | 256MB | 8MB | 464 GB | 2691 | |

| F740 | 중단됨 | 1998 - 08 | 400MHz DEC 알파 21164a | 512MB | 32MB | 928 GB | 5095 | |

| F760 | 중단됨 | 1998 - 08 | 600MHz DEC 알파 21164a | 1GB | 32MB | 1.39TB | 7750 | |

| F85 | 중단됨 | 2001 - 02 | 256MB | 64MB | 648 GB | |||

| F87 | 중단됨 | 2001 - 12 | 1.13GHz Intel P3 | 256MB | 64MB | 576 GB | ||

| F810 | 중단됨 | 2001 - 12 | 733MHz 인텔 P3 코퍼민 | 512MB | 128MB | 1.5TB | 4967 | |

| F820 | 중단됨 | 2000 - 12 | 733MHz 인텔 P3 코퍼민 | 1GB | 128MB | 3TB | 8350 | |

| F825 | 중단됨 | 2002 - 08 | 733MHz 인텔 P3 코퍼민 | 1GB | 128MB | 3TB | 8062 | |

| F840 | 중단됨 | 2000 - 8월/12월? | 733MHz 인텔 P3 코퍼민 | 3GB | 128MB | 6TB | 11873 | |

| F880 | 중단됨 | 2001 - 07 | 듀얼 733MHz Intel P3 카퍼민 | 3GB | 128MB | 9TB | 17531 | |

| FAS920 | 중단됨 | 2004 - 05 | 2.0GHz Intel P4 Xeon | 2GB | 256MB | 7TB | 13460 | |

| FAS940 | 중단됨 | 2002 - 08 | 1.8GHz Intel P4 Xeon | 3GB | 256MB | 14TB | 17419 | |

| FAS960 | 중단됨 | 2002 - 08 | 듀얼 2.2GHz Intel P4 Xeon | 6GB | 256MB | 28TB | 25135 | |

| FAS980 | 중단됨 | 2004 - 01 | 듀얼 2.8GHz Intel P4 Xeon MP 2MB L3 | 8GB | 512MB | 50TB | 36036 | |

| FAS250 | EOA 11/08 | 2004 - 01 | 600MHz Broadcom BCM1250 듀얼 코어 MIPS | 512MB | 64MB | 4TB | ||

| FAS270 | EOA 11/08 | 2004 - 01 | 650MHz Broadcom BCM1250 듀얼 코어 MIPS | 1GB | 128MB | 16TB | 13620* | |

| FAS2020 | EOA 8/12 | 2007 - 06 | 2.2GHz 모바일 셀러론 | 1GB | 128MB | 68TB | ||

| FAS2040 | EOA 8/12 | 2009 - 09 | 1.66GHz Intel Xeon | 4 GB | 512MB | 136TB | ||

| FAS2050 | EOA 5/11 | 2007 - 06 | 2.2GHz 모바일 셀러론 | 2GB | 256MB | 104TB | 20027* | |

| FAS2220 | EOA 3/15 | 2012 - 06 | 1.73GHz 듀얼 코어 Intel Atom C3528 | 6GB | 768MB | 180TB | ||

| FAS2240 | EOA 3/15 | 2011 - 11 | 1.73GHz 듀얼 코어 Intel Atom C3528 | 6GB | 768MB | 432TB | 38000 | |

| FAS2520 | EOA 12/17 | 2014 - 06 | 1.73GHz 듀얼 코어 Intel Atom C3528 | 36 GB | 4 GB | 840TB | ||

| FAS2552 | EOA 12/17 | 2014 - 06 | 1.73GHz 듀얼 코어 Intel Atom C3528 | 36 GB | 4 GB | 1243TB | ||

| FAS2554 | EOA 12/17 | 2014 - 06 | 1.73GHz 듀얼 코어 Intel Atom C3528 | 36 GB | 4 GB | 1440 TB | ||

| FAS2620 | 2016 - 11 | 1 x 6-코어 Intel Xeon D-1528 @ 1.90GHz | 64GB(HA당) | 8GB | 1440 TB | |||

| FAS2650 | 2016 - 11 | 1 x 6-코어 Intel Xeon D-1528 @ 1.90GHz | 64GB(HA당) | 8GB | 1243TB | |||

| FAS2720 | 2018 - 05 | 1 x 12 코어 1.50GHz Xeon D-1557 | 64GB(HA당) | 8GB | ||||

| FAS2750 | 2018 - 05 | 1 x 12 코어 1.50GHz Xeon D-1557 | 64GB(HA당) | 8GB | ||||

| FAS3020 | EOA 4/09 | 2005 - 05 | 2.8GHz Intel Xeon | 2GB | 512MB | 84TB | 34089* | |

| FAS3040 | EOA 4/09 | 2007 - 02 | 듀얼 2.4GHz AMD Opteron 250 | 4 GB | 512MB | 336TB | 60038* | |

| FAS3050 | 중단됨 | 2005 - 05 | 듀얼 2.8GHz Intel Xeon | 4 GB | 512MB | 168TB | 47927* | |

| FAS3070 | EOA 4/09 | 2006 - 11 | 듀얼 1.8GHz AMD 듀얼 코어 Opteron | 8GB | 512MB | 504TB | 85615* | |

| FAS3140 | EOA 2/12 | 2008 - 06 | 싱글 2.4GHz AMD Opteron 듀얼 코어 2216 | 4 GB | 512MB | 420TB | SFS2008 | 40109* |

| FAS3160 | EOA 2/12 | 듀얼 2.6GHz AMD Opteron 듀얼 코어 2218 | 8GB | 2GB | 672TB | SFS2008 | 60409* | |

| FAS3170 | EOA 2/12 | 2008 - 06 | 듀얼 2.6GHz AMD Opteron 듀얼 코어 2218 | 16 GB | 2GB | 840TB | SFS97_R1 | 137306* |

| FAS3210 | EOA 11/13 | 2010 - 11 | 단일 2.3GHz Intel Xeon(tm) 프로세서(E5220) | 8GB | 2GB | 480TB | SFS2008 | 64292 |

| FAS3220 | EOA 12/14 | 2012 - 11 | 단일 2.3GHz Intel Xeon(tm) 쿼드 프로세서(L5410) | 12 GB | 3.2GB | 1.44PB | ?? | ?? |

| FAS3240 | EOA 11/13 | 2010 - 11 | 듀얼 2.33GHz Intel Xeon(tm) 쿼드 프로세서(L5410) | 16 GB | 2GB | 1.20PB | ?? | ?? |

| FAS3250 | EOA 12/14 | 2012 - 11 | 듀얼 2.33GHz Intel Xeon(tm) 쿼드 프로세서(L5410) | 40 GB | 4 GB | 2.16PB | SFS2008 | 100922 |

| FAS3270 | EOA 11/13 | 2010 - 11 | 이중 3.0GHz Intel Xeon(tm) 프로세서(E5240) | 40 GB | 4 GB | 1.92PB | SFS2008 | 101183 |

| FAS6030 | EOA 6/09 | 2006 - 03 | 듀얼 2.6GHz AMD Opteron | 32GB | 512MB | 840TB | SFS97_R1 | 100295* |

| FAS6040 | EOA 3/12 | 2007 - 12 | 2.6 GHz AMD 듀얼 코어 Opteron | 16 GB | 512MB | 840TB | ||

| FAS6070 | EOA 6/09 | 2006 - 03 | 쿼드 2.6GHz AMD Opteron | 64GB | 2GB | 1.008PB | 136048* | |

| FAS6080 | EOA 3/12 | 2007 - 12 | 2 x 2.6GHz AMD 듀얼 코어 Opteron 280 | 64GB | 4 GB | 1.176PB | SFS2008 | 120011* |

| FAS6210 | EOA 11/13 | 2010 - 11 | 2 x 2.27GHz Intel Xeon(tm) 프로세서 E5520 | 48 GB | 8GB | 2.40PB | ||

| FAS6220 | EOA 3/15 | 2013 - 02 | 2 x 64비트 4코어 Intel Xeon(tm) 프로세서 E5520 | 96 GB | 8GB | 4.80PB | ||

| FAS6240 | EOA 11/13 | 2010 - 11 | 2 x 2.53GHz Intel Xeon(tm) 프로세서 E5540 | 96 GB | 8GB | 2.88PB | SFS2008 | 190675 |

| FAS6250 | EOA 3/15 | 2013 - 02 | 2 x 64비트 4코어 | 144 GB | 8GB | 5.76PB | ||

| FAS6280 | EOA 11/13 | 2010 - 11 | 2 x 2.93GHz Intel Xeon(tm) 프로세서 X5670 | 192 GB | 8GB | 2.88PB | ||

| FAS6290 | EOA 3/15 | 2013 - 02 | 2 x 2.93GHz Intel Xeon(tm) 프로세서 X5670 | 192 GB | 8GB | 5.76PB | ||

| FAS8020 | EOA 12/17 | 2014 - 03 | Intel Xeon CPU E5-2620 1 x 2.00GHz | 48 GB | 8GB | 1.92PB | SFS2008 | 110281 |

| FAS8040 | EOA 12/17 | 2014 - 03 | 1 x 64비트 8코어 2.10GHz E5-2658 | 64GB | 16 GB | 2.88PB | ||

| FAS8060 | EOA 12/17 | 2014 - 03 | 2 x 64비트 8코어 2.10GHz E5-2658 | 128 GB | 16 GB | 4.80PB | ||

| FAS8080EX | EOA 12/17 | 2014 - 06 | 2 x 64비트 10 코어 2.80GHz E5-2680 v2 | 256 GB | 32GB | 8.64PB | SPC-1 IOPS | 685,281.71* |

| FAS8200 | 2016 - 11 | 1 x 16 코어 1.70 GHz D-1587 | 128 GB | 16 GB | 4.80PB | SPEC SFS2014_swbuild | 4130 Mbit/s / 260 020 IOPS @2.7ms(ORT = 1.04ms) | |

| FAS9000 | 2016 - 11 | 2 x 18 코어 2.30GHz E5-2697 v4 | 512GB | 64GB | 14.4PB | |||

| AFF8040 | EOA 10/17 | 2014 - 03 | 1 x 64비트 8코어 2.10GHz E5-2658 | 64GB | 16 GB | |||

| AFF8060 | EOA 11/16 | 2014 - 03 | 2 x 64비트 8코어 2.10GHz E5-2658 | 128 GB | 16 GB | |||

| AF8080 | EOA 10/17 | 2014 - 06 | 2 x 64비트 10 코어 2.80GHz E5-2680 v2 | 256 GB | 32GB | |||

| AFF A200 | 2017 | 1 x 6-코어 Intel Xeon D-1528 @ 1.90GHz | 64GB | 16 GB | ||||

| AFF A220 | 2018 - 05 | 1 x 12 코어 1.50GHz Xeon D-1557 | 64GB | 16 GB | ||||

| AFF A300 | 2016 | 1 x 16 코어 Intel Xeon D-1587 @ 1.70GHz | 128 GB | 16 GB | ||||

| AFF A400 | 2019 | 2 x 10 코어 Intel Xeon Silver 4210 2.2GHz | 144 GB | |||||

| APP A700 | 2016 | 2 x 18 코어 2.30GHz E5-2697 v4 | 512GB | 64GB | ||||

| AFF A700스 | 2017 | 2 x 18 코어 2.30GHz E5-2697 v4 | 512GB | 32GB | SPC-1 | 2 400 059 IOPS @0.69ms | ||

| AFF A800 | 2018 - 05 | 2 x 24 코어 2.10 GHz 8160 스카이레이크 | 640 GB | 32GB | SPC-1 v3.6 SPEC SFS2014 swbuild (3) SPEC SFS®2014_swbuild 결과 | 2 401 171 IOPS @0.59ms with FC protocol; 2200 builds @ 0.73ms with 14227 MBytes/sec on 4-node cluster & FlexGroup; 4200 builds @ 0.78ms with 27165 MBytes/sec on 8-node cluster & FlexGroup; 6200 builds @ 2.829ms with 40117 MBytes/sec on NetApp 12-node AFF A800 with FlexGroup | ||

| 모델 | 상태 | 방출된 | CPU | 주 시스템 메모리 | 비휘발성 메모리 | 원시용량 | 벤치마크 | 결과 |

EOA = 가용성 끝

"*"를 사용하는 SPECsfs는 클러스터된 결과임.수행된 SPECsfs93, SPECsfs97, SPECsfs97_R1 및 SPECsfs2008을 포함한다.다른 벤치마크 버전의 결과는 비교가 안 된다.

참고 항목

- 네트워크 연결 스토리지

- NetApp

- NetApp 스토리지 시스템에서 사용되는 ONTAP 운영 시스템

- NetApp 스토리지 시스템에 사용되는 WAFL(Write Anywhere File Layout)

참조

- ^ Nabrzyski, Jarek; Schopf, Jennifer M.; Węglarz, Jan (2004). Grid Resource Management: State of the Art and Future Trends. Springer. p. 342. ISBN 978-1-4020-7575-9. Retrieved 11 June 2012.

- ^ Brian Beeler (31 January 2018). "NetApp AFF A200 VMmark 3 Results Published". Storage Review. Archived from the original on 2018-06-02. Retrieved 1 June 2018.

- ^ Jay White; Chris Lueth; Jonathan Bell (1 March 2013). "TR-3298. RAID-DP: NetApp Implementation of Double - Parity RAID for Data Protection" (PDF). NetApp. Archived from the original (PDF) on 2018-01-29. Retrieved 29 January 2018.

- ^ Peter Corbett; Atul Goel. "RAID Triple Parity" (PDF). NetApp. Archived from the original (PDF) on 2015-09-27. Retrieved 29 January 2018.

- ^ Jay White; Carlos Alvarez (11 October 2013). "Back to Basics: RAID-DP". NetApp. Archived from the original on 2017-06-19. Retrieved 24 January 2018.

- ^ "Cryptographic Module Validation Program". Computer Security Resource Center (CSRC). NIST. 4 December 2017. Archived from the original on 2018-12-14. Retrieved 14 December 2018.