마르코프 체인의 예

Examples of Markov chains이 글에는 마르코프 체인과 마르코프 프로세스 실행의 예가 수록되어 있다.

모든 예는 셀 수 있는 상태 공간에 있다.일반 상태 공간의 마르코프 체인에 대한 개요는 측정 가능한 상태 공간의 마르코프 체인을 참조하십시오.

이산 시간

주사위를 가지고 하는 보드게임

뱀과 사다리, 또는 주사위에 의해 전적으로 동작이 결정되는 다른 게임은 실제로 마코프 사슬로서 흡수되는 마르코프 사슬이다.과거 움직임에 대한 '기억'을 나타내는 블랙잭 등 카드게임과는 대조적이다.차이를 보려면 게임에서 특정 이벤트의 확률을 고려하십시오.위에서 언급한 주사위 게임에서 유일하게 중요한 것은 현판의 현황이다.다음 판의 상태는 현재 상태와 다음 주사위 굴림에 따라 달라진다.상황이 어떻게 현재 상태로 변했느냐에 따라 달라지지 않는다.블랙잭과 같은 게임에서 플레이어는 어떤 카드가 이미 보여졌는지(따라서 어떤 카드가 더 이상 갑판에 있지 않은지를 기억함으로써 이점을 얻을 수 있기 때문에 게임의 다음 상태(또는 손)는 과거 상태와 독립적이지 않다.

무작위 워크 마르코프 체인

중앙 편향 랜덤워크

각 단계에서 위치(x라 함)가 확률로 +1(오른쪽) 또는 -1(왼쪽)만큼 변경될 수 있는 숫자 라인에서 무작위 이동을 고려하십시오.

(여기서 c는 0보다 큰 상수)

For example, if the constant, c, equals 1, the probabilities of a move to the left at positions x = −2,−1,0,1,2 are given by respectively.무작위 보행은 c가 증가할수록 약해지는 센터링 효과를 가진다.

확률은 현재 위치(x의 값)에만 의존하고 어떤 이전 위치에도 의존하지 않기 때문에, 이 편향된 무작위 걷기는 마르코프 체인의 정의를 만족시킨다.

도박

여러분이 10달러부터 시작해서, 끝이 없고, 공정하고, 동전을 무한정 던지거나, 돈을 전부 잃을 때까지 1달러를 걸었다고 가정해보자. 이(가) n 토스 이후의 달러 수를 경우 X = 시퀀스 {X 은 마르코프 과정이다.만약 당신이 지금 12달러를 가지고 있다는 것을 안다면, 다음번 동전 던지기 후에 11달러 또는 13달러가 주어질 것으로 예상된다.이 추측은 당신이 10달러로 시작해서 11달러로, 10달러로, 11달러로, 그리고 12달러로 올랐다는 추가 지식으로는 개선되지 않는다.이전 투구의 지식으로 추측이 개선되지 않는다는 사실은 마코프 속성을 보여준다. 마코프 재산은 확률적인 과정의 기억력이 없다.[1][2]

심플한 날씨 모델

전날의 날씨를 고려할 때, 기후 조건의 확률은 전환 행렬로 나타낼 수 있다.[3]

매트릭스 P는 맑은 날이 또 다른 맑은 날이 될 가능성이 90%이고, 비가 오는 날은 또 다른 비가 오는 날이 될 가능성이 50%인 날씨 모델을 나타낸다.[3]열은 "햇볕"과 "비"라고 라벨을 붙일 수 있으며, 행은 같은 순서로 라벨을 붙일 수 있다.

(P)i j는 주어진 날이 i형일 경우 j형일 확률이다.

P의 행은 1에 해당한다는 점에 유의하십시오. P는 확률적 행렬이기 때문이다.[3]

일기예보

0일(오늘) 날씨는 화창하다고 한다.이는 "햇볕" 항목이 100%이고 "비" 항목이 0%인 초기 상태 벡터로 표현된다.

1일차(내일)의 날씨는 0일차부터 상태 벡터에 전환 행렬을 곱하여 예측할 수 있다.

따라서, 첫날도 화창할 확률이 90%이다.

2일차(모레)의 날씨도 우리가 1일차 계산한 상태 벡터로부터 같은 방법으로 예측할 수 있다.

또는

n일의 일반 규칙은 다음과 같다.

안정된 기상 상태

이 예에서, 더 먼 날의 날씨에 대한 예측은 그 뒤의 날마다 점점 더 적게 변화하며, 안정된 상태 벡터로 향하는 경향이 있다.[4]이 벡터는 하루 종일 맑은 날씨와 비가 올 확률을 나타내며, 초기 날씨와는 독립적이다.[4]

안정 상태 벡터는 다음과 같이 정의된다.

그러나 P가 정규 전환 행렬인 경우에만(즉, 모든 0이 아닌 항목이 있는 P가n 적어도 하나 이상 있는 경우) 엄격히 양의 벡터로 수렴한다.

q는 초기 조건과는 독립적이므로 P에 의해 변형될 때는 변하지 않아야 한다.[4]이것은 그것을 고유값 1을 가진 고유 벡터로 만들고, P로부터 파생될 수 있다는 것을 의미한다.[4]

비전문가의 관점에서, 정상상태 벡터는 우리가 그것을 P로 곱하면 정확히 같은 벡터를 다시 얻는 벡터다.[5]날씨 예에서는 이것을 사용하여 행렬 방정식을 설정할 수 있다.

그리고 그들이 확률 벡터이기 때문에 우리는 그것을 안다.

이 쌍의 동시 방정식을 풀면 안정 상태 벡터가 된다.

결론적으로, 장기적으로는 약 83.3%의 날이 맑다.모든 마르코프 과정이 안정된 상태 벡터를 가지고 있는 것은 아니라는 것을 깨닫는 것이 중요하다.특히 전환 행렬은 규칙적이어야 한다.그렇지 않으면 상태 벡터는 수렴하지 않고 시간이 지남에 따라 진동할 것이다.

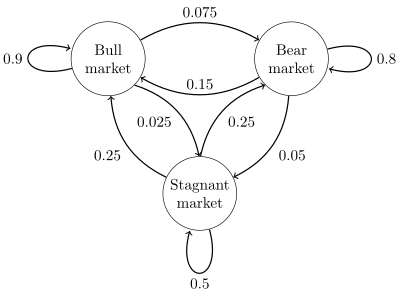

주식시장

간단한 예에 대한 상태 다이어그램이 오른쪽 그림에 나타나 있으며, 상태 전환을 그림으로 표시한다.주들은 가상의 주식시장이 특정 주간에 강세장, 약세장 또는 침체된 시장 추세를 보이고 있는지 여부를 나타낸다.그 수치에 따르면 소주간은 90%, 곰주간은 7.5%, 정체주간은 2.5% 순이다.상태 공간에 {1 = 황소, 2 = 곰, 3 = 정체} 레이블 지정 이 예제의 전환 매트릭스:

상태 위의 분포는 x(n + 1) = xP(n) 관계와 함께 확률형 행 벡터 x로 기록할 수 있다.따라서 시간 n에 시스템이 상태 x에(n) 있는 경우, 그 후 세 시간 후에 시간 n + 3에 분포가

특히, 시간 n에 시스템이 상태 2(베어)에 있는 경우, 시간 n + 3에 분포가 있다.

예를 들어 시장이 침체된 주간의 장기적 부분이나 침체된 시장에서 강세로 가는 데 걸리는 평균 주수를 전환 매트릭스를 이용하여 계산할 수 있다.전환 확률을 이용하여 정상 상태 확률은 다음과 같은 이유로 주 62.5%, 주 31.25%, 주 6.25%가 약세장에 있을 것이며 주 6.25%가 정체될 것임을 나타낸다.

철저한 전개와 많은 예는 온라인 모노그래프 Meyn & Twidie 2005에서 찾아볼 수 있다.[7]

유한 상태 기계는 마르코프 체인의 표현으로 사용될 수 있다.독립적이고 동일하게 분포된 입력 신호의 시퀀스(예를 들어, 코인 토스에 의해 선택된 이진 알파벳의 기호)를 가정할 때 기계가 시간 n에 상태 y에 있다면, 시간 n + 1에 상태 x로 이동할 확률은 현재 상태에 따라서만 달라진다.

연속시간

출생-사망 과정

한 사람이 팝콘 100알을 오븐에 넣고 각각의 알맹이가 독립적으로 기하급수적으로 분배된 시간에 튀는다면, 이것은 지속적인 시간 마코프 과정이 될 것이다. 이 t까지 튀어오른 커널의 수를 나타내는 경우, 문제는 나중에 튀어나올 커널의 수를 찾는 것으로 정의할 수 있다.다만 알아야 할 것은 't' 시간 이전에 튀어 나온 낟알의 숫자뿐이다.언제 튀어나왔는지 알 필요는 없으므로 를 이전 시간 "t"에 대해 아는 것은 관련이 없다.

여기서 설명하는 프로세스는 포아송 점 공정의 근사치인데, 포아송 공정도 마르코프 공정이다.

참고 항목

참조

- ^ Øksendal, B. K. (Bernt Karsten), 1945- (2003). Stochastic differential equations : an introduction with applications (6th ed.). Berlin: Springer. ISBN 3540047581. OCLC 52203046.

{{cite book}}: CS1 maint : 복수이름 : 작성자 목록(링크) - ^ Gagniuc, Paul A. (2017). Markov Chains: From Theory to Implementation and Experimentation. USA, NJ: John Wiley & Sons. pp. 1–235. ISBN 978-1-119-38755-8.

- ^ a b c Van Kampen, N.G. (2007). Stochastic Processes in Physics and Chemistry. NL: North Holland Elsevier. pp. 73–95. ISBN 978-0-444-52965-7.

- ^ a b c d Van Kampen, N.G. (2007). Stochastic Processes in Physics and Chemistry. NL: North Holland Elsevier. pp. 73–95. ISBN 978-0-444-52965-7.

- ^ "Going steady (state) with Markov processes". Bloomington Tutors.

- ^ a b Gagniuc, Paul A. (2017). Markov chains: from theory to implementation and experimentation. Hoboken, NJ: John Wiley & Sons. pp. 131–163. ISBN 9781119387572. OCLC 982373850.

- ^ S. P. 마인과 R.L. 트위디, 2005.2013-09-03년 웨이백 기계에 보관된 마르코프 체인 및 확률적 안정성

![{\displaystyle {\begin{aligned}x^{(n+3)}&={\begin{bmatrix}0&1&0\end{bmatrix}}{\begin{bmatrix}0.9&0.075&0.025\\0.15&0.8&0.05\\0.25&0.25&0.5\end{bmatrix}}^{3}\\[5pt]&={\begin{bmatrix}0&1&0\end{bmatrix}}{\begin{bmatrix}0.7745&0.17875&0.04675\\0.3575&0.56825&0.07425\\0.4675&0.37125&0.16125\\\end{bmatrix}}\\[5pt]&={\begin{bmatrix}0.3575&0.56825&0.07425\end{bmatrix}}.\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e236058858e3e9fc8c0bd61f7168c236bceedd37)