재귀 뉴럴 네트워크

Recursive neural network재귀 뉴럴 네트워크는 구조화된 입력에 대해 동일한 가중치를 재귀적으로 적용하여 생성된 일종의 심층 뉴럴 네트워크이며, 주어진 구조를 위상 순서로 횡단함으로써 가변 크기 입력 구조에 대한 구조화된 예측 또는 그에 대한 스칼라 예측을 생성한다.RvNN으로 축약되기도 하는 재귀적 신경 네트워크는 예를 들어, 자연 언어 처리의 학습 순서와 트리 구조, 주로 단어 임베딩에 기초한 구와 문장 연속 표현에서 성공적이었다.RvNN은 논리 [1]용어와 같은 구조의 분산 표현을 배우기 위해 처음 도입되었다.모델과 일반 프레임워크는 1990년대 [2][3]이후 추가 작업에서 개발되어 왔다.

아키텍처

기본의

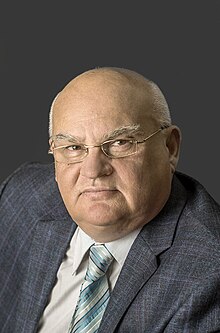

가장 단순한 아키텍처에서 노드는 네트워크 전체에서 공유되는 가중치 매트릭스와 tanh 등의 비선형성을 사용하여 부모로 결합됩니다.c와2 c가 노드의 n차원 벡터 표현일 경우1, 그 부모 또한 다음과 같이 계산되는 n차원 벡터가 될 것입니다.

여기서 W는 × 2n) 무게 매트릭스입니다.

이 아키텍처는 몇 가지 개선점을 가지고 자연 장면의 해석, 자연 언어 [4]문장의 구문 해석, 입체 [5]추상화 형태의 3D 형상 구조의 재귀적 자동 인코딩 및 생성 모델링에 성공적으로 사용되었습니다.

재귀 캐스케이드 상관(RecCC)

RecCC는 화학에 대한[6] 선구적인 응용과 방향 비순환 [7]그래프에 대한 확장을 가진 나무 영역을 다루기[2] 위한 건설적인 뉴럴 네트워크 접근법이다.

비감독 RNN

비감독 RNN을 위한 [8][9]프레임워크는 2004년에 도입되었다.

텐서

재귀 신경 텐서 네트워크는 [10]트리의 모든 노드에 대해 하나의 텐서 기반 구성 함수를 사용한다.

트레이닝

확률적 경사 강하

일반적으로 확률적 경사 강하(SGD)는 네트워크를 훈련하기 위해 사용됩니다.구배는 반복 신경망에 사용되는 시간을 통한 역 전파의 변형인 구조(BPTS)를 사용하여 계산된다.

특성.

나무에 대한 RNN의 보편적 근사 능력은 [11][12]문헌에서 입증되었다.

관련 모델

반복신경망

반복신경망은 선형사슬의 특정 구조를 가진 재귀적 인공신경망이다.재귀신경망은 자녀표현을 부모표현으로 결합하는 계층구조로 동작하는 반면, 재귀신경망은 이전 시간단계와 숨겨진 표현을 현재 시간단계에 대한 표현으로 결합하는 시간의 선형진행으로 동작한다.

트리 에코 스테이트네트워크

리저버 컴퓨팅 패러다임 내의 트리 에코 상태[13] 네트워크에 의해 재귀 신경망을 구현하기 위한 효율적인 접근법이 제시된다.

그래프 확장

그래프에 대한 확장으로는 그래프 신경 네트워크([14]GNN), 그래프용 신경 네트워크(NN4G),[15] 그리고 보다 최근의 그래프용 컨볼루션 신경 네트워크가 있다.

레퍼런스

- ^ Goller, C.; Küchler, A. (1996). "Learning task-dependent distributed representations by backpropagation through structure". Proceedings of International Conference on Neural Networks (ICNN'96). Vol. 1. pp. 347–352. CiteSeerX 10.1.1.52.4759. doi:10.1109/ICNN.1996.548916. ISBN 978-0-7803-3210-2. S2CID 6536466.

- ^ a b Sperduti, A.; Starita, A. (1997-05-01). "Supervised neural networks for the classification of structures". IEEE Transactions on Neural Networks. 8 (3): 714–735. doi:10.1109/72.572108. ISSN 1045-9227. PMID 18255672.

- ^ Frasconi, P.; Gori, M.; Sperduti, A. (1998-09-01). "A general framework for adaptive processing of data structures". IEEE Transactions on Neural Networks. 9 (5): 768–786. CiteSeerX 10.1.1.64.2580. doi:10.1109/72.712151. ISSN 1045-9227. PMID 18255765.

- ^ Socher, Richard; Lin, Cliff; Ng, Andrew Y.; Manning, Christopher D. "Parsing Natural Scenes and Natural Language with Recursive Neural Networks" (PDF). The 28th International Conference on Machine Learning (ICML 2011).

- ^ Li, Jun; Xu, Kai; Chaudhuri, Siddhartha; Yumer, Ersin; Zhang, Hao; Guibas, Leonadis (2017). "GRASS: Generative Recursive Autoencoders for Shape Structures" (PDF). ACM Transactions on Graphics. 36 (4): 52. arXiv:1705.02090. doi:10.1145/3072959.3073613. S2CID 20432407.

- ^ Bianucci, Anna Maria; Micheli, Alessio; Sperduti, Alessandro; Starita, Antonina (2000). "Application of Cascade Correlation Networks for Structures to Chemistry". Applied Intelligence. 12 (1–2): 117–147. doi:10.1023/A:1008368105614. ISSN 0924-669X. S2CID 10031212.

- ^ Micheli, A.; Sona, D.; Sperduti, A. (2004-11-01). "Contextual processing of structured data by recursive cascade correlation". IEEE Transactions on Neural Networks. 15 (6): 1396–1410. CiteSeerX 10.1.1.135.8772. doi:10.1109/TNN.2004.837783. ISSN 1045-9227. PMID 15565768. S2CID 12370239.

- ^ Hammer, Barbara; Micheli, Alessio; Sperduti, Alessandro; Strickert, Marc (2004). "Recursive self-organizing network models". Neural Networks. 17 (8–9): 1061–1085. CiteSeerX 10.1.1.129.6155. doi:10.1016/j.neunet.2004.06.009. PMID 15555852.

- ^ Hammer, Barbara; Micheli, Alessio; Sperduti, Alessandro; Strickert, Marc (2004-03-01). "A general framework for unsupervised processing of structured data". Neurocomputing. 57: 3–35. CiteSeerX 10.1.1.3.984. doi:10.1016/j.neucom.2004.01.008.

- ^ Socher, Richard; Perelygin, Alex; Y. Wu, Jean; Chuang, Jason; D. Manning, Christopher; Y. Ng, Andrew; Potts, Christopher. "Recursive Deep Models for Semantic Compositionality Over a Sentiment Treebank" (PDF). EMNPL 2013.

- ^ Hammer, Barbara (2007-10-03). Learning with Recurrent Neural Networks. Springer. ISBN 9781846285677.

- ^ Hammer, Barbara; Micheli, Alessio; Sperduti, Alessandro (2005-05-01). "Universal Approximation Capability of Cascade Correlation for Structures". Neural Computation. 17 (5): 1109–1159. CiteSeerX 10.1.1.138.2224. doi:10.1162/0899766053491878. S2CID 10845957.

- ^ Gallicchio, Claudio; Micheli, Alessio (2013-02-04). "Tree Echo State Networks". Neurocomputing. 101: 319–337. doi:10.1016/j.neucom.2012.08.017. hdl:11568/158480.

- ^ Scarselli, F.; Gori, M.; Tsoi, A. C.; Hagenbuchner, M.; Monfardini, G. (2009-01-01). "The Graph Neural Network Model". IEEE Transactions on Neural Networks. 20 (1): 61–80. doi:10.1109/TNN.2008.2005605. ISSN 1045-9227. PMID 19068426. S2CID 206756462.

- ^ Micheli, A. (2009-03-01). "Neural Network for Graphs: A Contextual Constructive Approach". IEEE Transactions on Neural Networks. 20 (3): 498–511. doi:10.1109/TNN.2008.2010350. ISSN 1045-9227. PMID 19193509. S2CID 17486263.

![p_{1,2}=\tanh \left(W[c_{1};c_{2}]\right)](https://wikimedia.org/api/rest_v1/media/math/render/svg/6987af6182af39692701b8272fa8144516092e2b)