공정성(기계학습)

Fairness (machine learning)이 기사는 여러 가지 이슈가 있습니다.개선을 도와주시거나 토크 페이지에서 이 문제들을 논의해 주시기 바랍니다.(이 템플릿 메시지를 제거하는 방법 및 시기 알아보기)

|

머신러닝의 공정성은 머신러닝 모델을 기반으로 자동화된 의사결정 과정에서 알고리즘 편향을 수정하려는 다양한 시도를 말합니다.기계 학습 과정 후에 컴퓨터가 내린 결정은 민감한 것으로 간주되는 변수에 기초한 것이라면 불공평하다고 여겨질 수 있습니다.이러한 종류의 변수의 예로는 성별, 민족성, 성적 성향, 장애 등이 있습니다.많은 윤리적 개념들이 그러하기 때문에 공정성과 편향성에 대한 정의는 항상 논란이 되고 있습니다.일반적으로 공정성과 편견은 결정 과정이 사람들의 삶에 영향을 미칠 때 관련이 있는 것으로 여겨집니다.기계 학습에서 알고리즘 편향의 문제는 잘 알려져 있고 잘 연구되어 있습니다.결과는 다양한 요인에 의해 왜곡될 수 있으므로 특정 집단 또는 개인에 대해 불공평한 것으로 간주될 수 있습니다.소셜 미디어 사이트가 개인화된 뉴스를 소비자에게 전달하는 방식이 그 예가 될 것입니다.

맥락

기계 학습의 공정성에 대한 논의는 비교적 최근의 주제입니다.2016년부터 이 주제에 대한 연구가 급격히 증가했습니다.[1]이러한 증가는 미국 법원에서 재범을 예측하기 위해 널리 사용되는 COMPAS 소프트웨어가 인종적으로 편향되어 있다고 주장한 ProPublica의 영향력 있는 보고서에 부분적으로 설명될 수 있습니다.[2]연구와 논의의 한 가지 주제는 공정성에 대한 정의인데, 보편적인 정의가 존재하지 않고 서로 다른 정의가 서로 모순될 수 있기 때문에 머신러닝 모델을 판단하기가 어렵기 때문입니다.[3]다른 연구 주제로는 편향의 기원, 편향의 종류, 편향을 줄이기 위한 방법 등이 있습니다.[4]

최근 몇 년 동안 기술 회사들은 머신 러닝의 편견을 감지하고 줄이는 방법에 대한 도구와 설명서를 만들었습니다.IBM은 소프트웨어 편향을 줄이고 공정성을 높이기 위해 여러 알고리즘을 갖춘 Python 및 R용 도구를 보유하고 있습니다.[5][6]구글은 머신 러닝의 편견을 연구하고 퇴치하기 위한 지침과 도구를 발표했습니다.[7][8]Facebook은 AI의 편견을 감지하기 위해 Fairness Flow라는 도구를 사용했다고 보고했습니다.[9]그러나 비판론자들은 회사의 노력이 부족하다고 주장하고 있습니다. 직원들이 도구를 모든 프로그램에 사용할 수 없고 사용할 수 있는 경우에도 도구 사용은 선택 사항이기 때문에 직원들이 거의 사용하지 않는다고 보고했습니다.[10]

논쟁거리

법 제도에서 알고리즘적 의사결정의 사용은 주목할 만한 사용 분야였습니다.2014년 에릭 홀더 당시 미국 법무장관은 "위험평가" 방법이 교육 수준이나 사회경제적 배경 등 피고인의 통제 하에 있지 않은 요소에 과도하게 초점을 맞추는 것 아니냐는 우려를 제기했습니다.[11]COMPAS에 관한 프로퍼블리카의 2016년 보고서는 흑인 피고인들이 백인 피고인들보다 더 높은 위험성으로 잘못 분류될 가능성이 거의 두 배나 높다고 주장했습니다. 반면 백인 피고인들과는 정반대의 실수를 저질렀습니다.[2]COMPAS의 설립자인 Northepoint Inc.는 그들의 도구가 공정하고 ProPublica가 통계적 오류를 범했다고 주장하며 이 보고서에 이의를 제기했고,[12] 그 후 ProPublica는 다시 반박했습니다.[13]

이미지 인식 알고리즘에서도 인종 및 성별 편견이 지적되었습니다.카메라의 얼굴 및 움직임 감지는 백인이 아닌 피험자의 얼굴 표정을 무시하거나 잘못된 라벨을 붙이는 것으로 밝혀졌습니다.[14]2015년 플리커와 구글 포토의 자동 태그 기능은 흑인들에게 "동물"과 "고릴라"와 같은 태그를 붙이는 것으로 밝혀졌습니다.[15]인공지능 알고리즘에 의해 심사된 2016년 국제 미인대회는 훈련 데이터의 편향으로 인해 피부가 밝은 사람들에게 편향된 것으로 밝혀졌습니다.[16]2018년에 세 개의 상업적인 성별 분류 알고리즘에 대한 연구는 세 개의 알고리즘 모두 밝은 피부의 남성을 분류할 때 일반적으로 가장 정확하고 어두운 피부의 여성을 분류할 때 가장 나쁜 것을 발견했습니다.[17]2020년 트위터의 이미지 크롭 도구는 더 밝은 피부의 얼굴을 선호하는 것으로 나타났습니다.[18]2021년에 출시된 기계 학습 텍스트-투-이미지 모델인 DALL-E는 사회적 고정관념을 강화하는 인종차별적이고 성차별적인 이미지를 생성하는 경향이 있으며, 이는 제작자들이 인정한 것입니다.[19]

머신 러닝 알고리즘이 사용 중인 다른 분야 중 편향된 것으로 나타난 분야로는 일자리 및 대출 애플리케이션이 있습니다.아마존은 소프트웨어를 사용하여 "여성"이라는 단어가 포함된 이력서에 불이익을 주는 등 성차별적인 입사 지원서를 검토해 왔습니다.[20]2019년에 애플의 새로운 애플 카드의 신용카드 한도를 결정하는 알고리즘은 재정을 공유하는 커플들에게도 여성들보다 남성들에게 훨씬 더 높은 한도를 주었습니다.[21]2021년 마크업(The Markup)의 보고서에 따르면 미국에서 사용 중인 모기지 승인 알고리즘은 백인이 아닌 지원자를 거부할 가능성이 더 높은 것으로 나타났습니다.[22]

그룹공정성기준

분류 문제에서 알고리즘은 알려진 특성 로부터 대상 변수인 특성 Y 를 예측하는 함수를 학습합니다 우리는 A 를 우리가 감각이라고 생각하는 에 포함되거나 암시적으로 인코딩된 일부 특성을 이산 랜덤 변수로 모델링합니다.tive 특성(성별, 민족성, 성적 성향 등)우리는 최종적으로 분류기의 예측을 {\로 나타냅니다.이제 주어진 분류기가 공정한지, 즉 그 예측이 이러한 민감한 변수들에 의해 영향을 받지 않는지를 평가하기 위한 세 가지 주요 기준을 정의해 보겠습니다.[23]

인디펜던스

우리는 한 특성A {\A}가 예측R {\ R과 통계적으로 독립적이라면 랜덤 변수( A 가 독립성을 만족한다고 말하고 우리는 다음과 같이 적습니다.

그러나 독립성에 대한 또 다른 동등한 표현은 다음과 같이 정의되는 랜덤 변수들 사이의 상호 정보의 개념을 사용하여 주어질 수 있습니다.

독립성 정의의 가능한 완화는의 슬랙ϵ > 0 \epsilon >0}을(를) 도입하는 것을 포함하며 공식에 의해 주어집니다.

마지막으로, 또 다른 가능한 는 I(≤ϵ I(R,A \epsilon}을 필요로 하는 것입니다.

분리

만약 민감한 특성 A}가 대상 값 Y textstyle Y가주어졌을 때 예측R {\textstyle 과 통계적으로 독립적이라면, 랜덤 변수(,) (가 분리를 만족한다고 말하고 우리는 다음과 같이 적습니다.

이항 목표율의 경우 다른 동등한 표현은 민감한 특성의 모든 값에 대해 참 양의 비율과 거짓 양의 비율이 같다는 것입니다(따라서 거짓 음의 비율과 참 음의 비율이 같다는 것입니다).

주어진 정의를 완화할 수 있는 방법은 비율 간의 차이에 대한 값이 0이 아닌 주어진 슬랙ϵ > 0 >0}보다 낮은 양수가 되도록 하는 것입니다.

일부 필드에서 혼동 행렬의 분리(분리 계수)는 예측된 누적 백분율 음과 예측된 누적 백분율 양 사이의 거리(확률 점수의 주어진 수준에서)를 측정하는 것입니다.

주어진 점수 값에서 이 분리 계수가 클수록 모형은 특정 확률 컷오프에서 양과 음의 집합을 구별하는 데 더 효과적입니다.Mayes(메이스)에 따르면,[24] "신용 업계에서는 모델화 접근 방식에 따라 유효성 검사 방법을 선택하는 것이 종종 관찰됩니다.예를 들어 모형화 절차가 모수적이거나 반모수적인 경우 2-표본 K-S 검정이 자주 사용됩니다.모델이 휴리스틱 또는 반복 검색 방법에 의해 도출된 경우 모델 성능의 측정값은 일반적으로 발산입니다.세번째 방법은 분리계수...분리계수는 다른 두 방법에 비해 모형의 분리 패턴을 반영하기 때문에 모형 성능에 대한 척도로 가장 합리적인 것으로 보입니다."

충분성

예측 R R이 주어졌을 때 민감한 A 가 대상 값 Y와 통계적으로 독립적이라면 랜덤 변수 (R, A, 가 충분하다고 말하고 우리는 다음과 같이 적습니다.

정의 간의 관계

마지막으로 위에 제시된 세 가지 정의와 관련된 주요 결과를 몇 가지 요약합니다.

- Assuming is binary, if and are not statistically independent, and and are not statistically independent either, then independence and separation cannot both hold except for rhetorical cases.

- 합동 분포로서의( Y {\Y)} {\ ,A,Y)}이) 모든 가능한 값에 대해 양의 확률을 가지며 A {\ A및 Y {\ Y}가 통계적으로 독립적이지 않다면, 분리와 충분성은 수사적인 경우를 제외하고 모두 유지될 수 없습니다.

독립성, 분리성, 충분성이 동시에 충족되는 경우를 완전공정성이라고 합니다.[25]그러나 구체적인 수사적인 경우를 제외하고는 완전한 공정성을 달성할 수 없습니다.[26]

그룹 공정성 정의의 수학적 공식화

예비 정의

공정성에 대한 대부분의 통계적 측정치는 서로 다른 측정치에 의존하기 때문에 이를 정의하는 것부터 시작하겠습니다.이진 분류기로 작업할 때 예측 클래스와 실제 클래스 모두 양과 음의 두 값을 취할 수 있습니다.이제 예측 결과와 실제 결과 간의 가능한 다른 관계에 대해 설명하겠습니다.[27]

- 참양성(True Positive, TP): 예측결과와 실제결과가 모두 긍정적인 등급에 있는 경우.

- 참음(True negative, TN): 예측한 결과와 실제 결과가 모두 음의 클래스에 할당된 경우.

- False Positive(FP): 실제 결과에서 할당된 양의 등급에 속할 것으로 예측되는 경우는 음의 등급에 해당합니다.

- 거짓 음성(False negative, FN): 실제 결과와 함께 부정적인 부류로 예측되는 경우는 긍정적인 경우입니다.

이러한 관계는 분류 모형의 정확도를 설명하는 표인 혼동 행렬로 쉽게 표현할 수 있습니다.이 행렬에서 열과 행은 각각 예측 사례와 실제 사례의 인스턴스를 나타냅니다.

이러한 관계를 사용하여 나중에 알고리즘의 공정성을 측정하는 데 사용할 수 있는 여러 측정 기준을 정의할 수 있습니다.

- 양의 예측값(PPV): 모든 양의 예측 중에서 정확하게 예측된 양의 경우의 비율.이 값은 일반적으로 정밀도(precision)라고 하며, 정확한 양의 예측 확률을 나타냅니다.다음과 같은 공식이 주어집니다.

- FDR(False Discovery Rate): 모든 긍정적인 예측 중에서 실제로 부정적인 예측의 비율.이것은 잘못된 양성 예측의 확률을 나타내며 다음 공식으로 제공됩니다.

- 음의 예측값(NPV): 모든 음의 예측값 중에서 정확하게 예측된 음의 경우의 비율.정확한 음의 예측 확률을 나타내며 다음 공식으로 제공됩니다.

- 거짓 누락률(FOR): 모든 부정적인 예측 중에서 실제로 긍정적인 예측의 비율.그것은 잘못된 음성 예측의 가능성을 나타내며 다음과 같은 공식으로 주어집니다.

- 참 양성률(TPR): 모든 양성 사례 중에서 정확하게 예측된 양성 사례의 비율.일반적으로 민감도 또는 회상이라고 하며, 긍정적인 피험자가 정확하게 분류될 확률을 나타냅니다.다음과 같은 공식이 주어집니다.

- 거짓 음성률(False negative rate, FNR): 모든 양성 사례 중 음성으로 잘못 예측된 양성 사례의 비율.이 값은 긍정적인 피험자가 부정적인 피험자로 잘못 분류될 확률을 나타내며 공식에 의해 제공됩니다.

- 참 음성 비율(TNR): 모든 음성 사례 중에서 올바르게 예측된 음성 사례의 비율.이 값은 부정적인 피험자가 정확하게 분류될 확률을 나타내며 다음 공식으로 제공됩니다.

- FPR(False Positive Rate): 모든 음성 사례 중에서 양성으로 잘못 예측된 음성 사례의 비율.이 값은 부정적인 피험자가 긍정적인 피험자로 잘못 분류될 확률을 나타내며 다음 공식으로 제공됩니다.

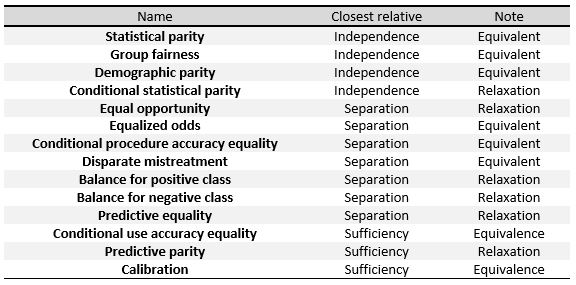

다음 기준은 본 섹션의 시작 부분에 제시된 세 가지 일반적인 정의, 즉 독립성, 분리성 및 충분성의 척도로 이해할 수 있습니다.오른쪽 표에서[23], 우리는 그들 사이의 관계를 볼 수 있습니다.

이러한 조치를 구체적으로 정의하기 위해 Verma et al. 에서 한 것처럼 크게 세 그룹으로 나눌 것입니다.:[27]예측된 결과, 예측된 결과 및 실제 결과에 기초한 정의[27], 예측된 확률 및 실제 결과에 기초한 정의.

이진 분류기와 다음 표기법으로 작업합니다. 는 분류기에 의해 주어진 점수를 말하는데, 어떤 과목이 긍정적이거나 부정적일 확률입니다. 은(는) 알고리즘에 의해 예측된 최종 분류를 나타내며, 그 값은 으로 S{\에서 파생됩니다 예를 들어 이(가) 특정 임계값 이상일 때 양수가 됩니다. 는 실제 결과, 즉 개체의 실제 분류를 나타내며 마지막으로 A 는 개체의 민감한 속성을 나타냅니다.

예측 결과에 따른 정의

이 절의 정의는 피험자의 다양한 분포에 대한 예측 R 에 초점을 맞춥니다.그것들은 공정성에 대한 가장 단순하고 직관적인 개념입니다.

- 인구통계학적 패리티, 통계적 패리티, 수용률 패리티 및 벤치마킹이라고도 합니다.보호 그룹과 비보호 그룹의 피험자가 양의 예측 클래스에 할당될 확률이 동일한 경우 분류기가 이 정의를 충족합니다.이는 다음 공식을 만족하는 경우입니다.

- 조건부 통계적 패리티.기본적으로 위의 정의로 구성되지만 인스턴스의 하위 집합으로만 제한됩니다.수학적 표기법에서는 다음과 같습니다.

예측된 결과와 실제 결과에 기반한 정의

이러한 정의는 예측 R 을(를) 고려할 뿐만 아니라 실제 Y 과(와) 비교합니다

- 예측 패리티, 결과 검정이라고도 합니다.보호된 그룹과 보호되지 않은 그룹의 제목이 동일한 PPV를 가지면 분류기가 이 정의를 충족합니다.이는 다음 공식을 만족하는 경우입니다.

- 수학적으로 분류기가 두 그룹에 대해 동일한 PPV를 가지면 FDR도 동일하게 되어 다음 공식을 만족합니다.

- 예측 균등이라고도 하는 잘못된 양의 오류율 균형입니다.보호된 그룹과 비보호된 그룹의 피험자가 동등한 FPR을 가질 경우 분류기가 이 정의를 충족합니다.이는 다음 공식을 만족하는 경우입니다.

- 수학적으로, 분류기가 두 그룹에 대해 동일한 FPR을 가지면, 다음 공식을 만족하는 TNR도 가질 것입니다.

- 기회 균등이라고도 하는 잘못된 음의 오류율 균형입니다.보호 그룹과 비보호 그룹의 피험자가 동일한 FNR을 가지면 분류기가 이 정의를 충족합니다.이는 다음 공식을 만족하는 경우입니다.

- 수학적으로 분류기가 두 그룹에 대해 동일한 FNR을 가지면 다음 공식을 만족하는 TPR도 가질 것입니다.

- 균등화 승산, 조건부 절차 정확도 균등 및 상이한 오처리라고도 합니다.보호 그룹과 비보호 그룹의 피험자가 동일한 TPR과 동일한 FPR을 가지면 분류기는 이 정의를 충족하며 다음 공식을 만족합니다.

- 조건부 사용 정확도 동일.보호 그룹과 비보호 그룹의 피험자가 동일한 PPV와 동일한 NPV를 가지면 분류기가 이 정의를 충족하며 다음 공식을 만족합니다.

- 전체적인 정확도가 같습니다.보호된 그룹과 비보호된 그룹의 제목이 동일한 예측 정확도를 가지면 분류기는 이 정의를 충족합니다. 즉, 한 클래스의 제목이 할당될 확률이 높습니다.이는 다음 공식을 만족하는 경우입니다.

- 대우 평등.보호 그룹과 비보호 그룹의 피험자가 FN과 FP의 비율이 같다면 분류기는 이 정의를 만족하며 다음 공식을 만족합니다.

예측 확률과 실제 결과에 기반한 정의

이러한 정의는 실제 Y 및 예측 확률 점수 을(를) 기반으로 합니다

- 검정 공정성, 즉 보정 또는 일치 조건부 주파수라고도 합니다.예측 확률 점수 이(가) 동일한 개체가 보호 또는 비보호 그룹에 속할 때 양의 클래스로 분류될 확률이 동일한 경우 분류기는 이 정의를 충족합니다.

- 웰 캘리브레이션은 이전 정의의 확장입니다.보호 그룹 내부 또는 외부의 개인들이 동일한 예측 확률 S{\를 가질 때, 그들은 양의 클래스에서 분류될 확률이 동일해야 하며, 이 확률은 와 동일해야 한다고 명시합니다

- 긍정적인 수업에 대한 균형.보호된 그룹과 비보호된 그룹 모두에서 양의 클래스를 구성하는 피험자의 평균 예측 확률 S 가 같다면 분류기는 이 정의를 만족합니다 즉, 실제 가 양인 보호된 그룹과 비보호된 그룹의 확률 점수의 기대값 Y Y가 sa임을 의미합니다.공식을 만족시키는 나:

- 부정적인 클래스에 대한 균형.보호된 그룹과 비보호된 그룹 모두에서 부정적인 클래스를 구성하는 주체의 평균 예측 확률 S 이가) 같으면 분류기는 이 정의를 만족합니다 즉, 실제 가 음수인 보호된 그룹과 비보호된 그룹의 확률 점수의 기대 값이 sa임을 의미합니다공식을 만족시키는 나:

균등혼란공정성

혼동 행렬의 경우, 독립성, 분리 및 충분성은 아래에 나열된 각 수량이 민감한 특성에 통계적으로 유의한 차이가 없어야 합니다.[26]

- 독립성: (TP + FP) / (TP + FP + FN + TN)

- 분리: TN / (TN + FP) 및 TP / (TP + FN) (즉, 특이성 및 호출).

- 충분성: TP / (TP + FP) 및 TN / (TN + FN) (즉, 정밀도 및 음의 예측값), 및

혼동 행렬의 분포는 분리와 충분성의 값이 주어질 때 알 수 있습니다.결과적으로 독립성을 포함하여 혼동 행렬에 기초한 모든 측도도 계산될 수 있습니다.따라서, 혼동 행렬은 TP, FP, TN 및 FN에 기초한 세 가지 기준과 다른 공정성 메트릭을 모두 포함합니다.

동일한 혼동 공정성의[28] 개념은 모든 민감한 특성에 걸쳐 주어진 결정 시스템의 혼동 행렬이 동일한 분포를 갖도록 합니다.오픈소스 소프트웨어로는 불공정 행위를 식별하는 동일혼란 공정성 테스트, 불공정 정도를 정량화하는 혼동 패리티 오류, 영향을 받는 집단을 식별하는 사후 분석 방법이 있습니다.[29]

사회복지기능

일부 학자들은 알고리즘 공정성을 사회복지 기능의 관점에서 정의할 것을 제안했습니다.그들은 사회복지 기능을 사용하면 알고리즘 설계자가 알고리즘의 영향을 받는 사람들에게 주는 혜택의 관점에서 공정성과 예측 정확성을 고려할 수 있다고 주장합니다.또한 설계자는 효율성과 형평성을 원칙적인 방법으로 상쇄할 수 있습니다.[30]Sendhil Mullainathan은 알고리즘 설계자들이 불우한 집단들의 절대적 이득을 인식하기 위해 사회복지 기능을 사용해야 한다고 말했습니다.예를 들어, 한 연구는 순수한 인간의 판단보다는 재판 전 구금에서 의사결정 알고리즘을 사용하는 것이 범죄율을 일정하게 유지하면서도 흑인, 히스패닉, 인종 소수자들의 구금율을 전반적으로 감소시킨다는 것을 발견했습니다.[31]

개인별 공정성 기준

공정성 정의의 중요한 차이점은 집단과 개인 개념 간의 차이입니다.[32][33][27][34]대략적으로 말하면, 그룹 공정성 기준은 일반적으로 민감한 속성(예: 성별, 민족성, 나이 등)에 의해 식별되는 그룹 수준에서 수량을 비교하는 반면, 개별 기준은 개인을 비교합니다.즉, 개인의 공정성은 "유사한 개인은 유사한 대우를 받아야 한다"는 원칙을 따르고 있습니다.

공정성에 대한 매우 직관적인 접근법이 있는데, 이는 보통 (자동화된) 결정을 내릴 때 민감한 기능을 명시적으로 사용하지 않도록 규정하는 FTU(Fairing Through Unarweness) 또는 블라인드니스(Blindness)라는 이름으로 진행됩니다.민감한 속성의 가치에 대해서만 다른 두 개인이 동일한 결과를 얻기 때문에 이것은 사실상 개인 공정성의 개념입니다.

그러나 일반적으로 FTU는 몇 가지 단점이 있는데, 주요한 점은 민감한 속성과 의사결정 과정에서 사용되는 비민감한 속성 간의 가능한 상관관계를 고려하지 않는다는 것입니다.예를 들어, 성별을 기준으로 차별하려는 (악의적인) 의도를 가진 에이전트는 모델에 성별에 대한 대리 변수(즉, 성별과 상관 관계가 높은 변수)를 도입하고 동시에 FTU 처방을 준수하면서 성별 정보를 효과적으로 사용할 수 있습니다.

민감한 변수와 관련된 어떤 변수가 의사결정 과정에서 모델에 의해 상당히 사용 가능한지에 대한 문제는 매우 중요하며, 그룹 개념과도 관련이 있습니다. 독립성 지표는 민감한 정보를 완전히 제거해야 하는 반면 분리 기반 지표는 상관관계를 허용합니다.라벨이 붙은 대상 변수 "justify"만큼만 가능합니다.

개인 공정성의 가장 일반적인 개념은 2012년[35] 신시아 디워크와 공동연구자들에 의해 선구적인 연구에서 소개되었으며, 특징을 입력으로 하는 의사결정 지도가 "유사한 개인을 유사하게 지도화"할 수 있도록 구축되어야 한다는 원칙의 수학적 번역으로 생각할 수 있고,모델 맵 상에서 Lipschitz 조건으로 표시됩니다.그들은 특정 상황에서 어떤 개인이 유사한지를 평가하기 위해 적절한 목표 관련 거리 측정 기준을 선택하는 것의 중요성을 강조하기 때문에 이 접근 방식을 정확하게 FTU의 대응점으로 Fairness Through Awareness(FTA)라고 부릅니다.다시 말하지만, 이 문제는 어떤 변수가 특정 맥락에서 "합법적"으로 보일 수 있는지에 대해 위에서 제기된 점과 매우 관련이 있습니다.

인과관계 기반 측정기준

인과적 공정성은 자원 배분이 공정해야 하는 특성들의 집합에서만 다른 두 명의 거의 동일한 사용자 또는 애플리케이션이 동일한 취급을 받는 빈도를 측정합니다.[36]공정성 지표에 대한 학술 연구의 전체 분야는 기계 학습 모델의 편향을 평가하기 위해 인과 모델을 활용하는 데 전념하고 있습니다.이 접근법은 일반적으로 데이터의 동일한 관측 분포가 변수 간의 서로 다른 인과 관계를 숨기고 결과가 어떤 형태의 편향에 의해 영향을 받는지 여부에 대한 해석을 다르게 할 수 있다는 사실에 의해 정당화됩니다.[23]

Kusner 등은 [37]어떤 개인에 대해서도 민감한 속성이 변경되는 반사실적 시나리오에서 결과가 변하지 않는다면 반사실적 공정한 의사결정 과정을 정의할 것을 제안합니다.수학 공식은 다음과 같습니다.

즉, 민감한 속성 = displaystyle A= 및 기타 특징 X = x {\displaystyle X=x}을(를) 가진 임의의 개체를 선택하고, A = b {\displaystyle A=b}을(를) 가진 동일한 개체를 선택하면 동일한 가능성을 가질 수 있습니다.기호 ← 는 민감한 특성 A 가 = A=에 된 시나리오의 반사실 랜덤 변수 을 나타냅니다 = = A = a, X = x}의 조건은 단일 관측치를 식별하는 모든 변수를 조건화한다는 점에서 이 요구 사항이 개별 수준에 있음을 의미합니다.

머신 러닝 모델은 종종 당시의 결정에 따라 결과가 좌우되는 데이터에 대해 훈련을 받습니다.[38]예를 들어, 기계 학습 모델이 재소자의 재범 여부를 결정해야 하고 재소자의 조기 석방 여부를 결정해야 한다면, 결과는 재소자의 조기 석방 여부에 달려 있을 수 있습니다.Mishler et al.[39] 은 반사실적 균등화 승산에 대한 공식을 제안합니다.

여기서 은(는) 랜덤 변수이고, Y는 x {\ x이(가) 수행된 결과이며, 은(는) 민감한 기능입니다.

바이어스 완화 전략

공정성은 데이터 전처리, 소프트웨어 교육 중 최적화 또는 알고리즘의 후처리 결과 등 세 가지 방법으로 머신러닝 알고리즘에 적용할 수 있습니다.

전처리

일반적으로 분류기만 문제가 있는 것은 아닙니다. 데이터 세트도 편향되어 있습니다. A=에 대한 데이터 D의 은 다음과 같이 정의할 수 있습니다.

즉, 주어가 와 다른 보호 특성을 가지며 와 같은 경우 양의 클래스에 속할 확률의 차이에 대한 근사치입니다

사전 처리 시 편향을 수정하는 알고리즘은 불공정한 결정을 초래할 수 있는 데이터셋 변수에 대한 정보를 제거하는 동시에 가능한 한 적게 변경하려고 노력합니다.이는 단순히 민감한 변수를 제거하는 것만큼 간단하지 않습니다. 다른 속성은 보호된 속성과 상관관계가 있을 수 있기 때문입니다.

이를 위한 방법은 초기 데이터 세트의 각 개체를 가능한 한 많은 정보를 유지하면서 특정 보호 그룹에 속하는지 식별할 수 없는 중간 표현에 매핑하는 것입니다.그런 다음 데이터의 새 표현이 알고리즘에서 최대 정확도를 얻기 위해 조정됩니다.

이러한 방식으로, 개인은 보호된 그룹의 어떤 구성원이 새로운 표현의 특정 값에 매핑될 확률이 보호된 그룹에 속하지 않은 개인의 확률과 동일한 새로운 다변수 표현에 매핑됩니다.그런 다음 이 표현을 사용하여 초기 데이터 대신 개체에 대한 예측값을 얻습니다.중간 표현은 보호된 그룹 내부 또는 외부의 개인에게 동일한 확률을 제공하도록 구성되므로 이 속성은 분류기에 숨겨집니다.

예제는 Jemel et al.[40] 에서 설명하고 있는데, 여기서는 다항식 랜덤 변수를 중간 표현으로 사용합니다.이 과정에서 시스템은 편향된 결정을 초래할 수 있는 정보를 제외한 모든 정보를 보존하고 가능한 한 정확한 예측을 얻도록 권장됩니다.

한편, 이 절차는 전처리된 데이터를 어떤 머신러닝 작업에도 사용할 수 있다는 장점이 있습니다.또한, 처리 전에 데이터셋에 보정이 적용되므로 분류기를 수정할 필요가 없습니다.반면, 다른 방법들은 정확성과 공정성에서 더 나은 결과를 얻습니다.[41]

리웨이트

재가중치는 전처리 알고리즘의 한 예입니다.이 아이디어는 지정된 그룹에 대해 가중치가 0이 되도록 각 데이터 집합 지점에 가중치를 할당하는 것입니다.[42]

데이터 집합 이(가) 편향되지 않은 경우 민감 A{\과( 대상 Y {\ Y은(는) 통계적으로 독립적이고 합동 분포의 확률은 다음과 같이 확률의 곱이 됩니다.

그러나 실제로 데이터 집합은 편견이 없으며 변수가 통계적으로 독립적이지 않으므로 관측된 확률은 다음과 같습니다.

이 소프트웨어는 편향을 보완하기 위해 선호하는 개체에 대해 낮은 가중치를 추가하고 선호하지 않는 개체에 대해 높은 가중치를 부여합니다. ∈ D {\X\in D}에 대해 다음을 얻습니다.

각 에 대해 와 연관된 가중치가 있을 때 그룹 = A = a에 가중 을 다음과 같이 계산합니다.

이 가중치를 다시 적용한 후에는 가중치가 적용된 판별이 0임을 알 수 있습니다.

처리중

또 다른 접근법은 훈련 시간에 편향을 수정하는 것입니다.이것은 알고리즘의 최적화 목표에 제약조건을 추가함으로써 이루어질 수 있습니다.[43]이러한 제약 조건은 알고리즘이 보호된 그룹과 나머지 개인에 대해 일정한 측정 비율을 동일하게 유지함으로써 공정성을 향상시키도록 합니다.예를 들어, 위양성률이 보호 그룹의 개인과 보호 그룹 외부의 개인에 대해 동일하다는 조건을 알고리즘의 목적에 추가할 수 있습니다.

이 방법에서 사용되는 주요 척도는 거짓 양성률, 거짓 음성률 및 전체 오분류율입니다.알고리즘의 목적에 이러한 제약 조건 중 하나 또는 몇 가지만 추가할 수 있습니다.거짓 마이너스 비율의 동일성은 참 플러스 비율의 동일성을 의미하므로 이는 기회의 동일성을 의미합니다.제한 사항을 문제에 추가한 후에는 다루기 어려워질 수 있으므로 이에 대한 완화가 필요할 수 있습니다.

이 기술은 높은 정확도를 유지하면서 공정성을 향상시키는 데 좋은 결과를 얻으며, 프로그래머가 공정성을 향상시킬 측정값을 선택하도록 합니다.그러나 각 머신 러닝 작업은 적용되는 방법이 다를 수 있으며 분류기의 코드를 수정해야 하는데, 이는 항상 가능한 것은 아닙니다.[41]

적대적 디바이어싱

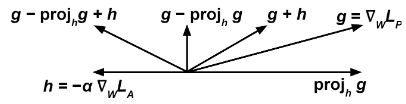

우리는 몇 가지 기울기 기반 방법(예: 기울기 하강)을 통해 두 개의 분류기를 동시에 훈련합니다.The first one, the predictor tries to accomplish the task of predicting , the target variable, given , the input, by modifying its weights to minimize some loss function . The second one, the adversary tries to accomplish the task of predicting , the sensitive variable, given by modifying its weights to minimize some loss function .[44][45]

여기서 중요한 점은 올바르게 전파하기 위해서는 위의 이(가) 이산 예측이 아닌 분류기의 원시 출력을 참조해야 한다는 것입니다. 예를 들어, 인공 신경망과 분류 문제의 경우 이(가) 소프트맥스 계층의 출력을 참조할 수 있습니다.

그런 다음 를 업데이트하여 ∇ }}에 따라 훈련 단계에서 LA {\ L_}를 최소화하고 에 W {\ W합니다.

The intuitive idea is that we want the predictor to try to minimize (therefore the term ) while, at the same time, maximize (therefore the term ), so that the adversary fails at predicting the sensitive variable from

∇ ∇ {\ _{{Anabla _{W}L_{P}}는 예측 변수가 상대방의 손실 함수를 줄이는 데 도움이 되는 방향으로 이동하는 것을 방지합니다.

이 알고리즘을 사용하여 예측자 분류 모델을 훈련하는 것은 적수 없이 훈련하는 것과 관련하여 인구 통계학적 패리티를 향상시킨다는 것을 알 수 있습니다.

후처리

마지막 방법은 공정성을 달성하기 위해 분류기의 결과를 수정하려고 합니다.이 방법에서는 각 개체에 대한 점수를 반환하는 분류기가 있으며 이항 예측을 수행해야 합니다.높은 점수는 긍정적인 결과를 얻을 가능성이 높고 낮은 점수는 부정적인 결과를 얻을 가능성이 높으나 원하는 대로 예라고 대답할 시기를 결정하기 위해 임계값을 조정할 수 있습니다.임계값의 변동은 참 양의 비율과 참 음의 비율 간의 균형에 영향을 미칩니다.

점수 함수가 보호된 속성과 독립적이라는 의미에서 공정하다면 임계값의 선택도 공정할 것이지만, 이러한 유형의 분류기는 편향되는 경향이 있으므로 공정성을 달성하기 위해서는 보호된 그룹마다 다른 임계값이 필요할 수 있습니다.[46]이를 위한 방법은 다양한 임계값 설정(이를 ROC 곡선이라고 함)에서 거짓 음성 비율에 대해 실제 양의 비율을 표시하고 보호된 그룹과 다른 개체의 비율이 동일한 임계값을 찾는 것입니다.[46]

후처리의 장점은 기법을 수정하지 않고 임의의 분류기 이후에 적용할 수 있으며 공정성 측정에서 우수한 성능을 가진다는 것입니다.단점은 테스트 시간 내에 보호된 속성에 접근해야 하는 필요성과 정확성과 공정성 사이의 균형에서 선택의 여지가 없다는 것입니다.[41]

옵션기준구분거부

에서 P( + X ) {\ P (+를 인스턴스 X 이(가) 양의 클래스 +에 속할 확률로 분류기에서 계산한 확률입니다.+ ) P + X이(가) 1에 가깝거나 0에 가까울 때 인스턴스X {\은(는) 클래스 + 또는 -에 각각 속하도록 높은 수준의 확실성으로 지정됩니다.그러나 X가 0.5에 가까울 때 분류가 더 불분명합니다.[47]

We say is a "rejected instance" if with a certain such that .

"ROC" 알고리즘은 위의 규칙을 따르는 rejected가 아닌 인스턴스와 거부된 인스턴스를 다음과 같이 분류하는 것으로 구성됩니다. 만약 인스턴스가 박탈된 그룹의 예( ( = X)=이면 양수로 레이블을 지정하고, 그렇지 않으면 음수로 레이블을 지정합니다.

우리는θ {\textstyle\theta}의 함수로 다양한 차별(링크) 측정을 최적화하여 각 문제에 대한 의θ {\textstyle \theta}를 찾고 특권 그룹에 대한 차별이 되지 않도록 할 수 있습니다.

참고 항목

참고문헌

- ^ Caton, Simon; Haas, Christian (2020-10-04). "Fairness in Machine Learning: A Survey". arXiv:2010.04053 [cs.LG].

- ^ a b Mattu, Julia Angwin,Jeff Larson,Lauren Kirchner,Surya. "Machine Bias". ProPublica. Retrieved 2022-04-16.

{{cite web}}: CS1 유지 : 여러 이름 : 저자 목록 (링크) - ^ Friedler, Sorelle A.; Scheidegger, Carlos; Venkatasubramanian, Suresh (April 2021). "The (Im)possibility of fairness: different value systems require different mechanisms for fair decision making". Communications of the ACM. 64 (4): 136–143. doi:10.1145/3433949. ISSN 0001-0782. S2CID 1769114.

- ^ Mehrabi, Ninareh; Morstatter, Fred; Saxena, Nripsuta; Lerman, Kristina; Galstyan, Aram (2021-07-13). "A Survey on Bias and Fairness in Machine Learning". ACM Computing Surveys. 54 (6): 115:1–115:35. arXiv:1908.09635. doi:10.1145/3457607. ISSN 0360-0300. S2CID 201666566.

- ^ "AI Fairness 360". aif360.mybluemix.net. Retrieved 2022-11-18.

- ^ "IBM AI Fairness 360 open source toolkit adds new functionalities". Tech Republic. 4 June 2020.

- ^ "Responsible AI practices". Google AI. Retrieved 2022-11-18.

- ^ Fairness Indicators, tensorflow, 2022-11-10, retrieved 2022-11-18

- ^ "How we're using Fairness Flow to help build AI that works better for everyone". ai.facebook.com. Retrieved 2022-11-18.

- ^ "AI experts warn Facebook's anti-bias tool is 'completely insufficient'". VentureBeat. 2021-03-31. Retrieved 2022-11-18.

- ^ "Attorney General Eric Holder Speaks at the National Association of Criminal Defense Lawyers 57th Annual Meeting and 13th State Criminal Justice Network Conference". www.justice.gov. 2014-08-01. Retrieved 2022-04-16.

- ^ Dieterich, William; Mendoza, Christina; Brennan, Tim (2016). "COMPAS Risk Scales: Demonstrating Accuracy Equity and Predictive Parity" (PDF). Northpointe Inc.

- ^ Angwin, Jeff Larson,Julia (29 July 2016). "Technical Response to Northpointe". ProPublica. Retrieved 2022-11-18.

{{cite web}}: CS1 유지 : 여러 이름 : 저자 목록 (링크) - ^ Rose, Adam (2010-01-22). "Are face-detection cameras racist?". Time. ISSN 0040-781X. Retrieved 2022-11-18.

- ^ "Google says sorry for racist auto-tag in photo app". The Guardian. 2015-07-01. Retrieved 2022-04-16.

- ^ "A beauty contest was judged by AI and the robots didn't like dark skin". The Guardian. 2016-09-08. Retrieved 2022-04-16.

- ^ Buolamwini, Joy; Gebru, Timnit (February 2018). Gender Shades: Intersectional Accuracy Disparities in Commercial Gender Classification (PDF). Conference on Fairness, Accountability and Transparency. New York, NY, USA. pp. 77–91.

- ^ "Student proves Twitter algorithm 'bias' toward lighter, slimmer, younger faces". The Guardian. 2021-08-10. Retrieved 2022-11-18.

- ^ openai/dalle-2-preview, OpenAI, 2022-11-17, retrieved 2022-11-18

- ^ "Amazon scraps secret AI recruiting tool that showed bias against women". Reuters. 2018-10-10. Retrieved 2022-11-18.

- ^ "Apple Card algorithm sparks gender bias allegations against Goldman Sachs". Washington Post. ISSN 0190-8286. Retrieved 2022-11-18.

- ^ Martinez, Emmanuel; Kirchner, Lauren (25 August 2021). "The Secret Bias Hidden in Mortgage-Approval Algorithms – The Markup". themarkup.org. Retrieved 2022-11-18.

- ^ a b c d 솔론 바로카스; 모리츠 하르트; 아르빈드 나라야난, 공정성과 기계 학습.2019년 12월 15일 회수.

- ^ Mayes, Elizabeth (2001). Handbook of Credit Scoring. NY, NY, USA: Glenlake Publishing. p. 282. ISBN 0-8144-0619-X.

- ^ Berk, Richard; Heidari, Hoda; Jabbari, Shahin; Kearns, Michael; Roth, Aaron (February 2021). "Fairness in Criminal Justice Risk Assessments: The State of the Art". Sociological Methods & Research. 50 (1): 3–44. doi:10.1177/0049124118782533. ISSN 0049-1241.

- ^ a b Räz, Tim (2021-03-03). "Group Fairness: Independence Revisited". ACM: 129–137. doi:10.1145/3442188.3445876. ISBN 978-1-4503-8309-7.

{{cite journal}}:저널 요구사항 인용journal=(도움말) - ^ a b c 베르마, 사힐, 줄리아 루빈."공정성 정의가 설명되었습니다."소프트웨어 공정성(fairware)에 관한 2018 IEEE/ACM 국제 워크숍, pp. 1-7. IEEE, 2018.

- ^ Gursoy, Furkan; Kakadiaris, Ioannis A. (November 2022). "Equal Confusion Fairness: Measuring Group-Based Disparities in Automated Decision Systems". IEEE: 137–146. doi:10.1109/ICDMW58026.2022.00027. ISBN 979-8-3503-4609-1.

{{cite journal}}:저널 요구사항 인용journal=(도움말) - ^ Gursoy, Furkan (2023-07-02), Equal Confusion Fairness: Measuring Group-Based Disparities in Automated Decision Systems, retrieved 2023-09-19

- ^ Chen, Violet (Xinying); Hooker, J. N. (2021). "Welfare-based Fairness through Optimization". arXiv:2102.00311 [cs.AI].

- ^ Mullainathan, Sendhil (June 19, 2018). Algorithmic Fairness and the Social Welfare Function. Keynote at the 19th ACM Conference on Economics and Computation (EC'18). YouTube. 48 minutes in.

In other words, if you have a social welfare function where what you care about is harm, and you care about harm to the African Americans, there you go: 12 percent less African Americans in jail overnight.... Before we get into the minutiae of relative harm, the welfare function is defined in absolute harm, so we should actually calculate the absolute harm first.

- ^ Mitchell, Shira; Potash, Eric; Barocas, Solon; d'Amour, Alexander; Lum, Kristian (2021). "Algorithmic Fairness: Choices, Assumptions, and Definitions". Annual Review of Statistics and Its Application. 8 (1): 141–163. Bibcode:2021AnRSA...8..141M. doi:10.1146/annurev-statistics-042720-125902. S2CID 228893833.

- ^ Castelnovo, Alessandro; Crupi, Riccardo; Greco, Greta; Regoli, Daniele; Penco, Ilaria Giuseppina; Cosentini, Andrea Claudio (2022). "A clarification of the nuances in the fairness metrics landscape". Scientific Reports. 12 (1): 4209. arXiv:2106.00467. Bibcode:2022NatSR..12.4209C. doi:10.1038/s41598-022-07939-1. PMC 8913820. PMID 35273279.

- ^ 메라비, 니나레, 프레드 모스타터, 느립수타 삭세나, 크리스티나 레만, 아람 갈스티안."기계학습의 편향성과 공정성에 관한 조사"ACM 컴퓨팅 조사(CSUR) 54, No. 6 (2021): 1-35

- ^ Dwork, Cynthia; Hardt, Moritz; Pitassi, Toniann; Reingold, Omer; Zemel, Richard (2012). "Fairness through awareness". Proceedings of the 3rd Innovations in Theoretical Computer Science Conference on - ITCS '12. pp. 214–226. doi:10.1145/2090236.2090255. ISBN 9781450311151. S2CID 13496699.

- ^ Galhotra, Sainyam; Brun, Yuriy; Meliou, Alexandra (2017). "Fairness testing: Testing software for discrimination". Proceedings of the 2017 11th Joint Meeting on Foundations of Software Engineering. pp. 498–510. arXiv:1709.03221. doi:10.1145/3106237.3106277. ISBN 9781450351058. S2CID 6324652.

- ^ Kusner, M. J., Loftus, J., Russell, C., & Silva, R. (2017).반사실 공정성.신경 정보 처리 시스템의 발전, 30

- ^ Coston, Amanda; Mishler, Alan; Kennedy, Edward H.; Chouldechova, Alexandra (2020-01-27). "Counterfactual risk assessments, evaluation, and fairness". Proceedings of the 2020 Conference on Fairness, Accountability, and Transparency. FAT* '20. New York, NY, USA: Association for Computing Machinery. pp. 582–593. doi:10.1145/3351095.3372851. ISBN 978-1-4503-6936-7. S2CID 202539649.

- ^ Mishler, Alan; Kennedy, Edward H.; Chouldechova, Alexandra (2021-03-01). "Fairness in Risk Assessment Instruments". Proceedings of the 2021 ACM Conference on Fairness, Accountability, and Transparency. FAccT '21. New York, NY, USA: Association for Computing Machinery. pp. 386–400. doi:10.1145/3442188.3445902. ISBN 978-1-4503-8309-7. S2CID 221516412.

- ^ Richard Zemel; Yu (Ledell) Wu; Kevin Swersky; Tonian Pitassi; Cyntia Dwork, Learning Fair Representations.2019년 12월 1일 검색됨

- ^ a b c Ziyuan Zhong, 기계 학습의 공정성에 대한 튜토리얼.2019년 12월 1일 검색됨

- ^ Faisal Kamiran; Toon Calders, 판별 없는 분류를 위한 데이터 전처리 기술2019년 12월 17일 회수됨

- ^ 무함마드 빌랄 자파르, 이사벨 발레라, 마누엘 고메스 로드리게스, 크리슈나 P.검마디, 이질적 대우 넘어 공정성과 이질적 영향: 이질적 학대 없는 학습 분류2019년 12월 1일 검색됨

- ^ a b Brian Hu Zhang; Blake Lemoine; Margaret Mitchell, 적대적 학습으로 원치 않는 편견 완화.2019년 12월 17일 회수됨

- ^ Joyce Xu, 알고리즘 편향에 대한 알고리즘 해결책: 기술 안내서2019년 12월 17일 회수됨

- ^ a b Moritz Hardt; Eric Price; Nathan Srebro, 지도 학습에서 기회의 평등.2019년 12월 1일 검색됨

- ^ a b Faisal Kamiran; Asim Karim; Xiangliang Zhang, 차별인식분류를 위한 결정이론2019년 12월 17일 회수됨

모델링합니다.tive 특성(성별, 민족성, 성적 성향 등)우리는 최종적으로

모델링합니다.tive 특성(성별, 민족성, 성적 성향 등)우리는 최종적으로

(가) 수행된 결과이며,

(가) 수행된 결과이며,

(가) 편향되지 않은 경우 민감

(가) 편향되지 않은 경우 민감